что это значит, как ускорить процесс

Тематический трафик – альтернативный подход в продвижении бизнеса

Мы выпустили новую книгу «Контент-маркетинг в социальных сетях: Как засесть в голову подписчиков и влюбить их в свой бренд».

Подпишись на рассылку и получи книгу в подарок!

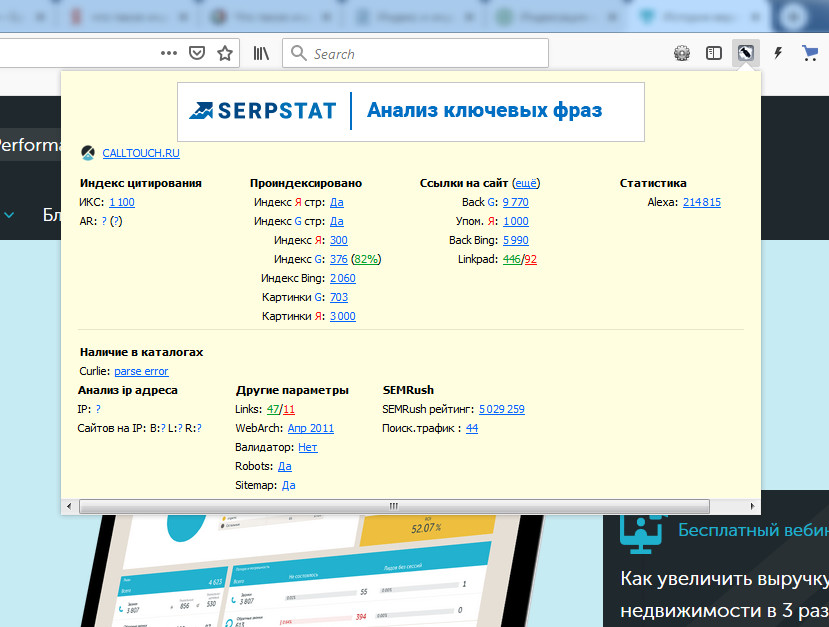

Индексация сайта — это процесс поиска, сбора, обработки и добавления сведений о сайте в базу данных поисковых систем.

Больше видео на нашем канале — изучайте интернет-маркетинг с SEMANTICA

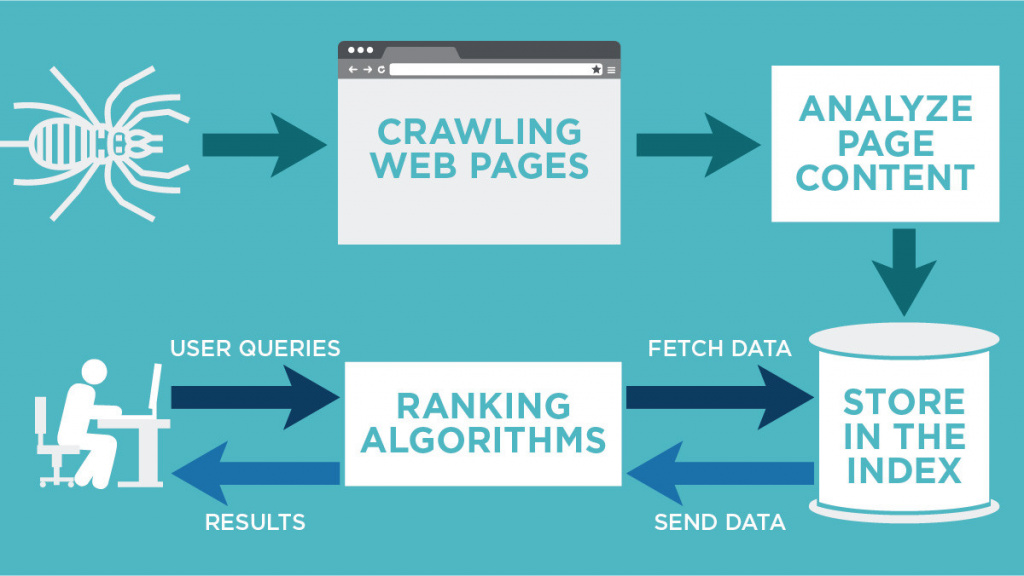

Индексация сайта значит, что робот поисковой системы посещает ресурс и его страницы, изучает контент и заносит его в базу данных.Впоследствии эта информация выдается по ключевым запросам. То есть, пользователи сети вводят в строку поиска запрос и получают на него ответ в виде списка проиндексированных страниц.

Если говорить простым языком, получится приблизительно так: весь интернет — это огромная библиотека. В любой уважающей себя библиотеке есть каталог, который облегчает поиск нужной информации. В середине 90-х годов прошлого века, вся индексация сводилась к такой каталогизации. Роботы находили на сайтах ключевые слова и формировали из них базу данных.

Сегодня боты собирают и анализируют информацию по нескольким параметрам (ошибки, уникальность, полезность, доступность и проч.) прежде, чем внести ее в индекс поисковой системы.

Алгоритмы работы поисковых роботов постоянно обновляются и становятся все сложнее. Базы данных содержат огромное количество информации, несмотря на это поиск нужных сведений не занимает много времени. Это и есть пример качественной индексации.

Если сайт не прошел индексацию, то информация до пользователей может и не дойти.

Как индексирует сайты Гугл и Яндекс

Яндекс и Гугл, пожалуй, самые популярные поисковики в России. Чтобы поисковые системы проиндексировали сайт, о нем нужно сообщить. Сделать это можно двумя способами:

- Добавить сайт на индексацию при помощи ссылок на других ресурсах в интернете — этот способ считается оптимальным, так как страницы, найденные таким путем, робот считает полезными и их индексирование проходит быстрее, от 12 часов до двух недель.

- Отправить сайт на индексацию путем заполнения специальной формы поисковой системы вручную с использованием сервисов Яндекс.Вебмастер, Google Webmaster Tools, Bing Webmaster Tools и др.

Второй способ медленнее, сайт встает в очередь и индексируется в течение двух недель или больше.

В среднем, новые сайты и страницы проходят индексацию за 1–2 недели.

Считается, что Гугл индексирует сайты быстрее. Это происходит потому, что поисковая система Google индексирует все страницы — и полезные, и неполезные. Однако в ранжирование попадает только качественный контент.

Яндекс работает медленнее, но индексирует полезные материалы и сразу исключает из поиска все мусорные страницы.

Индексирование сайта происходит так:

- поисковый робот находит портал и изучает его содержимое;

- полученная информация заносится в базу данных;

- примерно через две недели материал, успешно прошедший индексацию, появится в выдаче по запросу.

Есть 3 способа проверки индексации сайта и его страниц в Гугл и Яндексе:

- при помощи инструментов для вебмастеров — google.com/webmasters или webmaster.yandex.ru;

- при помощи ввода специальных команд в поисковую строку, команда для Яндекс будет выглядеть так: host: имя сайта+домен первого уровня; а для Гугл — site: имя сайта+домен;

- с помощью специальных автоматических сервисов.

Проверяем индексацию

Это можно сделать используя:

- операторы поисковых систем — смотрим в справке или тут;

- услуги специальных сервисов, например rds бар;

- Яндекс вебмастер;

- Google вебмастер.

Как ускорить индексацию сайта

От того, насколько быстро роботы проведут индексирование, зависит скорость появления нового материала в поисковой выдаче, тем быстрее на сайт придет целевая аудитория.

Для ускорения индексации поисковыми системами нужно соблюсти несколько рекомендаций.

- Добавить сайт в поисковую систему.

- Регулярно наполнять проект уникальным и полезным контентом.

- Навигация по сайту должна быть удобной, доступ на страницы не длиннее, чем в 3 клика от главной.

- Размещать ресурс на быстром и надежном хостинге.

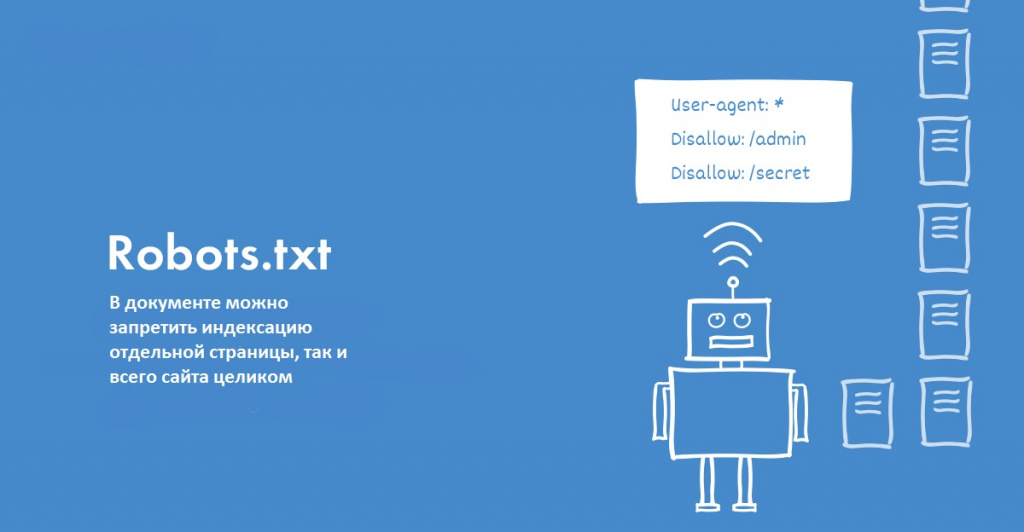

- Правильно настроить robots.txt: устранить ненужные запреты, закрыть от индексации служебные страницы.

- Проверить на наличие ошибок, количество ключевых слов.

- Сделать внутреннюю перелинковку (ссылки на другие страницы).

- Разместить ссылки на статьи в социальных сетях, социальных закладках.

- Создать карту сайта, можно даже две, — для посетителей и для роботов.

Как закрыть сайт от индексации

Закрыть сайт от индексации — запретить поисковым роботам доступ к сайту, к некоторым его страницам, части текста или изображению. Обычно это делается для того, чтобы скрыть от публичного доступа секретную информацию, технические страницы, сайты на уровне разработки, дублированные страницы и т. п.

Сделать это можно несколькими способами:

- При помощи robots.txt можно запретить индексацию сайта или страницы. Для этого в корне веб-сайта создается текстовый документ, в котором прописываются правила для роботов поисковых систем. Эти правила состоят из двух частей: первая часть (User-agent) указывает на адресата, а вторая (Disallow) запрещает индексацию какого-либо объекта.

Например, запрет индексации всего сайта для всех поисковых ботов выглядит так:

User-agent: *

Disallow: /

- При помощи мета-тега robots, что считается наиболее правильным для закрытия одной страницы от индексирования. При помощи тегов noindex и nofollow можно запретить роботам любых поисковых систем индексировать сайт, страницу или часть текста.

Запись для запрета индексации всего документа будет выглядеть так:

<meta name=»robots» content=»noindex, nofollow»/>

Можно создать запрет для конкретного робота:

<meta name=»googlebot» content=»noindex, nofollow»/>

На что влияет индексация при продвижении

Благодаря индексации сайты попадают в поисковую систему. Чем чаще обновляется контент, тем быстрее это происходит, так как боты чаще приходят на сайт. Это приводит к более высокой позиции при выдаче на запрос.

Индексация сайта в поисковых системах дает приток посетителей и способствует развитию проекта.

Кроме контента, роботы оценивают посещаемость и поведение посетителей. На основании этих факторов они делают выводы о полезности ресурса, чаще посещают сайт, что поднимает на более высокую позицию в поисковой выдаче. Следовательно, трафик снова увеличивается.

Индексация — это важный процесс для продвижения проектов. Чтобы индексирование прошло успешно, поисковые роботы должны убедиться в полезности информации.

Алгоритмы, по которым работают поисковые машины, постоянно меняются и усложняются. Цель индексации — внесение информации в базу данных поисковых систем.

semantica.in

как ее проверить, ускорить и запретить

Если интернет – огромная библиотека, то поисковые системы – ее сверхбыстрые сотрудники, способные быстро сориентировать читателя (интернет-пользователя) в бескрайнем океане информации. В этом им помогает систематизированная картотека – собственная база данных.

Когда пользователь вводит ключевую фразу, поисковая система показывает результаты из этой базы данных. То есть ПС хранят на своих серверах копии документов и обращаются к ним, когда пользователь отправляет запрос. Чтобы представить в выдаче определенную страницу, ее нужно сперва добавить в базу (индекс). Поэтому только что созданные сайты, о которых поисковики не знают, в выдаче не участвуют.

Поисковая система отправляет своего робота (он же паук, он же краулер) на поиски новых страниц, которые появляются в сети ежесекундно. Паучья стая собирает данные, передвигаясь по ссылкам с одной страницы на другую, и передает их в базу. Обработку информации производят уже другие механизмы.

У каждой поисковой системы – свой набор ботов, выполняющих разные функции. Вот пример некоторых роботов «Яндекса»:

- Основной робот.

- Индексатор картинок.

- Зеркальщик (обнаруживает зеркала сайта).

- Быстробот. Эта особь обитает на часто обновляемых сайтах. Как правило – новостных. Контент появляется в выдаче практически сразу после размещения. При ранжировании в таких случаях учитывается лишь часть факторов, поэтому позиции страницы могут измениться после прихода основного робота.

У «Гугла» тоже есть свой робот для сканирования новостей и картинок, а еще – индексатор видео, мобильных сайтов и т. д.

Скорость индексирования новых сайтов у разных ПС отличается. Каких-то конкретных сроков здесь нет, есть лишь примерные временные рамки: для «Яндекса» – от одной недели до месяца, для Google – от нескольких минут до недели. Чтобы не ждать индексации неделями, нужно серьезно поработать. Об этом и пойдет речь в статье.

Сперва давайте узнаем, как проверить, проиндексирован ли сайт.

Как проверить индексацию сайта

Проверить индексацию можно тремя основными способами:

- Сделать запрос в поисковик, используя специальные операторы.

- Воспользоваться инструментами вебмастеров (Google Search Console, «Яндекс.Вебмастер»).

- Воспользоваться специализированными сервисами или скачать расширение в браузер.

Поисковые операторы

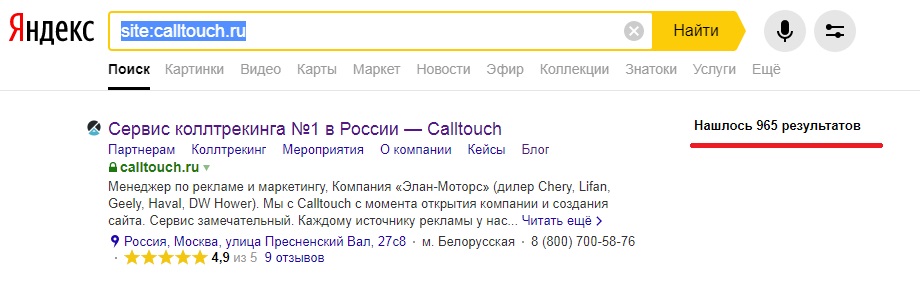

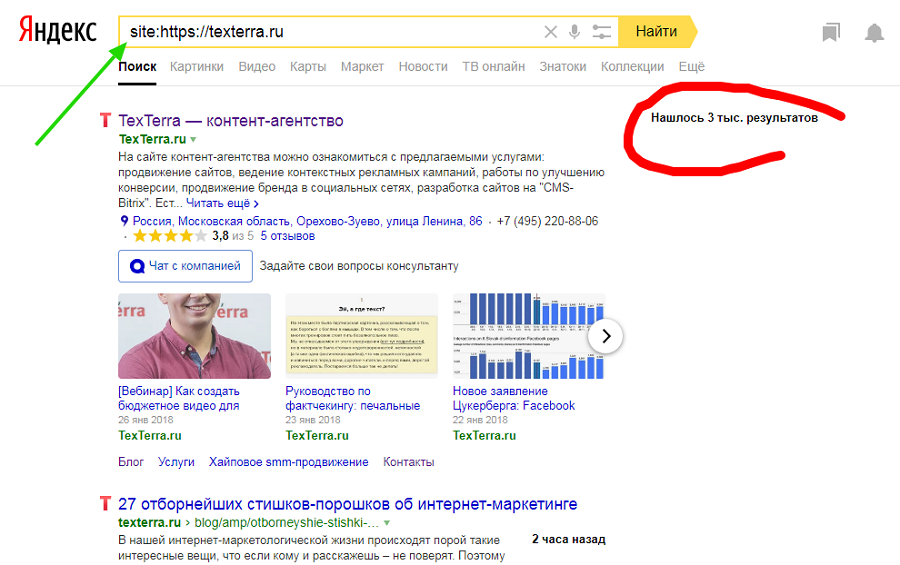

Быстро и просто примерное количество проиндексированных страниц можно узнать с помощью оператора site. Он действует одинаково в «Яндекс» и «Гугл».

Сервисы для проверки индексации

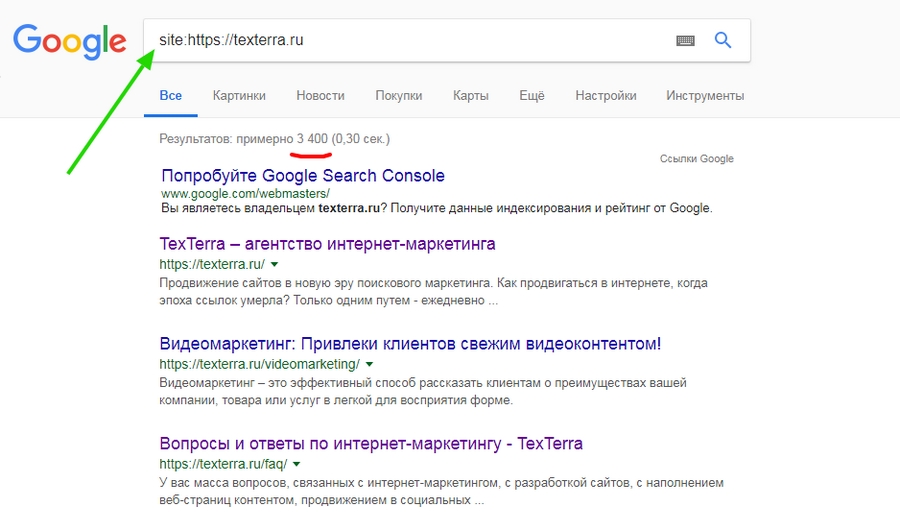

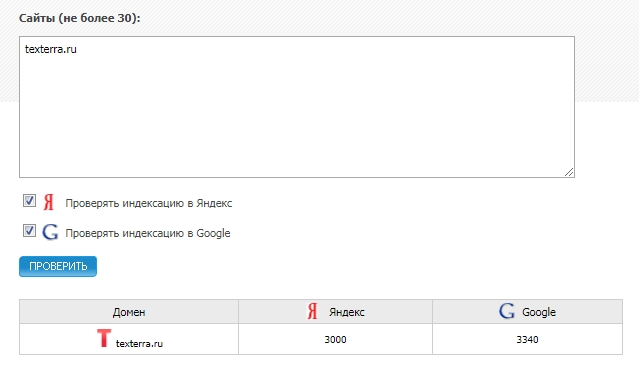

Бесплатные сервисы позволяют быстро узнать количество проиндексированных «Яндексом» и Google страниц. Есть, к примеру, очень удобный инструмент от XSEO.in и SEOGadget (можно проверять до 30 сайтов одновременно).

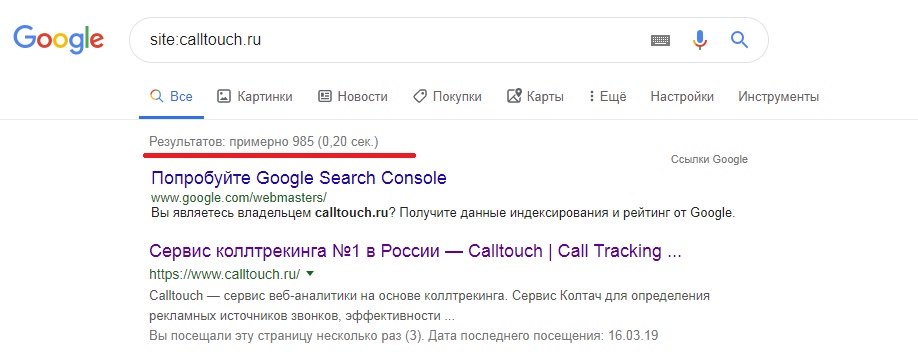

У RDS целая линейка полезных инструментов для проверки показателей сайтов, в том числе проиндексированных страниц. Можно скачать удобный плагин для браузера (поддерживаются Chrome, Mozilla и Opera) или десктопное приложение.

Вообще плагин больше подходит профессиональным SEOшникам. Если вы обычный пользователь, будьте готовы, что эта утилита будет постоянно атаковать вас лишней информацией, вклиниваясь в код страниц, и в итоге придется либо ее настраивать, либо удалять.

Панели вебмастера

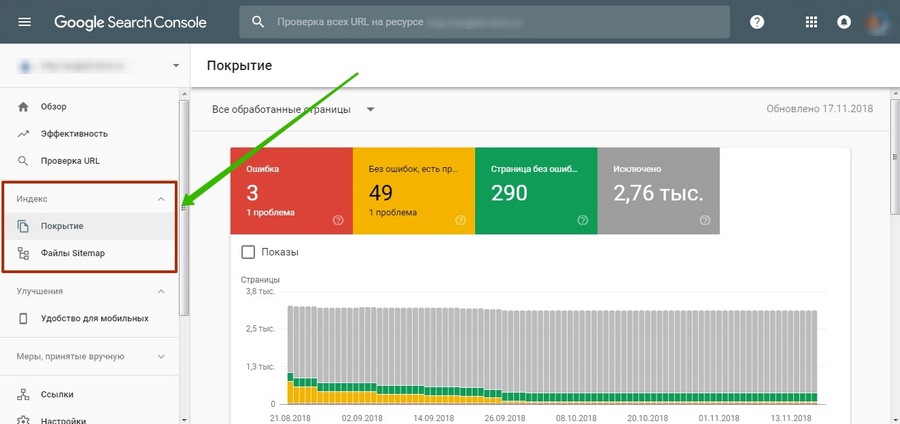

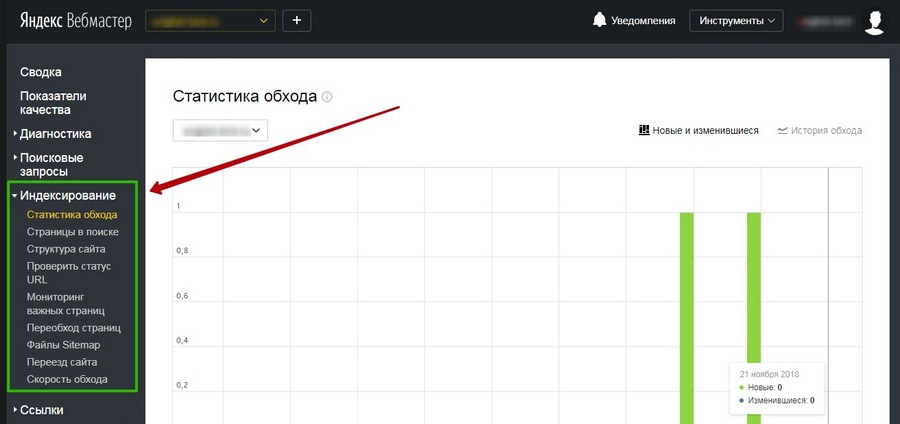

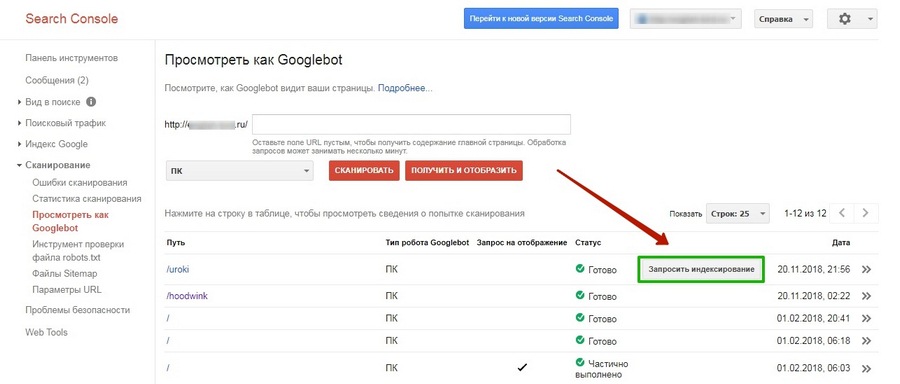

«Яндекс.Вебмастер» и Google Search Console предоставляют подробную информацию об индексировании. Так сказать, из первых уст.

В старой версии GSC можно также посмотреть статистику сканирования и ошибки, с которыми сталкиваются роботы при обращении к страницам.

Подробнее о данных об индексировании, представленных в панелях вебмастеров, можно почитать в соответствующих разделах наших руководств по «Яндекс.Вебмастеру» и Google Search Console.

58 самых распространенных ошибок SEOКак контролировать индексацию

Поисковые системы воспринимают сайты совсем не так, как мы с вами. В отличие от рядового пользователя, поисковый робот видит всю подноготную сайта. Если его вовремя не остановить, он будет сканировать все страницы, без разбора, включая и те, которые не следует выставлять на всеобщее обозрение.

При этом нужно учитывать, что ресурсы робота ограничены: существует определенная квота – количество страниц, которое может обойти паук за определенное время. Если на вашем сайте огромное количество страниц, есть большая вероятность, что робот потратит большую часть ресурсов на «мусорные» страницы, а важные оставит на будущее.

Поэтому индексированием можно и нужно управлять. Для этого существуют определенные инструменты-помощники, которые мы далее и рассмотрим.

Robots.txt

Robots.txt – простой текстовый файл (как можно догадаться по расширению), в котором с помощью специальных слов и символов прописываются правила, которые понимают поисковые системы.

Директивы, используемые в robots.txt:

|

Директива |

Описание |

|

User-agent |

Обращение к роботу. |

|

Allow |

Разрешить индексирование. |

|

Disallow |

Запретить индексирование. |

|

Host |

Адрес главного зеркала. |

|

Sitemap |

Адрес карты сайта. |

|

Crawl-delay |

Время задержки между скачиванием страниц сайта. |

|

Clean-param |

Страницы с какими параметрами нужно исключить из индекса. |

User-agent показывает, к какому поисковику относятся указанные ниже правила. Если адресатом является любой поисковик, пишем звездочку:

User-agent: Yandex

User-agent: GoogleBot

User-agent: Bingbot

User-agent: Slurp (поисковый робот Yahoo!)

User-agent: *

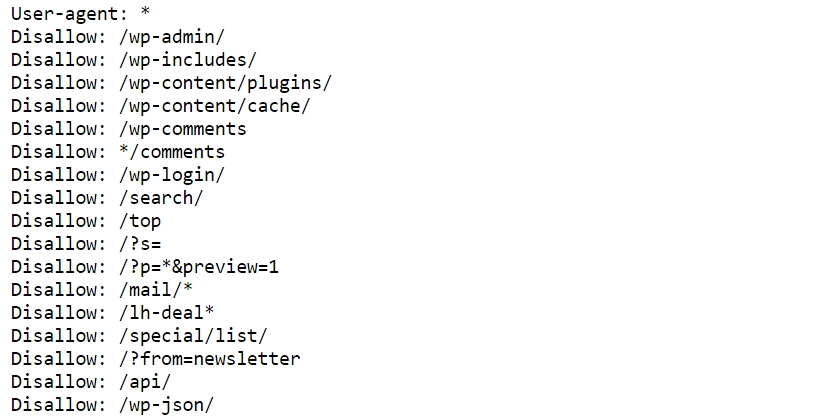

Самая часто используемая директива – disallow. Как раз она используется для запрета индексирования страниц, файлов или каталогов.

К страницам, которые нужно запрещать, относятся:

- Служебные файлы и папки. Админ-панель, файлы CMS, личный кабинет пользователя, корзина и т. д.

- Малоинформативные вспомогательные страницы, не нуждающиеся в продвижении. Например, биографии авторов блога.

- Различного вида дубли основных страниц.

На дублях остановимся подробнее. Представьте, что у вас есть страница блога со статьей. Вы прорекламировали эту статью на другом ресурсе, добавив к существующему URL UTM-метку для отслеживания переходов. Адрес немного изменился, но он все еще ведет на ту же страницу – контент полностью совпадает. Это дубль, который нужно закрывать от индексации.

Не только системы статистики виноваты в дублировании страниц. Дубли могут появляться при поиске товаров, сортировке, из-за наличия одного и того же товара в нескольких категориях и т. д. Даже сами движки сайта часто создают большое количество разных дублей (особенно WordPress и Joomla).

Мы делаем сайты, которые оптимизированы под поисковики и приносят продажи. ПодробнееПомимо полных дублей существуют и частичные. Самый лучший пример – главная страница блога с анонсами записей. Как правило, анонсы берутся из статей, поэтому на таких страницах отсутствует уникальный контент. В этом случае анонсы можно уникализировать или вовсе убрать (как в блоге Texterra).

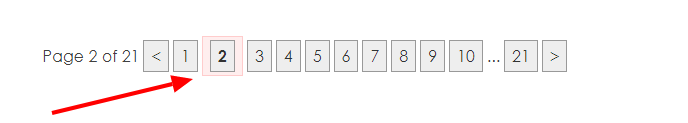

У подобных страниц (списки статей, каталоги товаров и т. д.) также присутствует постраничная навигация (пагинация), которая разбивает список на несколько страниц. О том, что делать с такими страницами, Google подробно расписал в своей справке.

Дубли могут сильно навредить ранжированию. Например, из-за большого их количества поисковик может показывать по определенным запросам совершенно не те страницы, которые вы планировали продвигать и на которые был сделан упор в плане оптимизации (например, есть усиленная ссылками страница товара, а поисковик показывает совершенно другую). Поэтому важно правильно настроить индексацию сайта, чтобы этой проблемы не было. Как раз один из способов борьбы с дублями – файл robots.txt.

Пример robots.txt для одного известного блога:

При составлении robots.txt можно ориентироваться на другие сайты. Для этого просто добавьте в конце адреса главной страницы интересующего сайта после слеша «robots.txt».Не забывайте только, что функционал у сайтов разный, поэтому полностью скопировать директивы топовых конкурентов и жить спокойно не получится. Даже если вы решите скачать готовый robots.txt для своей CMS, в него все равно придется вносить изменения под свои нужды.

Давайте разберемся с символами, которые используются при составлении правил.

Путь к определенному файлу или папке мы указываем через слеш (/). Если указана папка (например, /wp-admin/), все файлы из этой папки будут закрыты для индексации. Чтобы указать конкретный файл, нужно полностью указать его имя и расширение (вместе с директорией).

Если, к примеру, нужно запретить индексацию файлов определенного типа или страницу, содержащую какой-либо параметр, можно использовать звездочки (*):

Disallow: /*openstat=

Disallow: /*?utm_source=

Disallow: /*price=

Disallow: /*gclid=*

На месте звездочки может быть любое количество символов (а может и не быть вовсе). Значок $ используется, когда нужно отменить правило, созданное значком *. Например, у вас есть страница eda.html и каталог /eda. Директива «/*eda» запретит индексацию и каталога, и страницы. Чтобы оставить страницу открытой для роботов, используйте директиву «/eda$».

Запретить индексацию страниц с определенными параметрами также можно с помощью директивы clean-param. Подробнее об этом можно прочитать в справке «Яндекса».

Директива allow разрешает индексирование отдельных каталогов, страниц или файлов. Например, нужно закрыть от ПС все содержимое папки uploads за исключением одного pdf-файла. Вот как это можно сделать:

Disallow: /wp-content/uploads/

Allow: /wp-content/uploads/book.pdf

Следующая важная (для «Яндекса») директива – host. Она позволяет указать главное зеркало сайта.

У сайта может быть несколько версий (доменов) с абсолютно идентичным контентом. Даже если у вас домен единственный, не стоит игнорировать директиву host, это разные сайты, и нужно определить, какую версию следует показывать в выдаче. Об этом мы уже подробно писали в статье «Как узнать главное зеркало сайта и настроить его с помощью редиректа».

Еще одна важная директива – sitemap. Здесь (при наличии) указывается адрес, по которому можно найти карту вашего сайта. О том, как ее создать и для чего она нужна, поговорим позже.

Наконец, директива, которая применяется не так часто – crawl-delay. Она нужна в случае, когда нагрузка на сервер превышает лимит хостинга. Такое редко встречается у хороших хостеров, и без видимых причин устанавливать временные ограничения на скачивание страниц роботам не стоит. К тому же скорость обхода можно регулировать в «Яндекс.Вебмастере».

Нужно отметить, что поисковые системы по-разному относятся к robots.txt. Если для «Яндекса» это набор правил, которые нельзя нарушать, то «Гугл» воспринимает его, скорее, как рекомендацию и может проигнорировать некоторые директивы.

В robots.txt нельзя использовать кириллические символы. Поэтому если у вас кириллический домен, используйте онлайн-конвертеры.

После создания файла его нужно поместить в корневой каталог сайта, т. е.: site.ru/robots.txt.

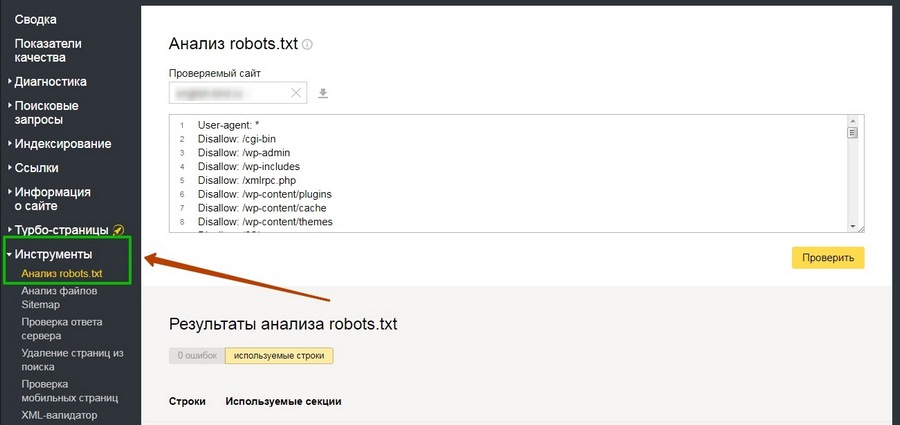

Проверить robots.txt на наличие ошибок можно в разделе «Инструменты» панели «Яндекс.Вебмастер»:

В старой версии Google Search Console тоже есть такой инструмент.

Как закрыть сайт от индексации

Если вам по какой-то причине нужно, чтобы сайт исчез из выдачи всех поисковых систем, сделать это очень просто:

User-agent: *

Disallow: /

Крайне желательно делать это, пока сайт находится в разработке. Чтобы снова открыть сайт для поисковых роботов, достаточно убрать слеш (главное – не забыть это сделать при запуске сайта).

Nofollow и noindex

Для настройки индексации используются также специальные атрибуты и html-теги.

У «Яндекса» есть собственный тег <noindex>, с помощью которого можно указать роботу, какую часть текста он не должен индексировать. Чаще всего это служебные части текста, которые не должны отображаться в сниппете, или фрагменты, которые не должны учитываться при оценке качества страницы (неуникальный контент).

Проблема в том, что этот тег практически никто кроме «Яндекса» не понимает, поэтому при проверке кода большинство валидаторов выдают ошибки. Это можно исправить, если слегка изменить внешний вид тегов:

<!—noindex—>текст<!—/noindex—>

Атрибут rel=”nofollow” позволяет закрыть от индексации отдельные ссылки на странице. В отличие от <noindex> его понимают все поисковые системы. Чтобы запретить роботу переходить по всем ссылкам на странице сразу, проще использовать вот такой мета-тег: <meta name=»robots» content=»nofollow» />.

Кстати, на мега-теге robots стоит остановиться подробнее. Как и файл robots.txt, он позволяет управлять индексацией, но более гибко. Чтобы понять принцип работы, рассмотрим варианты инструкций:

|

<meta name=»robots» content=»index,follow» /> |

индексировать контент и ссылки |

|

<meta name=»robots» content=»noindex,nofollow» /> |

не индексировать контент и ссылки |

|

<meta name=»robots» content=»noindex,follow» /> |

не индексировать контент, но переходить по ссылкам |

|

<meta name=»robots» content=»index,nofollow» /> |

индексировать контент, но не переходить по ссылкам |

Это далеко не все примеры использования мета-тега robots, так как помимо nofollow и noindex существуют и другие директивы. Например, noimageindex, запрещающая сканировать изображения на странице. Подробнее почитать об этом мета-теге и его применении можно в справке от Google.

Rel=”canonical”

Еще один способ борьбы с дублями – использование атрибута rel=”canonical”. Для каждой страницы можно задать канонический (предпочитаемый) адрес, который и будет отображаться в поисковой выдаче. Прописывая атрибут в коде дубля, вы «прикрепляете» его к основной странице, и путаницы c ee версиями не возникнет. При наличии у дубля ссылочного веса он будет передаваться основной странице.

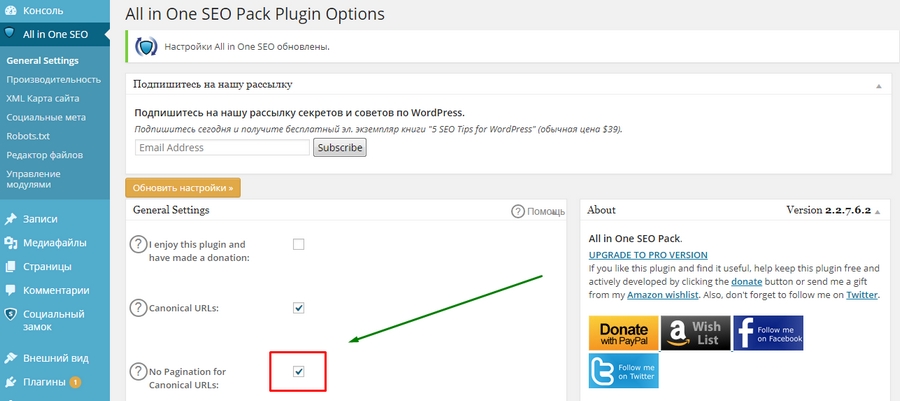

Вернемся к примеру с пагинацией в WordPress. С помощью плагина All in One SEO можно в один клик решить проблему с дублями этого типа. Посмотрим, как это работает.

Зайдем главную страницу блога и откроем, к примеру, вторую страницу пагинации.

Теперь посмотрим исходный код, а именно – тег <link> с атрибутом rel=»canonical» в разделе <head>. Изначально он выглядит так:

<link rel=»canonical» target=»_blank» href=»http://site.ru/page/2/»>

Каноническая ссылка установлена неправильно – она просто повторяет физический адрес страницы. Это нужно исправить. Переходим в общие настройки плагина All in One SEO и отмечаем галочкой пункт «No Pagination for Canonical URLs» (Запретить пагинацию для канонических URL).

После обновления настроек снова смотрим код, теперь должно быть вот так:

<link rel=»canonical» target=»_blank» href=»http://site.ru/»>

И так – на любой странице, будь то вторая или двадцатая. Быстро и просто.

Но есть одна проблема. Для Google такой способ не подходит (он сам об этом писал), и использование атрибута canonical может негативно отразиться на индексировании страниц пагинации. Если для блога это, в принципе, не страшно, то со страницами товаров лучше не экспериментировать, а использовать атрибуты rel=”prev” и rel=”next”. Только вот «Яндекс» их, по словам Платона Щукина, игнорирует. В общем, все неоднозначно и ничего не понятно, но это нормально – это SEO.

Чек-лист по оптимизации сайта, или 100+ причин не хоронить SEOSitemap (карта сайта)

Если файл robots.txt указывает роботу, какие страницы ему трогать не надо, то карта сайта, напротив, содержит в себе все ссылки, которые нужно индексировать.

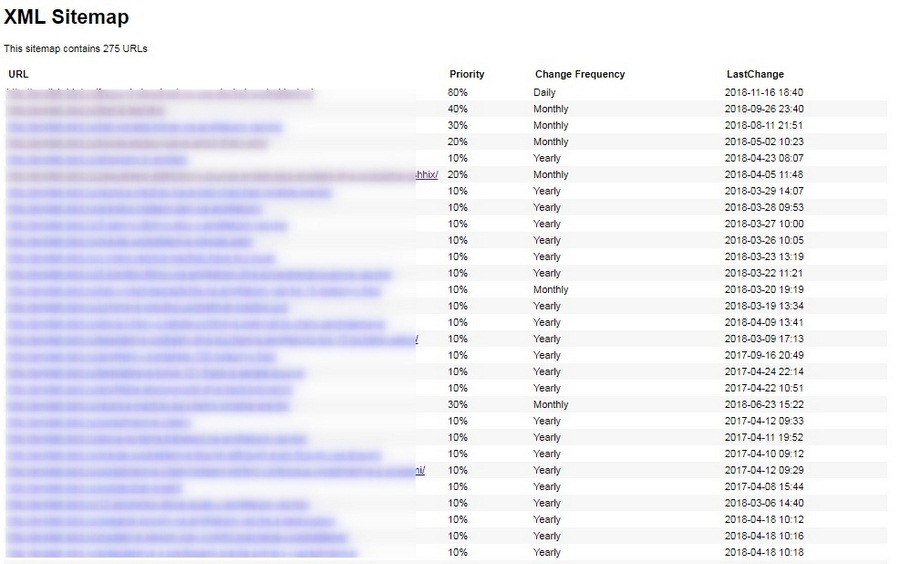

Главный плюс карты сайта в том, что помимо перечня страниц она содержит полезные для робота данные – дату и частоту обновлений каждой страницы и ее приоритет для сканирования.

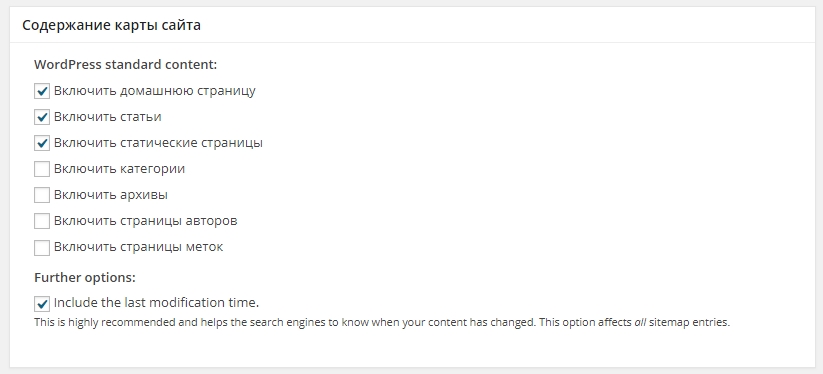

Файл sitemap.xml можно сгенерировать автоматически с помощью специализированных онлайн-сервисов. Например, Gensitemap (рус) и XML-Sitemaps (англ). У них есть ограничения на количество страниц, поэтому если у вас большой сайт (больше 1000 страниц), за создание карты придется заплатить символическую сумму. Также получить готовый файл можно с помощью плагина. Самый простой и удобный плагин для WordPress – Google XML Sitemaps. У него довольно много разных настроек, но в них несложно разобраться.

В результате получается простенькая и удобная карта сайта в виде таблички. Причем она становится доступной сразу после активации плагина.

Sitemap крайне полезен для индексации, так как зачастую роботы уделяют большое внимание старым страницам и игнорируют новые. Когда есть карта сайта, робот видит, какие страницы изменились, и при обращении к сайту в первую очередь посещает их.

SEO-оптимизация интернет-магазина: 25 эффективных советовЕсли вы создали карту сайта при помощи сторонних сервисов, готовый файл необходимо скачать и поместить, как и robots.txt, в папку на хостинге, где расположен сайт. Опять же, в корневой папке: site.ru/sitemap.xml.

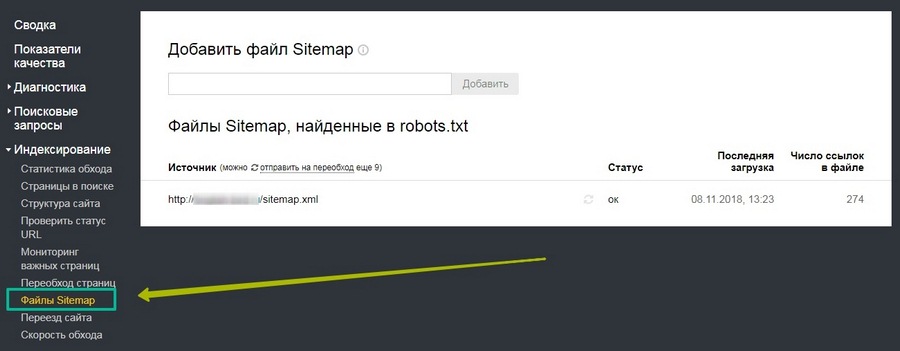

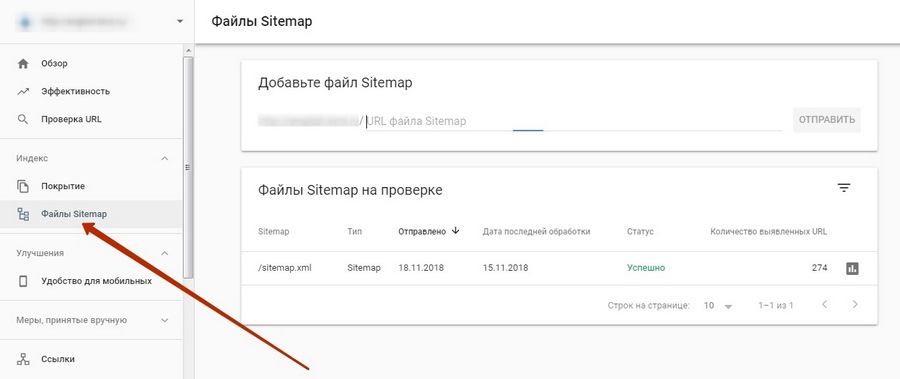

Для удобства желательно загрузить полученный файл в специальный раздел в «Яндекс.Вебмастере» и Google Search Console.

В старой версии инструмент немного отличается.

В «Яндекс.Вебмастере» проверить содержимое карты сайта на наличие ошибок можно в разделе «Инструменты».

Как ускорить индексацию

Поисковые системы рано или поздно узнают о вашем сайте, даже если вы ничего для этого не сделаете. Но вы наверняка хотите получать клиентов и посетителей как можно раньше, а не через месяцы, поэтому затягивать с индексацией – себе в убыток.

Регулярное быстрое индексирование необходимо не только новым, но и действующим сайтам – для своевременного обновления данных в поиске. Представьте, что вы решили оптимизировать старые непривлекательные заголовки и сниппеты, чтобы повысить CTR в выдаче. Если ждать, пока робот сам переиндексирует все страницы, можно потерять кучу потенциальных клиентов.

Вот еще несколько причин, чтобы как можно быстрее «скормить» роботам новые странички:

- На сайте публикуется контент, быстро теряющий актуальность. Если сегодняшняя новость проиндексируется и попадет в выдачу через неделю, какой от нее толк?

- О сайте узнали мошенники и следят за обновлениями быстрее любого робота: как только у вас публикуется новый материал, они копируют его себе и благополучно попадают на первые позиции благодаря более быстрому индексированию.

- На страницах появляются важные изменения. К примеру, у вас изменились цены или ассортимент, а в поиске показываются старые данные. В результате пользователи разочаровываются, растет показатель отказов, а сайт рискует опуститься в поисковой выдаче.

Ускорение индексации – работа комплексная. Каких-то конкретных способов здесь нет, так как каждый сайт индивидуален (как и серверы, на которых они расположены). Но можно воспользоваться общими рекомендациями, которые, как правило, позитивно сказываются на скорости индексирования.

Перечислим кратко, что можно сделать, чтобы сайт индексировался быстрее:

- Указать роботам, что индексировать и что не индексировать. Про robots.txt, карту сайта и все их преимущества мы уже говорили. Если файлы будут составлены правильно, боты быстрее справятся со свалившимся на них объемом новой информации.

- Зарегистрироваться в «Яндекс.Вебмастере» и Google Search Console. Там вы сможете не только заявить о новом сайте, но и получить доступ к важным инструментам и аналитике.

- Обратить внимание на сам сайт. Чтобы роботу (как и пользователям) проще было ориентироваться на сайте, у него должна быть понятная и простая структура и удобная навигация. Сюда же можно отнести грамотную перелинковку, которая может помочь в передвижении по сайту и обнаружении важных страниц. Качество контента тоже может повлиять на скорость индексирования, поэтому лучше выкладывать уникальные тексты, несущие пользу.

- Публикуйтесь на внешних площадках. Многие рекомендуют регистрировать сайты в сервисах социальных закладок, каталогах, «прогонять» по «Твиттеру», покупать ссылки и т. д. Мне в свое время это не помогло – новый сайт индексировался месяц. Но вот ссылки с крупных посещаемых ресурсов (где даже может обитать быстробот) действительно могут помочь. О том, как и где публиковаться, у нас было много статей: «Гостевой постинг: как публиковаться, вставлять ссылки и не платить за это», «Внешний контент-маркетинг: зачем, о чем и куда писать», гайд по линкбилдингу.

- Обновляйте сайт чаще. Если на сайте месяцами не публикуются новые материалы, робот меняет тактику и заходит на сайт реже.

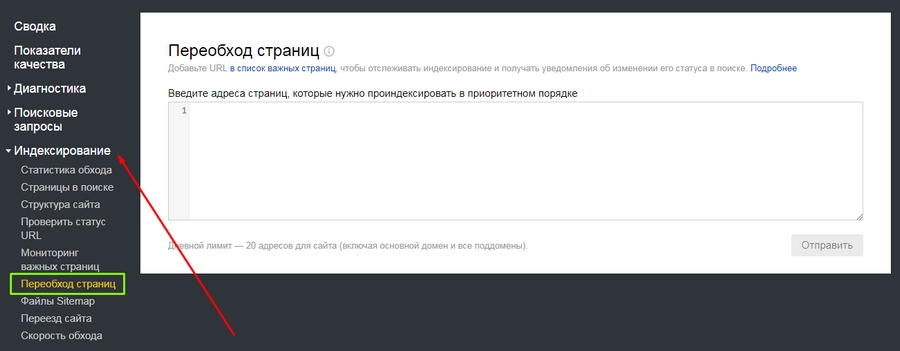

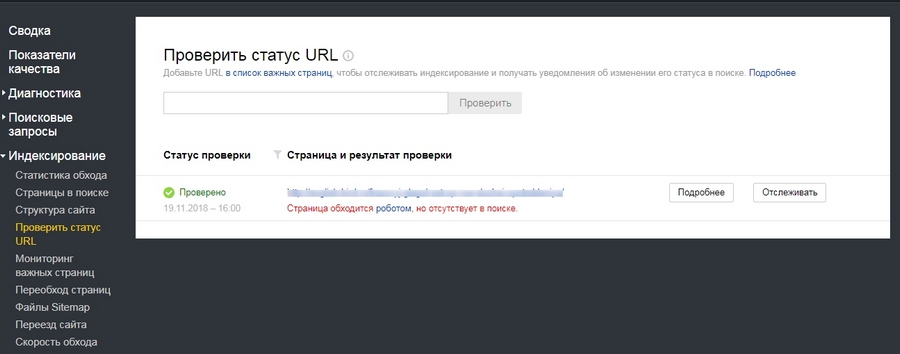

Еще в панелях «Яндекс.Вебмастера» и Google Search Console можно отправлять роботов на конкретные страницы.

Обратите внимание на то, что отдельные адреса можно добавить в важные, чтобы потом отслеживать их индексирование.

А вот еще одна полезная штука: здесь можно узнать, проиндексирован ли конкретный URL.

В Google запросить индексирование конкретных страниц можно во вкладке «Посмотреть как Googlebot» (старая версия).

Это, пожалуй, самые основные способы ускорения индексации. Есть и другие, но их эффективность – под вопросом. В большинстве случаев тратить на них время не стоит, если только проиндексировать сайт нужно срочно, и вы готовы испробовать любые способы. В таких случаях лучше читать конкретные кейсы. Например, как проиндексировать сайт в Google в течение 24 часов.

Вывод

Индексация сайта – сложный процесс, с которым поисковые системы далеко не всегда справляются в одиночку. Так как индексирование влияет непосредственно на ранжирование сайта в поисковой выдаче, имеет смысл взять управление в свои руки и максимально упростить работу поисковым роботам. Да, придется повозиться и набить много шишек, но даже такой непредсказуемый зверь как поисковый бот все же может покориться человеку.

kak-priruchit-poiskovogo-bota-gayd-po-indeksirovaniyu-saytatexterra.ru

Как управлять индексированием сайта — Онлайн-курсы Яндекса

1. Немного теории

Владелец сайта может влиять на то, как индексируется его ресурс.

Например, вы можете запросто закрыть для поисковой системы определённые разделы своего сайта. Для этого нужно добавить соответствующие команды в файл robots.txt — он находится в корневой папке сайта. Именно к этому файлу обращаются поисковые роботы, чтобы узнать, что можно индексировать, а что нет.

Поисковые системы исходят из того, что индексировать можно всё, что не запрещено. Поэтому владельцу сайта нужно самому позаботиться о том, чтобы в поиск не попала конфиденциальная информация — например, личные данные пользователей, их переписка или счета. Такие страницы нужно запретить индексировать. Рекомендуем также закрыть страницы со служебной информацией и страницы-дубликаты.

Многие системы управления сайтами (CMS) автоматически создают файл robots.txt и команды для роботов. Яндекс.Вебмастер позволяет проверить файл robots.txt на наличие ошибок. Для этого нужно загрузить содержимое файла в инструмент «Анализатор robots.txt». Для этого можно просто скопировать данные файла и вставить их в форму. Или загрузить файл robots.txt через интерфейс сервиса.

Сервис проверит файл и покажет, есть ли в нём ошибки.

Теперь поговорим о том, как создать правило для робота. Каждое правило состоит из двух элементов: это обращение к роботу и команда.

Если вы хотите обратиться сразу ко всем роботам, используйте элемент «User-agent:*». Для обращения только к роботу Яндекса нужно выбрать элемент «User-agent: Yandex».

Вы можете дать роботу команду «Allow:» (разрешить индексирование) или «Disallow:» (запретить индексирование). После команды нужно указать адрес, для которого должна применяться команда.

Например, так будет выглядеть правило, запрещающее всем поисковым роботам индексировать раздел siteforyandex.ru/admin:

User-agent: *

Disallow: /adminАнализатор помогает найти ошибки в файле robots.txt, проверить, все ли команды прописаны верно и понятны роботу, и узнать, разрешена ли к индексированию конкретная страница.

Файл robots.txt позволяет закрыть для индексирования весь контент страницы. Если вы хотите закрыть только какую-то часть контента, используйте тег noindex. Этот тег не даёт индексировать заключенный в него текст, но не мешает поисковой системе переходить по ссылкам внутри текста.

Совет

Чтобы узнать, какие разделы сайта и в каком объёме уже проиндексированы, воспользуйтесь инструментом «Структура сайта» в Яндекс.Вебмастере, он находится в разделе «Индексирование».

yandex.ru

Что такое индексация сайта, как ее проверить и как ускорить

Чтобы открыть онлайн-магазин, запустить информационный или развлекательный портал в сети необходим сайт – это, буквально, место или сегмент в виртуальном пространстве с уникальным адресом (домен), где размещается контент и файлы по проекту. Но чтобы ресурс можно было найти среди других, его необходимо «прописать» в специальной базе поисковых систем – индексе.

Что такое индексация сайта? Как её правильно выполнить и проверить? Можно ли ускорить этот процесс и полностью отказаться от него, на что влияет индекс? На все вопросы подробно отвечаем в этой статье.

Разбираемся в понятиях

Индексация страницы – это процесс сбора, проверки и внесения информации о контенте сайта в базу поисковых систем. Такая непростая и трудоемкая работа поручается специальным роботам, которые целиком обходят весь сайт и, следуя установленным алгоритмам ПС, собирают информацию со страниц. При индексации учитываются внешние и внутренние ссылки, графические элементы, текстовое наполнение и другое. Если ресурс проходит проверку, то он вносится в индекс ПС, то есть пользователи смогут его найти по поисковым запросам.

Вся информация в базе – это выжимка данных, собранных поисковыми роботами с сайтов в Интернете. Пользователю, обратившемуся к такой библиотеке через ПС, предлагается сначала каталог сайтов с релевантной запросу информацией. Поисковые системы ранжируют ресурсы по собственным алгоритмам, учитывая полезность, тематику и другие параметры. Ознакомившись с краткой информацией о ресурсе (заголовок + сниппет), пользователь кликает на позицию в выдаче и переходит на целевую страницу для дальнейшего изучения.

Попытки структурировать сайты в сети были приняты в конце 90-х годов прошлого века. В то время алгоритмы ПС только разрабатывались, поэтому индекс напоминал предметный указатель по ключевым словам, которые находили роботы на проверяемых страницах. Соответственно в ТОП выдачи часто проникали переоптимизированные и абсолютно бесполезные для пользователей сайты. За 20-30 лет развития алгоритмы отбора усложнились. Сегодня роботы смотрят не только на попадание контента в тематику, но и на его качество, полезность для людей, доступность сайта с разных устройств, скорость загрузки и многое другое.

Как индексируют Яндекс и Google

Для большинства пользователей Рунета, индексация в поисковых системах – это добавление сайта в базу Яндекса и/или Гугла. Обычно достаточно прописать ресурсы только в этих поисковиках, чтобы развивать свой проект. Провести индексацию, независимо от выбранной ПС, можно двумя способами:

- Поисковые роботы самостоятельно находят и проверяют созданный сайт или его новые страницы. Многие эксперты считают такой вариант самым выгодным, ведь если ПС сами хотят внести ресурс в индекс, то он пользуется популярностью. Значит, приносит пользу. Как роботы определяют полезность страниц: наличие активных внешних ссылок, объемы трафика и вовлеченность посетителей. Если все условия выполняются, то индексация сайта проходит быстрее: от 24 часов до недели. В противном случае ПС могут и вовсе «забыть» о новом ресурсе. Работы у роботов хватает.

- Пользователь принудительно отправляет сайт на индексацию с помощью заполнения формы на сервисе поисковой системы. Созданные страницы помещаются в очередь на «прописку» и ждут посещения роботов ПС. Обычно добавляют URL главной страницы, а боты сами обходят весь ресурс, ориентируясь по карте сайта, меню и внутренним ссылкам. Используются сервисы Google Webmaster Tools и Яндекс.Вебмастер соответственно. Этот вариант занимает больше времени, но не требует финансовых затрат.

Для сканирования сайтов существуют разные боты ПС. Например, проверку новых страниц перед внесением в индекс делает основной робот, который проверяет весь контент на ресурсе. Новую информацию на проиндексированных страницах проверяет быстрый робот в соответствии с графиком обновления. Также используются боты для сканирования новостной ленты, графического контента и другие.

Как проверить?

Алгоритмы индексации и соответственно скорость работы ботов Яндекса и Гугла отличаются. Считается, что Google проверяет страницы быстрее. Это связано с тем, что система сначала сканирует сайт полностью – полезные и неполезные страницы, но в выдачу пропускает только качественные ресурсы. Таким образом, попадание в индекс Гугла ещё не гарантирует место в выдаче.

Индексация сайта в Яндексе, что это такое и почему долго? Роботы ПС проверяют только полезные материалы, отсеивая мусорные страницы. Поэтому индексация затягивается. В любом случае сканирование контента на соответствие требованиям выполняют обе системы: Яндекс сразу, а Гугл после «прописки».

Проверить индексацию можно тремя способами:

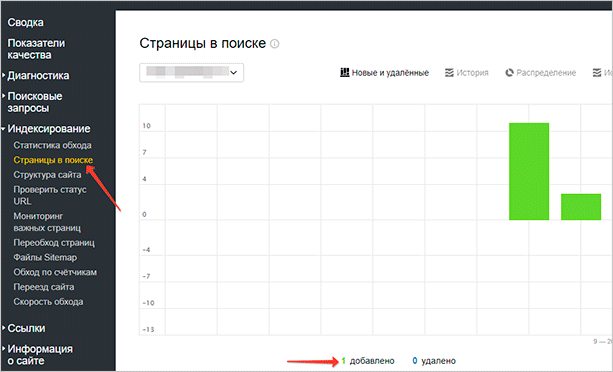

- Использовать инструменты вебмастеров, которые предоставляются поисковыми системами бесплатно – это webmaster.yandex.ru или google.com/webmasters. В Гугле откройте Search Console и далее раздел «Индекс Google». Информация о статусе сайта находится в блоке «Статус индексирования». В Яндексе пройдите по следующей цепочке: «Индексирование сайта» — «Страницы в поиске». Естественно нужно сначала внести в форму URL сайта и подтвердить права владельца.

-

Использовать специальные операторы, которые вводятся в поисковую строку. Для Яндекса и Гугла нужно прописать значение «site:» и после двоеточия добавить домен ресурса. Например: site:calltouch.ru. Таким способом можно узнать количество проиндексированных страниц. Если значения в Гугле и Яндексе сильно различаются, то вероятно сайт под фильтром.

-

Воспользоваться браузерными плагинами или спецсервисами. Это небольшие дополнения к веб-обозревателю, которые автоматически проверяют наличие страниц в индексе. Популярное решение — RDS Bar.

Как ускорить?

От того, как быстро роботы ПС проверят новый контент напрямую зависит скорость появления страниц в поисковой выдаче. Соответственно на сайт быстрее придет аудитория и совершит целевые действия. Скорость индексации зависит от нескольких факторов:

- Авторитетность сайта в сети, полезность для пользователей;

- Отсутствие ошибок при индексации;

- Качество и частота обновления контента;

- Наличие внутренних и внешних ссылок;

- Вложенность страниц;

- Правильно заполненные файлы sitemap.xml и robots.txt;

- Корректно выставленные ограничения в роботсе.

Для ускорения индексации рекомендуется выполнить следующие действия:

- Подобрать надежный и быстрый хостинг.

- Поставить сайт на индексацию в ПС Яндекса и Гугла.

- Корректно настроить robots.txt. В файле нужно запретить посещение технических, служебных страниц, просмотр другой информации, не представляющей пользы для посетителей.

- Создать файл карты sitemap.xml и сохранить его в корне сайта. По нему роботы проверяют структуру страниц, а также следят за обновлением контента.

- Проверить код главной и других страниц на наличие ошибок и дублей.

- Проверить текстовое наполнение на количество ключевых слов.

- Регулярно размещать на сайте новый полезный контент. Рекомендуется настроить внутреннюю перелинковку между статьями и страницами. Это простой и эффективный вариант повысить вовлеченность пользователей в проект и соответственно «подрасти» в выдаче.

- Настроить навигацию, сделать доступ к нужной странице с главного меню не длиннее 3-х кликов. К юзабилити сайтов сегодня предъявляются повышенные требования, так как это напрямую влияет на поведенческие факторы посетителей. Если до нужной информации расстояние в 10-12 кликов, то 90% пользователей покинут такой сайт.

- Разместить ссылки на ресурс в соцсетях, на тематических форумах, досках объявлений и других площадках генерации трафика.

Часто требуется уменьшить вес изображений, так как «тяжелая» графика замедляет загрузку страниц, плохо сказывается на индексировании и дальнейшем продвижении в поисковой выдаче.

Как закрыть страницы от роботов?

Выше мы узнали, что такое индексация страниц сайта, зачем она нужна, как ускорить этот процесс. Поговорим теперь, как спрятать от проверки информацию на страницах и зачем это делать. Обычно запрет на сканирование ботами ПС устанавливают, чтобы скрыть от публичного просмотра технические и служебные страницы, конфиденциальную информацию, ресурсы в разработке, дубли и другое.

То есть, чтобы качественно продвигаться в поиске, нужно знать, какие данные показывать, а какие скрывать.

Поставить запрет на сканирование ботами можно несколькими способами:

- Использовать файл robots.txt. В документе можно запретить индексацию отдельной страницы, так и всего сайта целиком. Этот файл как раз и устанавливает правила для роботов ПС. Для запрета используются два основных оператора: указание адресата (User-agent) и запрещающая директива (Disallow), которая ставит «шлагбаум» для бота. Например, если сайт ещё не готов к запуску, то в роботсе можно прописать следующий код: User-agent: * и на следующей строке Disallow: /. Так вы закроете весь ресурс для роботов ПС.

- Прописать специальные теги в файле robots.txt. Обычно этот вариант используется для скрытия одной страницы от сканирования. Используются теги noindex и nofollow, которые запрещают ботам ПС проверять страницу или часть контента. Например, можно запретить работу конкретного бота следующим кодом: <meta name=»googlebot» content=»noindex, nofollow»/>.

На что влияет индексация?

Благодаря «прописке» в поисковых системах Яндекса и Гугла, сайты попадают в поле видимости пользователей и потенциальных клиентов. Сама по себе целевая страница в сети, онлайн-магазин или Landing Page не представляет ценности. Полезность её определяют посетители. Соответственно находясь в индексе и регулярно обновляя контент, ресурс растет в выдаче. Это увеличивает приток трафика и помогает развивать проект.

Роботы ПС оценивают не только качество контента, но и поведенческие факторы, посещаемость, вовлеченность. С помощью этих метрик определяется полезность сайта. Чем лучше поведенческие факторы аудитории, тем выше страницы в ранге.

Первые 20 строк поисковой выдаче собирают 95% всего трафика по запросу. Поэтому быть в индексе на хорошем счету у ПС – это гарантия успешного продвижения и высоких конверсий.

Резюме

Мы рассмотрели, что такое индексация сайта в поисковых системах Яндекс и Гугла. Изучили основные моменты добавления, проверки и ускорения «прописки» в ПС. Узнали, как и зачем выставлять запреты на сканирование страниц ботами. У индексации простая задача, но с далеко идущими последствиями – внести информацию о сайте в базу поисковых систем.

www.calltouch.ru

Индекс и индексация сайта: что это такое?

Индекс поисковых систем – специальная база данных, в которую заносится информация, собираемая поисковыми роботами со страниц сайтов. При этом учитывается текстовое наполнение, внутренние и внешние ссылки, графические и некоторые другие объекты. Когда пользователь задает запрос поисковой системе, происходит обращение к базе данных. После этого выполняется ранжирование по релевантности – формирование списка сайтов по мере убывания их значимости.

Что такое индексация

Процесс добавления роботами собранной информации в базу называется индексацией. Затем данные определенным образом обрабатываются и создается индекс – выжимка из документов. Процесс заполнения индекса осуществляется одним из двух способов: вручную или автоматически. В первом случае владелец ресурса должен самостоятельно добавить URL веб-ресурса в специальную форму, которая есть у «Яндекса», Google и других поисковых систем. Во втором робот сам находит сайт, планомерно переходя по внешним ссылкам с других площадок или сканируя файл-карту sitemap.xml.

Первые попытки индексировать веб-ресурсы были сделаны еще в середине 90-х годов прошлого столетия. Тогда база данных была похожа на обычный предметный указатель, в котором содержались ключевые слова, найденные роботами на посещенных ими сайтах. Почти за 30 лет этот алгоритм был значительно усовершенствован и усложнен. Например, сегодня информация перед попаданием в индекс обрабатывается по сложнейшим вычислительным алгоритмам с привлечением искусственного интеллекта.

Зачем индекс поисковым системам

Индексация страниц сайта – неотъемлемая часть работы поисковых систем (не только Google и «Яндекса», но и всех остальных). База, полученная в процессе сканирования веб-ресурсов, используется для формирования релевантной выдачи. Основные роботы поисковых систем:

- основной – сканирует весь контент на сайте и его отдельных страницах;

- быстрый – индексирует только новую информацию, которая была добавлена после очередного обновления.

Также существуют роботы для индексации rss-ленты, картинок и др.

При первом посещении в базу попадают все новые сайты, если они подходят под требования поисковой системы. Во время повторного визита информация лишь дополняется деталями.

Скорость индексации страниц

Чем быстрее происходит добавление страницы в индекс, тем лучше для веб-ресурса. Однако поисковые роботы не могут выполнять такой большой объем работы так же часто, как обновляется наполнение сайтов. Индексация в «Яндекс» в среднем занимает одну-две недели, а в Google – несколько дней. С целью ускорения индексации ресурсов, для которых очень важно быстрое попадание информации в базу (новостные порталы и т. д.), применяется специальный робот, посещающий такие сайты от одного до нескольких раз в день.

Как проверить индексацию в «Яндексе» и Google

Воспользоваться информацией из панели веб-мастеров. В списке сервисов Google откройте Search Console, а затем перейдите в раздел «Индекс Google». Нужная информация будет находиться в блоке «Статус индексирования». В «Яндекс.Вебмастер» необходимо перейти по следующей цепочке: «Индексирование сайта» — «Страницы в поиске». Еще один вариант: «Индексирование сайта» — «История» — «Страницы в поиске».

Задать поиск по сайту с использованием специальных операторов. Для этого используйте запрос с конструкцией «site:», указав далее адрес вашего ресурса в полном формате. Так вы узнаете количество проиндексированных страниц. Серьезные расхождения в значениях (до 80 %), полученных в разных поисковых системах, говорят о наличии проблем (например, веб-ресурс может находиться под фильтром).

Установить специальные плагины и букмарклеты. Это небольшие дополнения для браузера, которые позволяют выполнить проверку индексации страниц сайта. Одним из самых популярных среди них является RDS Bar.

Как ускорить индексацию

На скорость индексации сайта прямо влияют несколько факторов:

- отсутствие ошибок, замедляющих процесс сбора информации поисковым роботом;

- авторитетность ресурса;

- частота обновления контента на сайте;

- частота добавления нового контента на сайт;

- уровень вложенности страниц;

- корректно заполненный файл sitemap.xml;

- ограничения в robots.txt.

Чтобы ускорить индексацию сайта, выполните ряд правил:

- выберите быстрый и надежный хостинг;

- настройте robots.txt, установив правила индексации и сняв ненужные запреты;

- избавьтесь от дублей и ошибок в коде страниц;

- создайте карту сайта sitemap.xml и сохраните файл в корневой папке;

- по возможности организуйте навигацию таким образом, чтобы все страницы были в 3 кликах от главной;

- добавьте ресурс в панели веб-мастеров «Яндекса» и Google;

- сделайте внутреннюю перелинковку страниц;

- зарегистрируйте сайт в авторитетных рейтингах;

- регулярно обновляйте контент.

Дополнительно рекомендуем оценить объем flash-элементов с точки зрения их влияния на продвижение. Наличие визуальных объектов этого типа значительно снижает долю поискового трафика, так как не дает роботам выполнить индексацию в полной мере. Также не желательно размещения ключевой информации в PDF-файлах, сохраненных определенным образом (сканироваться может только текстовое содержимое документа).

wiki.rookee.ru

что это такое и 7 её способов ускорить

Всем привет!

В этой статье я расскажу о том, что такое индексация сайта. Уверен, многие прекрасно понимают значение этого термина, но я постараюсь рассмотреть его более глубоко.

Мы поговорим о том, как улучшить индексацию сайта, какие действия нужно выполнить для того, чтобы поисковые роботы относились к проекту лояльно. Также мы кратко затронем тему требований поисковых систем и санкций за их невыполнение.

Давайте начинать!

Определение

Представьте, что сайт – это документ или несколько документов с информацией. Поисковая система – сборник таких документов, работающий по определенным правилам. Он помогает пользователям в кратчайшие сроки найти документ с нужной информацией. Для этого необходимо проверить каждый документ, посмотреть, какого рода в нем информация, после чего разместить его где-то относительно других документов. Это и есть индексация.

Индексация – это добавление информации о сайте в базы данных поисковиков.

Роботы приходят, сканируют весь контент, если все хорошо, – контент заносится в поисковые базы и начинает ранжироваться относительно других проектов.

После этого материалы попадают в поисковую выдачу. Позиция в поисковой выдаче может зависеть от качества материалов, самого ресурса, технической и внешней SEO-оптимизации и других факторов.

Поисковые системы заинтересованы в том, чтобы их пользователи получали качественные материалы в выдаче. По этой причине поисковая оптимизация претерпела очень много изменений за последние годы.

Раньше вебмастеры старались угодить роботам, делая свои проекты максимально “удобными” для индексации. Сейчас же роботы научились отличать “сеошный” бесполезный контент, от качественного и адекватного.

Поэтому для хорошей индексации не хватит простой SEO-оптимизации. Нужно понимать, что сейчас поисковые системы отдают предпочтение ресурсам с хорошими поведенческими факторами. Их можно добиться только при разработке проекта для людей.

За переоптимизацию или создание некачественного бесполезного контента ресурс может попасть под санкции. Это может включать в себя как простое снижение приоритета, так и полный запрет индексации со стороны поисковиков – материалы проекта удаляются из поисковых баз данных и больше никогда туда не попадают.

Если устранить все ошибки и больше никогда не допускать их, поисковики возвращают сайт к нормальному состоянию. Для этого придется написать в техническую поддержку с просьбой о проверке текущего состояния проекта.

У каждой поисковой системы есть свои правила. В большинстве своем они почти ничем не отличаются, поэтому вебмастеры стараются оптимизировать свои проекты сразу и для всех.

Особенности работы с поисковыми системами

Яндекс и Гугл – два наиболее популярных поисковика в России и СНГ. В основном люди, работающие с информационными проектами, стараются оптимизировать их именно под эти сервисы.

Когда вы только создаете свой сайт, то поисковые системы еще ничего не знают о нем. Поэтому для того, чтобы ресурс попал в поисковую выдачу, вы должны каким-то образом сообщить сервисам о том, что он существует.

Для этого можно использовать два способа:

Способ 1. Разместить ссылку на каких-то сторонних проектах.

В этом случае проект будет проиндексирован максимально быстро. Поисковик посчитает, что ваш сайт полезный и интересный, поэтому он сразу направит роботов для анализа содержимого.

Способ 2. Сообщить поисковикам о ресурсе при помощи специальных инструментов.

В Яндексе и Гугле есть специальные сервисы для вебмастеров. С их помощью вы сможете отслеживать состояние своих ресурсов относительно поисковых систем: смотреть статистику, количество показов, кликов, добавленные или удаленные страницы и т. д.

При добавлении сайта в эти инструменты вы сообщаете поисковикам о том, что проект существует. И если нет никаких запретов через Robots.txt или мета-теги, то он будет проиндексирован и добавлен в выдачу.

Срок добавления сайта в базу данных может быть разным: от нескольких дней до недели. Но обычно с этим не затягивают, особенно если ресурс добавлен в Yandex.Webmaster и Search Console.

Не забывайте, что добавление в базу данных – еще не означает, что материалы сайта сразу будут доступны по определенным запросам. Для этого может понадобиться дополнительное время. Роботы тщательно изучат содержимое проекта, и только после этого статьи будут доступны к показу по запросам.

Если вы решите не открывать ресурс сразу, а подождать, пока он заполнится определенным количеством материалов, то после отправки на анализ может пройти чуть больше времени. То есть, чем больше информации на проекте, тем дольше придется ждать полной индексации.

В среднем между отправкой сайта в сервис и появлением статей в выдаче проходит 1 – 2 недели.

Помимо вышеописанных способов добавления ресурса в поисковую базу, существует еще один, менее эффективный. Вам просто нужно ввести в поисковую строку следующие команды:

- Для Яндекса: Host: Название + site.ru.

- Для Google: Site: Название + site.ru, где site.ru – ваш домен.

Также вы можете попробовать добавить ресурс при помощи автоматических сервисов. Какой будет результат – неизвестно. Но я полагаю, что эти сервисы просто воспользуются командами или размещением ссылки где-либо.

Как проверить индексацию

Проверка индексации – тоже очень важный момент. Нужно удостовериться, что все страницы были восприняты как надо.

Если вы добавили сайт через инструменты для вебмастеров, то статус индексации можно узнать прямо там – в соответствующем разделе. В нем будет дана подробная информация о том, когда робот посещал страницу последний раз, какой статус он ей присвоил и т. д.

Также вы можете проверить статус при помощи строки поиска. Для необходимо воспользоваться специальными операторами. Их можно найти в документации для Яндекса и Гугла.

Если вам нужна массовая проверка, то вы можете воспользоваться специальными сервисами:

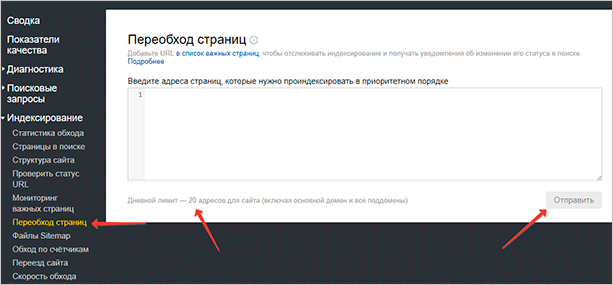

Отправление страницы на переобход

Если вы хотите, чтобы робот обошел материал еще раз, то вам необходимо отправить страницу на переобход. Это можно сделать при помощи панелей для вебмастеров.

В Яндекс.Вебмастере

Перейдите в “Индексирование” – “Переобход страниц”.

Введите адреса нужных документов в столбик – одна ссылка – одна строка. После этого нажмите кнопку “Отправить”. В течение нескольких часов робот Яндекса вновь проиндексирует материал.

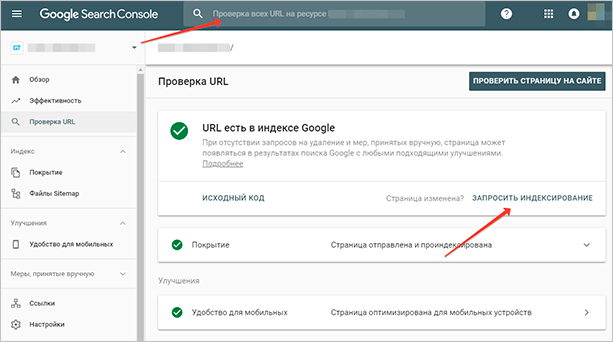

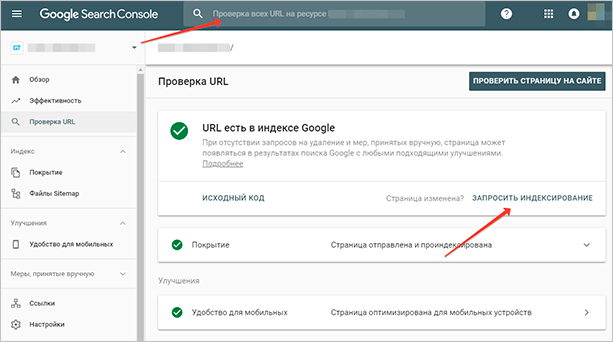

В Search Console

Нужно ввести нужный адрес в поле в верхней панели – далее кликнуть на кнопку “Запросить индексирование”.

Как ускорить индексацию

Чтобы ускорить индексацию, вы должны соблюсти несколько требований. В первую очередь, это добавление ресурса в поисковую систему – желательно через сервис для вебмастеров. Далее следуют повседневные рекомендации, выполняя которые, вы можете добиться ускорения этого процесса.

- Добавлять на сайт интересный контент. Будет лучше, если размещение материалов на ресурсе будет носить регулярный характер. В таком случае высока вероятность того, что на вашем проекте будут обитать быстроботы – они индексируют статьи в течение нескольких часов.

- Оптимизировать скорость загрузки при помощи сжатия картинок, оптимизации HTML, CSS, JS. Будет хорошо, если вы подберете для своего проекта быстрый виртуальный хостинг.

- Сформировать правильную структуру сайта, добавить функционал для удобной навигации. Поисковики могут оценивать, насколько ваш ресурс удобен для пользователей.

- Настроить перелинковку между материалами, рубриками и прочими страницами. Когда робот анализирует какую-то страницу со ссылками, он автоматически еще и индексирует те документы, на которые эти ссылки ведут.

- Создать правильный robots.txt. Вы должны закрыть ненужные технические страницы, оставив только само содержимое. Так в ранжирование не будет попадать мусор, это гарантирует, что ПС будут чаще посещать ваш проект.

- Создать XML-карту сайта и добавить ее в Яндекс Вебмастер и Search Console. С помощью этой карты Яндекс и Гугл будут ориентироваться по материалам. Это в значительной мере улучшит скорость анализа. Также можно сделать обычную карту сайта для пользователей. С ее помощью ваши гости смогут легко находить нужные статьи или рубрики. Это улучшит поведенческие факторы и видимость в ПС.

- Создать профили своего проекта в социальных сетях и регулярно размещать там ссылки на статьи. Это элемент крауд-маркетинга, который сейчас очень хорошо воспринимается ПС.

- Регулярно проверять сайт на ошибки и устранять их. Самые серьезные будут отображаться в сервисах для вебмастеров. Также вы можете закидывать ресурс на валидатор, чтобы определить ошибки в HTML/CSS-коде.

Раньше для этих целей использовали пингование. Оповещение ПС при помощи специальных плагинов или сервисов о выходе нового поста. Сейчас такой формат почти не используется. Яндекс и Гугл ограничили этот функционал, теперь в прежнем варианте пинг использовать нельзя.

Как закрыть сайт от индексации

Для этого мы можем использовать два способа:

Просто нужно удалить все содержимое этого файла, добавив вместо него:

User-agent: *

Disallow: /

С помощью этой строчки вы скажете всем поисковым роботам, что ваш ресурс индексировать не нужно – ни одной странички. Если до этого какие-то материалы попали в ранжирование – они будут удалены.

Также можно запретить индексацию для роботов какой-то отдельной поисковой системы. Для этого вместо звездочки, в User-agent: вы должны ввести название этого робота. Например, Yandex – для Яндекса, Googlebot – для Google.

Когда вы передумаете, вам нужно будет просто удалить этот код и добавить вместо него нормальное содержимое файла.

- С помощью мета-тегов

На каждой странице должны быть размещены следующие мета-теги:

<meta name=»robots» content=»noindex, nofollow»/>

<meta name=»Yandex» content=»noindex, nofollow»/> – если хотим закрыть для какой-то конкретной ПС, то в поле name вставляем имя робота.

Разместить такие мета-теги можно при помощи плагина Yoast SEO. В нем есть отдельные параметры, которые отвечают за индексацию. Можно закрыть как отдельную страницу, так и весь ресурс в целом.

Закрывать от индексации отдельные страницы при помощи мета-тегов считается хорошим тоном. Это и проще, и быстрее – не надо по многу раз дополнять файл robots.txt.

Заключение

Для того, чтобы ваш сайт хорошо индексировался, вы должны соблюдать совсем несложные требования. Нужно просто добавить его в Яндекс Вебмастер и Search Console, следить за регулярным выходом качественных материалов, своевременно исправлять ошибки и не нарушать правил.

Все это гарант того, что ваш проект будет на хорошем счету у роботов. А это, в свою очередь, будет иметь материальное значение. Ваши статьи будут выше в выдаче, дохода будет больше.

Некоторым новичкам бывает очень сложно разобраться со всеми тонкостями SEO-оптимизации. Очень много разной информации и не всегда она правильная. Если вы один из таких новичков, то я рекомендую вам пройти курс Василия Блинова “Как создать сайт”.

Из материалов с этого курса вы сможете узнать о том, как создать собственный информационный проект под монетизацию. Там рассмотрены наиболее важные нюансы, которые должен учитывать каждый вебмастер.

iklife.ru

Как сервер влияет на индексирование — Онлайн-курсы Яндекса

1. Немного теории

Чтобы попасть в поиск, сайт должен быть доступен для поисковых роботов. Иначе они не смогут его проиндексировать.

Одна из причин недоступности сайта — это сбой на сервере. В этом случае не только поисковые роботы, но и пользователи не смогут зайти на сайт. А если он будет недоступен продолжительное время, поисковые системы удалят его из своих баз, чтобы поддерживать их в актуальном состоянии. Поэтому важно следить за тем, чтобы сервер исправно отвечал на запросы.

У многих сервисов Яндекса есть свой поисковый робот. Например, свой робот есть у Поиска, Яндекс.Картинок, Яндекс.Видео, Яндекс.Каталога. И у каждого робота свои задачи и правила работы. Иногда сервер может быть настроен так, что он пропускает на сайт основной робот Яндекса, но не жалует роботов Яндекс.Видео и Яндекс.Картинок — это значит, что контент сайта, скорее всего, не попадёт на эти сервисы. Поэтому, если вы заметили, что какой-то тип контента плохо индексируется, проверьте, попадает ли нужный робот на ваш ресурс.

Проверить, отвечает сервер или нет, можно на сервисе Яндекс.Вебмастер — через инструмент «Проверка ответа сервера».

Тут нам предстоит заполнить форму. Указываем адрес сайта и выбираем поискового робота. Обратите внимание, что у Яндекса много роботов, каждый из которых решает свою задачу. Вот, например, основной поисковый робот. Выбираем его и нажимаем кнопку «Проверить».

Ответ готов.

Как видите, он состоит из нескольких пунктов. Давайте разберем самые важные из них. В первой строчке сообщается статус проверяемой страницы. Если сайт отвечает на запрос и доступен для поискового робота, Яндекс.Вебмастер показывает статус 200. Остальные статусы передают какую-то другую информацию. Например, статус 404 обозначает, что запрашиваемая страница была удалена. Описание статусов можно найти в разделе «Помощь» сервиса Яндекс.Вебмастер.

Переходим к строчке «Время ответа сервера». Чем меньше это время, тем лучше: поисковые роботы и пользователи смогут быстрее попасть на сайт.

В сообщении есть и другая информация. Например, мы можем посмотреть IP-адрес страницы, её кодировку и размер.

Совет

На сервисе Яндекс.Вебмастер вы можете получать уведомления о сбое в индексировании сайта. Если вы хотите получать уведомления о том, что сайт недоступен для пользователей, воспользуйтесь Яндекс.Метрикой. Она умеет присылать такие уведомления по смс или электронной почте.

yandex.ru