Локальный прокси-сервер для фильтрации браузерного трафика / Хабр

Хочу рассказать о процессе разработки и поделиться прокси-сервером, которым сам пользуюсь для фильтрации всяческого мусора и других задач, требующих просмотра или вмешательства в браузерный траффик. Возможно, аналогичный функционал уже где-то есть, но мне хотелось сделать конкретно под свои нужды с возможностью real-time дописывания кода под любую сиюминутно понадобившуюся мелочь. Ну и под не-мелочи тоже, но это уже дольше.

Первоначально была задача упростить посещение сайтов через медленное (около 5-10кбайт/с с лагами) подключение. Тут два основных направления: 1) вырезать всё что не нужно (в первую очередь рекламу), и 2) закешировать всё что можно закешировать без особого вреда для функционала посещаемых сайтов, даже когда сами сайты не разрешают кеширование в http-заголовках, а то и явно препятствуют ему, дописывая после урлов статических файлов знак вопроса с рандомным числом.

Предупреждение: реализация, описанная ниже, делалась для Linux-а, вроде бы работает на других *nix, но даже компиляция её на винде не рассматривалась (хотя возможность адаптировать, конечно, есть).

Черновой вариант: nginx + php-fpm

Тратить на всё это время не хотелось, поэтому было решено по-быстрому настроить связку nginx + php-fpm, из которых первый разбирал входящие подключения, включая https и перенаправлял их все, без разбора хостов и урлов, в один и тот же php-скрипт. Так же была маленькая программа на C, которая конвертировала http-proxy-протокол в обычный http(s)-трафик. То есть превращала запросы GET http://host/path HTTP/1.x в GET /path HTTP/1.x (имя хоста всё равно есть в Host-заголовке) и проксировала все https CONNECT’ы на локальный nginx. Как потом выяснилось, убирать http://host из http-запросов было не обязательно, nginx их принимает так же как и обычные.

PHP-скрипт, в свою очередь, собирал назад разложенный по разным переменным запрос, через fsockopen() подключался к целевому серверу (благо там поддержка SSL встроенная), слал собранный http-запрос, забирал ответ и отправлял его браузеру с помощью header() и echo. Скрипт делался не совсем с нуля, спасибо некоей Évelyne Lachance за https://github.com/eslachance/php-transparent-proxy (но всё же то, что по ссылке, имеет несколько другую цель и поэтому просто скопировать его было нельзя).

Скрипт делался не совсем с нуля, спасибо некоей Évelyne Lachance за https://github.com/eslachance/php-transparent-proxy (но всё же то, что по ссылке, имеет несколько другую цель и поэтому просто скопировать его было нельзя).

Тут возникли две проблемы

Во-первых, если собрать сам исходный URL труда не представляло, то содержимое POST-запросов собирать было уже сложнее, а если там ещё и необычный Content-Type и отправка файлов — то php-шный парсер почти необратимо терял исходные данные, собрать всё это назад из массива $_POST[] и уже залитых в серверную файловую систему загруженных файлов, ничего не потеряв, было почти нереально (по крайней мере по моей оценке). Но спасла положение весьма кстати появившаяся в php 5.4 опция enable_post_data_reading — если её поставить в off, то тело запроса парситься не будет и его можно будет просто прочитать блобом из файла ‘php://input’. При этом массивы $_POST и $_FILES, естественно, не будут инициализироваться, но они нам и не нужны.

Во-вторых, nginx не умеет генерить сертификаты на лету из коробки, а настройку «игнорировать все проблемы с сертификатами» я в firefox не нашёл. Проблема была на тот момент решена патчем браузера, заставлявшим его любой сертификат считать доверенным и подходящим. Наверно были и другие способы это сделать, но все они казались сложнее. Патч естественно был кривой и сделанный почти методом тыка (желания изучать весь браузерный код проверки сертификатов не было), но он делал своё дело, а больше было и не надо.

Между сборкой исходного запроса и отправкой проксированного тривиальным образом были добавлены два куска кода. Один проверял, что host или host/path не из чёрного списка (организованного в виде отдельного php-файла с массивом внутри). Второй проверял, нет ли страницы в кеше (если есть — отдаётся из кеша). Если страницы в кеше нет, то делается проксированный запрос. Если запрос был GET и статус ответа 200, то полученная страница — кандидат на запоминание в кеше. Запоминать или нет — решалось функцией, которая по хосту, урлу (там просто были прописаны конкретные адреса, которые меня интересовали и которые я знал что надо кешировать) и content-type выносила вердикт. Кешировалось немного: http-статус, content-type и тело ответа. И при отдаче из кеша, соответственно, отдавались только эти данные, а все остальные заголовки, которые были в исходном ответе, безвозвратно терялись.

Кешировалось немного: http-статус, content-type и тело ответа. И при отдаче из кеша, соответственно, отдавались только эти данные, а все остальные заголовки, которые были в исходном ответе, безвозвратно терялись.

Вот такая грубая и костыльная реализация, на удивление, вполне себе работала, хотя конечно артефакты её присутствия время от времени проявлялись и раздражали.

В следующие полгода использования система дорабатывалась под решение возникающих проблем (как проблем из-за общей её кривости, так и проблем — возникающих задач).

Ещё через 3-4 месяца мне надоело патчить браузер после каждого апдейта и было решено сделать всё по-нормальному — nginx и php выкидываем и пишем всё на C.

Итоговый вариант

Маленькая программа (из старой версии), которая разбирала и перенаправляла прокси-протокол, была взята за основу. Первоочерёдной задачей было реализовать в ней разворачивание https, потому что всё остальное в общем-то уже известно как делать (делалось не раз в другим проектах), а с SSL где-то кроме php я на тот момент ни разу не работал.

Для этого взял библиотеку OpenSSL. Весь код, её использующий, было решено выделить в отдельные процессы. Потому что, во-первых, в ней тогда постоянно находились дыры (а межпроцессная изоляция может эту проблему иногда сгладить), во-вторых так проще делать (модульность и инкапсуляция на уровне сокетов), и в-третьих API OpenSSL местами весьма странное (мягко говоря), и для нейтрализации последствий то ли кривого API, то ли неправильного его применения (вследствие отсутствующей или двусмысленной документации) удобно просто убивать ssl-процесс после того как соединение завершилось (к сожалению, это плохо сказывается на производительности, но я с этим смирился).

Жалобы на OpenSSL и на SSL

Вообще, из-за регулярных уязвимостей и невнятного API я даже собирался написать свою реализацию TLS, и даже начал, но, дойдя до парсинга сертификатов (увы, без этого почти ничего не сделать, ибо сертификаты оказывается используются не только для защиты от подмены сервера, но и для согласования ключей, даже если защита от подмены не нужна), испытал ещё один дискомфорт от спецификации ASN1. Стало понятно, что API библиотеки это только вершина айсберга, а внутри оно всё такое уже начиная с RFC самого протокола. Хотя в последнее время я более менее с этим всем смирился.

Стало понятно, что API библиотеки это только вершина айсберга, а внутри оно всё такое уже начиная с RFC самого протокола. Хотя в последнее время я более менее с этим всем смирился.

SSL/TLS-обёртки

Итак, были сделаны две вспомогательные программы, одна для заворачивания клиентского нешифрованного сокета в SSL/TLS, и вторая для разворачивания зашифрованного сокета, принятого сервером, в незашифрованный. Принцип простой: у подпрограммы есть наследуемые от родительской программы файловые декрипторы, которые родительская программа может заранее открыть нужным образом так, что дочерний процесс будет выглядеть для неё просто сокетом, в который можно записывать и из которого можно читать. При этом практически никакого отличия этого межпроцессного сокета от сокета интернетного не будет.

Таким образом, сервер принимает (accept) входящее подключение, выясняет что на той стороне хотят SSL/TLS, после чего отдаёт соединение дочернему процессу (который поднимает SSL/TLS-сессию, генерирует сертификат если нужно или берёт уже ранее сгенерированный), а от дочернего процесса берёт межпроцессный сокет, через который передаются уже нешифрованные данные.

Аналогично и на клиентской стороне, только в обратную сторону: клиент запускает дочерний шифрующий процесс, шлёт данные в межпроцессный сокет, а дочерний процесс уже обеспечивает их шифрование прозрачно для клиента.

Программы названы ssl-server-wrapper и ssl-client-wrapper. Кстати, второй можно запустить и отдельно вручную — тогда нешифрованный канал будет направлен в терминал, откуда его запустили, а установить SSL-соединение можно, набрав несколько простых команд.

Пример

Пишем

$ host ya.ru - узнаём ip-адрес ya.ru has address 87.250.250.242 $ ./ssl-client-wrapper T/etc/ssl/certs/ca-certificates.crt - указать место где хранятся доверенные RootCA C87.250.250.242:443/ya.ru - подключиться по указанному адресу с указанным SNI

Ответ (много отладочных логов, можно скомпилировать чтобы было без них): дамп сертификата и предоставленной цепочки

DEBUG: cert[-1] subject = /C=RU/O=Yandex LLC/OU=ITO/L=Moscow/ST=Russian Federation/CN=*.yandex.az DEBUG: cert[-1] issuer = /C=RU/O=Yandex LLC/OU=Yandex Certification Authority/CN=Yandex CA DEBUG: cert[0] subject = /C=RU/O=Yandex LLC/OU=ITO/L=Moscow/ST=Russian Federation/CN=*.yandex.az DEBUG: cert[0] issuer = /C=RU/O=Yandex LLC/OU=Yandex Certification Authority/CN=Yandex CA DEBUG: cert[1] subject = /C=RU/O=Yandex LLC/OU=Yandex Certification Authority/CN=Yandex CA DEBUG: cert[1] issuer = /C=PL/O=Unizeto Technologies S.A./OU=Certum Certification Authority/CN=Certum Trusted Network CA DEBUG: cert[2] subject = /C=PL/O=Unizeto Technologies S.A./OU=Certum Certification Authority/CN=Certum Trusted Network CA DEBUG: cert[2] issuer = /C=PL/O=Unizeto Sp. z o.o./CN=Certum CA

Попытка собрать trusted цепочку

DEBUG: cert[-1] issued by cert[1] DEBUG: cert[1] issued by cert[2] DEBUG: cert[2]=cert[*0] was not issued by something from trusted-cert-store - chain incomplete, trying to recover DEBUG: cache miss at ./cert-pin/cache/9nqv0qm41tlxyel95bbods0famxjagbx.0 DEBUG: downloading AIA issuer cert: http://repository.certum.pl/ca.cer DEBUG: cert[*0] issued by cert[*1] DEBUG: cert[*1] is self-signed, chain ended

Как видно, «Certum CA» нет в списке доверенных Root CA, поэтому на первый взгляд это обрыв цепочки, но во втором сертификате цепочки (cert[2]) нашлась ссылка http://repository.certum.pl/ca.cer откуда можно скачать этот неизвестный сертификат; сертификат скачан (cert[*1]), но оказался самоподписанным и таким образом ничему не помогающим. На самом деле, в Root CA есть «Certum Trusted Network CA», так что всё в порядке и можно было ничего не скачивать.

Проверка соответствия доменного имени:

DEBUG: check wildcard '*.yandex.az' against needed name 'ya.ru' DEBUG: check wildcard '*.yandex.tm' against needed name 'ya.ru' DEBUG: check wildcard '*.yandex.com.ua' against needed name 'ya.ru' DEBUG: check wildcard '*.yandex.de' against needed name 'ya.ru' DEBUG: check wildcard 'yandex.jobs' against needed name 'ya.ru' DEBUG: check wildcard '*.yandex.net' against needed name 'ya.ru' DEBUG: check wildcard '*.xn--d1acpjx3f.xn--p1ai' against needed name 'ya.ru' DEBUG: check wildcard '*.yandex.com.ge' against needed name 'ya.ru' DEBUG: check wildcard 'yandex.fr' against needed name 'ya.ru' DEBUG: check wildcard '*.yandex.fr' against needed name 'ya.ru' DEBUG: check wildcard 'yandex.kz' against needed name 'ya.ru' DEBUG: check wildcard 'yandex.aero' against needed name 'ya.ru' DEBUG: check wildcard '*.yandex.jobs' against needed name 'ya.ru' DEBUG: check wildcard '*.yandex.ee' against needed name 'ya.ru' DEBUG: check wildcard 'yandex.com' against needed name 'ya.ru' DEBUG: check wildcard 'yandex.tm' against needed name 'ya.ru' DEBUG: check wildcard 'yandex.ru' against needed name 'ya.ru' DEBUG: check wildcard '*.yandex.ru' against needed name 'ya.ru' DEBUG: check wildcard 'yandex.lv' against needed name 'ya.ru' DEBUG: check wildcard '*.yandex.lt' against needed name 'ya.ru' DEBUG: check wildcard 'yandex. az' against needed name 'ya.ru' DEBUG: check wildcard 'yandex.net' against needed name 'ya.ru' DEBUG: check wildcard 'yandex.lt' against needed name 'ya.ru' DEBUG: check wildcard 'ya.ru' against needed name 'ya.ru'

Итог:

DEBUG: protocol = TLSv1.2 DEBUG: cipher = ECDHE-RSA-AES128-GCM-SHA256 DEBUG: verify_result = 0 DEBUG: server_cert subject: /C=RU/O=Yandex LLC/OU=ITO/L=Moscow/ST=Russian Federation/CN=*.yandex.az DEBUG: server_cert issuer: /C=RU/O=Yandex LLC/OU=Yandex Certification Authority/CN=Yandex CA OK: connection to 87.250.250.242:443/ya.ru established

Теперь есть прозрачное подключение, шлём http-запрос и получаем ответ

GET / HTTP/1.0 Host: ya.ru Connection: close HTTP/1.1 200 Ok Accept-CH: Viewport-Width, DPR, Device-Memory, RTT, Downlink, ECT Accept-CH-Lifetime: 31536000 (...)

Основной функционал

С шифрованием разобрались, теперь можно приступить к обработке полезной нагрузки.

Так как nginx у нас больше нет, то парсинг запроса придётся реализовывать заново. В целом ничего сложного тут нет, сначала парсятся заголовки через \r\n или \n разделитель, до тех пор пока не встретится пустая строка, а затем, если был заголовок Content-Length, читается тело запроса указанного количества байт. Chunked encoding в запросах можно и не поддерживать — никакие нормальные браузеры, да и вообще http-клиенты, его не генерируют.

В целом ничего сложного тут нет, сначала парсятся заголовки через \r\n или \n разделитель, до тех пор пока не встретится пустая строка, а затем, если был заголовок Content-Length, читается тело запроса указанного количества байт. Chunked encoding в запросах можно и не поддерживать — никакие нормальные браузеры, да и вообще http-клиенты, его не генерируют.

После того, как запрос распарсен, он попадает в обработчик запроса — это та часть, которая раньше была написана на php, весьма увеличившаяся в размерах и количестве файлов. И хотя списки правил (кого блокировать, кого кешировать, кому резать куки и т.д.), ранее бывшие оформлены в виде php-массивов и коротких скриптовых функций, были переделаны в отдельные текстовые файлы специального удобного формата, но часть «пользовательской» логики всё ещё защита в коде (только теперь на C а не PHP), а код в целом унаследовал много признаков «сделать побыстрее как-нибуть» от своего предшественника. Сейчас обработчик (кроме капитально переделанных списков правил) всё так же сделан в виде одного «потока» кода из «главного» файла и вставленных в него include (не заголовочных файлов а сам код).

Изначально функционал обработчика был даже чуть меньше чем функционал последней из старых версий, но за 2 года плавно набрал ещё много нового. Из последнего — последние полгода-год всё чаще стали попадаться сайты с неполными цепочками сертификатов (потому что браузеры теперь их поддерживают без ругани), сначала я их просто вносил в белый список исключений, но это стало происходить слишком часто и пришлось реализовать кеширование и докачивание недостающих сертификатов в цепочке.

Что получилось

Отдельные модули для разворачивания шифрованного SSL/TLS-туннеля, один из которых при желании можно использовать как самостоятельную программу типа ssl-telnet. Ещё можно заменить их на какие-то альтернативные реализации (например с другой крипто-библиотекой), при этом остальная часть прокси ничего не заметит. Аналогично с инкрементальными обновлениями, ничего даже не нужно перезапускать. А ещё можно их использовать как демки по работе с OpenSSL (я прочёл много документации и всяких обсуждений в процессе их написания, возможно кто-то сможет теперь всё это быстрее усвоить).

- У клиента есть хранилище сертификатов для: белый список по сайтам (принимать и не проверять), чёрный список по сайтам (не проверять и не принимать), список вопросов (те, которые не входят ни в белый, ни в чёрный и не прошли валидацию — аналог браузерной страницы с предложением внести подозрительный сертификат в список исключений). Для сайтов можно включать режим белого списка (то есть принимать только сертификаты из него, остальные считать недоверенными). К сожалению, всё это делается путём манипуляций над файлами, интерактивного приложения пока нет.

- Серверная часть сама генерирует сертификаты ко всем сайтам на лету, ей нужен только корневой сертификат, добавленный как trusted root CA в браузер.

Возможность пробросить точку выхода в интернет через, например, ssh port forwarding (связанный с этим функционалом код расположен в helpers/remote.c и в proxy.c в месте где обрабатывается аргумент «—proxy».

Единообразный формат файлов правил для: блокировки загрузки страниц, блокировки куков, управления кешированием, включения сниффера, включения raw-режима (для real-time стримингов).

Аналог /etc/hosts но усовершенствованный: возможность сопоставления айпи-адреса не только по хосту, но и по порту и по протоколу, а так же сменить порт и протокол подключения.

Кеш, управляемый прописанными ему настройками, а не заголовками, присланными сервером. Заголовки управления кешированием часто не отражают действительность (или отражают мнение владельца сайта, которое может расходиться с критериями удобства пользования этим сайтом), поэтому сейчас они игнорируются. Думаю что стоит сделать их учёт по принципу «если сайт разрешил кешировать то значит можно, а если нет — разбираемся сами можно или нельзя», но пока руки не дошли.

- Кроме кеша есть ещё сохранения — это те страницы, которые не берутся с диска при запросе к ним, но на всякий случай всё равно сохраняются. При включении оффлайн-режима они тоже смотрятся (в файл offline.flag надо прописать предпочтительное время, за которое будут искаться сохранённые страницы при обращении к ним). При настройке сохранений учтите, что, несмотря на то, что сохраняются только ответы (содержимое POST-запросов не сохраняется), в них всё же могут быть некоторые данные, которые стоит беречь от кражи, а сохранённые на диске страницы — дополнительный вектор атаки.

Возможность кастомных действий перед, после или вместо загрузки страницы проксированным запросом. Реализваны хардкодом, файл handle/inc.rewrite.c

Есть dashboard (двоичный файл со статусами всех потоков прокси) и программа для его вывода на экран в удобном виде.

./dashboard --basedir=/path/to/proxy/base --highlight --loopЛюбой аспект работы прокси можно легко переделать при необходимости. Код, несмотря на то, что он весьма разросся по сравнению с первыми версиями, всё ещё занимает очень мало места, и не потребует много времени как на первоначальное изучение, так и на освежение в памяти забытых деталей. С другой стороны, кому-то это и минус — для пользования всеми возможностями программы предполагается её регулярная пересборка и правка кода, а не «скомпилировал и удалил исходники».

Плюсы и минусы

(+) Модульность

(-) Из-за изоляции OpenSSL работает медленнее чем могло бы

(+) Гибкая настраиваемость под конкретные нужды

(+-) Много настроек прямо в исходном коде в виде #define и не только

(+-) IPv6 не поддерживается

(-) Нет интерактивного приложения для настройки и управления

(-) Код местами весьма плох и костылен

(-) До сих пор нет поддержки Access-Control-Allow-Origin с не ‘*’ в закешированных ответах — но единственное что у меня от этого ломалось это интерфейс мэйлру почты.

(-) До сих пор нет поддержки учёта настроек кеширования, присылаемых сервером

(-) Скачивать через него большие файлы (не в raw режиме) неэффективно — сначала прокси скачает файл себе на диск, затем будет через localhost-сеть отдавать его браузеру, который опять будет сохранять его на диск, а ещё там где-то (а может и в нескольких местах) прописано ограничение в 10мбайт на запрос

Как собрать/установить и технические детали кода

Из обычных библиотек используются стандартная C-библиотека, zlib (для распаковки gzip http-ответов), openssl (линкуется только к ssl-подпрограммам). В случае с Debian это были пакеты zlib1g-dev и libssl-dev. Так же используются свои библиотеки (маленькие) с кодом который мне часто оказывается нужен в разных местах и поэтому вместо регулярного копипаста выделен в отдельные компилируемые единицы.

В целях данной публикации, для упрощения всё это собрано в один пакет (скачать можно тут) и обёрнуто в один сборочный скрипт (да, не Makefile, так уж вышло что пока я обхожусь без make) build-all. sh.

sh.

Ряд настроек расположен в исходниках: в скрипте fproxy/build2.sh, в файле fproxy/config.h (если у вас файл с бандлом доверенных центров сертификации расположен не в /etc/ssl/certs/ca-certificates.crt то надо этот путь заменить тут). Настройки подпрограмм (helpers/) расположены прямо в их коде вверху в виде #define (config.h они не используют), но их менять вряд ли кому потребуется.

То, что некоторая часть настроек прописана в компилируемом коде, а не в файлах настроек сделано для (моего) удобства. В файлах настроек настраивается то, что можно назвать наиболее часто меняющимися пользовательскими настройками (списки правил), а всё остальное — в общем то первоначальная настройка программы при её установке, и крайне редкие изменения всяких технических параметров (даже чаще меняется логика работы кода чем #define-настройки). По факту сейчас вполне рабочая версия получается если просто запустить build-all.sh и не трогать никакие исходники перед этим.

Но переделать код на приём настроек через командную строку или из ещё одного файла конфигурации несложно.

Для работы прокси нужна заранее подготовленная структура директорий. Для её создания есть скрипт prepare-dir.sh — он создаёт рядом подготовленную директорию fproxy-target/ со всем что требуется и кладёт туда примеры правил (в том числе много блокировок спамных доменов).

| Путь | Описание: |

|---|---|

| cache/ | Симлинки на второй уровень cache_real/. |

| cache_real/ | Кеш, двухуровневая структура — домен 2 уровня, потом полный домен. |

| saved/ | Симлинки на второй уровень saved_real/. |

| saved_real/ | Сохранённый не-кеш, 2-ур. структура. |

| cert-pin/certs/ | Настройки сертификатов для каждого домена (общий режим, белый/чёрный списки, вопросы). |

| cert-pin/queue/ | Тут создаются файлы при появлении вопросов в качестве флажков для интерактивной программы управлением этими настройками, если она будет. |

| cert-pin/cache/ | Кеш известных проксе сертификатов для дополнения неполных цепочек, принятых от сайтов (это НЕ список доверия, все эти сертификаты действительны только после прохождения проверок на общих основаниях). |

| dyn-certs/ | Кеш для сгенерированных сертификатов которые шлются браузеру. |

| hist/ | Сохранённая история посещений (инструментов для её просмотра пока нет, кроме ручного). |

| internal/ | Сейчас тут хранится сокет для запросов от скачивателя AIA сертификтов к проксе. |

| log/ | Логи. |

| pem/ | Корневой сертификат и приватные ключи для генерации сертификатов сайтов. |

| proxy_temp/ | Хранение запросов которые слишком большие для хранения их в памяти. |

| tmp/ | Временные файлы. |

| dyn-cert-serial | Файл с текущим серийным номером генерируемого сертификата (начальное содежание — символ ‘0’ и перевод строки после него). |

| mincache.date | Если файл есть и в нём тут записано число больше 0, то весь кеш раньше этого времени будет игнорироваться. |

| offline.flag | Если файл есть и в нём тут записано число больше 0, то прокси будет работать в режиме «интернет-архива» — на каждый запрос сначала искать в saved_real/ данные, близкие по времени к указанному числу, и только если не нашлось — проксировать запрос. |

| rules_*.txt | Различные правила, на данный момент их изменения учитываются только после перезапуска прокси. |

Насчёт прав доступа и вообще безопасности

Простейший вариант установки — запустить всё из под своего обычного юзера с обычными правами на всё (можно даже прямо из директории fproxy-target/, созданной скриптом prepare-dir.sh).

Но по ряду причин имеет смысл сделать по-другому. Для прокси создаётся отдельный юзер и группа, ему выдаются эксклюзивные права на чтение данных прокси, и права на запись в несколько мест, где они нужны. Права «только чтение» можно реализовать, поставив владельца root и группу прокси, и поставив доступ 0640 или 0750. Делать что бы то ни было из данных world-readable в любом случае плохая идея, всё же там лежит вся история браузера, а где-то и сохранённое содержание страниц, а так же ключи, с помощью которых браузеру можно делать MITM.

Права «только чтение» можно реализовать, поставив владельца root и группу прокси, и поставив доступ 0640 или 0750. Делать что бы то ни было из данных world-readable в любом случае плохая идея, всё же там лежит вся история браузера, а где-то и сохранённое содержание страниц, а так же ключи, с помощью которых браузеру можно делать MITM.

Для работы программы dashboard ей нужен только доступ на чтение к файлу BASE/log/dashboard и ничего другого.

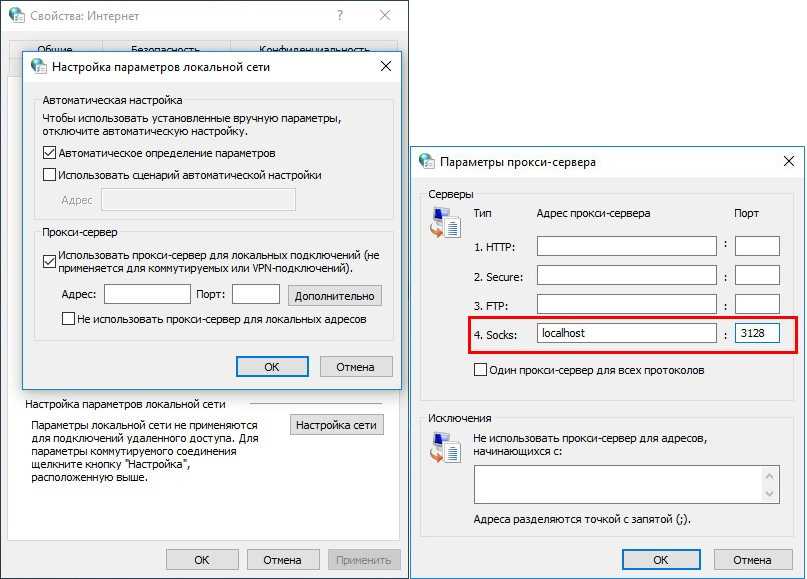

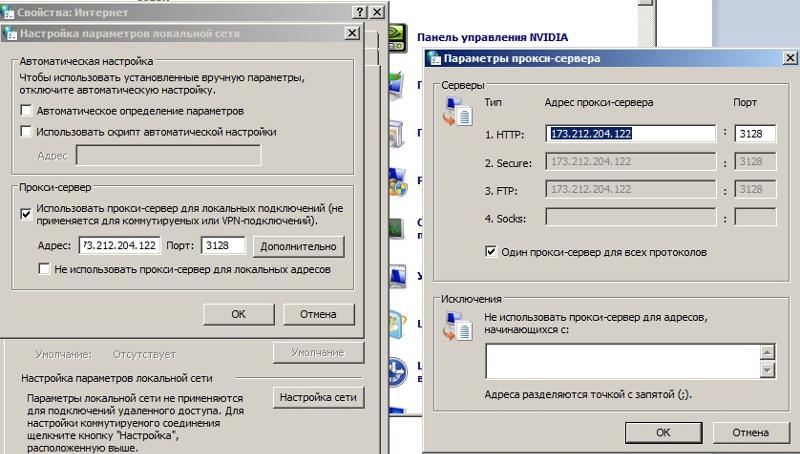

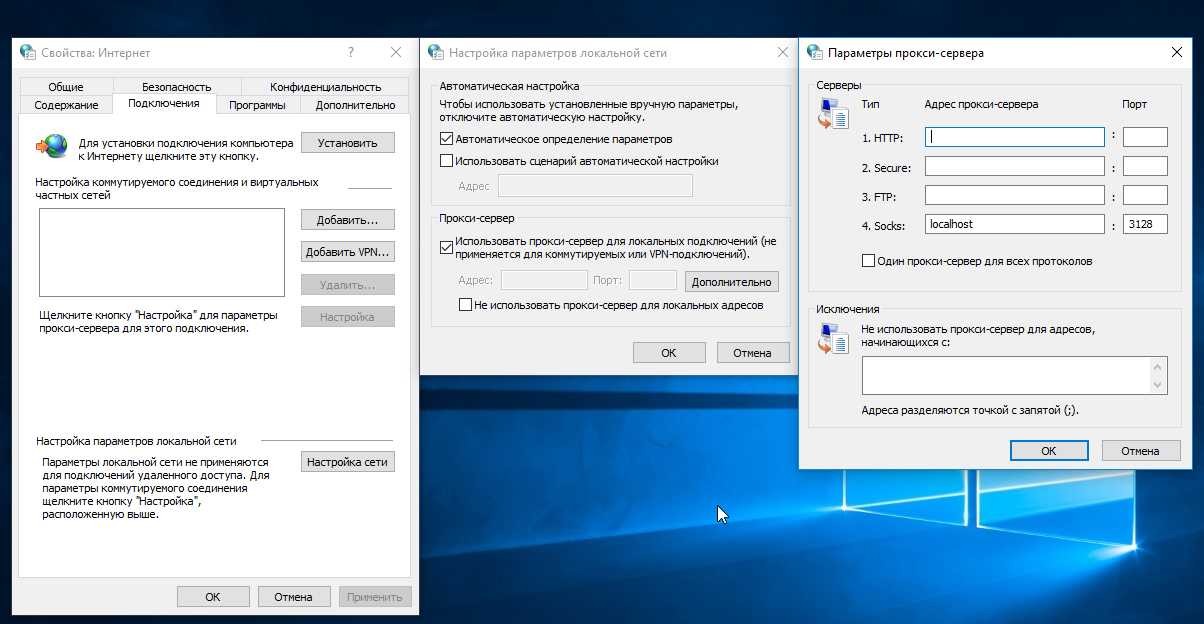

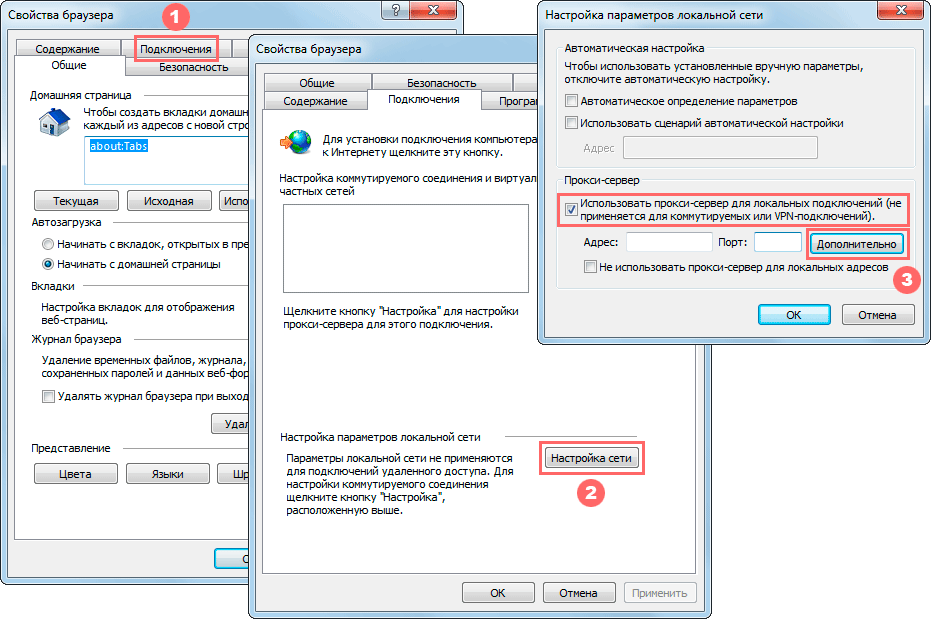

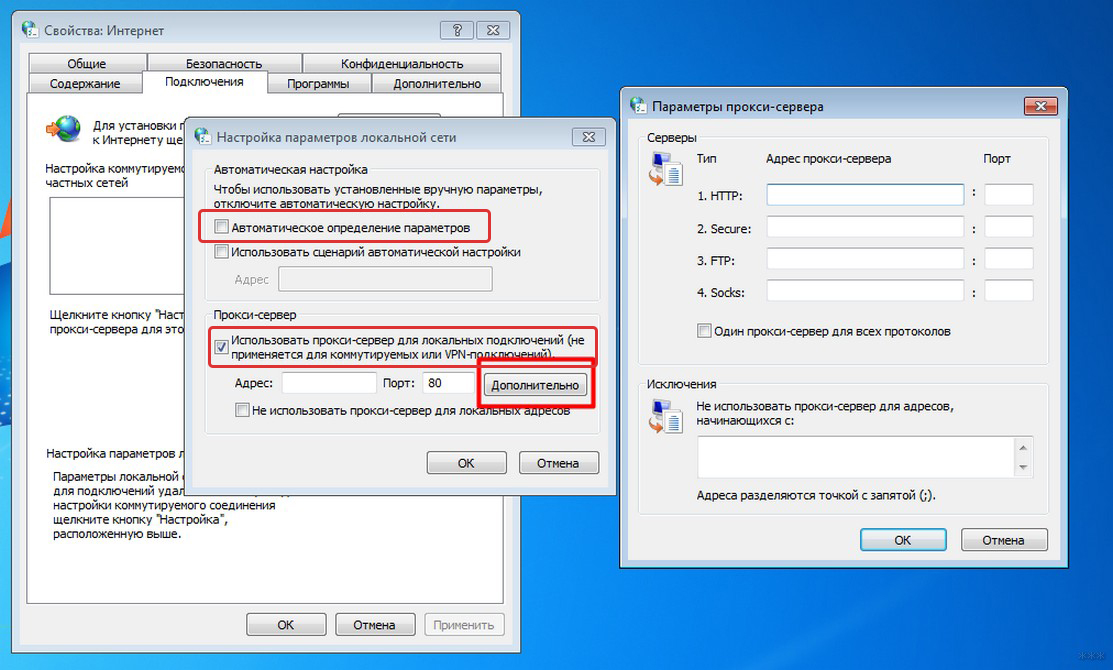

По умолчанию прокси слушает 127.0.0.10:3128. Для работы с 127.0.0.10 у меня ничего специально настраивать (в ОС) не пришлось, но возможно в каких-то системах нужно.

Рабочая директория по умолчанию — та, что была текущей при запуске, но это можно поменять в настройках.

Заключение

Ещё раз ссылка на скачивание: тут.

Для публикации код был дооформлен в такой вид, который на мой взгляд допустимо публиковать, но всё же делалось это исключительно для себя под локальное применение и «по-быстрее», так что сейчас код во многих местах не образец для подражания. Но основную задачу он выполняет, а со временем будет улучшаться.

Но основную задачу он выполняет, а со временем будет улучшаться.

Из наиболее приоритетных на данный момент планов на будущее в плане функционала — сделать интерактивную настройку и управление (сертификаты, кеш, история, менеджер загрузок больших файлов) либо отдельным приложением, либо в спецдомене через браузер, но ничего не обещаю.

Надеюсь, что кому-то это всё окажется интересным и так или иначе поможет.

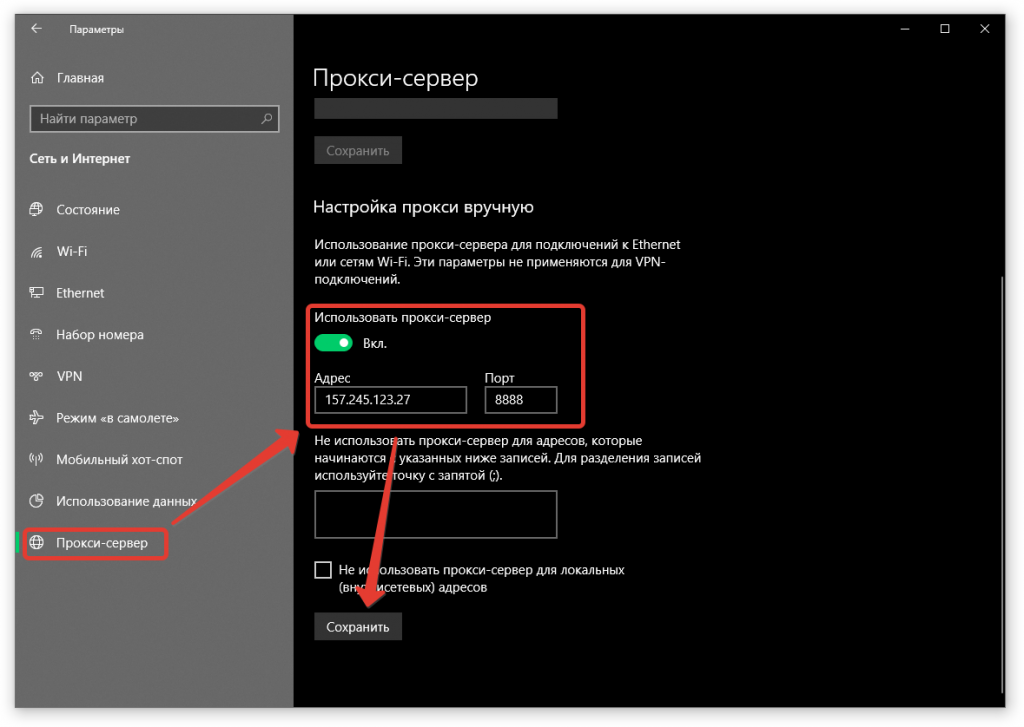

Настройка параметров прокси-сервера для локального шлюза данных

- Статья

- Чтение занимает 3 мин

Рабочим средам может понадобиться, чтобы доступ в Интернет осуществлялся через прокси-сервер. Это требование может препятствовать подключению локального шлюза данных Майкрософт к службе.

Это требование может препятствовать подключению локального шлюза данных Майкрософт к службе.

В следующей записи на superuser.com обсуждается, как вы можете попытаться определить, есть ли прокси-сервер в вашей сети: Как узнать, какой прокси-сервер используется? (SuperUser.com).

Хотя большинство параметров конфигурации шлюза можно изменить с помощью приложения локального шлюза данных, информация о прокси-сервере настраивается в файле конфигурации .NET. Расположение и имена файлов зависят от используемого шлюза.

Есть три файла конфигурации, связанных с использованием прокси-сервера с локальным шлюзом данных. К шлюзу и процессу его настройки применяются следующие два основных файла конфигурации.

- Первый файл предназначен для экранов конфигурации, используемых непосредственно для настройки шлюза. Если у вас есть проблемы с настройкой шлюза, посмотрите на следующий файл: C:\Program Files\On-premises data gateway\enterprisegatewayconfigurator.exe.config.

- Второй файл предназначен для фактической службы Windows, которая взаимодействует с облачной службой с помощью шлюза.

Этот файл обрабатывает запросы: C:\Program Files\On-premises data gateway\Microsoft.PowerBI.EnterpriseGateway.exe.config.

Этот файл обрабатывает запросы: C:\Program Files\On-premises data gateway\Microsoft.PowerBI.EnterpriseGateway.exe.config.

Если вы собираетесь внести изменения в конфигурацию прокси-сервера, эти файлы необходимо отредактировать так, чтобы конфигурации прокси-сервера были одинаковыми в обоих файлах.

Третий файл конфигурации необходимо отредактировать, чтобы шлюз мог подключаться к облачным источникам данных через прокси.

- C:\Program Files\On-premises data gateway\m\Microsoft.Mashup.Container.NetFX45.exe.config

В следующем разделе описывается, как редактировать эти файлы.

Настройка параметров прокси

В следующем примере показана конфигурация прокси-сервера по умолчанию, имеющаяся в обоих основных файлах конфигурации.

<system.net>

<defaultProxy useDefaultCredentials="true" />

</system.net>

В конфигурации по умолчанию применяется аутентификация Windows. Если прокси-сервер использует другую форму проверки подлинности, необходимо изменить параметры. Если вы не уверены, обратитесь к администратору сети.

Если вы не уверены, обратитесь к администратору сети.

Не рекомендуем использовать базовую проверку подлинности прокси-сервера. Использование базовой проверки подлинности прокси-сервера может привести к ошибкам, и в результате будет неправильна настройка шлюза. Чтобы устранить ошибку, выберите более надежный механизм проверки подлинности прокси.

Помимо использования учетных данных по умолчанию, можно добавить элемент <proxy>, чтобы более детально определить параметры прокси-сервера. Например, можно указать, что локальный шлюз данных всегда должен использовать прокси-сервер даже для локальных ресурсов, присвоив параметру bypassonlocal значение false. Этот параметр может помочь при устранении неполадок, если нужно отслеживать все HTTPS-запросы, исходящие из шлюза данных, в файлах журнала прокси-сервера. В соответствии с приведенным ниже образцом конфигурации все запросы должны передаваться через определенный прокси-сервер с IP-адресом 192.168.1.10.

<system.net> <defaultProxy useDefaultCredentials="true"> <proxy autoDetect="false" proxyaddress="http://192.168.1.10:3128" bypassonlocal="false" usesystemdefault="true" /> </defaultProxy> </system.net>

Вам также необходимо отредактировать файл Microsoft.Mashup.Container.NetFX45.exe.config, если вы хотите, чтобы шлюз подключался к облачным источникам данных через шлюз.

В файле разверните раздел <configurations>, чтобы включить указанное ниже содержимое, а также обновите атрибут proxyaddress, добавив сведения о прокси-сервере. Следующий пример перенаправляет все запросы облака через определенный прокси-сервер с IP-адресом 192.168.1.10.

<configuration>

<system.net>

<defaultProxy useDefaultCredentials="true" enabled="true">

<proxy proxyaddress="http://192.168.1.10:3128" bypassonlocal="true" />

</defaultProxy>

</system. net>

</configuration>

net>

</configuration>

Настройка этого третьего файла может потребоваться, если ваш прокси-сервер является обязательным для всего обмена данными через Интернет, особенно для корпоративного использования, когда сети безопасны и заблокированы. Если прокси-сервер нужен для обмена данными через шлюз, он, вероятно, также понадобится для любого интернет-трафика из контейнеров. В этом случае может показаться, что шлюз работает успешно, пока какой-либо контейнер не сделает внешний (через Интернет) запрос. Эта проблема особенно применима к потокам данных, которые пытаются отправить результирующий запрос локальных данных в Azure Data Lake Storage. Но это также применимо, когда запрос шлюза объединяет локальный набор данных с привязанным к Интернету набором данных.

Дополнительные сведения о настройке элементов прокси-сервера в файлах конфигурации .NET см. в статье об элементе defaultProxy (параметры сети).

Смена учетной записи службы шлюза на пользователя домена

Как объяснялось раньше, если при настройке параметров прокси-сервера вы использовали учетные данные по умолчанию, могут возникнуть проблемы с проверкой подлинности. Эта ситуация связана с тем, что учетная запись службы по умолчанию является идентификатором безопасности службы, а не прошедшим проверку подлинности пользователем домена. Чтобы настроить правильную проверку подлинности на прокси-сервере, вы можете сменить учетную запись службы шлюза. Дополнительные сведения об изменении учетной записи службы шлюза см. в статье Изменение учетной записи службы локального шлюза данных.

Эта ситуация связана с тем, что учетная запись службы по умолчанию является идентификатором безопасности службы, а не прошедшим проверку подлинности пользователем домена. Чтобы настроить правильную проверку подлинности на прокси-сервере, вы можете сменить учетную запись службы шлюза. Дополнительные сведения об изменении учетной записи службы шлюза см. в статье Изменение учетной записи службы локального шлюза данных.

Примечание

Чтобы избежать необходимости сбрасывать пароли, рекомендуем использовать управляемую учетную запись службы. Узнайте, как создать управляемую учетную запись службы в Active Directory.

Дальнейшие действия

- Сведения о брандмауэре

Локальный прокси-сервер для фильтрации браузерного трафика

Хочу рассказать о процессе разработки и поделиться прокси-сервером, которым сам пользуюсь для фильтрации всяческого мусора и других задач, требующих просмотра или вмешательства в браузерный траффик. Возможно, аналогичный функционал уже где-то есть, но мне хотелось сделать конкретно под свои нужды с возможностью real-time дописывания кода под любую сиюминутно понадобившуюся мелочь. Ну и под не-мелочи тоже, но это уже дольше.

Ну и под не-мелочи тоже, но это уже дольше.

Первоначально была задача упростить посещение сайтов через медленное (около 5-10кбайт/с с лагами) подключение. Тут два основных направления: 1) вырезать всё что не нужно (в первую очередь рекламу), и 2) закешировать всё что можно закешировать без особого вреда для функционала посещаемых сайтов, даже когда сами сайты не разрешают кеширование в http-заголовках, а то и явно препятствуют ему, дописывая после урлов статических файлов знак вопроса с рандомным числом.

Черновой вариант: nginx + php-fpm

Тратить на всё это время не хотелось, поэтому было решено по-быстрому настроить связку nginx + php-fpm, из которых первый разбирал входящие подключения, включая https и перенаправлял их все, без разбора хостов и урлов, в один и тот же php-скрипт. Так же была маленькая программа на C, которая конвертировала http-proxy-протокол в обычный http(s)-трафик. То есть превращала запросы GET http://host/path HTTP/1.x в GET /path HTTP/1. (имя хоста всё равно есть в Host-заголовке) и проксировала все https CONNECT’ы на локальный nginx. Как потом выяснилось, убирать  x

xhttp://host из http-запросов было не обязательно, nginx их принимает так же как и обычные.

PHP-скрипт, в свою очередь, собирал назад разложенный по разным переменным запрос, через fsockopen() подключался к целевому серверу (благо там поддержка SSL встроенная), слал собранный http-запрос, забирал ответ и отправлял его браузеру с помощью header() и echo. Скрипт делался не совсем с нуля, спасибо некоему Évelyne Lachance за https://github.com/eslachance/php-transparent-proxy (но всё же то, что по ссылке, имеет несколько другую цель и поэтому просто скопировать его было нельзя).

Тут возникли две проблемы

Во-первых, если собрать сам исходный URL труда не представляло, то содержимое POST-запросов собирать было уже сложнее, а если там ещё и необычный Content-Type и отправка файлов — то php-шный парсер почти необратимо терял исходные данные, собрать всё это назад из массива $_POST[] и уже залитых в серверную файловую систему загруженных файлов, ничего не потеряв, было почти нереально (по крайней мере по моей оценке). Но спасла положение весьма кстати появившаяся в php 5.4 опция enable_post_data_reading — если её поставить в off, то тело запроса парситься не будет и его можно будет просто прочитать блобом из файла ‘php://input’. При этом массивы $_POST и $_FILES, естественно, не будут инициализироваться, но они нам и не нужны.

Но спасла положение весьма кстати появившаяся в php 5.4 опция enable_post_data_reading — если её поставить в off, то тело запроса парситься не будет и его можно будет просто прочитать блобом из файла ‘php://input’. При этом массивы $_POST и $_FILES, естественно, не будут инициализироваться, но они нам и не нужны.

Во-вторых, nginx не умеет генерить сертификаты на лету из коробки, а настройку «игнорировать все проблемы с сертификатами» я в firefox не нашёл. Проблема была на тот момент решена патчем браузера, заставлявшим его любой сертификат считать доверенным и подходящим. Наверно были и другие способы это сделать, но все они казались сложнее. Патч естественно был кривой и сделанный почти методом тыка (желания изучать весь браузерный код проверки сертификатов не было), но он делал своё дело, а больше было и не надо.

Между сборкой исходного запроса и отправкой проксированного тривиальным образом были добавлены два куска кода. Один проверял, что host или host/path не из чёрного списка (организованного в виде отдельного php-файла с массивом внутри). Второй проверял, нет ли страницы в кеше (если есть — отдаётся из кеша). Если страницы в кеше нет, то делается проксированный запрос. Если запрос был GET и статус ответа 200, то полученная страница — кандидат на запоминание в кеше. Запоминать или нет — решалось функцией, которая по хосту, урлу (там просто были прописаны конкретные адреса, которые меня интересовали и которые я знал что надо кешировать) и content-type выносила вердикт. Кешировалось немного: http-статус, content-type и тело ответа. И при отдаче из кеша, соответственно, отдавались только эти данные, а все остальные заголовки, которые были в исходном ответе, безвозвратно терялись.

Второй проверял, нет ли страницы в кеше (если есть — отдаётся из кеша). Если страницы в кеше нет, то делается проксированный запрос. Если запрос был GET и статус ответа 200, то полученная страница — кандидат на запоминание в кеше. Запоминать или нет — решалось функцией, которая по хосту, урлу (там просто были прописаны конкретные адреса, которые меня интересовали и которые я знал что надо кешировать) и content-type выносила вердикт. Кешировалось немного: http-статус, content-type и тело ответа. И при отдаче из кеша, соответственно, отдавались только эти данные, а все остальные заголовки, которые были в исходном ответе, безвозвратно терялись.

Вот такая грубая и костыльная реализация, на удивление, вполне себе работала, хотя конечно артефакты её присутствия время от времени проявлялись и раздражали.

В следующие полгода использования система дорабатывалась под решение возникающих проблем (как проблем из-за общей её кривости, так и проблем — возникающих задач).

Ещё через 3-4 месяца мне надоело патчить браузер после каждого апдейта и было решено сделать всё по-нормальному — nginx и php выкидываем и пишем всё на C.

Итоговый вариант

Маленькая программа (из старой версии), которая разбирала и перенаправляла прокси-протокол, была взята за основу. Первоочерёдной задачей было реализовать в ней разворачивание https, потому что всё остальное в общем-то уже известно как делать (делалось не раз в другим проектах), а с SSL где-то кроме php я на тот момент ни разу не работал.

Для этого взял библиотеку OpenSSL. Весь код, её использующий, было решено выделить в отдельные процессы. Потому что, во-первых, в ней тогда постоянно находились дыры (а межпроцессная изоляция может эту проблему иногда сгладить), во-вторых так проще делать (модульность и инкапсуляция на уровне сокетов), и в-третьих API OpenSSL местами весьма странное (мягко говоря), и для нейтрализации последствий то ли кривого API, то ли неправильного его применения (вследствие отсутствующей или двусмысленной документации) удобно просто убивать ssl-процесс после того как соединение завершилось (к сожалению, это плохо сказывается на производительности, но я с этим смирился).

Жалобы на OpenSSL и на SSL

Вообще, из-за регулярных уязвимостей и невнятного API я даже собирался написать свою реализацию TLS, и даже начал, но, дойдя до парсинга сертификатов (увы, без этого почти ничего не сделать, ибо сертификаты оказывается используются не только для защиты от подмены сервера, но и для согласования ключей, даже если защита от подмены не нужна), испытал ещё один дискомфорт от спецификации ASN1. Стало понятно, что API библиотеки это только вершина айсберга, а внутри оно всё такое уже начиная с RFC самого протокола. Хотя в последнее время я более менее с этим всем смирился.

SSL/TLS-обёртки

Итак, были сделаны две вспомогательные программы, одна для заворачивания клиентского нешифрованного сокета в SSL/TLS, и вторая для разворачивания зашифрованного сокета, принятого сервером, в незашифрованный. Принцип простой: у подпрограммы есть наследуемые от родительской программы файловые декрипторы, которые родительская программа может заранее открыть нужным образом так, что дочерний процесс будет выглядеть для неё просто сокетом, в который можно записывать и из которого можно читать. При этом практически никакого отличия этого межпроцессного сокета от сокета интернетного не будет.

При этом практически никакого отличия этого межпроцессного сокета от сокета интернетного не будет.

Таким образом, сервер принимает (accept) входящее подключение, выясняет что на той стороне хотят SSL/TLS, после чего отдаёт соединение дочернему процессу (который поднимает SSL/TLS-сессию, генерирует сертификат если нужно или берёт уже ранее сгенерированный), а от дочернего процесса берёт межпроцессный сокет, через который передаются уже нешифрованные данные. В итоге весь дальнейший код может вообще не делать различий между http-соединением и https-соединением, прозрачно расшифровывающимся дочерним процессом, и использовать для работы с этими соединениями обычные функции для работы с сокетами.

Аналогично и на клиентской стороне, только в обратную сторону: клиент запускает дочерний шифрующий процесс, шлёт данные в межпроцессный сокет, а дочерний процесс уже обеспечивает их шифрование прозрачно для клиента.

Программы названы ssl-server-wrapper и ssl-client-wrapper. Кстати, второй можно запустить и отдельно вручную — тогда нешифрованный канал будет направлен в терминал, откуда его запустили, а установить SSL-соединение можно, набрав несколько простых команд.

Кстати, второй можно запустить и отдельно вручную — тогда нешифрованный канал будет направлен в терминал, откуда его запустили, а установить SSL-соединение можно, набрав несколько простых команд.

Пример

Пишем

$ host ya.ru - узнаём ip-адрес ya.ru has address 87.250.250.242 $ ./ssl-client-wrapper T/etc/ssl/certs/ca-certificates.crt - указать место где хранятся доверенные RootCA C87.250.250.242:443/ya.ru - подключиться по указанному адресу с указанным SNI

Ответ (много отладочных логов, можно скомпилировать чтобы было без них): дамп сертификата и предоставленной цепочки

DEBUG: cert[-1] subject = /C=RU/O=Yandex LLC/OU=ITO/L=Moscow/ST=Russian Federation/CN=*.yandex.az DEBUG: cert[-1] issuer = /C=RU/O=Yandex LLC/OU=Yandex Certification Authority/CN=Yandex CA DEBUG: cert[0] subject = /C=RU/O=Yandex LLC/OU=ITO/L=Moscow/ST=Russian Federation/CN=*.yandex.az DEBUG: cert[0] issuer = /C=RU/O=Yandex LLC/OU=Yandex Certification Authority/CN=Yandex CA DEBUG: cert[1] subject = /C=RU/O=Yandex LLC/OU=Yandex Certification Authority/CN=Yandex CA DEBUG: cert[1] issuer = /C=PL/O=Unizeto Technologies S.A./OU=Certum Certification Authority/CN=Certum Trusted Network CA DEBUG: cert[2] subject = /C=PL/O=Unizeto Technologies S.A./OU=Certum Certification Authority/CN=Certum Trusted Network CA DEBUG: cert[2] issuer = /C=PL/O=Unizeto Sp. z o.o./CN=Certum CA

Попытка собрать trusted цепочку

DEBUG: cert[-1] issued by cert[1] DEBUG: cert[1] issued by cert[2] DEBUG: cert[2]=cert[*0] was not issued by something from trusted-cert-store - chain incomplete, trying to recover DEBUG: cache miss at ./cert-pin/cache/9nqv0qm41tlxyel95bbods0famxjagbx.0 DEBUG: downloading AIA issuer cert: http://repository.certum.pl/ca.cer DEBUG: cert[*0] issued by cert[*1] DEBUG: cert[*1] is self-signed, chain ended

Как видно, «Certum CA» нет в списке доверенных Root CA, поэтому на первый взгляд это обрыв цепочки, но во втором сертификате цепочки (cert[2]) нашлась ссылка http://repository.certum.pl/ca.cer откуда можно скачать этот неизвестный сертификат; сертификат скачан (cert[*1]), но оказался самоподписанным и таким образом ничему не помогающим на самом деле, в Root CA есть «Certum Trusted Network CA», так что всё в порядке и можно было ничего не скачивать.

Проверка соответствия доменного имени:

DEBUG: check wildcard '*.yandex.az' against needed name 'ya.ru' DEBUG: check wildcard '*.yandex.tm' against needed name 'ya.ru' DEBUG: check wildcard '*.yandex.com.ua' against needed name 'ya.ru' DEBUG: check wildcard '*.yandex.de' against needed name 'ya.ru' DEBUG: check wildcard 'yandex.jobs' against needed name 'ya.ru' DEBUG: check wildcard '*.yandex.net' against needed name 'ya.ru' DEBUG: check wildcard '*.xn--d1acpjx3f.xn--p1ai' against needed name 'ya.ru' DEBUG: check wildcard '*.yandex.com.ge' against needed name 'ya.ru' DEBUG: check wildcard 'yandex.fr' against needed name 'ya.ru' DEBUG: check wildcard '*.yandex.fr' against needed name 'ya.ru' DEBUG: check wildcard 'yandex.kz' against needed name 'ya.ru' DEBUG: check wildcard 'yandex.aero' against needed name 'ya.ru' DEBUG: check wildcard '*.yandex.jobs' against needed name 'ya.ru' DEBUG: check wildcard '*.yandex.ee' against needed name 'ya.ru' DEBUG: check wildcard 'yandex.com' against needed name 'ya.ru' DEBUG: check wildcard 'yandex.tm' against needed name 'ya.ru' DEBUG: check wildcard 'yandex.ru' against needed name 'ya.ru' DEBUG: check wildcard '*.yandex.ru' against needed name 'ya.ru' DEBUG: check wildcard 'yandex.lv' against needed name 'ya.ru' DEBUG: check wildcard '*.yandex.lt' against needed name 'ya.ru' DEBUG: check wildcard 'yandex.az' against needed name 'ya.ru' DEBUG: check wildcard 'yandex.net' against needed name 'ya.ru' DEBUG: check wildcard 'yandex.lt' against needed name 'ya.ru' DEBUG: check wildcard 'ya.ru' against needed name 'ya.ru'

Итог:

DEBUG: protocol = TLSv1.2 DEBUG: cipher = ECDHE-RSA-AES128-GCM-SHA256 DEBUG: verify_result = 0 DEBUG: server_cert subject: /C=RU/O=Yandex LLC/OU=ITO/L=Moscow/ST=Russian Federation/CN=*.yandex.az DEBUG: server_cert issuer: /C=RU/O=Yandex LLC/OU=Yandex Certification Authority/CN=Yandex CA OK: connection to 87.250.250.242:443/ya.ru established

Теперь есть прозрачное подключение, шлём http-запрос и получаем ответ

GET / HTTP/1.0 Host: ya.ru Connection: close HTTP/1.1 200 Ok Accept-CH: Viewport-Width, DPR, Device-Memory, RTT, Downlink, ECT Accept-CH-Lifetime: 31536000 (...)

Основной функционал

С шифрованием разобрались, теперь можно приступить к обработке полезной нагрузки.

Так как nginx у нас больше нет, то парсинг запроса придётся реализовывать заново. В целом ничего сложного тут нет, сначала парсятся заголовки через \r\n или \n разделитель, до тех пор пока не встретится пустая строка, а затем, если был заголовок Content-Length, читается тело запроса указанного количества байт. Chunked encoding в запросах можно и не поддерживать — никакие нормальные браузеры, да и вообще http-клиенты, его не генерируют.

После того, как запрос распарсен, он попадает в обработчик запроса — это та часть, которая раньше была написана на php, весьма увеличившаяся в размерах и количестве файлов. И хотя списки правил (кого блокировать, кого кешировать, кому резать куки и т.д.), ранее бывшие оформлены в виде php-массивов и коротких скриптовых функций, были переделаны в отдельные текстовые файлы специального удобного формата, но часть «пользовательской» логики всё ещё защита в коде (только теперь на C а не PHP), а код в целом унаследовал много признаков «сделать побыстрее как-нибуть» от своего предшественника. Сейчас обработчик (кроме капитально переделанных списков правил) всё так же сделан в виде одного «потока» кода из «главного» файла и вставленных в него include (не заголовочных файлов а сам код).

Сейчас обработчик (кроме капитально переделанных списков правил) всё так же сделан в виде одного «потока» кода из «главного» файла и вставленных в него include (не заголовочных файлов а сам код).

Изначально функционал обработчика был даже чуть меньше чем функционал последней из старых версий, но за 2 года плавно набрал ещё много нового. Из последнего — последние полгода-год всё чаще стали попадаться сайты с неполными цепочками сертификатов (потому что браузеры теперь их поддерживают без ругани), сначала я их просто вносил в белый список исключений, но это стало происходить слишком часто и пришлось реализовать кеширование и докачивание недостающих сертификатов в цепочке.

Что получилось

Отдельные модули для разворачивания шифрованного SSL/TLS-туннеля, один из которых при желании можно использовать как самостоятельную программу типа ssl-telnet. Ещё можно заменить их на какие-то альтернативные реализации (например с другой крипто-библиотекой), при этом остальная часть прокси ничего не заметит.

Аналогично с инкрементальными обновлениями, ничего даже не нужно перезапускать. А ещё можно их использовать как демки по работе с OpenSSL (я прочёл много документации и всяких обсуждений в процессе их написания, возможно кто-то сможет теперь всё это быстрее усвоить). Код старался делать максимально понятным и простым.

Аналогично с инкрементальными обновлениями, ничего даже не нужно перезапускать. А ещё можно их использовать как демки по работе с OpenSSL (я прочёл много документации и всяких обсуждений в процессе их написания, возможно кто-то сможет теперь всё это быстрее усвоить). Код старался делать максимально понятным и простым.- У клиента есть хранилище сертификатов для: белый список по сайтам (принимать и не проверять), чёрный список по сайтам (не проверять и не принимать), список вопросов (те, которые не входят ни в белый, ни в чёрный и не прошли валидацию — аналог браузерной страницы с предложением внести подозрительный сертификат в список исключений). Для сайтов можно включать режим белого списка (то есть принимать только сертификаты из него, остальные считать недоверенными). К сожалению, всё это делается путём манипуляций над файлами, интерактивного приложения пока нет.

- Серверная часть сама генерирует сертификаты ко всем сайтам на лету, ей нужен только корневой сертификат, добавленный как trusted root CA в браузер.

Возможность пробросить точку выхода в интернет через, например, ssh port forwarding (связанный с этим функционалом код расположен в helpers/remote.c и в proxy.c в месте где обрабатывается аргумент «—proxy». Это не тоже самое что запустить само прокси на удалённом сервере. Тут важно что кеш и расшифровка SSL/TLS находятся на локальном компе, а пробрасывается только «внешний» конец. Хотя я давно не проверял работу этого режима, могла и сломаться.

Единообразный формат файлов правил для: блокировки загрузки страниц, блокировки куков, управления кешированием, включения сниффера, включения raw-режима (для real-time стримингов).

Аналог /etc/hosts но усовершенствованный: возможность сопоставления айпи-адреса не только по хосту, но и по порту и по протоколу, а так же сменить порт и протокол подключения.

Кеш, управляемый прописанными ему настройками, а не заголовками, присланными сервером.

Заголовки управления кешированием часто не отражают действительность (или отражают мнение владельца сайта, которое может расходиться с критериями удобства пользования этим сайтом), поэтому сейчас они игнорируются. Думаю что стоит сделать их учёт по принципу «если сайт разрешил кешировать то значит можно, а если нет — разбираемся сами можно или нельзя», но пока руки не дошли. Кеш хранится в интуитивно понятно организованном дереве директорий, хранится бессрочно, но можно либо вручную удалять отдельные сохранения, либо настройкой задать «игнорировать всё что сохранено раньше такого-то времени».

Заголовки управления кешированием часто не отражают действительность (или отражают мнение владельца сайта, которое может расходиться с критериями удобства пользования этим сайтом), поэтому сейчас они игнорируются. Думаю что стоит сделать их учёт по принципу «если сайт разрешил кешировать то значит можно, а если нет — разбираемся сами можно или нельзя», но пока руки не дошли. Кеш хранится в интуитивно понятно организованном дереве директорий, хранится бессрочно, но можно либо вручную удалять отдельные сохранения, либо настройкой задать «игнорировать всё что сохранено раньше такого-то времени».- Кроме кеша есть ещё сохранения — это те страницы, которые не берутся с диска при запросе к ним, но на всякий случай всё равно сохраняются. При включении оффлайн-режима они тоже смотрятся (в файл offline.flag надо прописать предпочтительное время, за которое будут искаться сохранённые страницы при обращении к ним). При настройке сохранений учтите, что, несмотря на то, что сохраняются только ответы (содержимое POST-запросов не сохраняется), в них всё же могут быть некоторые данные, которые стоит беречь от кражи, а сохранённые на диске страницы — дополнительный вектор атаки.

- Кроме кеша есть ещё сохранения — это те страницы, которые не берутся с диска при запросе к ним, но на всякий случай всё равно сохраняются. При включении оффлайн-режима они тоже смотрятся (в файл offline.flag надо прописать предпочтительное время, за которое будут искаться сохранённые страницы при обращении к ним). При настройке сохранений учтите, что, несмотря на то, что сохраняются только ответы (содержимое POST-запросов не сохраняется), в них всё же могут быть некоторые данные, которые стоит беречь от кражи, а сохранённые на диске страницы — дополнительный вектор атаки.

Возможность кастомных действий перед, после или вместо загрузки страницы проксированным запросом. Реализваны хардкодом, файл handle/inc.rewrite.c

Есть dashboard (двоичный файл со статусами всех потоков прокси) и программа для его вывода на экран в удобном виде.

./dashboard --basedir=/path/to/proxy/base --highlight --loopЛюбой аспект работы прокси можно легко переделать при необходимости. Код, несмотря на то, что он весьма разросся по сравнению с первыми версиями, всё ещё занимает очень мало места, и не потребует много времени как на первоначальное изучение, так и на освежение в памяти забытых деталей. С другой стороны, кому-то это и минус — для пользования всеми возможностями программы предполагается её регулярная пересборка и правка кода, а не «скомпилировал и удалил исходники».

Плюсы и минусы

(+) Модульность

(-) Из-за изоляции OpenSSL работает медленнее чем могло бы

(+) Гибкая настраиваемость под конкретные нужды

(+-) Много настроек прямо в исходном коде в виде #define и не только

(+-) IPv6 не поддерживается

(-) Нет интерактивного приложения для настройки и управления

(-) Код местами весьма плох и костылен

(-) До сих пор нет поддержки Access-Control-Allow-Origin с не ‘*’ в закешированных ответах — но единственное что у меня от этого ломалось это интерфейс мэйлру почты.

(-) До сих пор нет поддержки учёта настроек кеширования, присылаемых сервером

(-) Скачивать через него большие файлы (не в raw режиме) неэффективно — сначала прокси скачает файл себе на диск, затем будет через localhost-сеть отдавать его браузеру, который опять будет сохранять его на диск, а ещё там где-то (а может и в нескольких местах) прописано ограничение в 10мбайт на запрос

Как собрать/установить и технические детали кода

Из обычных библиотек используются стандартная C-библиотека, zlib (для распаковки gzip http-ответов), openssl (линкуется только к ssl-подпрограммам). Так же используются свои библиотеки (маленькие) с кодом который мне часто оказывается нужен в разных местах и поэтому вместо регулярного копипаста выделен в отдельные компилируемые единицы.

В целях данной публикации, для упрощения всё это собрано в один пакет (скачать можно тут) и обёрнуто в один сборочный скрипт (да, не Makefile, так уж вышло что пока я обхожусь без make) build-all. sh.

sh.

Ряд настроек расположен в исходниках: в скрипте fproxy/build2.sh, в файле fproxy/config.h (если у вас файл с бандлом доверенных центров сертификации расположен не в /etc/ssl/certs/ca-certificates.crt то надо этот путь заменить тут). Настройки подпрограмм (helpers/) расположены прямо в их коде вверху в виде #define (config.h они не используют), но их менять вряд ли кому потребуется.

То, что некоторая часть настроек прописана в компилируемом коде, а не в файлах настроек сделано для (моего) удобства. В файлах настроек настраивается то, что можно назвать наиболее часто меняющимися пользовательскими настройками (списки правил), а всё остальное — в общем то первоначальная настройка программы при её установке, и крайне редкие изменения всяких технических параметров (даже чаще меняется логика работы кода чем #define-настройки). По факту сейчас вполне рабочая версия получается если просто запустить build-all.sh и не трогать никакие исходники перед этим.

Но переделать код на приём настроек через командную строку или из ещё одного файла конфигурации несложно.

Для работы прокси нужна заранее подготовленная структура директорий. Для её создания есть скрипт prepare-dir.sh — он создаёт рядом подготовленную директорию fproxy-target/ со всем что требуется и кладёт туда примеры правил (в том числе много блокировок спамных доменов).

| Путь | Описание: |

|---|---|

| cache/ | Симлинки на второй уровень cache_real/. |

| cache_real/ | Кеш, двухуровневая структура — домен 2 уровня, потом полный домен. |

| saved/ | Симлинки на второй уровень saved_real/. |

| saved_real/ | Сохранённый не-кеш, 2-ур. структура. |

| cert-pin/certs/ | Настройки сертификатов для каждого домена (общий режим, белый/чёрный списки, вопросы). |

| cert-pin/queue/ | Тут создаются файлы при появлении вопросов в качестве флажков для интерактивной программы управлением этими настройками, если она будет. |

| cert-pin/cache/ | Кеш известных проксе сертификатов для дополнения неполных цепочек, принятых от сайтов (это НЕ список доверия, все эти сертификаты действительны только после прохождения проверок на общих основаниях). |

| dyn-certs/ | Кеш для сгенерированных сертификатов которые шлются браузеру. |

| hist/ | Сохранённая история посещений (инструментов для её просмотра пока нет, кроме ручного). |

| internal/ | Сейчас тут хранится сокет для запросов от скачивателя AIA сертификтов к проксе. |

| log/ | Логи. |

| pem/ | Корневой сертификат и приватные ключи для генерации сертификатов сайтов. |

| proxy_temp/ | Хранение запросов которые слишком большие для хранения их в памяти. |

| tmp/ | Временные файлы. |

| dyn-cert-serial | Файл с текущим серийным номером генерируемого сертификата (начальное содежание — символ ‘0’ и перевод строки после него). |

| mincache.date | Если файл есть и в нём тут записано число больше 0, то весь кеш раньше этого времени будет игнорироваться. |

| offline.flag | Если файл есть и в нём тут записано число больше 0, то прокси будет работать в режиме «интернет-архива» — на каждый запрос сначала искать в saved_real/ данные, близкие по времени к указанному числу, и только если не нашлось — проксировать запрос. |

| rules_*.txt | Различные правила, на данный момент их изменения учитываются только после перезапуска прокси. |

Насчёт прав доступа и вообще безопасности

Простейший вариант установки — запустить всё из под своего обычного юзера с обычными правами на всё (можно даже прямо из директории fproxy-target/, созданной скриптом prepare-dir.sh).

Но по ряду причин имеет смысл сделать по-другому. Для прокси создаётся отдельный юзер и группа, ему выдаются эксклюзивные права на чтение данных прокси, и права на запись в несколько мест, где они нужны. Права «только чтение» можно реализовать, поставив владельца root и группу прокси, и поставив доступ 0640 или 0750. Делать что бы то ни было из данных world-readable в любом случае плохая идея, всё же там лежит вся история браузера, а где-то и сохранённое содержание страниц, а так же ключи, с помощью которых браузеру можно делать MITM.

Права «только чтение» можно реализовать, поставив владельца root и группу прокси, и поставив доступ 0640 или 0750. Делать что бы то ни было из данных world-readable в любом случае плохая идея, всё же там лежит вся история браузера, а где-то и сохранённое содержание страниц, а так же ключи, с помощью которых браузеру можно делать MITM.

Для работы программы dashboard ей нужен только доступ на чтение к файлу BASE/log/dashboard и ничего другого.

По умолчанию прокси слушает 127.0.0.10:3128. Для работы с 127.0.0.10 у меня ничего специально настраивать (в ОС) не пришлось, но возможно в каких-то системах нужно.

Рабочая директория по умолчанию — та, что была текущей при запуске, но это можно поменять в настройках.

Заключение

Ещё раз ссылка на скачивание: тут.

Для публикации код был дооформлен в такой вид, который на мой взгляд допустимо публиковать, но всё же делалось это исключительно для себя под локальное применение и «по-быстрее», так что сейчас код во многих местах не образец для подражания. Но основную задачу он выполняет, а со временем будет улучшаться.

Но основную задачу он выполняет, а со временем будет улучшаться.

Из наиболее приоритетных на данный момент планов на будущее в плане функционала — сделать интерактивную настройку и управление (сертификаты, кеш, история, менеджер загрузок больших файлов) либо отдельным приложением, либо в спецдомене через браузер, но ничего не обещаю.

Надеюсь, что кому-то это всё окажется интересным и так или иначе поможет.

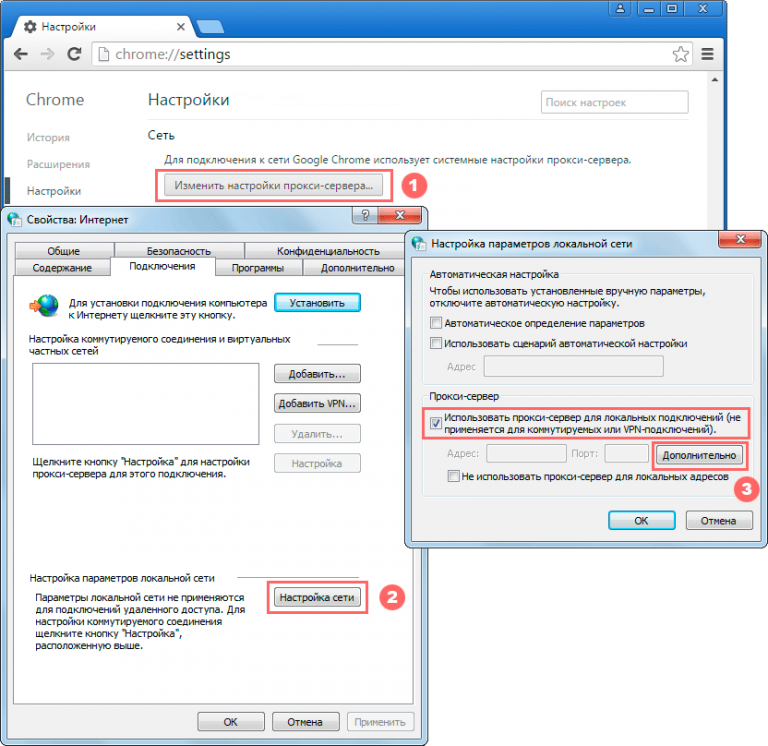

Поддержка прокси-серверов в приложениях Adobe Creative Cloud

Эта статья относится к Creative Cloud 2018 и более ранним версиям.

Creative Cloud расширяет функциональность приложения, предоставляя доступ к различным службам, таким как Assets, Adobe Fonts и Behance. На многих предприятиях доступ в Интернет ограничивается и контролируется прокси-сервером.

В данной статье описаны различные уровни поддержки прокси-окружений в продуктах Creative Cloud.

Adobe Asset Link не поддерживает среды прокси-серверов. Подробности приведены в документе Необходимые требования.

Требования к прокси-серверам для Creative Cloud Libraries

Для правильной синхронизации в корпоративном окружении Creative Cloud Libraries на панели Libraries в приложениях должны подключаться к локальному узлу localhost. Поэтому для обхода прокси-сервера в корпоративном окружении при использовании Libraries следует задать локальный узел localhost и адрес 127.0.0.1.

Если вы используете автоматическую настройку прокси-сервера (PAC) или протокол автоматического обнаружения прокси-сервера (WPAD) на компьютере Mac, необходимо активировать параметр Исключить простые имена хостов.

Примечание. Включение этой функции необходимо при вводе URL- или IP-адреса прокси-сервера вручную.

Подробнее о настройках прокси-сервера для Creative Cloud Libraries см. в разделах Настройка прокси-сервера для работы с библиотеками и Настройка прокси-сервера сетевым администратором.

Поддерживаемые типы настройки прокси

На компьютерах с Mac OS и Windows поддерживаются следующие конфигурации прокси-сервера:

- Настройка прокси-сервера с помощью URL-адреса PAC с проверкой подлинности или без нее

- Автоматическая настройка прокси (WPAD)

- Обычная проверка подлинности.

В случае, если пользователь указывает учетные данные в приложении Creative Cloud, Creative Cloud Libraries использует эти данные. Если пользователь не указывает учетные данные в приложении Creative Cloud, Creative Cloud Libraries запрашивает эти данные у пользователя.

В случае, если пользователь указывает учетные данные в приложении Creative Cloud, Creative Cloud Libraries использует эти данные. Если пользователь не указывает учетные данные в приложении Creative Cloud, Creative Cloud Libraries запрашивает эти данные у пользователя. - Аутентификация Kerberos поддерживается для Creative Cloud Libraries и приложения Creative Cloud для настольных ПК. Однако в настоящее время аутентификация Kerberos не поддерживается для продуктов Creative Cloud.

Неподдерживаемые типы настройки прокси

Следующие конфигурации прокси-сервера не поддерживаются:

- Проверки подлинности NTLM

- Поддержка локальных PAC-файлов

Поддержка PAC-файлов

Приложение Creative Cloud для настольных ПК и Creative Cloud Packager поддерживают удаленные PAC-файлы с базовой аутентификацией (PAC-файлы хранятся на удаленном сервере, доступ по URL-адресу).

Приложение Creative Cloud для настольных ПК и Creative Cloud Packager не поддерживают локально сохраненные pac-файлы.

Проверки подлинности NTLM не поддерживаются.

Среда прокси-сервера с проверкой подлинности и установленным приложением Creative Cloud для настольных ПК и другими продуктами Creative Cloud

Рекомендуется использовать только прокси-серверы HTTP и HTTPS. Прокси-сервер SOCKS не поддерживается в приложении Creative Cloud для настольных ПК.

Если корпоративное окружение настроено на использование прокси-сервера с обычной проверкой подлинности, будет происходить следующее.

Если используется вся функциональность Creative Cloud, то для лицензирования программного обеспечения и использования служб пользователи входят через приложение Creative Cloud для настольных ПК. Если приложение Creative Cloud для настольных ПК запускается впервые и обнаруживает прокси-сервер, запрашиваются учетные данные.

Введите учетные данные для прокси-сервера и выберите «Сохранить». При запуске приложений Creative Cloud они запрашивают подключение к Интернету. Приложения распознают, что учетные данные уже хранятся в приложении Creative Cloud для настольных ПК, и поэтому они используют эти учетные данные.

Поэтому для подключения к Интернету приложения больше не запрашивают необходимые данные, и можно использовать все функциональные возможности.

Однако в следующем приложении описанная технология внедрена не полностью, поэтому при его использовании в окружении с прокси-сервером и настроенной проверкой подлинности может происходить следующее.

Muse

Пользователю неоднократно предлагается ввести учетные данные. Когда пользователь выбирает функцию сохранения, диалоговое окно с учетными данными исчезает, и при следующих запусках не появляется.

Прокси-сервер с проверкой подлинности без приложения Creative Cloud для настольных ПК

Если есть прокси-сервер с проверкой подлинности, а приложение Creative Cloud для настольных ПК не установлено, каждое приложение обрабатывает подключение через прокси-сервер, что может приводить к различным последствиям. Обычно отображается единственный запрос учетных данных для прокси-сервера. Однако иногда диалоговые окна постоянно появляются при запуске и попытках использования расширенной функциональности.

Некоторые прокси-серверы для обхода проверки подлинности заносить домены в белый список. Полный список доменов можно найти в документации по конечным точкам Creative Cloud для корпоративного использования.

Поведение в окружениях, которым не требуются службы или которые работают без подключения к сети

При полностью автономной работе приложения не могут работать полностью корректно и не запрашивают учетных данных для подключения к Интернету. Если конечные пользователи пытаются получить доступ к требующим подключения функциям, им сообщают, что они работают в автономном режиме. Если конечные пользователи пытаются получить доступ к таким службам, как библиотеки, которые необходимы приложению Creative Cloud для настольных ПК, им сообщают, что эти службы нужно установить.

Многим функциям продуктов требуется интернет-подключение. Вот некоторые из них:

- Установки и запросы синхронизации настроек

- Установки и запросы входа в систему (из меню «Справка» и других)

- Запросы Adobe Anywhere в приложении Adobe Premiere Pro или Prelude

- Установки Business Catalyst в приложении Muse

- Установки Lightroom Mobile в приложении Lightroom

- Активация шрифта

- Установки Creative Cloud Libraries и остальные настройки Adobe CreativeSync

Синхронизируйте настройки

Функция синхронизации настроек может использоваться в среде прокси-серверов, если установлены последние версии следующих продуктов:

- Dreamweaver

- Premier Pro

- Adobe Media Encoder

- Animate

Связанные материалы

- Сетевые конечные точки Adobe Creative Cloud (PDF)

Вход в учетную запись

Войти

Управление учетной записью

Прокси сервер: что это и зачем нужен

Для чего нужны прокси-серверы в эпоху VPN? И как его выбрать, чтобы защитить личные данные? РБК Тренды разбираются вместе с экспертами

В этой статье:

- Что такое прокси-сервер

- Для чего нужен

- Как работает

- Виды прокси серверов

- Чем прокси отличается от VPN

- Почему прокси-серверы еще актуальны

Эксперты в этой статье:

- Максим Закамсков, руководитель направления IT Support компании SimbirSoft

- Микаэл Караманянц, генеральный директор компании «РашенСофт»

Что такое прокси-сервер

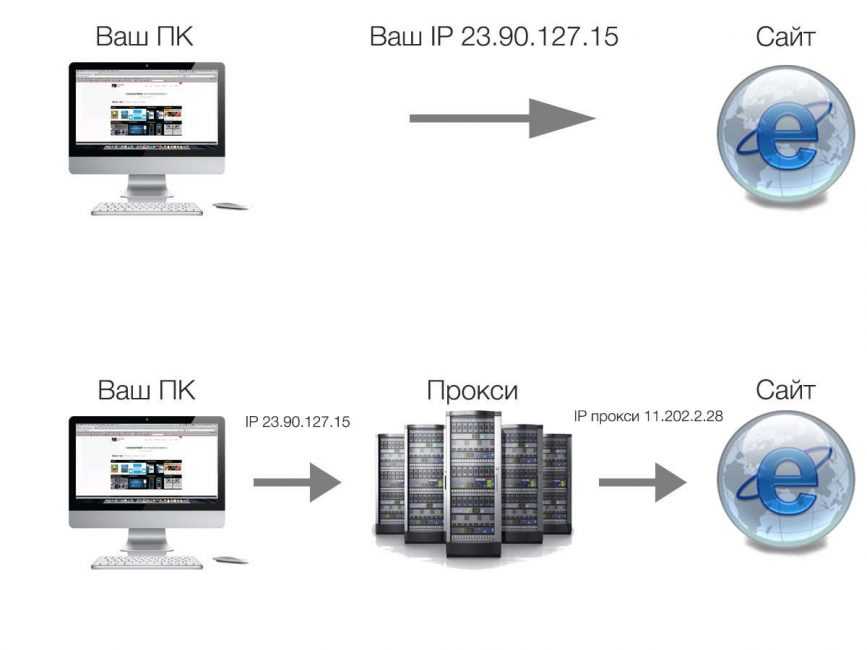

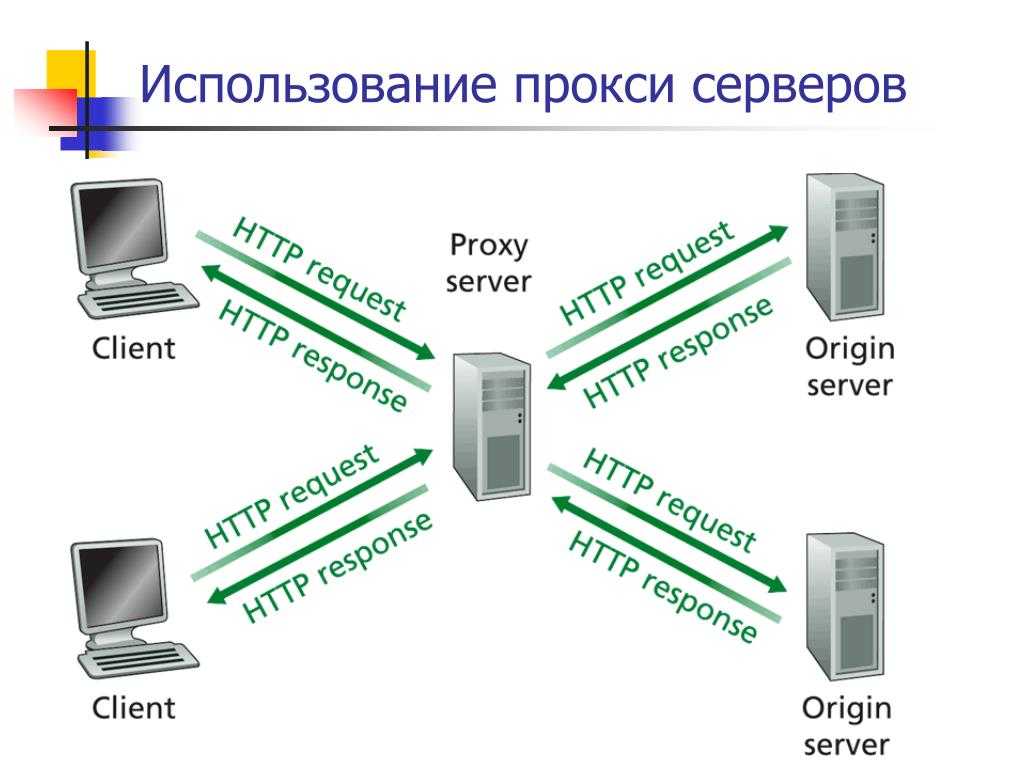

Прокси-сервер, прокси — это промежуточный сервер между пользователем интернета и серверами, откуда запрашивается информация. По сути, прокси — это посредник, фильтр или шлюз, который стоит между человеком и огромными (и не всегда безопасными) данными в сети.

По сути, прокси — это посредник, фильтр или шлюз, который стоит между человеком и огромными (и не всегда безопасными) данными в сети.

С прокси-серверами сталкиваются почти все пользователи интернета, даже если они об этом не подозревают. Работаете по найму? Теоретически, за вашими действиями в интернете может следит руководство. Делаете покупки в интернет-магазинах? Большинство владельцев сайтов используют прокси, чтобы защититься от мошенников. Регулярно посещаете крупные порталы? Их владельцы применяют прокси, чтобы распределять трафик.

Для чего нужен прокси-сервер

Назначение прокси-сервера зависит от его типа и вида. Прокси работает и для шифрования, и для кэширования информации, и как веб-фильтр. Современный и правильно настроенный прокси-сервер может выполнять разные задачи.

- Отслеживание информации. Например, крупные компании могут следить за запросами работников.

- Повышение скорости. За счет кэширования файлов, они загружаются быстрее.

- Конфиденциальность. Прокси меняет ваш IP-адрес и местоположение, из-за чего сложно отследить, кто делает запрос.

- Доступ к заблокированным сайтам. Прокси-сервер может передавать данные, что вы находитесь в другой стране, поэтому вам станут доступны заблокированные на вашей территории ресурсы.

- Блокировка нежелательных сайтов. Можно настроить прокси так, что пользователь не будет получать информацию с некоторых ресурсов.

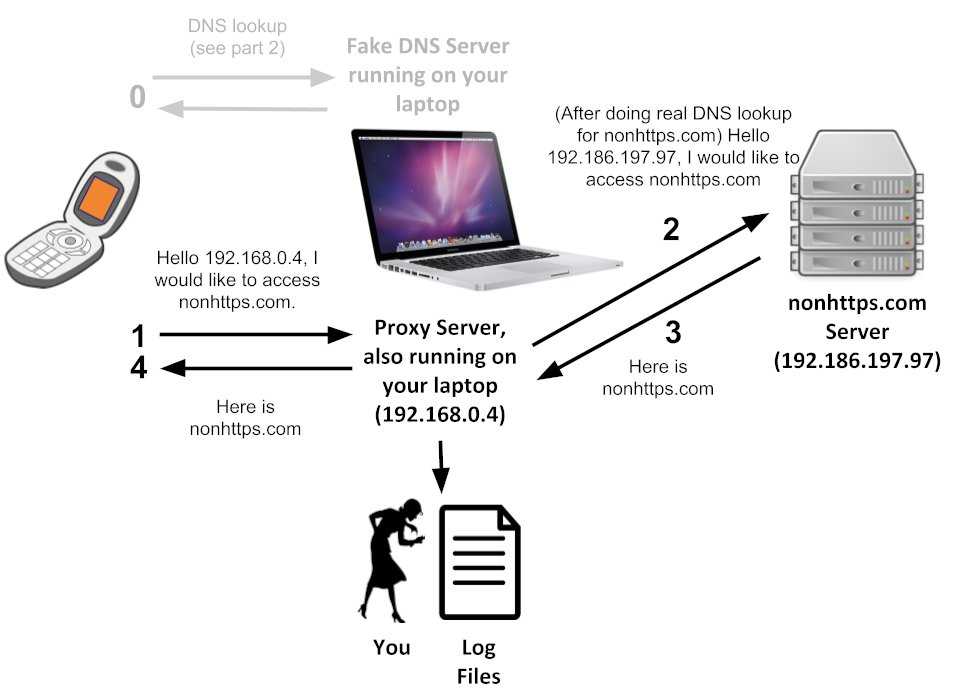

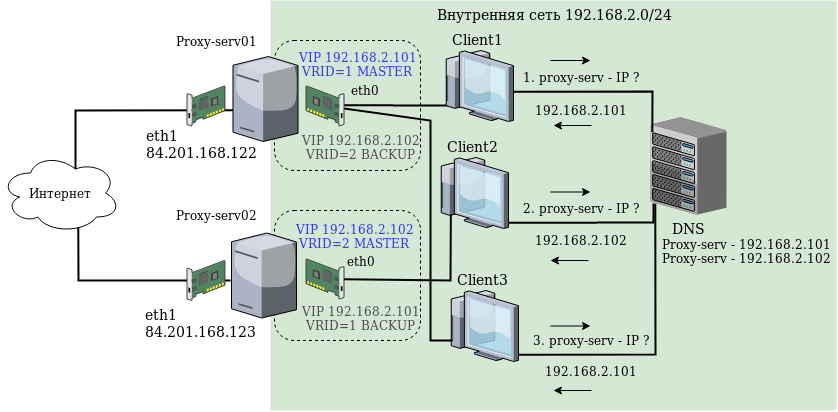

Как работает прокси-сервер

Алгоритмы в сети сохраняют исходящую информацию и формируют «профиль» пользователя: например, его историю запросов и типичное поведение. Эти знания можно использовать по-разному, самое безобидное — для настройки таргетированной рекламы.

При использовании прокси трафик идет не напрямую от компьютера на сервера, а через фильтр или шлюз. Именно прокси берет на себя ответственность сделать запрос на ресурс, получить информацию, при необходимости изменить ее и выдать пользователю. Как именно будет работать прокси и какие изменения он внесет во входящие или исходящие данные, зависит от его типа и настроек. Выделяют два основных прокси [1].

Как именно будет работать прокси и какие изменения он внесет во входящие или исходящие данные, зависит от его типа и настроек. Выделяют два основных прокси [1].

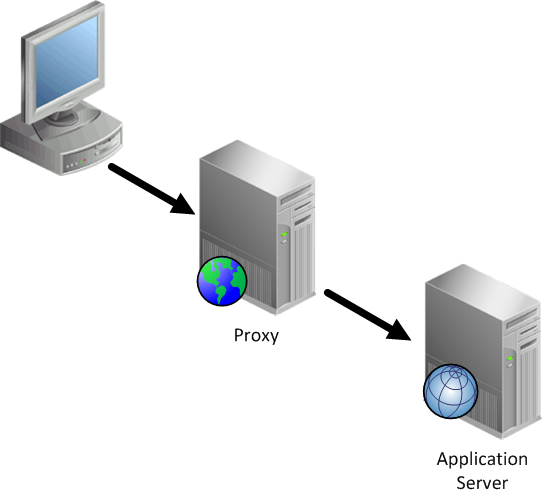

Прямой прокси-сервер (Forward Proxy)

Он находится между пользователем и внешними ресурсами. Прямой прокси-сервер работает с исходящими запросами, трансформирует их и уже потом обращается за информацией в сеть. С помощью такого посредника можно посещать заблокированные ресурсы, скрывать свое местоположение, кэшировать информацию — функциональность зависит от того, какой именно прокси-сервер вы используете.

Большинство современных прокси, которые подключают обычные пользователи интернета или компании, являются прямыми.

Обратный прокси-сервер (Reverse proxy)

Большинство сайтов используют несколько серверов для хранения информации: обратный прокси принимает запросы пользователей и сам решает, откуда запросить информацию. Поэтому часто такие прокси используют для балансировки нагрузки. Многие пользователи даже не подозревают, что ресурс использует обратный прокси-сервер. [2]

[2]

Также прокси серверы можно разделить уровню обеспечения анонимности клиента:

Прозрачный прокси-сервер

Такие не скрывают своей сущности, поэтому веб-ресурсы видят, что запрос идет не напрямую от пользователя, а от прокси. К тому же виден и реальный IP-адрес — так что никакой анонимности.

Обычно этот тип серверов используют учебные заведения для фильтрации входящего и исходящего контента, а также для кэширования информации. Так руководство школы или вуза может запретить учащимся посещать YouTube или социальные сети в стенах учебного заведения, чтобы ничто не отвлекало от учебы.

Анонимный прокси-сервер

Такие прокси не передают реальный IP-адрес, а заменяют его. То есть невозможно определить, где вы находитесь. Это помогает предотвратить утечку личных данных и отследить типичное поведение, что усложнит жизнь маркетологам.

К примеру, искажающий прокси-сервер передает, что пользователь находится в Лагосе; соответственно, ему будут предлагать рекламу и новости этого города. А на самом деле он жует пряник в Туле и новостями Африки особо не интересуется.

А на самом деле он жует пряник в Туле и новостями Африки особо не интересуется.

С помощью такого посредника можно обходить блокировку нежелательных ресурсов. Например, многие жители Китая используют прокси или VPN, чтобы преодолеть «Великий китайский фаервол», блокирующий сайты и даже запросы в поисковых системах. [3]

Из минусов: анонимные прокси не скрывают, что запрос передается через посредника, то есть сеть видит, что человек пользуется прокси-сервером.

Искажающий прокси-сервер

Искажающий прокси-сервер автоматически меняет HTTP-заголовки и IP-адрес пользователя, то есть помогает сохранить персональные данные, местоположение, историю просмотров и при этом не сообщает сети, что запрос идет через прокси.

Прокси высокой анонимности

Это наиболее современные и безопасные прокси-серверы. Они часто меняют IP-адрес пользователя, поэтому сложно определить реальное местоположение и исходящий трафик.

Например, компания Apple использует прокси-серверы для защиты данных пользователей с помощью функции «Частный узел», скрывая IP-адрес и шифруя трафик устройства. Для этого компания перенаправляет информацию через два независимых прокси-сервера [4].

Для этого компания перенаправляет информацию через два независимых прокси-сервера [4].

Функция «Частный узел» не работает в России, но пользователи Apple могут воспользоваться автопрокси, который операционная система подберет из доступных, или вручную задать реквизиты прокси-сервера.

Виды прокси-серверов

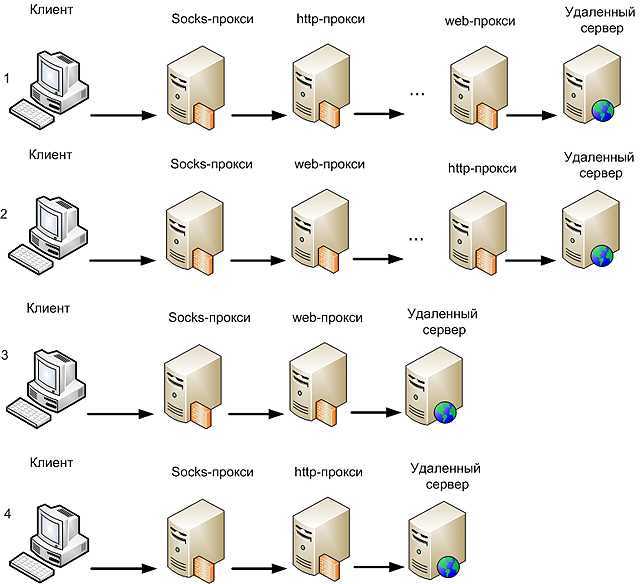

Чтобы выбрать подходящий прокси-сервер, нужно понимать для чего он вам нужен и какого функционала вы ждете. Существуют десятки видов прокси: SMTP, POP3, CGI, FTP и другие. Самые популярные:

HTTP-прокси

Это наиболее распространенный вид прокси. Они окружают пользователей практически везде: от офисов до дата-центров, будучи незаменимыми сетевыми помощниками.

Главные функции HTTP-прокси:

- Сжатие размера файлов (кэширование) для увеличения скорости;

- Блокировка ресурсов. Например, вы устанавливаете такой прокси в школе и запрещаете посещать все не образовательные ресурсы;

- Фильтрация рекламы.

HTTPS-прокси

Шифрует исходящий трафик, из-за чего сторонние ресурсы не могут узнать личную информацию, которую передает пользователь. Часто применяют, когда нужно сохранить пароли, логины, номера пластиковых карт. Но через HTTPS-прокси можно перехватить данные, если знать, как это сделать.

Часто применяют, когда нужно сохранить пароли, логины, номера пластиковых карт. Но через HTTPS-прокси можно перехватить данные, если знать, как это сделать.

Socks-прокси

Это самые прогрессивные и современные прокси-сервера. Сетевой протокол разработал Дейв Коблас в 1992 году. Сейчас используют версии Socks 4 и Socks 5. [5] Socks-прокси не передает информацию о IP-адресе, а сеть не видит, что пользователь делает запрос через прокси.

Микаэл Караманянц, генеральный директор компании «РашенСофт»:

«Самый простой HTTP прокси-сервер, словно юрист низкого-среднего уровня, который представляет ваши интересы, рассказывает вам о ходе вашего дела, сокращая информацию. Но любой настойчивый человек может спросить у него, чьи интересы он предоставляет.

HTTPS — это юрист более высокой квалификации, который старается держать все материалы дела и ваши персональные данные в секрете.

Socks-прокси — это ваш начальник безопасности, который следит за сохранностью ваших данных, скрывающий на кого он работает, выполняющий ваши приказы, выдавая их за свои».

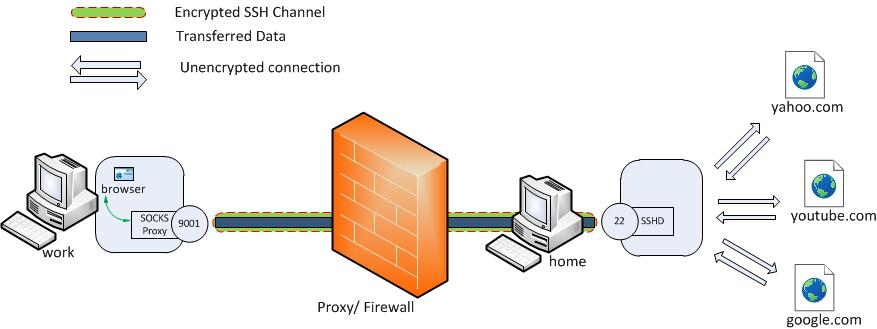

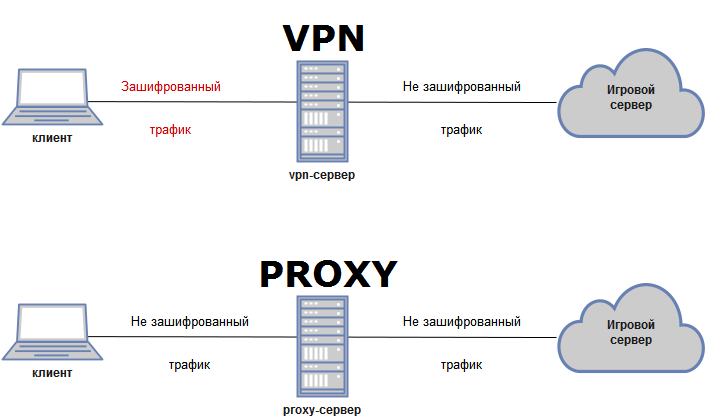

Чем прокси отличается от VPN

Как и прокси-сервер, VPN — посредник между пользователем и сетью. Сервис изменяет IP-адрес вашего компьютера — и в этом VPN схож по функциям с большинством прокси.

Максим Закамсков, руководитель направления IT Support компании SimbirSoft:

«В случае HTTPS-прокси: соединение клиент-прокси зашифровано с помощью сертификата и ключа, которые «живут» на прокси. Современные прокси-серверы, например, Squid, могут генерировать «валидные» сертификаты «на лету». Клиент будет уверен, что обратился к сайту через зашифрованное соединение, в адресной строке браузера будет показан замочек.

Тем не менее на прокси-сервере трафик от клиента к сайту расшифровывается, просматривается, редактируется (в зависимости от настроек сервера) и далее уже прокси-сервер устанавливает соединение с сайтом, шифруя его с помощью настоящего сертификата сайта. В случае VPN происходит то же самое — на VPN-сервере зашифрованный трафик расшифровывается, просматривается и далее отправляется в место назначения».

Большинство прокси-серверов сообщают сети, что они прокси-серверы; ресурсы видят, что запрос идет через посредника, а не от локальной сети. VPN действует как виртуальная сеть; запросы, проходящие через него для большинства программ ничем не отличается от запросов обычного пользователя.

Главное отличие VPN от прокси-сервера — это сквозное шифрование. При использовании VPN создается защищенный канал связи между вашим компьютером и VPN-сервером, который, помимо защиты, позволяет работать анонимно.

Для обеспечения анонимности лучше использовать именно VPN. И это оправдано, если вам нужно только скрыть свой IP-адрес. А если вы хотите настроить ограничения для ресурсов, увеличить скорость трафика или распределить нагрузку на сайт — без прокси не обойтись. Проще говоря, для прокси — обеспечение конфиденциальности — лишь одна из задач. Для VPN — единственная.

Микаэл Караманянц, генеральный директор компании «РашенСофт»: