Мета-тег Robots | SEO-портал

Мета-тег Robots должен содержать инструкции для поисковых роботов по отношению к веб-странице, на которой он указан.

Видео по теме

Для чего нужен мета-тег Robots?

Указание данного мета-тега, в зависимости от используемых в нем значений, может обеспечить запрет или разрешение поисковым роботам на индексирование веб-страницы, на переход по ссылкам, размещенным на данной странице, для последующей индексации, или на комбинацию данных инструкций.

С помощью файла robots.txt можно запретить сканирование определённых страниц и каталогов сайта, однако это не гарантирует того, что данные страницы не будут проиндексированы, т. к. роботы могут попасть на неё по внешним ссылкам. С помощью мета-тега Robots можно точно указать роботу, что данную страницу не следует индексировать.

Корректные инструкции мета-тега Robots гарантированно исполняются роботами поисковых систем по отношению к веб-странице.

Как прописать мета-тег Robots?

Как и другие мета-теги в HTML, Meta Robots указывается в блоке head веб-страницы и должен содержать два обязательных атрибута name и content:

<head> <meta name="robots" content="all" /> <head>

Атрибут Name мета-тега Robots

Важно знать, что атрибут name не обязательно должен содержать значение robots: в нём можно указывать название конкретного робота, для которого указана инструкция в атрибуте. Если указывается значение robots, то инструкция в атрибуте content предназначается для всех поисковых роботов. Таким образом, можно комбинировать инструкции для определённых роботов с помощью нескольких мета-тегов на одной веб-странице:

<head> <!-- Запрет индексирования страницы для всех роботов: --> <meta name="robots" content="noindex" /> <!-- Разрешение индексирования страницы роботу Яндекса: --> <meta name="yandex" content="index" /> </head>

Отметим, что в 99.9% случаев мета-тег Robots содержит общие для всех роботов инструкции и прибегать к использованию нескольких мета-тегов нет необходимости.

Директивы мета-тега Robots

В качестве значения атрибута content указывается одна или несколько директив (инструкций), перечисленных через запятую. Существуют общие директивы, понятные всем поисковым роботам, а также директивы, понятные только роботам определённых поисковых систем.

Общие директивы

В таблице представлены директивы мета-тега Robots, понятные роботам Яндекса и Google.

| Директива | Значение |

|---|---|

| all | Используется по умолчанию. Означает, что в отношении веб-страницы не предусмотрены исключающие правила для роботов. |

| noindex | Запрещает индексирование (отображение в поисковой выдаче) веб-страницы. |

| nofollow | Запрещает переход по ссылкам на веб-странице. |

| none | Запрещает индексирование и переход по ссылкам на веб-странице. |

| noarchive | Запрещает выводить ссылку на сохраненную копию веб-страницы в сниппете поисковой выдачи. |

Директивы для Google

В таблице ниже представлены директивы, понятные только роботам Google.

| Директива | Значение |

|---|---|

| nosnippet | Запрещает отображать фрагмент содержания страницы в поисковой выдаче, размещенный под заголовком сниппета. |

| notranslate | Запрещает отображать предложение перевести страницу в сниппете. |

| noimageindex | Запрещает индексировать изображения на странице. |

| unavailable_after:[date] | Запрещает отображать страницу в поисковой выдаче после указанного в формате RFC 850 времени. |

| nositelinkssearchbox | Запрещает отображение поля поиска по сайту в поисковой выдаче. |

Директивы для Яндекса

Кроме общих для всех роботов директив, робот Яндекса способен учитывать отдельную директиву noyaca, запрещающую использовать описание из Яндекс.Каталога при формировании сниппета поисковой выдачи:

<meta name="yandex" content="noyaca" />

Комбинирование директив

В качестве значения атрибута content в мета-теге Robots можно применять комбинации директив, перечисляя их через запятую. Рассмотрим на примерах.

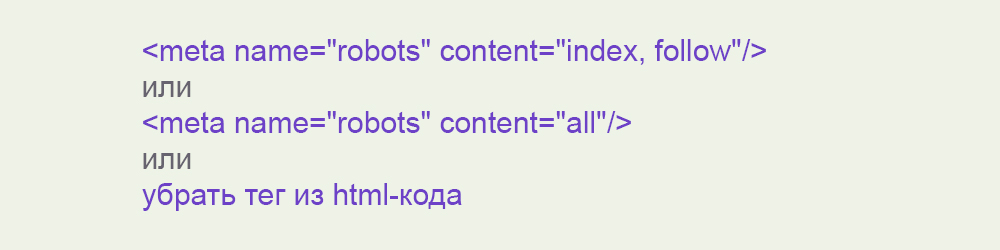

Значение «index, follow» или «all»

Для разрешения индексирования и перехода по ссылкам можно не указывать мета-тег Robots совсем, или использовать следующие значения:

<!--отсутствие мета-тега--> <!--или--> <meta name="robots" content="index, follow" /> <!--или--> <meta name="robots" content="all" />

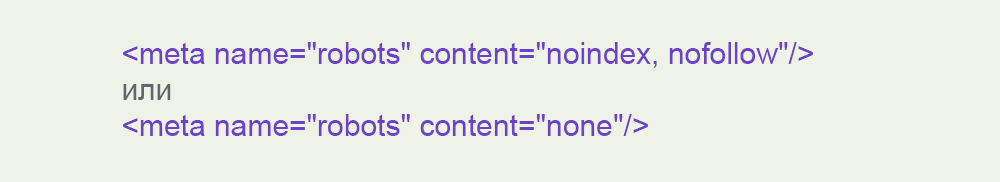

Значение «noindex, nofollow» или «none»

Для запрета индексирования страницы и перехода по ссылкам на ней можно применять следующие значения:

<meta name="robots" content="noindex, nofollow" /> <!--или--> <meta name="robots" content="none" />

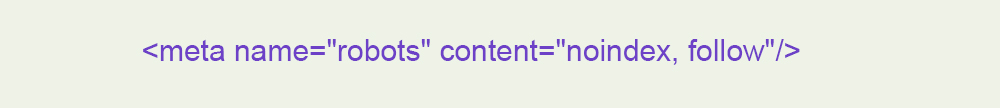

Значение «noindex, follow»

Если страницу не следует отображать в поисковой выдаче, но можно её сканировать на предмет ссылок, то применяется комбинация директив noindex, follow:

<meta name="robots" content="noindex, follow" />

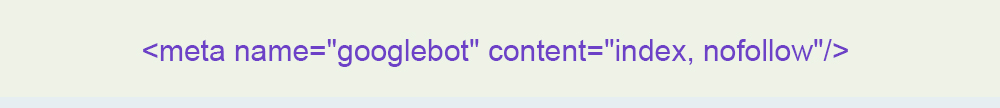

Значение «index, nofollow»

Если страницу следует отображать в поисковой выдаче, но не следует переходить по ссылкам на ней, то применяется комбинация index, nofollow:

<meta name="robots" content="index, nofollow" />

Рекомендации по применению

Необходимо очень внимательно использовать мета-тег Robots, т. к. он может стать причиной непопадания страниц сайта в поисковую выдачу. Чтобы исключить возможные недоразумения, следуйте указанным рекомендациям:

- применяйте запрещающие директивы мета-тега Robots, совмещая их с директивами файла robots.txt и не допускайте конфликтов между ними;

- учтите, что директивы файла robots.txt выполняются в первую очередь: если в robots.txt установлен запрет на сканирование страницы, а на странице указан мета-тег Robots со значением

allили другим равнозначным значением, то робот, следуя инструкции в файле robots.txt, не перейдёт на страницу и не проиндексирует её; - исключайте индексирование ненужных в поисковой выдаче страниц сайта (виртуальная корзина, результаты поиска по сайту, дубли страниц и т. д.).

Что такое мета-тег Robots и зачем он нужен?

Мета-тег robots поможет найти общий язык с поисковыми роботами

Даже не зная, зачем нужен мета-тег robots, только исходя из его названия, уже можно сделать выводы о том, что он имеет какое-то отношение к роботам поисковых систем. И это действительно так.

Внедрение мета-тега robots в код веб-страницы дает возможность указать поисковым ботам свои пожелания по поводу индексирования ее содержимого и ссылок, расположенных на ней.

Это может пригодится в многих ситуациях. Например, при наличии на сайте дублирования контента или для предотвращения передачи веса страничек по ссылкам, расположенным на них.

Как воспользоваться возможностями мета-тега robots

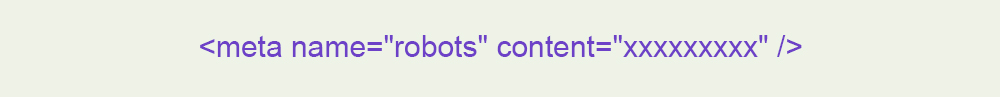

Страница, к которой нужно применить желаемые условия индексирования, должна содержать внутри тега <head> своего html-кода правильно оформленный мета-тег robots.

Структура его довольно проста:

Чтобы он был правильно воспринят ботами поисковиков, в данной конструкции содержимое атрибута content (‘’ххххххххх’’) должно состоять из одной или нескольких (через запятую) стандартных директив:

- index/noindex – указывает на необходимость индексации/игнорирования содержимого страницы.

- follow/nofollow – анализировать/игнорировать ссылки в пределах веб-страницы.

- all/none – индексировать/игнорировать страницу полностью.

- noimageindex – запрет индексации присутствующих на странице изображений.

- noarchive – запрет на вывод в результатах поиска ссылки «Сохраненная копия», которая дает возможность просматривать сохраненную в кэше поисковика копию страницы (даже если она временно недоступна или удалена с сайта).

- nosnippet – запрет на вывод в поисковой выдаче под названием страницы фрагмента текста (сниппета), описывающего ее содержание.

- noodp – директива, которая сообщает Google-боту о запрете использования в качестве сниппета страницы, описания из каталога Open Directory Project (он же DMOZ).

Особенности использования мета-тега robots

Некоторые поддерживаемый этим мета-тегом комбинации директив взаимозаменяемы (тождественны). Например, если нужно запретить индексирование содержимого странички и всех ссылок на ней, можно использовать в мета-теге robots ‘’noindex, nofollow’’ или же директиву ‘’none’’.

В обратном случае, когда нужно индексировать всё (в параметре content мета-тега robots – ‘’index, follow’’ или ‘’all’’), появляется еще и третий вариант – вообще не внедрять этот тег в код страницы.

Бывают и частные случаи, в которых указания по поводу индексирования нужно сообщить только роботу какой-нибудь одной поисковой системы. Для этого нужно вместо ‘’robots’’ указать имя бота, которого касаются содержащиеся в мета-теге директивы. Например, если Google должен внести в свой индекс содержимое странички, но при этом не анализировать ссылки на ней:

Важно, чтобы в содержимом атрибута content не было повторений или присутствия противоречащих друг другу директив, поскольку в этом случае мета-тег может быть проигнорирован поисковым ботом.

Еще один момент, на почве которого довольно часто спорят веб-мастера – регистр, в котором прописывается содержимое мета-тега. Одни считают, что правильно использовать только прописные, другие – только строчные. Но на самом деле приемлемы оба варианта, поскольку мета-тег нечувствителен к регистру.

Зачем нужен мета-тег robots, если есть файл robots.txt?

Да, действительно на первый взгляд может показаться, что применение этого мета-тега предоставляет те же возможности, что и настройка файла robots.txt. Но несколько отличий все же есть. И они вполне могут быть причинами, чтобы отдать предпочтение использованию мета-тега:

- Мета-тег robots используется для более тонкой настройки индексации – можно закрыть контент, но оставить открытыми ссылки (в параметре content мета-тега robots – ‘’noindex, follow’’) и наоборот. В robots.txt такой возможности нет.

- В ситуациях, когда нет возможности получить доступ к корневой директории веб-сайта, редактировать robots.txt не представляется возможным. Вот тогда-то и приходит на помощь одноименный мета-тег.

- В robots.txt можно закрыть от индексации целый каталог, чтобы запретить доступ ботов ко всем, содержащимся в нем страницам, тогда как мета-тег придется использовать для каждой из них. Получается, что в таком случае удобнее произвести настройки в файле. Но если некоторые страницы внутри каталога все же нужно оставить открытыми, удобнее использовать мета-тег.

Для управления индексацией страниц веб-сайта допустимо одновременно использовать мета-тег robots и файл robots.txt. Они могут отвечать за указания поисковым ботам по поводу разных веб-страниц или же дублировать команды друг друга.

А вот если в них будут присутствовать противоречащие директивы по поводу одних и тех же страниц, роботы поисковиков будут принимать не всегда верное решение – по умолчанию выбирается более строгое указание. Получается, что страницы (или ссылки на них), по поводу которых между robots.txt и мета-тегом robots имеются разногласия, индексироваться не будут.

Возможность управления индексацией веб-сайта – очень полезный инструмент для SEO-продвижения. Главное, научиться правильно определять, в какой ситуации эффективнее использовать тот или иной из теперь известных Вам способов.

HTML МЕТА-тег ROBOTS

У Вас в браузере заблокирован JavaScript. Разрешите JavaScript для работы сайта!

МЕТА тег robots служит для того, чтобы разрешать или запрещать роботам, приходящим на сайт, индексировать данную страницу. Кроме того, этот тег предназначен для того, чтобы предлагать роботам пройтись по всем страницам сайта и проиндексировать их. Кроме того, этим тегом могут воспользоваться те, кто не имеет доступа к корневому каталогу сервера и изменить файл robots.txt, но хочет запретить к индексированию свои файлы и директории.

Формат мета-тега Robots

МЕТА тег robots помещается в тег html-документа (внутри тега <HEAD>).

Формат достаточно прост (регистр букв значения не играет)

Данному мета-тегу можно присвоить варианта четыре значений. Атрибут CONTENT может содержать следующие значения:

Index (индексировать), noindex (не индексировать), follow (следовать по ссылкам), nofollow (не следовать по ссылкам)

Например, не индексировать данный документ:

<META NAME="ROBOTS" CONTENT="NOINDEX>

Робот поисковой машины не должен идти по ссылкам с данной страницы.

<META NAME="ROBOTS" CONTENT="NOFOLLOW">

Для одновременного запрета индексирования страницы и обхода ссылок с нее используйте

<META NAME="ROBOTS" CONTENT="NOINDEX,NOFOLLOW">Если значений несколько, то они разделяются запятыми.

Чтобы запретить индексирование страницы на вашем сайте только роботам Google и разрешить ее индексирование другим роботам, используйте следующий тег:

<META NAME="GOOGLEBOT" CONTENT="NOINDEX, NOFOLLOW">Чтобы разрешить роботам индексировать страницу, но запретить индексирование картинок на странице, используйте следующий тег:

<META NAME="ROBOTS" CONTENT="NOIMAGEINDEX">

Google автоматически создает и архивирует «снимок» каждой сканируемой страницы. Версия, сохраненная в кэше, позволяет показывать вашу страницу конечным пользователям, даже если исходная страница недоступна (из-за временной технической проблемы на веб-сервере). Сохраненная в кэше страница представляется пользователям в том виде, в котором ее в последний раз просканировал робот Google, при этом вверху страницы мы показываем сообщение о том, что это версия из кэша. Пользователи могут получить доступ к кэшированной версии, нажав на ссылку «Сохранено в кэше», расположенную на странице результатов поиска.

Чтобы запретить всем поисковым системам выводить эту ссылку на ваш сайт, добавьте в раздел <HEAD> следующий тег:

<META NAME="ROBOTS" CONTENT="NOARCHIVE">Чтобы запретить выводить ссылку «Сохранено в кэше» только системе Google, а остальным разрешить, используйте следующий тег:

Примечание. Этот тег удаляет только ссылку «Сохранено в кэше» на соответствующую страницу. Google продолжит индексировать страницу и выводить ее фрагмент.<META NAME="GOOGLEBOT" CONTENT="NOARCHIVE">

Предотвращение сканирования или удаление фрагментов

Фрагмент — это текст, который показывается под названием страницы в списке результатов поиска и описывает содержание страницы.

Чтобы запретить Google выводить фрагменты с вашей страницы, добавьте в раздел <HEAD> следующий тег:

<META NAME="GOOGLEBOT" CONTENT="NOSNIPPET">Примечание. При удалении фрагментов удаляются также и сохраненные в кэше страницы.

Как сделать так, чтобы поисковые системы не использовали данные DMOZ в результатах поиска для вашего сайта

Одним из источников, которые используются при создании фрагментов описаний, является Open Directory Project. Чтобы никакие поисковые системы (поддерживающие метатеги) не использовали эту информацию для описания страницы, добавьте следующий тег:

<META NAME="ROBOTS" CONTENT="NOODP">

Чтобы только для Google запретить использовать эту информацию в описании страницы, добавьте тег:

<META NAME="GOOGLEBOT" CONTENT="NOODP">

Если метатег «robots» используется для других команд, их можно объединить. Пример:

<META NAME="GOOGLEBOT" CONTENT="NOODP, NOFOLLOW">

Пример использования описания:

<META NAME="Description" CONTENT="Информация для WEB-разработчиков, программистов и студентов ВУЗ-ов, изучающх WEB-технологии.">

Поисковые запреты

Как сказать поисковой машине, что определенный участок кода не нужно индесировать или что по определенной ссылке не нужно следовать?

Каждый поисковик тут изобретает свой велосипед: Yandex рекомендует заключать подобный текст в теги <noindex>, Google дописывать у ссылок атрибут rel=»nofollow», Yahoo добавлять класс.

Тег NOINDEX

Запретить индексирование можно не только для файлов, но также и для их частей. Для того, чтобы запретить индексирование определенных частей файлов (текстовых), необходимо пометить их специальными тегами .rel=»nofollow»

Чтобы указать поисковой системе не идти по ссылке, в теге A можно задать атрибут rel=»nofollow»:

<a rel="nofollow" href="htmlweb.ru>WEB-технологии</a>Данный атрибут не влияет на индексацию ссылки. В большинстве поисковиков (кроме Google) переход по ней все-таки осуществляется. Единственная задача данного атрибута — сообщить поисковой системе, что рейтинг со страницы, на которой ссылка размещена, не должен передаваться странице, на которую данная ссылка ведет.

Если вам необходимо уменьшить количество внешних ссылок на странице, заключите их в теги <NOINDEX>здесь ссылки</NOINDEX> или <!—NOINDEX—>здесь ссылки<!—/NOINDEX—>

Использованны материалы с сайтов поисковых систем:

Google

class=»robots-nocontent»

Применение «class=robots-nocontent» атрибут:Ниже приводятся несколько примеров того, как применять этот атрибут для различных целей и различных вариантов синтаксиса:

<div>

Это навигационного меню сайта и является общим на всех страницах.

Она содержит много терминов и слов, не связанных с сайтом

</div><span> Это сайт заголовок, который присутствует на всех страницах сайта и не связан с какой-либо конкретной страницей </span>

<p>

Это Юридическая информация требуется на каждую страницу сайта

</p>Как часто индексировать документ поисковому роботу?

Вебмастер может «сказать» поисковому роботу или файлу bookmark пользователя, что содержимое того или иного файла будет изменяться. В этом случае робот не будет сохранять URL, а браузер пользователя внесет или не внесет это файл в bookmark. Пока эта информация описывается только в файле /robots.txt, Пользователь не будет знать о том, что эта страница будет изменяться.

Мета-таг DOCUMENT-STATE может быть полезен для этого. По умолчанию, этот мета-таг принимается с CONTENT=STATIC.

<META NAME="DOCUMENT-STATE" CONTENT="STATIC"> <META NAME="DOCUMENT-STATE" CONTENT="DYNAMIC">

Зеркала

Как исключить индексирование поисковой системой генерируемых страниц или дублирование документов, если есть зеркала сервера?

Генерируемые страницы — страницы, порождаемые действием CGI-скриптов. Их наверняка не следует индексировать, поскольку если попробовать провалиться в них из поисковой системы, будет выдана ошибка. Что касается зеркал, то негоже, когда выдаются две разные ссылки на разные сервера, но с одним и тем же содержимым. Чтобы этого избежать, следует использовать мета-таг URL с указанием абсолютного URL этого документа (в случае зеркал — на соответствующую страницу главного сервера).

<META NAME="URL" CONTENT="absolute_url">

Ещё почитать по теме:

Полное руководство по Robots.txt и метатегу Noindex

Файл Robots.txt и мета-тег Noindex важны для SEO-продвижения. Они информируют Google, какие именно страницы необходимо сканировать, а какие – индексировать (отображать в результатах поиска).

С помощью этих средств можно ограничить содержимое сайта, доступное для индексации.

Robots.txt – это файл, который указывает поисковым роботам (например, Googlebot и Bingbot), какие страницы сайта не должны сканироваться.

Файл robots.txt сообщает роботам системам, какие страницы могут быть просканированы. Но не может контролировать их поведение и скорость сканирования сайта. Этот файл, по сути, представляет собой набор инструкций для поисковых роботов о том, к каким частям сайта доступ ограничен.

Но не все поисковые системы выполняют директивы файла robots.txt. Если у вас остались вопросы насчет robots.txt, ознакомьтесь с часто задаваемыми вопросами о роботах.

По умолчанию файл robots.txt выглядит следующим образом:

Можно создать свой собственный файл robots.txt в любом редакторе, который поддерживает формат .txt. С его помощью можно заблокировать второстепенные веб-страницы сайта. Файл robots.txt – это способ сэкономить лимиты, которые могут пойти на сканирование других разделов сайта.

User-Agent: определяет поискового робота, для которого будут применяться ограничения в сканировании URL-адресов. Например, Googlebot, Bingbot, Ask, Yahoo.

Disallow: определяет адреса страниц, которые запрещены для сканирования.

Allow: только Googlebot придерживается этой директивы. Она разрешает анализировать страницу, несмотря на то, что сканирование родительской веб-страницы запрещено.

Sitemap: указывает путь к файлу sitemap сайта.

В файле robots.txt символ (*) используется для обозначения любой последовательности символов.

Директива для всех типов поисковых роботов:

User-agent:*

Также символ * можно использовать, чтобы запретить все URL-адреса кроме родительской страницы.

User-agent:*

Disallow: /authors/*

Disallow: /categories/*

Это означает, что все URL-адреса дочерних страниц авторов и страниц категорий заблокированы за исключением главных страниц этих разделов.

Ниже приведен пример правильного файла robots.txt:

User-agent:* Disallow: /testing-page/ Disallow: /account/ Disallow: /checkout/ Disallow: /cart/ Disallow: /products/page/* Disallow: /wp/wp-admin/ Allow: /wp/wp-admin/admin-ajax.php Sitemap: yourdomainhere.com/sitemap.xml

После того, как отредактируете файл robots.txt, разместите его в корневой директории сайта. Благодаря этому поисковый робот увидит файл robots.txt сразу после захода на сайт.

Noindex – это метатег, который запрещает поисковым системам индексировать страницу.

Существует три способа добавления Noindex на страницы:

Разместите приведенный ниже код в раздел <head> страницы:

<meta name=”robots” content=”noindex”>

Он сообщает всем типам поисковых роботов об условиях индексации страницы. Если нужно запретить индексацию страницы только для определенного робота, поместите его название в значение атрибута name.

Чтобы запретить индексацию страницы для Googlebot:

<meta name=”googlebot” content=”noindex”>

Чтобы запретить индексацию страницы для Bingbot:

<meta name=”bingbot” content=”noindex”>

Также можно разрешить или запретить роботам переход по ссылкам, размещенным на странице.

Чтобы разрешить переход по ссылкам на странице:

<meta name=”robots” content=”noindex,follow”>

Чтобы запретить поисковым роботам сканировать ссылки на странице:

<meta name=”robots” content=”noindex,nofollow”>

x-robots-tag позволяет управлять индексацией страницы через HTTP-заголовок. Этот тег также указывает поисковым системам не отображать определенные типы файлов в результатах поиска. Например, изображения и другие медиа-файлы.

Для этого у вас должен быть доступ к файлу .htaccess. Директивы в метатеге «robots» также применимы к x-robots-tag.

Плагин YoastSEO в WordPress автоматически генерирует приведенный выше код. Для этого на странице записи перейдите в интерфейсе YoastSEO в настройки публикации, щелкнув по значку шестеренки. Затем в опции «Разрешить поисковым системам показывать эту публикацию в результатах поиска?» выберите «Нет».

Также можно задать тег noindex для страниц категорий. Для этого зайдите в плагин Yoast, в «Вид поиска». Если в разделе «Показать категории в результатах поиска» выбрать «Нет», тег noindex будет размещен на всех страницах категорий.

- Чтобы проиндексированная страница была удалена из результатов поиска, убедитесь, что она не заблокирована в файле robots.txt. И только потом добавляйте тег noindex. Иначе Googlebot не сможет увидеть тег на странице. Если заблокировать страницу без тега noindex, она все равно будет отображаться в результатах поиска:

- Добавление директивы sitemap в файл robots.txt технически не требуется, но считается хорошей практикой.

- После обновления файла robots.txt рекомендуется проверить, не заблокированы ли важные страницы. Это можно сделать с помощью txt Tester в Google Search Console.

- Используйте инструмент проверки URL-адреса в Google Search Console, чтобы увидеть статус индексации страницы.

- Также можно проверить, проиндексировал ли Google ненужные страницы. Это можно сделать с помощью отчета в Google Search Console. Еще одной альтернативой может быть использование оператора «site». Это команда Google, которая отображает все страницы сайта, доступные в результатах поиска.

В последнее время в SEO-сообществе было много недоразумений по поводу использования noindex в robots.txt. Но представители Google много раз говорили, что поисковая система не поддерживают данный метатег. И все же многие люди настаивают на том, что он все еще работает. Но лучше избегать его использования.

Заблокированные через robots.txt страницы, не могут быть проиндексированы, даже если кто-то на них ссылается.

Чтобы быть уверенным, что страница без контента случайно не появится в результатах поиска, Джон Мюллер рекомендует размещать на этих веб-страницах noindex даже после того, как вы заблокировали их в robots.txt.

Использование файла robots.txt улучшает не только SEO, но и пользовательский опыт. Для этого реализуйте приведенные выше практики.

Данная публикация представляет собой перевод статьи «The Complete Guide to Robots.txt and Noindex Meta Tag» , подготовленной дружной командой проекта Интернет-технологии.ру

Указания поисковому роботу

При проведении SEO-оптимизации страниц сайта, иногда нужно изменить поведение поискового робота на конкретной странице. Например, запретить ему индексировать её содержание. Или же индексацию разрешить, но не позволять ему переходить по ссылкам. Сделать это можно при помощи специального мета-тега meta name robots.

«Способ применения» данного тега несколько отличается от использования файла Robots.txt — в данном файле можно дать указания поисковому роботу сразу для всего сайта, используя специальные регулярные выражения.

Но если вы хотите скрыть от поисковиков определённую страницу и не прописывать её в Robots.txt (чтобы вообще никто о ней не знал), то лучше прописать на самой странице данный мета-тег.

Что такое мета-тег Robots и как его использовать?

Это один из многочисленных тегов, используемых для сообщения роботам и/или браузерам т.н. метаданных (т.е. информации об информации). Среди самых известных и часто используемых:

Что прописывать в тег robots?

Выглядит он так:

Вместо многоточия может быть 7 основных вариантов. Каждый вариант — это комбинации специальных указаний index/noindex и follow/nofollow, а также archive/noarchive:

- index, follow. Это сообщает поисковикам о том, что нужно произвести индексацию данной страницы (index), а также следовать (follow) по ссылкам, которые есть на странице.

- all. Аналогично предыдущему пункту.

- noindex,follow или просто noindex. Запрещает индексировать данную страницу, но разрешает роботу переходить по ссылкам, расположенным на ней.

- index,nofollow или просто nofollow. Запрещает переходить по ссылкам, но разрешает индексировать страницу — т.е. содержимое страницы будет отправлено в поисковый индекс, но другие страницы, на которые стоят ссылки, в индекс не попадут (при условии, что робот иными способами до них не доберётся).

- noindex, nofollow. Указание не индексировать документ и не переходить по ссылкам, содержащимся в нём.

- none. Аналогично предыдущему пункту.

- noarchive. Данное указание запрещает показывать ссылку на сохранённую копию страницы в результатах выдачи:

Ссылка на сохранённую копию страницы в Яндексе

Если мета-тег Robots не указан, то принимается значение по умолчанию:

То же самое происходит, если на странице указано несколько этих тегов.

Все вышеперечисленные варианты понимаются большинством поисковых систем и, в частности, Яндексом. Google тоже хорошо распознаёт эти комбинации, но также вводит кое что ещё:

- Вместо name=robots можно указать name=googlebot — «обращение» конкретно к роботу Google.

- content=nosnippet (запрещает показывать сниппеты в поисковой выдаче) и content=noodp (запрещает брать содержимое сниппетов из описания сайта в каталоге DMOZ).

- content=noimageindex. При поиске по картинкам запрещает отображение ссылки на источник картинки.

- content=unavailable_after:[date]. В качестве date следует указать дату и время, после которой Гугл перестанет индексировать эту страницу. Едва ли это когда-нибудь пригодится

В общем, Google несколько расширяет содержимое мета-тега Robots.

Куда прописывать meta name robots?

Традиционно, все мета-теги прописываются между «head» и «/head» в HTML-коде страницы.

В WordPress они легко выставляются при помощи популярного плагина All in One Seo Pack:

Мета Robots в All in One Seo Pack

Таким образом, если вам необходимо «спрятать» определённую страницу от поисковых роботов — используйте данный мета-тег.

Loading…

Loading…Директивы Meta Robots и как их использовать

Meta Robots — это метатег, который позволяет настроить инструкции по индексации сайта. Его плюсы заключаются в надёжности и простоте установки. Но многие вебмастера и SEO-специалисты зачастую ограничиваются лишь директивами noindex и nofollow, указывающими на запрет индексации страниц сайта и содержащихся на них ссылок.

Я решил подробнее ознакомиться с возможностями Meta Robots, а потому в рамках данной статьи разберу и другие способы использования Meta Robots, которые вы сможете применить для SEO-продвижения вашего сайта.

Директивы Meta Robots и какие поисковые системы их учитывают

Всего существует чуть больше десятка основных директив Meta Robots, которые можно комбинировать между собой:

noindex— запрещает индексирование страницы.nofollow— запрещает роботу переходить по ссылкам с этой страницы.none— аналогичен комбинации noindex, nofollow.all— нет ограничений на индексирование и показ контента. Директива используется по умолчанию и не влияет на работу поисковых роботов, если нет других указаний.noimageindex— не индексировать изображения на этой странице.noarchive— запрещает показывать ссылку «Сохраненная копия» для определенной страницы.nocache— указывает на необходимость отправить запрос на сервер для валидации ресурса перед использованием кэшированных данных.nosnippet— запрещает показывать видео или фрагмент текста в результатах поиска.notranslate— запрещает предлагать перевод этой страницы в результатах поиска.unavailable_after: [RFC-850 date/time]— указывает точную дату и время, когда нужно прекратить сканирование и индексирование этой страницы.noodp— не использовать метаданные из проекта Open Directory для заголовков или фрагментов этой страницы.noydir— не брать название сайта и его описание из Yahoo! Directory (каталога Yahoo!).noyaca— не использовать описание из Яндекс.Каталога для сниппета в результатах поиска.

Некоторые из директив по-разному воспринимаются роботами тех или иных поисковых систем. В таблице ниже собрана информация о том, как боты систем Google, Yahoo, Bing и Яндекс работают с директивами Meta Robots.

| Директивы | Yahoo | Bing | Яндекс | |

|---|---|---|---|---|

| index | Да* | Да* | Да* | Да |

| noindex | Да | Да | Да | Да |

| follow | Да* | Да* | Да* | Да |

| nofollow | Да | Да | Да | Да |

| none | Да | ? | ? | Да |

| all | Да | ? | ? | Да |

| noimageindex | Да | Нет | Нет | Нет |

| noarchive | Да | Да | Да | Да |

| nocache | Нет | Нет | Да | Нет |

| nosnippet | Да | Нет | Да | Нет |

| notranslate | Да | Нет | Нет | Нет |

| unavailable_after | Да | Нет | Нет | Нет |

| noodp | Нет | Да** | Да** | Нет |

| noydir | Нет | Да** | Нет | Нет |

| noyaca | Нет | Нет | Нет | Да |

* Поисковая система не имеет официальной документации, которая бы подтверждала поддержку этой директивы. Но предполагается, что поддержка исключающего значения (например, nofollow) подразумевает поддержку положительного (например, follow).

** Теги noodp и noydir перестали поддерживаться, и, вероятно, не работают.

Директивы Meta Robots, которые стоит использовать в SEO

Как мы видим из предыдущей таблицы, не все атрибуты метатега Robots поддерживаются поисковой системой Google, под которую оптимизируют сайты большинство разработчиков и SEO-специалистов. Поэтому рассмотрим те атрибуты метатега Robots, которые поддерживаются Google:

- nosnippet,

- noimageindex,

- noarchive,

- unavailable_after.

Все они прописываются в блоке <head> страницы, к которой вы хотите применить те или иные инструкции по индексации.

Nosnippet

Эта директива может понадобиться, если, например, вы хотите предотвратить попадание контента вашего сайта в блоки с готовыми ответами Google (Featured Snippet). Несмотря на то, что фрагмент контента в Featured Snippet, как правило, позволяет повысить конверсию, всё же он может отвлекать внимание от самого сайта. То есть, у пользователей, получивших ответ на свой вопрос, пропадает надобность кликать по ссылке.

Для решения проблемы вам следует использовать инструкцию следующего вида:

<meta name="robots" content="nosnippet">Также важно учитывать, что атрибут nosnippet отключает и отображение расширенных сниппетов в результатах поиска.

К тому же, исследование HubSpot показало, что сниппеты с расширенной информацией получают в два раза больше кликов. Соответственно, отключение сниппета может стать причиной снижения CTR вашего сайта или отдельных его страниц.

Noimageindex

Директива noimageindex позволит скрыть графический контент на вашем сайте из результатов поиска по картинкам. Это может быть полезно, если вы, к примеру, хотите разместить на своём блоге уникальные изображения и при этом минимизировать риск воровства.

Чтобы запретить поисковым системам индексировать изображения, задайте в блоке <head> html-документа следующую директиву:

<meta name = "robots" content = "noimageindex">Действие необходимо повторить с каждой страницей, которая содержит изображения, которые вы хотите скрыть от поисковиков. Учитывайте, что если другие сайты уже ссылались на ваши изображения, поисковики могут продолжать индексировать их.

Запрещая индексацию изображений, не забывайте о том, что поиск по картинкам может приносить хороший дополнительный трафик вашему сайту.

Noarchive

Директива может пригодиться тем, кто работает с интернет-магазинами. К примеру, на вашем сайте есть страницы с товарами и указанной на них стоимостью. Так как цены с определённой периодичностью меняются, кэшированные страницы товаров могут быстро терять свою актуальность. Для предотвращения кэширования поместите в <head> страницы такую строку:

<meta name="robots" content="noarchive">Вопреки распространённому мнению, директива noarchive никак не влияет на ранжирование — эту информацию подтвердил в своем Твиттере ведущий аналитик компании Google, специалист отдела качества поиска по работе с вебмастерами Джон Мюллер (John Mueller).

Директива unavailable_after наиболее актуальна для страниц с акционными предложениями. Так как по истечению времени действия акции они теряют свою актуальность, вы можете указать поисковикам дату крайнего срока индексации контента. Дату и время нужно указывать в формате RFC 850.

К примеру, если вам нужно исключить возможность индексации страницы после 25 марта 2019 года, используйте метатег следующего вида:

<meta name="googlebot" content="unavailable_after: 25-Mar-2019 00:00:00 EST">Отдельно отметим, что для правильного функционирования тега необходимо, чтобы он был прописан до первого обхода роботом. В таком случае запрос на удаление из поисковой выдачи займёт примерно сутки после указанной даты.

Проверка правильности Meta Robots и его содержимого в Netpeak Spider

Перед проверкой атрибутов Meta Robots важно узнать, какие страницы индексируются на сайте, иначе не будет смысла внедрять вышеописанные атрибуты.

Программа доступна для операционных систем Microsoft Windows и Mac OS, поддержка платформы Linux в данный момент не доступна, но находится в разработке. Вы можете пользоваться бесплатной версией в течение 14 дней без каких либо ограничений.

Воспользуйтесь промокодом c6c39672 при оформлении заказа и получите специальную скидку 10% на покупку Netpeak Spider и Netpeak Checker!

С помощью Netpeak Spider вы можете найти запрещённые к индексации страницы. На таких страницах программа делает особый акцент, отмечая ошибками:

- Заблокировано в Meta Robots. Показывает страницы, запрещённые к индексации с помощью инструкции

<meta name="robots" content="noindex">в блоке<head>. - Nofollow в Meta Robots. Показывает страницы, содержащие инструкции

<meta name="robots" content="nofollow">в блоке<head>.

Для проверки сайта откройте программу и перейдите на вкладку «Параметры» на боковой панели. Найдите раздел «Индексация» и проверьте, отмечен ли галочкой пункт «Meta Robots». Если пункт не будет отмечен, программа не проанализирует метатег, и вы в финальном отчёте не увидите данных о нём.

Для сканирования всего сайта введите его начальный URL в адресную строку и нажмите кнопку «Старт». Если вам необходимо просканировать список страниц, зайдите в меню «Список URL» и выберите удобный вам способ добавления URL (ввести вручную, загрузить из файла или Sitemap, вставить из буфера обмена), после чего запустите сканирование.

По завершению сканирования получить информацию о Meta Robots вы можете несколькими путями:

1. В основной таблице на вкладке «Все результаты». В столбце Meta Robots просмотрите директивы, которые содержатся в соответствующем теге каждой из просканированных страниц.

2. На вкладке «Ошибки» боковой панели. Найдите ошибки, связанные с Meta Robots, и кликните по их названию. В таблице отфильтрованных результатов вы увидите полный список страниц, на которых были найдены эти ошибки.

3. На вкладке «Дашборд». Вы можете просмотреть данные в виде диаграмм об индексируемых страницах на сайте, а также узнать причины их неиндексируемости. Кликните на интересующую вас область, чтобы получить список страниц, соответствующих тому или иному значению.

4. На вкладке «Сводка» на боковой панели. Здесь вы можете ознакомиться как закрытыми от индексации страницами, так и посмотреть, какие ещё значения помимо noindex, nofollow заданы в метатеге Robots. Найдите пункт «Meta Robots» со списком всех имеющихся на сайте директив. Кликните на любую из них, чтобы ознакомиться со страницами, на которых они были найдены.

При необходимости вы можете воспользоваться функцией «Экспорт», чтобы выгрузить отфильтрованные результаты в отдельный файл формата .xlsx на свой компьютер. Нажмите на кнопку «Экспорт» в левом верхнем углу над результатами сканирования или выберите в соответствующем меню команду «Результаты в текущей таблице».

Коротко о главном

Meta Robots — удобный инструмент, который позволяет управлять инструкциями по индексации сайта и его отдельных страниц. Однако зачастую его использование ограничивается атрибутами запрета индексации — noindex, nofollow.

На деле же он может использоваться как минимум с 4 директивами, которые полноценно воспринимаются поисковыми роботами Google и помогают решить разного рода SEO-задачи. В их числе — nosnippet, noimageindex, noarchive и unavailable_after.

Проверить директивы метатега Robots всего сайта или списка определённых URL удобнее всего с помощью Netpeak Spider. Программа покажет все возможные ошибки, связанные с метатегами, и предоставит данные об атрибутах в максимально наглядном виде.

Краулер программы выполняет глубокий анализ сайта в автоматическом режиме, получает полную его структуру и находит ошибки технической оптимизации. Умеет находить битые ссылки и редиректы, обнаруживать дублирование страниц, Title, Description, заголовков h2 и т.д — проверяет более 50 ключевых параметров. Настоятельно рекомендую!

Метатег robots (meta name robots) – что это такое

Метатег robots – это код гипертекстовой разметки, позволяющий контролировать индексирование и показ страниц сайта в результатах поиска. Код можно писать на любой странице сетевого ресурса в специально отведенном для него месте. Роботы поисковых систем в процессе индексирования будут читать значение этого метатега и учитывать его в дальнейшей работе над сетевым ресурсом. Временное или постоянное внедрение этого кода может понадобиться в разных ситуациях. Например, он позволяет скрыть от поисковых роботов определенные ссылки или контент, который не должен попасть в выдачу поисковых систем. Этим тегом пользуются при оптимизации сайта, поисковом продвижении, наполнении ресурса уникальными статьями.

Использование

Код вписывают в заголовок каждой страницы, которую посещает робот. HTML-код выглядит следующим образом:

<html>

<head>

</head>

</html>

Все, что пользователь впишет между тегами <head> и </head> будет находиться в заголовке гипертекстовой разметки страницы.

Обсуждаемый код выглядит так:

<meta name=»robots» content=» » />

Между кавычками нужно указать команду, которую вы хотите отдать поисковому роботу.

Список стандартных значений метатега

Index и noindex. Разрешает или запрещает поисковику индексировать содержимое страницы соответственно. Полезно использовать при продвижении сайта и работе над ним в целом.

Follow и nofollow. Первое значение разрешает роботу переходить по ссылкам в пределах страницы, а второе запрещает. Также используется при SEO-оптимизации сетевых ресурсов.

Nosnippet. Директива запрещает роботу выводить в поисковой выдаче содержимое сниппета – краткое описание страницы.

Noarchive. Код запрещает роботу выводить в результатах поиска ссылку на сохраненную в кеше копию страницы.

All/none. Значение тега разрешает или запрещает индексацию всей страницы.

Noimageindex. Команда запрещает роботу индексировать опубликованные на странице фото.

Существуют и другие специальные указания, запрещающие или разрешающие поисковым роботам совершать определенные действия при индексировании содержимого страницы. Если тег отсутствует, то робот автоматически индексирует весь контент и все ссылки на странице. Если написано несколько тегов, значения которых противоречат друг другу, то поисковая система примет разрешающую директиву.

Значения метатега можно комбинировать, записывая команды через запятую. Записывать параметры можно без учета регистра. Если в атрибуте тега name стоит значение robots, то все поисковые системы будут учитывать его значение в процессе индексации. При желании можно дать команду конкретной поисковой системе, указав в атрибуте название робота. Например, значение Googlebot позволит запретить или разрешить определенные действия только поисковой системе Google.

Пример метатега:

<meta name=»googlebot» content=» » />

Если пользователь знает названия всех роботов, используемых поисковыми системами, то сможет давать команды каждому из них. Например, чтобы страница появилась в основном поиске Google, но не в новостях этого поисковика, нужно написать следующее:

<meta name=»googlebot-news» content=»noindex» />

Для передачи нескольких команд одной или нескольким поисковым системам или отдельным роботам можно писать несколько метатегов с разными или одинаковыми значениями. Если пользователь запутается и напишет команды, противоречащие друг другу, то робот выберет более строгую из них.

Причины использования метатега robots

Разработчики и пользователи сетевых ресурсов знают, что существует файл robots.txt, который помогает при СЕО-оптимизации, позволяя разрешать или запрещать роботам совершать определенные действия. Метатег robots дает возможность:

- закрывать содержимое страницы, оставляя ссылки доступными для индексирования;

- давать команды поисковым роботам при недоступности корневой директории сайта;

- открыть доступ роботу к просмотру содержимого некоторых страниц при закрытии от индексации каталогов.

Тег robots применяют совместно с файлом robots.txt для более тонкой настройки параметров индексации.

Веб-страницы роботов

О теге Robots

В двух словах

Вы можете использовать специальный HTML-тег, чтобы запретить роботам индексировать содержание страницы, и / или не сканировать его на наличие ссылок для подражания.

Например:

<Голова> <Название> ...

При использовании тега роботов необходимо учитывать два важных момента:

- роботы могут игнорировать тэг.Особенно вредоносные роботы, которые сканируют Интернет для уязвимостей безопасности и сборщики адресов электронной почты, используемые спамерами не будет обращать внимания.

- директива NOFOLLOW применяется только к ссылкам на этой странице. Это вполне вероятно, что робот может найти те же ссылки на некоторых других страница без NOFOLLOW (возможно, на каком-то другом сайте), и так до сих пор приходит на вашу нежелательную страницу.

Не путайте это НОСЛЕВО с атрибут ссылки rel = «nofollow».

Подробности

Как / роботы.TXT, роботы МЕТА тег является стандартом де-факто. Это произошло из «пернатых птиц» встречи в 1996 году распределенный семинар по индексированию, и был описан в заметках к совещанию.

Метатег также описан в HTML Спецификация 4.01, Приложение B.4.1.

Остальная часть этой страницы дает обзор того, как использовать роботов теги на ваших страницах, с некоторыми простыми рецептами. Чтобы узнать больше, смотрите также FAQ.

Как написать метатег роботов

Где поставить

Как и любой тег, он должен быть размещен в разделе HEAD HTML страница, как в примере выше.Вы должны поместить его на каждой странице вашего сайт, потому что робот может встретить глубокую ссылку на любой страница на вашем сайте.

Что положить в него

Атрибут «ИМЯ» должен быть «РОБОТЫ».

Допустимые значения для атрибута «CONTENT»: «INDEX», «NOINDEX», «FOLLOW», «НЕ СЛЕДУЕТ». Допускается несколько значений через запятую, но очевидно, только некоторые комбинации имеют смысл. Если нет тэг роботов, по умолчанию «INDEX, FOLLOW», так что нет необходимости объяснять это.Это оставляет:

,

Основы SEO: Мета Роботы «Noindex, Nofollow» Объяснение

Сегодня мы поговорим о одной из самых больших ошибок SEO , которую может совершить владелец сайта (или веб-разработчик): noindex . Просто упоминание об этом может вызвать дрожь в спине разработчика.

29/08/2018 Обновление: см. Примечания к обновлению в конце поста.

Что такое тег?

Проще говоря, этот метатег сообщает поисковым системам, какие действия они могут предпринять (или не предпринять) на определенной странице.Основные поисковые системы будут соблюдать команды, включенные в этот тег.

Этот метатег может быть включен в любое место между и тегами в заголовке страницы, как показано ниже:

ВАЖНО: Этот тег не имеет сайта общий эффект. Он может содержать разные значения на разных страницах одного и того же сайта.

Доступные значения для тега META ROBOTS

Ниже приведен список допустимых значений для тега META ROBOTS.

- Индекс (значение по умолчанию )

- Noindex

- Нет

- Подписаться

- Nofollow

- Noarchive

- Nosnippet

- Noodp ( больше не актуально )

- Нойдир ( больше не актуально )

Эти значения можно комбинировать, поэтому, например, все приведенные ниже варианты представляют собой совершенно корректные мета-теги robots:

Эффект NOINDEX, NOFOLLOW

Значение NOINDEX указывает поисковым системам НЕ индексировать эту страницу, поэтому в основном эта страница не должна отображаться в результатах поиска.

Значение NOFOLLOW сообщает поисковым системам, что они НЕ должны следить (открывать) страницы, на которые ссылаются на этой странице.

Иногда разработчики добавляют метатеги NOINDEX, NOFOLLOW на веб-сайтах разработчиков, чтобы поисковые системы не начинали случайно отправлять трафик на веб-сайт, который все еще находится в разработке.

Или у вас может быть свой текущий (действующий) веб-сайт на www.example.com, но вы также сохраняете копию для разработчиков на www.dev.example.com/. В этом случае целесообразно noindex, nofollow версии Dev, чтобы избежать многих потенциальных проблем.

Часто случается, что люди случайно добавляют этот тег на живые веб-сайты, забывают добавить его в копии для разработки или, что еще хуже, забывают удалить его с живых веб-сайтов после запуска.

Да, те же результаты и проблемы могут возникнуть из-за плохого файла robots.txt в корне веб-сайта, но это выходит за рамки темы этого поста.

~ 3% сайтов отелей затронуты

Согласно независимому анализу HermesThemes.Было установлено, что из более 50 000 гостиничных сайтов со всего мира ~ 3% веб-сайтов не позволяют поисковым системам индексировать свой веб-сайт.

Это было шокирующее открытие, которое побудило нас решить проблему с этой статьей.

Как проверить, содержит ли мой сайт эту ошибку?

К счастью, существует очень простой способ проверить любой сайт / страницу на наличие этой ошибки.

Просто откройте страницу в своем браузере, щелкните правой кнопкой мыши где-нибудь на странице (но не на ссылках или изображениях) и выберите «Просмотр источника страницы».В большинстве браузеров на Windows вы можете просто нажать CTRL + U на клавиатуре.

В результате откроется новая вкладка с полным HTML-кодом (как его видит браузер) для текущей страницы. Как упоминалось ранее, метатеги обычно находятся в верхней части веб-сайта, как в этом примере:

Если на этой странице вы видите строку META ROBOTS со значением NOINDEX или NONE, то вам нужно выполнить действие немедленно !

Как выглядят затронутые сайты в результатах поиска?

Я рад, что вы (надеюсь) спросил.

Существует очень удобный способ поиска в Google проиндексированных страниц по определенному доменному имени: [site: example.com] (без квадратных скобок).

Итак, мы идем в Google и ищем домен, который использует мета-роботы NOINDEX на их веб-сайте, и вот что мы получаем:

Я надеюсь, что вы понимаете, какой ущерб может быть нанесен, если ваш сайт полностью удалены из Google и других поисковых систем. Ваш обычный поисковый трафик упадет до нуля в течение нескольких дней.

Как исправить / удалить линию мета-роботов?

К счастью, решить эту проблему легко и не следует откладывать. Сначала вам нужно определить, откуда взялась эта строка.

В WordPress первое, что вам нужно сделать, это зайти в Dashboard> Настройки> Чтение.

Убедитесь, что флажок Видимость поисковой системы равен и не проверен .

Если это не помогло решить проблему, проверьте, не закодирована ли эта строка в теме.

Чтобы проверить это, перейдите в «Внешний вид»> «Редактор» и выберите «Theme Header header.php» в списке файлов справа (действительно для большинства тем).

Просмотрите этот файл и убедитесь, что нет метки META ROBOTS с вредоносным значением. Если есть — удалите его и нажмите синюю кнопку «Обновить файл».

Заключение

Эта строка кода может вызвать сильную головную боль, потерю дохода и негативное долгосрочное влияние на SEO.

Затрагивается ли ваш сайт NOINDEX? Проверьте сегодня!

Обновления от 29/08/2018:

Я хотел бы выделить время и упомянуть новые цифры от 29 августа 2018 года.

Количество анализируемых веб-сайтов резко возросло. Оригинальная статья ссылалась на данные, извлеченные из 50000 сайтов отелей. Сейчас я анализирую ~ 875 000 уникальных гостиничных сайтов (уникальных доменов).

Результаты этих 875 000+ гостиничных сайтов показывают, что 1,502% гостиничных сайтов используют NOINDEX или NONE в качестве значения своих мета-роботов.

Процент не кажется высоким, но это более 13 000 гостиничных сайтов, которые эффективно блокируют все поисковые роботы от индексации своих сайтов.

Конечно, некоторые из них делают это во время обслуживания своих веб-сайтов. Другие веб-сайты на самом деле пытаются вести себя сдержанно и показывать свой бизнес только через прямые ссылки.

Но я потратил время, чтобы вручную посетить более 200 случайных сайтов из этого списка, и я бы быстро подсчитал, что 3/4 из них фактически используют NOINDEX по ошибке.Вот и все.

Связанные

.SEO — метатег против robots.txt

Переполнение стека- Товары

- Клиенты

- Случаи использования

- Переполнение стека Публичные вопросы и ответы

- Команды Частные вопросы и ответы для вашей команды

- предприятие Частные вопросы и ответы для вашего предприятия

- работы Программирование и связанные с ним технические возможности карьерного роста

- Талант Нанимать технический талант

- реклама Связаться с разработчиками по всему миру

noindex, nofollow, noarchive, noodp & noydir

Мета-робот-тег контролирует пауков от сканирования и индексации вашей веб-страницы или публикации. В этом посте мы подробно рассмотрим все типы тегов. Мы можем использовать более одной метатеги на веб-странице, но это не очень хорошая практика, потому что это может вызвать конфликты. Следовательно, это должно происходить только один раз на веб-странице.

мета-тегов по умолчанию

Если вы не укажете метатег на веб-странице, то по умолчанию spider будет сканировать и индексировать вашу веб-страницу.Вы можете сказать, что он считает метатег ниже по умолчанию.

Мета роботы noindex

Предотвращает индексацию страницы. Это означает, что если вы укажете метатег ниже для страницы, эта страница не будет отображаться в результатах поиска. Например: вы не хотели бы, чтобы страницы вашего автора появлялись в результатах поиска, поэтому для предотвращения этого вы можете использовать мета-теги ниже на страницах автора.

Мета роботы nofollow

Этот метатег запрещает паукам переходить по любой ссылке на странице. Если вы новичок, то это может сбить вас с толку. Позвольте мне объяснить вам подробно. Всякий раз, когда паук (бот Google) находит ссылку (внутреннюю или внешнюю) на странице, он попадает на эту веб-страницу для сканирования и индексации, чтобы заставить паука не переходить по какой-либо ссылке на странице, мы можем использовать этот тег. Чтобы лучше это понять, можете сослаться на мой пост Dofollow vs nofollow.

Мета роботы noarchive

Вы, должно быть, видели в результатах поиска, что всякий раз, когда вы наводите указатель мыши на какой-либо результат, он отображает снимок этой страницы в правой части поиска Google (, см. Ниже снимок экрана !! ). Это мы называем кэшированной копией веб-страницы. Чтобы предотвратить кэширование страницы, мы можем указать тег ниже.

Мета роботов лапша

Запрещает поисковой системе (Google, Yahoo и MSN) отображать собственное описание, взятое из его каталога, вместо мета-описания.Использование тега ниже гарантирует, что поисковая система будет отображать ваше мета-описание под результатами поиска, и было бы полезно улучшить ваш CTR.

Мета роботы Нойдир

Это то же самое, что и вышеупомянутый тег NOODP, с той лишь разницей, что он применим только для Yahoo.

Лучшая практика использования noodp и noydir: Вы можете использовать тег ниже для всех своих веб-страниц —

ИЛИ (выше тега и ниже двух тегов — оба одинаковы)

Что делать, если на странице более одного тега мета-робота

Мы должны использовать его только один раз на страницу, и это лучший метод, но иногда из-за сочетания SEO-дружественных тем и плагинов SEO у нас может быть несколько экземпляров таких тегов.Поэтому для таких случаев давайте обсудим, как пауки (или сканеры) будут интерпретировать это.

CASE 1: В метатеге роботов нет конфликтующих значений.

Приведенные выше два тега были бы такими же:

СЛУЧАЙ 2: Значение конфликта присутствует в метатеге роботов.

Первый экземпляр:

Второй экземпляр:

В этом случае оба значения конфликтуют, так как одно указывает noindex, а другое заставляет паука индексировать страницу. Для таких случаев сканеры рассматривают первый случай конфликтов.

Таким образом, бот поисковой системы будет воспринимать это как , потому что noindex включается до индекса первого.

Как заблокировать конкретного поискового бота

Указывая мета-имя как «роботы», вы фактически блокируете всех роботов поисковых систем. Однако, если вы хотите заблокировать конкретного поискового бота, вы можете указать имя бота вместо «роботы»

BOT Имя:

Google: GOOGLEBOT

Yahoo: SLURP

MSN: MSNBOT

ASK: TEOMA

Итак, если вы хотите сделать свою страницу nofollow только для бота Google, вы можете использовать тег ниже.

Примечание. В названии мета я указал «Googlebot» вместо «robots», чтобы сделать его применимым только для бота поисковой системы Google.

Ссылка

мета-роботы тег: блог для веб-мастеров Google

<Изображение предоставлено>

,