Screaming Frog Seo Spider — подробное руководство по программе

Attention! Много букв! Много скринов! Много смысла!Доброго времени суток, друзья. Сегодня я хочу рассказать вам о настройке Screaming Frog (он же SF, он же краулер, он же паук, он же парсер — сразу определимся со всеми синонимами, ок?).

SF — очень полезная программа для анализа внутрянки сайтов. С помощью этой утилиты можно быстро выцепить технические косяки сайта, чтобы составить грамотное ТЗ на доработку. Но чтобы увидеть проблему, надо правильно настроить краулера, верно? Об этом мы сегодня с вами и поговорим.

- Примечание автора: сразу скажу — программа имеет много вкладок и настроек, которые по сути не нужны рядовому пользователю, потому я подробно опишу только наиболее важные моменты, а второстепенные пройдем вскользь… хотя кого я обманываю, когда это у меня были статьи меньше 30 к символов? *Зануда mode on*

- Примечание автора 2: при написании статьи я пользовался дополнительными материалами в виде официального мануала от разработчиков. Если что, почитать его можно тут https://www.screamingfrog.co.uk/seo-spider/user-guide/. Не пугайтесь английского, Google-переводчик в помощь — вполне себе сносная адаптация получается.

- Примечание автора 3: я люблю оставлять примечания…

Настройка Screaming Frog по шагам

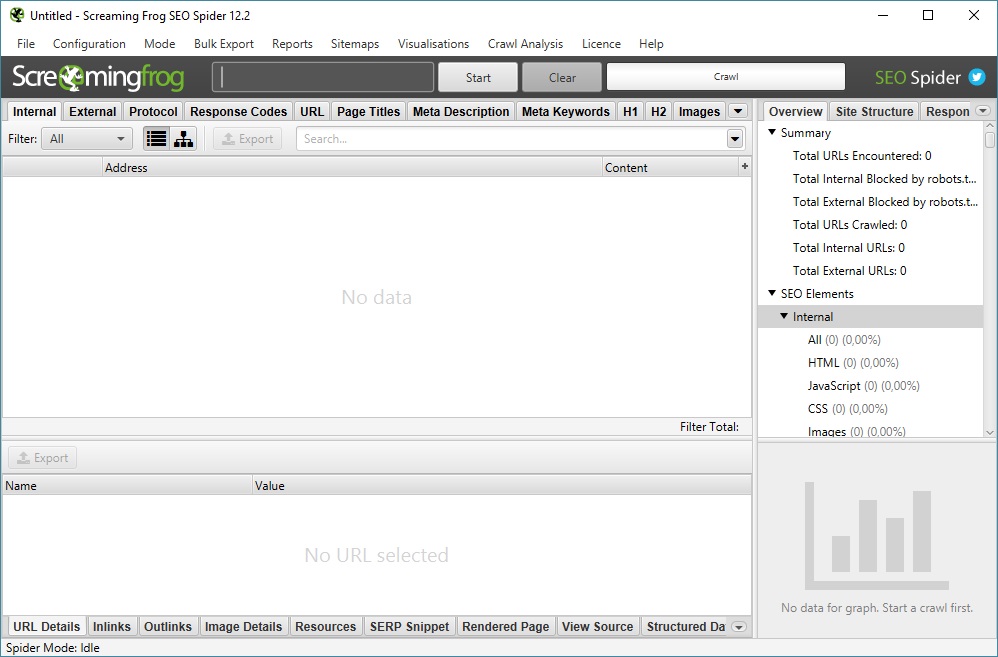

Рассмотрим основное меню программы, для того чтобы понимать что где лежит и что за что отвечает (тавтология… Вова может в копирайт!).Верхнее меню — управление парсингом, выгрузкой и многое другое

File

Из названия понятно, что это работа с файлами программы (загрузка проектов, конфиги, планирование задач — что-то вроде того).- Open — открыть файл с уже проведенным парсингом.

- Open Recent — открыть последний парсинг (если вы его сохраняли отдельным файлом).

- Save — собственно, сохранить парсинг.

- Configuration — загрузка/сохранение специальных настроек парсинга вроде выведения дополнительных параметров проверки и т.д. (про то, как задавать эти настройки, я далее расскажу подробнее).

- Crawl Recent — повторно парсить один из последних сайтов, который уже проверялся в этой программе.

- Scheduling

- Exit — призвать к ответу Друзя… нет, ну серьезно,тут все очевидно.

Configuration

Один из самых интересных и важных пунктов меню, тут мы задаем настройки парсинга.Ох, сейчас будет сложно — у многих пунктов есть подпункты, у этих подпунктов всплывающие окна с вкладками и кучей настроек…в общем крепитесь, ребята, будет много инфы.

Spider — собственно, настройки парсинга сайта

Вкладка Basic — выбираем что парсить

- Check Images — в отчет включаем анализ картинок.

- Check CSS — в отчет включаем анализ css-файлов (скрипты).

- Check JavaScript — в отчет включаем анализ JS-файлов (скрипты).

- Check SWF — в отчет включаем анализ Flash-анимации.

- Check External Link — в отчет включаем анализ ссылок с сайта на другие ресурсы.

- Check Links Outside of Start Folder — проверка ссылок вне стартовой папки. Т.е. отчет будет только по стартовой папке, но с учетом ссылок всего сайта.

- Follow internal “nofollow” — сканировать внутренние ссылки, закрытые в тег “nofollow”.

- Follow external “nofollow” — сканировать ссылки на другие сайты, закрытые в тег “nofollow”.

- Crawl All Subdomains — парсить все поддомены сайта, если ссылки на них встречаются на сканируемом домене.

- Crawl Outside of Start Folder — позволяет сканировать весь сайт, однако проверка начинается с указанной папки.

- Crawl Canonicals — выведение в отчете атрибута rel=”canonical” при сканировании страниц.

- Crawl Next/Prev — выведение в отчете атрибутов rel=”next”/”prev” при сканировании страниц пагинации.

- Extract hreflang/Crawl hreflang — при сканировании учитываются языковой атрибут hreflang и отображаются коды языка и региона страницы + формирование отчета по таким страницам.

- Extract AMP Links/Crawl AMP Links — извлечение в отчет ссылок с атрибутом AMP (определение версии контента на странице).

- Crawl Linked XML Sitemap — сканирование карты сайта. Тут краулер либо берет sitemap из robots.txt (Auto Discover XML Sitemap via robots.txt), либо берет карту по указанному пользователем пути (Crawl These Sitemaps).

Вкладка Limits — определяем лимиты парсинга

- Limit Crawl Total — задаем лимиты страниц для сканирования. Сколько всего страниц выгружаем для одного проекта.

- Limit Crawl Depth — задаем глубину парсинга. До какого уровня может дойти краулер при сканировании проекта.

- Limit Max Folder Depth — можно контролировать глубину парсинга вплоть до уровня вложенности папки.

- Limit Number of Query Strings — тут, если честно, сам не до конца разобрался, потому объясню так, как понял — мы ограничиваем лимит страниц с параметрами. Другими словами, если на одной статической странице есть несколько фильтров, то их комбинация может породить огромное количество динамических страниц. Вот чтобы такие “полезные” страницы не парсились (увеличивает время анализа в разы, а толковой информации по сути ноль), мы и выводим лимиты по Query Strings. Пример динамики — site.ru/?query1&query2&query3&queryN+1.

- Max Redirects to Follow

- Max URL Length to Crawl — максимальная длина URL для обхода (указываем в символах, я так понимаю).

- Max Links per URL to Crawl — максимальное количество ссылок на URL для обхода (указываем в штуках).

- Max Page Size (KB) to Crawl — максимальный размер страницы для обхода (указываем в килобайтах).

Вкладка Rendering — настраиваем параметры рендеринга (только для JS)

На выбор три опции — “Text Only” (паук анализирует только текст страницы, без учета Аякса и JS), “Old AJAX Crawling Scheme” (проверяет по устаревшей схеме сканирования Аякса) и “JavaScript” (учитывает скрипты при рендеринге). Детальные настройки есть только у последнего, их и рассмотрим.

- Enable Rendered Page Screen Shots — SF делает скриншоты анализируемых страниц и сохраняет их в папке на ПК.

- AJAX Timeout (secs) — лимиты таймаута. Как долго SEO Spider должен разрешать выполнение JavaScript, прежде чем проверять загруженную страницу.

- Window Size — выбор размера окна (много их — смотрим скриншот).

- Sample — пример окна (зависит от выбранного Window Size).

- Чекбокс Rotate — повернуть окно в Sample.

Вкладка Advanced — дополнительные опции парсинга

- Allow Cookies — учитывать Cookies, как это делает поисковый бот.

- Pause on High Memory Used — тормозит сканирование сайта, если процесс забирает слишком много оперативной памяти.

- Always Follows Redirect — разрешаем краулеру идти по редиректам вплоть до финальной страницы с кодом 200, 4хх, 5хх (по факту все ответы сервера, кроме 3хх).

- Always Follows Canonicals — разрешаем краулеру учитывать все атрибуты “canonical” вплоть до финальной страницы. Полезно, если на страницах сайта бардак с настройкой этого атрибута (например, после нескольких переездов).

- Respect Noindex — страницы с “noindex” не отображаются в отчете SF.

- Respect Canonical — учет атрибута “canonical” при формировании итогового отчета. Полезно, если у сайта много динамических страниц с настроенным rel=”canonical” — позволяет убрать из отчета дубли по метаданным (т.к. на страницах настроен нужный атрибут).

- Respect Next/Prev — учет атрибутов rel=”next”/”prev” при формировании итогового отчета. Полезно, если у сайта есть страницы пагинации с настроенными “next”/”prev”- позволяет убрать из отчета дубли по метаданным (т.к. на страницах настроен нужный атрибут).

- Extract Images from img srscet Attribute — изображения извлекаются из атрибута srscet тега <img>. SRSCET — атрибут, который позволяет вам указывать разные типы изображений для разных размеров экрана/ориентации/типов отображения.

- Respect HSTS Policy — если чекбокс активен, SF будет выполнять все будущие запросы через HTTPS, даже если перейдет по ссылке на URL-адрес HTTP (в этом случае код ответа будет 307). Если же чекбокс неактивен, краулер покажет «истинный» код состояния за перенаправлением (например, постоянный редирект 301).

- Respect Self Referencing Meta Refresh — учитывать принудительную переадресацию на себя же (!) по метатегу Refresh.

- Response Timeout — время ожидания ответа страницы, перед тем как парсер перейдет к анализу следующего урла. Можно сделать больше (для медленных сайтов), можно меньше.

- 5хх Response Retries — количество попыток “достучаться” до страниц с 5хх ответом сервера.

- Store HTML — можно сохранить статический HTML-код каждого URL-адреса, просканированного SEO Spider, на диск и просмотреть его до того, как JavaScript “вступит в игру”.

- Store Rendered HTML — позволяет сохранить отображенный HTML-код каждого URL-адреса, просканированного SEO Spider, на диск и просмотреть DOM после обработки JavaScript.

- Extract JSON-LD — извлекаем микроразметку сайта JSON-LD. При выборе — дополнительные чекбоксы с типами валидации микроразметки (Schema.

org, Google Validation, Case-Sensitive).

org, Google Validation, Case-Sensitive). - Extract Microdata — извлекаем микроразметку сайта Microdata. При выборе — дополнительные чекбоксы с типами валидации микроразметки (Schema.org, Google Validation, Case-Sensitive).

- Extract RDFa — извлекаем микроразметку сайта RDFa. При выборе — дополнительные чекбоксы с типами валидации микроразметки (Schema.org, Google Validation, Case-Sensitive).

Вкладка Preferences — так называемые “предпочтения”

Здесь задаем желаемые параметры для некоторых сканируемых элементов (title, description, url, h2, h3, alt картинок, размер картинок). Соответственно, если сканируемые элементы сайта не будут соответствовать нашим предпочтениям, программа нам об этом сообщит в научно-популярной форме. Совершенно необязательные настройки — каждый прописывает для себя свой идеал… или вообще их не трогает, от греха подальше (как делаю я).- Page Title Width — оптимальная ширина заголовка страницы. Указываем желаемые размеры от и до в пикселях и в символах.

- Meta Description Width — оптимальная ширина описания страницы. Аналогично, как и с тайтлом, указываем желаемые размеры.

- Other — сюда входит максимальная желаемая длина урл-адреса в символах (Max URL Length Chars), максимальная длина h2 в символах (Max h2 Length Chars), максимальная длина h3 в символах (Max h3 Length Chars), максимальная длина ALT картинок в символах (Max Image Length Chars) и максимальный вес картинок в КБ (Max Image Size Kilobytes).

Robots.txt — определяем каким правилам следовать при парсинге

Вкладка Settings — настраиваем парсинг относительно правил robots.txt

- Respect robots.txt — следуем всем правилам, прописанным в robots.txt. Т.е. учитываем в анализе те папки и файлы, которые открыты для робота.

- Ignore robots.txt — не учитываем robots.txt сайта при парсинге. В отчет попадают все папки и файлы, относящиеся к домену.

- Ignore robots.txt but report status — не учитываем robots.txt сайта при парсинге, однако в дополнительном меню выводится статус страницы (индексируемая или не индексируемая).

- Show internal/external URLs blocked by robots.txt — отмечаем в чекбоксах хотим ли мы видеть в итоговом отчете внутренние и внешние ссылки, закрытые от индексации в robots.txt. Данная опция работает только при условии выбора “Respect robots.txt”.

Вкладка Custom — ручное редактирование robots.txt в пределах текущего парсинга

Удобно, если вам нужно при парсинге сайта учитывать (или исключить) только определенные папки, либо же добавить правила для поддоменов. Кроме того, можно быстро сформировать и проверить свой рабочий robots, чтобы потом залить его на сайт.

Шаг 1. Прописать анализируемый домен в основной строке

Шаг 2. Кликнуть на Add, чтобы добавить robots.txt домена

Тут на самом деле все очень просто, поэтому я по верхам пробегусь по основным опциям (а в конце будет видео, где я бездумно прокликиваю все кнопки).

- Блок Subdomains — сюда, собственно, можно добавлять домены/поддомены, robots.txt которых мы хотим учитывать при парсинге сайта.

- Окно справа — для редактирования выгруженного robots.txt. Итоговый вариант будет считаться каноничным для парсера.

- Окошко снизу — проверка индексации url в зависимости от настроенного robots.txt. Справа выводится статус страницы (Allowed или Disallowed).

URL Rewriting — функция перезаписи URL «на лету»

Тут мы можем настроить перезапись урл-адресов домена прямо в ходе парсинга. Полезно, когда нужно заменить определенные регулярные выражения, которые засоряют итоговый отчет по парсингу.

Вкладка Remove Parameters

Вручную вводим параметры, которые нужно удалять из url при анализе сайта, либо исключить вообще все возможные параметры (чекбокс “Remove all”). Полезно, если у страниц сайта есть идентификаторы сеансов, отслеживание контекста (utm_source, utm_medium, utm_campaign) или другие фишки.

Вкладка Regex Replace

Изменяет все сканируемые урлы с использованием регулярных выражений. Применений данной настройки масса, я приведу только несколько самых распространенных примеров:

- Изменение всех ссылок с http на https (Регулярное выражение: http Заменить: https).

- Изменение всех ссылок на site.by на site.ru (Регулярное выражение: .by Заменить: .ru).

- Удаление всех параметров (Регулярное выражение: \?. * Заменить: ).

- Добавление параметров в URL (Регулярное выражение: $ Заменить: ?ПАРАМЕТР).

Вкладка Options

Вы рассчитывали увидеть здесь еще 100500 дополнительных опций для суперточной настройки URL Rewriting, я прав? Как бы странно это ни звучало, но здесь мы всего лишь определяем перезаписывать все прописные url-адреса в строчные или нет… вот как-то так, не спрашивайте, я сам не знаю почему для этой опции сделали целую отдельную вкладку.

Вкладка Test

Тут мы можем предварительно протестировать видоизменение url перед началом парсинга и, соответственно, подправить регулярные выражения, чтобы на выходе не получилось какой-нибудь ерунды.

CDNs — парсим поддомены, не отходя от кассы

Использование настройки CDNs позволяет включать в парсинг дополнительные домены/поддомены/папки, которые будут обходиться пауком и при этом считаться внутренними ссылками. Полезно, если нужно проанализировать массив сайтов, принадлежащих одному владельцу (например, крупный интернет-магазин с сетью сайтов под регионы). Также можно прописывать регулярные выражения на конкретные пути сканирования — т.е. парсить только определенные папки.

Во вкладке Test можно посмотреть как будут определяться урлы в зависимости от используемых параметров (Internal или External).

Include/Exclude — сканирование/удаление определенных папок

Можно регулярными выражениями задать пути, которые будут сканироваться внутри домена. Также можно запретить парсинг определенных папок. Единственный нюанс в настройках — при использовании Include будут парситься только УКАЗАННЫЕ папки, если же мы добавляем урлы в Exclude, сканироваться будут все папки, КРОМЕ УКАЗАННЫХ.

Выбираем папки для парсинга

Удаляем папки из парсинга

Примеры регулярных выражений для Exclude:

- http://site.by/obidnye-shutki-pro-seo.html (исключение конкретной страницы).

- http://site.by/obidnye-shutki-pro-seo/.* (исключение целой папки).

- http://site.by/.*/obidnye-shutki-pro-seo/.* (исключение всех страниц, после указанной).

- .*\?price.* (исключение страниц с определенным параметром).

- .*jpg$ (исключение файлов с определенным расширением).

- .*seo.* (исключение страниц с вхождением в url указанного слова).

- .*https.* (исключение страниц с https).

- http://site.by/.* (исключение всех страниц домена/поддомена).

Speed — регулируем скорость парсинга сайта

Можно выставить как количество потоков (по умолчанию 5), так и число одновременно сканируемых адресов. Влияет на скорость парсинга и вероятность бана бота, так что тут лучше не усердствовать.

User-Agent — выбираем под кого маскируемся

В списке user-agent можно выбрать от лица какого бота будет происходить парсинг сайта. Удобно, если в настройках сайта есть директивы, блокирующие того или иного бота (например, запрещен google-bot). Также полезно иногда прокраулить сайт гугл-ботом для смартфона, чтобы проверить косяки адаптива или мобильной версии.

Скажу сразу — это опция очень индивидуальна, лично я ее не пользую, потому что чаще всего незачем. В любом случае, настройка реагирования на http-заголовки позволяет определить, как паук будет их обрабатывать (если указаны нюансы в настройках). По крайней мере я так это понял.

В любом случае, настройка реагирования на http-заголовки позволяет определить, как паук будет их обрабатывать (если указаны нюансы в настройках). По крайней мере я так это понял.

Т.е. можно индивидуально настроить, например, какого формата контент обрабатывать, учитывать ли cookie и т.д. Нюансов там довольно много.

Custom — дополнительные настройки поиска по исходному коду

Custom Search

По сути обычный фильтр, с помощью которого можно вытягивать дополнительные данные, например, страницы, в которых вместо тега <strong> используется <bold> или еще лучше — страницы, которые НЕ содержат определенного контента (например, без кода счетчика метрики). Фактически в настройках можно задать все что угодно.

Custom Extraction

Это пользовательское извлечение любых данных из html (например, текстовое содержимое).

User Interface — обнуление настроек для колонок таблицы

Просто сбрасывает сортировку столбцов, ничего особенного, проходим дальше, граждане, не толпимся.

API Access — интеграция с разными сервисами

Для того чтобы получать больше данных по сайту, можно настроить интеграцию с разными сервисами статистики типа Google Analytics или Majestic, при условии того, что у вас есть аккаунт в этом сервисе.При этом для каждого сервиса отдельные настройки выгрузки по типам данных.

На примере GA

Authentification — настройки аутентификации (если есть запрос от сайта)

Есть два вида аутентификации — Standart Based и Form Based. По умолчанию используется Standart Base — если при парсинге от сайта приходит запрос на аутентификацию, в программе появляется соответствующее окно.

Form Based — использование для аутентификации встроенного в SF браузера (полезно, когда для подтверждения аутентификации нужно, например, пройти капчу). В данном случае необходимо вручную вводить урл сайта и в открывшемся окне браузера вводить логин/пароль, кликать recaptcha и т. д.

д.

System — внутренние настройки самой программы

Настройки работы самой программы — сколько оперативной памяти выделять на процесс, куда сохранять экспорт и т.д.

Давайте как обычно — подробнее о каждом пункте.

- Memory — выделяем лимиты оперативной памяти для парсинга. По дефолту стоит 2GB, но можно выделить больше (если ПК позволяет).

- Storage — выбор базы для хранения данных. Либо сохранение в ОЗУ (для этого у SF есть свой движок), либо в указанной папке на ПК пользователя.

- Proxy — подключение прокси-сервера для парсинга.

- Embedded Browser — использование встроенного в программу браузера (вкл/выкл).

Mode

- Spider (Режим паука) — классический парсинг сайта по внутренним ссылкам. Просто вводим нужный домен в адресную строку программы и запускаем работу.

- List — парсим только предварительно собранный список урл-адресов! Адреса можно выгрузить из файла (From a file), вбить вручную (Enter Manually), подтянуть их из карты сайта (Download Sitemap) и т.д. Если честно, этих трех способов получения списка урлов должно быть более чем достаточно.

- SERP Mode — в этом режиме нет сканирования, зато здесь можно загружать мета-данные сайта, редактировать их и предварительно понимать как они будут отображаться в браузере. Делать все это можно пакетно, что вполне себе удобно.

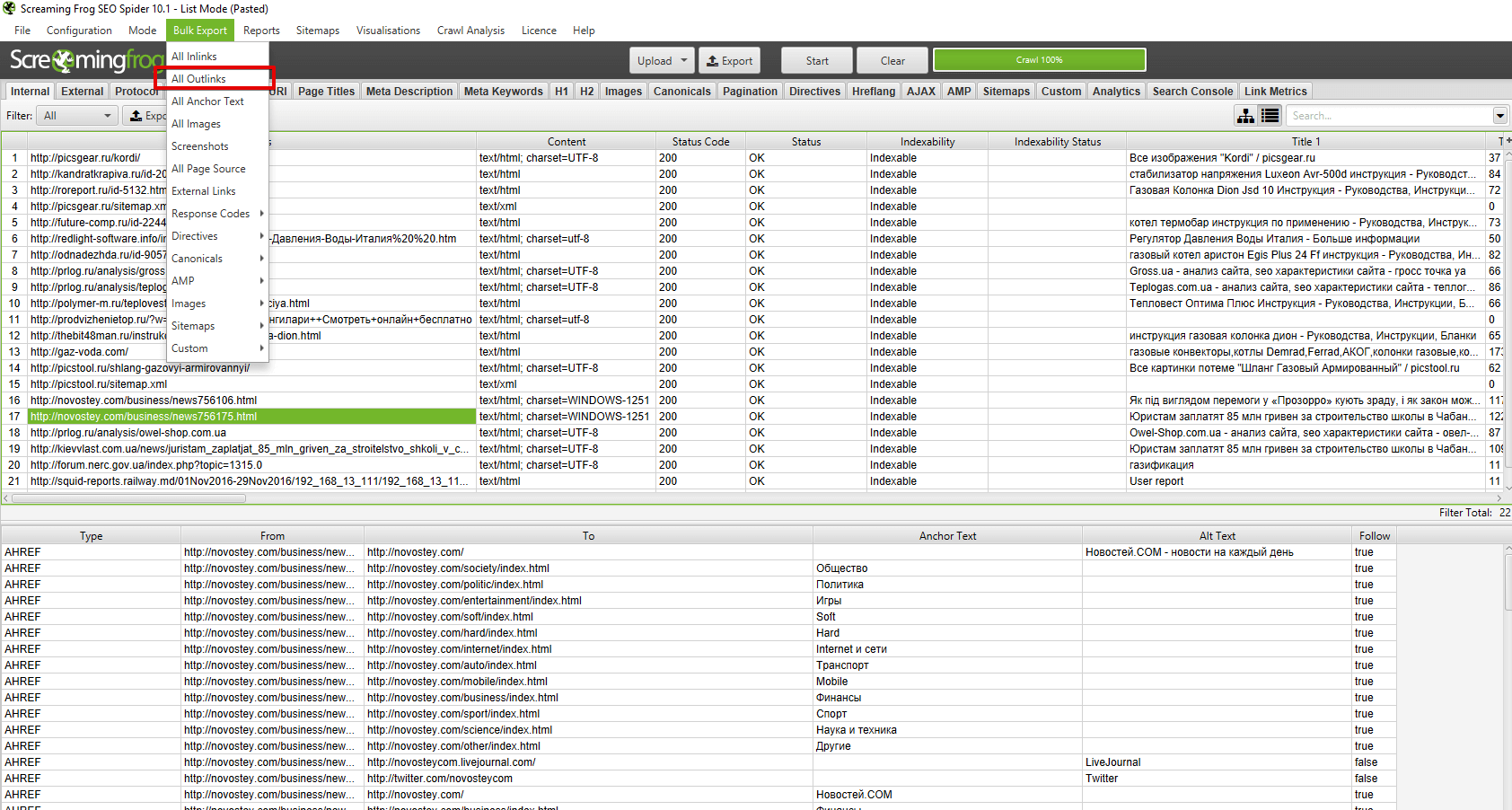

Bulk export

В этом пункте меню висят все опции SF, отвечающие за массовый экспорт данных из основного и дополнительного меню отчета. ..сейчас покажу на скриншоте.

..сейчас покажу на скриншоте.

В общем и целом с помощью bulk export можно вытянуть много разной полезной информации для последующей постановки ТЗ на доработки. Например, выгрузить в excel страницы, на которых найдены ссылки с 3хх ответом сервера + сами 3хх-ссылки, что позволяет сформировать задание для программиста или контент-менеджера (зависит от того, где зашиты 3хх-ссылки) на замену этих 3хх-ссылок на прямые с кодом 200. Теперь подробнее про то, что можно экспортировать при помощи Bulk Export.

- All Inlinks — получаем все входящие ссылки на каждый URI, с которым столкнулся краулер при сканировании сайта.

- All Outlinks — получаем все исходящие ссылки с каждого URI, с которым столкнулся краулер при сканировании сайта.

- All Anchor Text — выгрузка анкоров всех ссылок.

- All Images — выгрузка всех картинок (урл-адресами, естественно).

- Screenshots — экспорт снимков экрана.

- All Page Source — получаем статический HTML-код или обработанный HTML-код просканированных страниц (рендеринг HTML доступен только в режиме рендеринга JavaScript) .

- External Links — все внешние ссылки со всех просканированных страниц.

- Response Codes — все страницы в зависимости от выбранного кода ответа сервера (закрытые от индекса, с кодом 200, с кодом 3хх и т.д.).

- Directives — все страницы с директивами в зависимости от выбранной (Index Inlinks, Noindex Inlinks, Nofollow Inlinks и т.д.).

- Canonicals — страницы, содержащие канонические атрибуты, страницы без указания этих атрибутов, каноникализированные (*перекрестился*) страницы и т.д.

- AMP — страницы с AMP, ссылки с AMP (но код ответа не 200) и т.д.

- Structured Data — выгрузка страниц с микроразметкой.

- Images — выгрузка картинок без альт-текста, тяжелых картинок (в соответствии с указанным в настройках размером).

- Sitemaps — выгрузка всех страниц в карте сайта, неиндексируемых страниц в карте сайта и проч.

- Custom — выгрузка пользовательских фильтров.

Reports

Здесь содержится множество различных отчетов, которые также можно выгрузить.

- Crawl Overview — в этом отчете содержится сводная информация о сканировании, включая такие данные, как количество найденных URL-адресов, заблокированных robots.txt, число сканированных, тип контента, коды ответов и т. д.

- Redirect & Canonical Chains — отчет о перенаправлении и канонических цепочках. Здесь отображаются цепочки перенаправлений и канонических символов, показывается количество переходов по пути и идентифицируется источник, а также цикличность (если есть).

- Non-Indexable Canonicals — здесь можно получить выгрузку, в которой освещаются ошибки и проблемы с canonical. В частности, этот отчет покажет любые канонические файлы, которые не отдают корректного ответа сервера — заблокированы файлом robots.txt, с перенаправлением 3хх, ошибкой 4хх или 5хх (вообще все что угодно, кроме ответа «ОК» 200).

- Pagination — ошибки и проблемы с атрибутами rel=”next” и rel=”prev”, которые используются для обозначения содержимого, разбитого на пагинацию.

- Hreflang — проблемы с атрибутами hreflang (некорректный ответ сервера, страницы, на которые нет гиперссылок, разные коды языка на одной странице и т.д.).

- Insecure Content — показаны любые защищенные (HTTPS) URL-адреса, на которых есть небезопасные элементы, такие как внутренние ссылки HTTP, изображения, JS, CSS, SWF или внешние изображения в CDN, профили социальных сетей и т. д.

- SERP Summary — этот отчет позволяет быстро экспортировать URL-адреса, заголовки страниц и мета-описания с соответствующими длинами символов и шириной в пикселях.

- Orphan Pages — список потерянных страниц, собранных из Google Analytics API, Google Search Console (Search Analytics API) и XML Sitemap, которые не были сопоставлены с URL-адресами, обнаруженными во время парсинга.

- Structured Data — отчет содержит данные об ошибках валидации микроразметки страниц.

Sitemaps

С помощью этого пункта можно сгенерировать XML-карту сайта (страницы и картинки).

Все просто — выбираем что будем генерировать. В появившемся окне при необходимости выбираем нужные параметры и создаем карту сайта, которую потом заливаем в корневой каталог сайта.

Рассмотрим подробнее параметры, которые нам предлагают выбрать при генерации карты сайта.

Вкладка Pages — выбираем какие типы страниц включить в карту сайта.

- Noindex Pages — страницы, закрытые от индексации.

- Canonicalised — каноникализированные (опять это страшное слово!) страницы . Другими словами, динамика, у которой есть rel=”canonical”.

- Paginated URLs — страница пагинации.

- PDFs — PDF-документы.

- No response — страницы с кодом ответа сервера 0 (не отвечает).

- Blocked by robots.txt — страницы закрытые от индекса в robots.txt.

- 2xx — страницы с кодом 2хх (они будут в карте в любом случае).

- 3хх — страницы с кодом ответа 3хх (редиректы).

- 4хх — страницы с кодом ответа 4хх (битые ссылки на несуществующие страницы).

- 5хх — страницы с кодом ответа 5хх (проблема сервера при загрузке).

Вкладка Last Modified — выставляем дату последнего обновления карты.

- nclude <lastmod> tag — использовать в sitemap тег <lastmod> (дата последнего обновления карты).

- Use server report — использовать ответ сервера при создании карты, либо проставить дату вручную.

Вкладка Priority — выставляем приоритет ссылки в зависимости от глубины залегания страницы.

- Include <priority> tag — добавляет в карту сайта тег <priority>, показывающий приоритет страницы.

- Crawl Depth 0-5+ — в зависимости от глубины залегания страницы, можно проставить ее приоритет сканирования для поискового робота.

Вкладка Change Frequency — выставляем вероятную частоту обновления страниц.

- Include <changefreq> tag — использовать тег <changefreq> в карте сайта. Показывает частоту обновления страницы.

- Calculate from Last Modified header — рассчитать тег по последнему измененному заголовку.

- Use crawl depth settings — проставить тег в зависимости от глубины страницы.

Вкладка Images — добавляем картинки в карту сайта.

- Include Images — выводить в общей карте сайта картинки.

- Include Noindex Images — добавить картинки, закрытые от индекса.

- Include only relevant Images with up to … inlinks — добавить только картинки с заданным числом входящих ссылок.

- Regex list of CDNs hosting images to be included — честно, так и не понял что это такое… возможно настройка выгрузки в карту сайта картинок из хостинга (т.е. можно вбить списком несколько хостов и оттуда подтянуть картинки), но это всего лишь мои предположения.

Вкладка Hreflang — использовать в sitemap атрибут <hreflang> (или не использовать).

Visualisations

Это выбор интерактивной визуализации структуры сайта в программе. Можно получить отображение дерева сканирования и дерева каталогов. Основная фишка в том, что открываются эти карты и диаграммы во встроенном браузере программы, что позволяет эффективнее с ними работать (настраивать выведение, масштабировать, перескакивать к нужным урлам через поиск и т.д.).

Crawl Tree Graph — визуализация сканирования. По факту после завершения краулинга показывает текущую структуру сайта на основании анализа.

Directory Tree Graph — показывает ВСЕ каталоги после сканирования. Т.е. отличие от Crawl Tree Graph в том, что в этом отчете показываются, например, папки, закрытые от индекса. Назначение Crawl Tree Graph и Directory Tree Graph в основном заключается в упрощении анализа структуры текущего сайта, можно глазами пробежаться по всем папкам, зацепиться за косяки (т. к. они выделены цветом). При наведении на папку, показывается ее данные (url, title, h2, h3 и т.д.).

к. они выделены цветом). При наведении на папку, показывается ее данные (url, title, h2, h3 и т.д.).

Force Directed Crawl-Diagram — по сути то же самое, что и Crawl Tree Graph, только оформленное по-другому + показывает сканирование сайта относительно главной страницы (ну или стартовой). Кому-то покажется нагляднее, хотя по мне, выглядит гораздо сложнее для восприятия.

Force Directed Tree-Diagram — аналогично, другой тип визуализации дерева каталогов сайта.

Inlink Anchor Text Word Cloud — визуализация анкоров (ссылочного текста) внутренней ссылки. Анализирует каждую страницу по-отдельности. Помогает понять какими анкорами обозначена страница, как их много, насколько разнообразны и т.д.

Р- Разнообразие

Body Text Word Cloud — визуализация плотности отдельных слов на странице. По сути выглядит так же, как и Inlink Anchor Text Word Cloud, так что отдельный скрин делать смысла особого нет — обычное облако слов, по размеру можно определить какое слово встречается чаще, по общему числу посмотреть разнообразие слов на странице и т.д.

Каждая визуализация имеет массу настроек вывода данных, маркировки — про них я писать не буду, если станет интересно, сами поиграетесь, ок? Там ничего сложного.

Crawl Analysis

Большинство параметров сайта вычисляется пауком в ходе сбора статистики, однако некоторые данные (Link Score, некоторые фильтры и прочее) нуждаются в дополнительном анализе, чтобы попасть в финальный отчет. Данные, которые нуждаются в Crawl Analysis, помечены соответствующим образом в правом меню навигации.

Crawl Analysis запускается после основного парсинга. Перед запуском дополнительного анализа, можно настроить его (какие данные выводить в отчет).

- Link Score — присвоение оценок всем внутренним ссылкам сайта.

- Pagination — показывает петлевые пагинации, а также страницы, которые обнаружены только через атрибуты rel=”next”/”prev”.

- Hreflang — урлы hreflang без гиперссылки, битые ссылки.

- AMP — страницы без тегов “html amp”, теги не с 200 кодом ответа.

- Sitemaps — неиндексируемые страницы в карте сайта, урлы в нескольких картах сайта, потерянные страницы (например, есть в Google Analytics, есть в sitemap, не обнаружено при парсинге), страницы, которых нет в карте сайта, страницы в карте сайта.

- Analytics — потерянные страницы (есть в аналитике, нет в парсинге).

- Search Console — потерянные страницы (есть в вебмастере, нет в парсинге).

License

Исходя из названия, логично предположить, что этот пункт меню отвечает за разного рода манипуляции с активацией продукта…иии так оно и есть!

Buy a License — купить лицензию. При клике переход на соответствующую страницу официалов https://www.screamingfrog.co.uk/seo-spider/licence/. Стоимость ключа для одного ПК — 149 фунтов стерлинга. Есть пакеты для нескольких ПК, там, как обычно, идут скидки за опт.

Enter License — ввести логин и ключ лицензии, чтобы активировать полный функционал парсера.

Заметили, да? Лицензия покупается на год, не бессрочная

Help

Помощь юзеру — гайды, FAQ, связь с техподдержкой, в общем все, что связано с работой программы, ее багами и их решением.

- User Guide — мануал по работе с программой. Собственно, его я использовал, как один из источников, для написания этой статьи. При желании, можете ознакомиться, если я что-то непонятно рассказал или не донес. Еще раз оставлю ссылку https://www.screamingfrog.co.uk/seo-spider/user-guide/.

- FAQ — часто задаваемые вопросы по работе с SF и ответы на них https://www.screamingfrog.co.uk/seo-spider/faq/.

- Support — обратная связь с техподдержкой https://www.screamingfrog.co.uk/seo-spider/support/. Если программа ведет себя некрасиво (например, не принимает ключ лицензии), можно пожаловаться куда надо и все починят.

- Feedback — обратная связь. Та же самая страница, что и в Support. Т.е. можно не только жаловаться, но и вносить предложения по работе программы, предлагать партнерку, сказать банальное “спасибо” за такой крутой сервис (думаю ребятам будет приятно).

- Check for Updates и Auto Check for Updates — проверка на наличие обновлений программы. Screaming Frog нерегулярно, но довольно часто дорабатывается, поэтому есть смысл периодически проверять апдейты. Но лучше поставить галочку на Auto Check for Updates и программа сама будет автоматически предлагать обновиться при выходе нового апа.

- Debug — отчет о текущем состоянии программы. Нужно, если вы словили какой-то баг и хотите о нем сообщить разработчику. Там еще дополнительно есть настройки дебага, но я думаю, нет смысла заострять на этом внимание.

- About — собственно, краткая информация о самой программе (копирайт, сервисы, которые использовались при разработке).

Итог

Screaming Frog — очень гибкая в плане настройке утилита, с помощью которой можно вытянуть массу данных для анализа, нужно только (только… ха-ха) правильно настроить парсинг. Я надеюсь, мой мануал поможет вам в этом, хотя и не все я рассмотрел как надо, есть пробелы, но основные функции должны быть понятны.

Теперь от себя — текста много, скринов много, потому, если вы начинающий SEO-специалист, рекомендую осваивать SF поэтапно, не хватайтесь за все сразу, ибо есть шанс упустить важные нюансы.

Ну вот и все, ребята, я отчаливаю за новым материалом для нашего крутого блога. Подписывайтесь, чтобы не пропустить интересные публикации от меня и моих коллег. Всем удачи, всем пока!

Владимир Еленский

Практикующий SEO-специалист MAXI.BY media. Опыт работы более 5-ти лет. Хороший человек и просто красавчик.Инструменты для интернет-маркетинга, SEO и SMM

Screaming Frog SEO Spider – многофункциональный инструмент аудита и оптимизации сайтов для использования в профессиональной среде. Сканирует по множеству показателей, выявляет ошибки кода, препятствующие эффективному продвижению. Доступна бесплатная ознакомительная версия для проведения экспресс-анализа.

Сканирует по множеству показателей, выявляет ошибки кода, препятствующие эффективному продвижению. Доступна бесплатная ознакомительная версия для проведения экспресс-анализа.

В области SEO-оптимизации сайтов особое место занимают инструменты, способные в короткое время проанализировать внутреннюю структуру ресурса по всем необходимым показателям. Одна из таки программ — Screaming Frog SEO Spider, разработанная британским специалистом на основе популярной Xenu Link Sleuth, но с намного более широким функционалом. Так, Screaming Frog SEO Spider собирает ключевые данные о коде сайта и находит ошибки, препятствующие эффективному продвижению.

Стоит заметить, что программа Screaming Frog SEO Spider – платная, на данный момент покупка лицензии обойдется в 149 фунтов стерлингов в год. Но есть возможность скачать ознакомительную версию. Конечно, возможности демо-версии ограничены: количество проверяемых страниц – не более пятисот, однако ее вполне достаточно для поиска битых ссылок, неуникальных заголовков, дублей, а также генерации XML карты сайта. Для периодического экспресс-аудита бесплатная версия годится лучше всего.

Продвижение и SEO-оптимизация сайта, главная цель которого – продажа товаров, услуг, рекламных площадок, – это долгий и кропотливый процесс. Советуем проводить полное сканирование всего сайта или его разделов, если возникают проблемы с его продвижением. Для этого воспользуйтесь полной версией Screaming Frog SEO Spider.

Итак, что же предлагает нам данный SEO-сканер?

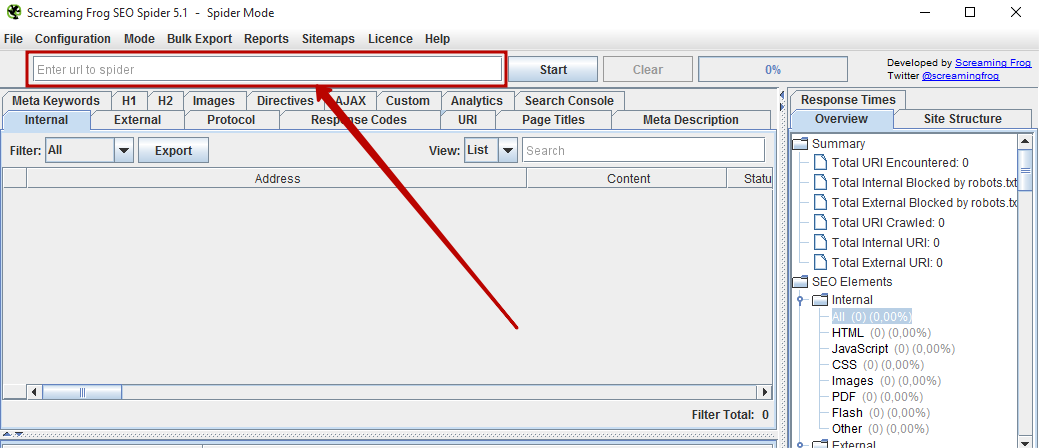

Программа проста в управлении. После инсталляции она открывается в нехитром и понятном интерфейсе. Достаточно лишь ввести в специальную строку адрес главной страницы сайт и нажать «старт». В процессе проверки отображается различная информация о содержании страниц, можно отфильтровать ее по типу (HTML, флэш, адреса картинок и т.д.).

Результаты аудита выводятся в виде таблицы и отсортированы по вкладкам

-

Internal – основные данные (адреса, тип контента и кодировка, статусы и коды ответа веб-сервера, информация о заголовках и других мета-тегах, размер станиц и уровень вложенности, исходящий и входящие внутренние и внешние ссылки, выявление дубликата контента).

-

External – внешние ресурсы, на которые ведут ссылки на проверяемом сайте (адреса, тип, кодировка, данные ответа веб-сервера, вложенность, а также общее количество внешних ссылок).

-

Response Code – информация о перенаправлениях (типы и цель редиректа).

-

URL – список неправильных, битых ссылок, данные других проблемных показателей (дубли, динамические адреса, некорректные символы, количество символов в адресах).

-

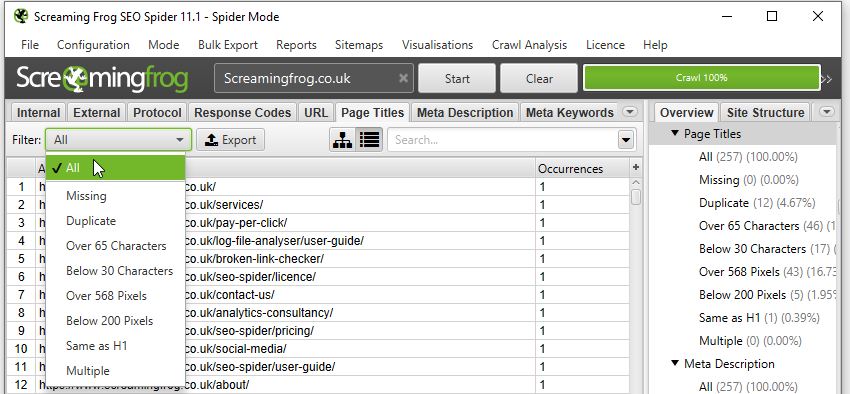

Page Titles – информация о тайтлах (заголовках) страниц (здесь ведется поиск страниц с отсутствующими тайтлами, дублями, выводится количество символов по каждому тайтлу, совпадения с h2 заголовками).

-

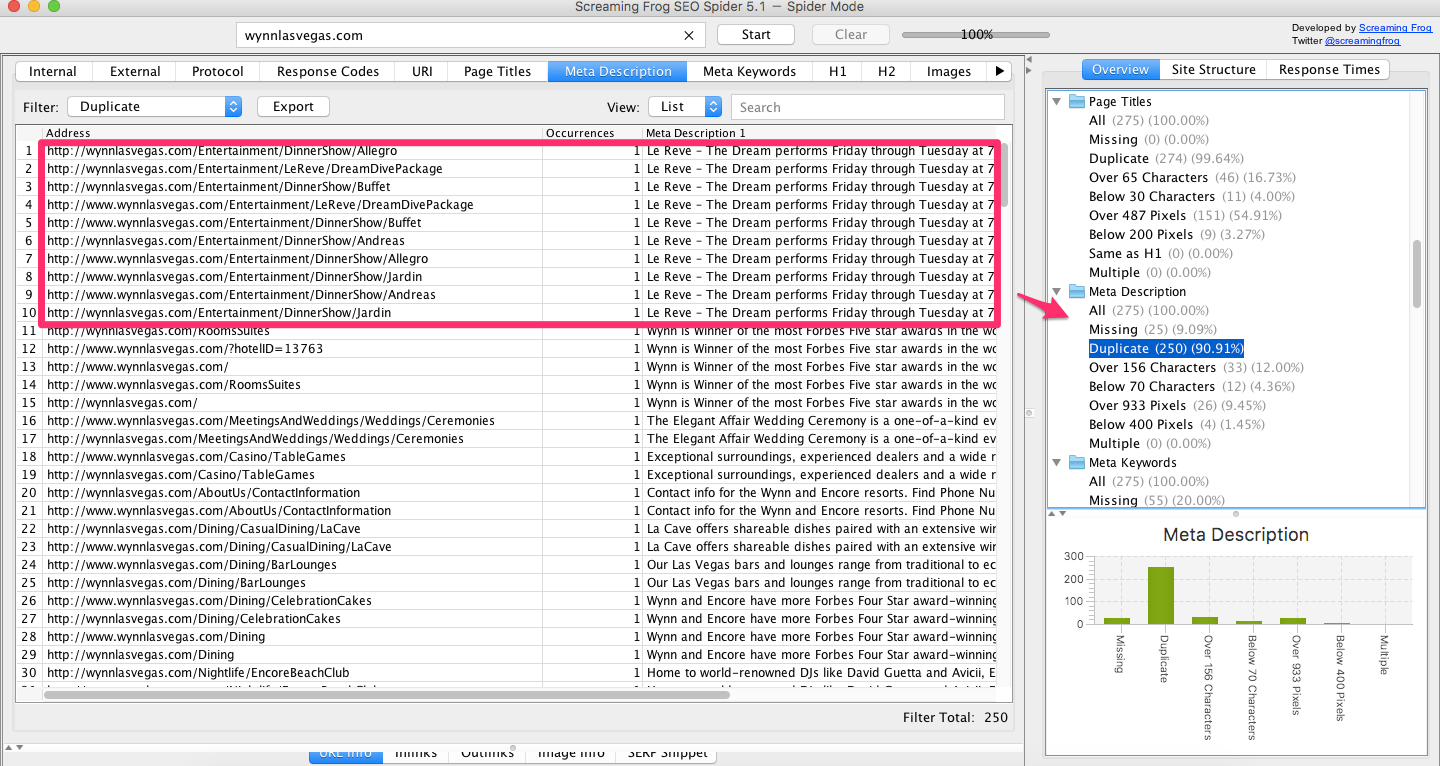

Meta Description – информация о свойствах данного тега.

-

Meta Keywords – анализ содержания ключевых слов на страницах.

-

вкладки h2 и h3 – результаты по заголовкам на всех анализируемых страницах сайта.

-

Images – количество и вес графических файлов на страницах сайта (необходимая информация для оптимизации и качества загрузки страниц).

-

Meta & Canonical – данные о meta robots и rel=canonical в структуре сайта.

Несмотря на видимую простоту, программа действительно обладает поражающим функционалом, доступным для пользователей лицензии. Информация отображается в реальном времени с быстрой загрузкой данных, есть возможность экспортировать таблицы в файл Excel, а также отфильтровать их вручную по различным показателям.

Для проведения комплексного разбора кода сайтов в сфере SEO-продвижения используются различные сервисы. Screaming Frog SEO Spider – приложение нового поколения, эффективный инструмент оптимизации, который должен быть в арсенале любого профессионального вебмастера и SEO-специалиста.

Назад в раздел

Подробная инструкция по использованию Screaming Frog SEO Spider

Автор Никита Чижиченко На чтение 12 мин. Просмотров 14.4k. Опубликовано

Правильный аудит сайта – это половина успешной оптимизации. Но для его проведения требуется ряд инструментов и их понимание.

Одним из наиболее полезных сервисов является Screaming Frog (SF), который дает возможность с помощью парсинга (сбора информации) получить необходимые данные, например, массово выгрузить пустые страницы или найти все дубликаты по метатегу Title.

В процессе оптимизации мы часто используем данный сервис, поэтому решили составить цикл обзорных статей, чтобы упростить специалистам навигацию по инструментарию и поиску решений нетривиальных задач. В этой статье-переводе расскажем о настройке парсинга и опишем, как без лишних проблем сканировать большие сайты.

Ознакомиться с сервисом более подробно можно в разделе первоисточника User Guide, на этом же сайте можно скачать бесплатную версию (предел парсинга – до 500 страниц, есть ограничение в настройках, поэтому рекомендуем использовать полную версию).

Configuration Options (опции для парсинга)Spider ConfigurationЗдесь задаются основные настройки парсера, которые разбиты по следующим вкладкам:

- Basic;

- Limits;

- Rendering;

- Advanced;

- Preferences.

Если здесь и далее чекбокс отмечен, выполняется указанный вид операции с созданием (при возможности) соответствующего отчета:

- Check Images – анализ картинок.

- Check CSS – анализ CSS-файлов.

- Check JavaScript – анализ JS-файлов.

- Check SWF — анализ Flash-анимаций.

- Check External Link – анализ ссылок с сайта на другие ресурсы.

- Check Links Outside of Start Folder – возможность проанализировать ссылки вне сканирования стартовой папки.

- Follow internal “nofollow” – сканирование внутренних ссылок, закрытые в тег “nofollow”.

- Follow external “nofollow” – сканирование ссылок на другие сайты, закрытые в тег “nofollow”.

- Crawl All Subdomains – парсинг всех поддоменов сайта, если ссылки на них встречаются на сканируемом домене.

- Crawl Outside of Start Folder – сканируется весь сайт, однако проверка начинается с указанной папки.

- Crawl Canonicals – выведение в отчете атрибута rel=”canonical” при сканировании страниц с использованием данного атрибута.

- Crawl Next/Prev – выведение в отчете атрибутов rel=”next”/”prev” при сканировании страниц пагинации.

- Extract hreflang/Crawl hreflang – при сканировании учитывается атрибут hreflang, отображаются коды языка и региона страницы.

- Extract AMP Links/Crawl AMP Links – извлечение в отчет ссылок с атрибутом AMP (определение версии контента на странице).

- Crawl Linked XML Sitemap – сканирование карты сайта.

Если включена данная опция, можно выбрать «Auto Discover XML Sitemaps via robots.txt» (SF сам найдет sitemap.xml с помощью robots.txt) или предоставить список файлов, отметив «Crawl These Sitemap» и вставив их в поле, которое появится.

Limits- Limit Crawl Total – задаем лимиты страниц для сканирования (сколько страниц сканируем для одного проекта).

- Limit Crawl Depth – задаем глубину парсинга: до какого уровня может дойти краулер при сканировании проекта. Если укажете уровень вложенности 1, Screaming Frog выдаст все URL уровня вложенности от введенного документа.

Например, если указать главную страницу и в Limit Crawl Depth добавить значение 1, то краулер перейдет по всем ссылкам с главной страницы и остановится. При параметре со значением 0 будет проверен только указанный документ.

Например, если указать главную страницу и в Limit Crawl Depth добавить значение 1, то краулер перейдет по всем ссылкам с главной страницы и остановится. При параметре со значением 0 будет проверен только указанный документ. - Limit Max Folder Depth – задаем глубину парсинга вплоть до уровня вложенности папки. Указанное значение отвечает за то, как глубоко можно сканировать сайт по адресу URL site.ru/papka-1/papka-2/papka-3/, где значение – параметр в Limit Max Folder Depth.

- Limit Number of Query Strings – задаем глубину парсинга для страниц с параметрами.

- Max Redirects to Follow – задаем максимальное количество редиректов, по которым краулер может переходить с одного адреса.

- Max URL Length to Crawl – максимальная длина URL, допустимого для сканирования.

- Max Links per URL to Crawl – максимальное количество ссылок в сканируемом URL для обхода.

- Max Page Size (KB) to Crawl – максимальный размер страницы для обхода (указываем в килобайтах).

На выбор три опции:

- Text Only – краулер анализирует только текст страницы.

- Old AJAX Crawling Scheme – проверяет по устаревшей схеме сканирования AJAX.

- JavaScript – учитывает скрипты при рендеринге.

Детальные настройки есть только в опции JavaScript.

- Enable Rendered Page Screen Shots – если чекбокс активен, SF делает скриншоты анализируемых страниц и сохраняет их в папке на ПК.

- AJAX Timeout (secs) – лимиты таймаута. Означает, как долго SF должен разрешать выполнение JavaScript, прежде чем проверять загруженную страницу.

- Window Size – выбор размера окна.

- Sample – пример окна.

- Чекбокс Rotate – повернуть окно (было 768х1280, стало 1280х768).

- Allow Cookies – учитывает Cookies, как это делает поисковый бот (можно принимать во внимание при выборе бота для парсинга).

- Pause on High Memory Used – останавливает сканирование сайта, если процесс забирает слишком много оперативной памяти. После остановки можно отключить опцию и продолжить парсинг.

- Always Follows Redirect – разрешает краулеру анализировать все редиректы, вплоть до финальной страницы.

- Always Follows Canonicals – разрешает краулеру анализировать все атрибуты “canonical”, вплоть до финальной страницы.

- Respect Noindex – страницы с “noindex” не отображаются в отчете.

- Respect Canonical – страницы с “canonical” не отображаются в отчете.

- Respect Next/Prev – страницы с rel=”next”/”prev” не отображаются в отчете, кроме первой (основной).

- Extract Images from img srscet Attribute – изображения извлекаются из атрибута srscet тега <img>. SRSCET – атрибут, который позволяет указывать разные типы изображений для разных размеров экрана/ориентации/типов отображения.

- Respect HSTS Policy – если чекбокс активен, SF выполнит все будущие запросы через HTTPS, даже если перейдет по ссылке на URL-адрес HTTP (в этом случае код ответа будет 307). Если же чекбокс неактивен, краулер покажет «истинный» код (например, в случае постоянного редиректа – 301).

- Respect Self Referencing Meta Refresh – учитывает принудительную переадресацию на себя же по метатегу Refresh.

- Response Timeout – время ожидания ответа страницы, перед тем как краулер перейдет к анализу следующего URL. Можно сделать больше (для медленных сайтов) или меньше.

- 5хх Response Retries – количество попыток “достучаться” до страниц с 5хх ответом сервера.

- Store HTML – можно сохранить статический HTML-код каждого просканированного URL-адреса на диск и просмотреть до обработки JavaScript.

- Store Rendered HTML – позволяет сохранить отображенный HTML-код каждого просканированного URL-адреса на диск и просмотреть DOM после обработки JavaScript.

- Extract JSON-LD – извлекает микроразметку сайта JSON-LD.

- Extract Microdata – извлекает микроразметку сайта Microdata.

- Extract RDFa – извлекает микроразметку сайта RDFa.

При выборе последних трех пунктов в каждом случае доступны дополнительные чекбоксы с типами валидации микроразметки (Schema.org, Google Validation, Case-Sensitive).

Здесь задаем желаемые параметры для ряда сканируемых элементов (Title, Description, URL, h2, h3, ALT и размер картинок).

- Page Title Width – оптимальная ширина заголовка страницы. Указываем желаемые размеры от и до в пикселях и в символах.

- Meta Description Width – оптимальная ширина описания страницы. Размеры – как в случае с Title.

- Other – сюда входит максимальная желаемая длина:

- URL-адреса в символах (Max URL Length Chars).

- h2 в символах (Max h2 Length Chars).

- h3 в символах (Max h3 Length Chars).

- ALT картинок в символах (Max Image Length Chars).

- Максимальный вес картинок в КБ (Max Image Size Kilobytes).

Здесь мы указываем парсеру, как именно учитывать файл robots.txt. Блок разделен на две вкладки – Settings и Custom.

SettingsIgnore robots.txtПо умолчанию SF будет подчиняться протоколу robots.txt: например, если сайт запрещен для сканирования в robots.txt, краулер не сможет его спарсить. Однако данная опция позволяет игнорировать этот протокол, таким образом разрешая попадание в отчет всех папок и файлов.

Respect robots.txtПри выборе опции мы можем получить отчет по внутренним и внешним ссылкам, закрытым от индексации в robots. txt. Для этого необходимо выбрать соответствующие чекбоксы: для отчета по внешним ссылкам – Show external URLs blocked by robots.txt, по внутренним – Show internal URLs blocked by robots.txt.

txt. Для этого необходимо выбрать соответствующие чекбоксы: для отчета по внешним ссылкам – Show external URLs blocked by robots.txt, по внутренним – Show internal URLs blocked by robots.txt.

Пользовательский файл robots.txt использует выбранный User Agent в конфигурации, таким образом данная опция позволит просканировать или протестировать robots.txt без необходимости внесения правок для актуальных директив или использования панелей вебмастеров.

Сначала укажите в основной строке название, нажмите кнопку Add, в итоге вы получите robots.txt домена:

В правом нижнем углу есть кнопка Test. Если слева вписать нужный URL домена и нажать на нее, программа покажет доступность URL для индекса с учетом указанных в robots.txt настроек.

URL RewritingДанный блок дает возможность перезаписать сканируемые URL в процессе парсинга. Функция удобна, если во время сканирования надо изменить регулярные выражения, которые не нужны в конечном отчете.

Remove ParametersЗдесь вводят параметры, которые можно удалить из URL при анализе сайта либо исключить все возможные параметры (чекбокс Remove all):

Regex ReplaceИзменяет все сканируемые URL с использованием регулярных выражений. Например, можно изменить все ссылки с HTTP на HTTPS:

OptionsЗдесь определяем перезапись прописных URL в строчные.

TestТут можно тестировать видоизменения URL перед началом парсинга, пример с учетом версии для Regex Replace:

CDNsДанная функция позволяет включать в парсинг дополнительные домены и папки, считая их внутренними ссылками. При этом можно указать для сканирования только конкретные папки:

Во вкладке Test можно посмотреть, как будут определяться URL с учетом параметров Internal и External, где Internal означает, что ссылка считается внутренней, а External – внешней.

Во вкладке Include мы вписываем выражения для парсинга только указанных папок, во вкладке Exclude – исключения, для парсинга всех, кроме указанных.

Разберем логику на примере вкладки Exclude:

Чтобы проверить выражение, можно использовать вкладку Test. Например, нужно запретить парсинг домена.

Если правило указано верно, то в Test при вводе нужного URL будет следующее:

Примеры других выражений:

- Чтобы исключить конкретный URL или страницу: http://www.example.com/do-not-crawl-this-page.html

- Чтобы исключить подкаталог или папку: http://www.example.com/do-not-crawl-this-folder/.*

- Чтобы исключить все после бренда, где иногда могут быть другие папки: http://www.example.com/.*/brand.*

- Если нужно исключить URL с определенным параметром, таким как price, содержащимся во множестве различных каталогов, можно использовать следующее выражение:

.*\?price.*

Важно: “?” является специальным символом в регулярном выражении и должен быть экранирован обратной косой чертой.

- Если нужно исключить все файлы, заканчивающиеся на .jpg, регулярное выражение будет выглядеть так:

.*jpg$

- Если нужно исключить все URL-адреса, заканчивающиеся случайным 6-значным числом после дефиса, например «-402001», регулярное выражение имеет такой вид:

.*-[0-9]{6}$

- Если нужно исключить любой URL, в котором есть produce, регулярное выражение будет:

.*produce.*

- Исключение страниц с HTTPS:

.*HTTPS.*

- Исключение всех страниц на http://www.domain.com: http://www.domain.com/.*

- Если не получается исключить URL-адрес, причиной может служить наличие специальных символов регулярного выражения, например “?”.

Вместо того, чтобы пытаться найти и экранировать их по отдельности (с помощью “\”), можно экранировать всю строку, начиная с \Q и заканчивая \E, например:

\Qhttp://www.example.com/test.php?product=special\E

Можно выставить как количество потоков (по умолчанию 5), так и число одновременно сканируемых адресов. Влияет как на скорость парсинга, так и на вероятность бана бота, поэтому лучше быть осторожными.

User-Agent (с помощью какого “бота” парсим)Опция Preset User-Agents позволяет выбрать, от лица какого бота будет происходить парсинг. Полезно, если в настройках сайта есть директивы, блокирующие конкретного бота. Дополнительно удобно при поиске ошибок, если парсинг производить от “лица” Googlebot Smartphone.

Данная опция позволяет указать конкретный вид контента для сканирования. Настроек много – от Accept-Language, Cookie, Referer или просто указания уникального имени заголовка.

Custom (настройки для парсинга дополнительных данных)Данная вкладка является одной из наиболее ценных, если есть необходимость в поиске конкретной информации по всему сайту.

Custom Search

Функция дает возможность получить отчет с учетом любого регулярного выражения, которое будет указано в соответствующем фильтре. Например, можно получить отчет по страницам, содержащим кодировку utf-8 в HTML-коде:

Используем соответствующий фильтр:

С помощью данной функции можно получить информацию при помощи CSS, XPath или Regex, например:

За счет функции Extract text можно получить данные о количестве статей в разных странах в отчете Custom:

User Interface (сброс сортировки столбцов)Функция для сброса пользовательской сортировки столбцов. Это все 🙂

API Access (интеграция с сервисами)Чтобы получить больше данных по сайту, можно настроить интеграцию с разными сервисами статистики, например, с Google Analytics или Ahrefs, при условии, что у вас есть необходимые данные для интеграции.

Здесь указываем предел оперативной памяти для парсинга.

Можно указать больше заданного, но делать это нужно осторожно.

StorageЗдесь указывается, куда будут сохраняться отчеты – в папку программы либо по указанному пути.

ProxyУказываете прокси, с помощью которых будет происходить парсинг (используется, если выбран чекбокс).

Embedded BrowserЕсли чекбокс активен, парсер использует встроенный в программу браузер для сканирования.

Mode (режимы сканирования)Выбираем режимы сканирования сайта.

Spider – классический парсинг сайта по внутренним ссылкам, вводим домен в адресную строку.

List – парсим только предварительно собранный список URL-адресов. Указать их можно несколькими способами:

- From a File – выгружаем URL-адреса из файла.

- Paste – выгружаем URL-адреса из буфера обмена.

- Enter Manually – вводим вручную в соответствующее поле.

- Download Sitemap – выгружаем их из карты сайта.

SERP Mode – режим не для сканирования: в нем можно загружать метаданные сайта, редактировать и тестировать для понимания дальнейшего отображения в браузере.

После парсинга информацию можно посмотреть в соответствующих отчетах вверху:

Или сбоку:

С помощью данных настроек можно решить ряд как простых, так и сложных задач в рамках аудита сайта. В других статьях мы будем их рассматривать.

Обновление SEO Spider Screaming Frog

Мы рады запустить Screaming Frog SEO Spider версии 14.0 под внутренним кодовым названием «мания величия».

С момента выпуска версии 13 в июле разработчики были заняты работой над следующим раундом функций для версии 14, основываясь на отзывах пользователей и, как всегда, небольшом внутреннем управлении.

Давайте поговорим о том, что нового в этом выпуске.

1) Темный режим

Возможно, это не самая важная функция в этом выпуске, но она используется на всех скриншотах, поэтому имеет смысл поговорить в первую очередь. Теперь вы можете переключиться в темный режим через «Конфигурация > Пользовательский интерфейс > Тема > Темный».

Это не только поможет снизить нагрузку на глаза для тех, кто работает при слабом освещении (все, кто сейчас живет в условиях пандемии), но и выглядит очень круто – и, как предполагаю (сейчас я), значительно повысит ваши технические навыки SEO.

Те, кто не напрягает глаза, могут заметить, что разработчики также изменили некоторые другие элементы стилей и графики, например, те, что находятся на вкладках обзора справа и структуры сайта.

2) Экспорт в Google Таблицы

Теперь вы можете экспортировать прямо в Google Таблицы.

Вы можете добавить несколько учетных записей Google и быстро подключиться к любой, чтобы сохранить данные сканирования, которые появятся на Google Диске в папке Screaming Frog SEO Spider и будут доступны через Таблицы.

Многие из вас уже знают, что Google Таблицы на самом деле не предназначены для масштабирования и имеют ограничение в 5 м ячеек. Это звучит много, но когда у вас по умолчанию 55 столбцов на вкладке Internal (которые могут легко утроиться в зависимости от вашей конфигурации), это означает, что вы можете экспортировать только около 90 тысяч строк (55 x 90 000 = 4950 000 ячеек).

Если вам нужно экспортировать больше, используйте другой формат экспорта, соответствующий размеру (или уменьшите количество столбцов). Стоит отметить что разработчики начали работу над записью на несколько листов, но на самом деле Таблицы не следует использовать таким образом.

Это также было интегрировано в планирование и командную строку. Это означает, что вы можете запланировать сканирование, которое автоматически экспортирует любые вкладки, фильтры, экспорт или отчеты в таблицу на Google Диске.

Вы можете создать папку с отметкой времени на Google Диске или перезаписать существующий файл.

Это должно быть полезно при обмене данными в командах, с клиентами или для отчетов Google Data Studio.

3) Заголовки HTTP

Теперь вы можете хранить, просматривать и запрашивать полные заголовки HTTP. Это может быть полезно при анализе различных сценариев, которые не охватываются извлеченными заголовками по умолчанию, таких как сведения о состоянии кеширования, set-cookie, content-language, политиках функций, заголовках безопасности и т.

Вы можете извлечь их, выбрав «Конфигурация > Паук > Извлечение» и выбрав «Заголовки HTTP». Заголовки запроса и ответа будут показаны полностью на вкладке «Заголовки HTTP» нижнего окна.

Заголовки HTTP-ответа также добавляются в виде столбцов на вкладке Internal, поэтому их можно просматривать, запрашивать и экспортировать вместе со всеми обычными данными сканирования.

Заголовки также можно экспортировать массово через «Массовый экспорт > Интернет > Все заголовки HTTP».

4) файлы cookie

Теперь вы также можете хранить файлы cookie через сканирование. Вы можете извлечь их, выбрав «Конфигурация > Паук > Извлечение» и выбрав «Файлы cookie». Затем они будут полностью показаны на вкладке Cookies в нижнем окне.

Вам нужно будет использовать режим рендеринга JavaScript, чтобы получить точное представление о файлах cookie, которые загружаются на страницу с помощью JavaScript или тегов изображений пикселей.

SEO Spider будет собирать имя файла cookie, значение, домен (первый или сторонний), срок действия, а также такие атрибуты, как secure и HttpOnly.

Затем эти данные могут быть проанализированы в совокупности, чтобы помочь в проверке файлов cookie, например, для GDPR, через «Отчеты > Файлы cookie > Сводка файлов cookie».

Вы также можете выделить несколько URL-адресов одновременно для массового анализа или экспортировать через «Массовый экспорт > Интернет > Все файлы cookie».

Обратите внимание: при выборе сохранения файлов cookie автоматическое исключение, выполняемое SEO Spider для тегов отслеживания Google Analytics, отключается, чтобы обеспечить точное представление всех выпущенных файлов cookie.

Это означает, что это повлияет на вашу аналитическую отчетность, если вы не решите исключить любые скрипты отслеживания из запуска с помощью конфигурации Exclude («Конфигурация > Исключить») или отфильтровать пользовательский агент «Screaming Frog SEO Spider» аналогично исключению PSI в этом FAQ.

5) Агрегированная структура сайта

SEO Spider теперь отображает количество URL-адресов, обнаруженных в каждом каталоге, в дереве каталогов (к которому вы можете получить доступ через значок дерева рядом с «Экспорт» на верхних вкладках).

Это помогает лучше понять размер и архитектуру веб-сайта, и некоторые пользователи считают его более логичным в использовании, чем традиционное представление списка.

Наряду с этим обновлением команда разработчиков улучшила правую вкладку «Структура сайта», чтобы отобразить агрегированное представление веб-сайта в виде дерева каталогов. Это помогает быстро визуализировать структуру веб-сайта и с первого взгляда определять, где возникают проблемы, например, индексируемость различных путей.

Если вы нашли области сайта с неиндексируемыми URL-адресами, вы можете переключить «вид», чтобы проанализировать «статус индексируемости» этих различных сегментов пути, чтобы увидеть причины, по которым они считаются неиндексируемыми.

Вы также можете переключить представление на глубину сканирования по каталогам, чтобы помочь выявить любые проблемы с внутренними ссылками на разделы сайта и многое другое.

Этот более широкий агрегированный вид веб-сайта должен помочь вам визуализировать архитектуру и принимать более обоснованные решения для различных разделов и сегментов.

6) Новые параметры конфигурации

Предоставлены два новых и важных параметра конфигурации – «Игнорировать неиндексируемые URL-адреса для фильтров на странице» и «Игнорировать URL-адреса с разбивкой на страницы для повторяющихся фильтров».

Оба они включены по умолчанию через «Конфигурация > Паук > Дополнительно» и означают, что неиндексируемые страницы не будут отмечены соответствующими фильтрами на странице для заголовков страниц, мета описаний или заголовков.

Это означает, что URL-адреса не будут считаться «повторяющимися», «более X символов» или «менее X символов», если, например, они являются noindex и, следовательно, не индексируются. Страницы, разбитые на страницы, также не будут помечены на дублирование.

Если вы сканируете промежуточный веб-сайт, у которого нет индекса на всех страницах, не забудьте отключить эти параметры.

Эти параметры немного отличаются от параметров конфигурации «здесь », которые вообще исключают появление неиндексируемых URL-адресов. Неиндексируемые URL-адреса по-прежнему будут отображаться в интерфейсе, они просто не будут помечены для соответствующих проблем.

Прочие обновления

Версия 14.0 также включает ряд небольших обновлений и исправлений ошибок, описанных ниже.

- На вкладке «Изображения» появился новый фильтр «Отсутствующий атрибут Alt». Ранее отсутствующие и пустые атрибуты alt появлялись под единственным фильтром «Отсутствующий замещающий текст». Однако может быть полезно разделить их, так как декоративные изображения должны иметь пустой замещающий текст (alt = “”), а не пропускать атрибут alt, который может вызвать проблемы в программах чтения с экрана. См. Наше руководство «Как найти отсутствующий замещающий текст и атрибуты изображения».

- Headless Chrome, используемый при рендеринге JavaScript, был обновлен, чтобы не отставать от вечнозеленого робота Google.

- «Принимать файлы cookie» было изменено на «Хранилище файлов cookie» с тремя вариантами: «Только сеанс», «Постоянный» и «Не хранить». По умолчанию установлено значение «Только сеанс», что имитирует поведение робота Googlebot без сохранения состояния.

- На вкладке «URL-адрес» доступны новые фильтры для решения распространенных проблем, включая множественные косые черты (//), повторяющийся путь, содержит пробелы и URL-адреса, которые могут быть частью внутреннего поиска.

- На вкладке «Безопасность» теперь есть фильтр «Отсутствует заголовок политики безопасного перехода».

- Теперь на вкладках «Внутренняя» и «Безопасность» есть столбец «Версия HTTP», который показывает, под какой версией было выполнено сканирование. Это подготовка к поддержке встроенного сканирования HTTP / 2 с помощью робота Googlebot.

- Теперь вы можете щелкнуть правой кнопкой мыши и «закрыть» или перетащить и переместить порядок вкладок нижнего окна аналогично верхним вкладкам.

- Неиндексируемые URL-адреса теперь не включаются в фильтр «URL-адреса не в Sitemap», так как мы предполагаем, что они не индексируются правильно и поэтому не должны быть помечены. Дополнительную информацию можно найти в нашем руководстве «Как проводить аудит XML-файлов Sitemap ».

- Проверка функции расширенных результатов Google была обновлена в соответствии с постоянно меняющейся документацией.

- Отчет «Сводка функций расширенных результатов Google», доступный через «Отчеты» в меню верхнего уровня, был обновлен и теперь включает «% подходящих» для расширенных результатов на основе обнаруженных ошибок. Этот отчет также включает общее и уникальное количество ошибок и предупреждений, обнаруженных для каждой функции Rich Result, в качестве обзора.

На данный момент это все, и создатели ПО уже начали работу над функциями для версии 15. Если у вас возникнут проблемы, добро пожаловать в службу поддержки.

А теперь скачайте Screaming Frog SEO Spider версии 14.0 и поделитесь с нами своим мнением!

Источник записи: https://www.screamingfrog.co.uk

Технический анализ сайта с помощью Screaming Frog SEO Spider

Любая работа над сайтом по его SEO-оптимизации начинается с определения текущего состояния его трех составляющих: технической, контентной и внешней (ссылочное присутствие).

В отличие от внешнего анализа, провести технический и

контентный, в теории, возможно и без использования стороннего программного

обеспечения, достаточно лишь знать, куда смотреть в исходном коде страниц

сайта. Тем не менее, как и во многих технических процессах, качественный софт

позволяет ускорить выполнение анализа в десятки, а то и в сотни раз.

Тем не менее, как и во многих технических процессах, качественный софт

позволяет ускорить выполнение анализа в десятки, а то и в сотни раз.

Именно поэтому при проведении технического анализа сайта, оптимизаторы используют так называемые «краулеры». И один из наиболее доступных и удобных, а потому и популярных, краулеров — это Screaming Frog SEO Spider. Именно его использует наша компания при проведении технического анализа сайта.

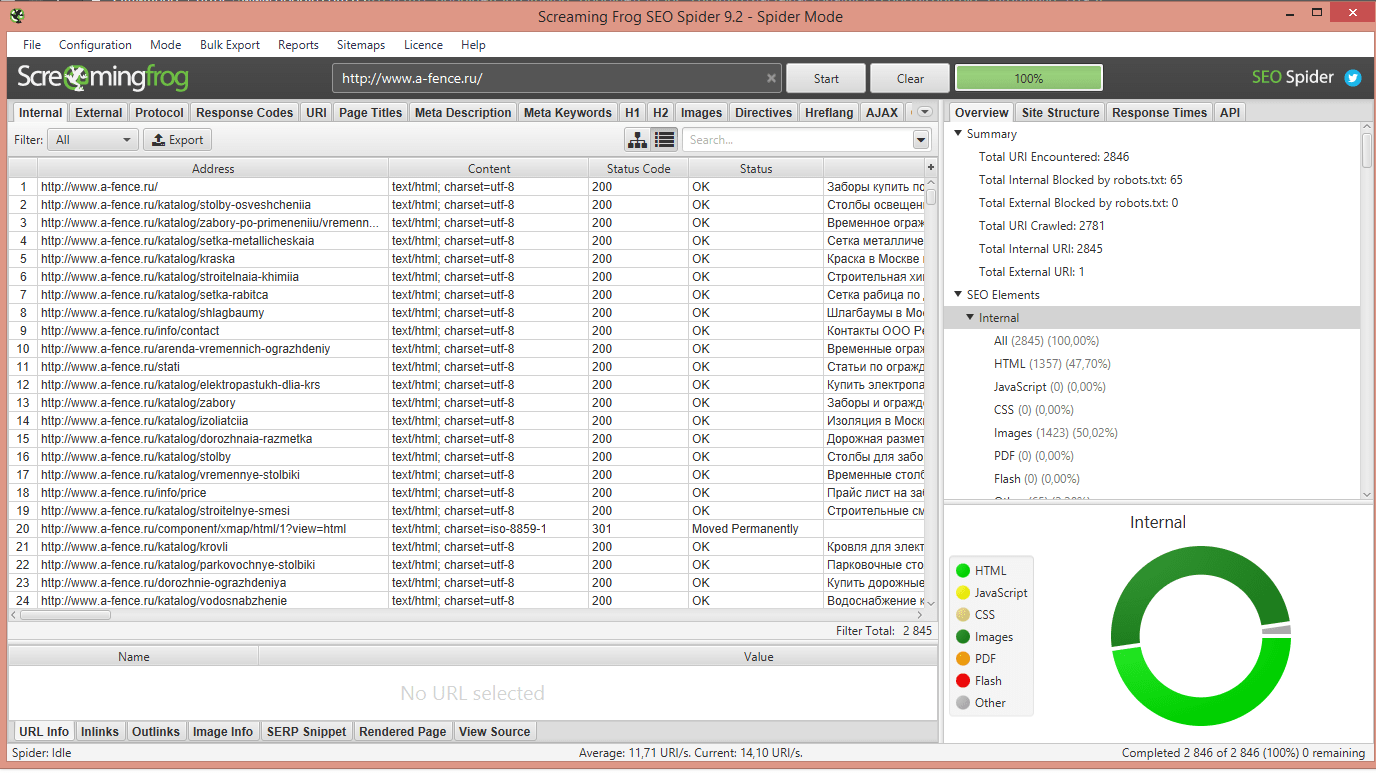

Суть работы краулера – это запуск на сайт своего робота (по своим свойствам похожего на поисковых роботов Яндекса и Google’а), который сканирует страницу, введенную в запросе, совершает переход по внутренним ссылкам на другие страницы этого сайта, сканирует их, переходит по их ссылкам и так пока не обойдет весь сайт. Данные, собранные своим роботом, программа Screaming Frog SEO Spider собирает в собственные таблицы.

В данном материале мы рассмотрим, какую именно полезную информацию для технического анализа сайта может нам дать Screaming Frog SEO Spider и как ее можно использовать при оптимизации.

Анализ внутренних ссылок

Итак, открываем SF SEO Spider и вводим URL-адрес сайта под анализ. Обход запущен, статус обхода отображается в процентах в правом углу окна программы.

Важно понимать, что робот начинает обход сайта именно с той страницы, которая введена в запросе. Если введена главная, робот начнет с нее и перейдет на дочерние (при наличии ссылок на них), а если введена дочерняя, робот начнет с нее и перейдет на ее дочерние, родительские и так далее (при наличии ссылок на них). При этом очевидно, что если продвигаемой страницы нет в результатах обхода, то и ссылок на других страницах сайта на нее нет. Такое явление называется «страница-сирота» и является грубой ошибкой в SEO.

Скриншоты в данном материале взяты с технического анализа сайта нашего клиента, но для сохранения конфиденциальности мы скрыли его домен.

После окончания обхода рассмотрим данные в первой таблице — Internal. Исходя из названия, здесь собраны внутренние ссылки сайта. (Все скриншоты в

материале увеличиваются при клике по ним).

Исходя из названия, здесь собраны внутренние ссылки сайта. (Все скриншоты в

материале увеличиваются при клике по ним).

В селекторе Filter мы можем отсортировать ссылки по типу, где html – это страницы сайта, а CSS, JavaScript, Images и остальное – соответствующие вложения и скачиваемые файлы.

В таблице Internal нас в первую очередь интересуют столбцы Status Code, Status, Indexability и Indexability Status.

Вот небольшая справка от наших SEO-специалистов по кодам ответа (Status Code):

- 200 – ссылка ведет на существующую страницу, все нормально

- 300, 301, 302 и т. д. – ссылка ведет на страницу, с которой происходит принудительное перенаправление на другой URL

- 400, 404 и т.д. – ссылка ведет на несуществующую страницу

- 500, 501, 505 и т. д. — переход по ссылке блокируется сервером сайта

- 0 – ссылка заблокирована в файле robots.txt (ее реальный код не важен роботу, так как переход заблокирован в любом случае).

Что с этим делать? Здесь все проще, чем может показаться. По 200 и 0 все очевидно – первые индексируются, вторые нет.

В ходе исследований и тестов, наши оптимизаторы определили, что ссылок 400 и 500 на сайте быть не должно, это ошибки в любом случае. Поэтому рекомендуется ручная чистка на страницах, где они заданы, вырезание из файлов шаблона, либо создание правила запрета на индекс в robots (менее желательное решение, лучше вычистить). 300 – приемлемый ответ, если конечная страница после перенаправления отдает 200, но все же если таких ссылок не много, лучше сразу им задать конечный URL.

Чтобы определить, на каких именно страницах на сайте находится та или иная ссылка (например, чтобы вычистить ссылку, отдающую код 400 или 500), необходимо кликнуть ЛКМ на ссылку в основной таблице, и внизу окна программы выбрать вкладку Inlinks. Все страницы, содержащие данную ссылку, выведены в столбце From.

Касательно столбцов Indexability и Indexability Status, они

отражают, доступен ли URL для индексации. Несложно заметить, что индексируются

только URL, отдающие код 200, однако и те не все. Некоторые из них помечены

статусом Canonicalised, но об этом чуть позже.

Несложно заметить, что индексируются

только URL, отдающие код 200, однако и те не все. Некоторые из них помечены

статусом Canonicalised, но об этом чуть позже.

Идем далее, переходим на страницу External. Здесь собраны уже ссылки с нашего сайта на страницы других сайтов, либо же файлы JS, CSS, изображений или других вложений, которые интегрированы на сайт с другого ресурса. Также смотрим на коды ответов, ссылаться или принимать файл с другого сайта с ошибками 400 или 500 крайне нежелательно для SEO. В случае с 300 так же проверяем доступность конечного URL.

Таблицы Response Codes и URL также выдают нам информацию о кодах ответа и статусе индексации ссылок, но в отличие от предыдущих таблиц, здесь нет разделения на внутренние и внешние URL.

Зато, здесь есть удобные фильтры в селекторе Filters – в таблице Response Codes можно четко отфильтровать URL по коду ответа, а в URL – вывести только URL, содержащие кириллицу (Non ASCII Characters), содержащие заглавные буквы (Uppercases), содержащие параметры (Parametrs), содержащие символ нижнего подчеркивания (Underscores), и содержащие более 115 символов. Все эти URL (кроме параметров и нижних подчеркиваний для не HTML-файлов) являются ошибками оптимизации, потому отлавливать их здесь весьма полезно.

И последнее из анализа ссылок, что нас интересует в SF SEO Spider – это таблица Canonicals.

Здесь собраны данные о работе механизма канонических ссылок на сайте. Основная их функция – это определять URL с параметрами (в самой ссылке параметры указаны после символа «?» и позволяют работать динамическим механизмам сайта, таким как фильтрация и сортировка товаров и т.д.) как ту же самую страницу, что и с URL без параметра, а не ее дубль. Таким образом, правильно настроенные канонические ссылки защищают страницы от образования дублей.

Таблица Canonicals отображает канонические ссылки

HTML-страницы сайта. Каждая страница без параметров должна иметь каноническую

ссылку сама в себя, страницы с параметрами – в себя без них. Страницы пагинации

– тоже сами в себя. Несоответствие этим стандартам свидетельствует об ошибке

оптимизации канонических ссылок, которые здесь легко определить.

Страницы пагинации

– тоже сами в себя. Несоответствие этим стандартам свидетельствует об ошибке

оптимизации канонических ссылок, которые здесь легко определить.

Также, селектор Filters здесь может вывести каждый случай канонизации отдельно.

Анализ мета-тегов и контента

Теперь посмотрим, чем нам может помочь Screaming Frog SEO Spider при анализе мета-тегов и контента сайта. Для этого нас интересуют таблицы Page Titles, Meta Descriptions, Meta Keywords, h2 и h3. Все эти таблицы имеют одинаковую структуру – отображают кол-во выбранного тега на странице, содержимое, длину в символах и в пикселях. Удобно видеть сразу превышение кол-ва и длины тегов, а также проблемы в оптимизации их контента.

Также, внизу окна программы есть вкладка SERP Snippet. Кликнув в основной таблице на любой URL и перейдя в нее, вам отобразится — как выглядит сниппет этой страницы в поисковой выдаче Google. Полезно сразу увидеть, какая часть тегов title и description отобразится, а какая будет скрыта за многоточием.

В селекторе Filters данных таблиц также можно отобразить проблемные страницы – с дублирующимися тегами (Duplicate), с отсутствующими (Missing), более одного (Multiple), а также превышающие рекомендуемые пределы (Over *** charecters).

Несколько рекомендаций по данным мета-тегам от SEO-отдела нашей компании:

- Title – строго не больше и не меньше одного, до 80 символов, содержит ключевой запрос, захватные слова (купить, цена, отзывы и т.д.), региональную принадлежность (в Москве, в Воронеже и т.д.).

- Meta Descriptions – строго не больше и не меньше одного, длина — 160-180 символов, содержит ключевой запрос, имеет призыв и привлекателен для клика на выдаче.

- Meta Keywords — на сегодняшний день является устаревшим и его наличие на сайте не несет ничего хорошего, поэтому в этой таблице смотрим, чтобы их просто не было.

- h2 – строго не больше и не меньше одного, содержит ключ.

- h3 — может быть несколько, содержат побочные ключи.

Таблица Images содержит список всех изображений на сайте. В основной таблице отображен тип и размер каждого, но нас больше интересует содержимое параметров alt. Его можно найти в уже знакомой нам вкладке Inlinks, так как одно изображение на каждой странице может иметь различный alt. Alt’ы рекомендовано содержат ключевой или побочный ключ.

Также, в последней версии программы Screaming Frog SEO Spider (13.0 на момент написания материала) добавили таблицу Content. Здесь в столбце Word Count указано количество слов на странице, что полезно при поиске малоинформативных (менее 30-50 слов в зависимости от наполнения шапки и подвала). Здесь же можно проверять грамматические ошибки и описки в текстах страниц, если включить эту функцию в настройках Configuration – Content – Spelling and Grammar и выбрать русский язык.

Безусловно, это лишь часть функционала программы Screaming Frog SEO Spider. Анализ страниц пагинации, ссылок hreflang, микроразметок, файлов Sitemap, скорости загрузки и других параметров используется при расширенном и более тщательном техническом анализе сайта. Однако, выявление и устранение ошибок, описанных в данном материале, уже поможет поднять позиции сайта топ в 80% случаев.

Конечно, для рядового владельца сайта или бизнеса подобная аналитика может показаться техническими дебрями. В таком случае у компании Business Boom Studio есть комплексное решение – SEO-аудит и SEO-продвижение сайта любой сложности с гарантией результата. Доверьте всю технику и работу с текстами профессионалам, и увеличьте поисковый трафик на ваш веб-ресурс от 50% до 500%.

Screaming Frog Seo Spider. Как аккаунт-менеджер ПО настраивал

Статья пригодиться тем, чья работа не только стоит на потоке в плане сканирования проектов, но и при этом требует установить такие настройки, которые одинаково подойдут, как на средние проекты с количеством URL до 500 тыс. , так и для небольших сайтов.

, так и для небольших сайтов.

Начну с того, что в нашей компании, как и в любом более-менее крупном рекламном digital-агентстве, остро стоит вопрос оптимизации и автоматизации рутинных процессов, освобождая время для решения более важных стратегических задач.

Так вот: пройдя испытательный срок и проработав в агентстве примерно 2 месяца, взялся я за задачи ежемесячного сканирования по нескольким проектам. В seo я, в принципе, не новичок, но моя основная специализация — это аккаунт-менеджмент и маркетинг.

Время от времени, я как аккаунт-менеджер для собственных нужд по проекту и обсуждения деталей продвижения с клиентами провожу анализ выдачи их сайтов в выдаче в целом, в ТОП 10 поисковиков, но иной раз есть потребность в том, чтобы провести подробное сканирование сайта.

Сканирование проектов осуществляю, как и все на ПО Screaming Frog SEO Spider . Установил прогу, получил от руководства на нее лицензию и не трогал в ней ничего из настроек параметров сканирования (ибо все работало, а как известно не надо чинить то, что не сломалось).

Ну и шло все своим чередом, пока не попался мне в ведение проект довольно масштабный, особенно в рамках своей профессиональной деятельности.

Запускал я сканирование несколько раз, где выяснилось, что величина проекта примерно 430 тыс. URL , при том, что прошлые процессы сканирования ограничивались проектами величиной max 1200-1700 URL . И проблема не в том, что сканирование проекта занимало около суток (как я понял из прочитанных мной материалов — это норма), а в том, что, оставляя на ночь работающий процесс, возвращался я к неизменно зависшей программе на прогрессе в 88-94%!

Инструкция к screaming frog seo spider , естественно, более чем подробно дает понимание того, что и для чего настраивается, но конкретных рекомендаций по настройке не дает.

Далее я обратился к поиску на тему того как правильно использовать seo spider tool . Перечитав несколько статей, посвященных настройке программы, сделал вывод, что в них описано то же самое, что и в инструкции, но более кратко и попроще.

В итоге по своему вопросу решил я воспользоваться помощью наших опытных специалистов, которые (за что им действительно огромное спасибо) буквально на пальцах объясняли мне по каким принципам данное ПО работает и дали несколько очень дельных рекомендаций по настройке.

В итоге, после 3 дней путем проб, ошибок и консультаций с коллегами я пришел к следующему

Характеристики устройства:

Процессор — Intel ( R ) Core ( TM )

i 3-7020 U

CPU 2.30 GHz

Оперативная память — 8,00 ГБ

Тип системы — 64-разрядная операционная система, процессор x64

Как видите показатели устройства весьма средние, но мне по роду обязанностей очень мощное железо то и не нужно, т. к. на выполнения своих задач, такой машины более чем хватает.

Настройки программы Screaming Seo spider (версия 14.1, последнее обновление):

1. Все данные по проекту записываются на SSD диск, размером 107 Гб. За заполняемостью диска конечно же надо следить и ненужные устаревшие данные стирать вручную. Компенсировать можно сделав экспорт проекта.

2. Включен рендер с использованием javascript

3. Отключены ограничения количества потоков сканирования

4. Максимальное количество URL в секунду — 2

5. Если вы параллельно выполняете еще трудоемкие процессы на рабочей машине (например работаете с парсингом в KeyCollector ), то обязательно ставьте краулинг на паузу.

Ниже привожу скрины с настройками Spider Configuration :

ВНИМАНИЕ!

В обязательном порядке, в настройках программы необходимо в методах записи информации по проекту выставить запись на жесткий диск, который обязательно SSD !

При описанных характеристиках устройства и настройках Screaming Frog, сканирование проекта величиной в 420-450 тыс. URL занимает порядка 30 часов, при условии того, что как минимум 12 часов сканирование выполняется параллельно с другими задачами на рабочем устройстве.

P. S. Решение о написании и публикации данного материала было принято после безуспешных попыток найти в пространстве рунета статьи о том, какие настройки рекомендуется выставлять в программе Screaming Frog . Находилась лишь общая информация о том, какие пункты в программе и ее конфигурации что обозначают, что человеку сведущему в SEO «как мертвому припарка». Поэтому, коллеги, читайте, пользуйтесь, делитесь с другими, и да пребудет с Вами Сила!)