Как проверить индексацию страниц сайта в Google и Яндекс

Термин «индексация сайта» сегодня знаком каждому веб мастеру и практически каждому владельцу онлайн-бизнеса. Она влияет на позицию, занимаемую вашим ресурсом в поисковых системах, и, разумеется, когда она выше, пользователи, пребывающие в поисках нужной информации, товаров, услуг, окажутся в числе ваших клиентов с большей вероятностью, ведь увидят вас в числе первых.

Соответственно, неточности индексирования скажутся негативно на рейтинг в ТОП выдачи, или вовсе приведут к тому, что предложение компании окажется за пределами пользовательских запросов. Компания Idea Digital Agency составила краткий гайд для владельцев онлайн-бизнеса. Мы расскажем, как проверить индексацию сайта, и что делать, если он оказался вне поля зрения ботов.

Что такое индексация сайта?

Это процедура, проводящаяся алгоритмами с использованием принципов искусственного интеллекта, с целью определить релевантность данных, их важность для пользователей и актуальность. Проводится она автоматически, а робот в ходе проведения производит определенный порядок действий:

Проводится она автоматически, а робот в ходе проведения производит определенный порядок действий:

- Находит вас благодаря СЕО-продвижению или при помощи внешних ссылок;

- Переходит по линку и отправляет запрос на получение контента серверу;

- Изучает и оценивает важность содержимого, затем принимает решение об индексировании;

- Отправляет отчет.

В случае положительного решения рейтинг повышается. Если данные признаны неважными, повторной процедуры ждать не придётся до момента исправления недостатков, помешавших роботу выполнить работу.

Зачем нужна индексация сайтов в Google, спросите вы. Ответ прост: только отсканированное и получившее индекс от бота содержимое отображается в пользовательской выдаче на нужных вам позициях. Если по каким-либо причинам аналитика ботов прошла мимо или же URL попали под анализ частично, каким бы замечательным ни был контент, или насколько полезными не оказались товары, клиенты останутся в неведении и получат в выдаче своих запросов ссылки на магазины конкурентов.

Путать понятия сканирование и индекс неправильно. Бот проводит обе процедуры. Сканировать робот может достаточно быстро, а индексирование — более длительный процесс.

Как ускорить индексацию сайта, рассмотрим подробно далее, но главное в принципе работы ботов-пауков — сканирование HTML-кода. Поэтому важно не только подготовить релевантный контент для страницы, но и правильно прописать основные теги, включая заголовки разных уровней, метатеги Title и Description. Эту задачу лучше доверить профессиональным оптимизаторам, если важен 100% результат.

Как проверить индексацию сайта

Если вы не уверены, прошел ли URL сканирование, отмечаете низкую посещаемость, ищете причины невысокой конверсии, стоит запустить проверку URL в Гугл и Яндексе на правильность обработки и ее наличие. Доступны несколько способов, как это сделать, и любой способ имеет свои преимущества. Рассмотрим каждый подробнее.

Хотите заказать комплексное интернет-продвижение или разработку сайта?

Заполните простую форму и мы свяжемся с вами в ближайшее время.

Проверка в панели вебмастеров

Индексация сайта в Гугле и Яндексе возможна стандартным инструментом — Панелью Вебмастера. Для каждой популярной системы существует прописанный алгоритм действий. Мы рассмотрим его для двух основных, используемых в нашей стране.

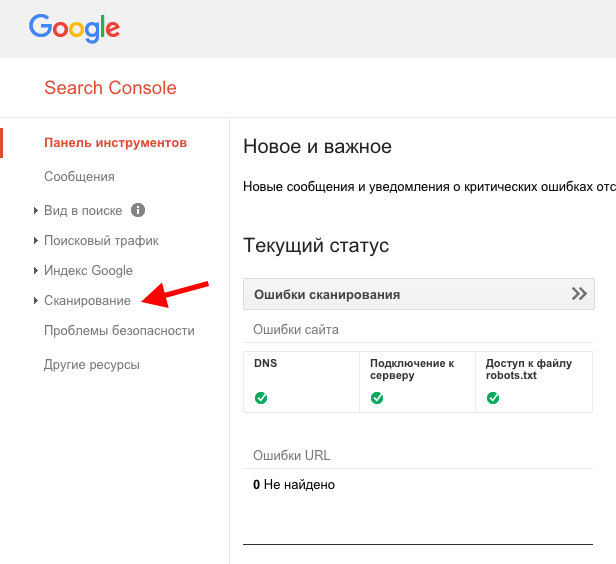

- Проверка в Google проводится через Search Console. Выберите раздел «Обзор» в консоли, откройте графический отчёт «Покрытие». На графике вы сможете увидеть количество проиндексированных безошибочно объектов (зеленый график) и те, с которыми возникла ошибка (красный график). Увидеть подробный отчёт об основных файлах можно переходом в соседнюю вкладку с отчетом.

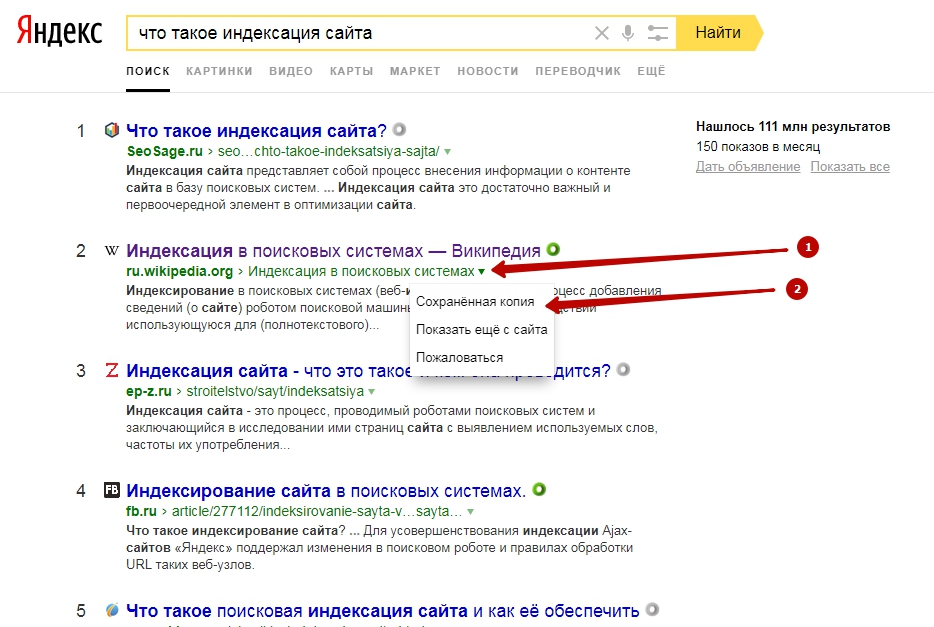

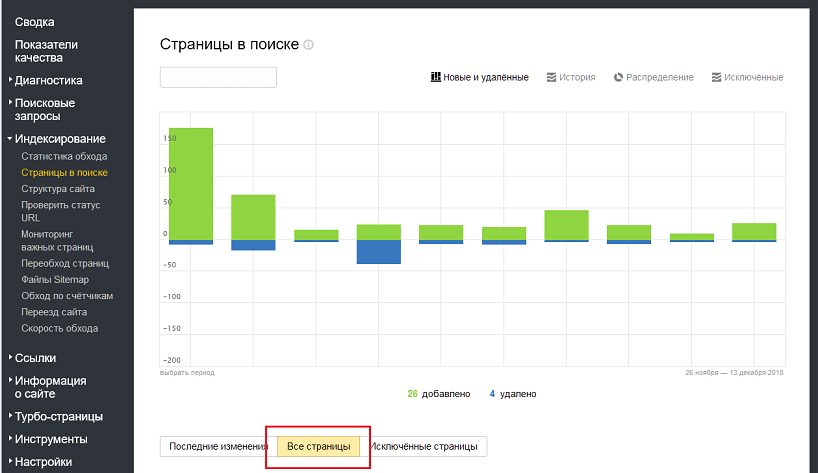

- Как проиндексировать сайт в Яндекс? Понадобится авторизоваться в сервисе Яндекс.Паспорт. Заходите непосредственно в сервис вебмастеров «Яндекс. Вебмастер», выбирайте параметр «Индексирование», далее — два пути: либо выбрать параметр «Страницы в поиске», либо его же в истории вебмастера. На полученном графике вы сможете отследить историю.

График идёт по экспоненте без резких колебаний — это хороший признак: SEO продвижение сайта идёт правильно. Если график неровный, напоминающий кардиограмму, это явный признак ошибок в анализе: их обязательно нужно исправить.

График идёт по экспоненте без резких колебаний — это хороший признак: SEO продвижение сайта идёт правильно. Если график неровный, напоминающий кардиограмму, это явный признак ошибок в анализе: их обязательно нужно исправить.

В случае, когда проверка сайта Гуглом или Яндексом показывает нелицеприятные результаты, стоит удостовериться, что он не закрыт для их внимания и устранены базовые проблемы.

Материал по теме: Google Search Console: как добавить сайт и лайфхаки для SEO

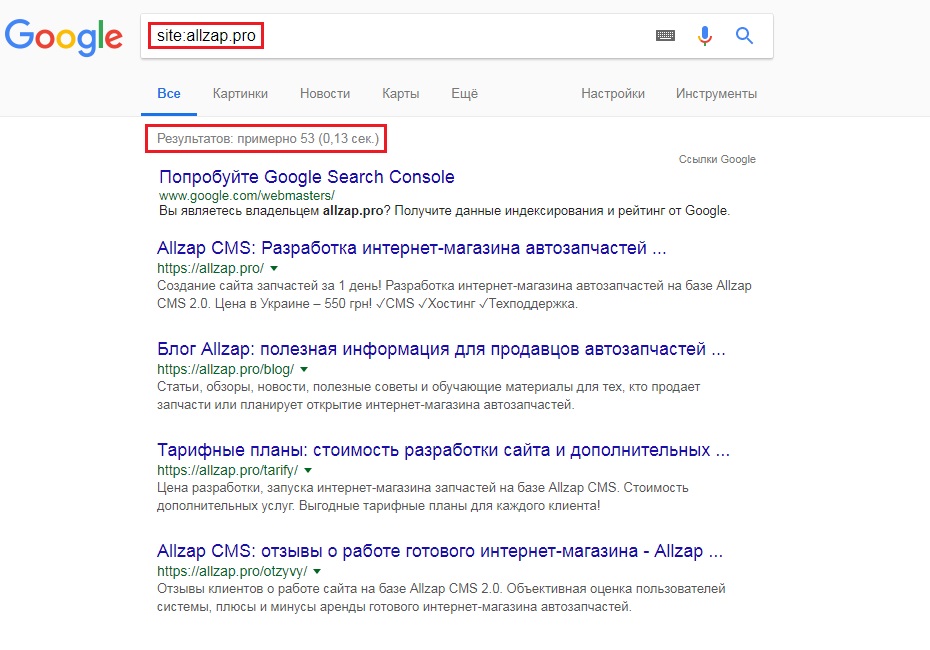

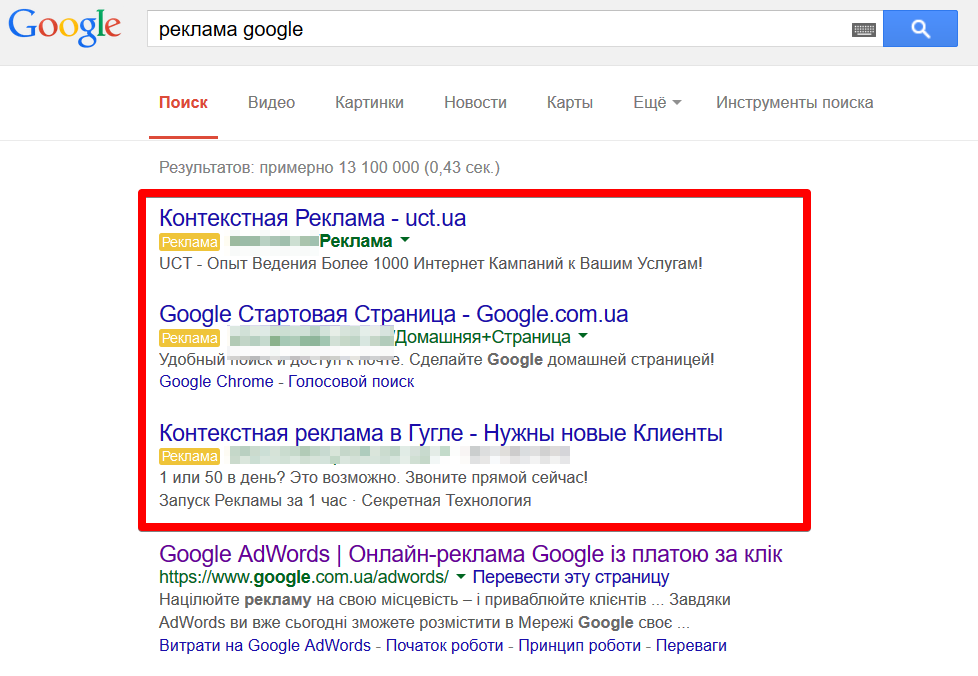

Проверка через операторы в поисковых запросах

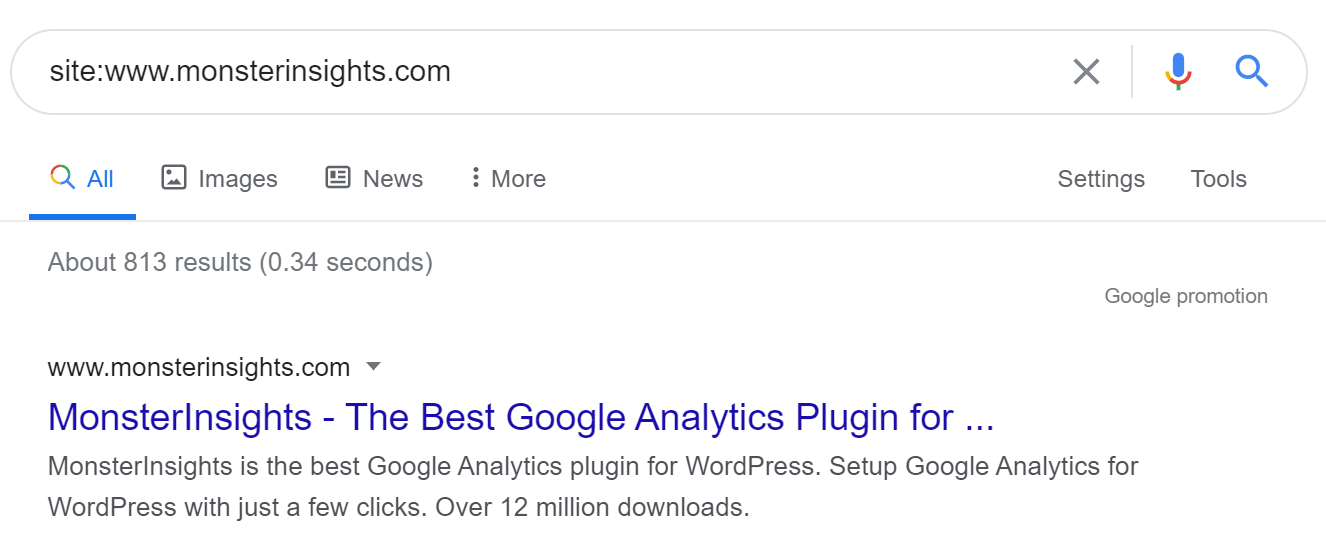

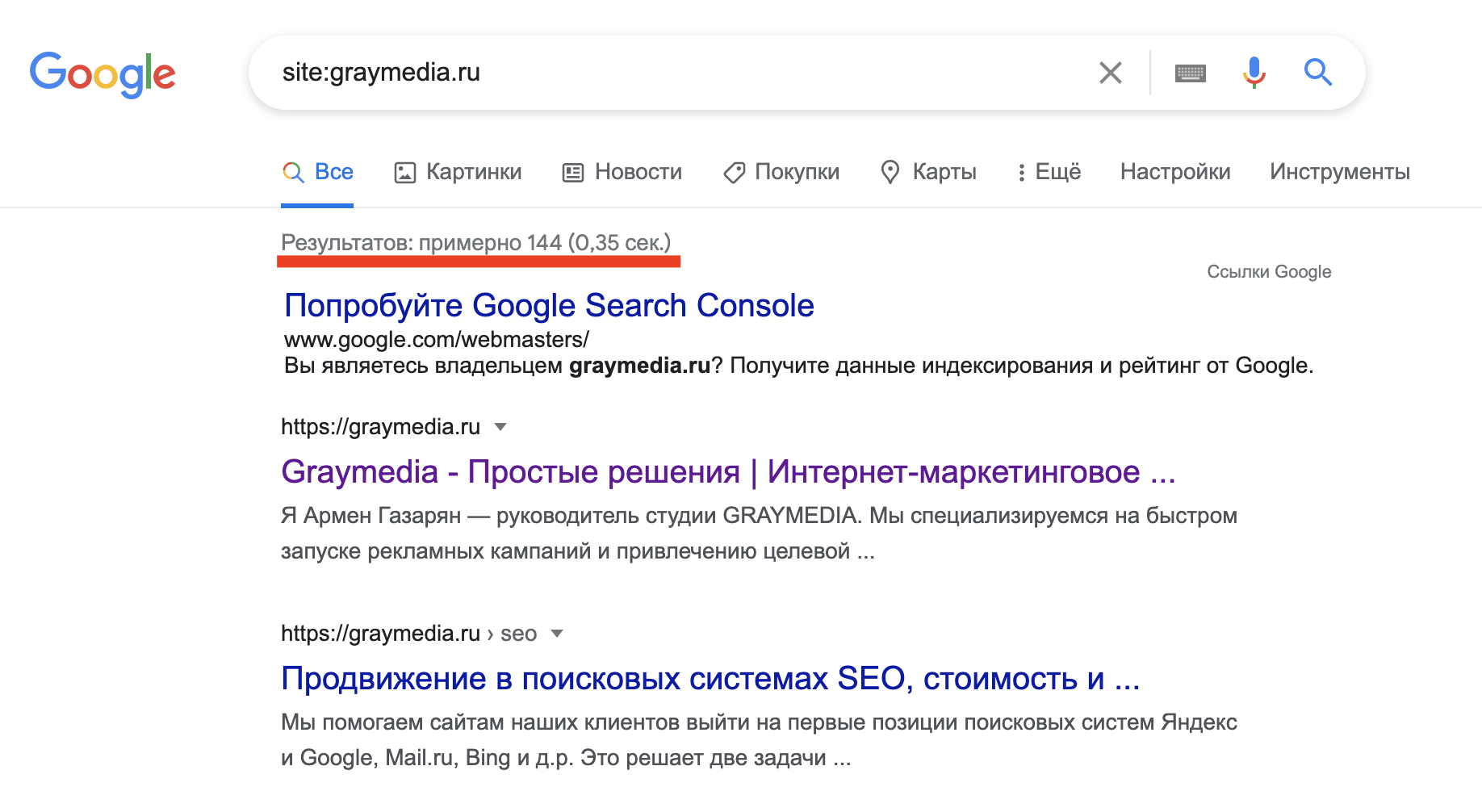

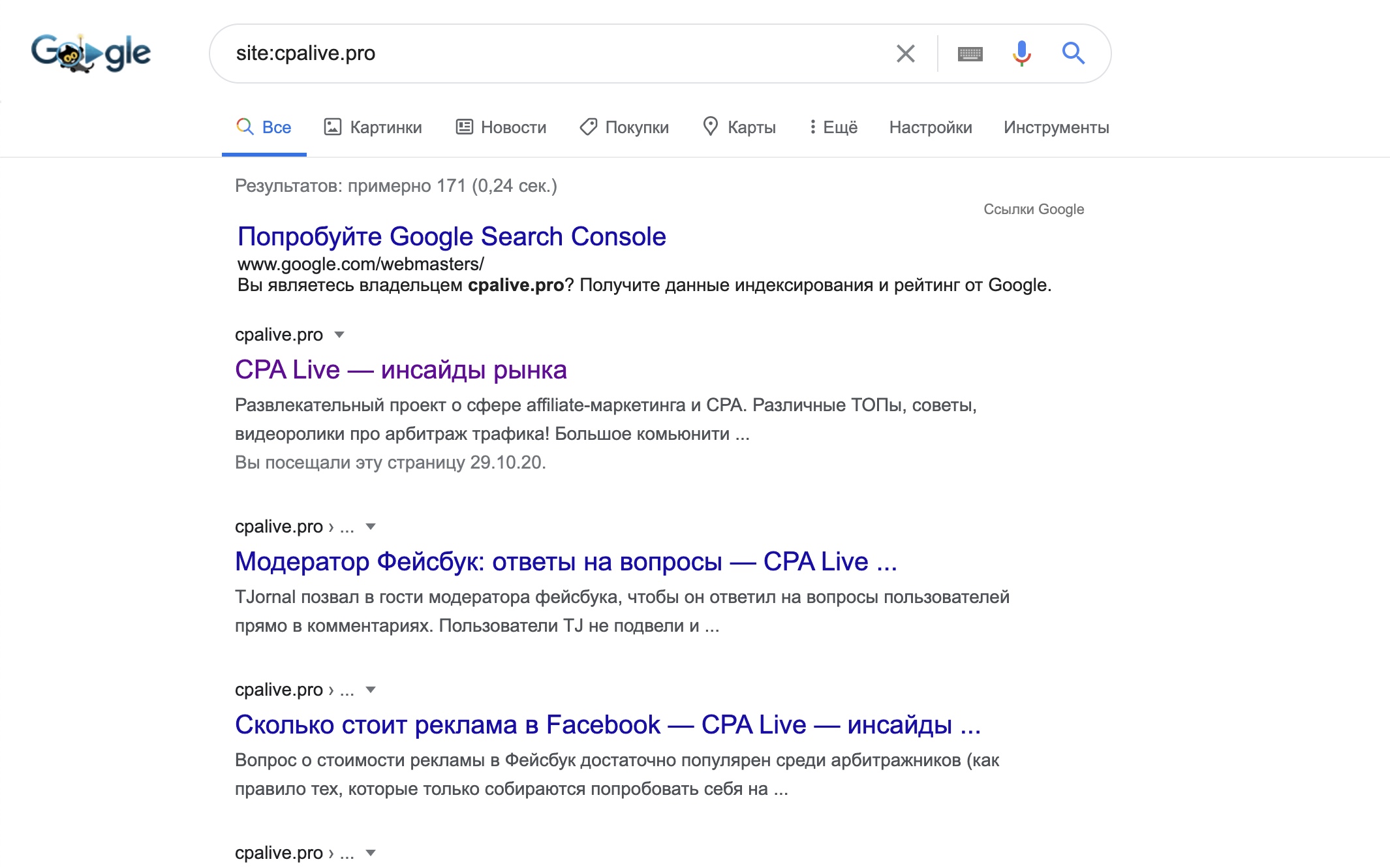

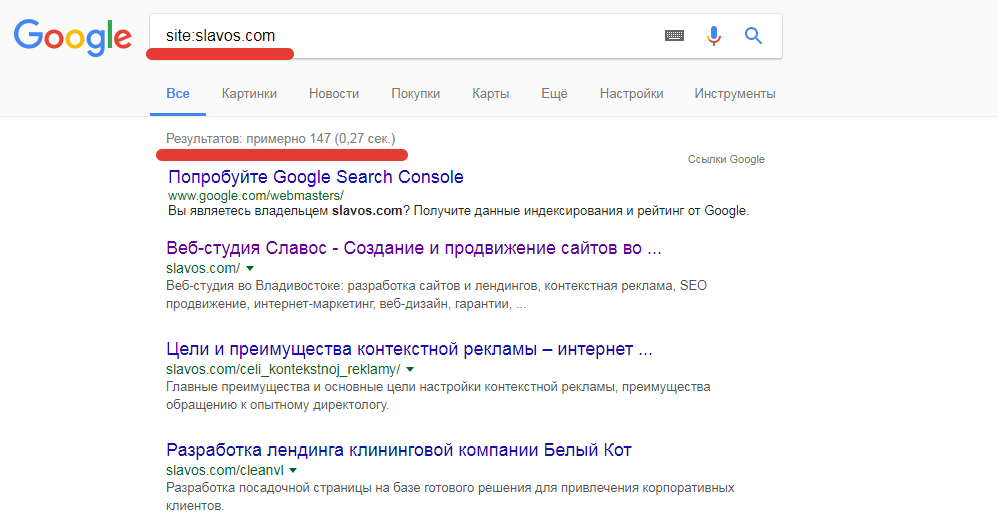

Индексация сайтов в Google отображается и в самом поисковике. Для изучения количества проиндексированных данных в целом можно использовать оператор site:. Алгоритм в этом случае проще простого: нужно добавить точный линк или доменное имя в Гугл, проставив перед адресом site:. После него без пробелов скопируйте полный линк. Посмотрите на выдачу.

Кстати, нелишним будет выполнить сравнение: запустите поиск в Яндекс и Гугл одновременно, если количество результатов выдачи будет существенно различаться, это признак того, что есть не выявленные ошибки, требующие исправления.

Чтобы получить более детальный анализ в Google можно зайти в раздел «Инструменты поиска»: так вы сможете увидеть, какое число линков было обработано с присвоением индекса за определенный период времени.

Параллельно рассмотрим, как проверить индексацию сайта операторами по каждому разделу.

- Стандартная схема — всё тот же site:. Вставьте после него полную ссылку и просмотрите результат. Отсутствие результата — верный признак того, что страница не индексируется.

- В этом случае можно задействовать специальные операторы. Для Гугл это – inurl:. Для Яндекса – url:. При обработке запроса с этими операторами положительный результат означает, что раздел всё же проиндексирован, отрицательный — его отсутствие в аналитике ПС.

С этой же целью можно выполнить такое простое действие, как посмотреть кэш Гугла. Для этого достаточно находясь на выбранной странице в поисковой строке перед URL прописать оператор cache и нажать энтер.

Проверка через плагины и букмарклеты

Узнать информацию можно и без непосредственного взаимодействия с поисковыми системами и их Консолями. Достаточно задействовать плагины или букмарклеты — небольшие приложения, которые устанавливаются непосредственно в браузер. Можно использовать такие плагины, как RDS bar или SEO Magic. Кроме них, существуют и другие микро-программы, с которыми массовая проверка индексации страниц будет минутным делом.

Достаточно задействовать плагины или букмарклеты — небольшие приложения, которые устанавливаются непосредственно в браузер. Можно использовать такие плагины, как RDS bar или SEO Magic. Кроме них, существуют и другие микро-программы, с которыми массовая проверка индексации страниц будет минутным делом.

Хотите заказать комплексное интернет-продвижение или разработку сайта?

Заполните простую форму и мы свяжемся с вами в ближайшее время.

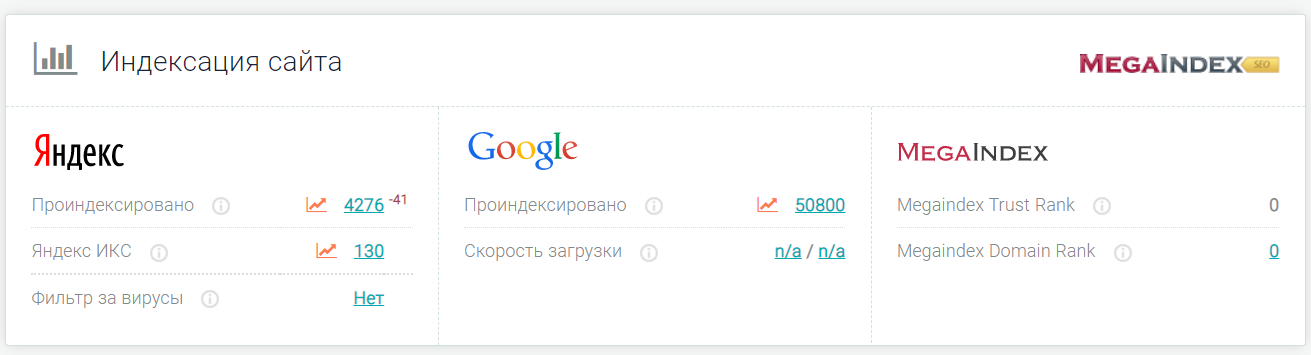

Анализ через сервисы для проверки индексации

Некоторые разработчики софта предлагают готовые решения, как узнать статус в ПС. Часть из них предлагается на платной основе и позволяет вытянуть сразу множество данных для анализа. Есть и более простые, shareware сервисы. В них может присутствовать ограничение по количеству линков, либо они могут иметь ограниченный функционал, но базовые данные они вполне могут вам предоставить. К таким сервисам относятся serphunt.ru и raskruty.ru. Для их применения достаточно перейти по адресу и следовать простым инструкциям.![]()

Платные версии сервисов предлагают такие компании, как serpstat, Netpeak, Se Ranking (у последних сервис условно бесплатный, но только при условии, что вы уже подписаны на один из платных тарифов).

Как проверить индексацию конкретной страницы

Как и в случае с аналитикой в целом, проанализировать каждую страницу по отдельности можно через Search Console Гугла. Сделать это очень просто: скопируйте линк и вставьте в строку поиска Консоли. При положительном ответе появится соответствующее информационное окно.

Если ответ отрицательный, вы можете отправить ее повторно при помощи кнопки «Запросить индексирование».

Также определенные URL можно протестировать через поисковик с оператором site:, url/inurl. И, конечно, такая опция присутствует в платных сервисах или плагинах для анализа.

Почему не индексируется сайт, основные ошибки

Предупреждён — значит, вооружён, считаем мы. Поэтому важно знать и о главных причинах, по которым поисковые боты игнорируют вас и не индексируют целиком или отдельные разделы.

- Часто проблема банальна: онлайн-проект только создан, и поисковые пауки ещё не добрались до него. При статистике создания новых объектов в интернете, такая ситуация не редкость. Поэтому иногда не стоит паниковать, достаточно проявить терпение и регулярно просматривать, не появились ли ваши страницы в индексе.

- Отсутствие sitemap — не критичный, но не лучший вариант. Если вы не предоставили роботам готовый гайдлайн, они могут выборочно проиндексировать несколько рандомных страниц, а остальные упустить из виду или проигнорировать.

- Ошибки в страницах: отчеты Google Search Console игнорировать не стоит. Они показывают текущие ошибки страниц, которые, в свою очередь, могут привести к сбоям обработки поисковыми роботами.

- Недостаток контента — повод для отклонения. Контент — это не только текстовое наполнение, но и всевозможные медиа-объекты, расположенные на странице.

- Проблемы с robots.txt. Если для мета-тега случайно был присвоен атрибут noindex, поисковые пауки его не смогут найти.

Аналогично с тегом X-Robots, который мог быть проставлен, как Noindex при тестировании или выставлен случайно. В общем, файл «роботов» стоит тщательно изучить на наличие лишних символов или атрибутов.

Аналогично с тегом X-Robots, который мог быть проставлен, как Noindex при тестировании или выставлен случайно. В общем, файл «роботов» стоит тщательно изучить на наличие лишних символов или атрибутов. - Низкая уникальность контента — тоже провоцирует на отказ. Если даже вы выступаете первоисточником контента, но при этом ваши конкуренты «слизали» его и ускоренно проиндексировали свой ресурс, приоритет получат они, а не вы.

- Наличие дублей страниц для Search robots — тоже тревожный сигнал.

Также для отслеживания причин игнорирования ботами можно посмотреть статистику: возможно, причина в низкой скорости загрузки.

Инструкция по ускорению индексации сайта

Индекс поисковиками — насущный вопрос. И ускорить его стоит всеми возможными способами. А их существует не так уж и мало. Перечислим наиболее эффективные:

- Обязательно создайте sitemap — это путеводитель для роботов-поисковиков.

- Если карта уже есть, не забывайте ее регулярно обновлять, чтобы новые страницы и обновленный контент тоже оказывался проиндексированным.

- Следите за уникальностью контента. Удаляйте тот, который показывает низкую уникальность.

- Следите, не осталось ли дублей страниц после разработки.

- Сбои при переходе по линкам и ошибочные редиректы только запутывают “пауков”.

- Постоянный контроль robots.txt — это практически профилактика здоровья вашего бизнеса онлайн.

- Отладка страниц на предмет скорости поможет ускорить процесс. Поэтому займитесь этим тоже.

- Разумное распределение ссылок на ресурсах-донорах и внутри самого ресурса позволит алгоритмам попасть к вам быстро и точно. Для этого обновлённые разделы анонсируйте в социальных сетях, выбирайте подходящих доноров и логичную перелинковку на ресурсе.

- Регулярные обновления — это сигнал роботам, что вы живёте и развиваетесь. Запомните это.

Материал по теме: Как проверить и увеличить скорость загрузки сайта?

Как закрыть сайт от индексации?

Есть ситуации, когда необходимо выполнить и обратное действие — не дать индексировать вас. Удалить страницу из поиска Гугл и закрыть ее от внимания ботов можно при помощи внесения соответствующих команд в robots.txt.

Удалить страницу из поиска Гугл и закрыть ее от внимания ботов можно при помощи внесения соответствующих команд в robots.txt.

Для этого используется команда Disallow.

С её помощью можно закрыть как все целиком, так и отдельные директории, картинки или медиа-контент.

Аналогично можно установить запрет и через кабинет веб-мастера. В различных CMS это может быть реализовано в разных позициях меню, но в целом вполне реализуемо.

И, конечно, можно запросить доступ по паролю на уровне настроек сервера.

Заключение

Загадочная процедура, о которой мы рассказали, не так уж страшна, как кажется на первый взгляд. Она полезна для всех ресурсов, за исключением еще не запущенных в работу или уже устаревших. И поэтому отследить отсутствие файлов, очень важно. Мы надеемся, что наша статья окажется для вас полезной, и ваш онлайн-проект будет точно индексироваться и отображаться на самых верхних позициях выдачи в поисковиках.

почему страницы сайта плохо индексируются в Гугл

Очень типичная ситуация, что Google плохо индексирует сайт, особенно, интернет магазины. В этой статье я подробно разбираю причины плохой индексации в Google, способы проверки и решения проблем индексации страниц в поисковой системе Гугл.

В этой статье я подробно разбираю причины плохой индексации в Google, способы проверки и решения проблем индексации страниц в поисковой системе Гугл.

Очень важно, чтобы ваш сайт был зарегистрирован в сервисе Google Search Console. Это сервис для аналитики, который показывает как сайт ведет себя в поисковой системе Google и без него сделать какой-то анализ просто невозможно.

Содержание:

- 1 Проверка индексации страниц

- 2 Индексация молодого сайта

- 3 Размер сайта

- 4 URL-адреса недоступны для индексирования

- 5 Наличие ошибок переадресации

- 6 Проблемы на стороне хостинга

- 7 Проиндексировано, несмотря на блокировку в файле robots.txt

Проверка индексации страниц

Если ваш сайт зарегистрирован на данном сервисе, то вы просто берете url страницы, которую хотите проверить и, используя инструмент «Проверка URL», получаете данные, введя url в поле и нажав Enter.

В данном примере видно, что url есть в индексе, а значит все нормально. Если бы урла не было в индексе, то, соответственно, сервис бы написал, что URL нет в индексе.

Если бы урла не было в индексе, то, соответственно, сервис бы написал, что URL нет в индексе.

Индексация молодого сайта

Если у вас молодой сайт и вы совсем недавно его запустили, то абсолютно нормально, что он долгое время не будет сразу индексироваться.

Сайт может и до месяца не индексироваться, такая особенность Google. Есть, конечно, способы как ускорить индексацию, например, закупить ссылок на сайт. Но в общем для молодого сайта долгая индексация это нормально.

Но, если ваш сайт уже имеет какой-то возраст, историю, а у него все равно наблюдаются проблемы с индексацией, то здесь нужно смотреть уже более детально.

Размер сайта

Если на вашем сайте несколько сотен тысяч страниц или даже более, то у него действительно могут быть проблемы с индексацией. Потому что на каждый сайт поисковая система Google выделяет определенный лимит по сканированию и индексированию страниц, так называемый краулинговый бюджет. И если у вас очень много страниц, то бюджета может просто не хватить на индексирование всех страниц.

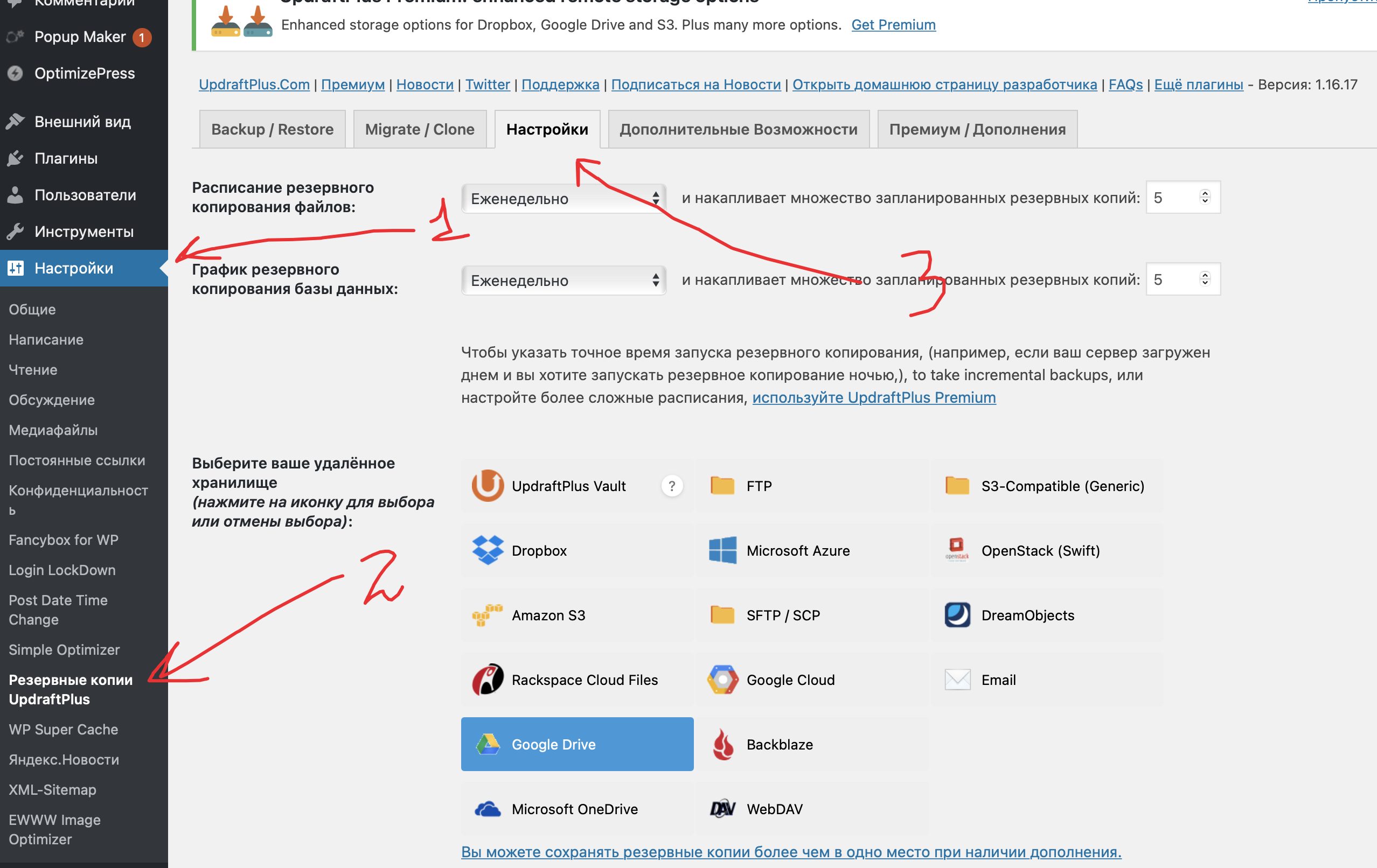

В данной ситуации поможет файл sitemap.xml, который лучше разбить на несколько файлов (категории, товары, служебные страницы и любые другие группы). Если у вас обновился ассортимент, вы добавили много новых товаров, соответственно, автоматически обновился файл sitemap. Вы просто загружаете новый файл через инструмент «Файлы Sitemap» и нажимаете «Отправить». Дальше идет сканирование этого файла.

Если же у вас сайт небольшой (несколько тысяч страниц или даже несколько десятков тысяч страниц), но все равно есть проблемы с индексацией, то нужно смотреть сам сайт. Возможно, есть какие-то технические проблемы, недоработки:

- страницы или раздел сайта могут быть закрыты в файле robots.txt;

- на странице есть мета-тег noindex;

- на страницу поставлен тег canonical, который ведет на какую-то другую страницу;

- страницы имеют 400 или 404 код ответа сервера и т.д.

То есть могут быть какие-то такие технические ошибки, которые не дают страницам или разделам индексироваться.![]() Все это как раз можно проверить через инструмент сервиса Google Search Console.

Все это как раз можно проверить через инструмент сервиса Google Search Console.

Но даже в случае проверки, которая показала, что все нормально, нужно воспользоваться еще инструментом «Покрытие».

Сперва необходимо зайти в разделы «Ошибка» и «Без ошибок, есть предупреждения». Это поможет узнать, какие ошибки есть на указанных страницах, а еще как их можно устранить. Давайте узнаем какие ошибки индексации считаются самыми распространенными, а также о том, как их исправить наиболее простыми способами.

URL-адреса недоступны для индексирования

Зачастую, это не одна ошибка, а целая группа проблем. Она появляется, если пользователь дает команду Google осуществить индексацию выбранного URL, однако сама причина не имеет доступа к обходу поисковыми роботами. Наиболее ярким примером такого случая является следующий:

В первую очередь необходимо понять, нужно ли добиться того, чтоб искомая страница показывалась в поисковике. Если за пример взять страницу, URL-адрес которой не индексируется, то следует прекратить попытки обхода. Эти попытки ни к чему не приведут, так как поисковик не сможет отправить нужный адрес в индекс.

Если за пример взять страницу, URL-адрес которой не индексируется, то следует прекратить попытки обхода. Эти попытки ни к чему не приведут, так как поисковик не сможет отправить нужный адрес в индекс.

Обычно, такие ошибки появляются из-за того, что в карту сайта случайным образом бы добавлен нежелательный URL. Если это так, то решение проблемы достигается путем редактирования файла Sitemap.xml. Для этого достаточно удалить из файла URL-адрес, который вызывает проблемы.

Если пользователю нужно, чтобы искомый адрес показывалась в поисковике, необходимо более подробно разобраться в том, из-за чего именно он не индексируется. Обычно, это происходит из-за следующих причин:

- Существует директива noindex, которая и не дает доступ к индексированию необходимой страницы. Чтобы решить проблему, необходимо удалить тег директивы из HTML-кода неиндексируемого адреса.

- Адрес не индексируется в файле в robots.txt. Чтобы устранить ошибки, нужно воспользоваться особым инструментом поисковика и заняться проверкой файла robots.

- Ошибка 404 (адрес не найден). Такое случается в двух случаях: когда страница была удалена самим владельцем, или в случае изменения начального URL. Решением проблемы является восстановление исходного кода или настройка 301-редиректа на существующем адресе.

- Soft 404 (ложная ошибка). Это случается довольно редко, когда сама адрес существует (сервер подтверждает его существование), но поисковик решил, что URL работает с ошибкой 404. Чаще всего такое происходит в случаях, когда на странице долгое время отсутствует контент (или же он слишком незначительный). Еще одним случаем появления такой ошибки является манипуляция с редиректами. Решение проблемы весьма простое – необходимо заняться поиском «неудачного» контента или же удалить нерелевантные редиректы.

- Ошибка 401 (неавторизованный запрос). Данная неисправность появляется, когда поисковик не получает доступ к искомой странице из-за отсутствия авторизации.

Для решения проблемы необходимо отменить авторизацию или ручным способом дать боту поисковика возможность взаимодействия с искомой страницей.

Для решения проблемы необходимо отменить авторизацию или ручным способом дать боту поисковика возможность взаимодействия с искомой страницей. - Ошибка 403. Ее появление означает, что поисковик пытается войти на сервер, однако бот не может получить доступ к контенту, находящемуся на странице. Исправить ошибку можно, разрешив доступ к адресу анонимным пользователям.

Наличие ошибок переадресации

Это происходит не только при ошибке 404 (то есть из-за перенаправления на страницу, не являющуюся релевантной), но и по многим другим причинам, возникающим при переадресации.

Например, страница не попадает в индекс из-за слишком частых перенаправлений или же неработающих URL-адресов при переадресациях. Решить проблему можно отладкой неправильно работающих 301- и 302-редиректов.

Проблемы на стороне хостинга

Часто проблемы возникают не из-за пользователя, а из-за проблем в хостинге. Наиболее часто встречается ошибка 5хх. Она появляется в случае, когда поисковик не может получить доступ к серверу. Это может произойти из-за поломки сервера, истечения срока ожидания или отсутствия доступа во время того, когда бот поисковика занимался обходом сайта.

Это может произойти из-за поломки сервера, истечения срока ожидания или отсутствия доступа во время того, когда бот поисковика занимался обходом сайта.

Решить проблему можно несколькими способами, но наиболее легкий из них – воспользоваться инструментом «Проверка URL-адреса». Если есть какие-либо неполадки в работе, то инструмент сможет их отобразить. Если проблем с сервером нет, то следует внимательно изучить то, какие предложения дает сам поисковик. В последнюю очередь стоит связаться с хостинг-провайдером.

Давайте перейдем к разделу «Без ошибок, есть предупреждения». Существуют случаи, когда поисковик может проиндексировать адрес сайта, но не может быть на 100% уверен, что в индексации была необходимость. Во время подобных ситуаций страницы будут помечен как физически существующие, но с предупреждением.

Обычно, такие страницы приносят ее больше проблем из-за того, что владелец сайта предоставил общий доступ тем документам, которые таковыми быть не должны. Именно по этой причине все URL-адреса, которые так или иначе получили желтую категорию, должны быть под контролем владельца сайта.

Именно по этой причине все URL-адреса, которые так или иначе получили желтую категорию, должны быть под контролем владельца сайта.

Проиндексировано, несмотря на блокировку в файле robots.txt

Данная ошибка считается одной из самых распространенных. Из-за нее все страницы, находящиеся на сайте, со стопроцентной вероятностью попадают в желтую категорию индексирования. На эту ошибку часто попадаются начинающие веб-мастера, а также специалисты, которые убеждены, что файл robots.txt является самым лучшим механизмом для того, чтобы страницы не попали в индекс поисковика.

На самом деле это далеко не так:

Если добавить директивы в этот файл, это не значит, что страницы будут полностью запрещены для индексирования. Владельцы сайтов используют этот файл для уменьшения перегрузки сайта.

Для стопроцентного исключения желаемых адресов в индекс поисковика используются другие механизмы. Запрет в файле robots.txt используется в роли рекомендации. Этот файл не сможет отсканировать адрес, который отклоняется в robots. txt во время процедуры обхода сайта. Однако, если на эту страницу ведут несколько других ссылок, то она вполне может проиндексироваться.

txt во время процедуры обхода сайта. Однако, если на эту страницу ведут несколько других ссылок, то она вполне может проиндексироваться.

Именно отсюда вытекает следующий момент: адреса могут индексироваться в неполной версии, так как роботы могут отсканировать лишь определенную часть документа, доступ к которому закрыт.

Решается данная проблема довольно просто. Нужно понять, какие URL-адреса относятся к желтой категории, а затем сделать вывод, стоит ли их блокировать. Если пользователь убежден, что данный адрес не должен находиться в индексе, то необходимо ограничить доступ ботов к поисковикам, используя мета-тег noindex или X-Robots-Tag. Страницы, не приносящие никакой пользы, лучше вообще удалить.

Теперь перейдем к разделу «Исключено». Консоль поисковика уведомляет пользователей обо всех адресах, которые полностью отсутствуют в индексе, однако работают на сайте. Такие адреса обычно и отображаются в блоке «Исключено».

Преимущественно, адреса попадают в этот блок по желанию вебмастера.

- Адрес нельзя обойти из-за директивы noindex

- Есть директивы, запрещающие индексирование, в файле robots.txt

- Выбранный адрес — это дубль

Зачастую происходит попадание адресов в блок из-за следующих ошибок:

- Адрес не индексируется из-за наличия ошибки 401/ ошибки 404/ ошибки 403/ ошибки 404

- Наличие редиректа, настроенного с ошибками

- Страница неканоническая (то есть поисковик выбрал канонический вариант не таким, каким его указал вебмастер)

Кроме этого, в разделе «Исключено» особое внимание уделите пункту «Страница просканирована, но не проиндексирована». Если среди страниц встречаются те, которые вы хотите чтобы были проиндексированы, значит проблема внутренняя, а именно с контентом этих страниц.

Это могут быть, например, дубли страниц (полный или частичный повтор контента). Таким дублями могут быть карточки товаров, которые мало отличаются по контенту и сильно дублируют друг друга. В этом случае необходимо уникализировать эти карточки.

Таким дублями могут быть карточки товаров, которые мало отличаются по контенту и сильно дублируют друг друга. В этом случае необходимо уникализировать эти карточки.

Проблемы могут иметь страницы со слабым, нерелевантным контентом. Например, на странице есть только коротенький текст и больше ничего нет. Естественно, Google определяет такую страницу как малоинформативную, неполезную.

Такую страницу он не индексирует и помещает ее в Исключения. Эти страницы необходимо исправить, доработать в соответствии с топом и отправить обратно на переиндексацию. Для этого нужно будет опять ввести url исправленной страницы в инструменте «Проверка URL».

Сервис выдаст ответ, что URL нет в индексе. Далее нажимаем «Запросить индексирование» и ваш запрос вновь будет отправлен на индексирование. Нужно будет подождать пока страница переиндексируется и, если страница верно исправлена, то она появится в индексе.

Подводя итог вышесказанному, можно сказать, что необходимо отслеживать все страницы, попавшие в блок «Исключено». Благодаря этому можно вовремя замечать все недоработки и своими силами исправить имеющиеся ошибки.

Благодаря этому можно вовремя замечать все недоработки и своими силами исправить имеющиеся ошибки.

0 0 голоса

Рейтинг статьи

14 главных причин, почему Google не индексирует ваш сайт

Google не будет индексировать ваш сайт? Ты не один. Существует множество потенциальных проблем, которые могут помешать Google индексировать веб-страницы, и в этой статье рассматриваются 14 из них.

Если вы хотите знать, что делать, если ваш сайт не оптимизирован для мобильных устройств или вы столкнулись со сложными проблемами индексации, у нас есть информация, которая вам нужна.

Узнайте, как устранить эти распространенные проблемы, чтобы Google снова начал индексировать ваши страницы.

1. У вас нет доменного имени

Первая причина, по которой Google не будет индексировать ваш сайт, заключается в том, что у вас нет доменного имени. Это может быть связано с тем, что вы используете неправильный URL-адрес для контента или он неправильно настроен в WordPress.

Если это происходит с вами, есть несколько простых решений.

Проверьте, не начинается ли ваш веб-адрес с «https://XXX.XXX…», что означает, что кто-то может вводить IP-адрес вместо имени домена и перенаправляться на ваш веб-сайт.

Кроме того, возможно, неправильно настроено перенаправление вашего IP-адреса.

Один из способов решить эту проблему — добавить переадресацию 301 с WWW-версий страниц обратно на соответствующие домены. Если люди перенаправляются сюда, когда пытаются найти что-то вроде [yoursitehere], мы хотим, чтобы они попали на ваше физическое доменное имя.

Важно убедиться, что у вас есть доменное имя. Это не подлежит обсуждению, если вы хотите занимать высокие позиции и быть конкурентоспособными в Google.

2. Ваш сайт не оптимизирован для мобильных устройств

Веб-сайт, адаптированный для мобильных устройств, имеет решающее значение для индексации вашего сайта Google, поскольку он ввел индексирование Mobile-First.

Независимо от того, насколько хорош контент на вашем веб-сайте, если он не оптимизирован для просмотра на смартфоне или планшете, вы потеряете рейтинг и трафик.

Оптимизация для мобильных устройств не должна быть сложной — простое добавление принципов адаптивного дизайна, таких как плавающие сетки и CSS Media Queries, может значительно помочь пользователям найти то, что им нужно, без каких-либо проблем с навигацией.

Первое, что я рекомендую сделать с этой проблемой, — запустить ваш сайт с помощью Google Mobile-Friendly Testing Tool.

Если вы не получили «пройдено чтение», вам нужно проделать определенную работу, чтобы сделать ваш сайт удобным для мобильных устройств.

3. Вы используете язык кодирования слишком сложным для Google способом

Google не будет индексировать ваш сайт, если вы используете язык кодирования сложным образом. Неважно, какой язык — он может быть старым или даже обновленным, как JavaScript — если настройки неверны и вызывают проблемы со сканированием и индексированием.

Если это проблема для вас, я рекомендую запустить Google Mobile-Friendly Testing Tool, чтобы увидеть, насколько ваш сайт действительно удобен для мобильных устройств (и внести любые исправления, которые могут потребоваться).

Если ваш веб-сайт еще не соответствует их стандартам, они предлагают множество ресурсов с рекомендациями по всевозможным причудам дизайна, которые могут возникнуть при разработке адаптивной веб-страницы.

4. Ваш сайт загружается медленно

Сайты с медленной загрузкой снижают вероятность того, что Google захочет, чтобы они отображались в верхних результатах индекса. Если ваш сайт долго загружается, это может быть связано со многими различными факторами.

Возможно даже, что у вас слишком много контента на странице для браузера пользователя, или если вы используете старомодный сервер с ограниченными ресурсами.

Решения:

- Используйте Google Page Speed Insights . Это один из моих любимых инструментов, который я нашел за последние годы, и он помогает мне определить, какие разделы веб-сайта требуют срочного внимания при повышении его скорости. Инструмент анализирует вашу веб-страницу в соответствии с пятью лучшими рекомендациями по производительности (которые имеют решающее значение для более быстрой загрузки сайтов), такими как минимизация подключений, уменьшение размера полезной нагрузки, использование кэширования браузера и т.

д., и дает вам предложения о том, как вы можете улучшить каждый аспект. твой сайт.

д., и дает вам предложения о том, как вы можете улучшить каждый аспект. твой сайт. - Используйте такой инструмент, как webpagetest.org . Этот инструмент сообщит вам, загружается ли ваш сайт достаточно быстро. Это также позволит вам подробно увидеть конкретные элементы на вашем сайте, которые вызывают у вас проблемы. Их водопад может помочь вам определить серьезные проблемы со скоростью страницы до того, как они вызовут серьезные проблемы.

- Снова используйте аналитику Google Page Speed — Посмотрите, где можно улучшить время загрузки сайта. Например, возможно, стоит изучить новый план хостинга с большим количеством ресурсов (чистые выделенные серверы намного лучше, чем общие) или использовать службу CDN, которая будет обслуживать статический контент из своего кеша в нескольких местах по всему миру.

В идеале, убедитесь, что скорость вашей страницы достигает 70 или выше. В идеале как можно ближе к 100.

Если у вас есть какие-либо вопросы относительно скорости страницы, вы можете ознакомиться с электронной книгой SEJ о Core Web Vitals.

5. На вашем сайте минимум хорошо написанного контента

Хорошо написанный контент имеет решающее значение для успеха в Google. Если у вас есть минимальный контент, который, по крайней мере, не соответствует уровню ваших конкурентов, у вас могут быть серьезные проблемы даже с попаданием в топ-50.

По нашему опыту, контент, содержащий менее 1000 слов, не так эффективен, как контент, содержащий более 1000 слов.

Являемся ли мы компанией по написанию контента? Нет, мы не. Является ли количество слов фактором ранжирования? Также нет.

Но когда вы решаете, что делать в контексте конкурса, убедитесь, что ваш контент хорошо написан, это ключ к успеху.

Содержание вашего сайта должно быть качественным и информативным. Он должен отвечать на вопросы, предоставлять информацию или иметь точку зрения, которая достаточно отличается от других сайтов в той же нише, что и ваша.

Если он не соответствует этим стандартам, Google, скорее всего, найдет другой сайт с более качественным контентом, который им соответствует.

Если вам интересно, почему ваш веб-сайт не занимает высокие позиции в результатах поиска Google по некоторым ключевым словам, несмотря на то, что он следует рекомендациям SEO, таким как добавление релевантных ключевых слов по всему тексту (Подсказка: ваш контент), тогда одним из виновников могут быть тонкие страницы, где на странице действительно должно быть больше 100 слов!

Тонкие страницы могут вызвать проблемы с индексацией, поскольку они не содержат много уникального контента и не соответствуют минимальным уровням качества по сравнению с вашими конкурентами.

6. Ваш сайт не удобен для пользователя и не привлекателен для посетителей

Наличие удобного и привлекательного сайта имеет решающее значение для хорошего SEO. Google повысит рейтинг вашего сайта в результатах поиска, если посетителям будет легко находить то, что они ищут, и перемещаться по веб-сайту, не чувствуя разочарования или раздражения.

Google не хочет, чтобы пользователи проводили слишком много времени на странице, которая либо долго загружается, либо имеет запутанную навигацию, либо просто неудобна в использовании, потому что слишком много отвлекающих факторов (например, реклама в верхней части страницы).

Если в каждой категории указан только один продукт вместо нескольких, возможно, именно поэтому ваш контент плохо ранжируется в Google! Важно не только настроить таргетинг на ключевые слова в каждом сообщении, но и убедиться, что все связанные сообщения ссылаются на другие соответствующие статьи/страницы по теме.

Нравится ли людям делиться вашим блогом? Читатели поражены вашим контентом? Если нет, то это может быть причиной того, что Google прекратил индексировать ваш сайт.

Если кто-то ссылается непосредственно на одну конкретную страницу продукта, а не использует относительные ключевые слова, такие как «купить», «купить» и т. д., возможно, что-то не так с тем, как другие страницы ссылаются на этот конкретный продукт.

Убедитесь, что все продукты, перечисленные на страницах категорий, также существуют в каждой соответствующей подкатегории, чтобы пользователи могли легко совершать покупки без необходимости перемещаться по сложной иерархии ссылок.

7.

У вас есть цикл перенаправления

У вас есть цикл перенаправленияЦиклы перенаправления — еще одна распространенная проблема, препятствующая индексации. Обычно они вызваны распространенной опечаткой и могут быть исправлены с помощью следующих шагов:

Найдите страницу, вызывающую цикл перенаправления. Если вы используете WordPress, найдите исходный HTML-код одного из ваших сообщений на этой странице или в файле .htaccess и найдите «Перенаправление 301», чтобы увидеть, с какой страницы он пытается направить трафик. Также стоит исправить все перенаправления 302 и убедиться, что они установлены на 301.

Используйте «найти» в проводнике Windows (или Command + F, если Mac) для поиска во всех файлах, содержащих «перенаправление», пока не обнаружите, в чем проблема.

Исправьте любые опечатки, чтобы дублирующийся URL-адрес не указывал на себя, а затем используйте код перенаправления, как показано ниже:

Коды состояния, такие как 404, не всегда отображаются в Google Search Console. Используя внешний сканер, такой как Screaming Frog, вы можете найти коды состояния для 404 и других ошибок.

Если все выглядит хорошо, используйте Google Search Console на месте, чтобы снова просканировать сайт и повторно отправить его на индексацию. Подождите неделю или около того, прежде чем снова зайти в Google Search Console, если появятся какие-либо новые предупреждения, требующие внимания.

У Google нет времени обновлять свои индексы каждый день, но они делают это каждые несколько часов, что означает, что иногда ваш контент может отображаться не сразу, даже если вы знаете, что он был обновлен. Потерпи! Вскоре он должен быть проиндексирован.

8. Вы используете плагины, которые блокируют сканирование вашего сайта роботом Googlebot

Одним из примеров такого плагина является плагин robots.txt. Если с помощью этого плагина вы установите для файла robots.txt запрет на индексирование своего сайта, робот Googlebot не сможет его просканировать.

Настройте файл robots.txt и выполните следующие действия:

При создании сделайте его общедоступным, чтобы поисковые роботы могли получить к нему доступ без ограничений.

Убедитесь, что в файле robots.txt нет следующих строк:

User-agent: * Disallow: /

Слэш означает, что файл robots.txt блокирует все страницы из корневой папки сайта. Вы хотите убедиться, что ваш файл robots.txt выглядит примерно так:

User-agent: * Запретить:

Если строка запрета пуста, это означает, что поисковые роботы могут сканировать и индексировать каждую страницу вашего сайта без ограничений (при условии, что у вас нет определенных страниц, помеченных как не индексируемые).

9. Ваш сайт использует JavaScript для Render Content

Использование JavaScript само по себе не всегда является сложной проблемой, которая вызывает проблемы с индексацией. Не существует единого правила, которое говорит, что JS — это единственное, что вызывает проблемы. Вы должны смотреть на отдельный сайт и диагностировать проблемы, чтобы определить если это проблема

Когда JS вступает в игру как проблема, это когда JS предотвращает сканирование, выполняя сомнительные действия — методы, которые могут быть похожи на маскировку.

Если вы создали обработанный HTML, а не необработанный HTML, и у вас есть ссылка в необработанном HTML, которой нет в обработанном HTML, Google не может сканировать или индексировать эту ссылку. Определение проблем отображаемого HTML и необработанного HTML имеет решающее значение из-за ошибок такого типа.

Если вы хотите скрыть файлы JS и CSS, не делайте этого. Google упомянул, что хочет видеть все ваши файлы JS и CSS при сканировании.

Google хочет, чтобы вы сохранили возможность сканирования всех JS и CSS. Если какие-либо из этих файлов у вас заблокированы, вы можете разблокировать их и разрешить полное сканирование, чтобы предоставить Google нужное представление о вашем сайте.

10. Вы не добавили все свойства домена в Google Search Console

Если у вас более одного варианта домена, особенно в ситуации, когда вы мигрировали с http:// на https://, вы должны все варианты вашего домена добавлены и проверены в Google Search Console.

Важно убедиться, что вы не пропустили ни один из вариантов домена при их добавлении в GSC.

Добавьте их в GSC и убедитесь, что вы подтвердили право собственности на все свойства домена, чтобы убедиться, что вы отслеживаете правильные.

Для новых сайтов, которые только начинают свою работу, это, скорее всего, не будет проблемой.

11. Ваши метатеги установлены на Noindex, NofollowИногда, по чистой случайности, метатеги установлены на noindex, nofollow. Например, на вашем сайте может быть ссылка или страница, которая была проиндексирована поисковым роботом Google, а затем удалена до перехода на noindex, nofollow был правильно настроен в серверной части вашего сайта.

В результате эта страница, возможно, не была повторно проиндексирована, и если вы используете плагин для блокировки Google от сканирования вашего сайта, эта страница может больше никогда не быть проиндексирована.

Решение простое: измените любые метатеги со словами noindex,nofollow, чтобы они читались как index, вместо этого следуйте.

Однако, если у вас есть тысячи подобных страниц, вам, возможно, предстоит тяжелая битва. Это один из тех моментов, когда вы должны стиснуть зубы и двигаться вперед с трудом.

Это один из тех моментов, когда вы должны стиснуть зубы и двигаться вперед с трудом.

В конце концов, производительность вашего сайта скажет вам спасибо.

12. Вы не используете карту сайта

Вам необходимо использовать карту сайта!

Карта сайта — это список всех страниц вашего сайта, а также один из способов для Google узнать, какой у вас контент. Этот инструмент поможет гарантировать, что каждая страница будет просканирована и проиндексирована консолью поиска Google.

Если у вас нет карты сайта, Google работает вслепую, если только все ваши страницы в настоящее время не проиндексированы и не получают трафик.

Однако важно отметить, что файлы Sitemap в формате HTML устарели в Google Search Console. В настоящее время предпочтительным форматом файлов Sitemap являются XML Sitemaps.

Вы хотите использовать свою карту сайта, чтобы сообщить Google, какие страницы вашего сайта являются важными, и вы хотите регулярно отправлять ее для сканирования и индексации.

13. Вы были наказаны Google в прошлом и до сих пор не исправили свои действия

Google неоднократно заявлял, что штрафы могут последовать за вами.

Если у вас уже был штраф и вы не исправили свой поступок, то Google не будет индексировать ваш сайт.

Ответ на этот вопрос довольно прост: если Google наказывает за это, они, возможно, ничего не смогут с этим поделать, потому что штрафы следуют за вами повсюду, как незваный друг, который волочит ноги по ковру, проходя через каждую комнату. твой дом.

Если вам интересно, зачем вам по-прежнему исключать некоторую информацию со своего веб-сайта, если у вас уже есть проблемы с поисковыми системами?

Дело в том, что несмотря на то, что есть способы избежать наказания, многие люди не знают, или уже не могут вносить эти изменения по каким-либо причинам (возможно, они продали свою компанию). Некоторые также думают, что простое удаление страниц и добавление старого контента на новый сайт будет работать так же хорошо (это не так).

Если вас оштрафовали, самый безопасный путь — полностью исправить свой поступок. У вас должен быть совершенно новый контент, и вы должны перестроить домен с нуля или провести полную перестройку контента. Google объясняет, что они ожидают, что вам потребуется столько же времени, чтобы уйти от штрафа, сколько потребовалось, чтобы вы попали в него.

14. Ваше техническое SEO ужасно

Не заблуждайтесь: покупка технического SEO на Fiverr.com похожа на покупку Lamborghini в магазине за доллар: вы, скорее всего, получите подделку, а не настоящую вещь.

Правильное техническое SEO того стоит: Google и ваши пользователи полюбят вас.

Давайте рассмотрим некоторые распространенные проблемы и решения, а также то, где вам может помочь техническое SEO.

Проблема: Ваш сайт не достигает показателей Core Web Vitals

Решение: Техническая поисковая оптимизация поможет вам определить проблемы с основными показателями работы сети и предоставит вам путь к их устранению. Не полагайтесь только на стратегический аудит — он не всегда поможет вам в этих областях. Вам нужен полный технический SEO-аудит, чтобы выявить некоторые из этих проблем, потому что они могут варьироваться от совершенно простых до невероятно сложных.

Не полагайтесь только на стратегический аудит — он не всегда поможет вам в этих областях. Вам нужен полный технический SEO-аудит, чтобы выявить некоторые из этих проблем, потому что они могут варьироваться от совершенно простых до невероятно сложных.

Проблема: Проблемы со сканированием и индексированием вашего сайта

Решение: Они могут быть невероятно сложными, и для их обнаружения и исправления требуется опытный специалист по технической оптимизации. Вы должны определить их, если обнаружите, что у вас нулевая тяга или вы не получаете никакой производительности от своего сайта.

Также убедитесь, что вы случайно не поставили галочку в поле «запрещать поисковым системам индексировать ваш сайт» в WordPress.

Проблема: Файл robots.txt вашего сайта каким-то образом непреднамеренно блокирует доступ поисковых роботов к важным файлам

Решение: Опять же, техническое SEO здесь, чтобы спасти вас из бездны. Некоторые сайты находятся в таком глубоком упадке, что вы не видите другого выхода, кроме как удалить сайт и начать заново. Ядерный вариант не всегда лучший вариант. Именно здесь опытный технический SEO-специалист на вес золота.

Некоторые сайты находятся в таком глубоком упадке, что вы не видите другого выхода, кроме как удалить сайт и начать заново. Ядерный вариант не всегда лучший вариант. Именно здесь опытный технический SEO-специалист на вес золота.

Контент, техническое SEO и ссылки — все это важно для поддержания траектории производительности вашего сайта. Но если у вашего сайта есть проблемы с индексацией, другие элементы SEO не помогут вам.

Не забудьте поставить галочки во всех полях и убедиться, что вы действительно продвигаете свой сайт самым правильным образом.

И не забудьте оптимизировать каждую страницу вашего сайта по релевантным ключевым словам! Также стоит убедиться, что ваше техническое SEO на должном уровне, потому что чем лучше Google сможет сканировать, индексировать и ранжировать ваш сайт, тем лучше будут ваши результаты.

Google (и трафик вашего сайта) будут вам благодарны.

Дополнительные ресурсы:

- 11 SEO-советов и приемов для улучшения индексации

- Как поисковые системы сканируют и индексируют: все, что вам нужно знать

- Как работают поисковые системы

Рекомендуемое изображение: Shutterstock/Sammby

Категория SEO

Как заставить Google проиндексировать ваш веб-сайт

Коротко о том, как заставить Google проиндексировать ваш веб-сайт

Процесс индексации Google сложен, и многие этапы влияют друг на друга.

Чтобы заставить их быстро проиндексировать ваш веб-сайт, вам нужно убедиться, что нет никаких препятствий, мешающих индексации Google.

Во-вторых, сделайте все возможное, чтобы уведомить Google о том, что у вас есть свежий контент и вы хотите, чтобы ваш сайт был проиндексирован. Имейте в виду, что качество вашего контента и отсутствие внутренних ссылок могут помешать процессу индексации.

Наконец, повысьте популярность своего веб-сайта, создав внешние ссылки на него и заставив людей обсуждать ваш контент в социальных сетях.

Содержание

- Кратко о процессе индексации Google

- Как проверить, проиндексировал ли Google ваш веб-сайт?

- Как заставить Google быстро проиндексировать ваш веб-сайт

- Заключение

Если вашего контента нет в Google, существует ли он вообще?

Чтобы ваш веб-сайт был виден в доминирующей поисковой системе, его сначала необходимо проиндексировать. В этой статье мы покажем вам, как заставить Google быстро и эффективно проиндексировать ваш сайт и какие препятствия следует избегать.

Кратко о процессе индексации Google

Прежде чем углубляться в то, как проиндексировать ваш веб-сайт, давайте рассмотрим упрощенное объяснение того, как работает процесс индексации Google.

Индекс Google можно сравнить с огромной библиотекой, которая больше, чем все библиотеки мира вместе взятые!

Индекс содержит миллиарды и миллиарды страниц, из которых Google выбирает наиболее релевантные, когда пользователи делают поисковые запросы.

С таким количеством контента, который постоянно меняется, Google должен постоянно искать новый контент, контент, который был удален, и контент, который был обновлен — и все это для поддержания своего индекса в актуальном состоянии.

Чтобы Google ранжировал ваш сайт, сначала необходимо пройти следующие три этапа:

- Обнаружение : Обрабатывая XML-карты сайта и переходя по ссылкам на других страницах, о которых Google уже знает, поисковая система обнаруживает новых и обновленных страниц и ставит их в очередь для сканирования.

- Сканирование : Затем Google переходит к сканированию каждой обнаруженной страницы и передает всю найденную информацию процессам индексирования.

- Индексация : Помимо прочего, процессы индексации обрабатывают контент-анализ, отображают страницы и определяют, индексировать их или нет.

Взаимосвязь системы индексирования Google

Процесс индексирования Google очень сложен, и многие этапы этого процесса взаимозависимы. Если какая-то часть потока пойдет не так, это повлияет и на другие фазы.

Если какая-то часть потока пойдет не так, это повлияет и на другие фазы.

Например, 10 августа 2020 года SEO-сообщество заметило ряд изменений в рейтинге результатов поиска. Многие утверждали, что это означало, что Google выпускает значительное обновление. Но на следующий день Google объявил, что на самом деле это было вызвано ошибкой в их системе индексации, которая повлияла на ранжирование:

Чтобы пролить свет на сложность и переплетение процесса индексации, Гарри Иллиес объяснил рабочий процесс Caffeine в ветке Twitter:

Этот твит предполагает, что ошибка на этапе индексации может сильно повлиять на последующий процесс – в данном случае испортить систему ранжирования.

Наряду с этим событием важно отметить, что в мае 2020 года Google подвергся масштабному обновлению ядра, которое повлияло на процесс индексации. С тех пор Google стал медленнее индексировать новый контент и стал более разборчивым в отношении контента, который он решает индексировать. Кажется, что процесс фильтрации качества стал намного строже, чем раньше.

Полезные ресурсы

- Как работает поиск Google

- Управление сканированием и индексированием: Полное руководство

Не упустите органический трафик время!

Как проверить, проиндексировал ли Google ваш сайт?

Существует несколько быстрых способов проверить, проиндексировал ли Google ваш веб-сайт или они все еще застряли на предыдущих этапах обнаружение и сканирование .

Отзыв от Google Search Console

Используйте отчет о покрытии индекса Google Search Console, чтобы получить краткий обзор статуса индексации вашего веб-сайта. В этом отчете содержится информация о технических деталях процесса сканирования и индексирования вашего сайта.

Отчет возвращает четыре типа статусов:

- Действителен : эти страницы были успешно проиндексированы.

- Действительно с предупреждениями : эти страницы были проиндексированы, но есть некоторые проблемы, которые вы, возможно, захотите проверить.

- Исключено : эти страницы не были проиндексированы, так как Google уловил четкие сигналы о том, что им не следует их индексировать.

- Ошибка : Google по какой-то причине не смог проиндексировать эти страницы.

- Войдите в Google Search Console.

- Выберите свойство.

- Нажмите

ПокрытиеподИндексв левой навигации.

Вот пример того, как выглядит отчет о покрытии индексом для крупного веб-сайта:

Отчет о покрытии индекса позволяет быстро проверить общий статус индексирования вашего сайта, а тем временем вы можете использовать инструмент проверки URL-адресов Google Search Console для увеличения на отдельных страницах.

Проверьте свой URL-адрес в Google Search Console- Войдите в Google Search Console.

- Выберите свойство.

- Отправьте URL-адрес веб-сайта, который вы хотите проверить.

Далее вы увидите что-то вроде этого:

Если инструмент проверки URL-адресов показывает, что URL-адрес еще не проиндексирован, вы можете использовать тот же инструмент для запроса индексации.

Часто задаваемые вопросы

- Просканировано — в настоящее время не проиндексировано в Google Search Console: как это исправить?

Проверьте кеш URL-адреса

Проверьте, есть ли кешированная версия вашего URL в Google, либо набрав cache:https://example.com в Google или адресную строку, или щелкнув маленькую стрелку, указывающую вниз под URL-адресом в поисковой выдаче.

Если вы видите результат, Google проиндексировал ваш URL. Вот пример для одной из наших статей:

Дата, указанная на снимке экрана, относится к последней индексации веб-сайта. Имейте в виду, что он ничего не говорит о том, когда он был просканирован в последний раз. Веб-сайт мог быть просканирован позже, но Google не проиндексировал его обновления, как указал Гарри Иллиес в этом твите.

В то же время, проверка кеша URL-адресов также не является надежной — вы можете увидеть кешированную страницу, даже если — тем временем — страница была удалена из индекса Google.

Если страница ранжируется, значит, она проиндексирована

Еще один способ проверить, были ли ваши страницы проиндексированы, — это проверить, ранжируются ли они с помощью системы отслеживания позиций или просто проверив данные о производительности Google Search Console, чтобы увидеть, получаете ли вы клики и показов:

Использовать данные о производительности для определения статуса индекса- Войдите в Google Search Console.

- Выберите свойство.

- Нажмите

Результаты поискаподПроизводительностьслева. - Отфильтруйте нужную страницу, щелкнув фильтр вверху. По умолчанию он открывается с настройкой

URL-адресов, содержащих. Заполните URL-адреса, которые вы ищете.

Далее вы увидите что-то вроде этого:

Поиск точного названия страницы или URL

В качестве альтернативы, чтобы узнать, проиндексирована ли страница, вы можете выполнить поиск по точному заголовку страницы, заключив его в кавычки ( «Название вашей страницы» ), использовать оператор поиска intitle: с заголовком вашей страницы ( intitle:"Заголовок вашей страницы" ) или просто введите URL-адрес в Google.

сайт: запросы

Вы также можете проверить, проиндексирована ли ваша страница, используя запрос сайт: для страницы. Вот пример: ввод https://www.conductor.com/academy/seo-reporting/ может показать, проиндексирована ли эта страница.

Однако такой подход не всегда надежен!

Мы видели случаи, когда страницы ранжируются, но не отображаются для сайта : запросов. Так что никогда не полагайтесь только на эту проверку.

Как заставить Google быстро проиндексировать ваш веб-сайт

Вот как заставить Google быстро проиндексировать ваш веб-сайт:

1. Предотвратить влияние директив роботов на индексацию

Распространенная причина, по которой Google не индексирует ваш контент, связана с директива noindex для роботов. Хотя эта директива помогает предотвратить проблемы с дублированием контента, она дает Google сильный сигнал не индексировать определенные страницы на вашем веб-сайте. Директивы Meta robots могут быть реализованы через источник HTML и заголовок HTTP.

В исходном коде HTML метатег robots может выглядеть примерно так:

.

Применяйте их только на страницах, которые вы определенно не хотите индексировать, и в случае, если страница, которую вы хотите проиндексировать, имеет проблемы с индексацией, дважды проверьте, не реализована ли директива noindex.

Обнаружение неиндексированного контента в режиме реального времени

Получайте мгновенные уведомления о любых важных страницах, которые не индексируются. Больше никаких SEO-сюрпризов!

2. Правильно настройте канонические теги

Хотя канонические теги не являются таким сильным сигналом, как директива meta robots, их неправильное использование может привести к проблемам с индексацией. Убедитесь, что страницы, которые вы хотите проиндексировать, не канонизированы.

Одна вещь, которую я видел, это сайты, которые настолько увязли в обеспечении канонизации своих страниц, что в конечном итоге канонизируют страницы, которые также помеченыnoindex.

Хлоя Смит, Старший SEO-менеджер, Blue ArrayGoogle нужны четкие, последовательные сигналы, поэтому канонизация вашего контента на странице с пометкой noindex может остановить работу затронутых страниц.

3. Не запрещайте контент, который вы хотите индексировать . Его можно настроить так, чтобы Google знал, что он должен игнорировать определенные части вашего веб-сайта.

Убедитесь, что URL-адреса, которые вы хотите проиндексировать, не запрещены в файле robots.txt. Нарушение файла robots.txt может привести к тому, что новый контент и обновления контента не будут индексироваться. Имейте в виду, что в файле robots.txt может ошибиться любой — даже такие крупные компании, как Ryanair.

Чтобы узнать, какие страницы заблокированы robots.txt, проверьте отчет «Проиндексировано, но заблокировано robots.txt» в Google Search Console.

Совет профессионала

Запрет URL-адреса в robots.txt не обязательно означает, что сайт исчезнет из поиска Google. Веб-сайт может появиться в поисковой выдаче, но с плохим фрагментом.

Веб-сайт может появиться в поисковой выдаче, но с плохим фрагментом.

Гас Пелогия, Менеджер по SEO-продуктам, Indeed.comФайл robots.txt может быть простым в использовании, но также достаточно мощным с точки зрения создания большого беспорядка. Я видел много случаев, когда веб-сайты были «готовы к работе» и запускались с помощью Disallow: /.

В результате все страницы блокируются для поисковых систем, и никто не может найти веб-сайт через поиск Google. Тем временем клиент начинает задаваться вопросом, почему Google ничего не индексирует. Одна строка кода может остаться незамеченной и помешать Google найти весь контент вашего сайта!

4. Предотвращение ловушек для сканеров и оптимизация бюджета сканирования

Чтобы получить максимальную отдачу от Google при сканировании вашего веб-сайта, избегайте создания ловушек для сканеров. Ловушки сканеров — это структурные проблемы на веб-сайте, которые приводят к тому, что сканеры находят практически бесконечное количество нерелевантных URL-адресов, в которых сканеры могут потеряться.

Вы должны убедиться, что техническая база вашего веб-сайта находится на должном уровне, и что вы используете надлежащие инструменты, которые могут быстро обнаруживать ловушки для поисковых роботов, на которые Google может тратить ваш ценный краулинговый бюджет.

Gerry White, SEOСамая большая причина ловушек для сканеров на веб-сайтах сегодня связана с многогранной навигацией и фильтрами по цене или размеру (особенно если вы можете выбрать несколько). Если вы не скроете эти URL-адреса от Google, вы можете легко создать миллионы дополнительных URL-адресов всего на нескольких страницах. Помните, что Google может переходить как по обычным ссылкам, так и по ссылкам JavaScript, и что URL-адреса чувствительны к регистру.

Мой совет: убедитесь, что все варианты URL, которые необходимо заблокировать, действительно заблокированы!

5. Предоставление индексируемого контента Google через XML-карту сайта

Если вы уверены, что с вашей стороны нет блокировок, вы должны облегчить Google обнаружение ваших URL-адресов и понимание инфраструктуры вашего веб-сайта. в общем. Карты сайта в формате XML — отличный способ сделать это.

в общем. Карты сайта в формате XML — отличный способ сделать это.

Весь недавно опубликованный контент или обновленный контент, который необходимо проиндексировать, должен автоматически добавляться в ваши XML-карты сайта. Чтобы Google мог легко найти ваш контент, отправьте свои XML-карты сайта в Google Search Console.

- Войдите в Google Search Console.

- Выберите свойство, для которого вы хотите отправить карту сайта.

- Нажмите

SitemapsподIndexс левой стороны. - Отправьте URL-адрес файла Sitemap в формате XML.

Затем Google будет регулярно проверять отправленную карту сайта в формате XML на наличие нового контента для обнаружения, сканирования и, возможно, индексации.

Совет для профессионалов

Если у вас большой веб-сайт, имейте в виду, что XML-карты сайта должны содержать не более 50 000 URL-адресов. Лучше создать больше XML-карт сайта с меньшим количеством URL-адресов, чем превысить этот лимит.

Оливер Мейсон описал стратегию XML-карты сайта, в которой он ограничил количество URL-адресов до 10 000 и организовал их в хронологическом порядке: sitemap1.xml содержит самые старые страницы, а sitemap14.xml содержит самые последние страницы.

Это привело к улучшению индексации. Кажется, окупается предоставление Google меньшего количества URL-адресов и группировка нового контента вместе.

Jess JoyceМой основной способ быстро проиндексировать что-либо — это всегда проверять сайт в Search Console, а затем отправлять туда XML-карту сайта.

Всегда следите за тем, чтобы в XML-карте сайта были указаны все страницы, которые вы хотите проиндексировать, и они организованы таким образом, чтобы Google мог их прочитать — с индексами карты сайта, если это необходимо.

Для меня это был лучший способ постучать в дверь Google, чтобы сообщить им, что они могут просмотреть веб-сайт как можно скорее и просканировать / проиндексировать все, что там найдено, и вы всегда можете вернуться, чтобы увидеть, когда он был отправлен и последний раз читался Google .

6. Вручную отправьте URL-адреса в Google Search Console

Несмотря на то, что Google самостоятельно обнаружит, просканирует и, возможно, проиндексирует ваши новые или обновленные страницы, ему все же стоит дать толчок, отправив URL-адреса в Google Search Console. Таким образом, вы также можете ускорить процесс ранжирования.

Вы можете отправить свои URL-адреса в инспекторе URL-адресов GSC:

- Войдите в Google Search Console

- Выберите веб-сайт, для которого вы хотите отправить URL-адрес

- Отправьте URL-адрес в верхнюю часть Google Search Console

- Проверить если URL-адрес индексируется, нажав

Кнопка TEST LIVE URL. - Нажмите кнопку

ЗАПРОСИТЬ ИНДЕКСИРОВАНИЕ. - Сделайте то же самое для страниц, которые ссылаются на страницу, которую вы хотите проиндексировать в Google.

Профессиональный совет

Обратите внимание, что страницы могут быть проиндексированы, но не ранжироваться. Например, если вы запросите индексацию в Google Search Console (GSC), ваши страницы будут быстро проиндексированы, но не сразу получат рейтинг. Однако, как правило, это ускоряет весь процесс.

Например, если вы запросите индексацию в Google Search Console (GSC), ваши страницы будут быстро проиндексированы, но не сразу получат рейтинг. Однако, как правило, это ускоряет весь процесс.

7. Отправить сообщение через Google My Business

Отправка сообщения через Google My Business дает Google дополнительный толчок для сканирования и индексации URL-адресов, которые вы туда включили. Мы не рекомендуем делать это только для любой публикации, и имейте в виду, что эта публикация будет отображаться на панели знаний Google My Business справа для брендовых поисковых запросов.

- Войдите в Google My Business

- Выберите место, для которого вы хотите отправить публикацию.

- Нажмите

Создайте сообщениеи выберитеЧто нового 9Тип 0392. - Добавьте фото, напишите краткий пост, выберите вариант

Узнать большедляДобавить кнопку (необязательно), введите URL-адрес в полеСсылка для кнопкии нажмитеОпубликовать.

- Сделайте то же самое для страниц, которые ссылаются на страницу, которую вы хотите проиндексировать в Google.

8. Автоматическое индексирование с помощью Google Indexing API

Веб-сайты с большим количеством недолговечных страниц, таких как объявления о вакансиях, объявления о событиях или видео в прямом эфире, могут использовать Google Indexing API для автоматического запроса на сканирование и индексирование нового контента. и изменения содержания. Поскольку это позволяет вам продвигать отдельные URL-адреса, это эффективный способ для Google поддерживать актуальность своего индекса.

С помощью Indexing API вы можете

- Обновить URL-адрес: уведомить Google о новом или обновленном URL-адресе для сканирования

- Удалить URL-адрес: уведомить Google об удалении устаревшей страницы с вашего веб-сайта

- Получить статус просьба: посмотрите, когда Google в последний раз сканировал URL-адрес

Сугантан Моханадасан, Соучредитель Snippet DigitalХотя Google не рекомендует скармливать им другие типы контента, кроме вакансий и событий, мне удалось проиндексировать обычные страницы с помощью API.

Я заметил одну вещь: API работает лучше для новых страниц, чем для переиндексации. Google может применить это в какой-то момент, но пока все работает нормально. У RankMath есть плагин, который значительно упрощает работу, но требует небольшой настройки.

9. Предоставление Google только высококачественного контента

Цель Google — как можно быстрее предоставить своим пользователям высококачественный контент. Поэтому всегда сосредотачивайтесь на том, чтобы предоставить Google лучший контент, который вы можете создать, чтобы увеличить ваши шансы на быструю индексацию.

Благодаря строгой оценке контента Google и нескончаемой конкуренции создание и оптимизация отличного контента — это процесс, который никогда не прекратится.

Помимо создания нового контента, сосредоточьтесь на улучшении того, что уже есть. Обновляйте неэффективный контент, чтобы он давал более качественные ответы потенциальным посетителям. Если на вашем веб-сайте есть некачественный или устаревший контент, подумайте о том, чтобы либо полностью удалить его, либо запретить Google тратить на него свой драгоценный краулинговый бюджет.

Если на вашем веб-сайте есть некачественный или устаревший контент, подумайте о том, чтобы либо полностью удалить его, либо запретить Google тратить на него свой драгоценный краулинговый бюджет.

Профессиональный совет

Процесс отсечения устаревшего, неактуального или просто слишком некачественного контента называется обрезкой контента. Избавляясь от мертвого груза, вы освобождаете место для другого контента, у которого есть потенциал, чтобы он процветал, предоставляя Google только лучший контент, который может предложить ваш сайт.

10. Предотвращение дублирования контента

Еще один способ превратить краулинговый бюджет Google в огромную трату — дублировать контент. Этот термин относится к очень похожему или идентичному контенту, который появляется на нескольких страницах вашего собственного веб-сайта или на других веб-сайтах.

В общем, дублированный контент может сбить Google с толку. В принципе, Google индексирует только один URL для каждого уникального набора контента. Но поисковой системе сложно определить, какую версию индексировать, и это впоследствии отражается в их результатах поиска. И поскольку идентичные версии продолжают конкурировать друг с другом, это снижает производительность для всех из них.

Но поисковой системе сложно определить, какую версию индексировать, и это впоследствии отражается в их результатах поиска. И поскольку идентичные версии продолжают конкурировать друг с другом, это снижает производительность для всех из них.

Дублированный контент может превратиться в серьезную проблему, в основном для владельцев веб-сайтов электронной коммерции, которым необходимо найти способ сообщить Google, какие части их веб-сайта нужно проиндексировать, а какие оставить скрытыми.

С этой целью вы можете использовать запрет в robots.txt для фильтров и параметров, или вы можете реализовать канонические URL-адреса. Но, как упоминалось в первой части этой статьи, будьте очень осторожны с тем, что вы реализуете, так как даже небольшое изменение может иметь негативные последствия.

Проблемы с дублированием содержимого вредят вашему сайту?

Не тратьте краулинговый бюджет на дублированный контент. Выполните быструю проверку с помощью ContentKing, чтобы устранить любые проблемы, препятствующие индексации.

11. Используйте внутренние ссылки и избегайте использования nofollow

Внутренние ссылки играют огромную роль в понимании Google тем вашего веб-сайта и его внутренней иерархии. Внедряя стратегически размещенные внутренние ссылки, вы облегчите Google понимание того, о чем ваш контент и как он помогает пользователям.

Не используйте rel="nofollow" атрибут на ваших внутренних ссылках, так как значение атрибута nofollow сигнализирует Google, что он не должен переходить по ссылке на целевой URL. Это приводит к тому, что значение ссылки также не передается.

Сэм Андервуд, SEO-консультант по электронной коммерцииЕсли вам нужно быстро проиндексировать новые страницы, продумайте стратегический способ внутренних ссылок на них.

Добавление внутренних ссылок на главную страницу и в области всего сайта, такие как верхний и нижний колонтитулы, значительно ускорит процесс сканирования и индексирования.

Рассмотрите возможность создания динамических областей на домашней странице, в которых будет отображаться ваш последний контент, будь то сообщение в блоге, новостная статья или продукт.

Вы также можете использовать ссылки в мегаменю, в которых перечислены последние URL-адреса в различных таксономиях вашего сайта.

12. Создавайте релевантные обратные ссылки на ваш контент

Не будет преувеличением сказать, что построение ссылок — одна из самых важных дисциплин в этой области. По общему мнению, ссылки способствуют вашему успеху в поисковой оптимизации более чем на 50 процентов.

С помощью внешних ссылок, часто называемых обратными, Google может обнаружить ваш веб-сайт. А поскольку ссылки также передают часть своего авторитета, вы будете быстрее проиндексированы, если обратная ссылка исходит с веб-сайта с высоким авторитетом, и это значительно повлияет на ваш рейтинг.

Чтобы помочь вам улучшить параметры индексации и ранжирования, вот целый список высокоэффективных стратегий построения ссылок.

13. Создайте шумиху вокруг своего контента в социальных сетях

Ранее в этой статье мы упоминали, что Google стал намного строже в отношении индексируемого контента.

График идёт по экспоненте без резких колебаний — это хороший признак: SEO продвижение сайта идёт правильно. Если график неровный, напоминающий кардиограмму, это явный признак ошибок в анализе: их обязательно нужно исправить.

График идёт по экспоненте без резких колебаний — это хороший признак: SEO продвижение сайта идёт правильно. Если график неровный, напоминающий кардиограмму, это явный признак ошибок в анализе: их обязательно нужно исправить. Аналогично с тегом X-Robots, который мог быть проставлен, как Noindex при тестировании или выставлен случайно. В общем, файл «роботов» стоит тщательно изучить на наличие лишних символов или атрибутов.

Аналогично с тегом X-Robots, который мог быть проставлен, как Noindex при тестировании или выставлен случайно. В общем, файл «роботов» стоит тщательно изучить на наличие лишних символов или атрибутов.

Для решения проблемы необходимо отменить авторизацию или ручным способом дать боту поисковика возможность взаимодействия с искомой страницей.

Для решения проблемы необходимо отменить авторизацию или ручным способом дать боту поисковика возможность взаимодействия с искомой страницей. д., и дает вам предложения о том, как вы можете улучшить каждый аспект. твой сайт.

д., и дает вам предложения о том, как вы можете улучшить каждый аспект. твой сайт.

Я заметил одну вещь: API работает лучше для новых страниц, чем для переиндексации. Google может применить это в какой-то момент, но пока все работает нормально. У RankMath есть плагин, который значительно упрощает работу, но требует небольшой настройки.

Я заметил одну вещь: API работает лучше для новых страниц, чем для переиндексации. Google может применить это в какой-то момент, но пока все работает нормально. У RankMath есть плагин, который значительно упрощает работу, но требует небольшой настройки.