Как создать правильный файл robots.txt, настройка, директивы

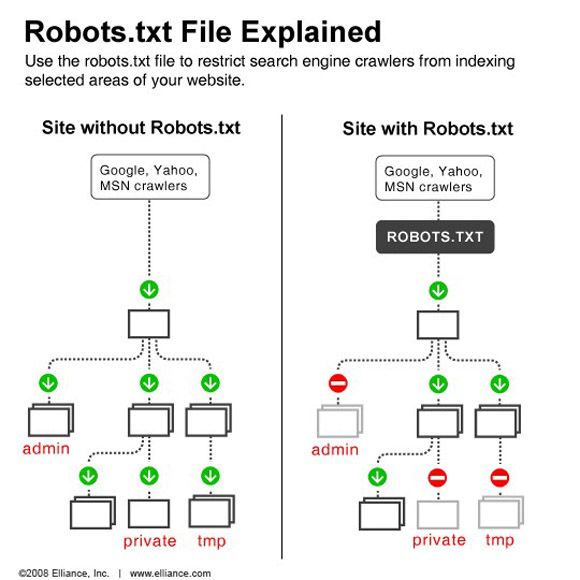

Файл robots.txt — текстовый файл в формате .txt, ограничивающий поисковым роботам доступ к содержимому на http-сервере.

Как определение, Robots.txt — это стандарт исключений для роботов, который был принят консорциумом W3C 30 января 1994 года, и который добровольно использует большинство поисковых систем. Файл robots.txt состоит из набора инструкций для поисковых роботов, которые запрещают индексацию определенных файлов, страниц или каталогов на сайте. Рассмотрим описание robots.txt для случая, когда сайт не ограничивает доступ роботам к сайту.

Простой пример:

User-agent: * Allow: /

Здесь роботс полностью разрешает индексацию всего сайта.

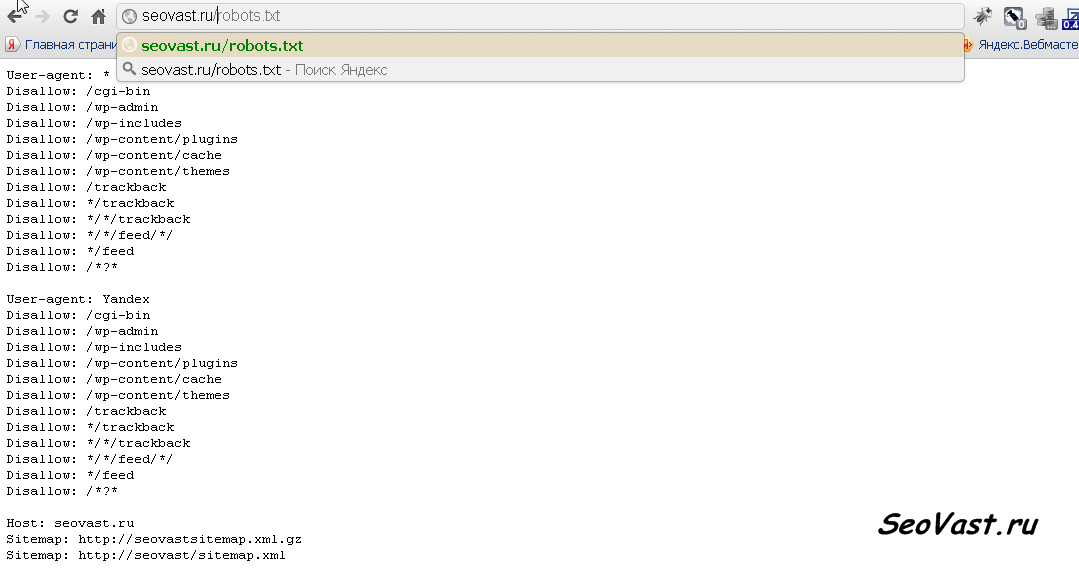

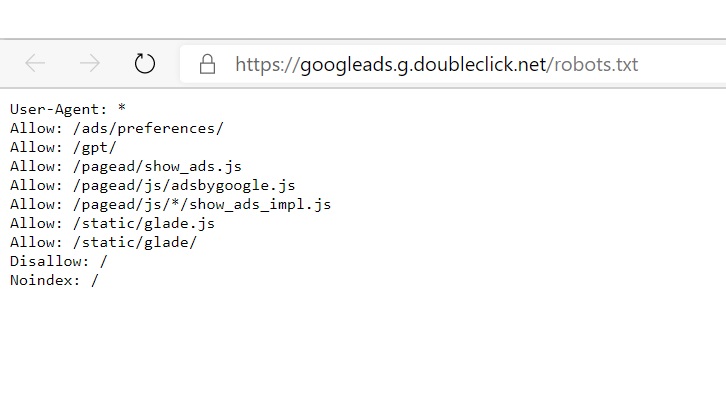

Файл robots.txt необходимо загрузить в корневой каталог вашего сайта, чтобы он был доступен по адресу:

ваш_сайт.ru/robots.txt

Для размещения файла в корне сайта обычно необходим доступ через FTP.

Если файл доступен, то вы увидите содержимое в браузере.

Для чего нужен robots.txt

Сформированный файл для сайта является важным аспектом поисковой оптимизации. Зачем нужен robots.txt? Например, в SEO robots.txt нужен для того, чтобы исключать из индексации страницы, не содержащие полезного контента и многое другое. Как, что, зачем и почему исключается уже было описано в статье про запрет индексации страниц сайта, здесь не будем на этом останавливаться. Нужен ли файл robots.txt всем сайтам? И да и нет. Если использование подразумевает исключение страниц из поиска, то для небольших сайтов с простой структурой и статичными страницами подобные исключения могут быть лишними. Однако, и для небольшого сайта могут быть полезны некоторые директивы, например директива Host или Sitemap, но об этом ниже.

Как создать robots.txt

Поскольку это текстовый файл, нужно воспользоваться любым текстовым редактором, например Блокнотом. Как только вы открыли новый текстовый документ, вы уже начали создание robots.txt, осталось только составить его содержимое, в зависимости от ваших требований, и сохранить в виде текстового файла с названием robots в формате txt. Все просто, и создание файла не должно вызвать проблем даже у новичков. О том, как составить и что писать в роботсе на примерах покажу ниже.

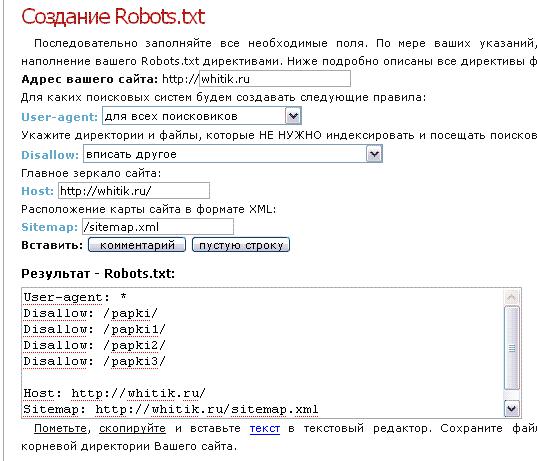

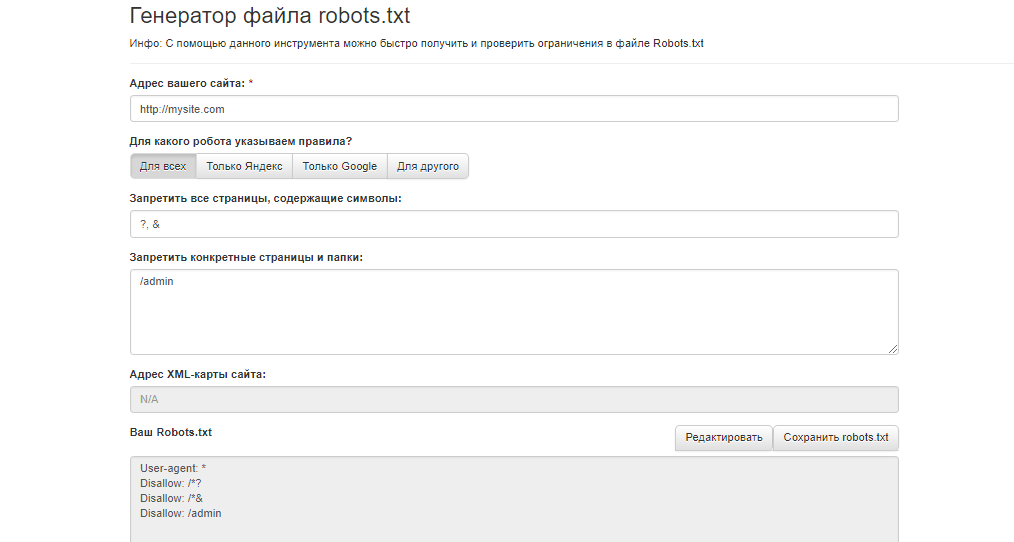

Cоздать robots.txt онлайн

Вариант для ленивых: скачать в уже в готовом виде. Создание robots txt онлайн предлагает множество сервисов, выбор за вами. Главное — четко понимать, что будет запрещено и что разрешено, иначе создание файла robots.txt online может обернуться трагедией, которую потом может быть сложно исправить. Особенно, если в поиск попадет то, что должно было быть закрытым. Будьте внимательны — проверьте свой файл роботс, прежде чем выгружать его на сайт. Все же пользовательский файл robots.txt точнее отражает структуру ограничений, чем тот, что был сгенерирован автоматически и скачан с другого сайта. Читайте дальше, чтобы знать, на что обратить особое внимание при редактировании robots.txt.

Все же пользовательский файл robots.txt точнее отражает структуру ограничений, чем тот, что был сгенерирован автоматически и скачан с другого сайта. Читайте дальше, чтобы знать, на что обратить особое внимание при редактировании robots.txt.

Редактирование robots.txt

После того, как вам удалось создать файл robots.txt онлайн или своими руками, вы можете редактировать robots.txt. Изменить его содержимое можно как угодно, главное — соблюдать некоторые правила и синтаксис robots.txt. В процессе работы над сайтом, файл роботс может меняться, и если вы производите редактирование robots.txt, то не забывайте выгружать на сайте обновленную, актуальную версию файла со всем изменениями. Далее рассмотрим правила настройки файла, чтобы знать, как изменить файл robots.txt и «не нарубить дров».

Правильная настройка robots.txt

Правильная настройка robots.txt позволяет избежать попадания частной информации в результаты поиска крупных поисковых систем. Однако, не стоит забывать, что команды robots.txt не более чем руководство к действию, а не защита. Роботы надежных поисковых систем, вроде Яндекс или Google, следуют инструкциям robots.txt, однако прочие роботы могут легко игнорировать их. Правильное понимание и применение robots.txt — залог получения результата.

Однако, не стоит забывать, что команды robots.txt не более чем руководство к действию, а не защита. Роботы надежных поисковых систем, вроде Яндекс или Google, следуют инструкциям robots.txt, однако прочие роботы могут легко игнорировать их. Правильное понимание и применение robots.txt — залог получения результата.

Чтобы понять, как сделать правильный robots txt, для начала необходимо разобраться с общими правилами, синтаксисом и директивами файла robots.txt.

Правильный robots.txt начинается с директивы User-agent, которая указывает, к какому роботу обращены конкретные директивы.

Примеры User-agent в robots.txt:

# Указывает директивы для всех роботов одновременно User-agent: * # Указывает директивы для всех роботов Яндекса User-agent: Yandex # Указывает директивы для только основного индексирующего робота Яндекса User-agent: YandexBot # Указывает директивы для всех роботов Google User-agent: Googlebot

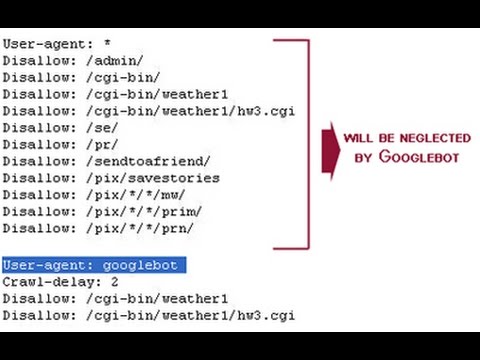

Учитывайте, что подобная настройка файла robots. txt указывает роботу использовать только директивы, соответствующие user-agent с его именем.

txt указывает роботу использовать только директивы, соответствующие user-agent с его именем.

Пример robots.txt с несколькими вхождениями User-agent:

# Будет использована всеми роботами Яндекса User-agent: Yandex Disallow: /*utm_ # Будет использована всеми роботами Google User-agent: Googlebot Disallow: /*utm_ # Будет использована всеми роботами кроме роботов Яндекса и Google User-agent: * Allow: /*utm_

Директива User-agent

Пример неправильного перевода строки в robots. txt:

txt:

User-agent: Yandex Disallow: /*utm_ Allow: /*id= User-agent: * Disallow: /*utm_ Allow: /*id=

Пример правильного перевода строки в robots.txt:

User-agent: Yandex Disallow: /*utm_ Allow: /*id= User-agent: * Disallow: /*utm_ Allow: /*id=

Как видно из примера, указания в robots.txt поступают блоками, каждый из которых содержит указания либо для конкретного робота, либо для всех роботов «*».

Кроме того, важно соблюдать правильный порядок и сортировку команд в robots.txt при совместном использовании директив, например «Disallow» и «Allow». Директива «Allow» — разрешающая директива, является противоположностью команды robots.txt «Disallow» — запрещающей директивы.

Пример совместного использования директив в robots.txt:

User-agent: * Allow: /blog/page Disallow: /blog

Данный пример запрещает всем роботам индексацию всех страниц, начинающихся с «/blog», но разрешает индексации страниц, начинающиеся с «/blog/page».

Прошлый пример robots. txt в правильной сортировке:

txt в правильной сортировке:

User-agent: * Disallow: /blog Allow: /blog/page

Сначала запрещаем весь раздел, потом разрешаем некоторые его части.

Еще один правильный пример robots.txt с совместными директивами:

User-agent: * Allow: / Disallow: /blog Allow: /blog/page

Обратите внимание на правильную последовательность директив в данном robots.txt.

Директивы «Allow» и «Disallow» можно указывать и без параметров, в этом случае значение будет трактоваться обратно параметру «/».

Пример директивы «Disallow/Allow» без параметров:

User-agent: * Disallow: # равнозначно Allow: / Disallow: /blog Allow: /blog/page

Как составить правильный robots.txt и как пользоваться трактовкой директив — ваш выбор. Оба варианта будут правильными. Главное — не запутайтесь.

Для правильного составления robots.txt необходимо точно указывать в параметрах директив приоритеты и то, что будет запрещено для скачивания роботам.

Синтаксис robots.txt

Роботы поисковых систем добровольно следуют командам robots.txt — стандарту исключений для роботов, однако не все поисковые системы трактуют синтаксис robots.txt одинаково. Файл robots.txt имеет строго определённый синтаксис, но в то же время написать robots txt не сложно, так как его структура очень проста и легко понятна.

Вот конкретные список простых правил, следуя которым, вы исключите частые ошибки robots.txt:

- Каждая директива начинается с новой строки;

- Не указывайте больше одной директивы в одной строке;

- Не ставьте пробел в начало строки;

- Параметр директивы должен быть в одну строку;

- Не нужно обрамлять параметры директив в кавычки;

- Параметры директив не требуют закрывающих точки с запятой;

- Команда в robots.

txt указывается в формате — [Имя_директивы]:[необязательный пробел][значение][необязательный пробел];

txt указывается в формате — [Имя_директивы]:[необязательный пробел][значение][необязательный пробел]; - Допускаются комментарии в robots.txt после знака решетки #;

- Пустой перевод строки может трактоваться как окончание директивы User-agent;

- Директива «Disallow: » (с пустым значением) равнозначна «Allow: /» — разрешить все;

- В директивах «Allow», «Disallow» указывается не более одного параметра;

- Название файла robots.txt не допускает наличие заглавных букв, ошибочное написание названия файла — Robots.txt или ROBOTS.TXT;

- Написание названия директив и параметров заглавными буквами считается плохим тоном и если по стандарту, robots.txt и нечувствителен к регистру, часто к нему чувствительны имена файлов и директорий;

- Если параметр директивы является директорией, то перед название директории всегда ставится слеш «/», например: Disallow: /category

- Слишком большие robots.txt (более 32 Кб) считаются полностью разрешающими, равнозначными «Disallow: »;

- Недоступный по каким-либо причинам robots.

txt может трактоваться как полностью разрешающий;

txt может трактоваться как полностью разрешающий; - Если robots.txt пустой, то он будет трактоваться как полностью разрешающий;

- В результате перечисления нескольких директив «User-agent» без пустого перевода строки, все последующие директивы «User-agent», кроме первой, могут быть проигнорированы;

- Использование любых символов национальных алфавитов в robots.txt не допускается.

Поскольку разные поисковые системы могут трактовать синтаксис robots.txt по-разному, некоторые пункты можно опустить. Так например, если прописать несколько директив «User-agent» без пустого перевода строки, все директивы «User-agent» будут восприняты корректно Яндексом, так как Яндекс выделяет записи по наличию в строке «User-agent».

В роботсе должно быть указано строго только то, что нужно, и ничего лишнего. Не думайте, как прописать в robots txt все, что только можно и чем его заполнить. Идеальный robots txt — это тот, в котором меньше строк, но больше смысла..png)

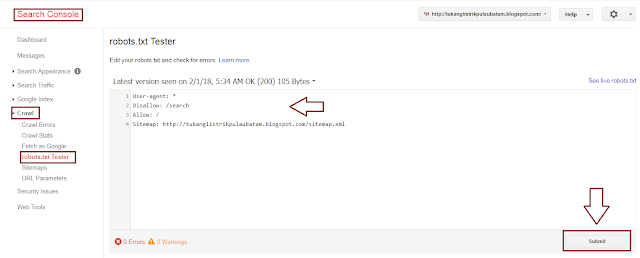

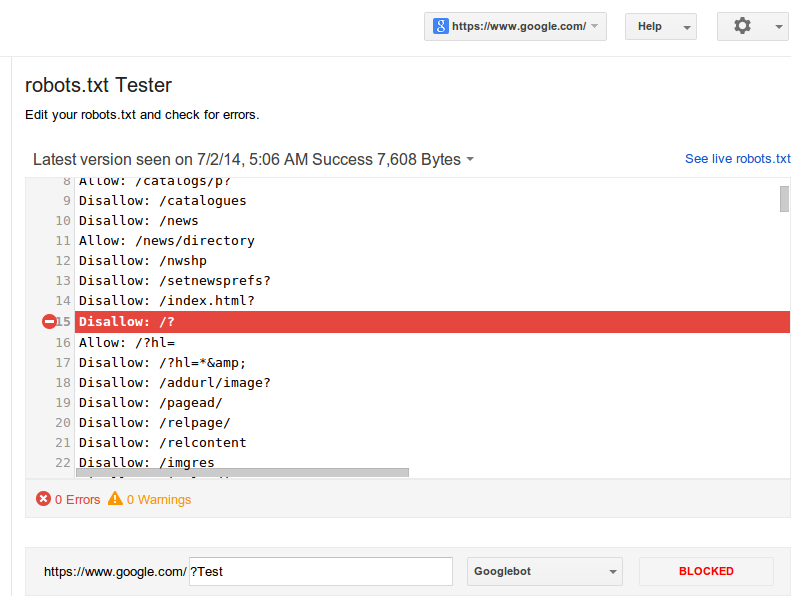

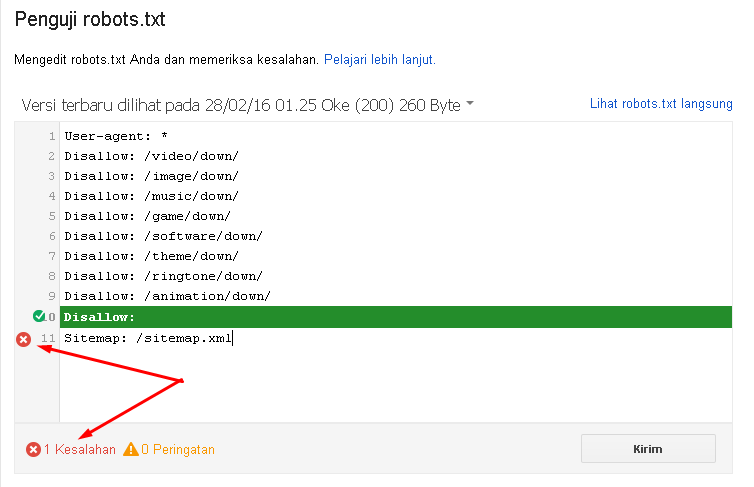

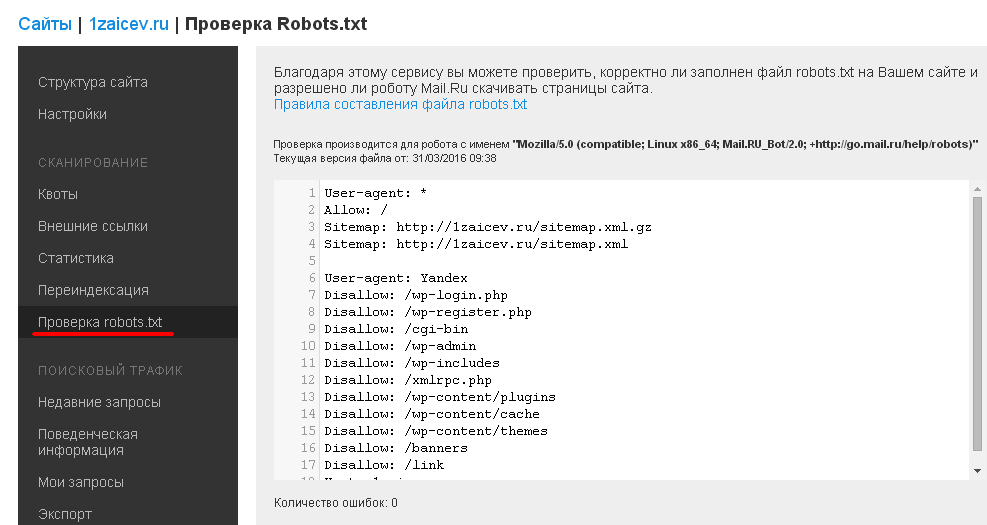

Как проверить robots.txt

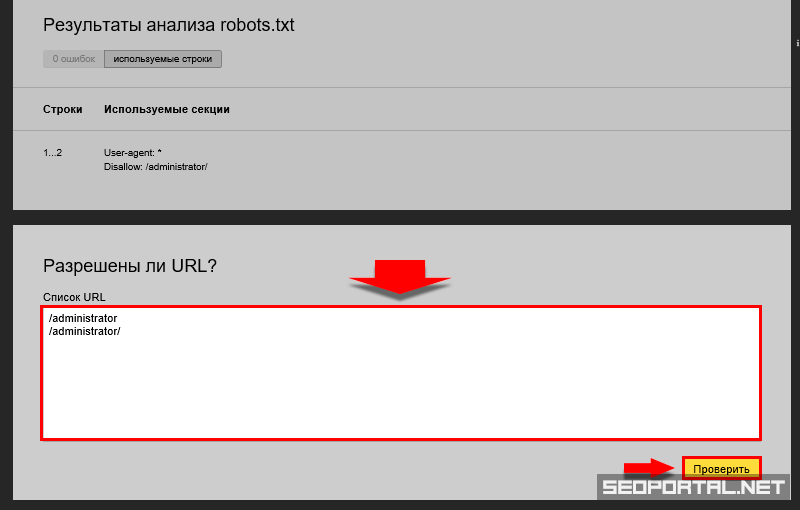

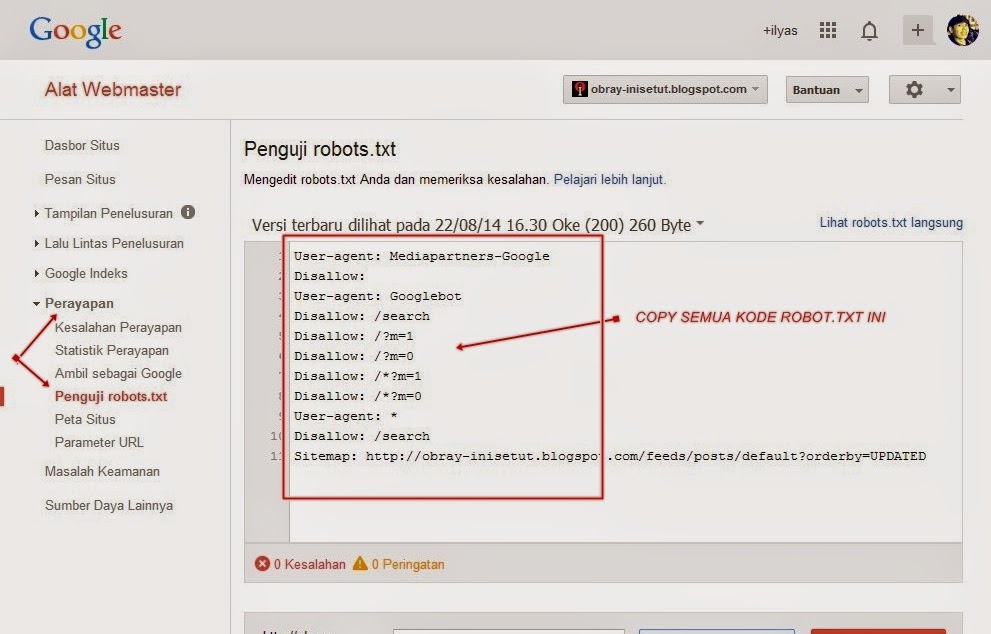

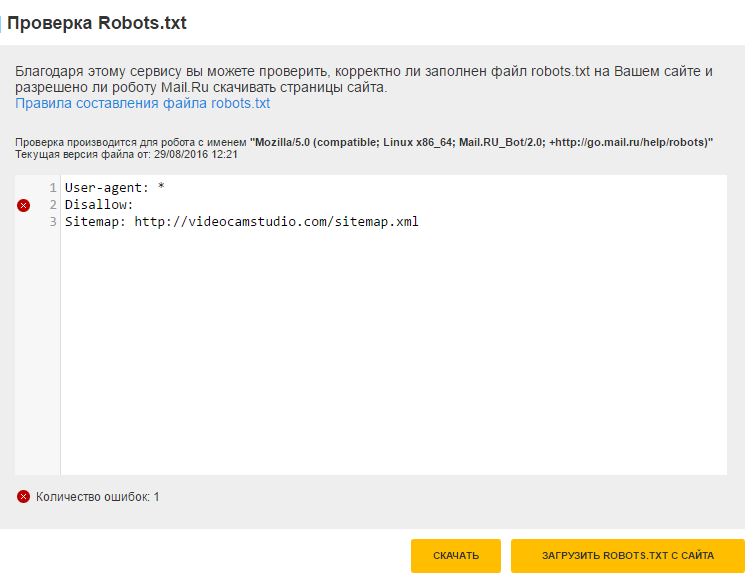

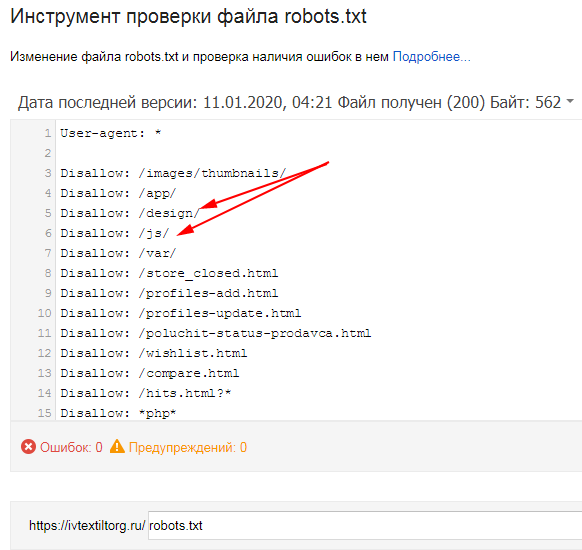

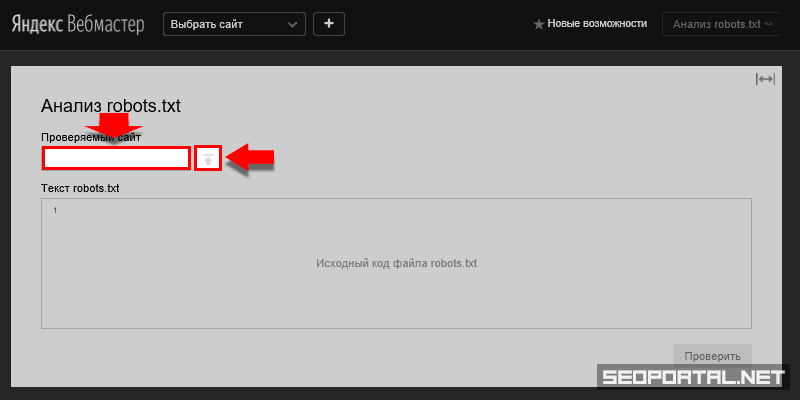

Для того, чтобы проверить robots.txt на корректность синтаксиса и структуры файла, можно воспользоваться одной из онлайн-служб. К примеру, Яндекс и Google предлагают собственные сервисы анализа сайта для вебмастеров, которые включают анализ robots.txt:

Проверка файла robots.txt в Яндекс.Вебмастер: http://webmaster.yandex.ru/robots.xml

Проверка файла robots.txt в Google: https://www.google.com/webmasters/tools/siteoverview?hl=ru

Для того, чтобы проверить robots.txt онлайн необходимо загрузить robots.txt на сайт в корневую директорию. Иначе, сервис может сообщить, что не удалось загрузить robots.txt. Рекомендуется предварительно проверить robots.txt на доступность по адресу где лежит файл, например: ваш_сайт.ru/robots.txt.

Кроме сервисов проверки от Яндекс и Google, существует множество других онлайн валидаторов robots. txt.

txt.

Robots.txt vs Яндекс и Google

Есть субъективное мнение, что указание отдельного блока директив «User-agent: Yandex» в robots.txt Яндекс воспринимает более позитивно, чем общий блок директив с «User-agent: *». Аналогичная ситуация robots.txt и Google. Указание отдельных директив для Яндекс и Google позволяет управлять индексацией сайта через robots.txt. Возможно, им льстит персонально обращение, тем более, что для большинства сайтов содержимое блоков robots.txt Яндекса, Гугла и для других поисковиков будет одинаково. За редким исключением, все блоки «User-agent» будут иметь стандартный для robots.txt набор директив. Так же, используя разные «User-agent» можно установить запрет индексации в robots.txt для Яндекса, но, например не для Google.

Отдельно стоит отметить, что Яндекс учитывает такую важную директиву, как «Host», и правильный robots.txt для яндекса должен включать данную директиву для указания главного зеркала сайта. Подробнее директиву «Host» рассмотрим ниже.

Подробнее директиву «Host» рассмотрим ниже.

Запретить индексацию: robots.txt Disallow

Disallow — запрещающая директива, которая чаще всего используется в файле robots.txt. Disallow запрещает индексацию сайта или его части, в зависимости от пути, указанного в параметре директивы Disallow.

Пример как в robots.txt запретить индексацию сайта:

User-agent: * Disallow: /

Данный пример закрывает от индексации весь сайт для всех роботов.

В параметре директивы Disallow допускается использование специальных символов * и $:

* — любое количество любых символов, например, параметру /page* удовлетворяет /page, /page1, /page-be-cool, /page/kak-skazat и т.д. Однако нет необходимости указывать * в конце каждого параметра, так как например, следующие директивы интерпретируются одинаково:

User-agent: Yandex Disallow: /page

User-agent: Yandex Disallow: /page*

$ — указывает на точное соответствие исключения значению параметра:

User-agent: Googlebot Disallow: /page$

В данном случае, директива Disallow будет запрещать /page, но не будет запрещать индексацию страницы /page1, /page-be-cool или /page/kak-skazat.

Если закрыть индексацию сайта robots.txt, в поисковые системы могут отреагировать на так ход ошибкой «Заблокировано в файле robots.txt» или «url restricted by robots.txt» (url запрещенный файлом robots.txt). Если вам нужно запретить индексацию страницы, можно воспользоваться не только robots txt, но и аналогичными html-тегами:

- <meta name=»robots» content=»noindex»/> — не индексировать содержимое страницы;

- <meta name=»robots» content=»nofollow»/> — не переходить по ссылкам на странице;

- <meta name=»robots» content=»none»/> — запрещено индексировать содержимое и переходить по ссылкам на странице;

- <meta name=»robots» content=»noindex, nofollow»/> — аналогично content=»none».

Разрешить индексацию: robots.txt Allow

Allow — разрешающая директива и противоположность директиве Disallow. Эта директива имеет синтаксис, сходный с Disallow.

Пример, как в robots. txt запретить индексацию сайта кроме некоторых страниц:

txt запретить индексацию сайта кроме некоторых страниц:

User-agent: * Disallow: / Allow: /page

Запрещается индексировать весь сайт, кроме страниц, начинающихся с /page.

Disallow и Allow с пустым значением параметра

Пустая директива Disallow:

User-agent: * Disallow:

Не запрещать ничего или разрешить индексацию всего сайта и равнозначна:

User-agent: * Allow: /

Пустая директива Allow:

User-agent: * Allow:

Разрешить ничего или полный запрет индексации сайта, равнозначно:

User-agent: * Disallow: /

Главное зеркало сайта: robots.txt Host

Директива Host служит для указания роботу Яндекса главного зеркала Вашего сайта. Из всех популярных поисковых систем, директива Host распознаётся только роботами Яндекса. Директива Host полезна в том случае, если ваш сайт доступен по нескольким доменам, например:

mysite.ru mysite.com

Или для определения приоритета между:

mysite.ru www.mysite.ru

Роботу Яндекса можно указать, какое зеркало является главным. Директива Host указывается в блоке директивы «User-agent: Yandex» и в качестве параметра, указывается предпочтительный адрес сайта без «http://».

Пример robots.txt с указанием главного зеркала:

User-agent: Yandex Disallow: /page Host: mysite.ru

В качестве главного зеркала указывается доменное имя mysite.ru без www. Таки образом, в результатах поиска буде указан именно такой вид адреса.

User-agent: Yandex Disallow: /page Host: www.mysite.ru

В качестве основного зеркала указывается доменное имя www.mysite.ru.

Директива Host в файле robots.txt может быть использована только один раз, если же директива Хост будет указана более одного раза, учитываться будет только первая, прочие директивы Host будут игнорироваться.

Если вы хотите указать главное зеркало для робота Google, воспользуйтесь сервисом Google Инструменты для вебмастеров.

Карта сайта: robots.

txt sitemap

txt sitemapПри помощи директивы Sitemap, в robots.txt можно указать расположение на сайте файла карты сайта sitemap.xml.

Пример robots.txt с указанием адреса карты сайта:

User-agent: * Disallow: /page Sitemap: http://www.mysite.ru/sitemap.xml

Указание адреса карты сайта через директиву Sitemap в robots.txt позволяет поисковому роботу узнать о наличии карты сайта и начать ее индексацию.

Директива Clean-param

Директива Clean-param позволяет исключить из индексации страницы с динамическими параметрами. Подобные страницы могут отдавать одинаковое содержимое, имея различные URL страницы. Проще говоря, будто страница доступна по разным адресам. Наша задача убрать все лишние динамические адреса, которых может быть миллион. Для этого исключаем все динамические параметры, используя в robots.txt директиву Clean-param.

Синтаксис директивы Clean-param:

Clean-param: parm1[&parm2&parm3&parm4&..&parmn] [Путь]

Рассмотрим на примере страницы со следующим URL:

www.mysite.ru/page.html?&parm1=1&parm2=2&parm3=3

Пример robots.txt Clean-param:

Clean-param: parm1&parm2&parm3 /page.html # только для page.html

или

Clean-param: parm1&parm2&parm3 / # для всех

Директива Crawl-delay

Данная инструкция позволяет снизить нагрузку на сервер, если роботы слишком часто заходят на ваш сайт. Данная директива актуальна в основном для сайтов с большим объемом страниц.

Пример robots.txt Crawl-delay:

User-agent: Yandex Disallow: /page Crawl-delay: 3

В данном случае мы «просим» роботов яндекса скачивать страницы нашего сайта не чаще, чем один раз в три секунды. Некоторые поисковые системы поддерживают формат дробных чисел в качестве параметра директивы Crawl-delay robots.txt.

Комментарии в robots.txt

Комментарий в robots.txt начинаются с символа решетки — #, действует до конца текущей строки и игнорируются роботами.

Примеры комментариев в robots.txt:

User-agent: * # Комментарий может идти от начала строки Disallow: /page # А может быть продолжением строки с директивой # Роботы # игнорируют # комментарии Host: www.mysite.ru

В заключении

Файл robots.txt — очень важный и нужный инструмент взаимодействия с поисковыми роботами и один из важнейших инструментов SEO, так как позволяет напрямую влиять на индексацию сайта. Используйте роботс правильно и с умом.

Если у вас есть вопросы — пишите в комментариях.

Рекомендуйте статью друзьям и не забывайте подписываться на блог.

Новые интересные статьи каждый день.

Как создать и правильно настроить файла robots.txt для индексации сайта

Привет, я руководитель SEO-отдела в компании TRINET.Group. Если на сайте падает трафик, возможно, запрещена индексация для поисковых систем. Причина в файле robots.txt. Если вовремя обнаружить проблему и настроить его работу правильно, индексация веб-страниц восстановится.

В этом видео я рассказываю, как robots.txt влияет на индексацию

В этой статье рассмотрим:

Что такое robots.txt?

Как его правильно настроить?

Какие сервисы использовать для проверок robots.txt?

Почему не стоит запрещать пагинацию?

Что такое robots.txt

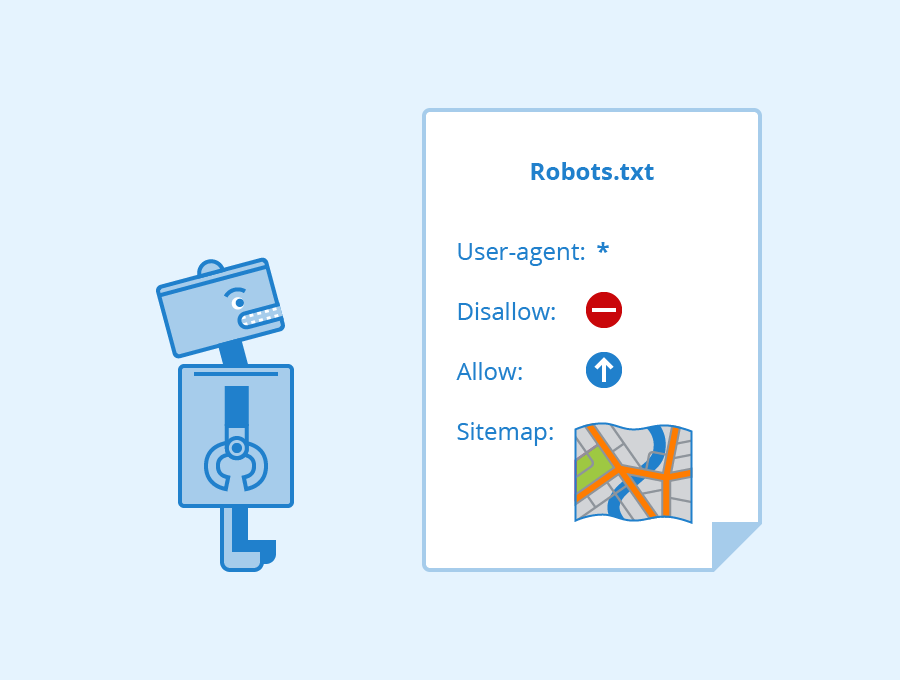

Справка: robots.txt — это файл в корневом каталоге, который отвечает за то, чтобы сайт был открыт для индексации и сканирования страницы или ее элементов поисковыми системами.

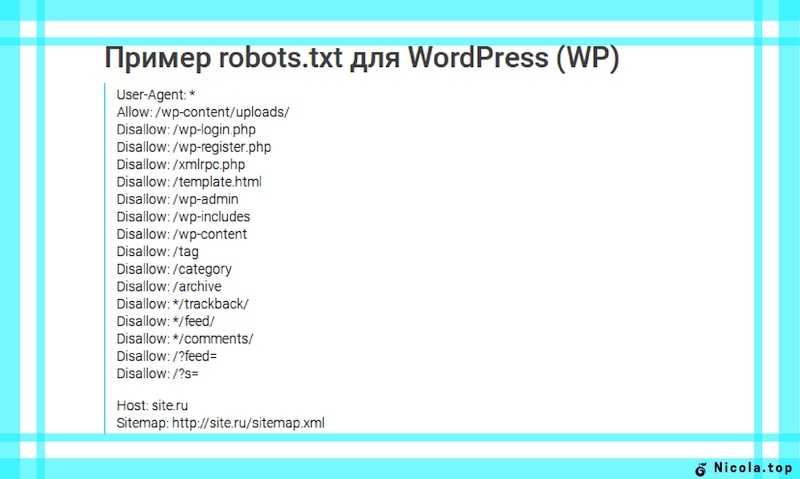

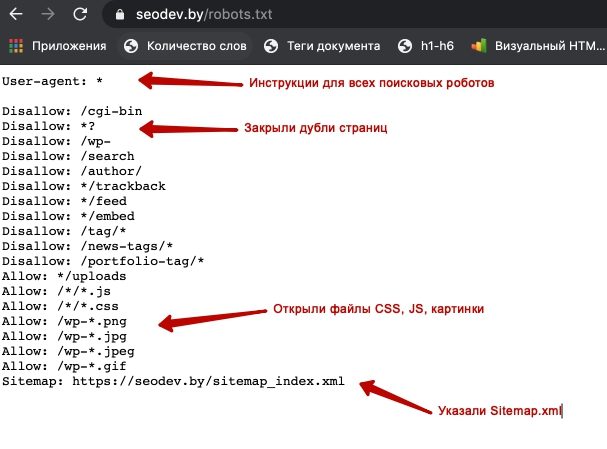

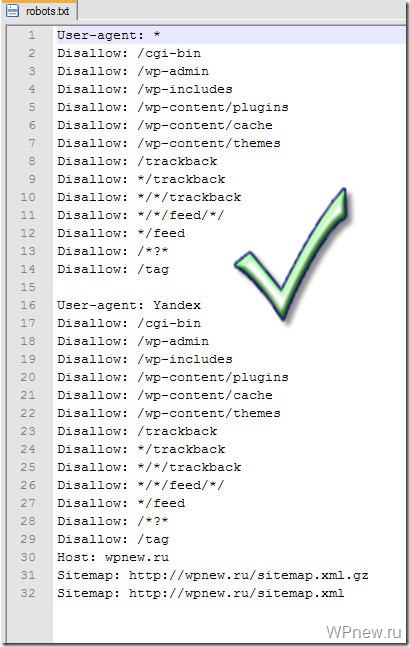

Пример файла robots.txt

Прежде чем зайти на сайт, поисковая система обращается к файлу robots.txt и индексирует директивы — правила, которые запрещают индексацию страниц. Например, указан «User-agent» — обязательная директива, где указано, для какого робота указаны правила. Если стоит «*» (звездочка), это означает руководство для всех роботов. Можно создать персональные правила для ботов Яндекса (User-agent: Yandex) или Google (User-agent: Googlebot).

Например, указан «User-agent» — обязательная директива, где указано, для какого робота указаны правила. Если стоит «*» (звездочка), это означает руководство для всех роботов. Можно создать персональные правила для ботов Яндекса (User-agent: Yandex) или Google (User-agent: Googlebot).

Читайте также: Разница SEO-продвижения в «Яндекс» и Google: почему отличаются позиции в поисковиках

Файл передает один из трех вариантов разрешений:

Частичный допуск — сканирование отдельных элементов. Запрещает индексацию данных, которые нельзя допускать в выдачу — формы с личными данными пользователей, дублированные страницы, неуникальные изображения и др.

Полный доступ — разрешено сканировать все.

Полный запрет — нельзя сканировать ничего. Часто такое ограничение применяется при размещении нового сайта, чтобы он был закрыт для посещения, пока ведется его разработка, наполнение и проверка работы.

Часто разработчики при запуске нового сайта забывают обновить этот файл и открыть сайт для индексации. И почему-то делают это по пятницам, не предупреждая никого. Таким образом, страницы нового сайта автоматически будут закрыты на выходные, трафик и продажи упадут. Страницы могут вылетать из индекса — обычно до 2 недель.

Если это быстро заметить, после исправления robots.txt индексация восстановится и позиции могут вернуться обратно. Если до открытия индексации пройдет больше недели, могут быть более негативные последствия.

Читайте также: SEO-специалист: кто это, его задачи, умения и навыки

Файл robots.txt необходим, и его важно корректно настраивать. Например, вам не нужно, чтобы поисковая система просканировала какие-то дублированные изображения или вы хотите скрыть от посетителей раздел, предназначенный только для сотрудников.

Главное предназначение robots. txt в SEO — закрытие дублей. Например, есть технические дубли страниц сортировки, фильтрации, UTM-метки, которые генерирует система управления сайтом CMS. От таких страниц в индексе необходимо избавиться, закрыть их от индексации.

txt в SEO — закрытие дублей. Например, есть технические дубли страниц сортировки, фильтрации, UTM-метки, которые генерирует система управления сайтом CMS. От таких страниц в индексе необходимо избавиться, закрыть их от индексации.

Как создать robots.txt и настроить его работу

Это обычный текстовый файл, который создается в блокноте. Указываются User-agent с помощью значка «звездочка» и ниже прописываются правила.

Существует несколько способов, как создать robots.txt:

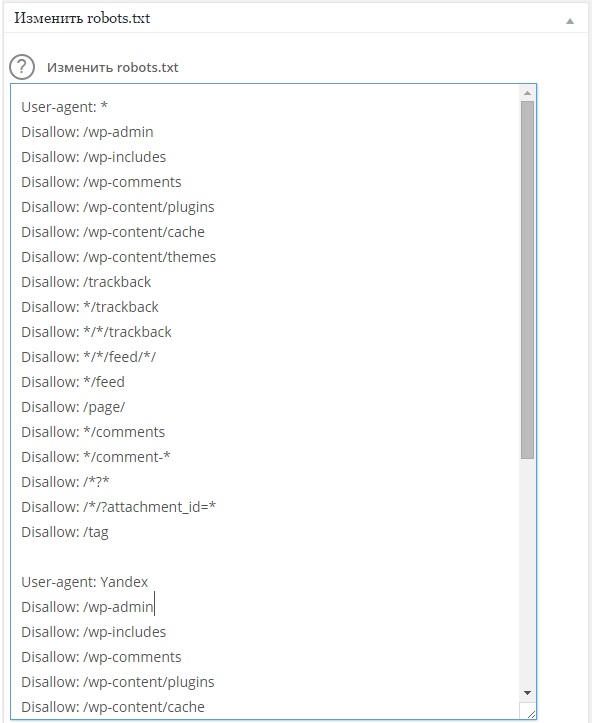

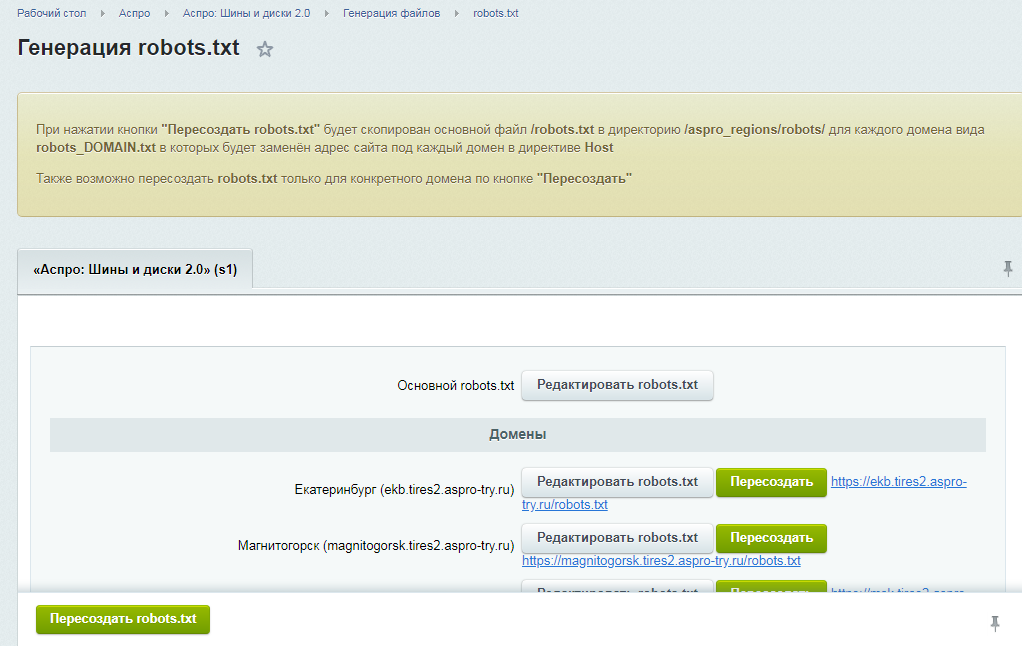

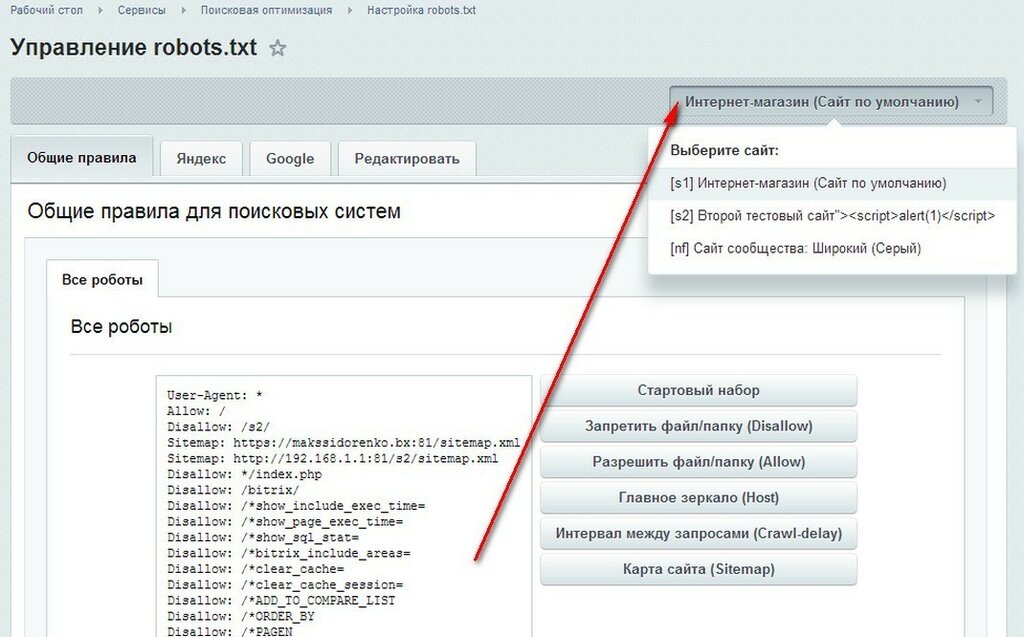

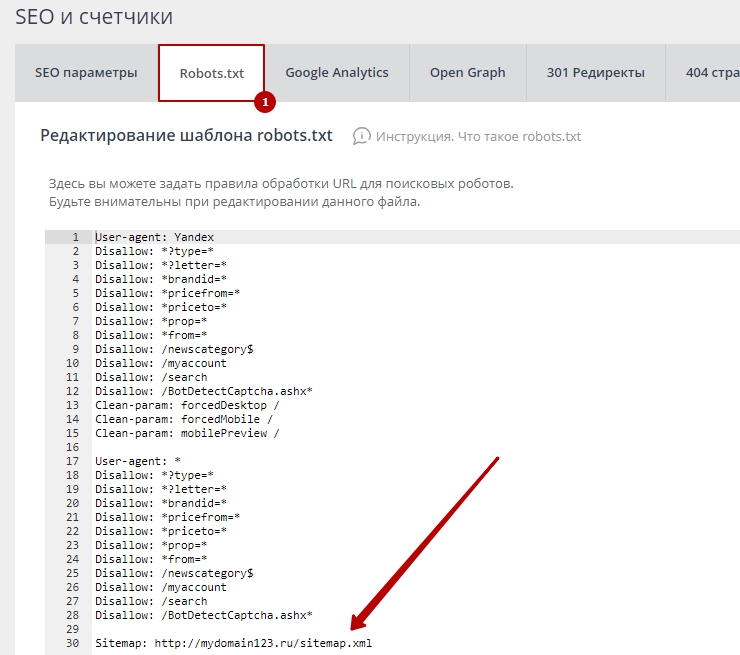

Самый простой метод — посмотреть стандартные правила для CMS сайта. Обычно туда включены рекомендации, что именно нужно закрыть от индексации. Эту информацию можно найти в интернете, например для Bitrix или WordPress. С помощью специальных плагинов и модулей редактирование возможно даже с административной панели CMS.

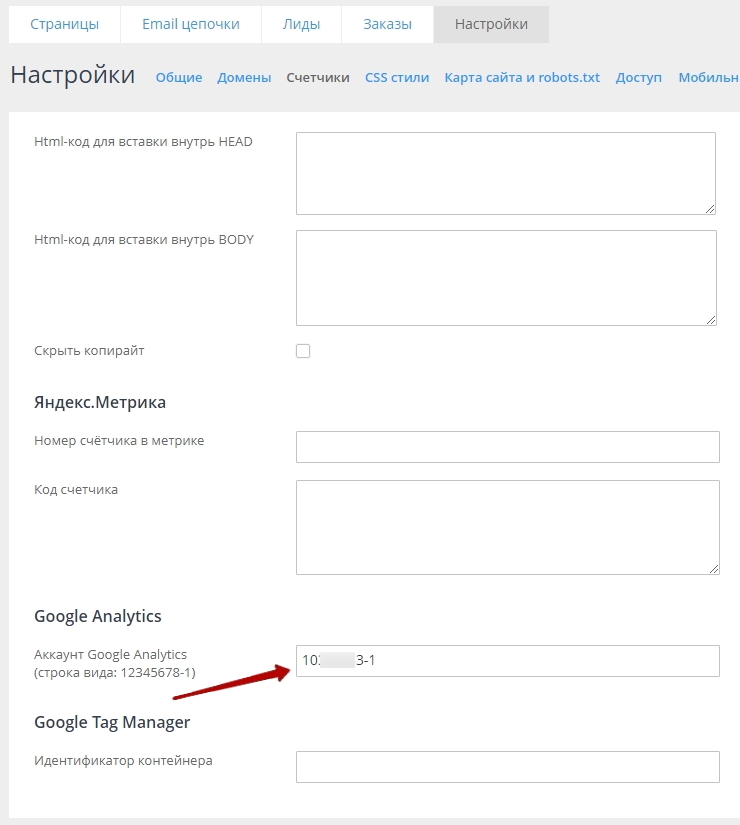

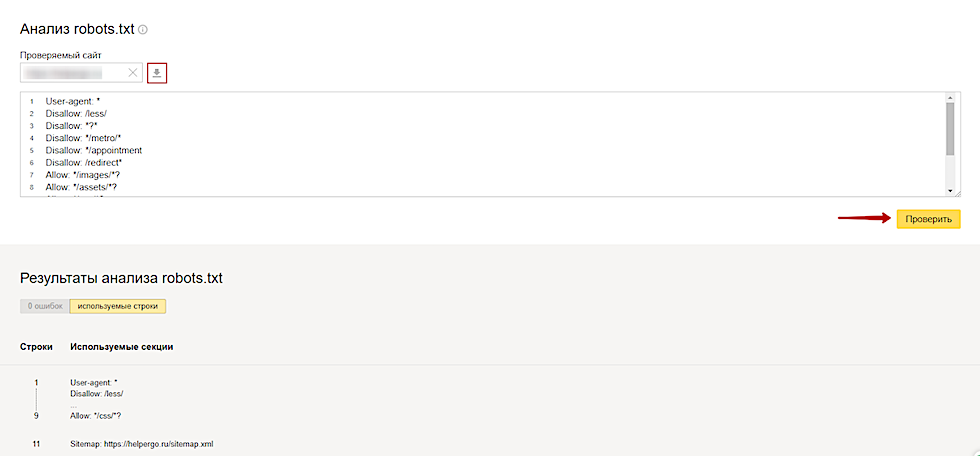

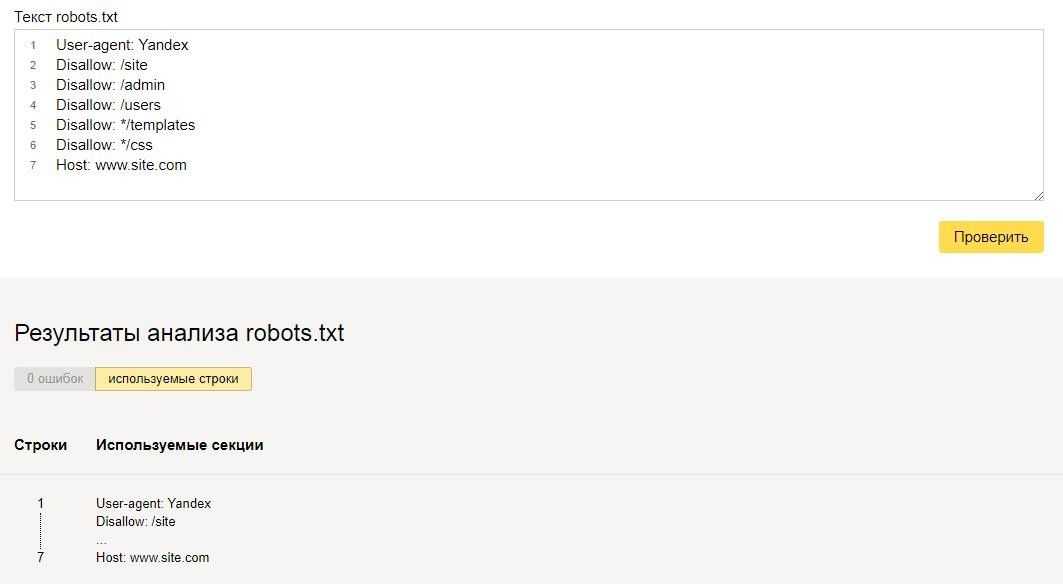

Инструменты в Яндекс.Вебмастер и в Google Search Console позволят вам осуществить проверку ваших директив, чтобы избежать ошибок.

Если сайт новый, за исходник можно взять стандарт и потом проверить в инструментах через валидатор.

Он сканирует robots.txt на содержание ошибок. В него можно добавить страницу сайта и посмотреть, какие элементы открыты, а какие закрыты.

Он сканирует robots.txt на содержание ошибок. В него можно добавить страницу сайта и посмотреть, какие элементы открыты, а какие закрыты.

Справка: Файл robots.txt создается через блокнот и сохраняется в формате «.txt». Учитывайте ограничение по размеру до 32 Кб на индексацию поисковой системой Яндекс.

Для формирования файла в CMS есть свои плагины. Классический вариант размещения — публикация через файловый менеджер или FTP-соединение с перезаписыванием файла. Обязательно проверьте результат. Возможно кэширование результатов — в таком случае обновите кэш браузера. Если хочется внедрить изменения и узнать, как будет работать страница, закроется ли она от индексации, не запретили ли лишнего, используйте сервисы проверки от Яндекса.

Читайте также: Актуальный сборник статей по SEO 2021 — статьи о продвижении и оптимизации сайтов

Основные директивы robots.

txt

txtИнструкции для поисковых роботов указываются с помощью символов и текста. Важно разобраться, какие директивы за что отвечают. Есть стандартные формулировки правил. Вот несколько примеров директив:

Disallow — запрет сканирования. Ставится двоеточие и внутри знаков «/» пишется название раздела, который нельзя сканировать. Disallow: /admin/ — будет запрещена индексация содержимого указанного раздела.

Allow — разрешающая директива. По умолчанию все, что не запрещено, то разрешено.

«$» — указывает на конец строки, например Disallow: /poly/$, папку индексировать нельзя, а ее содержимое можно.

Sitemap — указывает путь к карте сайта для ускорения индексации.

C помощью специальных платных программ можно удобно изучать каждую страницу на предмет доступности для индексации.

Пример проверки в Яндекс Вебмастер

Screaming Frog.

Netpeak Spider.

Почему не стоит запрещать пагинацию

Справка: пагинация — это разделение контента на сайте на отдельные страницы. Часто применяется в каталогах интернет-магазинов.

Пример страниц пагинации

Например, в одном из листингов представлены кольца — 1000 видов. Если разместить все в одном разделе, скорость загрузки страницы будет крайне низкой. Чтобы не выводить 1000 позиций в одном листинге, его разбивают на подстраницы для удобства клиентов и поисковых роботов.

Мы не рекомендуем закрывать пагинацию от поисковых роботов, чтобы ссылки на товары появлялись в выдаче и разделы сайта быстро индексировались. Поисковые системы должны просканировать все товары и узнать обо всем ассортименте.

Если правильно настраивать robots.txt и проверять его настройки, проблем с индексацией из-за этого файла не возникнет. Если обнаружены неполадки, рекомендуем обратиться к специалистам либо разобраться в вопросе самостоятельно.

Workspace.LIVE — мы в Телеграме

Новости в мире диджитал, ответы экспертов на злободневные темы, опросы, статьи и многое другое. Подписывайтесь: https://t.me/workspace

Как составить robots.txt самостоятельно

Как правильно составить robots.txt и зачем он нужен, как закрыть индексацию через robots.txt и бесплатно проверить robots.txt с помощью онлайн-инструментов.

Как поисковики сканируют страницу

Роботы-краулеры Яндекса и Google посещают страницы сайта, оценивают содержимое, добавляют новые ресурсы и информацию о страницах в индексную базу поисковика. Боты посещают страницы регулярно, чтобы переносить в базу обновления контента, отмечать появление новых ссылок и их доступность.

Зачем нужно сканирование:

- Собрать данные для построения индекса — информацию о новых страницах и обновлениях на старых.

- Сравнить URL в индексе и в списке для сканирования.

- Убрать из очереди дублирующиеся URL, чтобы не скачивать их дважды.

Боты смотрят не все страницы сайта. Количество ограничено краулинговым бюджетом, который складывается из количества URL, которое может просканировать бот-краулер. Бюджета на объемный сайт может не хватить. Есть риск, что краулинговый бюджет уйдет на сканирование неважных или «мусорных» страниц, а чтобы такого не произошло, веб-мастеры направляют краулеров с помощью файла robots.txt.

Боты переходят на сайт и находят в корневом каталоге файл robots.txt, анализируют доступ к страницам и переходят к карте сайта —

Sitemap, чтобы сократить время сканирования, не обращаясь к закрытым ссылкам. После изучения файла боты идут на главную страницу и оттуда переходят в глубину сайта.

Как узнать, попала ли страница сайта в индекс Яндекса или Google

Какие страницы краулер просканирует быстрее:

- Находятся ближе к главной.

Чем меньше кликов с главной ведет до страницы, тем она важнее и тем вероятнее ее посетит краулер. Количество переходов от главной до текущей страницы называется Click Distance from Index (DFI). - Имеют много ссылок.

Если многие ссылаются на страницу, значит она полезная и имеет хорошую репутацию. Нормальным считается около 11-20 ссылок на страницу, перелинковка между своими материалами тоже считается. - Быстро загружаются.

Проверьте скорость загрузки инструментом, если она медленная — оптимизируйте код верхней части и уменьшите вес страницы.

Все посещения ботов-краулеров не фиксируют такие инструменты, как Google Analytics, но поведение ботов можно отследить в лог-файлах. Некоторые SEO-проблемы крупных сайтов можно решить с помощью

анализа лог-файлов который также поможет увидеть проблемы со ссылками и распределение краулингового бюджета.

Посмотреть на сайт глазами поискового бота

Robots.txt для Яндекса и Google

Веб-мастеры могут управлять поведением ботов-краулеров на сайте с помощью файла robots.txt. Robots.txt — это текстовый файл для роботов поисковых систем с указаниями по индексированию. В нем написано какие страницы и файлы на сайте нельзя сканировать, что позволяет ботам уменьшить количество запросов к серверу и не тратить время на неинформативные, одинаковые и неважные страницы.

В robots.txt можно открыть или закрыть доступ ко всем файлам или отдельно прописать, какие файлы можно сканировать, а какие нет.

Требования к robots.txt:

- файл называется «robots.txt«, название написано только строчными буквами, «Robots.TXT» и другие вариации не поддерживаются;

- располагается только в корневом каталоге — https://site.com/robots.txt, в подкаталоге быть не может;

- на сайте в единственном экземпляре;

- имеет формат .

txt;

txt; - весит до 32 КБ;

- в ответ на запрос отдает HTTP-код со статусом 200 ОК;

- каждый префикс URL на отдельной строке;

- содержит только латиницу.

Если домен на кириллице, для robots.txt переведите все кириллические ссылки в Punycode с помощью любого Punycode-конвертера: «сайт.рф» — «xn--80aswg.xn--p1ai».

Robots.txt действует для HTTP, HTTPS и FTP, имеет кодировку UTF-8 или ASCII и направлен только в отношении хоста, протокола и номера порта, где находится.

Его можно добавлять к адресам с субдоменами —

http://web.site.com/robots.txt или нестандартными портами — http://site.com:8181/robots.txt. Если у сайта несколько поддоменов, поместите файл в корневой каталог каждого из них.

Как исключить страницы из индексации с помощью robots.txt

В файле robots.txt можно запретить ботам индексацию некоторого контента.

Яндекс поддерживает

стандарт исключений для роботов (Robots Exclusion Protocol). Веб-мастер может скрыть содержимое от индексирования ботами Яндекса, указав директиву «disallow». Тогда при очередном посещении сайта робот загрузит файл robots.txt, увидит запрет и проигнорирует страницу. Другой вариант убрать страницу из индекса — прописать в HTML-коде мета-тег «noindex» или «none».

Веб-мастер может скрыть содержимое от индексирования ботами Яндекса, указав директиву «disallow». Тогда при очередном посещении сайта робот загрузит файл robots.txt, увидит запрет и проигнорирует страницу. Другой вариант убрать страницу из индекса — прописать в HTML-коде мета-тег «noindex» или «none».

Google предупреждает, что robots.txt не предусмотрен для блокировки показа страниц в результатах выдачи. Он позволяет запретить индексирование только некоторых типов контента: медиафайлов, неинформативных изображений, скриптов или стилей. Исключить страницу из выдачи Google можно с помощью пароля на сервере или элементов HTML — «noindex» или атрибута «rel» со значением «nofollow».

Если на этом или другом сайте есть ссылка на страницу, то она может оказаться в индексе, даже если к ней закрыт доступ в файле robots.txt.

Закройте доступ к странице паролем или «nofollow» , если не хотите, чтобы она попала в выдачу Google. Если этого не сделать, ссылка попадет в результаты но будет выглядеть так:

Такой вид ссылки означает, что страница доступна пользователям, но бот не может составить описание, потому что доступ к ней заблокирован в robots. txt.

txt.

Содержимое файла robots.txt — это указания, а не команды. Большинство поисковых ботов, включая Googlebot, воспринимают файл, но некоторые системы могут его проигнорировать.

Если нет доступа к robots.txt

Если вы не имеете доступа к robots.txt и не знаете, доступна ли страница в Google или Яндекс, введите ее URL в строку поиска.

На некоторых сторонних платформах управлять файлом robots.txt нельзя. К примеру, сервис Wix автоматически создает robots.txt для каждого проекта на платформе. Вы сможете посмотреть файл, если добавите в конец домена «/robots.txt».

В файле будут элементы, которые относятся к структуре сайтов на этой платформе, к примеру «noflashhtml» и «backhtml». Они не индексируются и никак не влияют на SEO.

Если нужно удалить из выдачи какие-то из страниц ресурса на Wix, используйте «noindex».

Как составить robots.txt правильно

Файл можно составить в любом текстовом редакторе и сохранить в формате txt. В нем нужно прописать инструкцию для роботов: указание, каким роботам реагировать, и разрешение или запрет на сканирование файлов.

В нем нужно прописать инструкцию для роботов: указание, каким роботам реагировать, и разрешение или запрет на сканирование файлов.

Инструкции отделяют друг от друга переносом строки.

Символы robots.txt

«*» — означает любую последовательность символов в файле.

«$» — ограничивает действия «*», представляет конец строки.

«/» — показывает, что закрывают для сканирования.

«/catalog/» — закрывают раздел каталога;

«/catalog» — закрывают все ссылки, которые начинаются с «/catalog».

«#» — используют для комментариев, боты игнорируют текст с этим символом.

User-agent: * Disallow: /catalog/ #запрещаем сканировать каталог

Директивы robots.txt

Директивы, которые распознают все краулеры:

User-agent

На первой строчке прописывают правило User-agent — указание того, какой робот должен реагировать на рекомендации. Если запрещающего правила нет, считается, что доступ к файлам открыт.

Если запрещающего правила нет, считается, что доступ к файлам открыт.

Для разного типа контента поисковики используют разных ботов:

- Google: основной поисковый бот называется Googlebot, есть Googlebot News для новостей, отдельно Googlebot Images, Googlebot Video и другие;

- Яндекс: основной бот называется YandexBot, есть YandexDirect для РСЯ, YandexImages, YandexCalendar, YandexNews, YandexMedia для мультимедиа, YandexMarket для Яндекс.Маркета и другие.

Для отдельных ботов можно указать свою директиву, если есть необходимость в рекомендациях по типу контента.

User-agent: * — правило для всех поисковых роботов;

User-agent: Googlebot — только для основного поискового бота Google;

User-agent: YandexBot — только для основного бота Яндекса;

User-agent: Yandex — для всех ботов Яндекса. Если любой из ботов Яндекса обнаружит эту строку, то другие правила User-agent: * учитывать не будет.

Sitemap

Указывает ссылку на карту сайта — файл со структурой сайта, в котором перечислены страницы для индексации:

User-agent: * Sitemap: http://site.com/sitemap.xml

Некоторые веб-мастеры не делают карты сайтов, это не обязательное требование, но лучше составить Sitemap — этот файл краулеры воспринимают как структуру страниц, которые не можно, а нужно индексировать.

Disallow

Правило показывает, какую информацию ботам сканировать не нужно.

Если вы еще работаете над сайтом и не хотите, чтобы он появился в незавершенном виде, можно закрыть от сканирования весь сайт:

User-agent: * Disallow: /

После окончания работы над сайтом не забудьте снять блокировку.

Разрешить всем ботам сканировать весь сайт:

User-agent: * Disallow:

Для этой цели можно оставить robots. txt пустым.

txt пустым.

Чтобы запретить одному боту сканировать, нужно только прописать запрет с упоминанием конкретного бота. Для остальных разрешение не нужно, оно идет по умолчанию:

User-agent: BadBot Disallow: /

Чтобы разрешить одному боту сканировать сайт, нужно прописать разрешение для одного и запрет для остальных:

User-agent: Googlebot Disallow: User-agent: * Disallow: /

Запретить ботам сканировать страницу:

User-agent: * Disallow: /page.html

Запретить сканировать конкретную папку с файлами:

User-agent: * Disallow: /name/

Запретить сканировать все файлы, которые заканчиваются на «.pdf»:

User-agent: * Disallow: /*.pdf$

Запретить сканировать раздел http://site.com/about/:

User-agent: * Disallow: /about/

Запись формата «Disallow: /about» без закрывающего «/» запретит доступ и к разделу

http://site. com/about/, к файлу http://site.com/about.php и к другим ссылкам, которые начинаются с «/about».

com/about/, к файлу http://site.com/about.php и к другим ссылкам, которые начинаются с «/about».

Если нужно запретить доступ к нескольким разделам или папкам, для каждого нужна отдельная строка с Disallow:

User-agent: * Disallow: /about Disallow: /info Disallow: /album1

Allow

Директива определяет те пути, которые доступны для указанных поисковых ботов. По сути, это Disallow-наоборот — директива, разрешающая сканирование. Для роботов действует правило: что не запрещено, то разрешено, но иногда нужно разрешить доступ к какому-то файлу и закрыть остальную информацию.

Разрешено сканировать все, что начинается с «/catalog», а все остальное запрещено:

User-agent: * Allow: /catalog Disallow: /

Сканировать файл «photo.html» разрешено, а всю остальную информацию в каталоге /album1/ запрещено:

User-agent: * Allow: /album1/photo.html Disallow: /album1/

Заблокировать доступ к каталогам «site. com/catalog1/» и «site.com/catalog2/» но разрешить к «catalog2/subcatalog1/»:

com/catalog1/» и «site.com/catalog2/» но разрешить к «catalog2/subcatalog1/»:

User-agent: * Disallow: /catalog1/ Disallow: /catalog2/ Allow: /catalog2/subcatalog1/

Бывает, что для страницы оказываются справедливыми несколько правил. Тогда робот будет отсортирует список от меньшего к большему по длине префикса URL и будет следовать последнему правилу в списке.

Директивы, которые распознают боты Яндекса:

Clean-param

Некоторые страницы дублируются с разными GET-параметрами или UTM-метками, которые не влияют на содержимое. К примеру, если в каталоге товаров использовали сортировку или разные id.

Чтобы отследить, с какого ресурса делали запрос страницы с книгой book_id=123, используют ref:

«www.site. com/some_dir/get_book.pl?ref=site_1& book_id=123″

«www.site. com/some_dir/get_book.pl?ref=site_2& book_id=123″

«www. site. com/some_dir/get_book.pl?ref=site_3& book_id=123″

site. com/some_dir/get_book.pl?ref=site_3& book_id=123″

Страница с книгой одна и та же, содержимое не меняется. Чтобы бот не сканировал все варианты таких страниц с разными параметрами, используют правило Clean-param:

User-agent: Yandex Disallow: Clean-param: ref/some_dir/get_book.pl

Робот Яндекса сведет все адреса страницы к одному виду:

«www.example. com/some_dir/get_book.pl? book_id=123″

Для адресов вида:

«www.example2. com/index.php? page=1&sid=2564126ebdec301c607e5df»

«www.example2. com/index.php? page=1&sid=974017dcd170d6c4a5d76ae»

robots.txt будет содержать:

User-agent: Yandex Disallow: Clean-param: sid/index.php

Для адресов вида

«www.example1. com/forum/showthread.php? s=681498b9648949605&t=8243″

«www.example1. com/forum/showthread. php? s=1e71c4427317a117a&t=8243″

php? s=1e71c4427317a117a&t=8243″

robots.txt будет содержать:

User-agent: Yandex Disallow: Clean-param: s/forum/showthread.php

Если переходных параметров несколько:

«www.example1.com/forum_old/showthread.php?s=681498605&t=8243&ref=1311″

«www.example1.com/forum_new/showthread.php?s=1e71c417a&t=8243&ref=9896″

robots.txt будет содержать:

User-agent: Yandex Disallow: Clean-param: s&ref/forum*/showthread.php

Host

Правило показывает, какое зеркало учитывать при индексации. URL нужно писать без «http://» и без закрывающего слэша «/».

User-agent: Yandex Disallow: /about Host: www.site.com

Сейчас эту директиву уже

не используют, если в ваших robots.txt она есть, можно удалять. Вместо нее нужно на всех не главных зеркалах сайта поставить 301 редирект.

Crawl-delay

Раньше частая загрузка страниц нагружала сервер, поэтому для ботов устанавливали Crawl-delay — время ожидания робота в секундах между загрузками. Эту директиву можно не использовать, мощным серверам она не требуется.

Эту директиву можно не использовать, мощным серверам она не требуется.

Время ожидания — 4 секунды:

User-agent: * Allow: /album1 Disallow: / Crawl-delay: 4

Только латиница

Напомним, что все кириллические ссылки нужно перевести в Punycode с помощью любого конвертера.

Неправильно:

User-agent: Yandex Disallow: /каталог

Правильно:

User-agent: Yandex Disallow: /xn--/-8sbam6aiv3a

Пример robots.txt

Запись означает, что правило справедливо для всех роботов: запрещено сканировать ссылки из корзины, из встроенного поиска и админки, карта сайта находится по ссылке http://site.com/sitemap, ref не меняет содержание страницы get_book:

User-agent: * Disallow: /bin/ Disallow: /search/ Disallow: /admin/ Sitemap: http://site.com/sitemap Clean-param: ref/some_dir/get_book.pl

Инструменты для составления и проверки robots.

txt

txt

Составить robots.txt бесплатно поможет

инструмент для генерации robots.txt от PR-CY, он позволит закрыть или открыть весь сайт для ботов, указать путь к карте сайта, настроить ограничение на посещение страниц, закрыть доступ некоторым роботам и установить задержку:

Для проверки файла robots.txt на ошибки у поисковиков есть собственные инструменты:

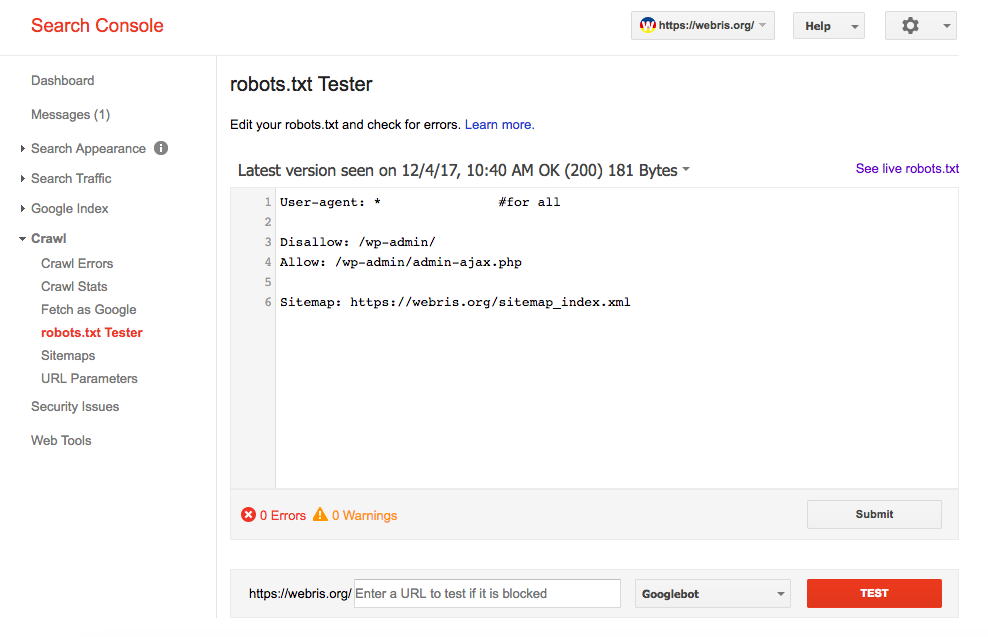

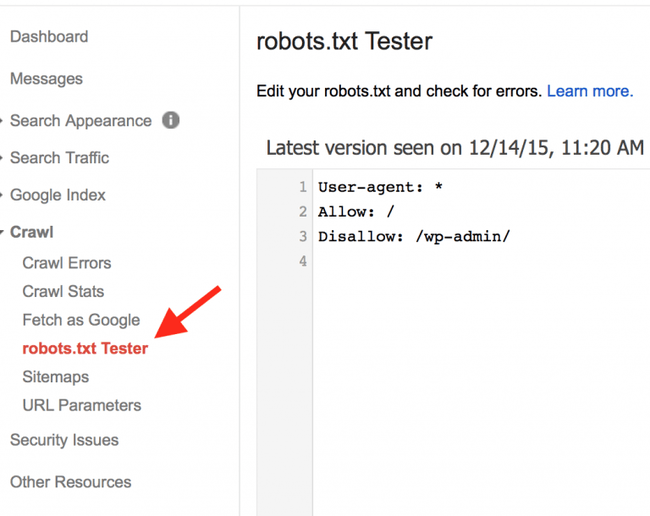

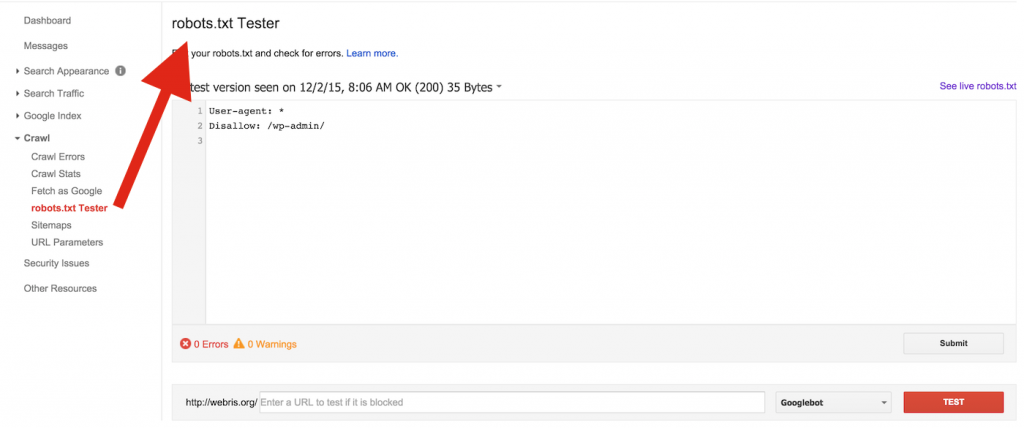

Инструмент проверки файла robots.txt от Google позволит проверить, как бот видит конкретный URL. В поле нужно ввести проверяемый URL, а инструмент покажет, доступна ли ссылка.

Инструмент проверки от Яндекса покажет, правильно ли заполнен файл. Нужно указать сайт, для которого создан robots.txt, и перенести его содержимое в поле.

Файл robots.txt не подходит для блокировки доступа к приватным файлам, но направляет краулеров к карте сайта и дает рекомендации для быстрого сканирования важных материалов ресурса.

Как создать идеальный файл robots.txt для SEO

Все любят «хаки».

Я не исключение — мне нравится находить способы сделать свою жизнь лучше и проще.

Вот почему техника, о которой я собираюсь рассказать вам сегодня, является одной из моих самых любимых. Это законный SEO-хак, который вы можете начать использовать прямо сейчас.

Это способ улучшить SEO, используя естественную часть каждого веб-сайта, о которой редко говорят. Тоже не сложно реализовать.

Это файл robots.txt (также называемый протоколом или стандартом исключения роботов).

Этот крошечный текстовый файл является частью каждого веб-сайта в Интернете, но большинство людей даже не знают о нем.

Он предназначен для работы с поисковыми системами, но, что удивительно, это источник SEO-сока, который только и ждет, чтобы его разблокировали.

Я видел, как клиент за клиентом из кожи вон лезут, пытаясь улучшить свое SEO. Когда я говорю им, что они могут редактировать небольшой текстовый файл, они почти не верят мне.

Однако существует множество несложных и не требующих много времени методов улучшения SEO, и это один из них.

Чтобы использовать возможности файла robots.txt, не требуется никаких технических знаний. Если вы можете найти исходный код своего веб-сайта, вы можете использовать это.

Итак, когда вы будете готовы, следуйте за мной, и я покажу вам, как именно изменить ваш файл robots.txt, чтобы поисковые системы полюбили его.

Чем важен файл robots.txtВо-первых, давайте посмотрим, почему файл robots.txt так важен.

Файл robots.txt, также известный как протокол или стандарт исключения роботов, представляет собой текстовый файл, который сообщает веб-роботам (чаще всего поисковым системам), какие страницы вашего сайта следует сканировать.

Он также сообщает веб-роботам, какие страницы , а не сканировать.

Допустим, поисковая система собирается посетить сайт. Прежде чем посетить целевую страницу, он проверит инструкции в файле robots. txt.

txt.

Существуют разные типы файлов robots.txt, поэтому давайте рассмотрим несколько различных примеров того, как они выглядят.

Допустим, поисковая система нашла этот пример файла robots.txt:

Это основной скелет файла robots.txt.

Звездочка после «user-agent» означает, что файл robots.txt применяется ко всем веб-роботам, посещающим сайт.

Косая черта после «Запретить» указывает роботу не посещать никакие страницы сайта.

Возможно, вам интересно, зачем кому-то запрещать веб-роботам посещать свой сайт.

В конце концов, одна из основных целей поисковой оптимизации — заставить поисковые системы легко сканировать ваш сайт, чтобы повысить его рейтинг.

Вот где раскрывается секрет этого SEO-хака.

Вероятно, на вашем сайте много страниц, верно? Даже если вам так не кажется, проверьте. Вы можете быть удивлены.

Если поисковая система сканирует ваш сайт, она будет сканировать каждую из ваших страниц.

А если у вас много страниц, поисковому роботу потребуется некоторое время, чтобы их просканировать, что может негативно сказаться на вашем рейтинге.

Это потому, что Googlebot (робот поисковой системы Google) имеет «краулинговый бюджет».

Он состоит из двух частей. Во-первых, это ограничение скорости сканирования. Вот как это объясняет Google:

Вторая часть — потребность в сканировании:

По сути, краулинговый бюджет — это «количество URL-адресов, которые робот Googlebot может и хочет сканировать».

Вы хотите помочь роботу Googlebot максимально эффективно расходовать краулинговый бюджет вашего сайта. Другими словами, он должен сканировать ваши самые ценные страницы.

Существуют определенные факторы, которые, по мнению Google, «отрицательно влияют на сканирование и индексацию сайта».

Вот эти коэффициенты:

Итак, вернемся к файлу robots.txt.

Если вы создадите правильную страницу robots.txt, вы можете указать роботам поисковых систем (и особенно роботу Google) избегать определенных страниц.

Подумайте о последствиях. Если вы скажете ботам поисковых систем сканировать только ваш самый полезный контент, боты будут сканировать и индексировать ваш сайт только на основе этого контента.

Как говорит Google:

«Вы не хотите, чтобы ваш сервер был перегружен поисковым роботом Google или чтобы вы тратили краулинговый бюджет на сканирование неважных или похожих страниц на вашем сайте».

Правильно используя файл robots.txt, вы можете убедить роботов поисковых систем разумно расходовать свой краулинговый бюджет. И именно это делает файл robots.txt таким полезным в контексте SEO.

Заинтригованы возможностями файла robots.txt?

Так и должно быть! Поговорим о том, как его найти и использовать.

Поиск файла robots.txtЕсли вы просто хотите быстро просмотреть файл robots.txt, есть очень простой способ просмотреть его.

На самом деле этот метод сработает для любого сайта . Таким образом, вы можете заглянуть в файлы других сайтов и посмотреть, что они делают.

Все, что вам нужно сделать, это ввести основной URL-адрес сайта в строку поиска вашего браузера (например, neilpatel. com, quicksprout.com и т. д.). Затем добавьте /robots.txt в конец.

com, quicksprout.com и т. д.). Затем добавьте /robots.txt в конец.

Произойдет одна из трех ситуаций:

1) Вы найдете файл robots.txt.

2) Вы найдете пустой файл.

Например, у Disney отсутствует файл robots.txt:

3) Вы получите 404.

Метод возвращает 404 для robots.txt:

Найдите секунду и просмотрите свой собственный файл robots.txt сайта.

Если вы найдете пустой файл или ошибку 404, вы захотите это исправить.

Если вы найдете действительный файл, возможно, для него установлены настройки по умолчанию, созданные при создании сайта.

Мне особенно нравится этот метод для просмотра файлов robots.txt других сайтов. Как только вы изучите все тонкости robots.txt, это может стать ценным упражнением.

Теперь давайте посмотрим на реальное изменение файла robots.txt.

Поиск файла robots.txt Дальнейшие действия будут зависеть от того, есть ли у вас файл robots. txt. (Проверьте, есть ли у вас, используя метод, описанный выше.)

txt. (Проверьте, есть ли у вас, используя метод, описанный выше.)

Если у вас нет файла robots.txt, вам нужно создать его с нуля. Откройте обычный текстовый редактор, например Блокнот (Windows) или TextEdit (Mac).

Для этого используйте только текстовый редактор . Если вы используете такие программы, как Microsoft Word, программа может вставлять в текст дополнительный код.

Editpad.org — отличный бесплатный вариант, и вы увидите, как я его использую в этой статье.

Вернуться к файлу robots.txt. Если у вас есть файл robots.txt, вам нужно найти его в корневом каталоге вашего сайта.

Если вы не привыкли копаться в исходном коде, вам может быть немного сложно найти редактируемую версию вашего файла robots.txt.

Обычно вы можете найти свой корневой каталог, зайдя на веб-сайт своей учетной записи хостинга, войдя в систему и перейдя в раздел управления файлами или FTP вашего сайта.

Вы должны увидеть примерно следующее:

Найдите файл robots. txt и откройте его для редактирования. Удалите весь текст, но сохраните файл.

txt и откройте его для редактирования. Удалите весь текст, но сохраните файл.

Примечание. Если вы используете WordPress, вы можете увидеть файл robots.txt при переходе на сайт yoursite.com/robots.txt, но вы не сможете найти его в своих файлах.

Это связано с тем, что WordPress создает виртуальный файл robots.txt, если в корневом каталоге нет файла robots.txt.

Если это произойдет с вами, вам необходимо создать новый файл robots.txt.

Создание файла robots.txtВы можете создать новый файл robots.txt с помощью любого текстового редактора по вашему выбору. (Помните, используйте только текстовый редактор.)

Если у вас уже есть файл robots.txt, убедитесь, что вы удалили текст (но не файл).

Во-первых, вам необходимо ознакомиться с некоторыми элементами синтаксиса, используемыми в файле robots.txt.

В Google есть хорошее объяснение некоторых основных терминов robots.txt:

Я покажу вам, как настроить простой файл robot. txt, а затем мы посмотрим, как его настроить. для SEO.

txt, а затем мы посмотрим, как его настроить. для SEO.

Начните с установки пользовательского агента. Мы собираемся установить его так, чтобы он применялся ко всем веб-роботам.

Сделайте это, поставив звездочку после термина пользовательского агента, например:

Затем введите «Disallow:», но после этого ничего не вводите.

Поскольку после запрета ничего нет, веб-роботы будут направлены на сканирование всего вашего сайта. Прямо сейчас все на вашем сайте является честной игрой.

На данный момент ваш файл robots.txt должен выглядеть так:

Я знаю, что это выглядит очень просто, но эти две строки уже делают многое.

Вы также можете сделать ссылку на карту сайта в формате XML, но это не обязательно. Если вы хотите, вот что напечатать:

Хотите верьте, хотите нет, но вот как выглядит базовый файл robots.txt.

Теперь давайте перейдем на следующий уровень и превратим этот маленький файл в SEO-бустер.

Оптимизация файла robots.txt для SEO

То, как вы оптимизируете файл robots.txt, зависит от содержания вашего сайта. Есть множество способов использовать robots.txt в своих интересах.

Я расскажу о некоторых наиболее распространенных способах его использования.

(Имейте в виду, что вы должны вместо использовать robots.txt для блокировки страниц от поисковых систем . Это большое нет-нет.)

Одно из лучших применений файла robots.txt — максимизировать краулинговые бюджеты поисковых систем, указав им не сканировать части вашего сайта, которые не отображаются для публики.

Например, если вы откроете файл robots.txt для этого сайта (neilpatel.com), вы увидите, что он запрещает страницу входа (wp-admin).

Поскольку эта страница используется только для входа в серверную часть сайта, роботам поисковых систем не имеет смысла тратить свое время на ее сканирование.

(Если у вас есть WordPress, вы можете использовать точно такую же строку запрета. )

)

Вы можете использовать аналогичную директиву (или команду), чтобы запретить ботам сканировать определенные страницы. После запрета введите часть URL-адреса после .com. Поместите это между двумя косыми чертами.

Итак, если вы хотите запретить боту сканировать вашу страницу http://yoursite.com/page/, введите следующее:

Возможно, вам интересно, какие именно типы страниц следует исключить из индексации. Вот несколько распространенных сценариев, в которых это может произойти:

Целенаправленное дублирование содержимого. Хотя дублированный контент — это в основном плохо, есть несколько случаев, когда он необходим и приемлем.

Например, если у вас есть версия страницы для печати, технически у вас есть дублированный контент. В этом случае вы можете указать ботам не сканировать одну из этих версий (как правило, версию для печати).

Это также удобно, если вы проводите сплит-тестирование страниц с одинаковым содержимым, но разным дизайном.

Страницы благодарности. Страница благодарности — одна из любимых страниц маркетологов, потому что она означает новый лид.

…Правильно?

Как оказалось, некоторые страницы с благодарностью доступны через Google . Это означает, что люди могут получить доступ к этим страницам, не проходя процесс захвата лидов, и это плохие новости.

Заблокировав страницы благодарности, вы можете убедиться, что их видят только квалифицированные лиды.

Допустим, ваша страница благодарности находится по адресу https://yoursite.com/thank-you/. В вашем файле robots.txt блокировка этой страницы будет выглядеть так:

Поскольку универсальных правил для запрещенных страниц не существует, файл robots.txt будет уникальным для вашего сайта. Используйте свое суждение здесь.

Есть еще две директивы, которые вам следует знать: noindex и nofollow .

Вы знаете директиву disallow, которую мы использовали? На самом деле это не предотвращает индексацию страницы.

Теоретически вы можете запретить страницу, но она все равно может оказаться в индексе.

Как правило, вам это не нужно.

Вот почему вам нужна директива noindex. Он работает с директивой disallow, чтобы боты не посещали или , индексировали определенные страницы.

Если у вас есть какие-либо страницы, которые вы не хотите индексировать (например, эти драгоценные страницы с благодарностью), вы можете использовать директиву disallow и noindex:

Теперь эта страница не будет отображаться в поисковой выдаче.

Наконец, директива nofollow. Фактически это то же самое, что и nofollow-ссылка. Короче говоря, он говорит веб-роботам не сканировать ссылки на странице.

Но директива nofollow будет реализована немного по-другому, потому что на самом деле она не является частью файла robots.txt.

Однако директива nofollow по-прежнему инструктирует веб-роботов, так что это та же концепция. Разница только в том, где это происходит.

Найдите исходный код страницы, которую вы хотите изменить, и убедитесь, что вы находитесь между тегами .

Затем вставьте эту строку:

Таким образом, это должно выглядеть так:

Убедитесь, что вы не помещаете эту строку между какими-либо другими тегами — только тегами

.Это еще один хороший вариант для страниц благодарности, поскольку веб-роботы не будут сканировать ссылки на какие-либо лид-магниты или другой эксклюзивный контент.

Если вы хотите добавить директивы noindex и nofollow, используйте следующую строку кода:

Это даст веб-роботам обе директивы одновременно.

Проверка всегоНаконец, проверьте файл robots.txt, чтобы убедиться, что все работает правильно.

Google предоставляет бесплатный тестер robots. txt в составе инструментов для веб-мастеров.

txt в составе инструментов для веб-мастеров.

Сначала войдите в свою учетную запись Webmasters, нажав «Войти» в правом верхнем углу.

Выберите свой ресурс (например, веб-сайт) и нажмите «Сканировать» на левой боковой панели.

Вы увидите «тестер robots.txt». Нажмите на это.

Если в поле уже есть код, удалите его и замените новым файлом robots.txt.

Нажмите «Тест» в нижней правой части экрана.

Если текст «Тест» изменится на «Разрешено», это означает, что файл robots.txt действителен.

Вот дополнительная информация об этом инструменте, чтобы вы могли подробно узнать, что все это значит.

Наконец, загрузите файл robots.txt в корневой каталог (или сохраните его там, если он у вас уже есть). Теперь вы вооружены мощным файлом, и вы должны увидеть увеличение видимости в поиске.

Заключение Мне всегда нравится делиться малоизвестными SEO-лайками, которые могут дать вам реальное преимущество во многих отношениях.

Правильно настроив файл robots.txt, вы не только улучшите собственное SEO. Вы также помогаете своим посетителям.

Если роботы поисковых систем смогут разумно расходовать свой краулинговый бюджет, они организуют и отобразят ваш контент в поисковой выдаче наилучшим образом, а это значит, что вы будете более заметны.

Также не требуется много усилий для настройки файла robots.txt. В основном это одноразовая настройка, и вы можете внести небольшие изменения по мере необходимости.

Независимо от того, запускаете ли вы свой первый или пятый сайт, использование файла robots.txt может иметь большое значение. Рекомендую попробовать, если вы еще этого не сделали.

Каков ваш опыт создания файлов robots.txt?

Посмотрите, как мое агентство может привлечь огромное количество трафика на ваш сайт Смотрите реальные результаты.

Заказать звонок

Как создать файл robots.txt для вашего веб-сайта [5 шагов]

Основная задача веб-робота — обход или сканирование веб-сайтов и страниц в поисках информации; они неустанно работают над сбором данных для поисковых систем и других приложений. Для некоторых есть веская причина держать страницы подальше от поисковых систем. Независимо от того, хотите ли вы настроить доступ к своему сайту или хотите работать над сайтом разработки, не отображаясь в результатах Google, файл robots.txt после его внедрения позволяет веб-сканерам и ботам знать, какую информацию они могут собирать.

Что такое файл robots.txt?

robots.txt — это простой текстовый файл веб-сайта в корневом каталоге вашего сайта, который соответствует стандарту исключения роботов. Например, www.yourdomain.com будет иметь файл robots.txt по адресу www.yourdomain. com/robots.txt. Файл состоит из одного или нескольких правил, которые разрешают или блокируют доступ сканерам, ограничивая их доступ к указанному пути к файлу на веб-сайте. По умолчанию все файлы полностью разрешены для сканирования, если не указано иное.

com/robots.txt. Файл состоит из одного или нескольких правил, которые разрешают или блокируют доступ сканерам, ограничивая их доступ к указанному пути к файлу на веб-сайте. По умолчанию все файлы полностью разрешены для сканирования, если не указано иное.

Файл robots.txt является одним из первых аспектов, проанализированных поисковыми роботами. Важно отметить, что на вашем сайте может быть только один файл robots.txt. Файл размещается на одной или нескольких страницах или на всем сайте, чтобы поисковые системы не отображали информацию о вашем сайте.

В этой статье описаны пять шагов для создания файла robots.txt и синтаксис, необходимый для защиты от ботов.

Как настроить файл Robots.txt

1. Создайте файл Robots.txt

У вас должен быть доступ к корню вашего домена. Ваш провайдер веб-хостинга может помочь вам определить, есть ли у вас соответствующий доступ.

Наиболее важной частью файла является его создание и расположение. С помощью любого текстового редактора создайте файл robots. txt. Его можно найти по адресу: 9.0003

txt. Его можно найти по адресу: 9.0003

- Корень вашего домена: www.yourdomain.com/robots.txt.

- Ваши поддомены: page.yourdomain.com/robots.txt.

- Нестандартные порты: www.yourdomain.com:881/robots.txt.

Примечание:

Файлы robots.txt не помещаются в подкаталог вашего домена (www.yourdomain.com/page/robots.txt).

Наконец, вам нужно убедиться, что ваш файл robots.txt является текстовым файлом в кодировке UTF-8. Google и другие популярные поисковые системы и сканеры могут игнорировать символы вне диапазона UTF-8, что может сделать ваши правила robots.txt недействительными.

2. Установите свой агент пользователя Robots.txt

Следующим шагом в создании файлов robots.txt является установка агента пользователя . Пользовательский агент относится к поисковым роботам или поисковым системам, которые вы хотите разрешить или заблокировать. Несколько сущностей могут быть пользовательским агентом . Ниже мы перечислили несколько поисковых роботов, а также их ассоциации.

Ниже мы перечислили несколько поисковых роботов, а также их ассоциации.

Существует три различных способа установки агента пользователя в файле robots.txt.

Создание одного агента пользователя

Синтаксис, который вы используете для установки агента пользователя: Агент пользователя: NameOfBot . Ниже DuckDuckBot является единственным установленным пользовательским агентом .

# Пример установки user-agent Пользовательский агент: DuckDuckBot

Создание более одного пользовательского агента

Если нам нужно добавить более одного, выполните тот же процесс, что и для пользовательского агента DuckDuckBot , в следующей строке, введя имя дополнительные пользовательский агент . В этом примере мы использовали Facebot.

#Пример установки более одного пользовательского агента Агент пользователя: DuckDuckBot Агент пользователя: Facebot

Настройка всех сканеров в качестве агента пользователя

Чтобы заблокировать всех ботов или сканеров, замените имя бота звездочкой (*).

#Пример установки всех поисковых роботов в качестве агента пользователя User-agent: *

Примечание:

Знак решетки (#) обозначает начало комментария.

3. Установите правила для файла robots.txt

Файл robots.txt читается группами. Группа будет указывать, кем является пользовательский агент , и иметь одно правило или директиву, чтобы указать, к каким файлам или каталогам пользовательский агент может или не может получить доступ.

Вот используемые директивы:

- Запретить : директива, относящаяся к странице или каталогу, относящемуся к вашему корневому домену, который вы не хотите сканировать именованным агентом пользователя . Он начинается с косой черты (/), за которой следует полный URL-адрес страницы. Вы завершите его косой чертой, только если он относится к каталогу, а не к целой странице. Вы можете использовать один или несколько запретить настроек для каждого правила.

- Разрешить : Директива относится к странице или каталогу, относящемуся к вашему корневому домену, который вы хотите, чтобы названный пользовательский агент сканировал. Например, вы можете использовать директиву allow , чтобы переопределить правило disallow . Он также будет начинаться с косой черты (/), за которой следует полный URL-адрес страницы. Вы завершите его косой чертой, только если он относится к каталогу, а не к целой странице. Вы можете использовать один или несколько разрешить настроек для каждого правила.

- Карта сайта : Директива карты сайта является необязательной и указывает местоположение карты сайта для веб-сайта. Единственным условием является то, что это должен быть полный URL-адрес. Вы можете использовать ноль или больше, в зависимости от того, что необходимо.

Поисковые роботы обрабатывают группы сверху вниз. Как упоминалось ранее, они получают доступ к любой странице или каталогу, для которых явно не установлено значение , запрещающее . Поэтому добавьте Disallow: / под user-agent информация в каждой группе, чтобы запретить этим конкретным пользовательским агентам сканировать ваш сайт.

Поэтому добавьте Disallow: / под user-agent информация в каждой группе, чтобы запретить этим конкретным пользовательским агентам сканировать ваш сайт.

# Пример как заблокировать DuckDuckBot Агент пользователя: DuckDuckBot Запретить: / #Пример того, как заблокировать более одного пользовательского агента Агент пользователя: DuckDuckBot Агент пользователя: Facebot Запретить: / #Пример того, как заблокировать все поисковые роботы Пользовательский агент: * Disallow: /

Чтобы заблокировать определенный поддомен от всех поисковых роботов, добавьте косую черту и полный URL-адрес поддомена в правило запрета.

# Пример Пользовательский агент: * Disallow: /https://page.yourdomain.com/robots.txt

Если вы хотите заблокировать каталог, выполните тот же процесс, добавив косую черту и имя вашего каталога, но затем закончите еще одной косой чертой.

# Пример Пользовательский агент: * Disallow: /images/

Наконец, если вы хотите, чтобы все поисковые системы собирали информацию на всех страницах вашего сайта, вы можете создать правило allow или disallow , но не забудьте добавить косую черту при использовании разрешить правило . Примеры обоих правил показаны ниже.

Примеры обоих правил показаны ниже.

# Разрешить пример, чтобы разрешить все поисковые роботы Пользовательский агент: * Разрешать: / # Пример запрета, чтобы разрешить все поисковые роботы Пользовательский агент: * Disallow:

4. Загрузите файл robots.txt

Веб-сайты не содержат файл robots.txt автоматически, поскольку он не требуется. Как только вы решите создать его, загрузите файл в корневой каталог вашего сайта. Загрузка зависит от файловой структуры вашего сайта и среды веб-хостинга. Обратитесь к своему хостинг-провайдеру, чтобы узнать, как загрузить файл robots.txt.

5. Проверьте правильность работы файла robots.txt

Существует несколько способов проверить правильность работы файла robots.txt. С любым из них вы можете увидеть любые ошибки в вашем синтаксисе или логике. Вот некоторые из них:

- Тестер Google robots.txt в их Search Console.

- Средство проверки и тестирования robots.txt от Merkle, Inc.

- Средство тестирования robots.

txt Ryte.

txt Ryte.

Бонус: использование robots.txt в WordPress

Если вы используете WordPress плагин Yoast SEO, вы увидите раздел в окне администратора для создания файла robots.txt.

Войдите в серверную часть своего веб-сайта WordPress и откройте Инструменты в разделе SEO , а затем щелкните Редактор файлов .

YoastСледуйте той же последовательности, что и раньше, чтобы установить пользовательские агенты и правила. Ниже мы заблокировали поисковые роботы из каталогов WordPress wp-admin и wp-includes, но по-прежнему разрешаем пользователям и ботам видеть другие страницы сайта. Когда закончите, нажмите Сохраните изменения в robots.txt , чтобы активировать файл robots.txt.

Отключить сканирование корзины

Поисковые системы, сканирующие ссылки для добавления в корзину и нежелательные страницы, могут повредить вашему SEO-рейтингу. Ссылки «Добавить в корзину» могут вызывать более специфические проблемы, поскольку эти страницы не кэшируются, что увеличивает нагрузку на ЦП и память вашего сервера, поскольку страницы повторяются.

К счастью, адаптировать файл robot.txt вашего сайта несложно, чтобы поисковые системы сканировали только те страницы, которые вам нужны. Используйте эти строки кода в файле robots.txt сайта, чтобы адресовать ссылки для добавления в корзину и указать поисковым системам не индексировать их.

Агент пользователя: * Disallow: /*add-to-cart=*

Также рекомендуется изменить файл robots.txt, чтобы запретить индексирование страниц корзины, оформления заказа и моей учетной записи, что можно сделать, добавив строки ниже.

Запретить: /корзина/ Запретить: /checkout/ Disallow: /my-account/

Заключение

Мы рассмотрели, как создать файл robots.txt. Эти шаги просты в выполнении и могут сэкономить ваше время и нервы, связанные с сканированием содержимого вашего сайта без вашего разрешения. Создайте файл robots.txt, чтобы заблокировать ненужное сканирование поисковыми системами и ботами.

Если вы размещаете с помощью Liquid Web и у вас есть вопросы по созданию файла robots. txt для вашего веб-сайта, обратитесь за помощью в нашу службу поддержки.

txt для вашего веб-сайта, обратитесь за помощью в нашу службу поддержки.

Что такое файл robots.txt? Рекомендации по синтаксису Robot.txt

Что такое файл robots.txt?

Robots.txt — это текстовый файл, который веб-мастера создают для того, чтобы проинструктировать веб-роботов (обычно роботов поисковых систем) о том, как сканировать страницы на их веб-сайте. Файл robots.txt является частью протокола исключения роботов (REP), группы веб-стандартов, которые регулируют, как роботы сканируют Интернет, получают доступ и индексируют контент, а также предоставляют этот контент пользователям. REP также включает в себя такие директивы, как метароботы, а также инструкции для страницы, подкаталога или сайта о том, как поисковые системы должны обрабатывать ссылки (например, «follow» или «nofollow»).

На практике файлы robots.txt указывают, могут ли определенные пользовательские агенты (программное обеспечение для веб-сканирования) сканировать части веб-сайта. Эти инструкции по обходу указываются путем «запрета» или «разрешения» поведения определенных (или всех) пользовательских агентов.

User-agent: [имя user-agent]Disallow: [строка URL не сканируется]

Вместе эти две строки считаются полным файлом robots.txt — хотя один файл robots может содержать несколько строк пользовательских агентов и директив (например, запрещает, разрешает, задержки сканирования и т. д.).

В файле robots.txt каждый набор директив агента пользователя отображается как отдельный набор , разделенных разрывом строки:

В файле robots.txt с несколькими директивами агента пользователя каждое правило запрещает или разрешает только применяется к пользовательскому агенту (агентам), указанным в этом конкретном наборе, разделенном разрывом строки. Если файл содержит правило, которое применяется более чем к одному пользовательскому агенту, сканер будет обращать внимание (и следовать директивам) только на наиболее конкретные группа инструкций.

Вот пример:

Msnbot, discobot и Slurp вызываются специально, поэтому эти пользовательские агенты будут только обращать внимание на директивы в своих разделах файла robots. txt. Все остальные пользовательские агенты будут следовать директивам в группе пользовательских агентов: *.

txt. Все остальные пользовательские агенты будут следовать директивам в группе пользовательских агентов: *.

Пример robots.txt:

Вот несколько примеров robots.txt в действии для сайта www.example.com:

URL-адрес файла robots.txt: www.example.com/robots.txt Блокировка всех поисковых роботов для всего контентаUser-agent: * Disallow: /

Использование этого синтаксиса в файле robots.txt предписывает всем поисковым роботам не сканировать какие-либо страницы на www.example. com, включая домашнюю страницу.

Разрешение всем поисковым роботам доступа ко всему контентуАгент пользователя: * Disallow:

Использование этого синтаксиса в файле robots.txt указывает поисковым роботам просканировать все страницы на www.example.com, включая главную страницу.

Блокировка определенного поискового робота из определенной папкиАгент пользователя: Googlebot Запретить: /example-subfolder/

Этот синтаксис указывает только сканеру Google (имя пользовательского агента Googlebot) не сканировать любые страницы, которые содержать строку URL www. example.com/example-subfolder/.

example.com/example-subfolder/.

Агент пользователя: Bingbot Запретить: /example-subfolder/blocked-page.html

Этот синтаксис указывает только сканеру Bing (имя пользовательского агента Bing) избегать сканирование конкретной страницы по адресу www.example.com/example-subfolder/blocked-page.html.

Как работает файл robots.txt?

Поисковые системы выполняют две основные функции:

- Сканирование сети в поисках контента;

- Индексирование этого контента, чтобы его можно было предоставить тем, кто ищет информацию.

Чтобы сканировать сайты, поисковые системы следуют ссылкам, чтобы перейти с одного сайта на другой — в конечном счете, сканируя многие миллиарды ссылок и веб-сайтов. Такое поведение сканирования иногда называют «пауками».

После перехода на веб-сайт, но до его сканирования поисковый робот будет искать файл robots. txt. Если он найдет его, сканер сначала прочитает этот файл, прежде чем продолжить просмотр страницы. Поскольку файл robots.txt содержит информацию о как поисковая система должна сканировать, найденная там информация будет указывать дальнейшие действия сканера на этом конкретном сайте. Если файл robots.txt , а не содержит какие-либо директивы, запрещающие деятельность пользовательского агента (или если на сайте нет файла robots.txt), он продолжит сканирование другой информации на сайте.

txt. Если он найдет его, сканер сначала прочитает этот файл, прежде чем продолжить просмотр страницы. Поскольку файл robots.txt содержит информацию о как поисковая система должна сканировать, найденная там информация будет указывать дальнейшие действия сканера на этом конкретном сайте. Если файл robots.txt , а не содержит какие-либо директивы, запрещающие деятельность пользовательского агента (или если на сайте нет файла robots.txt), он продолжит сканирование другой информации на сайте.

Другие важные сведения о файле robots.txt:

(более подробно обсуждается ниже)

Чтобы файл robots.txt можно было найти, его необходимо поместить в каталог верхнего уровня веб-сайта.

Robots.txt чувствителен к регистру: файл должен называться «robots.txt» (не Robots.txt, robots.TXT и т. д.).

Некоторые пользовательские агенты (роботы) могут игнорировать ваш файл robots.txt. Это особенно характерно для более гнусных поисковых роботов, таких как вредоносные роботы или скребки адресов электронной почты.

Файл /robots.txt является общедоступным: просто добавьте /robots.txt в конец любого корневого домена, чтобы увидеть директивы этого сайта (если этот сайт имеет файл robots.txt!). Это означает, что любой может видеть, какие страницы вы сканируете или не хотите, поэтому не используйте их для сокрытия личной информации пользователя.

Каждый поддомен в корневом домене использует отдельные файлы robots.txt. Это означает, что и у blog.example.com, и у example.com должны быть свои собственные файлы robots.txt (по адресу blog.example.com/robots.txt и example.com/robots.txt).

Обычно рекомендуется указывать местоположение любых карт сайта, связанных с этим доменом, в нижней части файла robots.txt. Вот пример:

Определение критических предупреждений robots.txt с помощью Moz Pro

Функция сканирования сайта Moz Pro проверяет ваш сайт на наличие проблем и выделяет срочные ошибки, которые могут помешать вам появиться в Google. Воспользуйтесь 30-дневной бесплатной пробной версией и посмотрите, чего вы можете достичь:

Воспользуйтесь 30-дневной бесплатной пробной версией и посмотрите, чего вы можете достичь:

Начните мою бесплатную пробную версию

Технический синтаксис robots.txt

Синтаксис robots.txt можно рассматривать как «язык» файлов robots.txt . Есть пять общих терминов, которые вы, вероятно, встретите в файле robots. Среди них:

Агент пользователя: Конкретный поисковый робот, которому вы даете инструкции по сканированию (обычно это поисковая система). Список большинства пользовательских агентов можно найти здесь.

Disallow: Команда, используемая для указания агенту пользователя не сканировать определенный URL-адрес. Для каждого URL разрешена только одна строка «Запретить:».

Разрешить (применимо только для робота Googlebot): команда, сообщающая роботу Googlebot, что он может получить доступ к странице или вложенной папке, даже если ее родительская страница или вложенная папка могут быть запрещены.

Crawl-delay: Сколько секунд сканер должен ждать перед загрузкой и сканированием содержимого страницы. Обратите внимание, что Googlebot не подтверждает эту команду, но скорость сканирования можно установить в Google Search Console.

Карта сайта: Используется для вызова местоположения любых карт сайта в формате XML, связанных с этим URL-адресом. Обратите внимание, что эта команда поддерживается только Google, Ask, Bing и Yahoo.

Сопоставление с шаблоном

Когда дело доходит до фактических URL-адресов, которые нужно блокировать или разрешать, файлы robots.txt могут оказаться довольно сложными, поскольку они позволяют использовать сопоставление с шаблоном для охвата диапазона возможных вариантов URL-адресов. Google и Bing поддерживают два регулярных выражения, которые можно использовать для идентификации страниц или подпапок, которые SEO хочет исключить. Этими двумя символами являются звездочка (*) и знак доллара ($).

- * — это подстановочный знак, представляющий любую последовательность символов.

- $ соответствует концу URL-адреса.

Где находится файл robots.txt на сайте?

Всякий раз, когда они заходят на сайт, поисковые системы и другие поисковые роботы (например, поисковый робот Facebook, Facebot) знают, что нужно искать файл robots.txt. Но они будут искать этот файл только в одном конкретном месте : в основном каталоге (обычно это ваш корневой домен или домашняя страница). Если пользовательский агент посещает www.example.com/robots.txt и не находит там файл robots, он предполагает, что на сайте его нет, и продолжает сканировать все на странице (и, возможно, даже на всем сайте). Даже если страница robots.txt существует по адресу , скажем, example.com/index/robots.txt или www.example.com/homepage/robots.txt, она не будет обнаружена пользовательскими агентами, и, следовательно, сайт будет рассматриваться так, как если бы у него вообще не было файла robots.

Чтобы ваш файл robots.txt был найден, всегда включайте его в свой основной каталог или корневой домен.

Зачем вам robots.txt?