Как ускорить индексацию сайта в Яндексе и Google?

#Оптимизация сайта #Индексация

#1

Ноябрь’17

29

Ноябрь’17

29

Индексация — сканирование сайта и добавление информации о нем поисковыми роботами в свою базу данных. Чем быстрее сайт обходят поисковые роботы, тем быстрее можно добиться результатов в поисковом продвижении. Есть несколько способов ускорить индексацию.

- Правильная настройка файла robots.txt позволит роботам не индексировать лишний «мусор», что положительно отразится на времени индексации всего сайта.

- Создание актуальной карты сайта также облегчит работу поисковых роботов, поскольку им не придется самостоятельно искать, какие страницы им необходимо вносить в индекс.

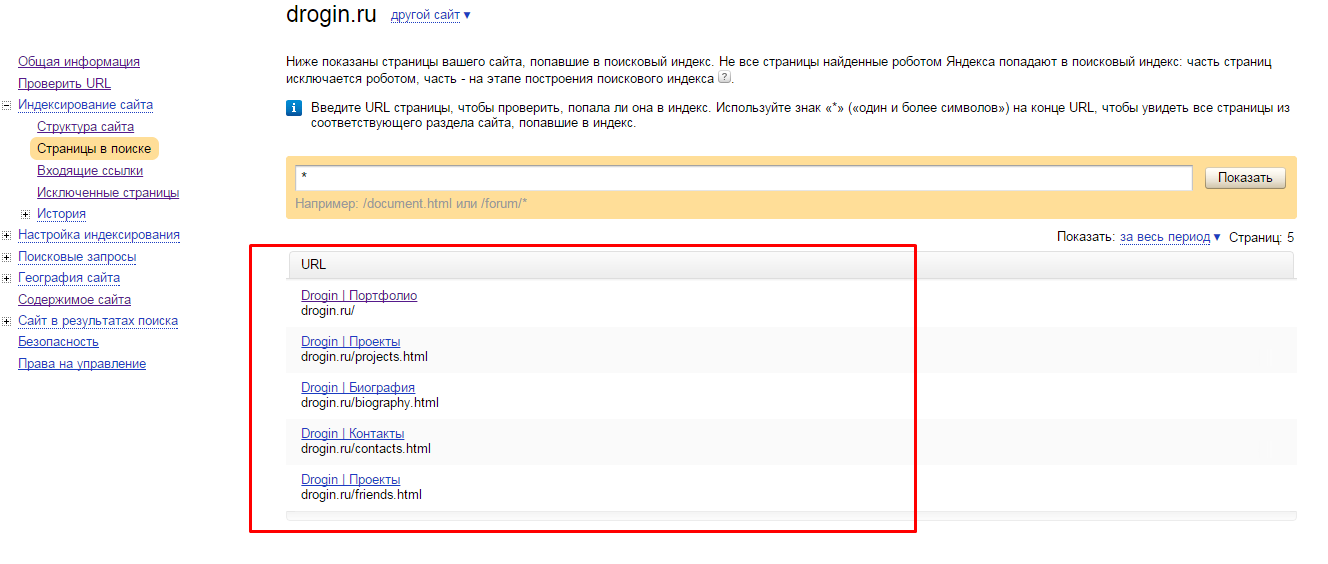

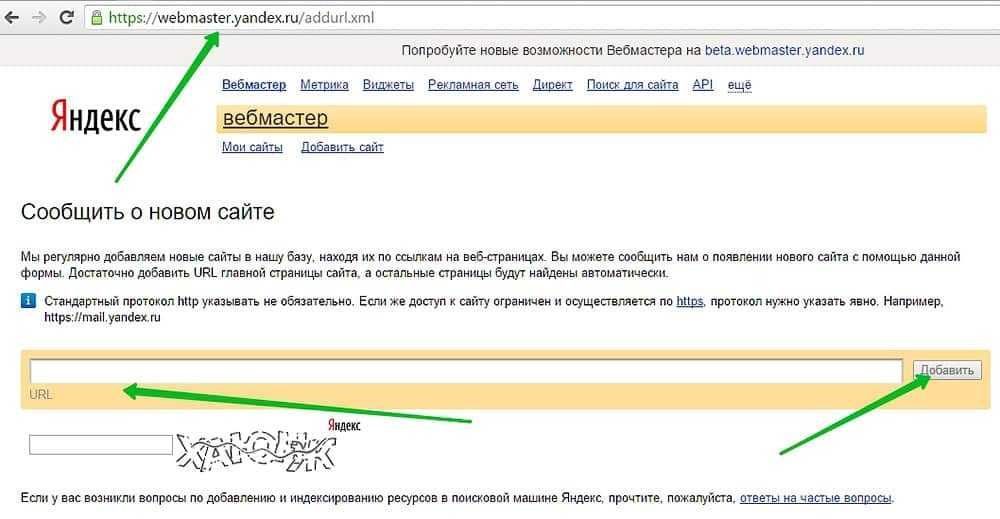

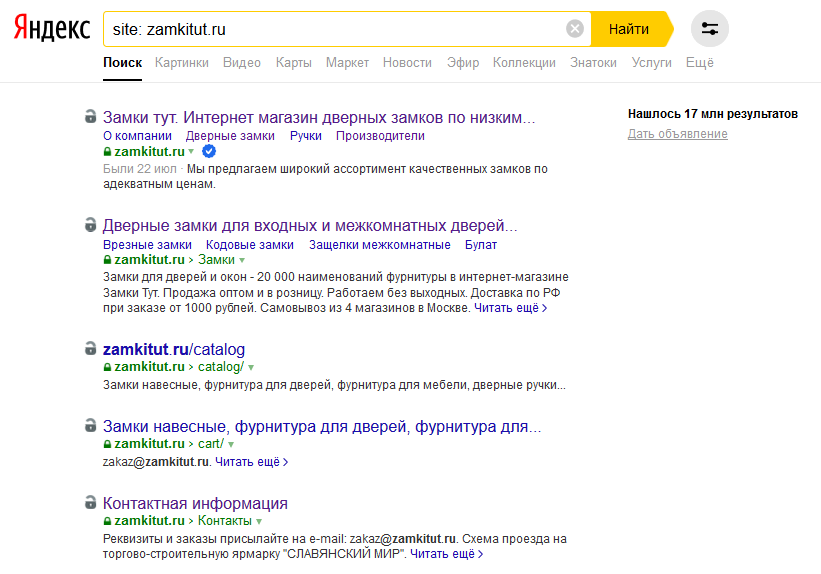

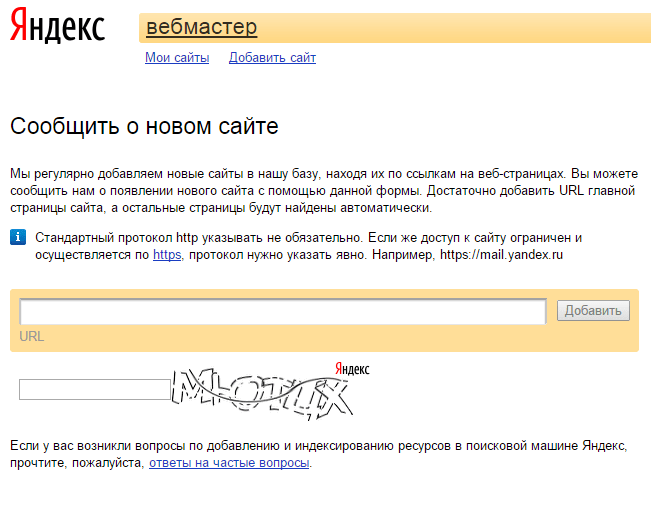

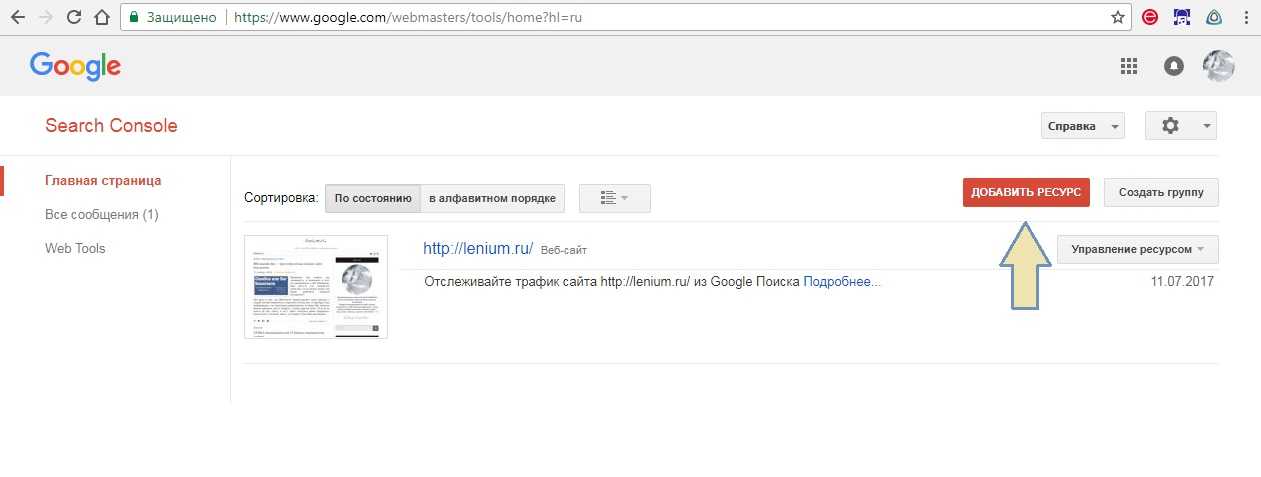

- Добавление сайта в панели для вебмастеров Яндекса, Google, Mail позволит сообщить ботам о существовании сайта.

- Добавление данных о файлах sitemap.xml, robots.txt в панели для вебмастеров упростит обход сайта поисковыми роботами.

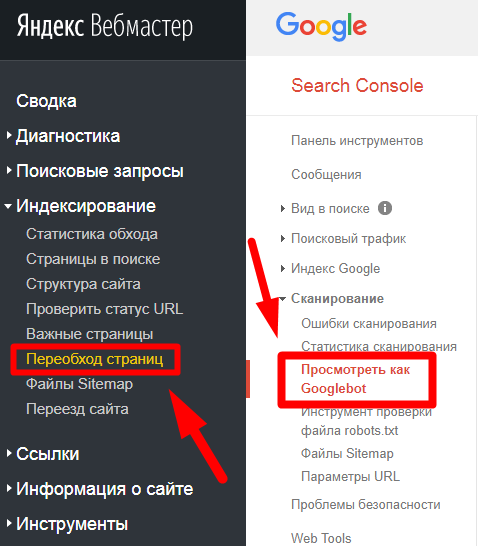

- Добавление измененных/новых страниц в инструменты «Переобход страниц» и «Просмотреть как Googlebot» уменьшает время их переиндексации.

- Настройка внутренней перелинковки.

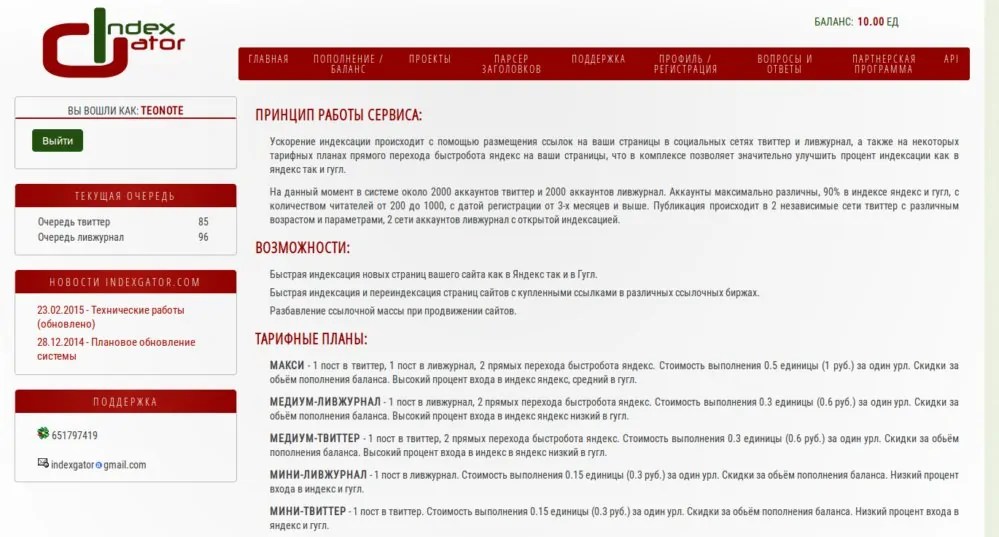

- Наличие внешних ссылок на сайт (закупка ссылочной массы, посты в социальных сетях, ссылки на форумах). Ни для кого не секрет, что роботы индексируют сайт, переходя по всем ссылкам, которые находят на своем пути. Поэтому чем больше внутренних и внешних ссылок на страницы сайта, тем быстрее поисковик их просканирует.

- Регулярное выставление уникального контента. Поисковые роботы быстрее сканируют сайты, на которых постоянно публикуется новый контент, нежели веб-ресурсы, которые с момента создания не обновляются.

- Организованная структура сайта. Если вы не допустили никаких ошибок в структуре, то на каждую страницу сайта будет как минимум одна внутренняя ссылка.

Это позволит ботам добраться до всех страниц сайта и добавить их в свою базу.

Это позволит ботам добраться до всех страниц сайта и добавить их в свою базу.

Данные способы помогут ускорить индексацию сайта в Яндексе и Google.

Похожее

Оптимизация сайта Индексация

Атрибут rel=canonical

Оптимизация сайта Индексация

Индексация ссылок

Оптимизация сайта Индексация

#133

Атрибут rel=canonical

Апрель’23

12737

23Оптимизация сайта Индексация

#119

Индексация ссылок

Апрель’19

4847

30Оптимизация сайта Индексация

#111

Описание и настройка директивы Clean-param

Апрель’19

10164

24Оптимизация сайта Индексация

#104

Как привлечь быстроробота Яндекс

Февраль’19

2373

21Оптимизация сайта Индексация

#94

Проверка индекса сайта. Как найти мусорные или недостающие страницы

Как найти мусорные или недостающие страницы

Декабрь’18

10138

28Оптимизация сайта Индексация

#86

Как закрыть ссылки и текст от поисковых систем

Ноябрь’18

6620

22Оптимизация сайта Индексация

#82

Почему Яндекс удаляет страницы из поиска

Ноябрь’18

Оптимизация сайта Индексация

#60

Правильная индексация страниц пагинации

Февраль’18

8739

19Оптимизация сайта Индексация

#47

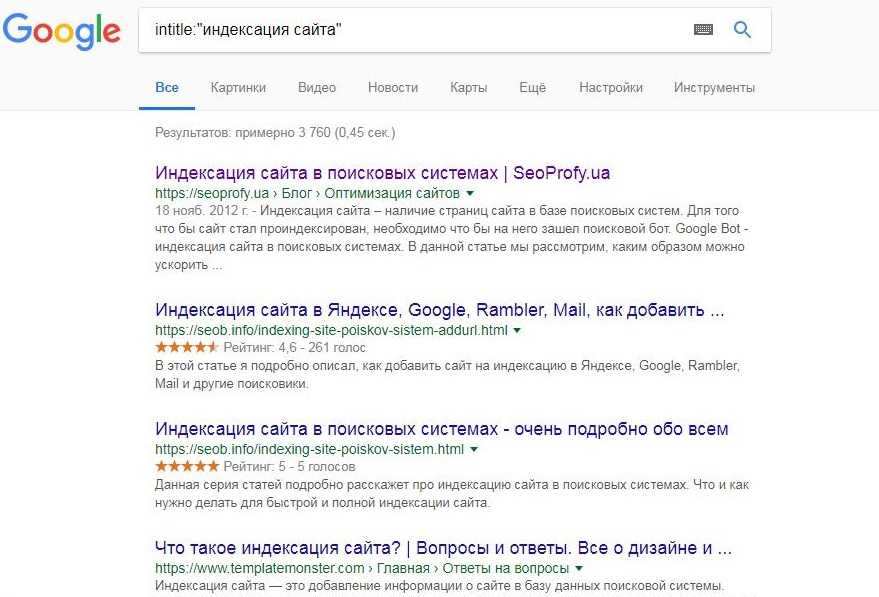

Как узнать дату индексации страницы

Ноябрь’17

8397

19Оптимизация сайта Индексация

#46

Какие страницы надо закрывать от индексации

Ноябрь’17

11291

19Оптимизация сайта Индексация

#38

Как удалить страницу из индекса Яндекса и Google

Ноябрь’17

14957

20Оптимизация сайта Индексация

#37

Как добавить страницу в поиск Яндекса и Google

20898

19Оптимизация сайта Индексация

#7

Как закрыть сайт от индексации

Ноябрь’17

10612

18Оптимизация сайта Индексация

#2

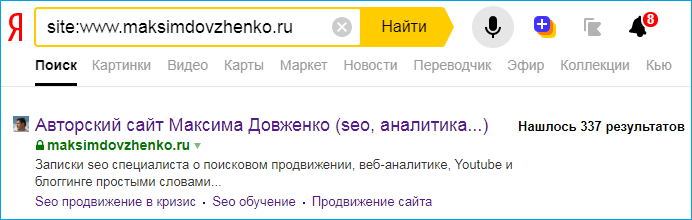

Как проверить индексацию сайта в поисковых системах

Ноябрь’17

18487

Как ускорить индексацию сайта в Яндексе и Google 🚀 – PR-CY Блог

Актуальные способы ускорить индексирование страниц в обоих поисковиках. Обновленный материал.

Обновленный материал.

В статье:

Проблемы с индексацией сайта в ПС

Как ускорить индексацию страниц

FAQ: что влияет на скорость индексации сайта

Чем быстрее страница займет место в выдаче поисковой системы, тем быстрее ее смогут увидеть пользователи, и тем больше вероятность, что она будет считаться первоисточником контента.

Нельзя точно сказать, когда боты поисковых систем просканируют страницу и она появится в выдаче. На частоту индексирования страниц ботами влияет:

- Частота обновления контента страниц. Боты составляют краулинговый бюджет сайта на основе данных об обновлении контента. Если страницы не меняются, нет смысла их часто сканировать.

- Поведенческие факторы, которые обрабатывают поисковые боты. Чем лучше ПФ, тем востребованнее сайт у аудитории, а это еще один сигнал к повышению внимания от робота.

- Хостинг.

На загруженном хостинге снижается скорость обработки запросов от робота.

На загруженном хостинге снижается скорость обработки запросов от робота.

Разберем типичные проблемы, с которыми сталкиваются оптимизаторы.

Частые проблемы с индексацией сайта в ПС

Страницы вообще не индексируются

Если роботы и Яндекса, и Google игнорируют страницы сайта, нужно убедиться, что ботам не запретили обход. Проверьте настройки хостинга и файл robots.txt — там не должно быть запрета на индексацию. Также запрет может быть в HTTP-заголовке X-Robot-Tag, который находится в файле конфигурации сервера. Проверить запрет через X-Robots-Tag можно в инструменте бесплатно.

Страницы не индексируются одним из поисковиков

Если либо Google, либо Яндекс не индексируют страницы сайта, проблема может быть в санкциях от этого поисковика. Нужно определить, какие санкции лежат на сайте, и исправить ошибки. Помогут материалы о санкциях Яндекса и фильтрах Google.

Страницы индексируются, но долго

Если приходится долго ждать индексации новых страниц, вариантов может быть много: контент редко обновляется и поэтому боты редко его посещают, страницы не оптимизированы, не участвуют в перелинковке или проблема в чем-то другом. Способы ускорить индексацию мы разберем дальше.

Способы ускорить индексацию мы разберем дальше.

Посмотреть динамику индексации страниц и найти ошибки в SEO можно в сервисе для анализа сайта от PR-CY:

График индексации в сервисеИтак, если страницы не индексируются, то проверьте ограничения, если игнорирует поисковик, то возможны санкции, а если индексирование идет, но долго, это повод попытаться его ускорить.

Как ускорить индексацию страниц

Представитель Google Джон Мюллер на вопрос об индексировании ответил так:

«Лучший способ улучшить процесс индексирования — создавать превосходный, а значит уникальный и убедительный контент. Именно в нем должны нуждаться пользователи, именно его они затем будут рекомендовать другим. Нужно также понимать, что поисковые системы не индексируют абсолютно все, что выложено в сети».

Создавайте превосходный контент, а если ваш контент плохо индексируется, то он недостаточно превосходный. 🙂 Это все, конечно, хорошо, но давайте посмотрим, что конкретно можно сделать, чтобы ускорить процесс.

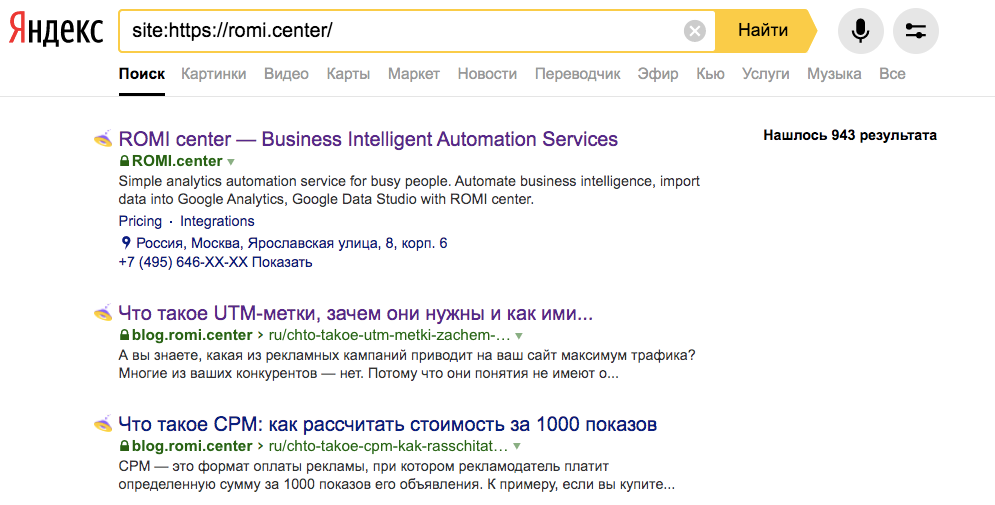

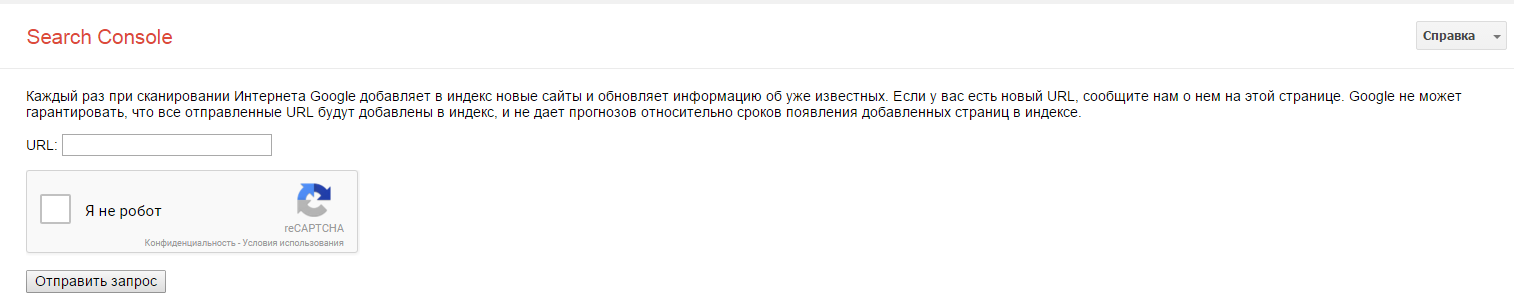

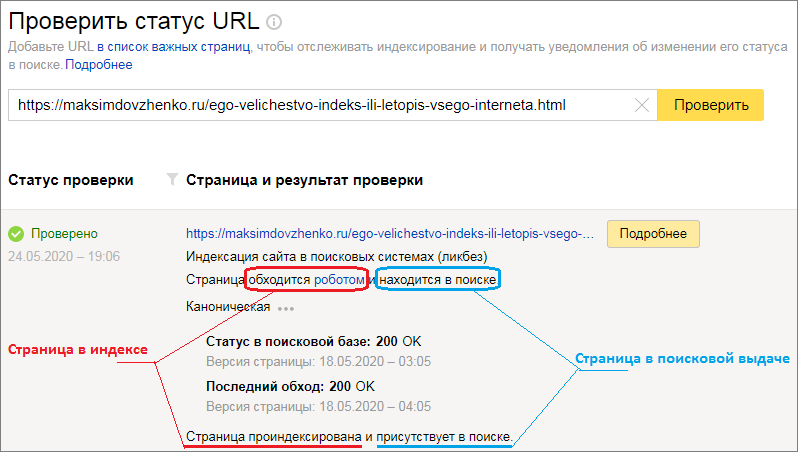

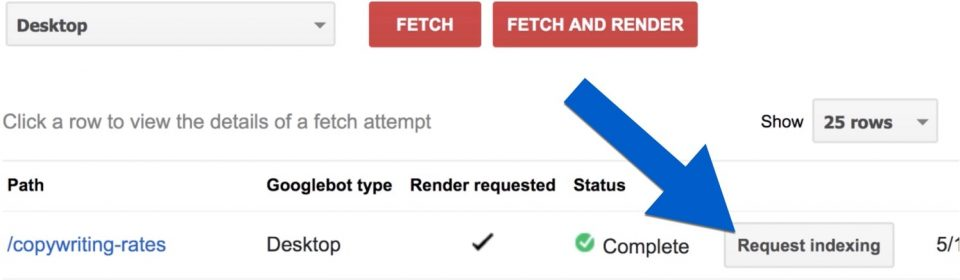

Отправить страницу на переобход

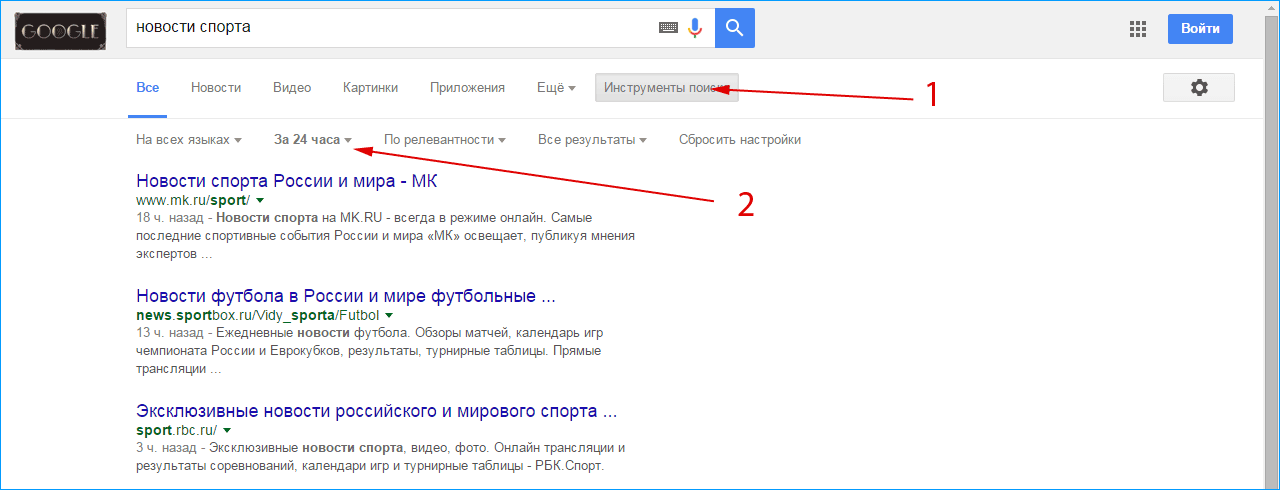

Можно дополнительно обратить внимание поисковиков на конкретные URL. В Google Search Console и Яндекс.Вебмастере найдите переобход страниц и отправьте нужные URL на индексацию.

В Яндекс.Вебмастере это раздел Индексирование — Переобход страниц. В консоли Google это Инструмент проверки URL.

Массовая отправка страниц на переиндексацию в Google

Есть способ отправлять на повторное сканирование не по одной ссылке за раз, а по 200 URL в день. В этом мог бы помочь бесплатный скрипт, который сделал SEO-отдел компании Journey Further на базе Indexing API Google. Проблема в том, что для его работы понадобится аккаунт в Google Cloud Platform, но в марте Google перестал регистрировать пользователей из России в своем облачном сервисе.

Если вы не из РФ, можете настроить скрипт для массовой переиндексации URL. Для этого нужно:

Установить node.js.

Создать сервисный аккаунт в Google Cloud Platform.

Создать закрытый JSON-ключ.

Скачать скрипт и вставить ключ вместо содержимого service_account.

Связать скрипт с Google Search Console: назначить владельцем client_email. Нужен не полный доступ, а именно роль «Владелец».

Перейти по ссылке, выбрать сервисный аккаунт, который вы создали, и включить Index API.

В папке скрипта открыть файл urls и внести в него до 100 URL. Если нужно больше, можно отправить еще до 100 во втором заходе. В день можно отправлять не больше 200 ссылок.

Вызвать PowerShell, зажав Shift и правую кнопку мыши в окне.

Прописать node index.js.

Готово, через несколько секунд появится 200 ОК.

Проверить разрешения в robots.txt

В файле robots.txt веб-мастер прописывает рекомендации для поисковых ботов Яндекса и Google. Можно запретить ботам посещать некоторые страницы, для этого есть директива «disallow», «nofollow», можно использовать мета-тег «noindex» или «none». Тогда при следующем посещении сайта бот увидит запрет и может к нему прислушаться. А может и не прислушаться.

Можно запретить ботам посещать некоторые страницы, для этого есть директива «disallow», «nofollow», можно использовать мета-тег «noindex» или «none». Тогда при следующем посещении сайта бот увидит запрет и может к нему прислушаться. А может и не прислушаться.

Как говорит Ксения Пескова, SEO-TeamLead в Siteclinic:

«Если вы закроете сканирование в файле robots.txt — это всё равно может не уберечь от индексации страницы, так как в файле мы запрещаем сканирование, и это всего лишь рекомендации, а не прямое указание».

В любом случае, лучше проверить файл robots, вдруг там стоят запреты, к которым прислушались боты поисковых систем.

Создать Sitemap — Карту сайта

Карта сайта помогает поисковым ботам понять структуру ресурса и обнаруживать обновления контента.

Почитать по теме:

Как составить карту сайта (файл Sitemap)

Для ускорения индексации карту можно сделать динамической, то есть по мере создания новых страниц она сама будет обновляться. Для проектов на конструкторах сайтов, например, на Tilda, карта по умолчанию динамическая, для CMS есть плагины и отдельные сервисы. К примеру, на WordPress с этой задачей справится All in One SEO Pack.

Для проектов на конструкторах сайтов, например, на Tilda, карта по умолчанию динамическая, для CMS есть плагины и отдельные сервисы. К примеру, на WordPress с этой задачей справится All in One SEO Pack.

Можно обновить файл Sitemap вручную. Обновленные страницы Google рекомендует отметить в Карте тегом < lastmod >. Обновленный файл отправьте с помощью специального отчета. Не стоит загружать один и тот же файл повторно: если вы ничего не поменяли в Карте сайта, никаких изменений не будет.

Но опять же, ссылки в Карте сайта — это рекомендации, важнее создать грамотную структуру сайта и организовать внутреннюю перелинковку.

Проверить структуру и перелинковку разделов

На сайте не должно быть страниц, оторванных от других. Если на страницу не ведут ссылки с категорий, разделов и других страниц, поисковикам сложнее определить ее релевантность и неоткуда перейти на нее для сканирования. Такие страницы называют сиротами.

Страница-сирота в структуре сайтаНужно встроить их в структуру сайта. К примеру, в этой схеме каждая страница имеет ссылку с родительской категории, но они вполне могут линковаться и между собой:

К примеру, в этой схеме каждая страница имеет ссылку с родительской категории, но они вполне могут линковаться и между собой:

Еще один момент, который влияет на поведение бота — это Click Distance from Index (DFI), то есть количество кликов от главной до текущей страницы. Чем оно меньше, тем важнее считается страница, тем больший приоритет она получит с точки зрения бота. Приоритетные страницы он смотрит первее остальных.

DFI не определяется по числу директорий в URL, они могут не совпадать. Например, если на главной странице будет ссылка на хит продаж — конкретную модель холодильника Atlant, то DFI будет равен двум. Но при этом карточка модели может находиться в каталоге и подразделе каталога, тогда директорий будет больше — site.com/shop/refrigerator/one_chamber_refrigerators/atlant/h_1401_100.

Если страница не индексируется, проверьте ее расположение в структуре сайта и количество кликов до нее с главной.

Александр Шестаков, руководитель продукта Links.Sape:

«Внутренняя перелинковка положительно влияет сразу на несколько параметров, например, увеличивает трафик и упрощает работу поисковых роботов. Также ускорению индексации способствуют внешние ссылки из качественных источников (сайтов с высоким трастом и уровнем трафика).

При этом любую внешнюю ссылку можно усилить, закупив дополнительные ссылки на страницу, с которой она исходит. Такая стратегия многоступенчатого усиления называется Tier 2.

Существуют и более сложные разветвленные стратегии, например Tier 3-5. Эти методы приводят к увеличению веса страницы, и не только качественно ускоряют индексацию сайта, но и влияют на рост позиций. При этом усиление ссылок не вызывает у поисковых систем подозрения в манипуляциях».

Взять за правило обновлять контент

Поисковики ценят, когда веб-мастер следит за актуальностью контента, исправляет его и добавляет что-то новое. Регулярно обновляющийся сайт бот будет чаще сканировать. Чем реже обновлять контент, тем реже боту понадобится его перепроверять.

Чем реже обновлять контент, тем реже боту понадобится его перепроверять.

Сотрудник Google советовал добавлять на страницу видео с Youtube, если странице нечего добавить и содержание еще актуально. Поведенческие улучшатся за счет просмотра видео, на странице появится новый формат контента — это тоже хороший сигнал для поисковика.

Материал по теме:

Как переупаковать контент

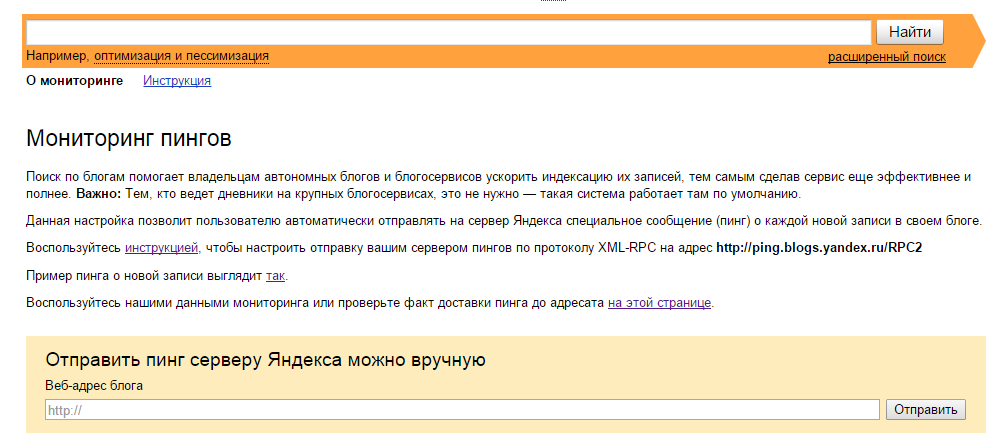

Публиковать ссылки в соцсетях и на других площадках

Найдите сторонние сайты по вашей тематике, где можно оставлять ссылки или публиковать посты, и размещайте таким образом ссылки на новые материалы.

CTO компании Pear Advert Иван Самохин:

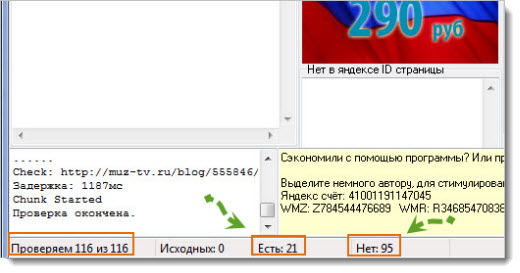

«Вопрос индексации остается актуальным не только для вашего сайта, но и для страниц с ссылками на ваш ресурс. Убедитесь в том, что страницы с внешними ссылками находятся в индексе поисковых систем, иначе оказать положительное влияние на продвижение сайта они не смогут».

Вы можете договориться о партнерстве с площадкой, близкой вам по тематике, и обмениваться ссылками. Главное, что размещения ссылок должны выглядеть естественными и подходить по теме. К примеру, ссылка на магазин рыболовных снастей будет уместно выглядеть на форуме рыболовов или туристическом портале. Ищите справочники, форумы, другие соцсети, отзовики, сервисы вопросов и ответов и другие площадки для размещения.

Главное, что размещения ссылок должны выглядеть естественными и подходить по теме. К примеру, ссылка на магазин рыболовных снастей будет уместно выглядеть на форуме рыболовов или туристическом портале. Ищите справочники, форумы, другие соцсети, отзовики, сервисы вопросов и ответов и другие площадки для размещения.

Материал по теме:

Как получить ссылки на сайт бесплатно

Если вы ведете страницы в социальных сетях, размещайте на них анонсы ваших новых материалов. С помощью разметки OpenGraph можно задать ссылке красивое превью с нужной картинкой и заголовком, и получить переходы пользователей на страницу.

Превью ссылки в посте в ВКонтактеОтследить популярные страницы поможет сервис сквозной аналитики и коллтрекинга Calltracking.ru. С его помощью вы сможете понять:

- с каких страниц поступают целевые и нецелевые обращения;

- есть ли проблемы с версткой на страницах сайта;

- на какие страницы увеличивать трафик и запускать рекламу.

Сервис помогает оптимизировать рекламу с учетом всех лидов и их стоимости.

Ускорить загрузку сайта

Ограничивать индексацию может долгий ответ сервера. По словам Джона Мюллера из Google, если в среднем это время составляет больше одной секунды, Google не будет сканировать столько страниц, сколько мог бы.

Медленная загрузка страниц вредит им по всем параметрам: пользователи не ждут, а поисковые системы считают страницы некачественными и могут даже понизить сайт в выдаче, если проблема с загрузкой есть у всех страниц.

Материал по теме:

Полное руководство по ускорению сайта

Многое можно проверить на сайте автоматически. Поможет сервис для анализа сайта: он оценит загрузку сайта и отдельно найдет конкретные страницы, на которых есть проблема со скоростью.

Проверка скорости загрузкиПоиск медленных страниц на сайтеАудит сайта с проверкой внутренних страниц доступен на всех платных тарифах.

Вы можете попробовать неделю бесплатно и оценить все возможности сервиса.

FAQ: что еще влияет на скорость индексации сайта

Как страницы вне индекса могут повлиять на отношение поисковика к сайту?

Качество контента на сайте поисковики оценивают только по проиндексированным страницам.

Тег noindex может влиять на индексацию страницы после его снятия?

По словам Джона Мюллера из Google, у веб-мастера не будет проблем с реиндексацией URL, на которых когда-то был noindex.

Как редирект влияет на индексацию страниц?

Джон Мюллер утверждает, что поисковик скорее всего не проиндексирует конечный URL при использовании ссылок с 301 редиректом.

Как ускорить индексацию страниц, которые были 404?

Если адрес страницы отдавал 404 и не был индексирован, на индексирование может потребоваться некоторое время. Как советуют Seroundtable, можно создать новый URL для этого контента и настроить 301 редирект со старого адреса, либо запросить повторное сканирование URL.

Как поисковики относятся к URL c хэшами?

URL с хешами поисковик не проиндексирует. То есть ссылка https://site.ru/news/p/statya проиндексируется, а ссылка на конкретную часть статьи — https://site.ru/news/p/statya#step — нет.

Расскажите, какие способы ускорить попадание в индекс знаете вы? Добавьте в комментариях, если мы что-то упустили в материале.

Как заставить Google быстро проиндексировать ваш сайт

Если и есть что-то в мире SEO, что хочет видеть каждый SEO-специалист, так это способность Google быстро сканировать и индексировать их сайт.

Индексация важна. Он выполняет множество начальных шагов к успешной стратегии SEO, в том числе обеспечивает отображение ваших страниц в результатах поиска Google.

Но это только часть истории.

Индексирование — это всего лишь один шаг в полной серии шагов, необходимых для эффективной стратегии SEO.

Эти этапы включают следующее, и их можно свести к трем этапам всего процесса:

- Сканирование.

- Индексация.

- Рейтинг.

Хотя это можно свести к минимуму, это не обязательно единственные шаги, которые использует Google. Реальный процесс намного сложнее.

Если вы запутались, давайте сначала рассмотрим несколько определений этих терминов.

Почему определения?

Они важны, потому что, если вы не знаете, что означают эти термины, вы рискуете использовать их взаимозаменяемо, что является неправильным подходом, особенно когда вы сообщаете о своей работе клиентам и заинтересованным сторонам.

Что вообще такое сканирование, индексирование и ранжирование?

Проще говоря, это этапы процесса Google по обнаружению веб-сайтов во всемирной паутине и отображению их на более высоких позициях в результатах поиска.

Каждая страница, обнаруженная Google, проходит один и тот же процесс, включающий сканирование, индексирование и ранжирование.

Сначала Google просматривает вашу страницу, чтобы определить, стоит ли включать ее в свой индекс.

Шаг после сканирования называется индексированием.

Предполагая, что ваша страница проходит первую оценку, это шаг, на котором Google включает вашу веб-страницу в свой собственный категоризированный индекс базы данных всех доступных страниц, которые он просканировал до сих пор.

Ранжирование — последний шаг в этом процессе.

Здесь Google покажет результаты вашего запроса. Хотя чтение вышеприведенного может занять несколько секунд, Google выполняет этот процесс — в большинстве случаев — менее чем за миллисекунду.

Наконец, веб-браузер выполняет процесс рендеринга, чтобы он мог правильно отображать ваш сайт, позволяя его сканировать и индексировать.

Во всяком случае, рендеринг — это процесс, столь же важный, как сканирование, индексирование и ранжирование.

Давайте рассмотрим пример.

Допустим, у вас есть страница с кодом, который отображает теги noindex, но показывает теги index при первой загрузке.

К сожалению, многие SEO-специалисты не понимают разницы между сканированием, индексированием, ранжированием и рендерингом.

Они также используют термины взаимозаменяемо, но это неправильный способ сделать это — и только запутывает клиентов и заинтересованных лиц относительно того, что вы делаете.

Как специалисты по поисковой оптимизации, мы должны использовать эти термины для дальнейшего разъяснения того, что мы делаем, а не для создания дополнительной путаницы.

В любом случае, идем дальше.

Если вы выполняете поиск в Google, единственное, что вы просите Google сделать, это предоставить вам результаты, содержащие все релевантные страницы из его индекса.

Часто миллионы страниц могут соответствовать тому, что вы ищете, поэтому у Google есть алгоритмы ранжирования, которые определяют, какие результаты должны отображаться как лучшие, а также наиболее релевантные.

Итак, образно говоря: сканирование — это подготовка к вызову, индексация — это выполнение вызова, и, наконец, ранжирование — это победа в вызове.

Хотя это простые концепции, алгоритмы Google совсем не такие.

Страница должна быть не только ценной, но и уникальной

Если у вас возникли проблемы с индексацией вашей страницы, вам нужно убедиться, что страница ценна и уникальна.

Но не заблуждайтесь: то, что вы считаете ценным, может не совпадать с тем, что считает ценным Google.

Google также вряд ли будет индексировать страницы низкого качества из-за того, что эти страницы не представляют никакой ценности для пользователей.

Если вы выполнили технический контрольный список SEO на уровне страницы и все прошло проверку (это означает, что страница индексируется и не страдает от каких-либо проблем с качеством), вам следует спросить себя: действительно ли эта страница — и мы имеем в виду действительно — ценный?

Просмотр страницы свежим взглядом может быть полезным, потому что это может помочь вам выявить проблемы с контентом, которые иначе вы бы не обнаружили. Кроме того, вы можете найти то, чего раньше не замечали.

Один из способов определить эти конкретные типы страниц — выполнить анализ страниц низкого качества и с очень небольшим органическим трафиком в Google Analytics.

Затем вы можете принять решение о том, какие страницы оставить, а какие удалить.

Однако важно отметить, что вы не просто хотите удалить страницы, на которых нет трафика. Они все еще могут быть ценными страницами.

Если они освещают тему и помогают вашему сайту стать актуальным авторитетом, не удаляйте их.

Это только навредит вам в долгосрочной перспективе.

Имейте регулярный план, предусматривающий обновление и повторную оптимизацию старого контента

Результаты поиска Google постоянно меняются, как и веб-сайты в этих результатах поиска.

Большинство веб-сайтов, входящих в первую десятку результатов Google, всегда обновляют свой контент (по крайней мере, они должны быть) и вносят изменения в свои страницы.

Важно отслеживать эти изменения и выборочно проверять изменяющиеся результаты поиска, чтобы знать, что нужно изменить в следующий раз.

Регулярная ежемесячная или ежеквартальная проверка вашего сайта — в зависимости от размера вашего сайта — имеет решающее значение для того, чтобы оставаться в курсе событий и быть уверенным, что ваш контент продолжает превосходить конкурентов.

Если ваши конкуренты добавляют новый контент, узнайте, что они добавили и как вы можете их превзойти. Если они по какой-либо причине внесли изменения в свои ключевые слова, узнайте, что это были за изменения, и обойдите их.

Ни один SEO-план не является реалистичным предложением «установил и забыл». Вы должны быть готовы оставаться приверженными регулярной публикации контента наряду с регулярными обновлениями старого контента.

Удаление некачественных страниц и создание регулярного графика удаления контента

Со временем вы можете обнаружить, просматривая свою аналитику, что ваши страницы работают не так, как ожидалось, и у них нет показателей, на которые вы надеялись.

В некоторых случаях страницы также являются заполнителями и не улучшают блог с точки зрения вклада в общую тему.

Эти некачественные страницы также обычно не полностью оптимизированы. Они не соответствуют передовым практикам SEO, и у них обычно нет идеальной оптимизации.

Обычно вы хотите убедиться, что эти страницы должным образом оптимизированы и охватывают все темы, которые ожидаются от этой конкретной страницы.

В идеале вы хотите, чтобы шесть элементов каждой страницы всегда были оптимизированы:

- Заголовок страницы.

- Мета-описание.

- Внутренние ссылки.

- Заголовки страниц (теги h2, h3, h4 и т.д.).

- изображений (альтернатива изображения, название изображения, физический размер изображения и т. д.).

- Разметка Schema.org.

Но то, что страница не полностью оптимизирована, не всегда означает, что она низкого качества. Влияет ли это на общую тему? Тогда вы не хотите удалять эту страницу.

Ошибочно сразу удалять все страницы, которые не соответствуют определенному минимальному количеству трафика в Google Analytics или Google Search Console.

Вместо этого вы хотите найти страницы, которые не работают хорошо с точки зрения каких-либо показателей на обеих платформах, а затем расставить приоритеты, какие страницы удалить на основе релевантности и того, вносят ли они вклад в тему и ваш общий авторитет.

Если нет, то вы хотите удалить их полностью. Это поможет вам исключить сообщения-заполнители и создать лучший общий план, чтобы ваш сайт был максимально сильным с точки зрения содержания.

Кроме того, убедитесь, что ваша страница написана на темы, интересующие вашу аудиторию, и это очень поможет.

Убедитесь, что ваш файл robots.txt не блокирует сканирование каких-либо страниц

Вы обнаружили, что Google вообще не сканирует и не индексирует какие-либо страницы на вашем веб-сайте? Если это так, возможно, вы случайно полностью заблокировали сканирование.

Проверить это можно в двух местах: на панели управления WordPress в разделе Общие > Чтение > Включить сканирование и в самом файле robots.txt.

Вы также можете проверить файл robots.txt, скопировав следующий адрес: https://domainnameexample.com/robots.txt и введя его в адресную строку веб-браузера.

Если ваш сайт настроен правильно, при переходе на него ваш файл robots. txt должен отображаться без проблем.

txt должен отображаться без проблем.

В robots.txt, если вы случайно полностью отключили сканирование, вы должны увидеть следующую строку:

User-agent: * disallow: /

Косая черта в строке запрета указывает поисковым роботам прекратить индексировать ваш сайт, начиная с корневой папки в public_html.

Звездочка рядом с агентом пользователя сообщает всем возможным поисковым роботам и агентам пользователя, что им запрещено сканировать и индексировать ваш сайт.

Убедитесь, что у вас нет мошеннических тегов Noindex

Без надлежащего надзора можно позволить тегам noindex опередить вас.

Возьмем, к примеру, следующую ситуацию.

У вас много контента, который вы хотите сохранить в индексе. Но вы создаете сценарий без вашего ведома, где кто-то, кто его устанавливает, случайно настраивает его до такой степени, что он не индексирует большой объем страниц.

А что случилось, что этот объем страниц не проиндексирован? Скрипт автоматически добавил целую кучу мошеннических тегов noindex.

К счастью, эту конкретную ситуацию можно исправить, выполнив относительно простой поиск и замену базы данных SQL, если вы используете WordPress. Это может помочь гарантировать, что эти мошеннические теги noindex не вызовут серьезных проблем в будущем.

Ключ к исправлению ошибок такого типа, особенно на веб-сайтах с большим объемом контента, заключается в том, чтобы убедиться, что у вас есть способ исправить любые подобные ошибки достаточно быстро — по крайней мере, в достаточно короткие сроки, чтобы это не привело к негативным последствиям. повлиять на любые показатели SEO.

Убедитесь, что страницы, которые не проиндексированы, включены в вашу карту сайта

Если вы не включили страницу в свою карту сайта и она не имеет взаимосвязанных ссылок где-либо еще на вашем сайте, у вас может не быть возможности сообщить об этом Google что он существует.

Когда вы отвечаете за большой веб-сайт, это может уйти от вас, особенно если не осуществляется надлежащий контроль.

Допустим, у вас есть большой веб-сайт о здоровье на 100 000 страниц. Возможно, 25 000 страниц никогда не попадут в индекс Google, потому что по какой-то причине они просто не включены в XML-карту сайта.

Это большое число.

Вместо этого вы должны убедиться, что остальные из этих 25 000 страниц включены в вашу карту сайта, потому что они могут значительно повысить ценность вашего сайта в целом.

Даже если они не работают, если эти страницы тесно связаны с вашей темой и хорошо написаны (и качественно), они добавят авторитета.

Кроме того, может случиться так, что внутренняя ссылка ускользнет от вас, особенно если вы программно не заботитесь об этой индексации с помощью каких-либо других средств.

Добавление страниц, которые не проиндексированы, в вашу карту сайта может помочь убедиться, что все ваши страницы обнаружены правильно, и что у вас нет серьезных проблем с индексированием (вычеркните еще один пункт контрольного списка для технического SEO).

Убедитесь, что на сайте не существует мошеннических канонических тегов

Если у вас есть мошеннические канонические теги, эти канонические теги могут помешать индексации вашего сайта. И если у вас их много, то это может еще больше усугубить проблему.

Допустим, у вас есть сайт, на котором ваши канонические теги должны иметь следующий формат:

Но на самом деле они отображаются как:

Это пример мошеннического канонического тега. Эти теги могут нанести ущерб вашему сайту, вызвав проблемы с индексацией. Проблемы с этими типами канонических тегов могут привести к следующему:

- Google не видит ваши страницы должным образом — особенно если конечная страница назначения возвращает ошибку 404 или программную ошибку 404.

- Путаница – Google может выбрать страницы, которые не окажут большого влияния на ранжирование.

- Напрасный краулинговый бюджет . Сканирование страниц Google без надлежащих канонических тегов может привести к трате краулингового бюджета, если ваши теги установлены неправильно.

Когда ошибка распространяется на многие тысячи страниц, поздравляем! Вы потратили краулинговый бюджет на то, чтобы убедить Google, что эти страницы нужно сканировать, тогда как на самом деле Google должен был сканировать другие страницы.

Когда ошибка распространяется на многие тысячи страниц, поздравляем! Вы потратили краулинговый бюджет на то, чтобы убедить Google, что эти страницы нужно сканировать, тогда как на самом деле Google должен был сканировать другие страницы.

Первый шаг к их устранению — найти ошибку и исправить свой недосмотр. Убедитесь, что обнаружены все страницы с ошибкой.

Затем создайте и реализуйте план дальнейшего исправления этих страниц в достаточном объеме (в зависимости от размера вашего сайта), чтобы это имело значение. Это может отличаться в зависимости от типа сайта, над которым вы работаете.

Убедитесь, что неиндексированная страница не потеряна

Страница-сирота — это страница, которая не отображается ни на карте сайта, ни во внутренних ссылках, ни в навигации и не может быть обнаружена Google ни одним из вышеперечисленных методов. .

Другими словами, это потерянная страница, которая не идентифицируется должным образом с помощью обычных методов сканирования и индексирования Google.

Как это исправить?

Если вы обнаружите, что страница является потерянной, вам необходимо восстановить ее. Вы можете сделать это, включив свою страницу в следующие места:

- Карта сайта XML.

- Навигация по верхнему меню.

- Обеспечение большого количества внутренних ссылок с важных страниц вашего сайта.

Сделав это, у вас будет больше шансов убедиться, что Google просканирует и проиндексирует эту потерянную страницу, включив ее в общий расчет рейтинга.

Исправить все внутренние ссылки nofollow

Хотите верьте, хотите нет, но nofollow буквально означает, что Google не будет переходить или индексировать эту конкретную ссылку. Если у вас их много, то вы тормозите индексацию Google страниц вашего сайта.

На самом деле существует очень мало ситуаций, когда вы должны использовать nofollow по внутренней ссылке. Добавление nofollow к вашим внутренним ссылкам — это то, что вы должны делать только в случае крайней необходимости.

Если подумать, как владелец сайта, вы контролируете свои внутренние ссылки. Зачем вам nofollow по внутренней ссылке, если это не страница вашего сайта, которую вы не хотите, чтобы посетители видели?

Например, подумайте о частной странице входа веб-мастера. Если пользователи обычно не заходят на эту страницу, вы не хотите включать ее в обычное сканирование и индексирование. Таким образом, это должно быть noindexed, nofollow и удалено из всех внутренних ссылок в любом случае.

Но если у вас много nofollow-ссылок, это может вызвать у Google вопрос о качестве, и в этом случае ваш сайт может быть помечен как более неестественный (в зависимости от серьезности nofollow-ссылок).

Если вы включаете nofollow в свои ссылки, то, вероятно, лучше их удалить.

Из-за этих nofollow вы говорите Google не доверять этим конкретным ссылкам.

Дополнительные сведения о том, почему эти ссылки не являются качественными внутренними ссылками, можно узнать из того, как Google в настоящее время обрабатывает ссылки nofollow.

Видите ли, долгое время существовал один тип ссылок nofollow, до недавнего времени, когда Google изменил правила и то, как классифицируются ссылки nofollow.

В новых правилах nofollow Google добавил новые классификации для различных типов ссылок nofollow.

Эти новые классификации включают пользовательский контент (UGC) и спонсируемую рекламу (рекламу).

В любом случае, с этими новыми классификациями nofollow, если вы их не включите, это может фактически быть сигналом качества, который Google использует, чтобы решить, следует ли индексировать вашу страницу.

Вы также можете запланировать их включение, если вы делаете интенсивную рекламу или пользовательский контент, например, комментарии в блогах.

А поскольку комментарии в блогах, как правило, генерируют много автоматического спама, сейчас самое время правильно пометить эти nofollow-ссылки на вашем сайте.

Убедитесь, что вы добавили мощные внутренние ссылки

Существует разница между обычной внутренней ссылкой и «мощной» внутренней ссылкой.

Обычная внутренняя ссылка — это просто внутренняя ссылка. Добавление многих из них может — или не может — сильно повлиять на ваш рейтинг целевой страницы.

Но что, если вы добавите ссылки со страниц, у которых есть обратные ссылки, передающие ценность? Даже лучше!

Что, если вы добавите ссылки с более мощных страниц, которые уже представляют ценность?

Вот как вы хотите добавить внутренние ссылки.

Почему внутренние ссылки так важны для SEO? По следующим причинам:

- Они помогают пользователям перемещаться по вашему сайту.

- Они передают полномочия с других страниц, обладающих большими полномочиями.

- Они также помогают определить общую архитектуру веб-сайта.

Перед случайным добавлением внутренних ссылок вы должны убедиться, что они мощные и имеют достаточную ценность, чтобы помочь целевым страницам конкурировать в результатах поиска.

Отправьте свою страницу в консоль поиска Google

Если у вас по-прежнему возникают проблемы с индексацией вашей страницы Google, вы можете рассмотреть возможность отправки своего сайта в консоль поиска Google сразу после того, как вы нажмете кнопку публикации.

Это позволит быстро сообщить Google о вашей странице, и это поможет вам сделать так, чтобы ваша страница была замечена Google быстрее, чем другие методы.

Кроме того, это обычно приводит к индексации в течение нескольких дней, если ваша страница не страдает от каких-либо проблем с качеством.

Это должно помочь двигаться в правильном направлении.

Используйте плагин мгновенного индексирования Rank Math

Чтобы быстро проиндексировать ваше сообщение, вы можете рассмотреть возможность использования плагина мгновенного индексирования Rank Math.

Использование плагина мгновенного индексирования означает, что страницы вашего сайта обычно быстро сканируются и индексируются.

Плагин позволяет сообщить Google о добавлении страницы, которую вы только что опубликовали, в приоритетную очередь сканирования.

Плагин мгновенного индексирования Rank Math использует API мгновенного индексирования Google.

Улучшение качества вашего сайта и процессов его индексации означает, что он будет оптимизирован для более быстрого ранжирования за более короткий промежуток времени

Улучшение индексации вашего сайта включает в себя уверенность в том, что вы улучшаете качество своего сайта, а также то, как он сканируется и индексируется.

Сюда также входит оптимизация краулингового бюджета вашего сайта.

Убедившись, что ваши страницы имеют самое высокое качество, что они содержат только сильный контент, а не заполняющий контент, и что они имеют надежную оптимизацию, вы увеличиваете вероятность того, что Google быстро проиндексирует ваш сайт.

Кроме того, сосредоточение ваших оптимизаций на улучшении процессов индексации с помощью плагинов, таких как Index Now, и других типов процессов также создаст ситуации, когда Google сочтет ваш сайт достаточно интересным, чтобы быстро просканировать и проиндексировать ваш сайт.

Правильная оптимизация этих типов элементов оптимизации контента означает, что ваш сайт будет принадлежать к тем сайтам, которые любит видеть Google, и значительно упростит достижение результатов индексации.

Дополнительные ресурсы:

- 14 основных причин, по которым Google не индексирует ваш сайт

- Как проиндексировать сайт перед запуском и почему это важно

- Продвинутое техническое SEO: полное руководство

Рекомендуемое изображение: BestForBest/Shutterstock

Категория Техническое SEO

Как ускорить индексацию Google? Как мы индексируем сайты наших клиентов в течение 48 часов?

Уже некоторое время наблюдаю проблемы с индексацией сайтов. Google официально сообщает об изменении алгоритмов индексации и заявляет, что задержки вызваны интенсивными тестами. Как решить эту проблему и проиндексировать свою страницу намного быстрее? Придется ли веб-сайтам платить за индексацию в будущем? В сегодняшней записи я проанализирую возможные сценарии и расскажу вам, что может быть в картах для вашего процесса SEO!

Google официально сообщает об изменении алгоритмов индексации и заявляет, что задержки вызваны интенсивными тестами. Как решить эту проблему и проиндексировать свою страницу намного быстрее? Придется ли веб-сайтам платить за индексацию в будущем? В сегодняшней записи я проанализирую возможные сценарии и расскажу вам, что может быть в картах для вашего процесса SEO!

Содержание

- Является ли индексирование Google бесплатным?

- Как ускорить индексирование Google — новые решения

- API Google

- Не только Google

- Как работать с Google API?

- Чем отличается Google Indexing API?

- API Google — что это значит для обычных пользователей?

- Придется ли нам платить за индексирование страниц в Google?

- Возможные сценарии будущего платной индексации Google

- Преимущества платной индексации в будущем

- Возможные сценарии будущего платной индексации Google

- Еда на вынос

Чему вы научитесь?

- Как Google в настоящее время индексирует веб-сайты,

- Что такое Google Indexing API и как его использовать,

- Как нам удалось ускорить индексацию веб-сайтов для наших клиентов без использования Google API,

- Если индексирование Google, вероятно, будет платным в будущем.

Является ли индексирование Google бесплатным? Да, но… Проблемы с индексацией Google – предварительный обзор того, что может случиться

Знаете, почему я вообще решил написать эту запись? Вы слышали, что Google отозвал инструмент отправки URL?

Это, в свою очередь, привело к проблемам с индексацией веб-сайтов, которые впервые были замечены в октябре 2021 года.

Что они означают в реальной жизни? Проще говоря, владельцам веб-сайтов приходится намного дольше ждать, пока их страницы и контент будут просканированы и проиндексированы роботами поисковых систем.

Вы видите? Я не единственный, кто заметил проблему. Владельцы веб-сайтов и SEO-специалисты со всего мира изо всех сил пытаются найти эффективный рецепт индексации своих страниц.

Создатели контента, владельцы интернет-магазинов и многие другие специалисты испытывают трудности с индексированием нового контента, продуктов, категорий, сообщений в блогах и других материалов.

Согласно официальному заявлению Google, алгоритм был изменен, что негативно сказалось на индексации. Тем не менее, поисковик обещает, что все вернется на круги своя и снова заработает без проблем.

Стоит также отметить, что многие специалисты заметили, что хотя Google Search Console предлагает возможность скачать страницу и отправить ее на индексацию, это всего лишь предложение для Google и часто не принимается во внимание.

До октября 2021 года каждый такой запрос приводил к посещению сайта роботами поисковых систем примерно в течение 48 часов. Однако это уже не так.

Я неоднократно замечал, что материалы, опубликованные на сайтах наших клиентов, не индексировались даже три месяца.

Кроме того, на этот период также повлияли многочисленные факторы, такие как отрасль или краулинговый бюджет конкретного веб-сайта.

Как вы знаете, чем выше авторитет вашего сайта, тем больше его краулинговый бюджет , по крайней мере теоретически. Это означает, что Google должен посещать его чаще.

Это означает, что Google должен посещать его чаще.

Однако часто реальность не имеет ничего общего с теорией. Даже крупные и авторитетные веб-сайты с внушительным краулинговым бюджетом сообщали о проблемах с индексацией.

Поэтому многие отраслевые эксперты (включая меня) начали задаваться вопросом, как справиться с проблемой, не прибегая к незаконным трюкам с черной шляпой SEO.

Как ускорить индексирование Google — новые решения

Я решил разобраться в проблеме и поискать самостоятельное решение, которое позволило бы мне эффективно индексировать сайты клиентов, не полагаясь на алгоритм Google, их модификации и недавно разработанный API индексирования.

Ищете эффективные инструменты для быстрой индексации? Прочтите сегодняшнюю статью, чтобы узнать, как я ускорил индексацию Google на сайтах моих клиентов.

API Google

Что такое API Google? Indexing API (интерфейс прикладного программирования) был создан Google и предоставляет владельцам сайтов возможность уведомлять поисковую систему, когда они добавляют или удаляют страницу. Предполагается, что это упростит процесс индексации.

Предполагается, что это упростит процесс индексации.

Где его найти? Проверьте библиотеку API Google Cloud Console:

Выше вы можете увидеть скриншоты из интерфейса Google, показывающие, где вы можете найти API.

Этот API можно использовать для различных веб-сайтов, и он взаимодействует с Google Search Console. Он обещает уведомлять поисковую систему каждый раз, когда ваш сайт изменяется, что должно улучшить индексацию URL.

Не только Google

Что делать, если решение, предлагаемое Google, не соответствует вашим ожиданиям? Не волнуйся!

Уже есть SEO-инструменты и скрипты, которые можно написать на python. Rank Math и его «Indexing Now» можно использовать для связи с Bing, который разрабатывает сервис, конкурирующий с инструментом Google.

Bing предлагает решение для настоящих магнатов, таких как Amazon, чтобы помочь им быстро индексировать новые продукты, категории или другие элементы контента, которые появляются на сайте.

Кажется, что это недавно разработанное решение весьма эффективно, и Google следует по его стопам, пытаясь придумать более совершенный и совершенный инструмент.

Rank Math, который уже включал варианты для связи с Bing, также представил возможность для связи с Google API.

Как работать с Google API?

Вам интересно, как начать свое приключение с Google API? Вам нужно будет создать ключ API и настроить его для своего домена, подключив его к Google Search Console (здесь требуется подтверждение домена).

При этом у вас должны быть следующие уровни доступа: Владелец – как в Google Search Console, так и в проекте, настроенном в Google Cloud:

Чтобы узнать больше об Indexing API, разработанном Google, посетите: https://developers.google.com/search/apis/indexing-api/v3/quickstart?hl=en_US

Чем отличается Google API индексирования?

Хотя Google рекомендует загружать карту сайта, Indexing API предлагает роботу Googlebot индексировать страницы до обновления карты сайта.

Кроме того, стоит отметить, что карта сайта часто не меняется, так как URL-адрес остается прежним, а изменяется только контент сайта (добавление нового контента, его оптимизация для SEO, изменение внутренних ссылок, доработка UX и т. д.) .

Следовательно, вы хотите сообщить Google об этих изменениях, чтобы он быстро посетил сайт и проиндексировал его актуальную версию.

В случае с многочисленными интернет-магазинами очень важно немедленно индексировать новые продукты, записи в блогах или обзоры, и это невозможно сделать за несколько дней, не говоря уже о нескольких месяцах.

В процессе SEO мы стремимся обеспечить быструю индексацию веб-сайтов, продуктов и сообщений в блогах наших клиентов.

Вот почему мы постоянно работаем над увеличением краулинговых бюджетов наших клиентов и разрабатываем эффективный инструмент индексации, совместимый с Google и эффективно работающий независимо от CMS (будь то WordPress, Magento, Shopify или пользовательская CMS).

Хотя Интернет изобилует индексаторами и решениями, которые были разработаны несколько лет назад, они довольно сомнительны и полагаются на черную SEO-оптимизацию.

Что это значит? Они используют PBN и автоматические системы связывания (включая SWL) для поддержки индексации. Как вы, наверное, знаете, Google не одобряет такие действия и знает, что они искусственные.

Следовательно, частое использование таких индексаторов может дать обратный результат. Ваш сайт не будет проиндексирован, и на него дополнительно попадут спамные ссылки.

Что примечательного в Google Indexing API? Это ценный источник информации об индексации вашего сайта.

Помимо того, что вы видите, что API действительно поддерживает индексацию сайта, вы получаете представление о процессе сканирования, его частоте и эффективности (например, информацию о частоте ошибок и т. д.)

Ниже вы можете увидеть скриншоты со статистикой индексации наших клиентов ‘ веб-сайты после использования Google API:

Это один из сайтов наших клиентов, на котором мы внедрили API. Как только это было реализовано, поисковые роботы начали посещать сайт (ниже вы также можете увидеть скриншоты, показывающие количество проиндексированных страниц до и после использования Google Indexing API):

Как только это было реализовано, поисковые роботы начали посещать сайт (ниже вы также можете увидеть скриншоты, показывающие количество проиндексированных страниц до и после использования Google Indexing API):

Проиндексированные страницы нашего клиента до внедрения API решение – сайт сервиса

Те же проиндексированные страницы клиента после внедрения API решение – сайт сервиса

Количество проиндексированных страниц до внедрения решения API – клиент электронной коммерции

Количество проиндексированных страниц после внедрения решения API – клиент электронной торговли

Чтобы убедиться, что API работает, давайте взглянем на воздействия других SEO-специалистов:

Конечно, при тестировании решения мы в первую очередь отслеживаем его влияние на сайты наших клиентов.

API Google — что это значит для обычных пользователей?

Google постоянно расширяет свои услуги. Indexing API был выпущен совсем недавно и, безусловно, будет использоваться для оптимизации связи между индексаторами и веб-сайтами.

Такой ход событий имеет смысл, поскольку Google сталкивается с многочисленными проблемами с ресурсами.

Учитывая, сколько миллионов страниц создается ежедневно, для поисковой системы может оказаться невозможным посетить и просканировать их все, удаляя спам или автоматически созданные сайты, которые не представляют никакой ценности для пользователей.

Такой Indexing API может быть эффективным решением, поскольку в конечном итоге только сайты, использующие его, смогут отправлять запросы на индексацию robots. Таким образом, Google будет знать, что имеет дело с качественным, надежным веб-сайтом, который нужно быстро просканировать.

Придется ли нам платить за индексирование страниц в Google?

Несмотря на то, что существует множество инструментов и решений, временно решающих проблему индексации веб-сайтов, очень важно рассмотреть эту проблему более внимательно, поскольку:

- Google Indexing API предоставляется бесплатно только в ограниченном диапазоне.

Это означает, что вы можете запросить индексацию определенного количества страниц. В настоящее время ограничения проверяются, но это может указывать на то, что более крупные игроки и владельцы более крупных веб-сайтов должны будут платить за использование инструмента и индексацию всех своих страниц в будущем.

Это означает, что вы можете запросить индексацию определенного количества страниц. В настоящее время ограничения проверяются, но это может указывать на то, что более крупные игроки и владельцы более крупных веб-сайтов должны будут платить за использование инструмента и индексацию всех своих страниц в будущем. - Хотите узнать мою теорию? Поскольку Google должен использовать свои ресурсы для индексации определенной страницы, он может потребовать от нас оплаты этих ресурсов.

Возможные сценарии будущего платной индексации Google

Не о чем беспокоиться! Даже если Google захочет, чтобы мы заплатили за индексацию веб-сайта, это, вероятно, не будет большой суммой.

Даже сегодня существует множество систем, использующих Google API (например, рекламные системы, CMS, инструменты для управления фидами продуктов или мониторинга ключевых слов), которые позволяют вам получать доступ, управлять и отслеживать ограниченные данные. Это означает, что если вы хотите увидеть всю базу данных, вам придется заплатить за ресурсы.

Это означает, что если вы хотите увидеть всю базу данных, вам придется заплатить за ресурсы.

По всей вероятности, Google будет стремиться сделать решение как можно более популярным и широко используемым, чтобы гарантировать, что крупные платформы, такие как WordPress или Magento, будут полагаться на API или создавать плагины и взимать за них абонентскую плату.

Сколько вам нужно будет заплатить? Я ожидаю суммы от 5 до 15 долларов в месяц. Для крупных и качественных веб-сайтов такие сборы не должны быть проблемой.

Хотите узнать еще более вероятный сценарий? На мой взгляд, весьма вероятно, что популярные CMS начнут предоставлять пользователям готовые API Google. Он будет доступен либо в виде платных инструментов CMS, либо в виде специальных платных плагинов.

Что делать, если вы не используете популярную CMS? Не волнуйтесь, при профессиональной поддержке разработчиков веб-сайтов вы сможете писать специальные скрипты, интегрировать Google API со своей страницей и самостоятельно оплачивать индексацию.

В Delante, сразу после запуска Google Indexing API, мы начали разработку собственного приложения для дальнейшего ускорения индексации веб-сайтов для наших клиентов. Он был создан на основе структурированного процесса:

Интерфейс приложения для индексации Delante.

Этот инструмент позволяет нам эффективно и действенно отправлять веб-сайты клиентов на индексацию. Кроме того, это ценный источник информации о статусе индексации и возможных проблемах, которые могут возникнуть на сайте:

Честно говоря, хотя процесс разработки инструмента был трудоемким и энергозатратным, сок определенно стоил того. сжимать.

В настоящее время мы можем проиндексировать важные страницы наших клиентов уже в течение 6-48 часов, тогда как раньше нам приходилось ждать этого даже несколько месяцев.

Хотите попробовать наше приложение для индексации? Воспользуйтесь услугами индексации веб-сайтов!

Преимущества платной индексации в будущем

Что, если мой прогноз окажется верным и индексация веб-сайта будет платной? Не помешает ли это работе SEO-специалистов?

Не обязательно!

Платная индексация веб-сайтов имеет множество преимуществ:

- Благодаря платному решению Google сможет быстро выявлять все спамерские, автоматически созданные веб-сайты, которые не представляют никакой ценности для пользователей.

Как? Такие сайты, вероятно, даже не захотят внедрять Google API, так как для этого требуется авторизация GSC.

Как? Такие сайты, вероятно, даже не захотят внедрять Google API, так как для этого требуется авторизация GSC. - Следовательно, поисковая система сможет сэкономить большую часть своих ресурсов, которые раньше выделялись для индексации спам-сайтов.

- Владельцы веб-сайтов смогут спать спокойно, зная, что их краулинговый бюджет управляется более эффективно, а страницы действительно индексируются.

- В целом, это может быть хорошим источником дохода для Google, который принесет пользу и пользователям. Как это возможно? С одной стороны, владельцам веб-сайтов и интернет-магазинов будет предоставлен простой и эффективный способ управления процессами индексации. С другой стороны, поисковая система сможет выявлять некачественные сайты со спамом и получать дополнительный доход, не обременяя пользователей, предлагающих ценный контент.

Вывод

Последние несколько месяцев многие специалисты отрасли наблюдают серьезные проблемы с индексацией веб-сайтов.

Это позволит ботам добраться до всех страниц сайта и добавить их в свою базу.

Это позволит ботам добраться до всех страниц сайта и добавить их в свою базу. На загруженном хостинге снижается скорость обработки запросов от робота.

На загруженном хостинге снижается скорость обработки запросов от робота.

Когда ошибка распространяется на многие тысячи страниц, поздравляем! Вы потратили краулинговый бюджет на то, чтобы убедить Google, что эти страницы нужно сканировать, тогда как на самом деле Google должен был сканировать другие страницы.

Когда ошибка распространяется на многие тысячи страниц, поздравляем! Вы потратили краулинговый бюджет на то, чтобы убедить Google, что эти страницы нужно сканировать, тогда как на самом деле Google должен был сканировать другие страницы.

Это означает, что вы можете запросить индексацию определенного количества страниц. В настоящее время ограничения проверяются, но это может указывать на то, что более крупные игроки и владельцы более крупных веб-сайтов должны будут платить за использование инструмента и индексацию всех своих страниц в будущем.

Это означает, что вы можете запросить индексацию определенного количества страниц. В настоящее время ограничения проверяются, но это может указывать на то, что более крупные игроки и владельцы более крупных веб-сайтов должны будут платить за использование инструмента и индексацию всех своих страниц в будущем. Как? Такие сайты, вероятно, даже не захотят внедрять Google API, так как для этого требуется авторизация GSC.

Как? Такие сайты, вероятно, даже не захотят внедрять Google API, так как для этого требуется авторизация GSC.