| ||||||||||||

4 программы для скачивания сайтов

Эти четыре программы помогут вам загрузить практически любой сайт к себе на компьютер. Очень полезно, если вы боитесь потерять доступ к любимым статьям, книгам, инструкциям и всему остальному, что могут удалить или заблокировать.

HTTrack позволяет пользователям загружать сайт из интернета на жесткий диск. Программа работает путем копирования содержимого всего сайта, а затем загружает все каталоги, HTML, изображения и другие файлы с сервера сайта на ваш компьютер.

При просмотре скопированного сайта HTTrack поддерживает исходную структуру ссылок сайта. Это позволяет пользователям просматривать его в обычном браузере. Кроме того, пользователи могут нажимать на ссылки и просматривать сайт точно так же, как если бы они смотрели его онлайн.

HTTrack также может обновлять ранее загруженные сайты, а также возобновлять любые прерванные загрузки. Приложение доступно для Windows, Linux и даже для устройств на базе Android.

Если вы твердо придерживаетесь экосистемы Apple и имеете доступ только к Mac, вам нужно попробовать SiteSucker. Программа, получившая такое название, копирует все файлы веб-сайта на жесткий диск. Пользователи могут начать этот процесс всего за несколько кликов, что делает его одним из самых простых в использовании инструментов. Кроме того, SiteSucker довольно быстро копирует и сохраняет содержимое сайта. Однако помните, что фактическая скорость загрузки будет зависеть от пользователя.

К сожалению, SiteSucker не лишен недостатков. Во-первых, SiteSucker — платное приложение. На момент написания этой статьи SiteSucker стоит $4.99 в App Store. Кроме того, SiteSucker загружает каждый файл на сайте, который может быть найден. Это означает большую загрузку с большим количеством потенциально бесполезных файлов.

Во-первых, SiteSucker — платное приложение. На момент написания этой статьи SiteSucker стоит $4.99 в App Store. Кроме того, SiteSucker загружает каждый файл на сайте, который может быть найден. Это означает большую загрузку с большим количеством потенциально бесполезных файлов.

Cyotek WebCopy — инструмент, позволяющий пользователям копировать полные версии сайтов или только те части, которые им нужны. К сожалению, приложение WebCopy доступно только для Windows, но зато оно является бесплатным. Использовать WebCopy достаточно просто. Откройте программу, введите целевой URL-адрес и все.

Кроме того, WebCopy имеет большое количество фильтров и опций, позволяющих пользователям скачивать только те части сайта, которые им действительно нужны. Эти фильтры могут пропускать такие вещи, как изображения, рекламу, видео и многое другое, что может существенно повлиять на общий размер загрузки.

Этот граббер с открытым исходным кодом существует уже давно, и на это есть веские причины.

GetLeft очень удобен для пользователя, что и объясняет его долговечность. Для начала просто запустите программу и введите URL-адрес сайта, затем GetLeft автоматически анализирует веб-сайт и предоставит вам разбивку страниц, перечисляя подстраницы и ссылки. Затем вы можете вручную выбрать, какие части сайта вы хотите загрузить, установив соответствующий флажок.

После того, как вы продиктовали, какие части сайта вы хотите зазрузить, нажмите на кнопку. GetLeft загрузит сайт в выбранную вами папку. К сожалению, GetLeft не обновлялся какое-то время.

Спасибо, что читаете! На данный момент большинство моих заметок, статей и подборок выходит в telegram канале «Левашов». Обязательно подписывайтесь, чтобы не пропустить новости мира ИТ, полезные инструкции и нужные сервисы.

Хотите больше постов в блоге? Подборок софта и сервисов, а также обзоры на гаджеты? Сейчас, чтобы писать регулярно и радовать вас большими обзорами, мне требуется помощь.

Заранее спасибо! Все собранные средства будут пущены на развитие сайта. Поддержка проекта является подарком владельцу сайта.

7 бесплатных инструментов для загрузки целых веб-сайтов для использования в автономном режиме или резервного копирования

При сегодняшней скорости Интернета и ответственности не так много причин загружать весь веб-сайт для использования в автономном режиме. Возможно, вам нужна копия сайта в качестве резервной копии или вам нужно отправиться куда-нибудь в отдаленное место, эти инструменты позволят вам загрузить весь сайт для чтения в автономном режиме.

🤣😍😂 60 лучших веб-сайтов для бесплатной загрузки электронных книг в формате ePub и PDF

Вот краткий список некоторых из лучших веб-сайтов, загружающих программное обеспечение для начала работы. HTTrack — лучший и любимец многих уже много лет.

HTTrack — лучший и любимец многих уже много лет.

↓ 01 — HTTrack |

Окна | макОС | LinuxHTTrack — бесплатная (GPL, свободное/свободное программное обеспечение) и простая в использовании автономная утилита браузера. Он позволяет вам загружать сайт World Wide Web из Интернета в локальный каталог, рекурсивно создавая все каталоги, получая HTML, изображения и другие файлы с сервера на ваш компьютер. HTTrack упорядочивает относительную ссылочную структуру исходного сайта. Просто откройте страницу «зеркального» веб-сайта в своем браузере, и вы сможете просматривать сайт от ссылки к ссылке, как если бы вы просматривали его онлайн. HTTrack также может обновлять существующий зеркальный сайт и возобновлять прерванные загрузки. HTTrack полностью настраивается и имеет встроенную справочную систему.

↓ 02 – Архивная коробка |

Окна | макОС | Linux ArchiveBox — это мощное решение для интернет-архивирования, предназначенное для сбора, сохранения и просмотра сайтов, которые вы хотите сохранить в автономном режиме. Вы можете настроить его как инструмент командной строки, веб-приложение и настольное приложение (альфа-версия) в Linux, macOS и Windows. Вы можете передавать ему URL-адреса по одному или запланировать регулярный импорт из закладок или истории браузера, таких каналов, как RSS, сервисов закладок, таких как Pocket/Pinboard, и других. См. форматы ввода для полного списка.

Вы можете настроить его как инструмент командной строки, веб-приложение и настольное приложение (альфа-версия) в Linux, macOS и Windows. Вы можете передавать ему URL-адреса по одному или запланировать регулярный импорт из закладок или истории браузера, таких каналов, как RSS, сервисов закладок, таких как Pocket/Pinboard, и других. См. форматы ввода для полного списка.

Он сохраняет моментальные снимки URL-адресов, которые вы ему подаете, в нескольких форматах: HTML, PDF, скриншоты PNG, WARC и т. д., при этом широкий спектр контента извлекается и сохраняется автоматически (текст статьи, аудио/ видео, репозитории git и т. д.). См. выходные форматы для полного списка. Цель состоит в том, чтобы спать спокойно, зная, что часть Интернета, которая вам небезразлична, будет автоматически сохранена в надежных, легкодоступных форматах в течение десятилетий после того, как она выйдет из строя.

Cyotek WebCopy — это бесплатный инструмент для локального копирования полных или частичных веб-сайтов на жесткий диск для просмотра в автономном режиме. WebCopy просканирует указанный веб-сайт и загрузит его содержимое на ваш жесткий диск. Ссылки на такие ресурсы, как таблицы стилей, изображения и другие страницы веб-сайта, будут автоматически переназначены в соответствии с локальным путем. Используя его обширную конфигурацию, вы можете определить, какие части веб-сайта будут скопированы и как.

WebCopy просканирует указанный веб-сайт и загрузит его содержимое на ваш жесткий диск. Ссылки на такие ресурсы, как таблицы стилей, изображения и другие страницы веб-сайта, будут автоматически переназначены в соответствии с локальным путем. Используя его обширную конфигурацию, вы можете определить, какие части веб-сайта будут скопированы и как.

WebCopy проверит HTML-разметку веб-сайта и попытается обнаружить все связанные ресурсы, такие как другие страницы, изображения, видео, загрузки файлов — все и вся. Он загрузит все эти ресурсы и продолжит поиск других. Таким образом, WebCopy может «сканировать» весь веб-сайт и загружать все, что он видит, чтобы создать приемлемое факсимиле исходного веб-сайта.

↓ 04 – UnMHT |

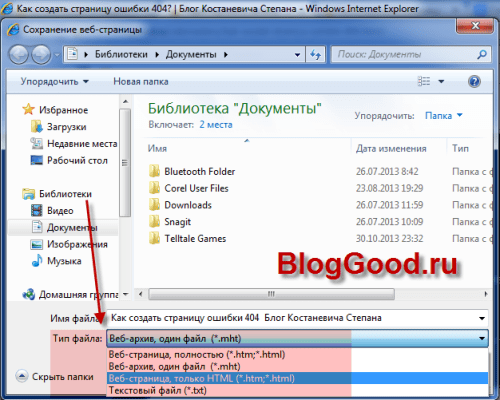

Надстройка Firefox UnMHT позволяет просматривать файлы формата веб-архива MHT (MHTML) и сохранять полные веб-страницы, включая текст и графику, в один файл MHT в Firefox/SeaMonkey. MHT (MHTML, RFC2557) — это формат архива веб-страницы для хранения HTML и изображений, CSS в одном файле.

- Сохранить веб-страницу как файл MHT.

- Вставьте URL-адрес веб-страницы и дату, которую вы сохранили в сохраненный файл MHT.

- Одновременное сохранение нескольких вкладок в виде файлов MHT.

- Сохранение нескольких вкладок в один файл MHT.

- Сохранение веб-страницы одним щелчком мыши в предварительно указанном каталоге с функцией быстрого сохранения.

- Преобразовать файлы HTML и каталог, содержащий файлы, используемые HTML, в файл MHT.

- Просмотр файла MHT, сохраненного UnMHT, IE, PowerPoint и т. д.

↓ 05 – захват |

macOS | Linux Grab-site — это простой предварительно настроенный поисковый робот, предназначенный для резервного копирования веб-сайтов. Дайте сайту захвата URL-адрес, и он будет рекурсивно сканировать сайт и записывать файлы WARC. Внутри Grab-Site использует форк wpull для сканирования. Grab-site — это поисковый робот для архивирования веб-сайтов в файлы WARC. Он включает в себя панель инструментов для мониторинга нескольких обходов и поддерживает изменение шаблонов игнорирования URL-адресов во время обхода.

Он включает в себя панель инструментов для мониторинга нескольких обходов и поддерживает изменение шаблонов игнорирования URL-адресов во время обхода.

↓ 06 – WebScrapBook |

Окна | макОС | LinuxWebScrapBook — это расширение для браузера, которое точно захватывает веб-страницу с различными форматами архивов и настраиваемыми конфигурациями. Этот проект унаследован от устаревшего дополнения Firefox ScrapBook X. Веб-страницу можно сохранить в виде папки, архивного файла в формате zip (HTZ или MAFF) или отдельного HTML-файла (опционально в качестве расширения). Архивный файл можно просмотреть, открыв индексную страницу после распаковки, используя встроенную программу просмотра архивных страниц или другие вспомогательные инструменты.

↓ 07 – Архиварикс |

200 файлов бесплатно | Онлайн Загрузчик веб-сайтов и система управления контентом (CMS), конвертер существующих сайтов. Загрузите весь живой веб-сайт — 200 файлов бесплатно! Возможность загрузки . onion сайтов! Их система загрузки веб-сайтов позволяет бесплатно загружать до 200 файлов с веб-сайта. Если файлов на сайте больше и все они вам нужны, то вы можете оплатить эту услугу. Стоимость скачивания зависит от количества файлов. Вы можете скачать с существующих веб-сайтов, Wayback Machine или Google Cache.

onion сайтов! Их система загрузки веб-сайтов позволяет бесплатно загружать до 200 файлов с веб-сайта. Если файлов на сайте больше и все они вам нужны, то вы можете оплатить эту услугу. Стоимость скачивания зависит от количества файлов. Вы можете скачать с существующих веб-сайтов, Wayback Machine или Google Cache.

↓ 08 – Загрузчик веб-сайтов [Не бесплатно] |

OnlineЗагрузчик веб-сайтов, копировщик веб-сайтов или Ripper веб-сайтов позволяет загружать веб-сайты из Интернета на локальный жесткий диск вашего компьютера. Загрузчик веб-сайтов упорядочивает загруженный сайт по относительной структуре ссылок исходного веб-сайта. Загруженный веб-сайт можно просмотреть, открыв одну из HTML-страниц в браузере.

После клонирования веб-сайта на жесткий диск вы можете открыть исходный код веб-сайта с помощью редактора кода или просто просмотреть его в автономном режиме с помощью выбранного вами браузера. Site Downloader можно использовать для разных целей. Использовать программное обеспечение для загрузки с веб-сайта действительно просто, ничего не загружая.

Использовать программное обеспечение для загрузки с веб-сайта действительно просто, ничего не загружая.

- Резервные копии. Если у вас есть веб-сайт, у вас всегда должна быть свежая резервная копия веб-сайта на случай, если сервер сломается или вас взломают. Загрузчик веб-сайтов — это самый быстрый и простой способ сделать резервную копию вашего веб-сайта, он позволяет загружать весь веб-сайт.

- Автономный загрузчик веб-сайтов — загрузите веб-сайт в автономном режиме для дальнейшего использования, к которому вы можете получить доступ, скажем, даже без подключения к Интернету. когда вы в полете или на отдыхе на острове!

Обновлено 2 февраля 2023 г. / Категория: Веб-инструменты, сервисы и ресурсы / Автор: Ngan Tengyuen

лучших рипперов сайтов | Octoparse

Иногда вам нужно загрузить веб-контент с веб-сайта для просмотра в автономном режиме или последующего использования. В других случаях вам может даже понадобиться вся копия сайта в качестве резервной копии. Возможно, вам понадобится риппер веб-сайта, чтобы частично или полностью загрузить веб-сайт в локальное хранилище для доступа в автономном режиме. В этой статье мы представим 4 простых в использовании рипперов веб-сайтов в Интернете.

Возможно, вам понадобится риппер веб-сайта, чтобы частично или полностью загрузить веб-сайт в локальное хранилище для доступа в автономном режиме. В этой статье мы представим 4 простых в использовании рипперов веб-сайтов в Интернете.

Что такое Ripper для веб-сайтов

Легко получать обновленный контент с веб-сайта в режиме реального времени с помощью RSS-канала. Однако есть еще один способ, который поможет вам быстрее получить любимый контент под рукой. Риппер веб-сайта позволяет вам загрузить весь веб-сайт и сохранить его на жестком диске для просмотра без подключения к Интернету. Есть три основные структуры — последовательности, иерархии и сети, которые используются для создания веб-сайта. Эти структуры будут определять, как информация будет отображаться и организовываться. Ниже приведен список из 4 лучших программ для копирования веб-сайтов в 2022 году. Список основан на простоте использования, популярности и функциональности.

4 лучших простых в использовании рипперов веб-сайтов

1. Октопарс

Октопарс Octoparse — это простой и интуитивно понятный инструмент для извлечения данных из веб-сайтов без написания кода. Его можно использовать как в системах Windows, так и в Mac OS, что соответствует потребностям парсинга веб-страниц на различных типах устройств. Независимо от того, являетесь ли вы начинающим самостоятельно, опытным экспертом или владельцем бизнеса, он удовлетворит ваши потребности благодаря обслуживанию корпоративного класса за 3 шага в расширенном режиме:

Шаг 1: Загрузите и зарегистрируйте этот риппер сайта без кодирования бесплатно.

Шаг 2: Откройте веб-страницу, которую нужно очистить, и скопируйте URL-адрес. Затем вставьте URL-адрес в Octoparse и запустите автоочистку. Позже настройте поле данных в режиме предварительного просмотра или в рабочем процессе справа.

Шаг 3: Начните очистку, нажав кнопку «Выполнить». Собранные данные можно загрузить в файл Excel на локальное устройство.

Для опытных профессионалов «Расширенный режим» поможет вам настроить собственный поисковый робот. Чтобы устранить трудности с настройкой и использованием, Octoparse добавляет Web Scraping Templates , охватывающий более 30 веб-сайтов для начинающих, чтобы освоиться с программным обеспечением. Они позволяют пользователям собирать данные без настройки задачи. С Octoparse вы можете извлекать данные корпоративного тома за считанные минуты. Кроме того, вы можете настроить Scheduled Cloud Extraction , который позволит вам получать динамические данные в режиме реального времени и вести запись отслеживания.

Веб-сайт для загрузки: https://www.octoparse.com/download

Истории клиентов: https://www. octoparse.com/CustomerStories

octoparse.com/CustomerStories

Минимальные требования:

Windows 10, 8, 7, XP, Mac OS

Microsoft .NET Framework 3.5 SP1

56 МБ свободного места на жестком диске

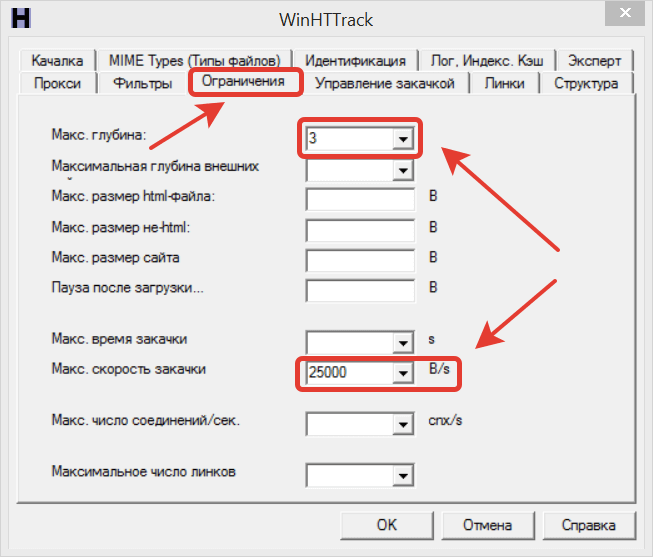

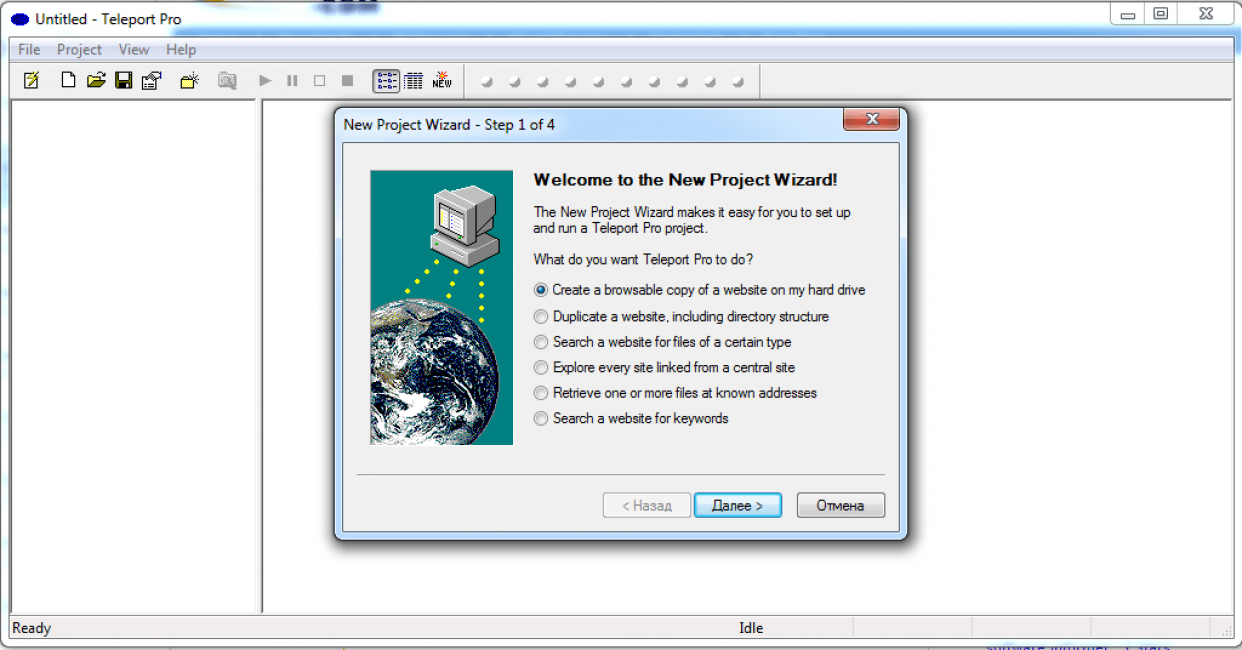

2. HTTrackHTTrack — очень простая, но мощная бесплатная программа для копирования веб-сайтов. Он может загрузить весь веб-сайт из Интернета на ваш компьютер. Начните с Wizard и следуйте настройкам. Вы можете указать количество одновременных подключений при загрузке веб-страниц в разделе «Установить параметр». Вы можете получить фотографии, файлы и HTML-код из всех каталогов, обновить текущий зеркальный веб-сайт и возобновить прерванные загрузки.

Недостаток его в том, что его нельзя использовать для загрузки ни одной страницы сайта. Вместо этого он загрузит весь корень веб-сайта. Кроме того, требуется некоторое время, чтобы вручную исключить типы файлов, если вы просто хотите загрузить определенные.

Веб-сайт: http://www.httrack.com/

Минимальные требования:

Windows 10, 8.1, 8, 7, Vista SP2

Microsoft .NET Framework 4.6

20 МБ свободного места на жестком диске

3. Cyotek WebCopyWebCopy — это программа для копирования веб-сайтов, которая позволяет частично или полностью копировать веб-сайты локально для чтения в автономном режиме. Он исследует структуру веб-сайтов, а также связанные ресурсы, включая таблицы стилей, изображения, видео и многое другое. И этот связанный ресурс будет автоматически переназначаться в соответствии с его локальным путем.

Недостатком этого является то, что Cyotek WebCopy не может анализировать/сканировать/вычищать веб-сайты, использующие Javascript или любые другие с динамическими функциями. Он не может очистить необработанный исходный код веб-сайта, а только то, что он отображает в браузере.

Веб-сайт: https://www.

72

72 07.2017

07.2017