Как проверить индексацию всего сайта и конкретной страницы в Яндексе и Google: инструкция по сервисам и рекомендации

Технические доработки под требования SEO и оптимизация структуры сайта – это первостепенные моменты в продвижении ресурса, но если поисковые системы не знают о нем, то есть он не проиндексирован, то продвижение невозможно.

Что же такое индексация? Это добавление поисковыми роботами собранных сведений о ресурсе в базы данных. Дальнейшее ранжирование происходит уже по проиндексированным страницам. Предлагаем несколько простых и понятных способов проверки страниц, которые «видят» поисковые системы.

Рассмотрим каждый вариант подробнее.

Оглавление:

-

Проверка индексирования сайта через панель Яндекс.Вебмастера и Google Search Console

-

Проверка количества проиндексированных страниц в ПС при помощи операторов

-

Анализ индексации сайта при помощи плагинов и расширений

-

Отслеживание проиндексированных страниц с помощью online сервисов

-

Программы для контроля индексации сайта

-

Проверка индексации страницы

-

Почему сайт может не индексироваться

-

Выводы SEO-специалиста Веб-центра

1. Проверка индексирования сайта через панель Яндекс.Вебмастера и Google Search Console

Бесплатный и достоверный способ с использованием сервисов для вебмастеров.

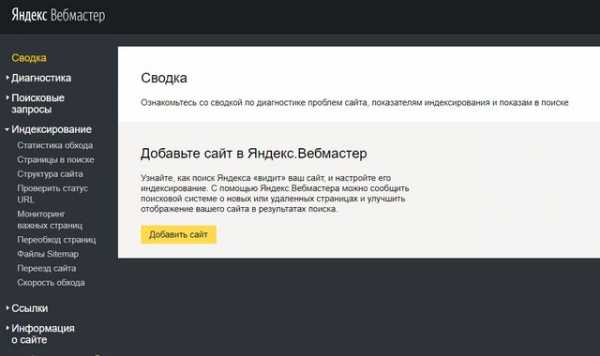

Яндекс.Вебмастер

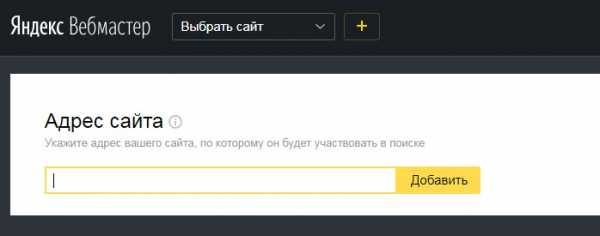

В первую очередь выполняем авторизацию в аккаунте Яндекса и входим в сервис Вебмастер. Далее вводим url ресурса и нажимаем кнопку «Добавить».

Добавление сайта в вебмастер Яндекса

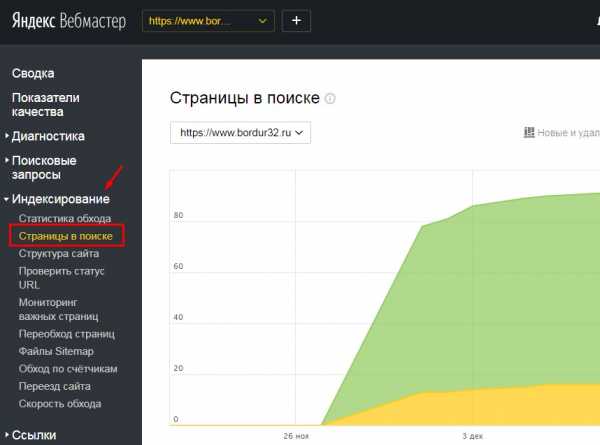

После прохождения верификации переходим в панель и нажимаем вкладку «Индексирование» – «Страницы в поиске». Тут представлены страницы веб-сайта, участвующие в поиске Яндекса.

Просмотр страниц в поиске Яндекса через панель для вебмастеров

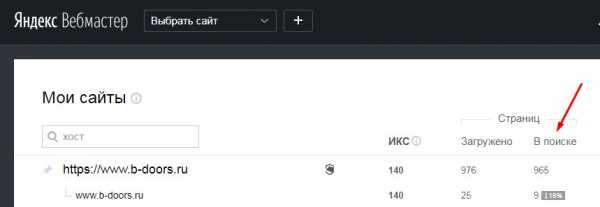

Также количество загруженных и проиндексированных страниц можно посмотреть в сервисе на странице «Мои сайты».

Просмотр количества страниц в поиске на вкладке «Мои сайты»

Для анализа список страниц можно скачать из сервиса файлом в форматах .xls и .csv.

Google Search Console

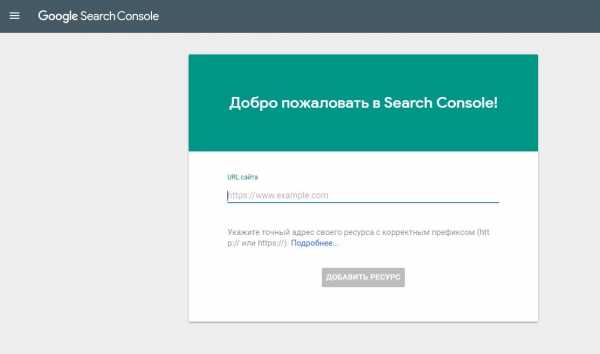

Аналогично вебмастеру Яндекса проходим авторизацию в аккаунте Google, входим в сервис search.google, вводим url сайта и нажимаем кнопку «Добавить ресурс».

Пример верификации в панели вебмастеров в Гугл

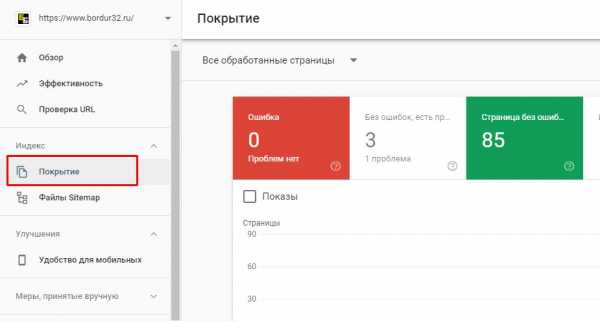

После подтверждения прав на сайт для проверки индексации ресурса в панели Вебмастера Гугл переходим во вкладку «Индекс» – «Покрытие».

Просмотр страниц в ПС Гугл через панель для вебмастеров

Нужно учитывать, что информация в Google Search Console примерная, так как в отчете показывается статистика после последнего обхода, то есть количество страниц может быть другим на текущий момент проверки.

Примеры проверки индексации сайта

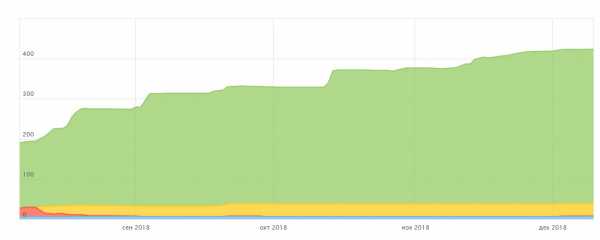

На скриншоте – сайт, у которого нет проблем с индексацией в Яндексе

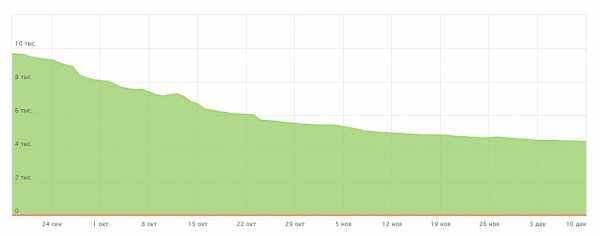

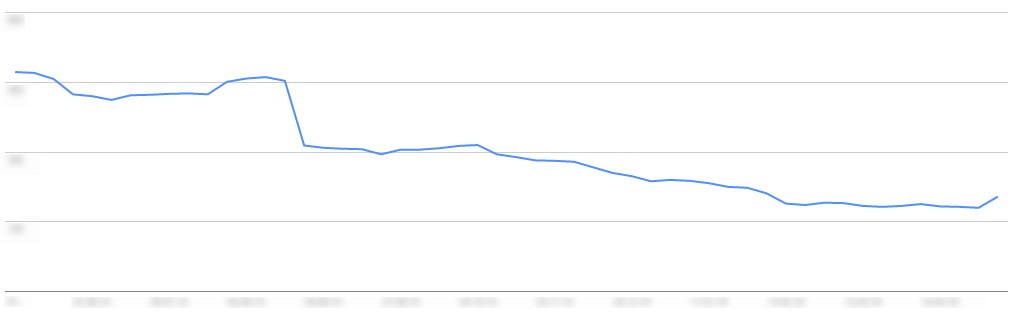

На скриншоте – сайт, у которого регулярно удаляются страницы из поиска Яндекса

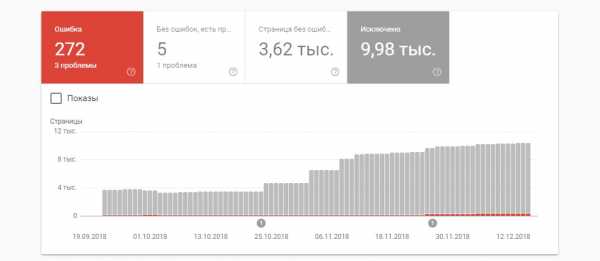

На скриншоте – сайт, у которого регулярно удаляются страницы из поиска Гугл

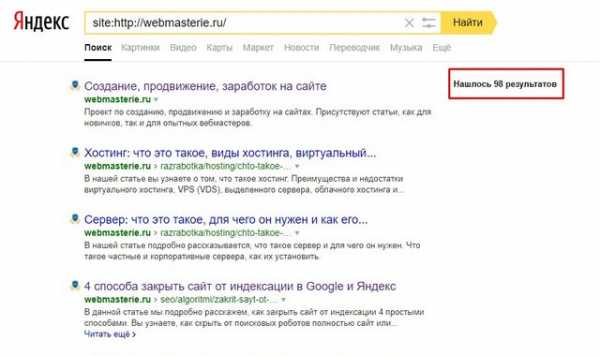

2. Проверка количества проиндексированных страниц в ПС при помощи операторов

Применяя документный оператор «site» возможно увидеть примерное количество страниц в индексе. Для использования этого параметра введите в строке поиска «site:адрес_интересующего_сайта», например «site:https://www.bordur32.ru».

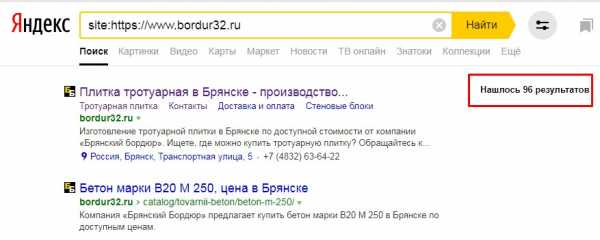

Пример использования оператора «site» в Яндексе

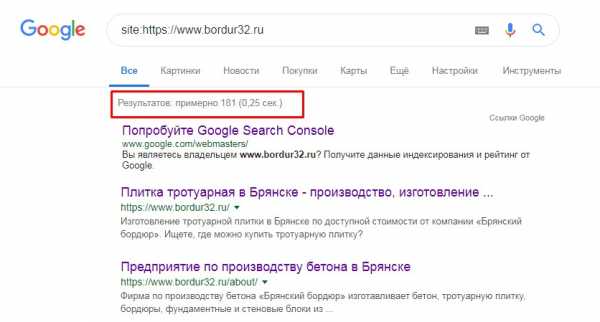

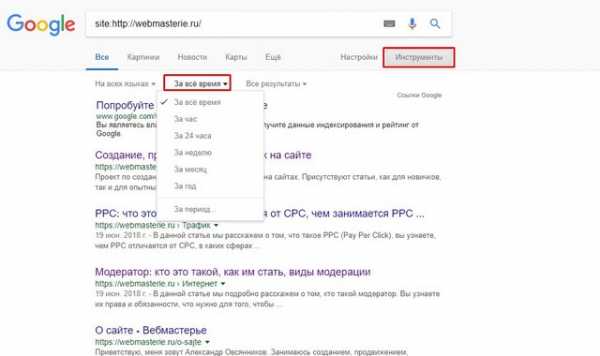

Пример использования команды «site» в Гугле

3. Анализ индексации сайта при помощи плагинов и расширений

Чтобы не вводить операторы в строке браузера перед url используется данный автоматизированный способ. Скачиваем бесплатный букмарклет для браузера (небольшой по размеру скрипт, сохраняемый в закладках) и кликаем на специальную иконку находясь на сайте.

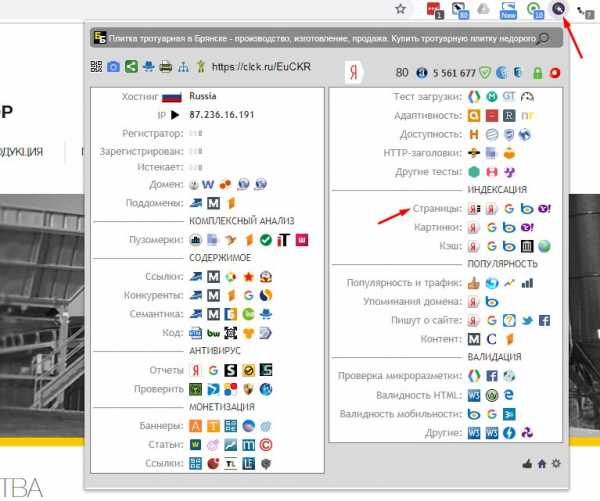

Пример использования плагина SEO-tools

Установить расширение вы можете по ссылке

Пример использования расширения RDS bar

Установить расширение вы можете по ссылке

4. Отслеживание проиндексированных страниц с помощью online сервисов

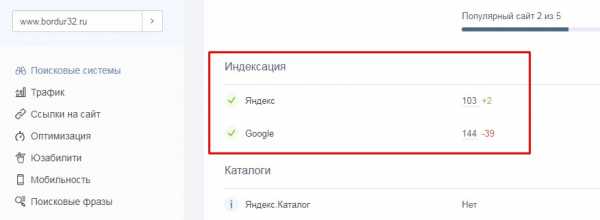

Еще один способ проверки индексации это использование сторонних ресурсов. Например, переходим на сайт a.pr-cy.ru вводим url и нажимаем «Анализировать».

Скриншот проверки индексации сайта в a.pr-cy.ru

Индексацию сайта можно проверить и в других сервисах, например: seogadget.ru, xseo.in и других.

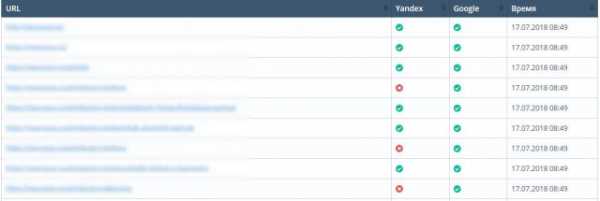

5. Программы для контроля индексации сайта

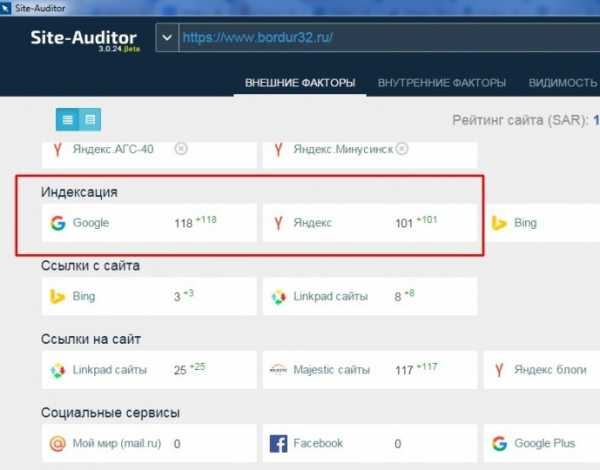

Существуют бесплатные (Site-Auditor) и платные программы (Semonitor) для анализа сайта и проверки страниц в индексе. Выбранное программное обеспечение скачиваем и устанавливаем на ПК. В строку ввода добавляем url проверяемого сайта.

Скриншот фрагмента анализа сайта в программе Site-Auditor

Проверка индексации страницы

Иногда требуется не только узнать сколько страниц проиндексировано в Яндексе и Google, но и нужно определить индексируется ли какая-то конкретная страница. Это можно сделать следующими способами:

1. В панели для вебмастеров:

-

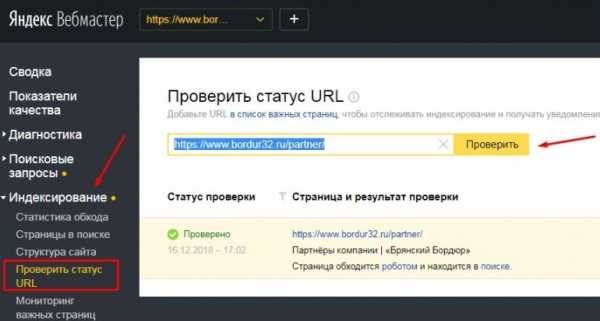

Яндекс – следовать по пути «Индексирование» – «Проверить статус URL». В поле для ввода данных ввести либо полный урл интересующей страницы, либо путь от корня сайта начинающийся с «/». Далее нажать кнопку «Проверить».

Проверяемая страница в поиске Яндекса

-

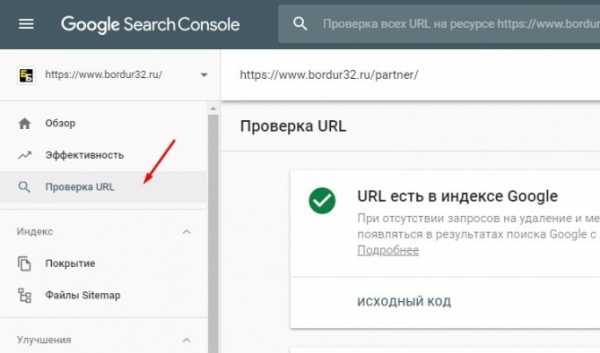

Google – перейти во вкладку «Проверка URL» и ввести урл интересующей страницы.

Проверяемая страница проиндексирована в Google

2. Оператор «url»

В строке поиска вводим специальный оператор. Запрос будет выглядеть так: «url:адрес_интересующей_страницы».

Пример использования оператора «url» в ПС Яндекс

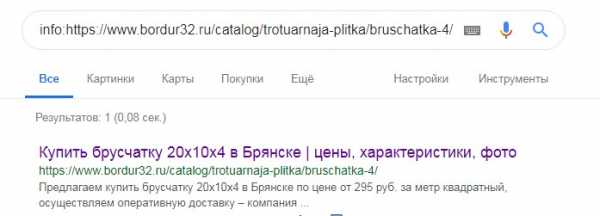

3. Оператор «info»

В поисковой системе Google можно воспользоваться оператором «info». Запрос в строке поиска будет выглядеть следующим образом: «info:адрес_интересующей_страницы»

Пример использования оператора «info» в ПС Гугл

Почему сайт может не индексироваться

В идеале страницы ресурса должны быть проиндексированы и их количество в поисковых системах должно быть примерно одинаковым. Но так бывает далеко не всегда. Рассмотрим причины мешающие индексации сайта.

Ошибки в файле robots.txt

Файл robots.txt – это текстовый документ в формате .txt лежащий в корневом каталоге веб-сайта, запрещающий или разрешающий индексирование страниц роботам ПС. Поэтому неправильное использование директив может закрыть от индексации весь сайт или отдельные страницы ресурса.

Отсутствие файла sitemap.xml

Карта сайта (файл sitemap.xml) – это специальный документ расположенный в корневом каталоге, содержащий ссылки на все страницы ресурса. Этот файл помогает поисковым роботам оперативно и качественно индексировать ресурс. Поэтому в него нужно добавлять только те страницы, которые должны попасть в индекс.

Новый сайт

Процесс индексации нового ресурса занимает некоторое время. Поэтому в данном случае нужно просто подождать, не забывая контролировать процесс индексации.

Приватные настройки

В некоторых CMS, таких, как WordPress и Megagroup, существует возможность скрыть от индексации страницы через админку сайта, данные настройки могут стоять по умолчанию.

Тег «noindex»

Страницы могут быть закрыты от индекса в коде с помощью мета тега name=»robots» content=»noindex, nofollow» />. Нужно проверить его наличие и либо убрать из кода, либо заменить на «index» и «follow».

Мусорные страницы

Еще одной из причин может стать большое количество мусорных страниц, не предоставляющих полезного и уникального контента в рамках сайта. Такие страницы нужно закрывать от индексации, чтобы не возникали проблемы с индексированием ресурса и робот не тратил время на посещения этих страниц.

Также причиной не индексации страниц ресурса могут быть ошибки сканирования, блокировка сайта в файле .htaccess, дубли страниц, не уникальный контент, низкий uptime хостинга, медленная скорость загрузки сайта, баны и фильтры ПС.

Выводы SEO-специалиста Веб-центра

Главная цель как владельца сайта так и SEO-специалиста добиться индексирования нужных страниц ресурса. Для этого нужно регулярно контролировать страницы в поиске Яндекса и Google, проверять сервисы для вебмастеров на наличие ошибок на сайте, наполнять его уникальным и полезным контентом, следить и оптимизировать скорость загрузки ресурса.

Для ускорения процесса индексации нужно подтвердить права на сайт в Яндекс.Вебмастер и Google Search Console и разместить в них ссылку на файл sitemap.xml, также можно отправлять на переобход важные страницы ресурса.

Подробно эту тему мы разобрали в видео на нашем Ютуб-канале

www.obrazstroy.ru

Проверить индексацию страницы сайта в Яндексе и Google за две минуты!

Сегодня любой крупный поисковик постоянно меняет алгоритмы ранжирования и предпочтения в сортировке сайтов. Одновременно изменяется время индексирования страниц, каждая из которых может стать весомым плюсом в поисковой выдаче или во внешней ссылочной массе. Иногда страницы после нового ранжирования «вылетают» из индексированной базы, а значит и из поиска целыми пачками. Соответственно оптимизаторы и владельцы сайтов обязаны постоянно проверять наличие конкретных страниц в индексе Яндекса и Google. Подобный анализ позволяет избегать досадных ситуаций, когда серьёзные надежды строятся в расчёте на раздел или статью, которая по каким-то причинам не попала в индексированный массив.

Очередной сервис от Серпхант предлагает простой и удобный инструмент, позволяющий быстро и бесплатно проверить индексацию страницы сайта в Яндексе и Google. Эта автоматическая программа выгодно отличается следующими преимуществами:

- максимально быстрая выдача результатов;

- возможность загрузки и до 50 адресов;

- гарантия достоверности предоставляемых сведений;

- отсутствие платы за использование

Поэтому вам достаточно просто ввести до 50 адресов страниц сайта, чтобы уже через пару минут посмотреть, индексируются ли введенные разделы Яндексом и Google. Наш автоматизированный онлайн сервис не даёт сбоев и всегда работает как швейцарские часы!

Напоследок стоит отметить один ключевой момент. Профессиональным SEO-специалистам и владельцам сайтов стоит помнить о том, что каждый день неиндексированная страница постепенно утрачивает свою уникальность из-за массового пополнения информационного поля интернета новыми материалами. Своевременная индексация является своеобразным подтверждением авторских прав на контент страницы, которая будет зарегистрирована в базе данных поисковой системы. В противном случае вы рискуете не только оригинальным содержимым, которое может быть попросту украдено. В этом случае можно потерять авторство в целом, которое может быть присвоено мошенниками, умеющими ускорять индексацию.

Предлагаемый сервис позволит вам быстро посмотреть, как обстоят дела у каждой страницы с индексом и принять соответствующие меры в случае отсутствия положительного результата.

Сервис индексирования страниц от Серпхант – бесплатно, быстро, достоверно и результативно!

serphunt.ru

4 эффективных способа проверить индексацию в Яндекс и Google

Если вы хотите узнать, есть ли определенная страница в индексе поисковой системы и сколько в целом страниц вашего сайта участвуют в поиске, вам стоит узнать о четырех самых простых способах поверки индексации сайта, которыми пользуются все SEO-специалисты.

В процессе индексирования портала, поисковый бот сначала сканирует его, то есть, обходит для изучения контента, а затем добавляет информацию о веб-ресурсе в базу данных. Затем поисковая система формирует поиск по этим базам. Не путайте сканирование с индексацией – это разные вещи.

Как узнать количество страниц на сайте?

Чтобы понимать, сколько еще страниц вашего проекта не проиндексировано, нужно знать их общее количество. Это позволит понять, как быстро индексируется ваш сайт. Сделать это можно несколькими способами:

- Посмотреть карту сайта. Ее вы найдете по адресу: название_вашего_сайта.ru/sitemap.xml. Здесь показываются в основном показываются все страницы, размещенные на ресурсе. Но иногда карта сайта может генерироваться не правильно, и часть страниц в ней может не быть.

- Воспользоваться специальной программой. Эти программы сканируют весь ваш сайт и выдают все страницы вашего сайта, пример таких программ Screaming Frog Seo (платная) иди Xenus Links Sleuth (бесплатная).

Способы проверки индексации сайта

Предлагаем вашему вниманию 4 самых распространенных и простых способа, позволяющие проверить, какие страницы есть в индексе, а какие – нет.

1. Через панель вебмастера

Этим методом владельцы веб-ресурсов проверяют их наличие в поиске чаще всего.

Яндекс

- Авторизуйтесь в Яндекс.Вебмастер.

- Перейдите в меню «Индексирование сайта».

- Под ним найдите строку «Страницы в поиске».

Можно пойти и по другому пути:

- Выберите «Индексирование сайта».

- Дальше перейдите в «История».

- Затем кликните на вкладку «Страницы в поиске».

И первым, и вторым способом вы сможете изучить динамику роста или спада числа страниц в поисковой системе.

- Зайдите в панель управления сервиса Google Webmaster Tools.

- Кликните на вкладку Search Console.

- Перейдите в «Индекс Google».

- Нажмите на опцию «Статус индексирования».

2. Через операторов поисковых систем

Они помогают уточнить результаты поиска. Так, применение оператора «site» позволяет увидеть приблизительное число страниц, которые уже находятся в индексе. Чтобы проверить этот параметр, в строке поиска Яндекс либо Google укажите: «site:адрес_вашего_сайта».

Важно! Если результаты в Google и Яндекс сильно разнятся между собой, то значит ваш сайт имеет какие-то проблемы со структурой сайта, мусорными страницы, индексацией или на него наложены санкции.

Для поиска вы также можете использовать дополнительные инструменты, например, чтобы узнать, как изменялась индексация страниц за определенный период времени. Для этого под поисковой строкой нажмите на вкладку «Инструменты поиска» и выберите период, к примеру, «За 24 часа».

3. Посредством плагинов и расширений

Используя специальные программы, проверка индексации веб-ресурса произойдет автоматически. Это можно сделать с помощью плагинов и расширений, еще известных как букмарклеты. Они представляют собой javascript-программы, которые сохраняются в браузере в виде стандартных закладок.

Преимущество плагинов и расширений в том, что вебмастеру нет необходимости каждый раз по новой заходить в поисковик и вводить там адреса сайтов, операторы и прочее. Скрипты произведут все в автоматическом режиме.

Самым популярным плагином, применяемым в этих целях, является RDS bar, который можно скачать в магазине приложений любого браузера.

Стоит отметить, что в Mozilla Firefox у плагина куда больше возможностей, чем в других браузерах. RDS bar предоставляет информацию относительно и всего веб-сайта, и его отдельных страниц

На заметку. Есть платные и бесплатные плагины. И самый большой минус бесплатных плагинов в том, что в них регулярно нужно вводить капчу.

Нельзя оставить без внимания и букмарклет «Проверка индексации». Чтобы включить программу, просто перетяните ссылку на панель браузера, а затем запустите свой портал и нажмите на закладку расширения. Так вы откроете новую вкладку с Яндекс или Google, где изучите нужную информацию касательно индексации определенных страниц.

4. С помощью специальных сервисов

Я в основном пользуюсь сторонними сервисами, потому что в них наглядно видно какие страницы в индексе, а какие там отсутствуют.

Бесплатный сервис

https://serphunt.ru/indexing/ — есть проверка, как по Яндекс, так и по Google. Бесплатно можно проверить до 50 страниц в сутки.

Платный сервис

Из платных мне больше всего нравится Topvisor — стоимость 0.024р. за проверку одной страницы.

Вы загружаете в сервис все страницы вашего сайта и он вам покажет, какие находятся в индексе поисковых систем, а какие нет.

Заключение

Главная цель владельца любого веб-ресурса – добиться индексации всех страниц, которые будут доступны поисковым роботам для сканирования и копирования информации в базу данных. Реализовать эту задачу на большом сайте может быть очень непросто.

Но при правильном комплексном подходе, то есть, грамотной SEO-оптимизации, регулярном наполнении сайта качественным контентом и постоянном мониторинге процесса включения страниц в индекс поисковиков, можно добиться положительных результатов. Для этого мы в этой статье и рассказали о четырех методах проверки индексации сайта.

Знайте, что, если страницы слишком резко начали вылетать из поиска – с вашим ресурсом что-то не так. Но зачастую проблема таится не в процессе индексации, а в самой оптимизации. Желаете быстро индексироваться и попадать в ТОП выдачу поисковых запросов? Предлагайте целевой аудитории контент, превосходящий конкурентов.

Пожалуйста, оцените эту статью. Чтобы мы могли делать лучший контент! Напишите в комментариях, что вам понравилось и не понравилось!

ПолезноРейтинг статьи: / 5. Кол-во оценок:

webmasterie.ru

Как быстро проверить индексацию сайта в Google и Яндекс — Netpeak Blog

Как оперативно узнать, попала ли важная для вас страница в индекс поисковых систем? Да и вообще, сколько страниц сайта «видят» поисковики? Я описал в этом посте способы, которые чаще всего используют SEO-специалисты, и приготовил бонус для читателей.

При индексировании страницы робот поисковой системы добавляет сведения о сайте в базу данных. Дальнейший поиск происходит по проиндексированным страницам. Не стоит путать индексацию и сканирование.

Робот может просканировать весь сайт быстро. А добавлять в индекс медленно, не добавлять часть страниц или удалять страницы из индекса.

1. Проверьте индексацию в панели вебмастеров

Это базовый способ проверки для вебмастера или владельца сайта.

Google. Необходимо зайти в Search Console и на вкладке «Индекс Google» выбрать «Статус индексирования».

Yandex. Проходим авторизацию в Яндекс.Паспорт, заходим в Яндекс.Вебмастер и переходим по пути «Индексирование сайта» — «Страницы в поиске». Еще один вариант: «Индексирование сайта» — «История» — «Страницы в поиске». Здесь можно посмотреть динамику изменения количества страниц в поиске.

Чтобы использовать этот метод, у вас должен быть определенный уровень доступа в панель вебмастера. Пример хорошего индексирования сайта. Количество качественных страниц растет, и они добавляются в индекс.  Проблемы с индексацией выглядят так:

Проблемы с индексацией выглядят так:

На скриншоте — сайт, закрытый от индексации в файле robots.txt

Хотите узнать больше о поисковом продвижении? Подписывайтесь на рассылку:

Наши подписчики всегда получают больше.

2. Используйте операторы в поисковых запросах

Поисковые операторы позволяют уточнять результаты поиска. Оператор «site:» выдает информацию о приблизительном количестве проиндексированных страниц. Для проверки в строке поиска Google или Яндекс введите «site:[url вашего сайта]».

Иногда большая разница между результатами в Google и Яндекс свидетельствует о наличии проблем с сайтом.

Например, сайт cubing.com.ua находится под фильтром АГС.

Используя дополнительные инструменты поиска, можно узнать данные об индексации за определенный период времени. Так, за последний час в индексе Google появились 49 страниц русскоязычной Википедии:

3. Используйте плагины и букмарклеты

Плагины и букмарклеты (небольшие javascript-программы, сохраняемые как браузерные закладки) — автоматизированный вариант проверки. В данном случае не надо открывать поисковик отдельно и вводить что-либо в поиск.

Это делают плагины и скрипты:

На скриншоте — плагин RDS bar для Google Chrome. Возможности RDS bar для Mozilla Firefox еще круче. С помощью плагина можно проверить индексацию текущей страницы и общий индекс всего сайта. Но в бесплатных вариантах капча не даст спокойно работать 🙂

Букмарклет «Проверка индексации». Перетащите ссылку из открытого файла на панель закладок. Дальше просто откройте нужный сайт и нажмите на эту закладку. Откроется новая вкладка с Google или Яндекс и нужными данными в выдаче.

4. Установите сервисы для проверки индексации

Это маленькие помощники SEO-специалистов. Их множество. Например, связка Netpeak Spider и Netpeak Checker.

Netpeak Spider позволяет просканировать весь сайт. Плюс в том, что вы получаете не только информацию о количестве страниц в индексе, но и список этих страниц, а также много дополнительных данных: каноникал, код ответа, название, заголовки, метаописания, мета роботс, robots.txt, редиректы, внутренние и внешние ссылки и другие. Также программа предупреждает об ошибках в этих данных.

Как только список всех URL сайта был получен, его можно загрузить в Netpeak Checker и уже проверить непосредственно на факт индексации поисковыми системами.

Почему не индексируется сайт?

1. Новый сайт. Иногда нужно просто подождать. Страницы в индекс не попадают все и сразу. Часто этот процесс растягивается на несколько месяцев.

2. Нет карты сайта (sitemap). Качественная карта сайта поможет поисковым роботам быстрее просканировать и проиндексировать ваш сайт. Ссылку на карту нужно добавить в панель вебмастеров.

3. Ошибки на сайте. Панели вебмастеров регулярно оповещают владельцев сайтов об ошибках. Заметили проблему в индексации? Смотрите, какие ошибки находит робот, и исправляйте их.

4. Ошибка с метатегом robots. Частая ошибка при несознательном изменении настроек CMS или хостинга. В коде страниц сайта появляется следующая строка:

5. Ошибка с robots.txt. Часто советуют закрывать в robots.txt всё ненужное. Особенность файла robots.txt в том, что один лишний символ может открытый для индексации сайт превратить в закрытый. Даже если вы правильно закрыли часть сайта, ненароком можно было зацепить нужные вещи, которые находятся глубже. Ваш сайт закрыт от индексации, если вы видите у себя в robots.txt эту конструкцию:

User-agent: * Disallow: /

Что еще может стать поводом для проблем с индексацией сайта?- дубли страниц;

- неуникальный контент;

- проблемы с доступностью и скоростью загрузки.

Читайте подробнее, как ускорить загрузку сайта с помощью сервиса CDN.

Выводы

Цель владельца сайта — чтобы все страницы, открытые для индексации, были в индексе поисковой системы. Достичь этого сложно. К тому же важно следить за процессом занесения страниц в индекс: резкие изменения в положительную или отрицательную сторону — сигнал о проблеме. Мы описали четыре способа проверки индексации страниц сайта:

- В панелях вебмастеров Google и Яндекс.

- С помощью поискового оператора «site:».

- С помощью плагинов, вроде RDS bar, и буркмарклетов.

- В специальных сервисах, например, Netpeak Spider.

Часто дело не в индексации, а в подходе к оптимизации. Хотите индексироваться и ранжироваться — отвечайте на запрос пользователя лучше всех. В таком случае все описанное выше понадобится только для фиксации хорошего результата.

P.S. Бонус для тех, кто дочитал 🙂

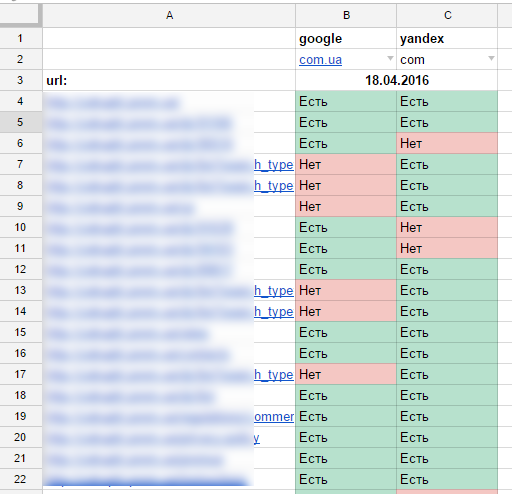

Держите таблицу, с помощью которой я работаю с индексацией сайтов. Как работать с таблицей?

- Сделать копию.

- Выбрать доменную зону.

- Загрузить в столбец А список URL-адресов.

- Подождать результатов (чем больше адресов, тем дольше надо ждать).

В итоге получаем приблизительно такую картину:

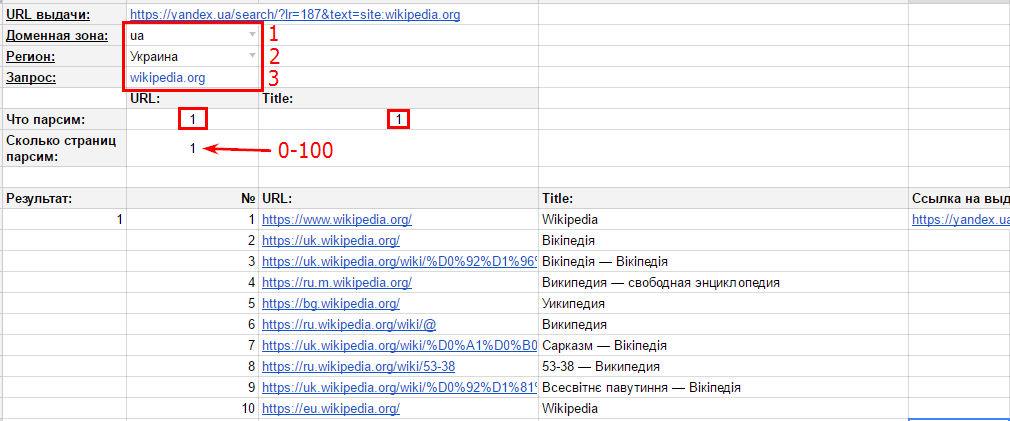

Затем можно выделить столбцы B, C и скопировать данные на соседние два столбца. Так вы сохраните результаты на текущую дату для сравнения с результатами индексации через определенное время. А вот еще одна таблица для фиксации результатов выдачи по оператору «site:» для Yandex. Инструкция проста:

- Выбрать доменную зону.

- Выбрать регион.

- Ввести запрос (адрес сайта).

- Поставить «1», если хотите получить адрес и заголовок.

- Ввести количество страниц выдачи, которые вы хотите сохранить (от 1 до 100).

С помощью этой таблички я не раз находил проблемные Title или лишние страницы в индексе.

netpeak.net

Проверка индексации сайта в Яндекс и Гугл

В данной статье мы рассмотрим, как проверить индексацию страницы в Яндексе и Google, что для этого делают опытные SEO-специалисты, а также какие есть способы массовой проверки индексации страниц.

Индексируем или сканируем?

Прежде чем мы приступим к рассмотрению вопроса статьи, сделаем небольшое замечание: часто читатели и начинающие владельцы сайтов путают такие понятия, как сканирование страницы и её индексация.

При индексации поисковый робот добавляет все важные сведения о сайте и странице в индекс (отдельную базу данных). После того, как это произошло, запросы в поисковой системе ведут только на те страницы, которые уже были ранее проиндексированы. Сканирование сайта – чуть другая вещь, предусматривающая изучение поисковым роботом сайта согласно с данными, указанными в robots.txt. Но вернемся к нашей теме – как может проводиться массовая проверка индексации сайтов?

Проверяем индексацию в панели вебмастера

Базовый и самый простой способ как для вебмастера, так и для владельца сайта:

Проверка сайта в Google. В случае, если проводится проверка проиндексированности страниц в Гугле, следует зайти в Search Console и там найти вкладку «Индекс Google», а далее перейти к просмотру статуса индексирования.

Проверка сайта в Yandex. Если же аналогичные данные нужно получить от Яндекса, то в панели «Яндекс.Вебмастер» следует пройти по маршруту «Индексирование сайта» → «Страницы в поиске». Там же, к слову, можно посмотреть и динамику индексации сайта и его страниц.

Для того, чтобы получить эти данные, нужно иметь соответствующий доступ к панели вебмастера и в Гугле, и в Яндексе.

Ниже вы можете увидеть пример сайта, который имеет хорошие показатели индексации…

…и не очень хорошие показатели, появившиеся вследствие запрета на проведение индексации в файле robots.txt.

Работаем с операторами поисковых запросов

С помощью поисковых операторов можно уточнить те или иные результаты поиска. Так, с помощью оператора «site:» можно узнать о примерном количестве страниц, которые находятся в индексе.

Для того, чтобы получить такую информацию, достаточно лишь в поисковой строке ввести site:[url сайта]. Кстати говоря – подобная проверка является своеобразным триггером для некоторых случаев. Так, при слишком большой разнице между результатами в Гугле и Яндексе можно сделать вывод, что у сайта есть какие-то проблемы в одной из поисковых систем. Например – наложенный фильтр.

В Google массовую проверку индексации страниц помогают провести дополнительные инструменты поиска. Например, тут можно увидеть, что за последний час появилось 49 страниц в русскоязычной Википедии:

Используем плагины и расширения для браузеров

Не будем давать рекламу тем или иным браузерным расширениям или плагинам, которые могут использоваться для проверки индексации страниц. Отметим только, что они представляют собой небольшие части java-кода, которые размещаются в браузере и позволяют проводить проверку индексации в автоматическом режиме.

Есть также специальные сервисы-краулеры, которые используются для проверки страниц. Их огромное множество, и большинство способны предоставить даже больше данных, чем просто сведения об индексации (например, редиректы, битые ссылки, переадресацию, каноникал, метаописание и т.д.).

В Интернете также можно встретить множество сайтов, которые предлагают провести проверку индексации страниц сайта. Некоторые специально «заточены» для таких задач, другие же предоставляют комплексный анализ. Но во всех случаях мы рекомендуем использовать вышеперечисленные варианты – они показывают наиболее точные данные, а получение информации и проверка проиндексированности страниц происходит очень быстро.

Онлайн-сервисы для проверки индексации

В случае, если вам необходимо проверить индексацию страниц без использования сервисов аналитики поисковых систем, вы можете воспользоваться функционалом следующих онлайн-сервисов:

Google Index Checker от Small SEO Tools

Всё, что вам нужно, чтобы проверить индексацию сайта за несколько секунд — использование сервиса Google Index Checker. Для получения информации вам будет необходимо ввести URL и нажать кнопку “Check”, после чего вы получите данные о количестве проиндексированных страниц.

Index Checking

Ещё один сервис, который позволяет проверить индексацию сайта в Гугле, это Index Checking. С его помощью вы также можете получить информацию об индексации любого URL вашего сайта, а в режиме проверки вы можете вводить до 25 URL за один раз.

Почему сайт не индексируется?

Индексация сайта в некоторых случаях может содержать ошибки. В частности, проверка индексации сайта может показать, что поисковые системы не видят много страниц. Почему в таком случае сайт не индексируется?

- Новый сайт. Несмотря на то, что официально поисковые системы заявляют об отсутствии т.н. “Песочниц”, молодые сайты не сразу попадают в индекс, а потому этот процесс может затянуться на несколько месяцев.

- Отсутствует sitemap. При отсутствии карты сайта краулеры поисковых систем могут индексировать сайт куда дольше.

- Ошибки с мета-тегом robots. Проверьте мета-тег на страницах — если у вас в мета-теге содержится директива noindex, поисковые системы не смогут проиндексировать сайт.

- Ошибки в htaccess/robots.txt. Проверьте эти файлы и убедитесь в том, что вы не закрыли доступ поисковым ботам.

Ну и напоследок — если кроме индексации вас интересуют еще и позиции — наш сервис поможет вампроверить сайт в Google или в Yandex, а также и в других поисковых системах. Просто введите ваш домен в форму ниже. Это бесплатно.

spyserp.com

как ее проверить, ускорить и запретить

Если интернет – огромная библиотека, то поисковые системы – ее сверхбыстрые сотрудники, способные быстро сориентировать читателя (интернет-пользователя) в бескрайнем океане информации. В этом им помогает систематизированная картотека – собственная база данных.

Когда пользователь вводит ключевую фразу, поисковая система показывает результаты из этой базы данных. То есть ПС хранят на своих серверах копии документов и обращаются к ним, когда пользователь отправляет запрос. Чтобы представить в выдаче определенную страницу, ее нужно сперва добавить в базу (индекс). Поэтому только что созданные сайты, о которых поисковики не знают, в выдаче не участвуют.

Поисковая система отправляет своего робота (он же паук, он же краулер) на поиски новых страниц, которые появляются в сети ежесекундно. Паучья стая собирает данные, передвигаясь по ссылкам с одной страницы на другую, и передает их в базу. Обработку информации производят уже другие механизмы.

У каждой поисковой системы – свой набор ботов, выполняющих разные функции. Вот пример некоторых роботов «Яндекса»:

- Основной робот.

- Индексатор картинок.

- Зеркальщик (обнаруживает зеркала сайта).

- Быстробот. Эта особь обитает на часто обновляемых сайтах. Как правило – новостных. Контент появляется в выдаче практически сразу после размещения. При ранжировании в таких случаях учитывается лишь часть факторов, поэтому позиции страницы могут измениться после прихода основного робота.

У «Гугла» тоже есть свой робот для сканирования новостей и картинок, а еще – индексатор видео, мобильных сайтов и т. д.

Скорость индексирования новых сайтов у разных ПС отличается. Каких-то конкретных сроков здесь нет, есть лишь примерные временные рамки: для «Яндекса» – от одной недели до месяца, для Google – от нескольких минут до недели. Чтобы не ждать индексации неделями, нужно серьезно поработать. Об этом и пойдет речь в статье.

Сперва давайте узнаем, как проверить, проиндексирован ли сайт.

Как проверить индексацию сайта

Проверить индексацию можно тремя основными способами:

- Сделать запрос в поисковик, используя специальные операторы.

- Воспользоваться инструментами вебмастеров (Google Search Console, «Яндекс.Вебмастер»).

- Воспользоваться специализированными сервисами или скачать расширение в браузер.

Поисковые операторы

Быстро и просто примерное количество проиндексированных страниц можно узнать с помощью оператора site. Он действует одинаково в «Яндекс» и «Гугл».

Сервисы для проверки индексации

Бесплатные сервисы позволяют быстро узнать количество проиндексированных «Яндексом» и Google страниц. Есть, к примеру, очень удобный инструмент от XSEO.in и SEOGadget (можно проверять до 30 сайтов одновременно).

У RDS целая линейка полезных инструментов для проверки показателей сайтов, в том числе проиндексированных страниц. Можно скачать удобный плагин для браузера (поддерживаются Chrome, Mozilla и Opera) или десктопное приложение.

Вообще плагин больше подходит профессиональным SEOшникам. Если вы обычный пользователь, будьте готовы, что эта утилита будет постоянно атаковать вас лишней информацией, вклиниваясь в код страниц, и в итоге придется либо ее настраивать, либо удалять.

Панели вебмастера

«Яндекс.Вебмастер» и Google Search Console предоставляют подробную информацию об индексировании. Так сказать, из первых уст.

В старой версии GSC можно также посмотреть статистику сканирования и ошибки, с которыми сталкиваются роботы при обращении к страницам.

Подробнее о данных об индексировании, представленных в панелях вебмастеров, можно почитать в соответствующих разделах наших руководств по «Яндекс.Вебмастеру» и Google Search Console.

58 самых распространенных ошибок SEOКак контролировать индексацию

Поисковые системы воспринимают сайты совсем не так, как мы с вами. В отличие от рядового пользователя, поисковый робот видит всю подноготную сайта. Если его вовремя не остановить, он будет сканировать все страницы, без разбора, включая и те, которые не следует выставлять на всеобщее обозрение.

При этом нужно учитывать, что ресурсы робота ограничены: существует определенная квота – количество страниц, которое может обойти паук за определенное время. Если на вашем сайте огромное количество страниц, есть большая вероятность, что робот потратит большую часть ресурсов на «мусорные» страницы, а важные оставит на будущее.

Поэтому индексированием можно и нужно управлять. Для этого существуют определенные инструменты-помощники, которые мы далее и рассмотрим.

Robots.txt

Robots.txt – простой текстовый файл (как можно догадаться по расширению), в котором с помощью специальных слов и символов прописываются правила, которые понимают поисковые системы.

Директивы, используемые в robots.txt:

|

Директива |

Описание |

|

User-agent |

Обращение к роботу. |

|

Allow |

Разрешить индексирование. |

|

Disallow |

Запретить индексирование. |

|

Host |

Адрес главного зеркала. |

|

Sitemap |

Адрес карты сайта. |

|

Crawl-delay |

Время задержки между скачиванием страниц сайта. |

|

Clean-param |

Страницы с какими параметрами нужно исключить из индекса. |

User-agent показывает, к какому поисковику относятся указанные ниже правила. Если адресатом является любой поисковик, пишем звездочку:

User-agent: Yandex

User-agent: GoogleBot

User-agent: Bingbot

User-agent: Slurp (поисковый робот Yahoo!)

User-agent: *

Самая часто используемая директива – disallow. Как раз она используется для запрета индексирования страниц, файлов или каталогов.

К страницам, которые нужно запрещать, относятся:

- Служебные файлы и папки. Админ-панель, файлы CMS, личный кабинет пользователя, корзина и т. д.

- Малоинформативные вспомогательные страницы, не нуждающиеся в продвижении. Например, биографии авторов блога.

- Различного вида дубли основных страниц.

На дублях остановимся подробнее. Представьте, что у вас есть страница блога со статьей. Вы прорекламировали эту статью на другом ресурсе, добавив к существующему URL UTM-метку для отслеживания переходов. Адрес немного изменился, но он все еще ведет на ту же страницу – контент полностью совпадает. Это дубль, который нужно закрывать от индексации.

Не только системы статистики виноваты в дублировании страниц. Дубли могут появляться при поиске товаров, сортировке, из-за наличия одного и того же товара в нескольких категориях и т. д. Даже сами движки сайта часто создают большое количество разных дублей (особенно WordPress и Joomla).

Мы делаем сайты, которые оптимизированы под поисковики и приносят продажи. ПодробнееПомимо полных дублей существуют и частичные. Самый лучший пример – главная страница блога с анонсами записей. Как правило, анонсы берутся из статей, поэтому на таких страницах отсутствует уникальный контент. В этом случае анонсы можно уникализировать или вовсе убрать (как в блоге Texterra).

У подобных страниц (списки статей, каталоги товаров и т. д.) также присутствует постраничная навигация (пагинация), которая разбивает список на несколько страниц. О том, что делать с такими страницами, Google подробно расписал в своей справке.

Дубли могут сильно навредить ранжированию. Например, из-за большого их количества поисковик может показывать по определенным запросам совершенно не те страницы, которые вы планировали продвигать и на которые был сделан упор в плане оптимизации (например, есть усиленная ссылками страница товара, а поисковик показывает совершенно другую). Поэтому важно правильно настроить индексацию сайта, чтобы этой проблемы не было. Как раз один из способов борьбы с дублями – файл robots.txt.

Пример robots.txt для одного известного блога:

При составлении robots.txt можно ориентироваться на другие сайты. Для этого просто добавьте в конце адреса главной страницы интересующего сайта после слеша «robots.txt».Не забывайте только, что функционал у сайтов разный, поэтому полностью скопировать директивы топовых конкурентов и жить спокойно не получится. Даже если вы решите скачать готовый robots.txt для своей CMS, в него все равно придется вносить изменения под свои нужды.

Давайте разберемся с символами, которые используются при составлении правил.

Путь к определенному файлу или папке мы указываем через слеш (/). Если указана папка (например, /wp-admin/), все файлы из этой папки будут закрыты для индексации. Чтобы указать конкретный файл, нужно полностью указать его имя и расширение (вместе с директорией).

Если, к примеру, нужно запретить индексацию файлов определенного типа или страницу, содержащую какой-либо параметр, можно использовать звездочки (*):

Disallow: /*openstat=

Disallow: /*?utm_source=

Disallow: /*price=

Disallow: /*gclid=*

На месте звездочки может быть любое количество символов (а может и не быть вовсе). Значок $ используется, когда нужно отменить правило, созданное значком *. Например, у вас есть страница eda.html и каталог /eda. Директива «/*eda» запретит индексацию и каталога, и страницы. Чтобы оставить страницу открытой для роботов, используйте директиву «/eda$».

Запретить индексацию страниц с определенными параметрами также можно с помощью директивы clean-param. Подробнее об этом можно прочитать в справке «Яндекса».

Директива allow разрешает индексирование отдельных каталогов, страниц или файлов. Например, нужно закрыть от ПС все содержимое папки uploads за исключением одного pdf-файла. Вот как это можно сделать:

Disallow: /wp-content/uploads/

Allow: /wp-content/uploads/book.pdf

Следующая важная (для «Яндекса») директива – host. Она позволяет указать главное зеркало сайта.

У сайта может быть несколько версий (доменов) с абсолютно идентичным контентом. Даже если у вас домен единственный, не стоит игнорировать директиву host, это разные сайты, и нужно определить, какую версию следует показывать в выдаче. Об этом мы уже подробно писали в статье «Как узнать главное зеркало сайта и настроить его с помощью редиректа».

Еще одна важная директива – sitemap. Здесь (при наличии) указывается адрес, по которому можно найти карту вашего сайта. О том, как ее создать и для чего она нужна, поговорим позже.

Наконец, директива, которая применяется не так часто – crawl-delay. Она нужна в случае, когда нагрузка на сервер превышает лимит хостинга. Такое редко встречается у хороших хостеров, и без видимых причин устанавливать временные ограничения на скачивание страниц роботам не стоит. К тому же скорость обхода можно регулировать в «Яндекс.Вебмастере».

Нужно отметить, что поисковые системы по-разному относятся к robots.txt. Если для «Яндекса» это набор правил, которые нельзя нарушать, то «Гугл» воспринимает его, скорее, как рекомендацию и может проигнорировать некоторые директивы.

В robots.txt нельзя использовать кириллические символы. Поэтому если у вас кириллический домен, используйте онлайн-конвертеры.

После создания файла его нужно поместить в корневой каталог сайта, т. е.: site.ru/robots.txt.

Проверить robots.txt на наличие ошибок можно в разделе «Инструменты» панели «Яндекс.Вебмастер»:

В старой версии Google Search Console тоже есть такой инструмент.

Как закрыть сайт от индексации

Если вам по какой-то причине нужно, чтобы сайт исчез из выдачи всех поисковых систем, сделать это очень просто:

User-agent: *

Disallow: /

Крайне желательно делать это, пока сайт находится в разработке. Чтобы снова открыть сайт для поисковых роботов, достаточно убрать слеш (главное – не забыть это сделать при запуске сайта).

Nofollow и noindex

Для настройки индексации используются также специальные атрибуты и html-теги.

У «Яндекса» есть собственный тег <noindex>, с помощью которого можно указать роботу, какую часть текста он не должен индексировать. Чаще всего это служебные части текста, которые не должны отображаться в сниппете, или фрагменты, которые не должны учитываться при оценке качества страницы (неуникальный контент).

Проблема в том, что этот тег практически никто кроме «Яндекса» не понимает, поэтому при проверке кода большинство валидаторов выдают ошибки. Это можно исправить, если слегка изменить внешний вид тегов:

<!—noindex—>текст<!—/noindex—>

Атрибут rel=”nofollow” позволяет закрыть от индексации отдельные ссылки на странице. В отличие от <noindex> его понимают все поисковые системы. Чтобы запретить роботу переходить по всем ссылкам на странице сразу, проще использовать вот такой мета-тег: <meta name=»robots» content=»nofollow» />.

Кстати, на мега-теге robots стоит остановиться подробнее. Как и файл robots.txt, он позволяет управлять индексацией, но более гибко. Чтобы понять принцип работы, рассмотрим варианты инструкций:

|

<meta name=»robots» content=»index,follow» /> |

индексировать контент и ссылки |

|

<meta name=»robots» content=»noindex,nofollow» /> |

не индексировать контент и ссылки |

|

<meta name=»robots» content=»noindex,follow» /> |

не индексировать контент, но переходить по ссылкам |

|

<meta name=»robots» content=»index,nofollow» /> |

индексировать контент, но не переходить по ссылкам |

Это далеко не все примеры использования мета-тега robots, так как помимо nofollow и noindex существуют и другие директивы. Например, noimageindex, запрещающая сканировать изображения на странице. Подробнее почитать об этом мета-теге и его применении можно в справке от Google.

Rel=”canonical”

Еще один способ борьбы с дублями – использование атрибута rel=”canonical”. Для каждой страницы можно задать канонический (предпочитаемый) адрес, который и будет отображаться в поисковой выдаче. Прописывая атрибут в коде дубля, вы «прикрепляете» его к основной странице, и путаницы c ee версиями не возникнет. При наличии у дубля ссылочного веса он будет передаваться основной странице.

Вернемся к примеру с пагинацией в WordPress. С помощью плагина All in One SEO можно в один клик решить проблему с дублями этого типа. Посмотрим, как это работает.

Зайдем главную страницу блога и откроем, к примеру, вторую страницу пагинации.

Теперь посмотрим исходный код, а именно – тег <link> с атрибутом rel=»canonical» в разделе <head>. Изначально он выглядит так:

<link rel=»canonical» target=»_blank» href=»http://site.ru/page/2/»>

Каноническая ссылка установлена неправильно – она просто повторяет физический адрес страницы. Это нужно исправить. Переходим в общие настройки плагина All in One SEO и отмечаем галочкой пункт «No Pagination for Canonical URLs» (Запретить пагинацию для канонических URL).

После обновления настроек снова смотрим код, теперь должно быть вот так:

<link rel=»canonical» target=»_blank» href=»http://site.ru/»>

И так – на любой странице, будь то вторая или двадцатая. Быстро и просто.

Но есть одна проблема. Для Google такой способ не подходит (он сам об этом писал), и использование атрибута canonical может негативно отразиться на индексировании страниц пагинации. Если для блога это, в принципе, не страшно, то со страницами товаров лучше не экспериментировать, а использовать атрибуты rel=”prev” и rel=”next”. Только вот «Яндекс» их, по словам Платона Щукина, игнорирует. В общем, все неоднозначно и ничего не понятно, но это нормально – это SEO.

Чек-лист по оптимизации сайта, или 100+ причин не хоронить SEOSitemap (карта сайта)

Если файл robots.txt указывает роботу, какие страницы ему трогать не надо, то карта сайта, напротив, содержит в себе все ссылки, которые нужно индексировать.

Главный плюс карты сайта в том, что помимо перечня страниц она содержит полезные для робота данные – дату и частоту обновлений каждой страницы и ее приоритет для сканирования.

Файл sitemap.xml можно сгенерировать автоматически с помощью специализированных онлайн-сервисов. Например, Gensitemap (рус) и XML-Sitemaps (англ). У них есть ограничения на количество страниц, поэтому если у вас большой сайт (больше 1000 страниц), за создание карты придется заплатить символическую сумму. Также получить готовый файл можно с помощью плагина. Самый простой и удобный плагин для WordPress – Google XML Sitemaps. У него довольно много разных настроек, но в них несложно разобраться.

В результате получается простенькая и удобная карта сайта в виде таблички. Причем она становится доступной сразу после активации плагина.

Sitemap крайне полезен для индексации, так как зачастую роботы уделяют большое внимание старым страницам и игнорируют новые. Когда есть карта сайта, робот видит, какие страницы изменились, и при обращении к сайту в первую очередь посещает их.

SEO-оптимизация интернет-магазина: 25 эффективных советовЕсли вы создали карту сайта при помощи сторонних сервисов, готовый файл необходимо скачать и поместить, как и robots.txt, в папку на хостинге, где расположен сайт. Опять же, в корневой папке: site.ru/sitemap.xml.

Для удобства желательно загрузить полученный файл в специальный раздел в «Яндекс.Вебмастере» и Google Search Console.

В старой версии инструмент немного отличается.

В «Яндекс.Вебмастере» проверить содержимое карты сайта на наличие ошибок можно в разделе «Инструменты».

Как ускорить индексацию

Поисковые системы рано или поздно узнают о вашем сайте, даже если вы ничего для этого не сделаете. Но вы наверняка хотите получать клиентов и посетителей как можно раньше, а не через месяцы, поэтому затягивать с индексацией – себе в убыток.

Регулярное быстрое индексирование необходимо не только новым, но и действующим сайтам – для своевременного обновления данных в поиске. Представьте, что вы решили оптимизировать старые непривлекательные заголовки и сниппеты, чтобы повысить CTR в выдаче. Если ждать, пока робот сам переиндексирует все страницы, можно потерять кучу потенциальных клиентов.

Вот еще несколько причин, чтобы как можно быстрее «скормить» роботам новые странички:

- На сайте публикуется контент, быстро теряющий актуальность. Если сегодняшняя новость проиндексируется и попадет в выдачу через неделю, какой от нее толк?

- О сайте узнали мошенники и следят за обновлениями быстрее любого робота: как только у вас публикуется новый материал, они копируют его себе и благополучно попадают на первые позиции благодаря более быстрому индексированию.

- На страницах появляются важные изменения. К примеру, у вас изменились цены или ассортимент, а в поиске показываются старые данные. В результате пользователи разочаровываются, растет показатель отказов, а сайт рискует опуститься в поисковой выдаче.

Ускорение индексации – работа комплексная. Каких-то конкретных способов здесь нет, так как каждый сайт индивидуален (как и серверы, на которых они расположены). Но можно воспользоваться общими рекомендациями, которые, как правило, позитивно сказываются на скорости индексирования.

Перечислим кратко, что можно сделать, чтобы сайт индексировался быстрее:

- Указать роботам, что индексировать и что не индексировать. Про robots.txt, карту сайта и все их преимущества мы уже говорили. Если файлы будут составлены правильно, боты быстрее справятся со свалившимся на них объемом новой информации.

- Зарегистрироваться в «Яндекс.Вебмастере» и Google Search Console. Там вы сможете не только заявить о новом сайте, но и получить доступ к важным инструментам и аналитике.

- Обратить внимание на сам сайт. Чтобы роботу (как и пользователям) проще было ориентироваться на сайте, у него должна быть понятная и простая структура и удобная навигация. Сюда же можно отнести грамотную перелинковку, которая может помочь в передвижении по сайту и обнаружении важных страниц. Качество контента тоже может повлиять на скорость индексирования, поэтому лучше выкладывать уникальные тексты, несущие пользу.

- Публикуйтесь на внешних площадках. Многие рекомендуют регистрировать сайты в сервисах социальных закладок, каталогах, «прогонять» по «Твиттеру», покупать ссылки и т. д. Мне в свое время это не помогло – новый сайт индексировался месяц. Но вот ссылки с крупных посещаемых ресурсов (где даже может обитать быстробот) действительно могут помочь. О том, как и где публиковаться, у нас было много статей: «Гостевой постинг: как публиковаться, вставлять ссылки и не платить за это», «Внешний контент-маркетинг: зачем, о чем и куда писать», гайд по линкбилдингу.

- Обновляйте сайт чаще. Если на сайте месяцами не публикуются новые материалы, робот меняет тактику и заходит на сайт реже.

Еще в панелях «Яндекс.Вебмастера» и Google Search Console можно отправлять роботов на конкретные страницы.

Обратите внимание на то, что отдельные адреса можно добавить в важные, чтобы потом отслеживать их индексирование.

А вот еще одна полезная штука: здесь можно узнать, проиндексирован ли конкретный URL.

В Google запросить индексирование конкретных страниц можно во вкладке «Посмотреть как Googlebot» (старая версия).

Это, пожалуй, самые основные способы ускорения индексации. Есть и другие, но их эффективность – под вопросом. В большинстве случаев тратить на них время не стоит, если только проиндексировать сайт нужно срочно, и вы готовы испробовать любые способы. В таких случаях лучше читать конкретные кейсы. Например, как проиндексировать сайт в Google в течение 24 часов.

Вывод

Индексация сайта – сложный процесс, с которым поисковые системы далеко не всегда справляются в одиночку. Так как индексирование влияет непосредственно на ранжирование сайта в поисковой выдаче, имеет смысл взять управление в свои руки и максимально упростить работу поисковым роботам. Да, придется повозиться и набить много шишек, но даже такой непредсказуемый зверь как поисковый бот все же может покориться человеку.

kak-priruchit-poiskovogo-bota-gayd-po-indeksirovaniyu-saytatexterra.ru

Как проверить проиндексирован ли сайт и ускорить этот процесс

Доброго времени суток, дорогие друзья. Многие начинающие веб-мастера, самостоятельно занимающиеся продвижением своих сайтов, не уделяют должного внимания индексации своего ресурса. Это приводит к потере времени и денег, затраченных на создание неэффективной интернет-площадки, которую не любят поисковики, а соответственно, и пользователи с рекламодателями.

Поэтому сегодня, продолжая цикл статей о сайтостроительстве, мы поговорим о том, как проверить проиндексирован ли сайт в целом и его отдельные страницы в частности, а также обсудим, как и для чего нужно ускорять процесс индексации.

Что такое индексация и зачем она нужна

Мы уже не раз говорили о том, что зарабатывать на своем сайте можно только при условии достижения высокого уровня посещаемости, интересного потенциальным рекламодателям.

Большинство пользователей попадает на определенный ресурс из поисковых систем, вводя в них интересующие их запросы. Поисковые роботы сверяют эти запросы со своей базой данных и выводят оптимальные результаты поиска. Для того чтобы сайт попал в эту базу, он должен быть проиндексирован поисковой системой. В противном случае посетители просто не смогут найти его.

При этом очень важно, чтобы не просто ресурс, но каждая его новая страничка была максимально быстро учтена поисковиком. Оптимально, если она содержит внутреннюю перелинковку, позволяющую не только заносить в базу новый материал, но и по указанным ссылкам обновлять старый.

Почему индексация должна быть быстрой?

Кроме увеличения трафика посетителей скорость индексирования влияет и на многие другие показатели ресурса.

Кроме увеличения трафика посетителей скорость индексирования влияет и на многие другие показатели ресурса.

Ежедневно в сети появляются новые сайты, тематика которых конкурирует с вашей веб-площадкой. Все они наполняются схожим контентом, который по мере роста численности конкурентов, теряет свою уникальность. Это происходит оттого, что большинство сайтов занимается публикацией многочисленных рерайтов. Простым языком, если вы написали уникальную статью и сразу не позаботились о ее учете поисковиком, не факт, что в момент такового материал останется уникальным.

Кроме того, не проиндексированный контент становится лакомой мишенью для мошенников. Недобросовестному веб-мастеру ничего не мешает попросту скопировать материал на свой ресурс, провести быстрое индексирование и получить от поисковых роботов право на его авторство. А вашу статью поисковики в дальнейшем сочтут не уникальной, что может привести к бану интернет-площадки. Поэтому контролировать и ускорять процесс индексации особенно важно для молодых ресурсов, пробивающих себе дорогу.

Еще одним моментом, зависящим от быстрого индексирования каждой страницы, является возможность получать деньги за платные ссылки. Ведь до тех пор, пока статья с ссылкой не будет проиндексирована поисковиками, свое вознаграждение вы не получите.

Как проверить проиндексирован ли сайт в целом?

Для начала стоит убедиться, что ваш сайт попадает в базу поисковиков. Для этого нужно узнать общее число его страниц. При наличии современной системы управления веб-ресурсом, посмотреть данную цифру можно в административной части. При этом учитывается итоговое число страничек и записей.

Если по какой-либо причине данная информация недоступна, можно воспользоваться сервисом Xml-sitemaps.com. Учтите, что он бесплатен только при работе с сайтами, имеющими в своем арсенале до полутысячи страниц.

Узнав требуемое число, можно приступать к проверке индексирования площадки в главных поисковых системах – Яндекс и Google. Для этого существует несколько способов:

- Использование специальных инструментов для веб-мастеров: webmaster.yandex.ru и google.com/webmasters. Зарегистрировавшись в них и добавив свой ресурс в систему, вам станут доступны не только данные о количестве проиндексированных страничек, но и статистика других «пузомерок».

- Ручная проверка через ввод специальных команд в строку поиска. При этом в Яндексе нужно ввести конструкцию host:имя сайта+домен либо host:www+ имя сайта+домен, например, host:abc.ru. На это система выдаст все проиндексированные страницы. Для проверки в Google потребуется ввести запрос: site:имя сайта+домен, т.е. site:abc.ru.

- Использование автоматических сервисов, проверяющих индексацию сразу в обеих поисковых системах. К числу таких относятся, например, Site-auditor.ru, Pr-cy.ru или Seolib.ru. Также можно добавить в свой браузер плагин RDS Bar, который будет показывать сведения о ресурсе, включая индексацию страничек, на котором вы находитесь.

С помощью любого из данных методов можно узнать, проиндексирован ли сайт в целом, и определить число занесенных в базу поисковиков страниц ресурса.

Что делать с полученной информацией?

В идеале, количество страничек сайта должно совпадать с числом проиндексированных страниц. К сожалению, так бывает далеко не всегда. Гораздо чаще встречаются два варианта развития событий:

- Проиндексированное число элементов – меньше. Соответственно, вы сильно теряете в трафике, ведь по многим запросам пользователей ваш сайт остается недоступным для них.

- Количество проиндексированных страниц превышает реальное число таковых. Если у вас подобный вариант, радоваться не стоит. Вероятнее всего имеет место дублирование страничек, что размывает их вес, увеличивает число повторяющегося материала и мешает продвижению ресурса.

Обе проблемы необходимо максимально быстро решить. Иначе вы рискуете получить неэффективную веб-площадку, заработать на которой можно только в мечтах. А для этого придется проверить индексацию всех страниц по отдельности, чтобы узнать, какие из них «стратили».

Как проверить индексацию отдельной или всех страниц

Проверка отдельной странички нужна, когда необходимо убедиться, что новый опубликованный контент успешно «замечен» поисковыми системами. Или когда вы приобрели на чужом ресурсе платную ссылку и теперь с нетерпением ждете ее индексации. Это можно сделать через:

- Ввод URL страницы в строку поиска Яндекс или Google. В случае если проблем с восприятием страницы поисковиками нет, она первой отобразится в результатах поиска.

- Уже упомянутый плагин RDS Bar.

Для проверки индексации всех страничек сайта понадобится список их адресов (URL). Для этого можно воспользоваться каким-либо генератором карт веб-ресурсов, к примеру, Sitemap Generator. Чтобы собрать только URL страниц, не забудьте внести маску ненужных адресов, например, на комментарии, в окне «Exclude Patterns». По окончании процесса следует перейти во вкладку Yahoo Map/Text, откуда скопировать сгенерированный перечень всех адресов.

Имея его на руках, индексацию всех страничек не составит труда проверить с помощью программы YCCY.ru. Просто добавьте данные в список исходных URL и выберите одну из предложенных поисковых систем: Google, Яндекс или Rambler. Нажмите кнопку «Начать Проверку» и получайте утешительные или не очень результаты.

Как улучшить и ускорить процесс индексации?

Узнав перечень непроиндексированных страниц, необходимо разобраться в причинах этого. Прежде всего, стоит проверить качество работы хостинга и самой веб-площадки и убедиться в уникальности размещенных материалов. Далее промониторьте ресурс на наличие контента слишком короткого (до 2 000 символов без пробелов), содержащего более 2-3 ссылок на сторонние ресурсы, либо много Java и Flash ссылок. Все эти факторы в первую очередь могут влиять на то, что ваш материал остается «невидимым» для поисковиков.

Узнав перечень непроиндексированных страниц, необходимо разобраться в причинах этого. Прежде всего, стоит проверить качество работы хостинга и самой веб-площадки и убедиться в уникальности размещенных материалов. Далее промониторьте ресурс на наличие контента слишком короткого (до 2 000 символов без пробелов), содержащего более 2-3 ссылок на сторонние ресурсы, либо много Java и Flash ссылок. Все эти факторы в первую очередь могут влиять на то, что ваш материал остается «невидимым» для поисковиков.

Ускорить процесс индексирования сайта можно с помощью:

- частого обновления уникального материала, что очень ценят поисковики;

- грамотной внутренней перелиновки страниц, позволяющей поисковым системам видеть новый и обновлять уже содержащийся в базе контент;

- публикации ссылок на статьи во всех социальных сетях и тематических форумах;

- закупки ссылок с прокачанного аккаунта.

Надеюсь, вы поняли, что быстрая индексация страниц ресурса – основа его продвижения в поисковиках, от которой напрямую зависит ваш потенциальный доход.

Если я глаголил не зря, прошу порекомендовать мою статью в социальных сетях, поспособствовав ее индексации 🙂 На этом прощаюсь и желаю успехов в любом деле!

P.S. Телеграм канал блога — t.me/investbro_ru — подписывайтесь!

investbro.ru