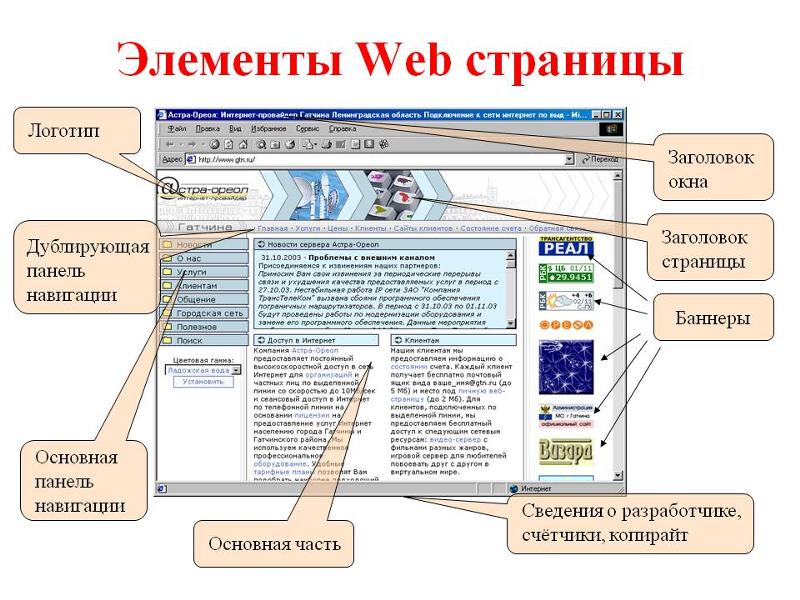

Сканирование и анализ веб-сайтов: подборка полезных сервисов

Рассказываем про несколько инспекторов, с помощью которых можно быстро проанализировать, чего не хватает в вашем проекте, и узнать, какие изменения нужно внести для улучшения показателей сайта.

YSlow

YSlow — проведёт небольшой анализ загрузки не только страницы, но и отдельных составляющих сайта. Сервис проверяет вынесение заголовков, использование компрессии, а также вынесение скриптов в индивидуальные файлы, после чего предоставляет информацию по улучшению проекта. За основу берутся исследования Yahoo. Сервис предоставляется в виде расширения для всех топовых браузеров.

Web Developer Checklist

Web Developer Checklist — ещё один интересный сервис для веб-разработчика, который поможет по пунктам проверить готовность проекта к запуску. Доступен в виде сайта и расширения.

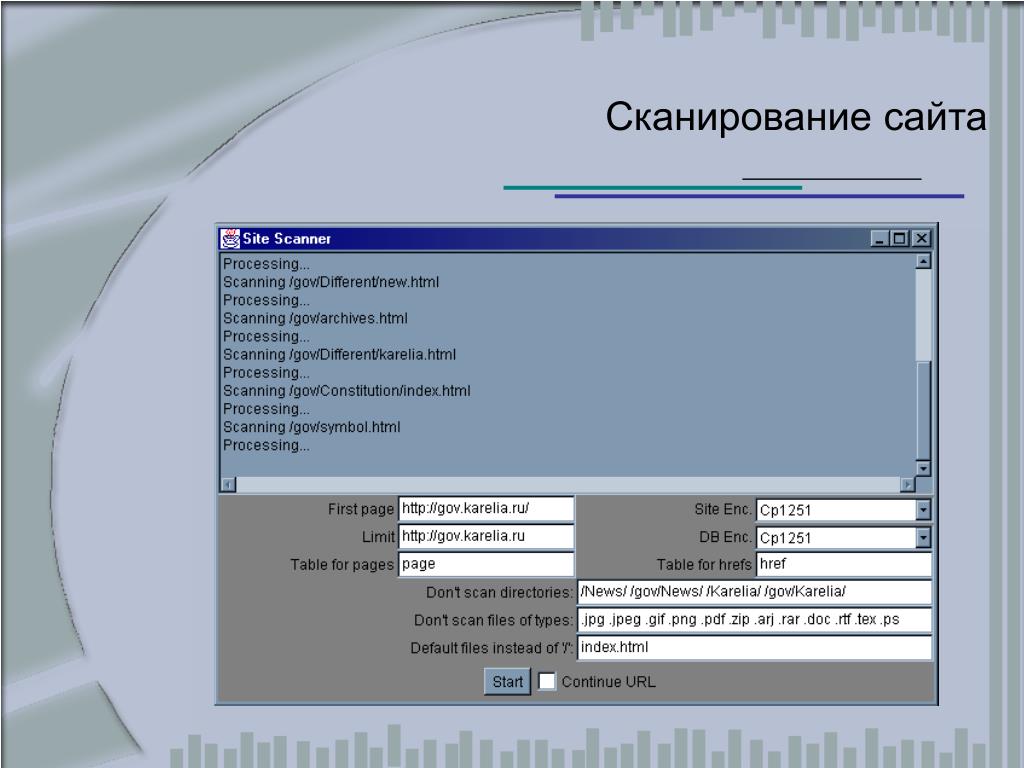

Site Scan

Site Scan — инструмент от Microsoft, который проведёт сканирование вашего проекта и подскажет, как реализовать изменения, если они требуются.

PageSpeed Insights

PageSpeed Insights — один из инструментов PageSpeed Tools от Google. Он анализирует содержание и технический стек вашего сайта и предлагает решения, позволяющие ускорить его загрузку. В параметры оценки входит не только скорость, но и удобство использования. Советы могут иметь желательный и критический характер. К критическим относятся такие вещи как, например, блокировка отрисовки страницы небрежно вставленным в header JavaScript-кодом.

Test My Site

Test My Site — еще один инструмент от Google, который позволяет протестировать скорость загрузки страниц сайта на мобильных устройствах. Его отличительная особенность в том, что в конце анализа отображается процент пользователей, которые уходят с сайта, не дождавшись загрузки. По словам Google, для того, чтобы соответствовать ожиданиям, сайт должен грузиться не более 3 секунд.

GTMetrix

GTMetrix — разработка хостинг-провайдера GT, которая объединяет в себе сервисы PageSpeed Insights и Yahoo YSlow, описанные выше, что позволяет получить наиболее полный анализ в едином интерфейсе и применить лучшие практики двух корпораций.

WebPageTest

WebPageTest — анализирует загрузку страниц из разных точек мира и отображение сайта в разных браузерах. В сервисе также есть функции, которые, например, предоставят информацию о времени загрузки страницы или отобразят в виде графика внутреннее устройство сайта. Пригодится, если вы хотите адаптировать свой проект под различные браузеры.

SEO Чеклист

SEO Чеклист — поможет вам ничего не забыть при проведении SEO-оптимизации сайта. Помимо простой оптимизации для поиска, можно отмечать ход проведения технического аудита сайта, оптимизации ссылок, а также исследование соцактивности. В список можно добавлять свои собственные пункты, а также экспортировать его в PDF.

Browser Shots

Browser Shots — сервис, зайдя на который, вы наверняка поймете, как мало браузеров знаете. На нем можно проверить, как будет выглядеть ваш сайт во всех (или почти всех) когда-либо существовавших браузерах. Сервис бесплатный, использовать его можно и без регистрации, но если вы собираетесь проводить дотошную проверку каждой страницы, придется завести аккаунт.

Screenfly

Screenfly — служит логическим продолжением предыдущего сервиса. С его помощью можно взглянуть на сайт глазами владельца Kindle, iPad и еще целого списка устройств, не имея их на руках — просто введите в поле адрес вашего сайта и затем выбирайте устройства в меню сверху. Доступны в том числе и экзотические модели вроде телефонов BlackBerry и Motorola и смарт-телевизоров. Кроме того, можно указать произвольный размер окна в пикселях.

Observatory

Observatory — проверит безопасность вашего сайта (например, соответствие политике защиты контента, использование cookies, очевидные XSS-уязвимости). По итогам вашему сайту будет выставлена оценка от A до F. Сайт умеет хранить историю исследований — с её помощью можно проследить, становится ли ваш сайт лучше со временем.

Nibbler

Nibbler — проект, проводящий тотальную проверку вашего сайта. Оценка проводится по длинному списку характеристик, среди которых качество кода, адаптация под мобильные устройства, формат ссылок на материалы сайта, качество заголовочной информации и многое другое. Кроме того, отдельная графа в результатах содержит рекомендации по улучшению ситуации — в нее попадут только те советы, последовать которым в данный момент важнее всего. Если вы пройдетесь по каждому из пунктов, добившись оценки в 10 баллов, ваш сайт станет, пожалуй, одним из лучших в интернете.

Кроме того, отдельная графа в результатах содержит рекомендации по улучшению ситуации — в нее попадут только те советы, последовать которым в данный момент важнее всего. Если вы пройдетесь по каждому из пунктов, добившись оценки в 10 баллов, ваш сайт станет, пожалуй, одним из лучших в интернете.

Dotcom-tools

Dotcom-tools — инструмент, позволяющий тестировать сайт из 25 точек мира, которые находятся на всех 5 континентах. Кроме того, по результатам проверки предоставляется многосторонний отчёт производительности, включающий в себя такие параметры, как:

- Проверка ошибок и диагностика;

- 10% самых быстрых и самых медленных элементов;

- Понятное описание скорости и прочих данных на диаграмме;

- Разбивка по элементам хоста.

Добавляйте другие известные вам сервисы в комментарии, мы будем периодически обновлять подборку.

Реклама на Tproger: найдем для вас разработчиков нужного стека и уровня.

Подробнее

Реклама на tproger.

Загрузка

Просмотр Структуры и Скрытых Файлов ᐈ

Сканирование каталогов веб-сайтов и конфиденциальных файлов — одна из важных задач при тестировании вашего сайта. Сканирование необходимо для обнаружения конфиденциальных каталогов или поиска скрытых каталогов на веб-сайте. С помощью нашего инструмента вы можете сканировать и находить такие файлы, как PHP Robots.txt и другую информацию;

Если мошенники просканируют ваш сайт и найдут загруженные файлы, они могут загрузить на ваш сайт вредоносный код. Если на вашем сайте есть скрытые файлы, о которых вы не знаете, вы можете стать легкой добычей для киберпреступников. Они могут получить доступ к конфиденциальной информации и использовать ее в незаконных целях.

По этой причине очень важно знать, как найти скрытые файлы на веб-сайте и в каталогах.

Мы объясним, как просмотреть каталог веб-сайта со сканером. Это простой и бесплатный способ получить полный список скрытых каталогов, которые могут стать уязвимостью для вашего сайта.

Что такое сканер каталогов веб-сайтов?

Как найти скрытые страницы на сайте?

Отличная идея — просканировать веб-сайт на наличие скрытых каталогов и файлов (скрытых — это каталоги и файлы, на которые нет ссылок и о которых знает только владелец сайта!) с помощью онлайн-сканера каталогов веб-сайтов. Как минимум, вы можете узнать что-то новое о сайте, просмотреть структуру каталогов сайта, а иногда просто выпадает суперприз — архив сайта или базы данных, резервная копия конфиденциальных документов и т.д.

Что такое каталог сайта?

Это основная папка, в которой хранятся все каталоги и файлы сайта. Именно в эту папку загружается архив с файлами сайта и базой данных. Если вы поместите файлы сайта не в ту папку, вместо сайта будет отображаться ошибка 403.

Средство поиска каталогов помогает найти указанный каталог в системе для файлов, содержащих сообщения (например, в формате XML или JSON). Когда сообщения прочитаны, они могут быть переданы в основной конвейер сообщений, где на них может воздействовать весь спектр фильтров обработки сообщений.

Средство просмотра файлов веб-сайта обычно используется в тех случаях, когда внешнее приложение сбрасывает файлы (возможно, по FTP) в файловую систему, чтобы их можно было проверить, изменить и, возможно, перенаправить через HTTP или JMS.

Это помогает профессионально сканировать каталог веб-сайтов. Особенно, когда вы запускаете тесты, ориентированные на безопасность, и просматриваете каталог веб-сайта, он закрывает некоторые дыры, которые не покрываются классическими веб-сканерами уязвимостей. Он ищет определенные веб-объекты, но не ищет уязвимости и не ищет веб-контент, который может быть уязвимым.

Что могут быть «скрытые файлы»?

В общем случае это могут быть следующие каталоги:

- Файлы конфигурации проекта, которые создает интегрированная среда разработки (IDE).

- Специальная конфигурация и файлы конфигурации для данного проекта или технологии.

Вы должны регулярно сканировать сайты, чтобы увидеть, не передаются ли какие-либо конфиденциальные и проприетарные файлы. Просмотр каталога веб-сайта — это действительно простое правило, которое поможет защитить вас от хакерских атак и сохранить ваши файлы в полной безопасности.

Просмотр каталога веб-сайта — это действительно простое правило, которое поможет защитить вас от хакерских атак и сохранить ваши файлы в полной безопасности.

Различные типы сканеров каталогов веб-сайтов

Как просмотреть каталог сайта? Сканеры работают по разным принципам. Есть инструменты для сканирования вашего сайта (и это авторизованные инструменты), а есть и хакерские. С этической точки зрения вы не можете сканировать каталоги других сайтов. Юридически это считается взломом и мошенничеством.

Посмотрим, по какому принципу будут работать разные типы сканеров каталогов.

- Словарь сканировать сайт на наличие файлов.

- Сканирование чистым сканером.

- Сканирование веб-сканером.

- Сканирование с реализацией библиотеки запросов Python.

Как видите, есть несколько способов сканирования и поиска скрытых файлов на вашем сайте. Вы можете выбрать наиболее удобный для вас или воспользоваться нашим простым инструментом Website Directory Scanner.

Руководство по эффективному использованию нашего сканера каталогов

Если вы хотите найти скрытые страницы на веб-сайте и знаете, как просмотреть список каталогов веб-сайтов, используйте наш инструмент сканера каталогов веб-сайтов.

Это достаточно просто:

- После этого наш поисковый робот просканирует весь ваш сайт;

- Получить отчет об аудите целиком и просмотреть все файлы в каталоге веб-сайта в Интернете.

Вот и все. Так просто выглядит процесс поиска в каталоге веб-сайтов.

Специальные функции нашего сканера каталогов веб-сайтов

Что ж, давайте кратко рассмотрим основные функции нашего сканера каталогов веб-сайтов.

Как только сканирование остановится, вы увидите оценку вашего сайта, количество просканированных страниц и количество страниц в индексе Google. Например, мы просканировали наш сайт sitechecker.pro. Результаты сканирования вы можете увидеть на скриншоте ниже.

Прокручивая ниже, вы можете увидеть проблемы на уровне сайта. Если на вашем веб-сайте есть скрытые файлы, которые может сканировать наш инструмент, вы также увидите их в этом списке.

Следующей особенностью нашего инструмента является то, что вы можете просматривать ошибки, разделенные на три категории. Это критические ошибки, которые говорят вам о важности их исправления как можно скорее.

Это предупреждения, информирующие владельца сайта о том, что можно улучшить. А второстепенные — это уведомления, которые не являются важными предупреждениями.

Так вы можете просмотреть все файлы в каталоге веб-сайта. Это очень просто и не займет у вас много времени. Кроме того, это позволит избежать неприятных ситуаций с доступом к вашему сайту.

Просканируйте каталог своего веб-сайта прямо сейчас!

Часто задаваемые вопросы

Что такое каталог веб-сайта?

Веб-каталог – это онлайн-список или каталог веб-сайтов. Также известный как тематический каталог, эти списки представляют собой организованный метод поиска веб-сайтов.

Как получить все файлы с веб-сайта?

Самый простой способ поиска в веб-каталоге — это подключиться к веб-серверу через SSH или RDP и запустить команду для вывода списка локальных каталогов.

Что такое фаззер URL?

Это действие по обнаружению, позволяющее обнаружить ресурсы, которые не должны быть общедоступными (например, /backups, /index.php.old, /archive.tgz, /source_code.zip и т.д.).

Является ли фаззинг URL незаконным?

Мы настоятельно рекомендуем вам не запускать программы тестирования на проникновение на чужом сайте без письменного разрешения веб-мастера. Это может иметь для вас нежелательные последствия в зависимости от законов вашей страны о кибербезопасности.

20 лучших инструментов веб-сканирования для быстрого сканирования веб-сайтов

Веб-сканирование (также известное как извлечение веб-данных, веб-скрапинг) сегодня широко применяется во многих областях. Еще до того, как веб-сканер станет общедоступным, это волшебное слово для обычных людей без навыков программирования. Его высокий порог продолжает блокировать людей за дверью больших данных. Инструмент веб-скрейпинга — это технология автоматизированного сканирования, которая устраняет клин между таинственными большими данными для всех. В этой статье вы можете узнать топ 20 Инструменты веб-краулера на основе настольных устройств или облачных сервисов.

Как помогают инструменты веб-сканирования

- Больше никаких повторяющихся действий по копированию и вставке.

- Получите хорошо структурированные данные, не ограничиваясь Excel, HTML и CSV.

- Экономия времени и экономичность.

- Это лекарство для маркетологов, интернет-продавцов, журналистов, ютуберов, исследователей и многих других, которым не хватает технических навыков.

Инструменты веб-сканирования для Windows/Mac 1. Octoparse — бесплатный веб-скрейпер для пользователей, не умеющих кодировать

Программное обеспечение с удобным интерфейсом «укажи и щелкни» создано специально для тех, кто не занимается кодированием. Вот видео об Octoparse, а также основные функции и простые шаги, чтобы вы могли лучше узнать его.

Основные функции Octoparse Web Crawler

- Запланированное извлечение из облака: извлечение динамических данных в режиме реального времени.

- Очистка данных: встроенная конфигурация Regex и XPath для автоматической очистки данных.

- Обход блокировки: облачные сервисы и IP-прокси-серверы для обхода ReCaptcha и блокировки.

Простые шаги для получения данных с помощью Octoparse Web Crawling Tool

- Предварительно созданные парсеры: для сбора данных с популярных веб-сайтов, таких как Amazon, eBay, Twitter и т. д.

- Автоматическое определение: введите целевой URL-адрес в Octoparse, и он автоматически обнаружит структурированные данные и очистит их для загрузки.

- Расширенный режим. Расширенный режим позволяет техническим пользователям настраивать парсер данных, который извлекает целевые данные со сложных сайтов.

- Формат данных: EXCEL, XML, HTML, CSV или в ваши базы данных через API.

- Octoparse получает данные о продуктах, ценах, контенте блога, контакты для потенциальных клиентов, сообщения в социальных сетях и т.

д.

д.

Использование готовых шаблонов

Octoparse имеет более 100 парсеров шаблонов, и вы можете легко получить данные из Yelp, Google Maps, Facebook, Twitter, Amazon, eBay и многих популярных веб-сайтов, используя эти парсеры шаблонов в течение трех шаги.

1. Выберите на главной странице шаблон, который поможет получить нужные вам данные. Если вы не видите нужный шаблон на странице шаблона, вы всегда можете попробовать выполнить поиск по названию веб-сайта в программном обеспечении, и оно сразу сообщит вам, доступны ли какие-либо шаблоны. Если по-прежнему нет шаблона, соответствующего вашим потребностям, отправьте нам по электронной почте информацию о вашем проекте и требованиях и узнайте, с чем мы можем помочь.

2. Нажмите на окно очистки шаблонов и прочтите руководство, в котором рассказывается, какие параметры необходимо заполнить, предварительный просмотр данных и многое другое. Затем нажмите «попробовать» и заполните все параметры.

3. Извлеките данные. Нажмите сохранить и запустить. Вы можете запускать данные локально или в облаке. Если он не поддерживает локальный запуск, его необходимо запустить в облаке. В большинстве случаев мы рекомендуем работать в облаке, чтобы парсер мог парсить с ротацией IP и избегать блокировок.

Создание поискового робота с нуля

Если у вас нет готового к использованию шаблона для ваших целевых веб-сайтов, не беспокойтесь, вы можете создать свои собственные поисковые роботы для сбора нужных данных с любого веб-сайта; это обычно в пределах трех шагов.

1. Перейдите на веб-страницу, которую вы хотите очистить: введите URL-адреса страниц, которые вы хотите очистить, в строке URL на главной странице. Нажмите кнопку «Пуск».

2. Создайте рабочий процесс, нажав «Автоматическое определение данных веб-страницы». Подождите, пока вы не увидите «Автоопределение завершено», а затем вы можете проверить предварительный просмотр данных, чтобы увидеть, есть ли какие-либо ненужные поля данных, которые вы хотели бы удалить или добавить.

3. Нажмите кнопку «Сохранить» и нажмите кнопку «Выполнить», чтобы начать извлечение. Вы можете выбрать «Запустить задачу на своем устройстве», чтобы запустить задачу на своем ПК, или выбрать «Выполнить задачу в облаке», чтобы запустить задачу в облаке, чтобы вы могли запланировать запуск задачи в любое время. .

2. 80legs

80legs — это мощный инструмент веб-сканирования, который можно настроить в соответствии с индивидуальными требованиями. Он поддерживает извлечение огромных объемов данных вместе с возможностью мгновенной загрузки извлеченных данных.

Основные функции 80legs:

- API: 80legs предлагает пользователям API для создания сканеров, управления данными и многого другого.

- Настройка Scraper: платформа приложений 80legs на основе JS позволяет пользователям настраивать веб-сканирование с индивидуальным поведением.

- IP-серверы: набор IP-адресов используется в запросах веб-скрапинга.

3. ParseHub

Parsehub – это поисковый робот, который собирает данные с веб-сайтов с помощью технологии AJAX, JavaScript, файлов cookie и т. д. Его технология машинного обучения позволяет читать, анализировать и затем преобразовывать веб-документы в соответствующие данные.

Основные функции Parsehub:

- Интеграция: Google Sheets, Tableau

- Формат данных: JSON, CSV

- Устройство: Mac, Windows, Linux

4. Visual Scraper

Помимо SaaS, VisualScraper предлагает услуги парсинга веб-страниц, такие как услуги доставки данных и создание программных экстракторов для клиентов. Visual Scraper позволяет пользователям планировать выполнение проектов в определенное время или повторять последовательность каждую минуту, день, неделю, месяц, год. Пользователи могут использовать его для частого извлечения новостей, обновлений, форума.

Пользователи могут использовать его для частого извлечения новостей, обновлений, форума.

Важные особенности Visual Scraper:

- Различные форматы данных: Excel, CSV, MS Access, MySQL, MSSQL, XML или JSON.

- Похоже, что официальный сайт сейчас не обновляется, и эта информация может быть неактуальной.

5. WebHarvy

WebHarvy — это программа для парсинга веб-страниц, работающая по принципу «укажи и щелкни». Он предназначен для непрограммистов.

Важные особенности WebHarvy:

- Очистите текст, изображения, URL-адреса и электронные письма с веб-сайтов. Поддержка прокси-сервера

- обеспечивает анонимное сканирование и предотвращает блокировку веб-серверами.

- Формат данных: файл XML, CSV, JSON или TSV. Пользователи также могут экспортировать очищенные данные в базу данных SQL.

6.

Content Grabber (Sequentum)

Content Grabber (Sequentum) Content Grabber — это программное обеспечение для сканирования веб-страниц, предназначенное для предприятий. Он позволяет создавать автономные агенты веб-сканирования. Пользователям разрешено использовать C# или VB.NET для отладки или написания сценариев для управления программированием процесса сканирования. Он может извлекать контент практически с любого веб-сайта и сохранять его в виде структурированных данных в выбранном вами формате.

Важные функции Content Grabber:

- Интеграция со сторонними приложениями для анализа данных или создания отчетов.

- Мощное редактирование сценариев, интерфейсы отладки.

- Форматы данных: отчеты Excel, XML, CSV и большинство баз данных.

7. Helium Scraper

Helium Scraper — это программное обеспечение для визуального сканирования веб-данных, предназначенное для пользователей. Для новых пользователей доступна 10-дневная пробная версия, и как только вы будете удовлетворены тем, как она работает, совершив разовую покупку, вы сможете использовать программное обеспечение всю жизнь. По сути, это может удовлетворить потребности пользователей в сканировании на начальном уровне.

Для новых пользователей доступна 10-дневная пробная версия, и как только вы будете удовлетворены тем, как она работает, совершив разовую покупку, вы сможете использовать программное обеспечение всю жизнь. По сути, это может удовлетворить потребности пользователей в сканировании на начальном уровне.

Основные характеристики elium Scraper:

- Формат данных: Экспорт данных в CSV, Excel, XML, JSON или SQLite.

- Быстрое извлечение: параметры для блокировки изображений или нежелательных веб-запросов.

- Ротация прокси.

Загрузчик веб-сайтов 8. Cyotek WebCopy

Cyotek WebCopy иллюстративен, как и его название. Это бесплатный сканер веб-сайтов, который позволяет частично или полностью копировать веб-сайты локально на жесткий диск для использования в автономном режиме. Вы можете изменить его настройку, чтобы сообщить боту, как вы хотите сканировать. Кроме того, вы также можете настроить псевдонимы доменов, строки пользовательского агента, документы по умолчанию и многое другое.

Однако WebCopy не включает виртуальную модель DOM или какую-либо форму синтаксического анализа JavaScript. Если веб-сайт интенсивно использует JavaScript для работы, более вероятно, что WebCopy не сможет сделать точную копию. Скорее всего, он не будет правильно обрабатывать динамические макеты веб-сайтов из-за интенсивного использования JavaScript.

9. HTTrack

Будучи бесплатным программным обеспечением для сканирования веб-сайтов, HTTrack предоставляет функции, хорошо подходящие для загрузки всего веб-сайта на ваш компьютер. У него есть версии для Windows, Linux, Sun Solaris и других систем Unix, которые охватывают большинство пользователей. Интересно, что HTTrack может отображать один сайт или несколько сайтов вместе (с общими ссылками). Вы можете указать количество подключений, которые будут открываться одновременно при загрузке веб-страниц, в разделе «Установить параметры». Вы можете получить фотографии, файлы и HTML-код с зеркального веб-сайта и возобновить прерванную загрузку.

Кроме того, в HTTrack доступна поддержка прокси для максимальной скорости. HTTrack работает как программа командной строки или через оболочку для частного (захват) или профессионального (онлайн-зеркало) использования. С учетом сказанного, HTTrack следует предпочитать и использовать больше людям с продвинутыми навыками программирования.

10. Getleft

Getleft — бесплатный и простой в использовании инструмент для захвата веб-сайтов. Он позволяет загружать весь веб-сайт или любую отдельную веб-страницу. После запуска Getleft вы можете ввести URL-адрес и выбрать файлы, которые хотите загрузить, прежде чем он запустится. Пока он работает, он меняет все ссылки для локального просмотра. Кроме того, он предлагает многоязычную поддержку. Теперь Getleft поддерживает 14 языков! Тем не менее, он обеспечивает только ограниченную поддержку Ftp, он будет загружать файлы, но не рекурсивно.

В целом Getleft должен удовлетворить базовые потребности пользователей в сканировании без более сложных тактических навыков.

Extension/Add-on Web Scrapers 11. Scraper

Scraper — это расширение Chrome с ограниченными функциями извлечения данных, но оно полезно для проведения онлайн-исследований. Это также позволяет экспортировать данные в таблицы Google. Этот инструмент предназначен для начинающих и экспертов. Вы можете легко скопировать данные в буфер обмена или сохранить их в электронных таблицах с помощью OAuth. Scraper может автоматически генерировать XPath для определения URL-адресов для сканирования. Он не предлагает всеохватывающие услуги сканирования, но большинству людей все равно не нужно заниматься запутанными конфигурациями.

12. OutWit Hub

OutWit Hub — это надстройка Firefox с десятками функций извлечения данных, упрощающих поиск в Интернете. Этот инструмент веб-сканера может просматривать страницы и сохранять извлеченную информацию в надлежащем формате.

OutWit Hub предлагает единый интерфейс для извлечения небольших или огромных объемов данных в соответствии с потребностями. OutWit Hub позволяет вам очистить любую веб-страницу из самого браузера. Он даже может создавать автоматических агентов для извлечения данных.

OutWit Hub позволяет вам очистить любую веб-страницу из самого браузера. Он даже может создавать автоматических агентов для извлечения данных.

Это один из самых простых инструментов веб-скрейпинга, который можно использовать бесплатно и который предлагает вам удобное извлечение веб-данных без написания единой строки кода.

Web Scraping Services 13. Scrapinghub (теперь Zyte)

Scrapinghub — это облачный инструмент для извлечения данных, который помогает тысячам разработчиков извлекать ценные данные. Его инструмент визуальной очистки с открытым исходным кодом позволяет пользователям очищать веб-сайты без каких-либо знаний в области программирования.

Scrapinghub использует Crawlera, интеллектуальный ротатор прокси-серверов, который поддерживает обход мер противодействия ботам, чтобы легко сканировать огромные или защищенные ботами сайты. Это позволяет пользователям выполнять сканирование с нескольких IP-адресов и мест без проблем с управлением прокси-сервером через простой HTTP API.

Scrapinghub преобразует всю веб-страницу в организованный контент. Его команда экспертов готова помочь в случае, если его конструктор сканирования не может работать в соответствии с вашими требованиями.

14. Dexi.io

В качестве поискового робота на основе браузера Dexi.io позволяет вам собирать данные на основе вашего браузера с любого веб-сайта и предоставляет вам три типа роботов для создания задачи очистки — экстрактор, краулер и каналы. Бесплатное программное обеспечение предоставляет анонимные веб-прокси-серверы для веб-скрапинга, и ваши извлеченные данные будут размещаться на серверах Dexi.io в течение двух недель, прежде чем данные будут заархивированы, или вы можете напрямую экспортировать извлеченные данные в файлы JSON или CSV. Он предлагает платные услуги для удовлетворения ваших потребностей в получении данных в реальном времени.

15. Webhose.io

Webhose.io позволяет пользователям получать данные в режиме реального времени путем сканирования онлайн-источников со всего мира в различных чистых форматах. Этот поисковый робот позволяет сканировать данные и дополнительно извлекать ключевые слова на разных языках, используя несколько фильтров, охватывающих широкий спектр источников.

Этот поисковый робот позволяет сканировать данные и дополнительно извлекать ключевые слова на разных языках, используя несколько фильтров, охватывающих широкий спектр источников.

И вы можете сохранить очищенные данные в форматах XML, JSON и RSS. И пользователям разрешен доступ к данным истории из своего архива. Кроме того, webhose.io поддерживает не более 80 языков с результатами сканирования данных. И пользователи могут легко индексировать и искать структурированные данные, просканированные Webhose.io.

В целом, Webhose.io может удовлетворить элементарные требования пользователей к сканированию.

16. Импорт. io

Пользователи могут формировать свои собственные наборы данных, просто импортируя данные с определенной веб-страницы и экспортируя данные в CSV.

Вы можете легко очистить тысячи веб-страниц за считанные минуты, не написав ни одной строки кода, и создать более 1000 API-интерфейсов в соответствии с вашими требованиями. Общедоступные API предоставляют мощные и гибкие возможности для программного управления Import.io и получения автоматизированного доступа к данным. Import.io упростил сканирование, интегрировав веб-данные в ваше собственное приложение или веб-сайт всего за несколько кликов.

Общедоступные API предоставляют мощные и гибкие возможности для программного управления Import.io и получения автоматизированного доступа к данным. Import.io упростил сканирование, интегрировав веб-данные в ваше собственное приложение или веб-сайт всего за несколько кликов.

Чтобы лучше удовлетворять потребности пользователей в сканировании, он также предлагает бесплатное приложение для Windows, Mac OS X и Linux для создания средств извлечения и сканирования данных, загрузки данных и синхронизации с онлайн-аккаунтом. Кроме того, пользователи могут планировать задачи сканирования еженедельно, ежедневно или ежечасно.

17. Spinn3r (теперь datastreamer.io)

Spinn3r позволяет получать полные данные из блогов, новостей и сайтов социальных сетей, а также каналов RSS и ATOM. Spinn3r распространяется с API Firehouse, который управляет 95 % работы по индексированию. Он предлагает расширенную защиту от спама, которая удаляет спам и недопустимое использование языка, тем самым повышая безопасность данных.

Spinn3r индексирует контент, аналогичный Google , и сохраняет извлеченные данные в файлах JSON. Веб-скребок постоянно сканирует Интернет и находит обновления из нескольких источников, чтобы получать публикации в режиме реального времени. Консоль администратора позволяет управлять сканированием, а полнотекстовый поиск позволяет выполнять сложные запросы к необработанным данным.

RPA-инструмент веб-скрейпинга 18. UiPath

UiPath — это роботизированное программное обеспечение для автоматизации процессов для бесплатного парсинга веб-страниц. Он автоматизирует сканирование веб-данных и данных на рабочем столе из большинства сторонних приложений. Вы можете установить программное обеспечение для роботизированной автоматизации процессов, если вы запускаете его в Windows. Uipath может извлекать табличные данные и данные на основе шаблонов на нескольких веб-страницах.

Uipath предоставляет встроенные инструменты для дальнейшего сканирования. Этот метод очень эффективен при работе со сложными пользовательскими интерфейсами. Инструмент очистки экрана может обрабатывать как отдельные текстовые элементы, группы текста и блоки текста, например извлекать данные в формате таблицы.

Этот метод очень эффективен при работе со сложными пользовательскими интерфейсами. Инструмент очистки экрана может обрабатывать как отдельные текстовые элементы, группы текста и блоки текста, например извлекать данные в формате таблицы.

Кроме того, для создания интеллектуальных веб-агентов не требуется никакого программирования, но хакер .NET внутри вас будет иметь полный контроль над данными.

Библиотека для программистов 19. Scrapy

Scrapy — это платформа с открытым исходным кодом, работающая на Python. Библиотека предлагает программистам готовую к использованию структуру для настройки поискового робота и извлечения данных из Интернета в больших масштабах. С помощью Scrapy вы сможете гибко настроить парсер в соответствии с вашими потребностями, например, чтобы точно определить, какие данные вы извлекаете, как они очищаются и в каком формате они будут экспортироваться.

С другой стороны, вы столкнетесь с множеством проблем в процессе парсинга веб-страниц и приложите усилия для его поддержания. С учетом сказанного вы можете начать с некоторых реальных практик очистки данных с помощью python.

С учетом сказанного вы можете начать с некоторых реальных практик очистки данных с помощью python.

20. Puppeteer

Puppeteer — это библиотека Node, разработанная Google. Он предоставляет программистам API для управления Chrome или Chromium по протоколу DevTools, а также позволяет программистам создавать инструменты веб-скрейпинга с помощью Puppeteer и Node.js. Если вы новичок в программировании, вы можете потратить некоторое время на учебные пособия, в которых рассказывается, как очищать Интернет с помощью Puppeteer.

Помимо парсинга веб-страниц, Puppeteer также используется для:

- получения скриншотов или PDF-файлов веб-страниц.

- Автоматизировать отправку форм/ввод данных.

- Создать инструмент для автоматического тестирования.

Выберите один из перечисленных парсеров в соответствии с вашими потребностями. Вы можете просто создать поисковый робот и извлекать данные с любого веб-сайта.

Связанные ресурсы

Что такое веб-краулер и как он работает

Законно ли сканирование веб-страниц

Создайте веб-краулер с помощью Octoparse

30 лучших инструментов обработки больших данных для анализа данных

Бесплатные онлайн-инструменты для веб-сканеров

Screaming Frog SEO Spider Website Crawler

Ведущий в отрасли сканер веб-сайтов для Windows, macOS и Linux, которому тысячи SEO-специалистов и агентств по всему миру доверяют технический SEO-аудит сайтов.

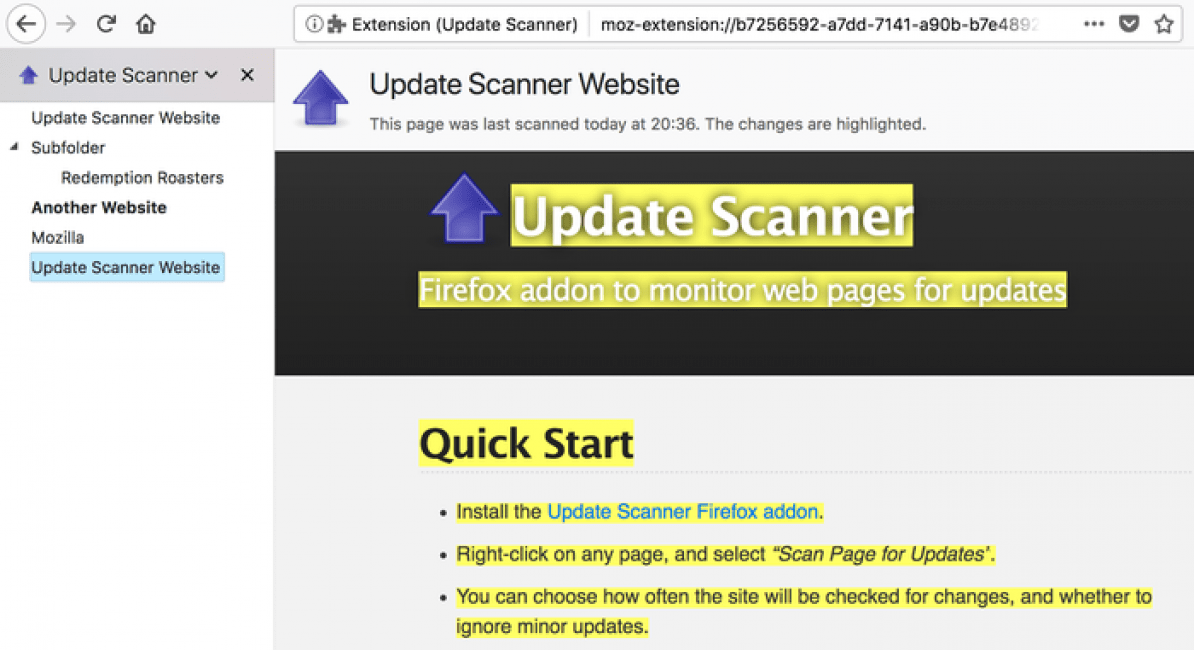

Инструмент SEO Spider

Screaming Frog SEO Spider — это поисковый робот для веб-сайтов, который помогает улучшить внутреннюю SEO-оптимизацию путем проверки распространенных проблем SEO. Загрузите и просканируйте 500 URL-адресов бесплатно или купите лицензию, чтобы снять ограничение и получить доступ к расширенным функциям.

Бесплатная и платная загрузка

youtube.com/embed/Rm_hziAo14A?rel=0&vq=hd1080&showinfo=0 frameborder=» allowfullscreen=»»>Что можно сделать с помощью SEO Spider Tool?

SEO Spider — это мощный и гибкий поисковый робот, способный эффективно сканировать как небольшие, так и очень большие веб-сайты, позволяя вам анализировать результаты в режиме реального времени. Он собирает ключевые данные на месте, чтобы позволить SEO-специалистам принимать обоснованные решения.

Обнаружение повторяющегося контента

Обнаружение точных дубликатов URL-адресов с помощью алгоритмической проверки md5, частично дублированных элементов, таких как как заголовки страниц, описания или заголовки и найти страницы с низким содержанием.

* Максимальное количество URL-адресов, которые вы можете сканировать, зависит от выделенной памяти и хранилища. Пожалуйста, ознакомьтесь с нашими часто задаваемыми вопросами.

Из множества инструментов, которые мы используем в iPullRank, я могу с уверенностью сказать, что я использую только Screaming Frog SEO Spider каждый божий день. Он невероятно многофункциональный, быстро улучшается, и я регулярно нахожу новый вариант использования. Я не могу поддержать это достаточно сильно.

Он невероятно многофункциональный, быстро улучшается, и я регулярно нахожу новый вариант использования. Я не могу поддержать это достаточно сильно.

Майк Кинг

Основатель iPullRank

Screaming Frog SEO Spider — это мой основной инструмент для первоначального SEO-аудита и быстрой проверки: мощный, гибкий и недорогой. Я не мог бы рекомендовать это больше.

Алейда Солис

Владелец, Ораинти

Инструмент SEO Spider Tool сканирует и сообщает о…

The Screaming Frog SEO Spider — это инструмент SEO-аудита, созданный настоящими SEO-специалистами с тысячами пользователей по всему миру. Краткий обзор некоторых данных, собранных при сканировании include —

- Ошибки — Ошибки клиента, такие как неработающие ссылки и ошибки сервера (нет ответов, ошибки клиента 4XX и сервера 5XX).

- Перенаправления — Постоянные, временные, перенаправления JavaScript и метаобновления.

- Заблокированные URL-адреса — Просмотр и аудит URL-адресов, запрещенных протоколом robots.txt.

- Заблокированные ресурсы — Просмотр и аудит заблокированных ресурсов в режиме рендеринга.

- Внешние ссылки — просмотр всех внешних ссылок, их кодов состояния и исходных страниц.

- Безопасность . Обнаружение небезопасных страниц, смешанного содержимого, небезопасных форм, отсутствующих заголовков безопасности и многого другого.

- Проблемы с URL-адресами — символы, отличные от ASCII, символы подчеркивания, символы верхнего регистра, параметры или длинные URL-адреса.

- Duplicate Pages — Обнаружение точных и близких к дубликату страниц с помощью расширенных алгоритмических проверок.

- Заголовки страниц — Отсутствующие, повторяющиеся, длинные, короткие или множественные элементы заголовка.

- Мета-описание — Отсутствующие, повторяющиеся, длинные, короткие или множественные описания.

- Мета-ключевые слова — В основном для справочных или региональных поисковых систем, поскольку они не используются Google, Bing или Yahoo.

- Размер файла — Размер URL-адресов и изображений.

- Время ответа — просмотрите, сколько времени требуется страницам для ответа на запросы.

- Заголовок последнего изменения — просмотр даты последнего изменения в заголовке HTTP.

- Глубина сканирования — просмотр глубины URL-адреса в архитектуре веб-сайта.

- Количество слов — Анализ количества слов на каждой странице.

- h2 — Отсутствующие, повторяющиеся, длинные, короткие или множественные заголовки.

- h3 – Отсутствующие, повторяющиеся, длинные, короткие или множественные заголовки

- Meta Robots – Index, noindex, follow, nofollow, noarchive, nosnippet и т.

д.

д. - Meta Refresh — Включая целевую страницу и временную задержку.

- Canonicals — Элементы ссылок и канонические заголовки HTTP.

- X-Robots-Tag — см. директивы, издаваемые через заголовок HTTP.

- Разбиение на страницы — просмотр атрибутов rel=»next» и rel=»prev».

- Follow & Nofollow — Просмотр мета-атрибутов nofollow и nofollow ссылок.

- Цепочки перенаправления – Узнайте о цепочках и петлях перенаправления.

- Атрибуты hreflang — Аудит отсутствующих ссылок подтверждения, несовместимых и неправильных языковых кодов, неканонического hreflang и т. д.

- Внутренние ссылки — просмотр всех страниц, ссылающихся на URL-адрес, текст привязки и указание на то, является ли ссылка подпиской или nofollow.

- Исходящие ссылки — просмотр всех страниц, на которые ссылается URL, а также ресурсов.

- Якорный текст — Весь текст ссылки. Альтернативный текст изображений со ссылками.

- Визуализация — Сканирование фреймворков JavaScript, таких как AngularJS и React, путем сканирования отображаемого HTML-кода после выполнения JavaScript.

- AJAX — выберите, чтобы подчиняться устаревшей схеме сканирования Google AJAX.

- Изображения — Все URL-адреса со ссылкой на изображение и все изображения с данной страницы. Изображения более 100 КБ, отсутствует замещающий текст, замещающий текст превышает 100 символов.

- User-Agent Switcher — сканирование как Googlebot, Bingbot, Yahoo! Slurp, мобильные юзер-агенты или ваш собственный UA.

- Пользовательские заголовки HTTP — Укажите любое значение заголовка в запросе, от Accept-Language до cookie.

- Пользовательский поиск по исходному коду — Найдите все, что хотите, в исходном коде веб-сайта! Будь то код Google Analytics, конкретный текст или код и т.

д.

д. - Пользовательское извлечение — Соберите любые данные из HTML-кода URL-адреса с помощью XPath, селекторов пути CSS или регулярных выражений.

- Интеграция с Google Analytics . Подключитесь к API Google Analytics и извлекайте данные о пользователях и конверсиях непосредственно во время сканирования.

- Интеграция с консолью поиска Google — подключение к Google Search Analytics и API проверки URL и массовый сбор данных о производительности и состоянии индекса.

- Интеграция с PageSpeed Insights — подключение к PSI API для метрик Lighthouse, возможностей повышения скорости, диагностики и данных отчета о пользовательском опыте Chrome (CrUX) в любом масштабе.

- Показатели внешних ссылок — извлекайте показатели внешних ссылок из Majestic, Ahrefs и API Moz в сканирование для выполнения аудита контента или ссылок на профили.

- Генерация XML-карты сайта — Создайте XML-карту сайта и карту сайта с изображением с помощью поискового робота.

- Пользовательский файл robots.txt — Загрузите, отредактируйте и протестируйте файл robots.txt сайта с помощью нового пользовательского файла robots.txt.

- Визуализированные снимки экрана — выборка, просмотр и анализ просканированных визуализированных страниц.

- Store & View HTML & Rendered HTML — необходим для анализа DOM.

- Сканирование и проверка AMP — Сканируйте URL-адреса AMP и проверяйте их с помощью официального встроенного средства проверки AMP.

- Анализ XML-карты сайта — сканирование XML-карты сайта независимо или в рамках сканирования для поиска отсутствующих, неиндексируемых и бесхозных страниц.

- Визуализации — анализ внутренней структуры ссылок и URL-адресов веб-сайта с использованием сканирующих диаграмм и древовидных графов дерева каталогов.

- Структурированные данные и проверка — Извлечение и проверка структурированных данных на соответствие спецификациям Schema.

org и функциям поиска Google.

org и функциям поиска Google. - Проверка орфографии и грамматики . Проверьте орфографию и грамматику вашего веб-сайта на более чем 25 различных языках.

- Сравнение сканирования — Сравните данные сканирования, чтобы увидеть изменения в проблемах и возможности для отслеживания технического прогресса SEO. Сравнивайте структуру сайта, выявляйте изменения в ключевых элементах и показателях и используйте сопоставление URL-адресов для сравнения промежуточных и рабочих сайтов.

Я протестировал почти все SEO-инструменты, появившиеся на рынке, но не могу вспомнить ни одного из них, которым я пользуюсь чаще, чем Screaming Frog. Для меня это швейцарский армейский нож SEO-инструментов. Screaming Frog стал бесценным ресурсом в моем SEO-арсенале, от обнаружения серьезных технических проблем SEO до сканирования верхних целевых страниц после миграции, выявления проблем с рендерингом JavaScript и устранения международных проблем SEO. Я настоятельно рекомендую Screaming Frog всем, кто занимается SEO.

Я настоятельно рекомендую Screaming Frog всем, кто занимается SEO.

Гленн Гейб

Основатель, GSQI

Screaming Frog Web Crawler — один из основных инструментов, к которому я обращаюсь при проведении аудита сайта. Это экономит время, когда я хочу проанализировать структуру сайта или составить список контента для сайта, где я могу определить, насколько эффективен сайт для удовлетворения информационных или ситуационных потребностей аудитории этого сайта. Обычно я каждый год покупаю новое издание Screaming Frog на свой день рождения, и это один из лучших подарков на день рождения, который я мог себе сделать.

Билл Славски

Директор, Go Fish Digital

Об инструменте

Screaming Frog SEO Spider — это быстрый и продвинутый инструмент SEO-аудита сайта. Его можно использовать для сканирования как небольших, так и очень больших веб-сайтов, где ручная проверка каждой страницы была бы чрезвычайно трудоемкой, и где вы можете легко пропустить проблему перенаправления, метаобновления или дублирования страницы. Вы можете просматривать, анализировать и фильтровать данные сканирования по мере их сбора и постоянного обновления в пользовательском интерфейсе программы.

Вы можете просматривать, анализировать и фильтровать данные сканирования по мере их сбора и постоянного обновления в пользовательском интерфейсе программы.

SEO Spider позволяет экспортировать ключевые элементы SEO на сайте (URL, заголовок страницы, мета-описание, заголовки и т. д.) в электронную таблицу, чтобы ее можно было легко использовать в качестве основы для рекомендаций по SEO. Посмотрите наше демонстрационное видео выше.

Просканировать 500 URL-адресов бесплатно

Упрощенную версию инструмента можно загрузить и использовать бесплатно. Однако эта версия ограничена сканированием до 500 URL-адресов за одно сканирование и не дает вам полного доступа к конфигурации, сохранению обходов или расширенным функциям, таким как рендеринг JavaScript, настраиваемое извлечение, интеграция с Google Analytics и многое другое. Вы можете сканировать 500 URL-адресов с одного и того же веб-сайта или столько веб-сайтов, сколько хотите, сколько угодно раз!

Всего за 199 фунтов стерлингов в год вы можете приобрести лицензию, которая снимает ограничение на сканирование 500 URL-адресов, позволяет сохранять сканирование и открывает параметры конфигурации и расширенные функции паука.

Либо нажмите кнопку «Купить лицензию» в SEO Spider, чтобы купить лицензию после загрузки и ознакомления с программным обеспечением.

Часто задаваемые вопросы и руководство пользователя

SEO Spider сканирует такие сайты, как Googlebot, обнаруживая гиперссылки в HTML, используя алгоритм поиска в ширину. Он использует настраиваемый гибридный механизм хранения, способный сохранять данные в ОЗУ и на диске для сканирования больших веб-сайтов. По умолчанию он будет сканировать только необработанный HTML-код веб-сайта, но он также может отображать веб-страницы с помощью безголового Chromium для обнаружения контента и ссылок.

Для получения дополнительных рекомендаций и советов по использованию поискового робота Screaming Frog SEO —

- Ознакомьтесь с нашим кратким руководством по началу работы.

- Ознакомьтесь с рекомендуемым оборудованием, руководством пользователя, учебными пособиями и часто задаваемыми вопросами. Пожалуйста, также посмотрите демонстрационное видео, встроенное выше!

- Ознакомьтесь с нашими учебными пособиями, в том числе о том, как использовать SEO Spider для проверки неработающих ссылок, проверки дублированного контента, проверки орфографии и грамматики веб-сайтов, создания файлов Sitemap в формате XML, сканирования JavaScript, тестирования robots.

д.

д.

д.

д.

д.

д.

org и функциям поиска Google.

org и функциям поиска Google.