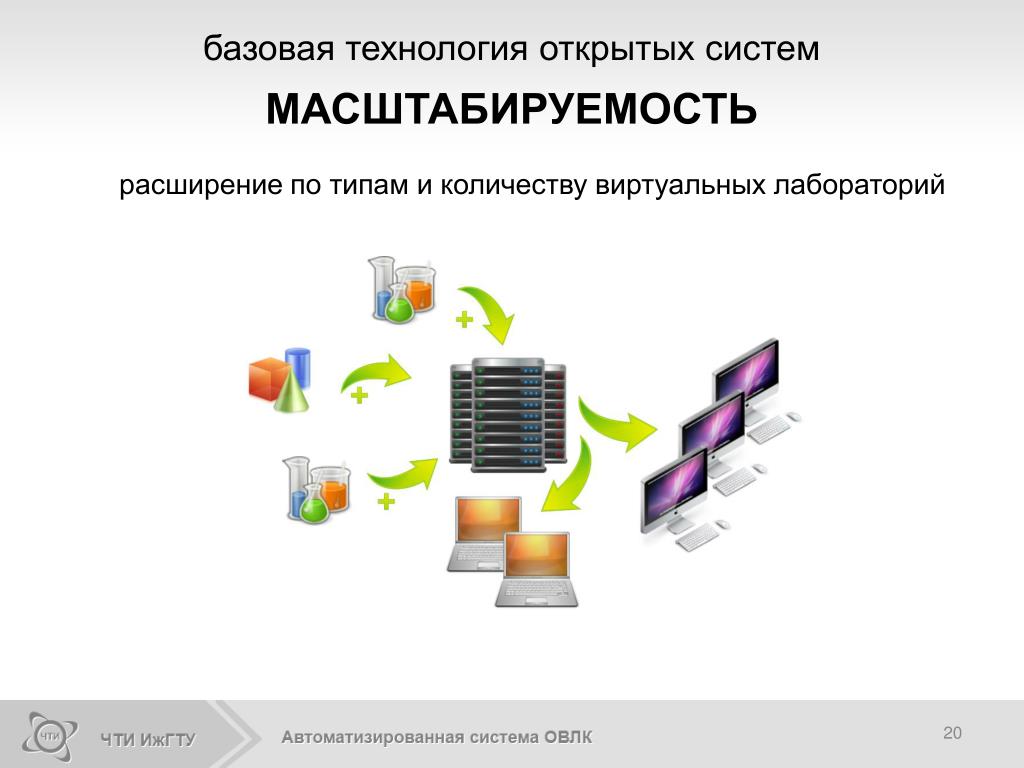

Масштабируемость системы

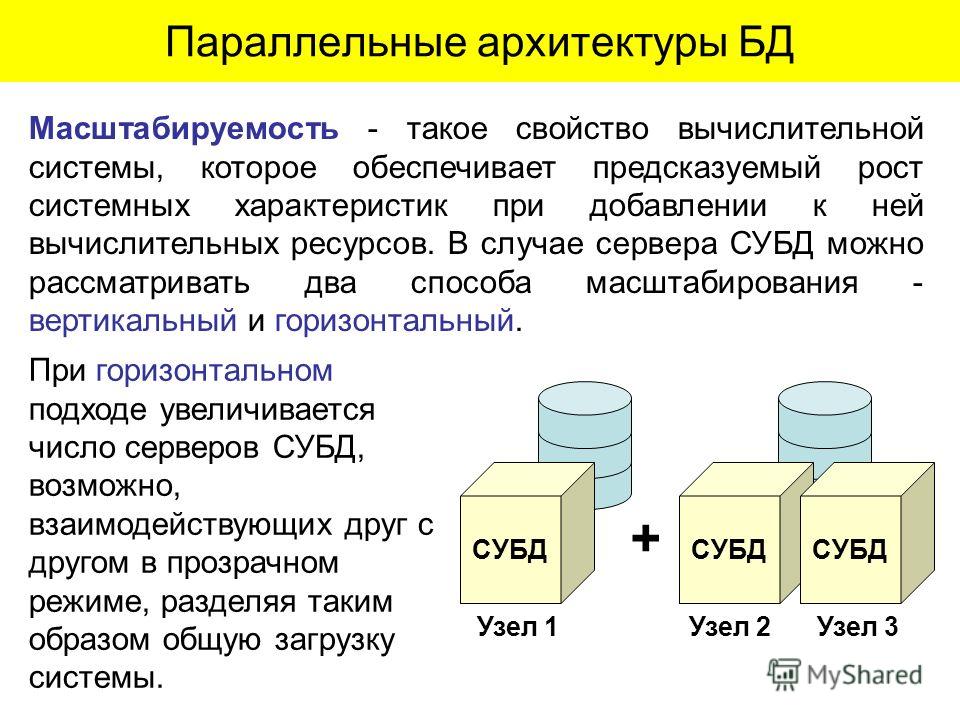

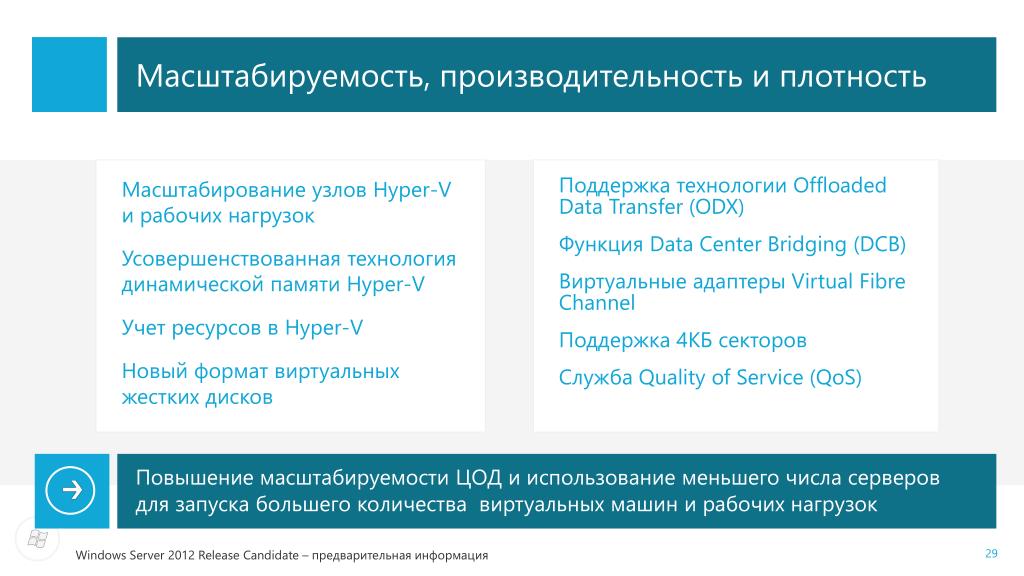

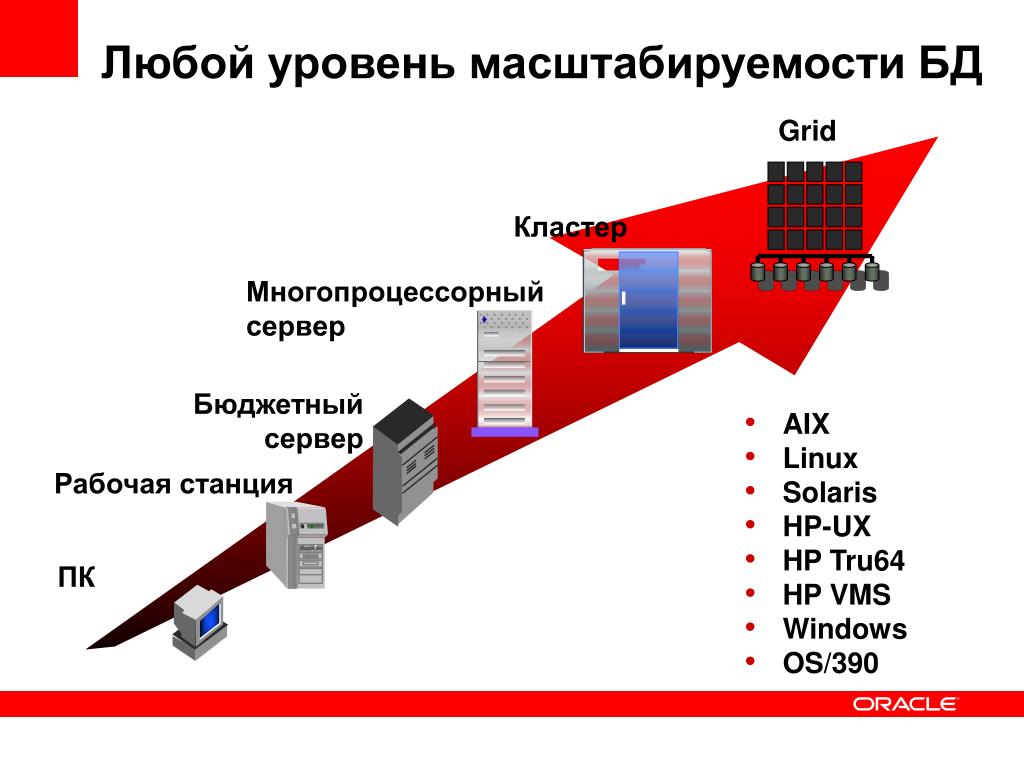

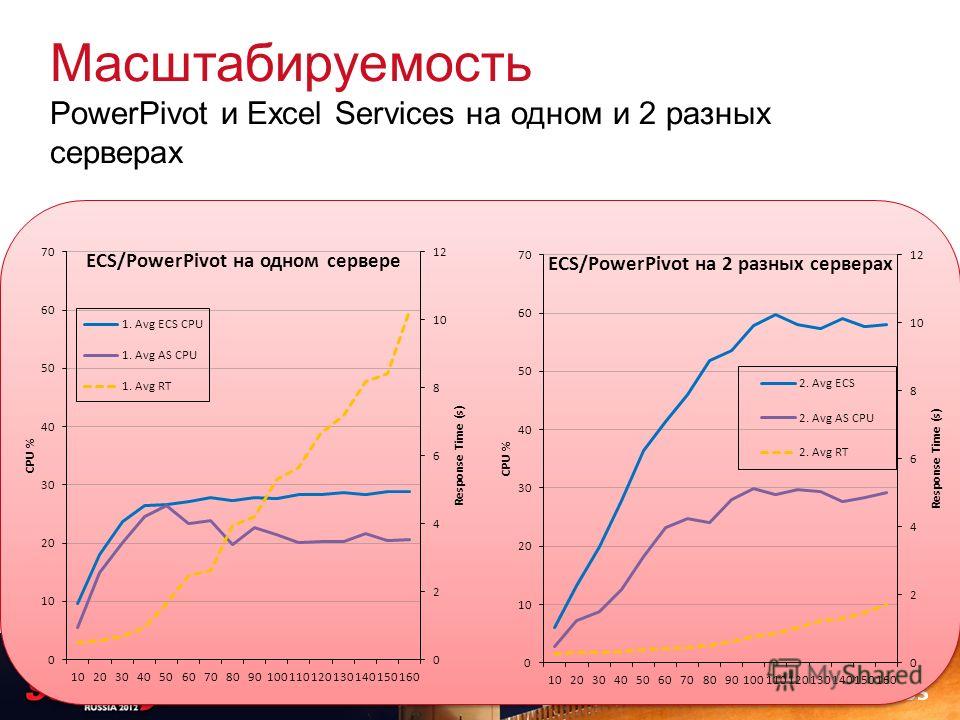

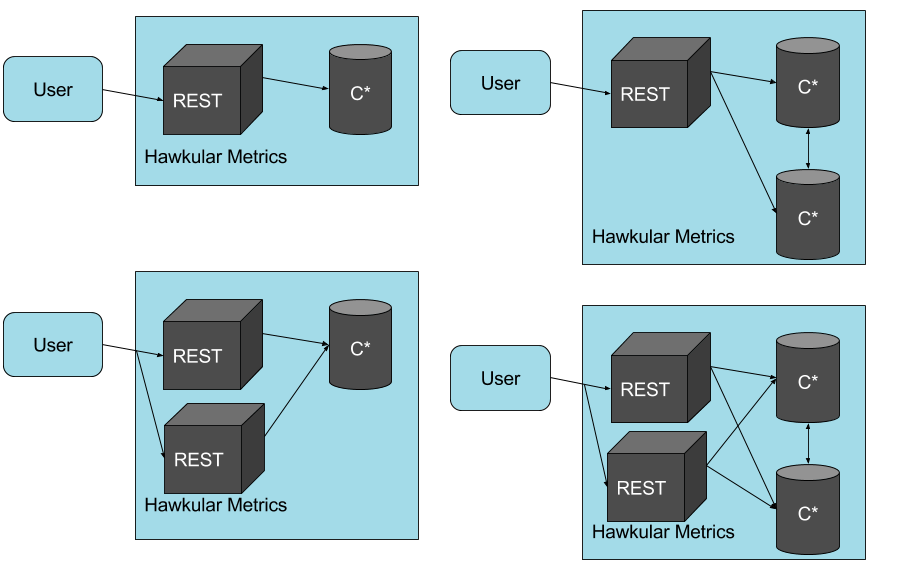

Масштабируемость — такое свойство вычислительной системы, которое обеспечивает предсказуемый рост системных характеристик, например, числа поддерживаемых пользователей, быстроты реакции, общей производительности и пр., при добавлении к ней вычислительных ресурсов. В случае сервера СУБД можно рассматривать два способа масштабирования — вертикальный и горизонтальный (рис. 2).

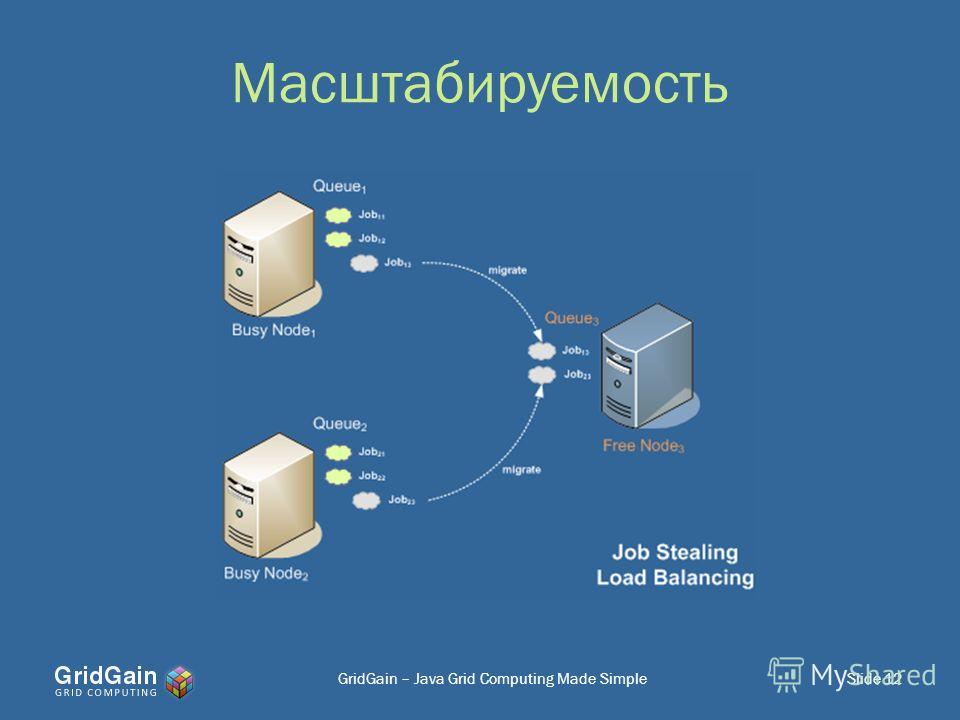

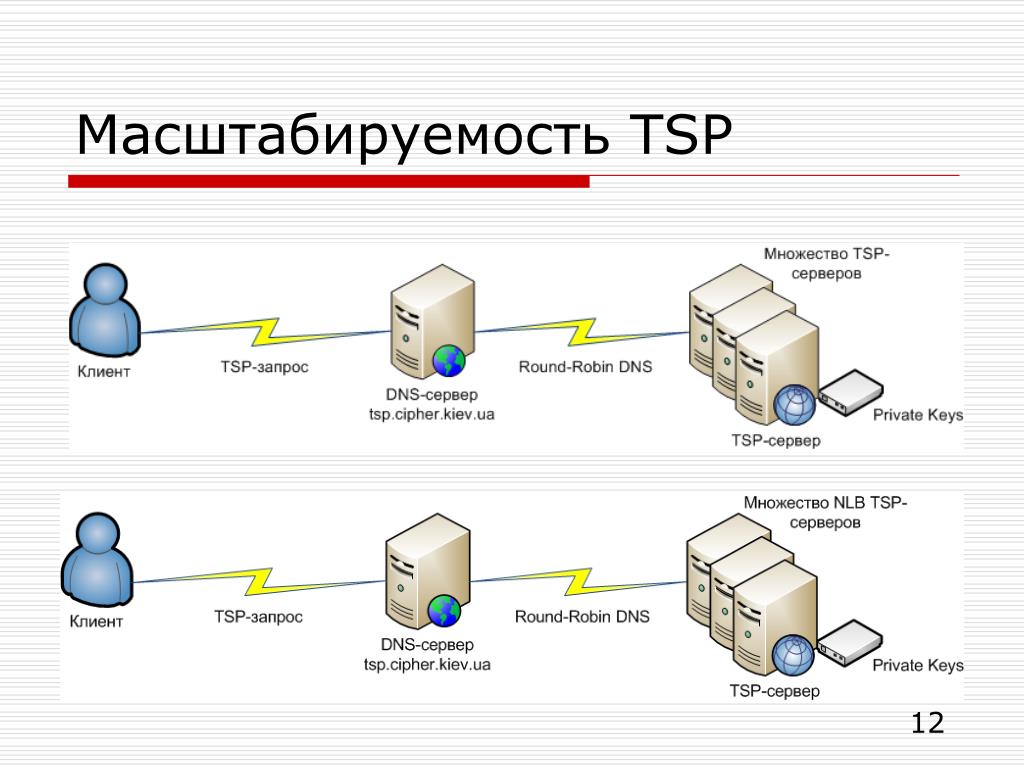

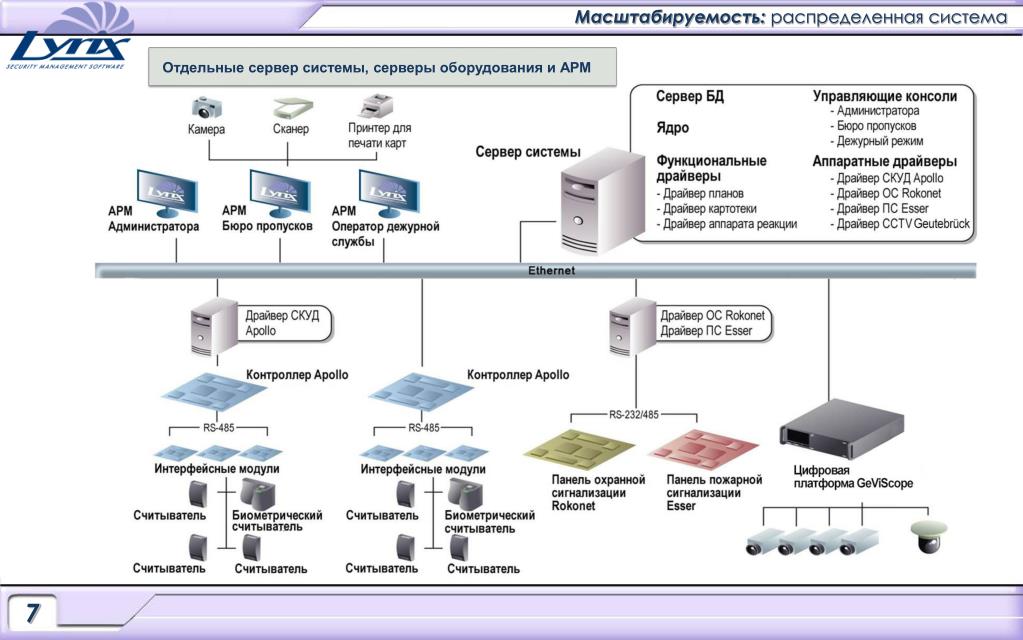

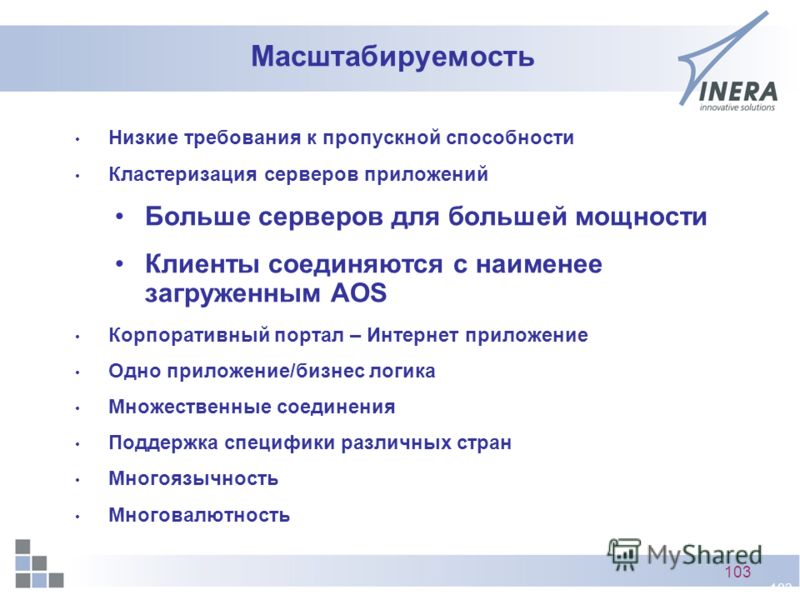

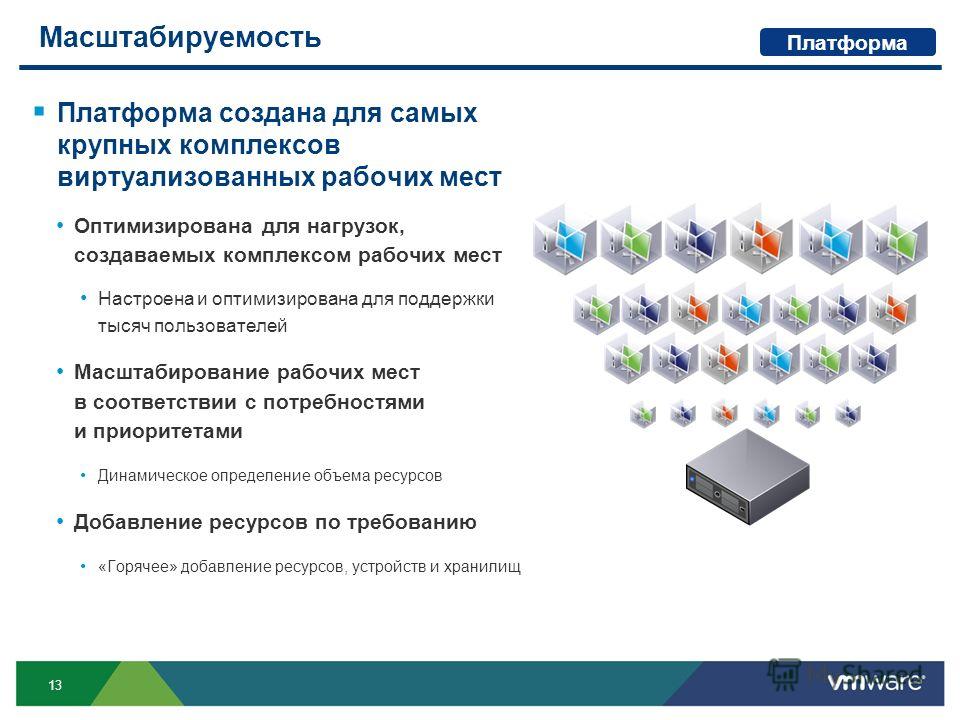

При горизонтальном масштабировании увеличивается число серверов СУБД, возможно, взаимодействующих друг с другом в прозрачном режиме, разделяя таким образом общую загрузку системы. Такое решение, видимо, будет все более популярным с ростом поддержки слабосвязанных архитектур и распределенных баз данных, однако обычно оно характеризуется сложным администрированием.

Вертикальное масштабирование подразумевает увеличение мощности отдельного сервера СУБД и достигается заменой аппаратного обеспечения (процессора, дисков) на более быстродействующее или добавлением дополнительных узлов.

Свойство масштабируемости актуально по двум основным причинам. Прежде всего, условия современного бизнеса меняются столь быстро, что делают невозможным долгосрочное планирование, требующее всестороннего и продолжительного анализа уже устаревших данных, даже для тех организаций, которые способны это себе позволить. Взамен приходит стратегия постепенного, шаг за шагом, наращивания мощности информационных систем. С другой стороны, изменения в технологии приводят к появлению все новых решений и снижению цен на аппаратное обеспечение, что потенциально делает архитектуру информационных систем более гибкой. Одновременно расширяется межоперабельность, открытость программных и аппаратных продуктов разных производителей, хотя пока их усилия, направленные на соответствие стандартам, согласованы лишь в узких секторах рынка. Без учета этих факторов потребитель не сможет воспользоваться преимуществами новых технологий, не замораживая средств, вложенных в недостаточно открытые или оказавшиеся бесперспективными технологии. В области хранения и обработки данных это требует, чтобы и СУБД, и сервер были масштабируемы. Сегодня ключевыми параметрами масштабируемости являются:

С другой стороны, изменения в технологии приводят к появлению все новых решений и снижению цен на аппаратное обеспечение, что потенциально делает архитектуру информационных систем более гибкой. Одновременно расширяется межоперабельность, открытость программных и аппаратных продуктов разных производителей, хотя пока их усилия, направленные на соответствие стандартам, согласованы лишь в узких секторах рынка. Без учета этих факторов потребитель не сможет воспользоваться преимуществами новых технологий, не замораживая средств, вложенных в недостаточно открытые или оказавшиеся бесперспективными технологии. В области хранения и обработки данных это требует, чтобы и СУБД, и сервер были масштабируемы. Сегодня ключевыми параметрами масштабируемости являются:

- поддержка многопроцессорной обработки;

- гибкость архитектуры.

Многопроцессорные системы

е. операционной системы, аппаратного обеспечения, а также навыков администрирования. С этой целью возможно также применение систем с массовым параллелизмом (MPP), но пока их использование ограничивается специальными задачами, например, расчетными. При оценке сервера СУБД с параллельной архитектурой целесообразно обратить внимание на две основные характеристики расширяемости архитектуры: адекватности и прозрачности.

е. операционной системы, аппаратного обеспечения, а также навыков администрирования. С этой целью возможно также применение систем с массовым параллелизмом (MPP), но пока их использование ограничивается специальными задачами, например, расчетными. При оценке сервера СУБД с параллельной архитектурой целесообразно обратить внимание на две основные характеристики расширяемости архитектуры: адекватности и прозрачности.Свойство адекватности требует, чтобы архитектура сервера равно поддерживала один или десять процессоров без переустановки или существенных изменений в конфигурации, а также дополнительных программных модулей. Такая архитектура будет одинаково полезна и эффективна и в однопроцессорной системе, и, по мере роста сложности решаемых задач, на нескольких или даже на множестве (MPP) процессоров. В общем случае потребитель не должен дополнительно покупать и осваивать новые опции программного обеспечения.

Обеспечение прозрачности архитектуры сервера, в свою очередь, позволяет скрыть изменения конфигурации аппаратного обеспечения от приложений, т.

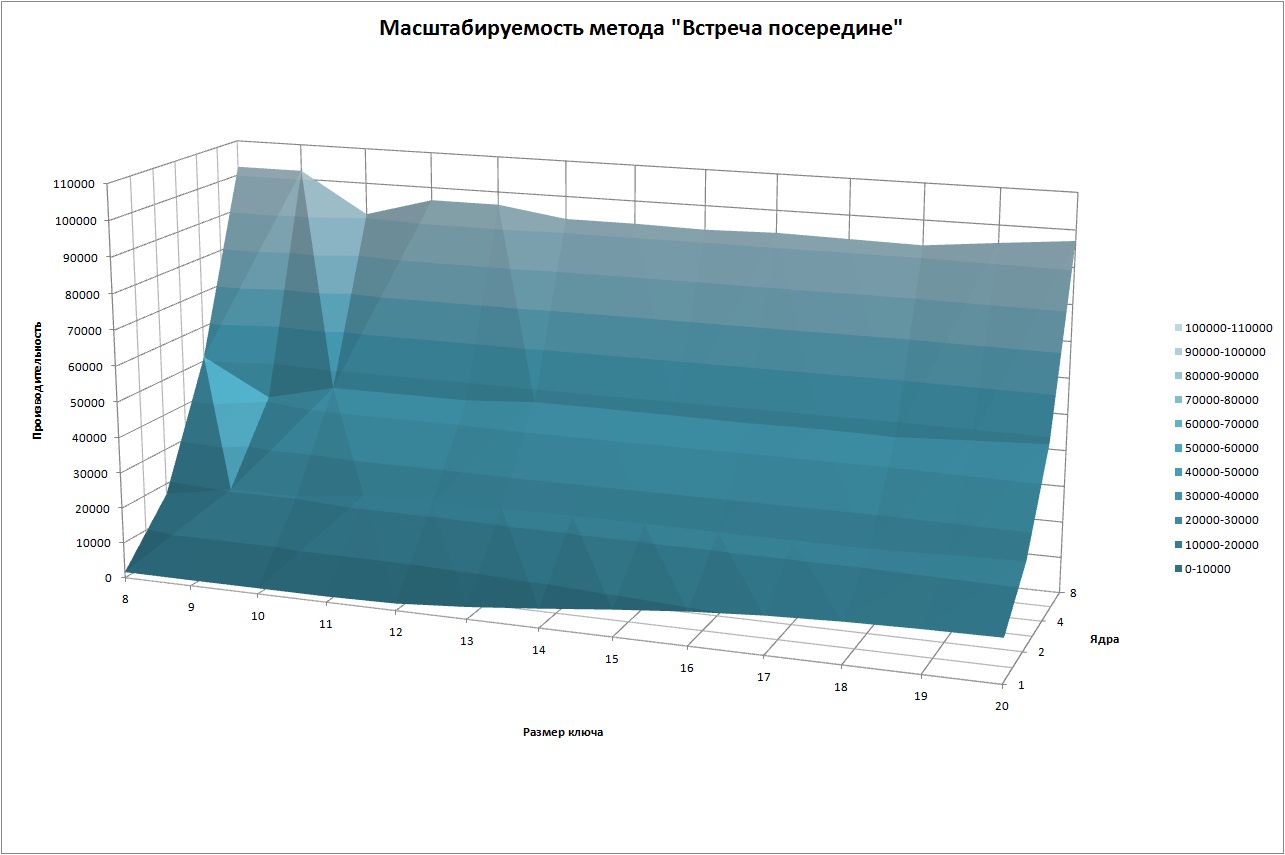

Качественная поддержка многопроцессорной обработки требует от сервера баз данных способности самостоятельно планировать выполнение множества обслуживаемых запросов, что обеспечило бы наиболее полное разделение доступных вычислительных ресурсов между задачами сервера. Запросы могут обрабатываться последовательно несколькими задачами или разделяться на подзадачи, которые, в свою очередь, могут быть выполнены параллельно (рис. 3). Последнее более оптимально, поскольку правильная реализация этого механизма обеспечивает выгоды, независимые от типов запросов и приложений.

Гибкость архитектуры

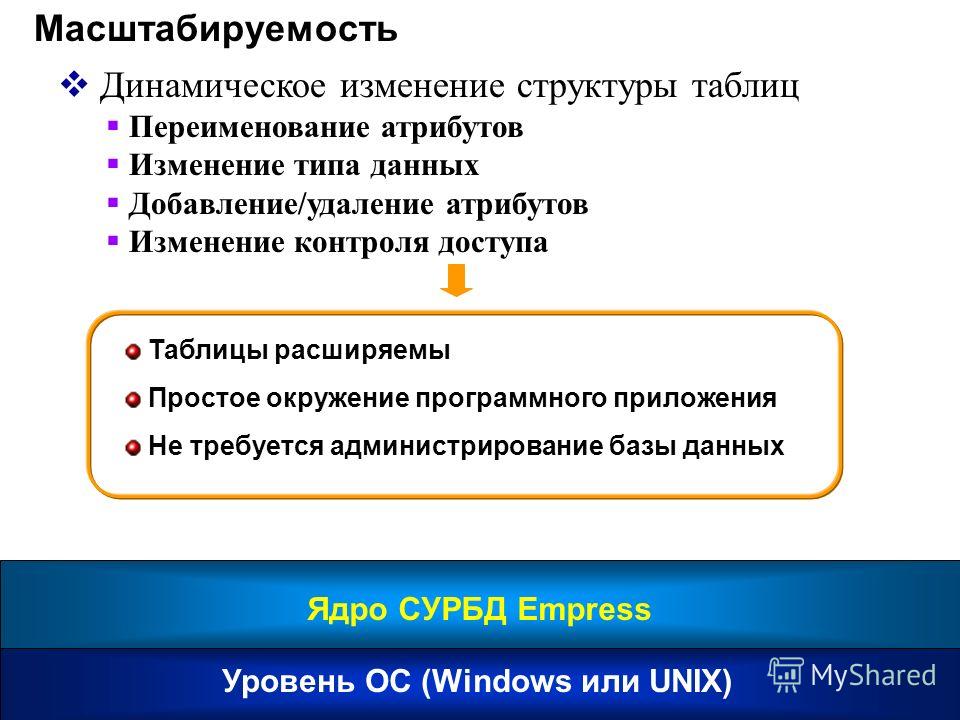

Независимо от степени мобильности, поддержки стандартов, параллелизма и других полезных качеств, производительность СУБД, имеющей ощутимые встроенные архитектурные ограничения, не может наращиваться свободно.

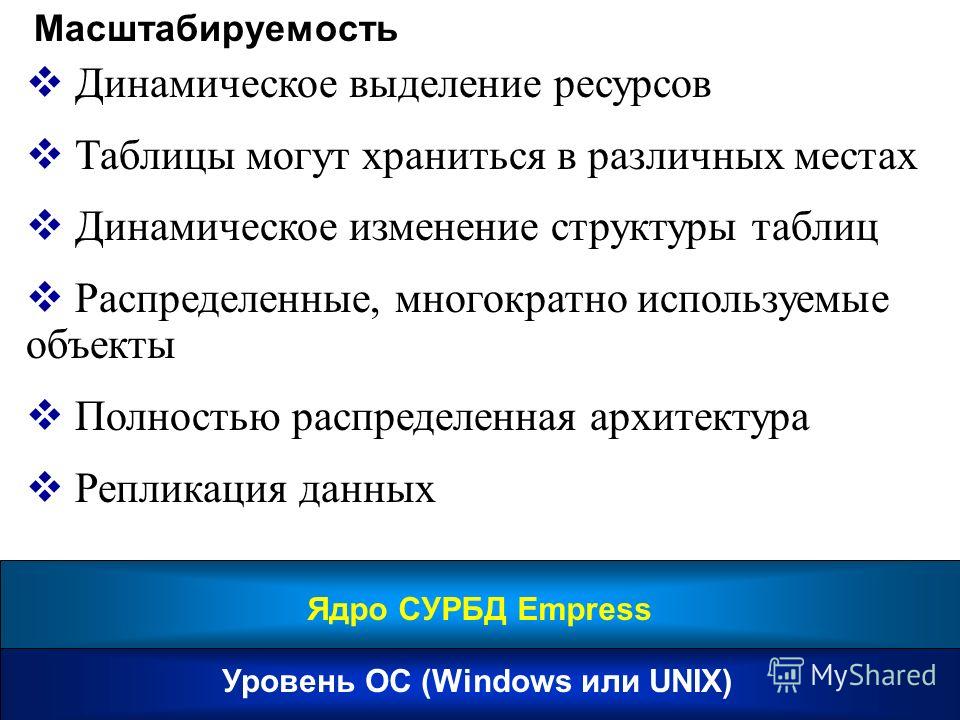

Обычно узким местом является невозможность динамической подстройки характеристик программ сервера баз данных. Способность на ходу определять такие параметры, как объем потребляемой памяти, число занятых процессоров, количество параллельных потоков выполнения заданий (будь то настоящие потоки (threads), процессы операционной системы или виртуальные процессоры) и количество фрагментов таблиц и индексов баз данных, а также их распределение по физическим дискам БЕЗ останова и перезапуска системы является требованием, вытекающим из сути современных приложений.

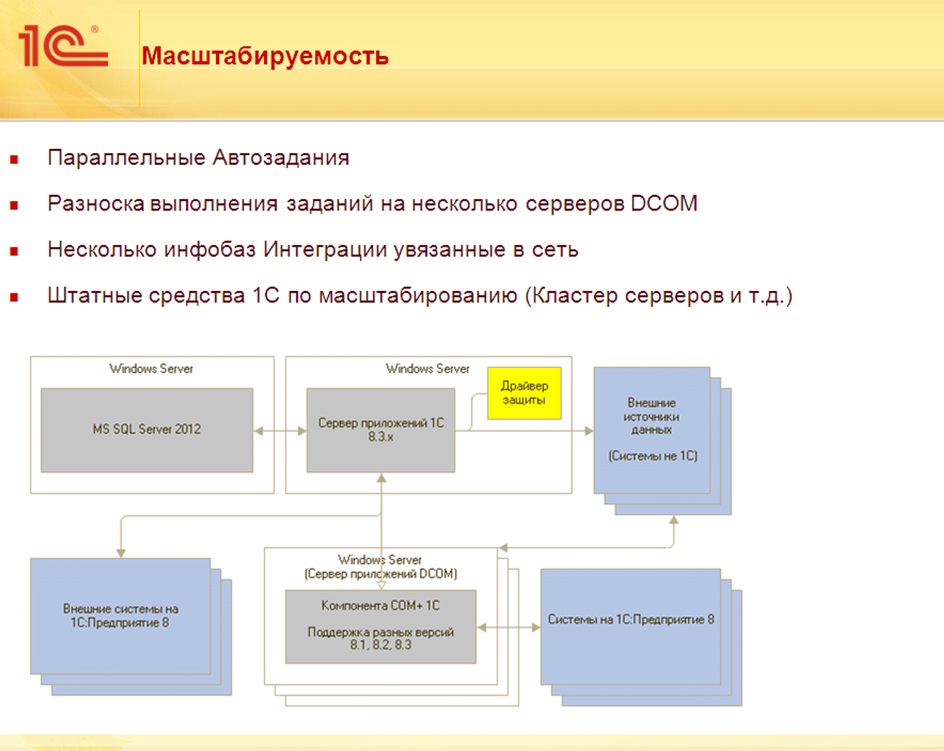

Масштабируемость

Масштабируемость — это способность системы адаптироваться к расширению предъявляемых требований и возрастанию объемов решаемых задач.

Работа одного прикладного решения в разных условиях

Система «1С:Предприятие 8» имеет хорошие возможности масштабирования. Она позволяет работать как в файловом варианте, так и с использованием технологии «клиент-сервер».

Персональное использование, файловый вариант работы

При работе в файловом варианте платформа может работать с локальной информационной базой, расположенной на том же компьютере, на котором работает пользователь. Такой вариант работы может использоваться в домашних условиях или при работе на ноутбуке.

Файловый вариант также обеспечивает возможность работы по локальной сети нескольких пользователей с одной информационной базой. Такой способ работы может использоваться в небольших рабочих группах, он прост в установке и эксплуатации.

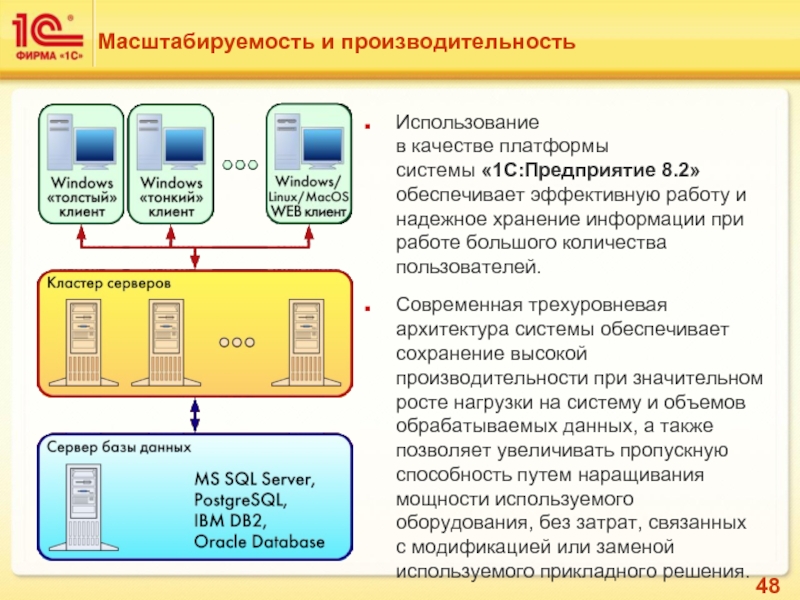

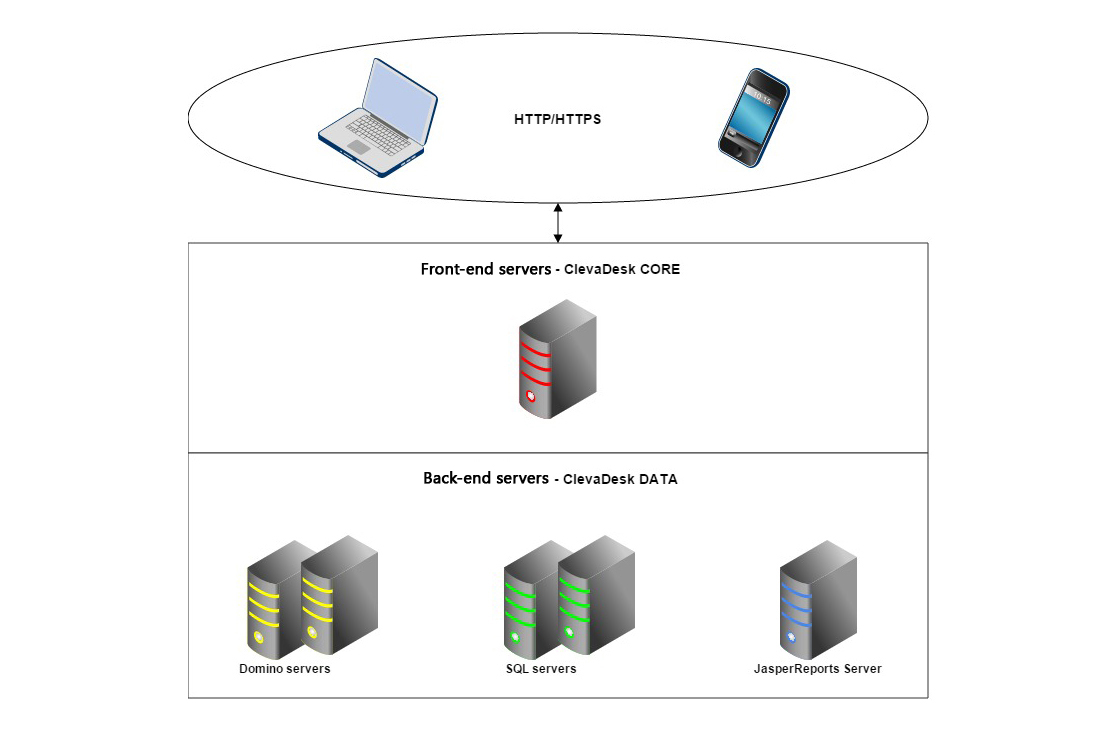

Для больших рабочих групп и в масштабах предприятия может применяться клиент-серверный вариант работы, основанный на трехуровневой архитектуре с использованием кластера серверов «1С:Предприятия 8» и отдельной системы управления базами данных. Он обеспечивает надежное хранение данных и их эффективную обработку при одновременной работе большого количества пользователей.

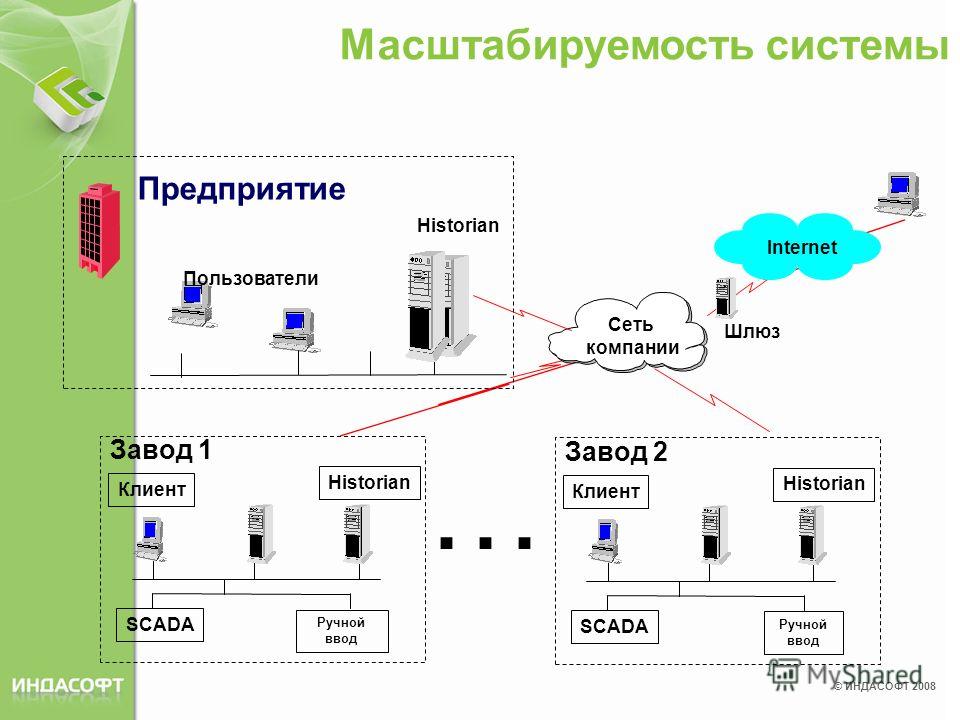

Крупные холдинговые компании могут использовать работу в распределенной информационной базе, сочетающуюся с применением как файлового, так и клиент-серверного вариантов работы. Распределенная информационная база позволяет объединить удаленные друг от друга подразделения холдинга, а каждое из этих подразделений может использовать, в свою очередь, файловый или клиент-серверный варианты работы. Механизм распределенной информационной базы будет обеспечивать идентичность конфигураций, используемых в каждом из подразделений холдинга, и осуществлять обмен данными между отдельными информационными базами, входящими с состав распределенной системы.

Механизм распределенной информационной базы будет обеспечивать идентичность конфигураций, используемых в каждом из подразделений холдинга, и осуществлять обмен данными между отдельными информационными базами, входящими с состав распределенной системы.

Важно отметить, что одни и те же прикладные решения (конфигурации) могут использоваться как в файловом, так и в клиент-серверном варианте работы. При переходе от файлового варианта к технологии «клиент-сервер» не требуется вносить изменения в прикладное решение. Поэтому выбор варианта работы целиком зависит от потребностей заказчика и его финансовых возможностей. На начальной стадии можно работать в файловом варианте, а затем с увеличением количества пользователей и объема базы данных можно легко перейти на клиент-серверный вариант работы со своей информационной базы.

Многопользовательская работа

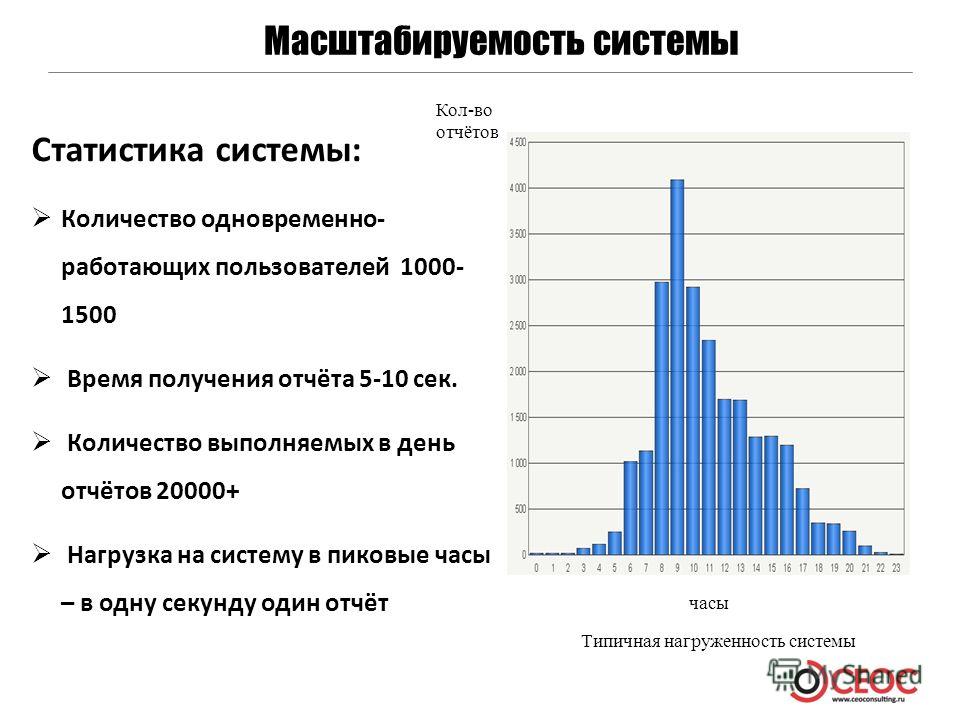

Одним из основных показателей масштабируемости системы является возможность эффективной работы при увеличении количества решаемых задач, объема обрабатываемых данных и количества интенсивно работающих пользователей.

В варианте клиент-сервер обеспечивается возможность параллельной работы большого количества пользователей. Как показывают тесты, с ростом числа пользователей скорость ввода документов уменьшается очень медленно. Это означает, что при увеличении количества интенсивно работающих пользователей скорость реакции автоматизированной системы остается на приемлемом уровне.

В модели данных, поддерживаемой системой «1С:Предприятие 8», не существует таблиц базы данных, однозначно приводящих к конкурентному доступу со стороны нескольких пользователей. Конкурентный доступ возникает только при обращении к логически связанным данным и не затрагивает данные, не связанные между собой с точки зрения предметной области.

При выполнении регламентных операций исключены ситуации, когда для начала работы в некотором отчетном периоде требуется установка монопольного режима. Регламентные операции могут выполняться в удобные для пользователей и организации моменты времени. Монопольный режим устанавливается не при запуске системы, а в тот момент, когда необходимо выполнение операции, требующей его включения. После выполнения таких операций монопольный режим может быть отключен.

Монопольный режим устанавливается не при запуске системы, а в тот момент, когда необходимо выполнение операции, требующей его включения. После выполнения таких операций монопольный режим может быть отключен.

Механизмы оптимизации

Технологическая платформа «1С:Предприятия 8» содержит ряд механизмов, оптимизирующих скорость работы прикладных решений.

Управление блокировками в транзакции

Режим управляемых блокировок в транзакции позволяет управлять блокировками данных в терминах предметной области и повышает параллельность работы пользователей. Подробнее…

Выполнение на сервере

В варианте клиент-сервер использование сервера «1С:Предприятия 8» позволяет сосредоточить на нем выполнение наиболее объемных операций по обработке данных. Например, при выполнении даже весьма сложных запросов программа, работающая у пользователя, будет получать только необходимую ей выборку, а вся промежуточная обработка будет выполняться на сервере. Обычно увеличить мощность сервера гораздо проще, чем обновить весь парк клиентских машин.

Обычно увеличить мощность сервера гораздо проще, чем обновить весь парк клиентских машин.

Кэширование данных

Система «1С:Предприятие 8» использует механизм кэширования данных, считанных из базы данных при использовании объектной техники. При обращении к реквизиту объекта выполняется чтение всех данных объекта в кэш, расположенный в оперативной памяти. Последующие обращения к реквизитам того же объекта будут направляться уже в кэш, а не в базу данных, что значительно сокращает время, затрачиваемое на получение нужных данных.

Работа встроенного языка на сервере

При работе в клиент-серверном варианте вся работа прикладных объектов выполняется только на сервере. Функциональность форм и командного интерфейса также реализована на сервере.

На сервере выполняется подготовка данных формы, расположение элементов, запись данных формы после изменения. На клиенте отображается уже подготовленная на сервере форма, выполняется ввод данных и вызовы сервера для записи введенных данных и других необходимых действий.

На клиенте отображается уже подготовленная на сервере форма, выполняется ввод данных и вызовы сервера для записи введенных данных и других необходимых действий.

Аналогично командный интерфейс формируется на сервере и отображается на клиенте. Также и отчеты формируются полностью на сервере и отображаются на клиенте.

Примеры технологических параметров внедрений решения «Управление производственным предприятием»

В этом разделе публикуется развернутая информация о технологических параметрах внедрений «1C:Предприятие 8. Управление производственным предприятием» на предприятиях различного масштаба и профиля деятельности.

Цель раздела — ознакомить ИТ- специалистов с данными о реально используемом оборудовании и с примерами нагрузки реальных внедрений «1С:Предприятия 8».

Также эта информация может быть полезна и для пользователей всех программ системы «1С:Предприятие 8».

1С:Центр управления производительностью — инструмент мониторинга и анализа производительности

1С:Центр управления производительностью (1С:ЦУП) — инструмент мониторинга и анализа производительности информационных систем на платформе «1С:Предприятие 8». 1С:ЦУП предназначен для оценки производительности системы, сбора подробной технической информации об имеющихся проблемах производительности и анализа этой информации с целью дальнейшей оптимизации. Подробнее…

1С:ТестЦентр — инструмент автоматизации нагрузочных испытаний

1С:ТестЦентр — инструмент автоматизации многопользовательских нагрузочных испытаний информационных систем на платформе «1С:Предприятие 8». С его помощью можно моделировать работу предприятия без участия реальных пользователей, что позволяет оценивать применимость, производительность и масштабируемость информационной системы в реальных условиях. Подробнее…

Подробнее…

Внедрение корпоративных информационных систем на платформе «1С:Предприятие 8»

Опыт внедрения прикладных решений на платформе «1С:Предприятие 8» показывает, что система позволяет решать задачи различной степени сложности — от автоматизации одного рабочего места до создания информационных систем масштаба предприятия.

В то же время, внедрение большой информационной системы предъявляет повышенные требования по сравнению с небольшим или средним внедрением. Информационная система масштаба предприятия должна обеспечивать приемлемую производительность в условиях одновременной и интенсивной работы большого количества пользователей, которые используют одни и те же информационные и аппаратные ресурсы в конкурентном режиме. Подробнее…

База знаний по технологическим вопросам крупных внедрений

Фирма «1С», совместно с сертифицированными «1С:Экспертами по технологическим вопросам» и другими техническими специалистами, ведет и регулярно обновляет базу знаний по технологическим вопросам крупных внедрений.

База знаний — это постоянно пополняемый информационный ресурс, который является основным источником информации по технологическим вопросам крупных внедрений:

- Методики и технологии, ориентированные на повышение качества крупных внедрений

- Технологические проблемы крупных внедрений и способы их решения

Подробнее…

Масштабируемость: рост системы в разных направлениях

Перевод статьи «Scalability: Growing a System in Different Directions».

Вокруг распределенных систем ходит много разговоров, но все они крутятся, собственно, вокруг размеров. Причем, говоря о размере, люди обычно подразумевают размер самой системы. И когда дело касается распределенных систем, оказывается, размер действительно имеет значение.

Сфера компьютерных вычислений имеет

удивительно длинную историю. Но если

мы говорим о распределенных системах,

то история немного отличается. Распределенные вычисления в нашем

современном понимании начали появляться

в поздние 1960-е и ранние 1970-е, когда

компьютеры начали взаимодействовать

в сетях (Ethernet).

Распределенные вычисления в нашем

современном понимании начали появляться

в поздние 1960-е и ранние 1970-е, когда

компьютеры начали взаимодействовать

в сетях (Ethernet).

В течение следующего десятилетия распределенные вычисления становились все более распространенными. Любопытно, что системы начали становиться «распределенными», когда появилась одна массивная распределенная система – интернет.

К 1980-м компьютеры уже использовались повсеместно, а доступ к интернету (и другим сетям) стал более обыденным. Не углубляясь в детали, можно заключить, что машин стало больше, а кроме того, они стали гораздо больше взаимодействовать друг с другом.

Такой тип «роста» имеет собственное

название в царстве распределенных

систем. Фактически, сегодня многие

инженеры (и не только занимающиеся

распределенными системами) довольно

широко используют этот термин. Я говорю,

конечно же, о масштабируемости. Итак,

давайте рассмотрим, что такое масштабируемая

распределенная система, а также – каким

образом система может расти.

Как происходит масштабирование?

Масштабируемость системы может означать много различных вещей в зависимости от того, с чем имеет дело эта система, а также от того, какая часть системы растет. Но в общих чертах можно сказать, что если система обладает масштабируемостью, значит, она может продолжать справляться со своей работой и действовать эффективно в условиях своего роста.

Но что такое «рост»? Какая часть системы увеличивается?

Говоря о том, что система растет, в разных случаях мы, скорее всего, будем иметь в виду разные вещи. Другими словами, система запросто может расти в разных направлениях.

Определение: масштабируемой распределенной системой называется такая система, которая продолжает эффективно работать по мере возрастания количества пользователей и ресурсов.Например, мы можем утверждать, что система растет, если растет число пользователей, взаимодействующих с ней. Если с системой работало 5 тысяч пользователей и вдруг их число возросло до 50 тысяч, это определенно своего рода рост системы!

Как система может расти? Больше данных, больше процессов, больше машин, больше пользователей. Обычно система растет не в одном направлении!

Обычно система растет не в одном направлении!Но система также может расти и в плане ее собственных ресурсов. Например, однажды она может получить особенно высокий трафик, а следовательно, очень большое количество данных, которые нужно обрабатывать. Или система может особенно интенсивно использоваться в определенный период времени, что приведет к значительному росту количества одновременно запущенных процессов. Или вот еще пример: единая система может расти за счет числа физических машин (серверов) внутри нее.

Все эти вещи – данные, процессы, машины – представляют собой различные направления, по которым может происходить рост системы. И, как мы выяснили ранее, наплыв пользователей это тоже один из видов роста системы.

На самом деле в реальном мире

распределенные системы растут не в

одном направлении, а в нескольких

одновременно. Например, мы можем заметить,

что в результате наплыва пользователей

возросло и количество данных. А для

обработки большего количества данных

мы добавляем новые серверы или базы

данных.

В реальном мире распределенная система имеет тенденцию расти в больше, чем в одном направлении.

Измеряем масштабируемость: масштабируемость по размеру, географическая и административная масштабируемостьС учетом того, что система может расти по-разному, имеет смысл говорить о масштабируемости системы в привязке к тому, как именно она растет. Чтобы конкретизировать форму масштабируемости, придумано несколько терминов. Основные из них – масштабируемость по размеру, географическая масштабируемость и административная масштабируемость. Это три формы часто называют измерениями масштабируемости. Давайте рассмотрим каждую из них подробнее.

Рост, измеряемый количественно

Первое измерение масштабируемости

лежит на пересечении двух вещей, которые

мы уже обсуждали: количества пользователей

и количества ресурсов (какими бы эти

ресурсы ни были). Мы знаем, что и то, и

другое может возрастать количественно.

Когда такое происходит, мы говорим, что

система увеличилась в размерах.

Если система обладает масштабируемостью по размеру, это означает, что она сохраняет свою производительность и остается пригодной к использованию независимо от того, как много ресурсов она может получить.

Возьмем пример. Скажем, наша распределенная система в какой-то день получает высокий трафик. На основе этого мы можем понять, что объем нашей базы данных или существующее количество серверов нашей системы просто не могут справиться с многочисленными запросами в день с особенно высоким трафиком.

Мы можем решить увеличить объем базы

данных или на несколько часов добавить

серверы для обработки большего потока

данных. Но если наша система масштабируется

по размеру, добавление новых узлов не

должно отрицательно сказаться на

производительности. То есть, если мы

решили добавить больше узлов для

обработки ресурсов или обслуживания

пользователей, в результате не должны

упасть производительность и эффективность

работы всей системы. Наша система должна

иметь возможность продолжать работу

на уровне, который ожидают от нее

пользователи, и, разумеется, для

пользователей работа с этой системой

не должна замедлиться.

Рост с увеличением сложности

До сих пор мы говорили о добавлении ресурсов или пользователей в функционирующую систему. Но по мере роста системы мы можем обнаружить, что добавление узлов не решает проблему. Фактически, порой само это добавление может приводить к непредсказуемым последствиям.

На первый взгляд может показаться, что добавить узлы или ресурсы в систему довольно легко. Однако это очень наивный подход к сложной проблеме. Если речь идет о распределенной системе, географическая и административная масштабируемость имеют много нюансов, которые могут быть не слишком очевидными.

Увеличение расстояний

Когда система начинает существенно увеличиваться в размерах, мы должны обдумать еще один вопрос: где конкретно расположены наши ресурсы? Здесь и выходит на сцену географическая масштабируемость.

Если система обладает географической

масштабируемостью, она может продолжать

эффективно функционировать и использоваться

вне зависимости от расстояния между

пользователями и ресурсами системы.

Вначале это может показаться странным или смешным, но погодите. Скажем, чтобы сделать нашу систему масштабируемой по размеру, мы добавляем больше узлов, которые помогут справиться с возросшей нагрузкой. Если эти узлы – серверы, они могут располагаться в одном месте или в разных местах. И если мы добавляем в нашу систему что-то значительное, такое как целый дата-центр, этот наш новый дата-центр может располагаться достаточно далеко от того дата-центра, который у нас был изначально.

Добавление еще одного узла в нашу систему может казаться простым делом. Но мы помним, что наша цель – создание системы, которая продолжит эффективно функционировать, и к которой по-прежнему смогут легко получать доступ пользователи. В этих условиях добавление нового узла осложняет достижение нашей цели.

Мы, конечно, можем добавлять новые

узлы в нашу систему и без учета дистанций

между ними. Но это зависит от расположения

узлов и расстояния между ними и

пользователями. Под расстоянием следует

понимать буквальное физическое

пространство между ними, т. е.,

расстояние в географическом смысле.

е.,

расстояние в географическом смысле.

Но почему вообще расстояние имеет значение? Потому что пересылка данных и взаимодействие разных частей системы занимают определенное время. Два узла, находящиеся в одной комнате, обмениваются информацией гораздо быстрее, чем два узла, находящиеся в два раза дальше друг от друга. К сожалению, существуют физические (географические?) ограничения, справиться с которыми не поможет даже очень хороший wifi.

Если система обладает географической масштабируемостью, добавление новых узлов не увеличивает количество времени, необходимого для коммуникации между ними.

Таким образом, добавляя каждый новый узел, нужно учитывать его физическое расположение по отношению к остальным частям системы.

Рост затрачиваемых усилий

Наконец, если система растет по размеру

и в географическом плане, возникает

последний вопрос: кто будет наблюдать

за новыми частями расширяющейся системы?

Мы подобрались к административной

масштабируемости.

Если система обладает административной масштабируемостью, добавление новых узлов не должно вызывать существенного роста количества усилий, необходимых для управления этими новыми узлами.

Это особенно важно, если система используется многими администраторами (людьми или организациями, запускающими эту систему наравне с другими людьми и организациями). Каждый из них должен иметь возможность использовать систему, даже когда ею уже пользуются другие.

Административная масштабируемость это еще одно измерение масштабируемости, о котором часто забывают. И если нам легко счесть добавление еще одного узла простым решением проблемы роста системы, нам так же легко забыть, что добавление ресурсов в систему означает, что в будущем понадобятся дополнительные усилия для их поддержки.

В системе, обладающей административной масштабируемостью, добавление ресурсов по мере роста системы не должно вызывать сильного увеличения управленческих усилий.

Если для масштабирования нашей системы

нам потребовалось добавить целый

дата-центр узлов, мы должны суметь

прикинуть количество человеко-часов,

которое потребуется на поддержку этих

узлов и их работоспособности.

Очень часто, говоря о том, что нужно сделать систему масштабируемой, разработчики на самом деле думают только об увеличении размеров системы. Однако, как и многие другие вещи, распределенные системы развиваются больше, чем в одном направлении. Масштабируемость по размеру это лишь один из аспектов проблемы. Очень важно учитывать также географическую и административную масштабируемость. А обратив внимание на каждый из этих аспектов, мы обнаружим множество нюансов и своих сложностей.

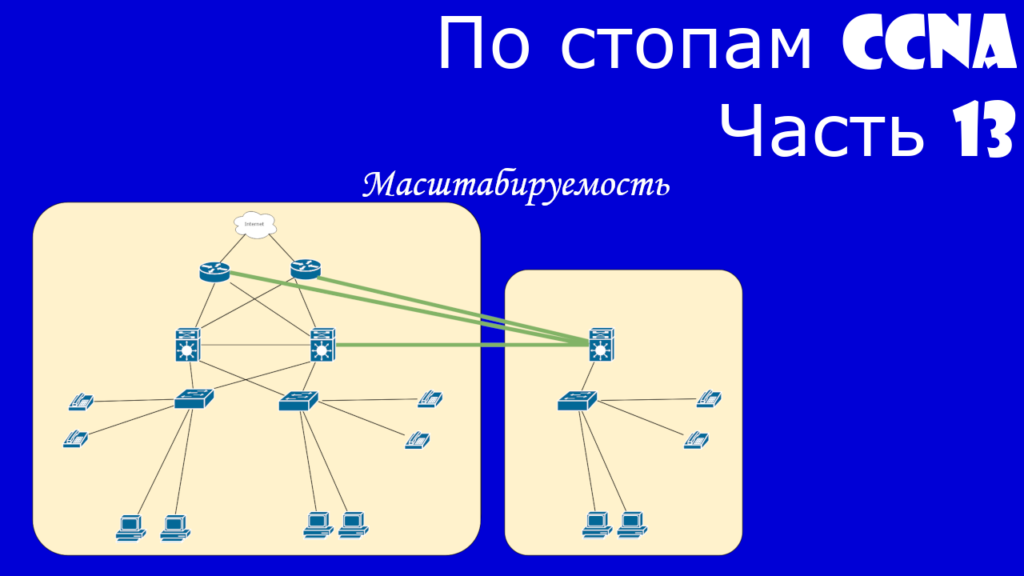

Расширяемость и масштабируемость | Компьютерные сети

Термины «расширяемость» и «масштабируемость» иногда неверно используют как синонимы.

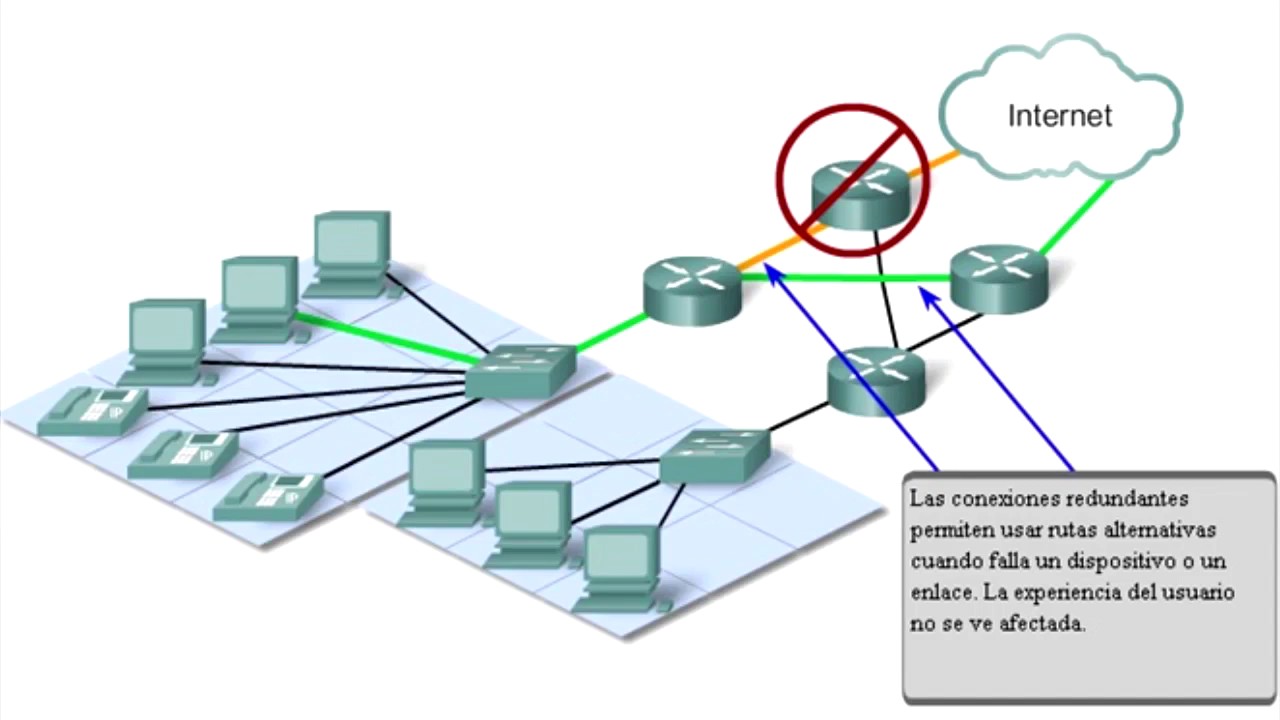

Расширяемость означает возможность сравнительно простого добавления отдельных компонентов сети (пользователей, компьютеров, приложений, служб), наращивания длины сегментов кабелей и замены существующей аппаратуры более мощной.

При этом принципиально важно, что простота расширения системы иногда может обеспечиваться в определенных пределах. Например, локальная сеть Ethernet, построенная на основе одного разделяемого сегмента коаксиального кабеля, обладает хорошей расширяемостью в том смысле, что позволяет легко подключать новые станции. Однако такая сеть имеет ограничение на число станций — оно не должно превышать 30-40. Хотя сеть допускает физическое подключение к сегменту и большего числа станций (до 100), при этом резко снижается производительность сети. Наличие такого ограничения и является признаком плохой масштабируемости системы при ее хорошей расширяемости.

Например, локальная сеть Ethernet, построенная на основе одного разделяемого сегмента коаксиального кабеля, обладает хорошей расширяемостью в том смысле, что позволяет легко подключать новые станции. Однако такая сеть имеет ограничение на число станций — оно не должно превышать 30-40. Хотя сеть допускает физическое подключение к сегменту и большего числа станций (до 100), при этом резко снижается производительность сети. Наличие такого ограничения и является признаком плохой масштабируемости системы при ее хорошей расширяемости.

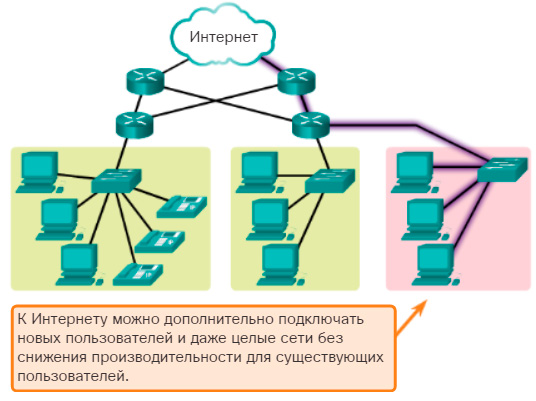

Масштабируемость означает, что сеть позволяет наращивать количество узлов и протяженность связей в очень широких пределах, при этом производительность сети не снижается.

Для обеспечения масштабируемости сети приходится применять дополнительное коммуникационное оборудование и специальным образом структурировать сеть. Обычно масштабируемое решение обладает многоуровневой иерархической структурой, которая позволяетдобавлять элементы на каждом уровне иерархии без изменения главной идеи проекта.

Примером хорошо масштабируемой сети является Интернет, технология которого (TCP/IP) оказалась способной поддерживать сеть в масштабах земного шара. Организационная структура Интернета, которую мы рассмотрели в главе 5, образует несколько иерархических уровней: сети пользователей, сетей локальных поставщиков услуг и т. д. вверх по иерархии вплоть до сетей межнациональных поставщиков услуг. Технология TCP/IP, на которой построен Интернет, также позволяет строить иерархические сети. Основной протокол Интернета (IP) основан на двухуровневой модели: нижний уровень составляют отдельные сети (чаще всего сети корпоративных пользователей), а верхний уровень — это составная сеть, объединяющая эти сети. Стек TCP/IP поддерживает также концепцию автономной системы. В автономную систему входят все составные сети одного поставщика услуг, так что автономная система представляет собой более высокий уровень иерархии.

Наличие автономных систем в Интернете позволяет упростить решение задачи нахождение оптимального маршрута — сначала ищется оптимальный маршрут между автономными системами, а затем каждая автономная система находит оптимальный маршрут внутри себя.

Не только сама сеть должна быть масштабируемой, но и устройства, работающие на магистрали сети, также должны обладать этим свойством, так как рост сети не должен приводить к необходимости постоянной смены оборудования. Поэтому магистральные коммутаторы и маршрутизаторы строятся обычно по модульному принципу, позволяя наращивать количество интерфейсов и производительность обработки пакетов в широких пределах.

Как обеспечить масштабируемость облака | Dinarys

Главная / Блог / Как обеспечить масштабируемость облака

Поскольку общие объемы нагрузки на вычислительные системы все больше растут, они адаптируются и становятся более сложными с точки зрения базовой архитектуры. Создаются новые программные инструменты и интегрируются для оптимизации производительности, расширяются возможности сервера и т. д. Все эти процессы оптимизации системы определяются одним понятием — масштабирование — одна из ключевых специализаций экспертов DevOps.

Есть идеи по поводу вашего проекта?

Свяжитесь с нами!

Сделать запросЧто такое масштабируемость и как обеспечить ее для вашего бизнеса, когда большинство операционных мощностей сосредоточено в облаке? Давайте углубимся в тему.

Источник изображения: Static.bluepiit

Что такое масштабируемость?

Каково окончательное определение масштабируемости?

В основном, это способность повышать производительность системы наиболее рациональным способом. На практике это обычно достигается путем добавления вычислительных ресурсов, как аппаратных, так и / или программных. Однако, переписать существующий код в большинстве случаев является довольно радикальным решением, поэтому в 9 из 10 случаев компании останавливают увеличение количества серверов или расширение возможностей существующей серверной системы.

Обратите внимание, что необходимость в масштабировании возникает не только тогда, когда общая производительность системы становится низкой и недостаточной. Существующая и работающая архитектура может работать очень хорошо, но лаги могут препятствовать процессам из-за быстрого роста пользовательского трафика.

Существующая и работающая архитектура может работать очень хорошо, но лаги могут препятствовать процессам из-за быстрого роста пользовательского трафика.

Если вы хотите проверить, насколько эффективно работают ваши сетевые протоколы и ресурсы веб-сервера, вы можете использовать любую доступную утилиту тестера нагрузки (например, siege), которая будет эмулировать искусственный приток пользователей на ваш сервер с тоннами запросов. Вам просто нужно отследить два ключевых параметра: n — определяет общее количество запросов и c — указывает количество одновременных запросов.

В результате вы получаете RPS (количество запросов в секунду), которое показывает, сколько запросов ваша серверная система способна обработать в данный момент. Это отражает максимальное количество пользователей, которое, если они попытаются одновременно взаимодействовать с вашим сервером, может привести к сбою системы. Эта процедура тестирования в конечном итоге показывает, чего ожидать, и насколько важно создать архитектуру, подверженную масштабируемости.

С другой стороны, подумайте хотя бы на секунду, возможно, вам будет удобнее настроить некоторые конфигурации серверов и оптимизировать процедуры обналичивания в вашем конкретном случае.

Таким образом, вы можете безопасно отложить масштабирование до лучших времен.

Есть идеи по поводу вашего проекта?

Свяжитесь с нами!

Сделать запросТипы масштабирования

Основные и наиболее распространенные типы процедур масштабирования включают в себя:

Вертикальное масштабирование — увеличение

Источник изображения: Dzone

Вертикальное масштабирование — это когда общая мощь бизнеса увеличивается за счет повышения производительности внутренних ресурсов сервера — процессоров, памяти, дисков и емкости сети. Сервер в своей базовой форме остается неизменным.

Горизонтальное масштабирование — масштабирование

Источник изображения: Dzone

В поле зрения есть реальная позиция — увеличение против масштабирования. Что лучше?

Что лучше?

В частности, поскольку цифровая нагрузка и трафик постоянно растут, вертикальное масштабирование рано или поздно сталкивается с ограничениями в виде технических спецификаций серверов. Вот где в игру вступает горизонтальное масштабирование. Основное значение этого термина определяет, что вычислительные мощности увеличиваются путем добавления идентичных узлов поверх существующих. Горизонтальное масштабирование чаще всего достигается при наличии настроенной серверной инфраструктуры (в частности, центров обработки данных), а также согласованной схемы взаимодействия между серверами.

Диагональное масштабирование

Это относительно новый термин, который придумал Джон Аллспо — автор и соучредитель Adaptive Capacity Labs. Таким образом, диагональное масштабирование объединяет лучшее из двух миров и определяет вертикальное масштабирование горизонтально масштабированных узлов, которые уже реализованы в существующей серверной инфраструктуре.

Как обеспечить максимальную масштабируемость

Теперь несколько практических советов, которые помогут вам провести процедуру масштабируемости облачных вычислений наиболее правильно, с минимальными затратами.

Проводить балансировку нагрузки

Распределение нагрузки подразумевает комплекс усилий по распределению процессов вычислительной сети между несколькими аппаратно-программными ресурсами (дисками, процессорами или отдельными серверами), которые сосредоточены в одном сокете или кластере. Основная цель здесь — оптимизировать расходы вычислительных мощностей, повысить производительность сети, сократить временные затраты при обработке сетевых запросов, а также снизить шансы того, что определенный сервер ответит на DDoS в какой-то замечательный момент.

Кроме того, распределение нагрузки между несколькими узлами (вместо полной эксплуатации одного узла) повышает доступность услуг, предоставляемых вашей компанией. В частности, если у вас под рукой есть несколько дополнительных серверов, то даже если какой-то рабочий блок выходит из строя, у вас есть готовая автоматическая замена.

В частности, если у вас под рукой есть несколько дополнительных серверов, то даже если какой-то рабочий блок выходит из строя, у вас есть готовая автоматическая замена.

Процедура балансировки реализуется с помощью целого набора алгоритмов и методов, каждый из которых соответствует следующим уровням модели OSI: Сеть, Транспорт и Приложение. В практической реализации это требует использования нескольких физических серверов вместе со специализированным программным обеспечением, аналогичным веб-серверу Nginx.

Обратитесь к услугам автоматического масштабирования

Автоматическое масштабирование является особым подходом к динамическому масштабированию в контексте облачных сервисов (т.е. масштабирование, которое подразумевает настройку вычислительных мощностей в соответствии с объемом сетевой нагрузки). В частности, пользователям служб, которые включают процедуры автоматического масштабирования (наиболее известными из которых являются Amazon Web Service, Google Cloud Platform и Microsoft Azure), предоставляются дополнительные виртуальные машины, если это необходимо (которые могут быть автоматически исключены из кластера или контейнера). по мере успокоения трафика и интенсивности запросов).

по мере успокоения трафика и интенсивности запросов).

Благодаря такому подходу компании получают улучшенную доступность, отказоустойчивость, а также максимальные возможности экономии бюджета. С такими услугами вы используете столько серверной мощности, сколько вам нужно в данный момент. Это довольно выигрышный вариант, в отличие от физического масштабирования, когда вам необходимо приобрести и дополнительно поддерживать дорогостоящее оборудование.

Обратите внимание, что автоматическая облачная масштабируемость всегда идет рука об руку с решениями для балансировки нагрузки.

Контейнеры микросервисов, кластеризация

Вы можете использовать ресурсоэффективные процедуры повышения производительности, которые объединяют сервисы в контейнеры, а затем собирают эти контейнеры в кластеры. За кластеризацией следуют определения сценариев, которые либо добавляют недостающие ресурсы (экземпляры), если это необходимо, либо минимизируют выделение ресурсов, чтобы избежать их избытка.

Реализовать кеширование

Во время горизонтального масштабирования простое кэширование памяти не может быть реализовано сразу для нескольких узлов, поэтому его необходимо оптимизировать. В частности, такие хранилища, как Memcached или Redis, можно использовать для комбинированного распределения данных кэша между итерациями приложения. Эти инструменты работают в соответствии с различными алгоритмами, так что объем данных кэширования уменьшается. Кэш-хранилища также хорошо защищены от ошибок репликации и хранения данных.

При использовании кеш-хранилищ важно предотвратить ситуацию, когда разные итерации приложения одновременно запрашивают некэшированные данные. Для этого необходимо обновить данные кэширования вне потока производительности вашего приложения и использовать их непосредственно в приложении.

Таким образом, при правильном подходе кэширование может помочь вашим системам получить возможность масштабирования в облаке для обработки интенсивных нагрузок и достижения оптимальной производительности.

Использовать услуги CDN

CDN — это сеть физически удаленных компьютеров, которые передают контент пользователям услуг. Другими словами, это распределенное хранилище и использование кэша. Обычно обращение к CDN является наиболее актуальным, когда веб-служба, веб-сайт или полнофункциональное приложение ориентированы на пользовательскую аудиторию, которая распределена по территории нескольких стран. Ценообразование CDN напрямую зависит от объемов трафика, проходящего через сервис.

В качестве альтернативы CDN может быть убыточным решением, если ваша TA, несмотря на широкое территориальное распределение, имеет локализации с концентрацией определенных пользователей. То есть, предположим, что около 60% вашей TA основано в США, 30% в Лондоне, а остальные 10% разбросаны по всей планете. В таком случае использование CDN будет рациональным решением только для последних 10% (тогда как в других местах потребуется установка новых серверов).

Как мы решаем проблемы масштабирования?

В настоящее время среди наших ярких примеров масштабирования, проведенного собственными специалистами, можно назвать создание архитектуры высокой масштабируемости для таких общедоступных облачных хранилищ, как AWS, Microsoft Azure, Google Cloud и Digital Ocean. Мы используем сценарии автоматического развертывания среды с помощью Terraform — системы следующего поколения для создания, управления и настройки облачной инфраструктуры. Наши серверные кластеры основаны на программном обеспечении для автоматического масштабирования Kubernetes и вспомогательной технологии контейнеризации Docker.

Заключение

Источник изображения: CDN.Lynda

Используя масштабируемость в среде облачных вычислений с помощью вышеупомянутых и других методов, вы можете расти быстрее и проще, а также оставаться гибкими на протяжении всего пути. Если вы стремитесь выбрать правильный подход к масштабированию, вам обязательно следует обратиться к экспертам. Позвольте нам найти вам специалистов DevOps, которые предоставят наиболее оптимальную серверную инфраструктуру для вашего конкретного бизнеса, которая будет адаптирована к нагрузкам любой интенсивности.

Позвольте нам найти вам специалистов DevOps, которые предоставят наиболее оптимальную серверную инфраструктуру для вашего конкретного бизнеса, которая будет адаптирована к нагрузкам любой интенсивности.

Тестируем масштабируемость – пошаговая инструкция

Ваше приложение может быть практически идеальным, но если оно не имеет возможности масштабирования, то внезапный пик трафика может подвесить всю систему. Поэтому обеспечить возможность быстрого расширения доступной базы ресурсов и протестировать возможности масштабирования в стресс-тестах на нагрузку – важно для обеспечения стабильности работы.

Важность масштабирования

Масштабируемость это, в первую очередь, способность сети, системы или процесса адаптироваться к внезапным изменениям. Это может быть резко возросший поток посетителей или объем передачи данных или какие-то другие нагрузки. Тесты масштабируемости симулируют различные сценарии возникновения подобных пиковых нагрузок, чтобы проверить готовность вашего приложения к критическим ситуациям.

Стресс-тесты очень важны, потому что неспособность вашего приложения справляться с нагрузками может похоронить все ваши усилия по развитию бизнеса. К примеру, если вы планируете большие продажи в рамках какой-то акции, то должны подготовиться к резкому увеличению привлеченных вами покупателей. Иначе сайт не выдержит нагрузки, и те покупатели, на привлечение которых вы тратили средства и силы, попросту уйдут, хотя были уже готовы что-то у вас купить. Например, так случилось с канадской железнодорожной компанией VIA Rail, которая объявила о скидках в честь 150-летия Канады. Акция оказалась настолько популярной, что приток покупателей практически остановил все онлайн продажи этой компании.

Масштабируемость, надежность и производительность – практически синонимы. Они характеризуют то, насколько ваша система готова к рабочим нагрузкам.

Для улучшения масштабируемости нет единого подхода. То, что годится для небольшого сайта, не подойдет для серверов MMORPG. Разработчик должен понимать особенности своего приложения. Например, если ваш сайт сильно зависит от производительности базы данных, вы должны обратить внимание на ее функционирование при резко возрастающем потоке посетителей.

Например, если ваш сайт сильно зависит от производительности базы данных, вы должны обратить внимание на ее функционирование при резко возрастающем потоке посетителей.

Тестирование масштабирования

Основная задача нагрузочного теста проста – определить, в какой момент и почему система перестает справляться с нагрузкой и как это можно исправить. Но этот процесс не так прост, как кажется. И часто требуются определенные компромиссы и сложные решения. Например, при написании PHP-приложения придется пожертвовать скоростью, но организовать загрузку данных не одним файлом, а по частям.

Тестирование поможет вам определить как снижение производительности приложения на стороне клиента и ухудшение его клиентских качеств для пользователя, так и устойчивость ваших серверов к нагрузкам.

При тестировании масштабируемости нужно учитывать ряд факторов:

- Время отклика

- Время отрисовки на экране

- Пропускную способность

- Количество запросов в секунду

- Использование сети

- Использование памяти

- Время, требуемое для выполнения задач

Цели тестирования масштабирования

В идеале, конечно, хотелось бы, чтобы приложение работало одинаково хорошо во всех ситуациях. Но это, увы, недостижимые мечты. Надо ставить реалистичные цели. И более конкретные.

Но это, увы, недостижимые мечты. Надо ставить реалистичные цели. И более конкретные.

Например, «приложение должно при определенной нагрузке иметь определенное время отклика». И уточнить – какое. Другая цель – «сервер должен оставаться работоспособным при большой нагрузке». И уточнить, что имеется в виду под «большой нагрузкой». Или – «время проведения транзакции при 100 одновременных посетителях не должно быть больше 4 секунд» — тоже конкретная цель.

Приложения нужно протестировать на различные параметры, и конечным итогом ваших тестов должно явиться понимание, что именно ограничивает производительность при пиковых нагрузках – сеть, базы данных, оборудование или программное обеспечение.

Подготовка к тестированию

Когда вы разрабатываете новое приложение, вы не знаете, сколько у него будет пользователей через несколько лет. И по мере того, как к вам будет приходить успех, у вас будут множиться проблемы. Например, если вы храните данные о новых посетителях в базе данных, внезапный рост посещаемости может замедлить работу всего, что завязано на базы данных.

Поскольку разные ситуации порождают разные проблемы, нужно тестировать приложения с малым, средним и большим приростом нагрузки. При небольших нагрузках все должно работать безупречно, и этот тест поможет вам определить базовую производительность вашей системы. Средние нагрузки помогут понять, как будет себя вести приложение в обычном режиме, под нагрузкой, а большие – как оно справляется с пиковым приростом посетителей. И на каждом этапе, наверняка, вскроются свои проблемы.

Нужно быть уверенным, что конфигурация оборудования и среды остается во всех режимах тестирования одной и той же.

Рисунок ниже показывает почти идеальную зависимость использования памяти от времени. В данном тесте нагрузка постепенно возрастает, и время показывает фактически величину нагрузки. Идеально масштабируемая система сначала демонстрирует рост потребляемых ресурсов, а затем – стабильные показатели. График говорит о том, что памяти хватает на все три режима нагрузки.

Другой график, ниже, иллюстрирует пропорциональный нагрузке рост использования ресурсов. В данном случае растет время исполнения запроса с ростом числа посетителей.

В данном случае растет время исполнения запроса с ростом числа посетителей.

Пропорциональный рост говорит о том, что в принципе, ваше оборудование работает как положено и тут не возникнет внезапного ухудшения производительности при росте числа посетителей. Если же он не пропорционален нагрузке, надо обратить внимание на ресурсы оборудования, изменить их конфигурацию для достижения желаемого результата и снова – тестировать.

Масштабирование – вертикальное или горизонтальное

После первого цикла тестов вы будете менять конфигурацию оборудования. Расширять или же увеличивать производительность – масштабировать горизонтально или вертикально. Это не одно и то же.

- Вертикальное масштабирование – замена оборудования на более производительное. Например, замена процессора на более мощный

- Горизонтальное масштабирование – увеличение количества доступных ресурсов. Например, подключить для обслуживания вашего приложения еще один сервер

Оба этих подхода имеют как плюсы, так и минусы. Вертикальное масштабирование выглядит проще, но у процессоров есть предел производительности, и тут не получится повышать мощность сколько угодно. Горизонтальное масштабирование дает стабильный результат прироста мощности, но это может оказаться затратным.

Вертикальное масштабирование выглядит проще, но у процессоров есть предел производительности, и тут не получится повышать мощность сколько угодно. Горизонтальное масштабирование дает стабильный результат прироста мощности, но это может оказаться затратным.

Тестирование масштабирования – чек-лист

Вот типичная последовательность действий при тестировании масштабирования:

- Выберите какой-нибудь повторяющийся во время выполнения вашего приложения процесс

- Определите ваши критерии, по которым будете оценивать масштабируемость и производительность

- Составьте список инструментов для тестирования

- Зафиксируйте окружение и конфигурацию оборудования

- Составьте план, продумайте сценарии нагрузочного теста

- Напишите визуальный скрипт и загрузите тестовые сценарии

- Выполните тесты

- Проанализируйте результаты

Информация, полученная вами, послужит руководством для проведения апгрейдов. Например, если ваша компания ожидает рост посещаемости на 400 процентов в ближайшие месяцы, надо повышать производительность серверов. Или добавлять память. Возможно – надо менять серверное ПО. Все это вы должны выяснить в процессе тестирования. Тесты должны помочь вам выработать грамотную стратегию повышения производительности.

Или добавлять память. Возможно – надо менять серверное ПО. Все это вы должны выяснить в процессе тестирования. Тесты должны помочь вам выработать грамотную стратегию повышения производительности.

Разработка стресс-тестов

Нагрузочное тестирование имеет смысл и пользу только тогда, когда сценарии стресс-тестов хорошо проработаны. Параметры нагрузки продуманы в соответствии с реально ожидаемыми нагрузками и возможностями оборудования, а конфигурация аппаратной среды и окружения зафиксирована и одинакова для всех серий тестов. При этом должны контролироваться различные параметры, характеризующие загрузку – использование памяти, нагрузка на процессор и т.п.

Вот типичные шаги при разработке грамотного теста.

- Начните с разработки различных сценариев поведения пользователей. Проверьте их и задокументируйте – какие именно запросы поступают приложению в процессе их исполнения.

- Спроектируйте тест, моделирующий различное количество одновременных посетителей, с различной скоростью сети и различными версиями браузеров.

- Запустите тест, моделируя поступающие от пользователей запросы.

- Масштабируйте оборудование или программное обеспечение.

- Повторите тесты – и так до тех пор, пока производительность не будет соответствовать вашим требованиям.

Обеспечьте одинаковую конфигурацию и одинаковый сценарий роста нагрузки в различных тестах. IBM, кстати, разработало огромную инструкцию по проведению стресс-тестов.

Советы по улучшению масштабируемости и проведению тестов

- Разгрузите свою базу данных, ограничив количество открытых соединений и транзакций. Но не перекладывайте все на приложение – непропорциональное распределение нагрузки приведет к другим проблемам.

- Кэш может сильно помочь с выгрузкой ресурсов. Используйте CDN для разгрузки ваших серверов и даже более того – мощные сервера CDN ускорят работу вашего приложения.

- Не нужно хранить все подряд в базе данных. Используйте базы данных для хранения действительно важной для вашего бизнеса или для вашего приложения информации.

- Ограничьте доступ к тем ресурсам, которых не хватает. Если несколько процессов требуют выполнения одного и того же процесса, поставьте их в очередь – пусть ожидают завершения выполнения предыдущего запроса. Иначе зависнут все.

- Разбиение процессов на асинхронные потоки и параллельное их выполнение небольшим, ограниченным количеством обработчиков существенно повышает производительность.

- Обмен данными по сети гораздо более медленный, чем операции в памяти – уменьшите количество запросов-ответов от вашего приложения клиенту.

- Меняйте только одну переменную за один раз. Да, это потребует больше времени на отладку, но зато вы поймете, что конкретно привело к тем или иным изменениям.

- Обнулите всё, что возможно, до проведения теста, чтобы результаты работы предыдущего теста не влияли на последующий. Рекомендуется перезагрузка серверного ПО и пр., но само оборудование можно все-таки не перегружать.

- Каждый раз, когда вы проводите повторные тесты, выполняйте их все.

Не стоит надеяться на результаты, полученные полгода назад – все могло существенно измениться.

Не стоит надеяться на результаты, полученные полгода назад – все могло существенно измениться. - По максимуму автоматизируйте процесс тестирования. Тогда тесты можно будет запускать и в нерабочее время. Кроме того, автоматизация стандартизует условия проведения тестов.

Средства тестирования масштабирования

Выбор средств зависит от масштабов вашего проекта, его особенностей и т. п. К счастью, сейчас нет недостатка в бесплатных средствах для нагрузочного тестирования.

Вот некоторые из них:

TechBeacon приводит список из 12 бесплатных средств для нагрузочного тестирования.

Заключение

Масштабируемость, устойчивость к пиковым нагрузкам вещь далеко не второстепенная. От нее зависит успех любого приложения или интернет-магазина. Мудрый совет опытного бизнесмена – «Если вы не растете, вы умираете» в данном случае относится к ресурсам, которые обеспечат работоспособность и выживаемость вашей системы при внезапном наплыве посетителей. О котором, вы, как и все, мечтаете и к которому стремитесь.

Масштабируемость | Computerworld Россия | Издательство «Открытые системы»

Определение

Масштабируемость — это возможность увеличить вычислительную мощность Web-сайта или компьютерной системы (в частности, их способности выполнять больше операций или транзакций за определенный период времени) за счет установки большего числа процессоров или их замены на более мощные.

Бизнес начинается с конкретного набора требований к информационной системе. Однако с ростом компании растет важность вопроса о масштабируемости ее компьютерных систем.

Масштабируемость — вещь хорошая, поскольку означает, что вам не придется начинать с нуля и создавать абсолютно новую информационную систему с новым программным и аппаратным обеспечением. Если у вас есть масштабируемая система, то, скорее всего, вам удастся сохранить то же самое программное обеспечение, попросту нарастив аппаратную часть системы. В самой этой идее нет ничего нового, однако современные реалии, в частност, распространение электронной коммерции, изменили практику реализации — и отношение к ней — масштабируемых компьютерных систем.

Если у вас есть масштабируемая система, то, скорее всего, вам удастся сохранить то же самое программное обеспечение, попросту нарастив аппаратную часть системы. В самой этой идее нет ничего нового, однако современные реалии, в частност, распространение электронной коммерции, изменили практику реализации — и отношение к ней — масштабируемых компьютерных систем.

Вглубь или вширь?

Два термина характеризуют две стратегии масштабирования: масштабирование вглубь или масштабирование вширь.

Масштабирование вглубь — это традиционный подход. Вместо небольшого сервера приобретается более крупный многопроцессорный сервер (или кластер серверов). Если этого недостаточно, возможно, понадобится мэйнфрейм или даже суперкомпьютер.

У этого подхода есть существенный недостаток — он требует неоправданно больших затрат времени и финансовых средств. В современной бизнес-среде, особенно в области электронной коммерции, долгосрочное планирование и итоговая эффективность могут оказаться менее приоритетными, нежели возможность быстро и с разумными затратами приступить к использованию нового приложения. Вследствие этого оказывается более предпочтительным иной подход, который относительно быстр и прост и предусматривает покупку набора недорогих стандартных серверных модулей.

Вследствие этого оказывается более предпочтительным иной подход, который относительно быстр и прост и предусматривает покупку набора недорогих стандартных серверных модулей.

Нельзя утверждать, что какой-либо из этих подходов изначально лучше другого: каждый имеет свои преимущества. И сегодня компании, занимающиеся электронной коммерцией, выбирают прагматические стратегии роста, которые предусматривают масштабирование как вглубь, так и вширь. По мере роста числа транзакций и количества посетителей узлов Web-серверы и серверы приложений масштабируются за счет добавления других небольших серверов, на которых работают многочисленные копии программного обеспечения.

В то же время крупные серверы баз данных масштабируются более медленно и обдуманно путем установки мощных многопроцессорных компьютеров, на которых работает одна копия программного обеспечения сервера баз данных.

Брайан Ричардсон, аналитик компании Meta Group, считает, что масштабирование вширь — наиболее приемлемый способ для Web-серверов и серверов приложений, поскольку нет необходимости, чтобы каждая транзакция обрабатывалась одной и той же копией приложения. Серверы баз данных, однако, лучше работают в том случае, когда используется один экземпляр приложения. Это предотвращает возникновение конфликтов при выполнении транзакций — к примеру, торговая компания не может обещать доставить товар, которого еще нет на складе.

Серверы баз данных, однако, лучше работают в том случае, когда используется один экземпляр приложения. Это предотвращает возникновение конфликтов при выполнении транзакций — к примеру, торговая компания не может обещать доставить товар, которого еще нет на складе.

Ричардсон считает, что «накопительный» подход к масштабированию Web-серверов и приложений с одно- или двухпроцессорными платформами не только прост, но и дешев.

«В данном случае важны не общая стоимость владения и вычислительная эффективность с точки зрения перспектив последующей обработки, — сказал он. — Здесь важнее скорость развертывания системы. Насколько быстро вы сможете приступить к использованию нового приложения? Насколько быстро вы сможете начать обрабатывать транзакции электронной коммерции со своими бизнес-партнерами? Как правило, общая стоимость владения играет второстепенную роль по сравнению с гибкостью и адаптируемостью решения. Нередко куда важнее легко и быстро установить небольшие серверы и сократить срок реализации проекта на полгода».

Время покупать

Уэйн Керночан, аналитик компании Aberdeen Group, согласен с этим мнением.

«Честно говоря, использование множества небольших серверов — это быстрый, но грубый подход, — отметил он. — Он применим с такими Web-приложениями, как электронная почта или служба каталогов, которые просто ?перебрасываются? на другой сервер… Такой подход имеет смысл, когда вы изо всех сил торопитесь начать работу, и отдаленное будущее вас не очень интересует».

Однако Дэвид Фридландер, аналитик компании Giga Information Group, уверен, что «именно за счет масштабирования вглубь, а не вширь вы сможете добиться, чтобы одному экземпляру приложения доставалось больше процессорных ресурсов. Если вы работаете с биржей ценных бумаг или обрабатываете тысячи финансовых транзакций в секунду, вам потребуется такое более мощное процессорное ядро».

«В случае с одним крупным сервером вам не нужно столько внимания уделять сети, так как она находится внутри системы и это намного упрощает администрирование, — добавил Керночан. — Это важно, поскольку наши исследования показывают, что административные затраты с течением времени перекрывают все остальные расходы».

— Это важно, поскольку наши исследования показывают, что административные затраты с течением времени перекрывают все остальные расходы».

Но с точки зрения краткосрочной перспективы расходы на приобретение, а не на поддержку сервера немаловажны для большинства компаний, работающих в области электронной коммерции. Цены на серверы варьируются в весьма широком диапазоне, но восьмипроцессорный компьютер может обойтись компании в два раза дороже, чем двухпроцессорный. Так или иначе, соотношение цен не в пользу более крупного компьютера до тех пор, пока дело ограничивается четырьмя процессорами или пока база данных не станет очень большой.

Стоит помнить о том, что операционные системы могут по-разному поддерживать различные подходы к масштабированию. Так, теоретически операционная система Windows 2000 Datacenter Server, которую готовит к выпуску корпорация Microsoft, в состоянии сделать масштабирование вглубь более приемлемым и более эффективным, нежели масштабирование вширь. Datacenter дает возможность пользователям начать с небольшого сервера и добавлять в систему вплоть до 32 процессоров. Но, по мнению Ричардсона, масштабирование в таком стиле, скорее всего, в конечном итоге обойдется компании дороже, чем масштабирование за счет приобретения небольших серверов.

Но, по мнению Ричардсона, масштабирование в таком стиле, скорее всего, в конечном итоге обойдется компании дороже, чем масштабирование за счет приобретения небольших серверов.

В свете продолжающегося быстрого роста оборотов электронной коммерции весьма вероятно, что каждая стратегия, будь то масштабирование вглубь или вширь, по-прежнему будет находить своих сторонников.

Поделитесь материалом с коллегами и друзьями

Определение масштабируемости

Что такое масштабируемость?

Масштабируемость — это характеристика организации, системы, модели или функции, которая описывает ее способность справляться и хорошо работать в условиях возрастающей или расширяющейся рабочей нагрузки или объема. Хорошо масштабируемая система сможет поддерживать или даже повышать уровень производительности или эффективности, даже если она проверяется все более и более высокими эксплуатационными требованиями.

На финансовых рынках под масштабируемостью понимается способность финансовых институтов справляться с возросшими требованиями рынка; В корпоративной среде масштабируемая компания — это компания, которая может поддерживать или улучшать размер прибыли при увеличении объема продаж.

Ключевые выводы

- Масштабируемость описывает способность системы легко адаптироваться к возросшей рабочей нагрузке или требованиям рынка.

- Масштабируемая компания может получить выгоду от эффекта масштаба и быстро наращивать производство.

- Масштабируемость становится все более актуальной в последние годы, поскольку технологии облегчили привлечение большего числа клиентов и расширение рынков по всему миру.

Понимание масштабируемости

Масштабируемость, будь то в финансовом контексте или в контексте бизнес-стратегии, описывает способность компании расти, не ограничиваясь ее структурой или доступными ресурсами, когда она сталкивается с увеличением производства.Идея масштабируемости становится все более актуальной в последние годы, поскольку технологии облегчили привлечение клиентов, расширение рынков и масштабирование.

Эта концепция тесно связана с термином «эффект масштаба», когда определенные компании могут снизить свои производственные затраты и повысить прибыльность по мере роста и увеличения производства. В ситуациях, когда увеличение производства увеличивает затраты и снижает прибыль, это называется эффектом масштаба.

В ситуациях, когда увеличение производства увеличивает затраты и снижает прибыль, это называется эффектом масштаба.

Пример масштабируемости в техническом секторе

Некоторые технологические компании, например, обладают удивительной способностью быстро масштабироваться, что дает им большие возможности для роста.Причина этого заключается в отсутствии материальных запасов и модели «программное обеспечение как услуга» (SaaS) для производства товаров и услуг. Компаниям с низкими операционными накладными расходами и минимальной нагрузкой на складские помещения и инвентаризацию или вообще без нее не требуется много ресурсов или инфраструктуры для быстрого роста.

Даже компании, не связанные напрямую с технологической отраслью, имеют большую возможность масштабирования за счет использования определенных технологий. Привлечение клиентов, например, с помощью таких инструментов, как цифровая реклама, стало намного проще.

Даже банковские учреждения могут внедрять стратегии цифровой рекламы для увеличения числа подписчиков на услуги онлайн-банкинга, увеличения своей клиентской базы и потенциального дохода. К другим технологиям, которые помогают в масштабировании, относятся трудосберегающие, такие как автоматизированные системы управления складом, используемые крупными розничными торговцами, включая Amazon и Wal-Mart.

К другим технологиям, которые помогают в масштабировании, относятся трудосберегающие, такие как автоматизированные системы управления складом, используемые крупными розничными торговцами, включая Amazon и Wal-Mart.

Особые соображения

По своей сути масштабируемый бизнес — это бизнес, ориентированный на реализацию процессов, ведущих к эффективной работе.Рабочий процесс и структура бизнеса допускают масштабируемость.

У всех масштабируемых компаний есть устоявшаяся группа лидеров, включая руководителей высшего звена, инвесторов и советников, которые обеспечивают стратегию и направление. Масштабируемые компании также имеют единообразную рекламу бренда в своих подразделениях и регионах. Отсутствие контроля над брендом иногда приводит к тому, что компании теряют из виду свою основную ценность, что снижает масштабируемость. Yahoo — тому пример. После того, как компания быстро расширилась, она потеряла из виду свой основной бизнес и потерпела неудачу.

Масштабируемая компания имеет эффективные инструменты для измерения, поэтому весь бизнес можно оценивать и управлять им на каждом уровне. Такое управление приводит к эффективным операциям, описанным выше, и помогает при составлении бюджета капиталовложений.

Такое управление приводит к эффективным операциям, описанным выше, и помогает при составлении бюджета капиталовложений.

Высокая масштабируемость —

Это гостевой пост Пэдди Байерса, соучредителя и технического директора Ably, платформы доставки данных в реальном времени. Вы можете просмотреть исходную статью в блоге Ably.

Пользователи должны знать, что они могут полагаться на предоставляемую им услугу. На практике, поскольку время от времени отдельные элементы неизбежно выходят из строя, это означает, что вы должны иметь возможность продолжать работу, несмотря на эти отказы.

В этой статье мы подробно обсуждаем концепции надежности и отказоустойчивости и объясняем, как платформа Ably спроектирована с использованием отказоустойчивых подходов для обеспечения гарантий надежности.

В качестве основы для этого обсуждения сначала несколько определений:

Надежность

Степень, на которую можно положиться на продукт или услугу.Доступность и Надежность — это формы надежности.

Доступность

Степень доступности продукта или услуги для использования при необходимости. Это часто сводится к обеспечению достаточного резервирования ресурсов со статистически независимыми отказами.Надежность

Степень, в которой продукт или услуга соответствуют своей спецификации при использовании. Это означает, что система, которая не только доступна, но и спроектирована с обширными избыточными мерами, чтобы продолжала работать так, как ожидают ее пользователи .Отказоустойчивость

Способность системы оставаться надежной (как доступной, так и надежной) при наличии сбоев определенных компонентов или подсистем.

Отказоустойчивые системы допускают отказы: они разработаны для смягчения воздействия неблагоприятных обстоятельств и обеспечения надежности системы для конечного пользователя. Методы отказоустойчивости могут использоваться для повышения доступности и надежности.

Методы отказоустойчивости могут использоваться для повышения доступности и надежности.

Доступность можно условно рассматривать как гарантию безотказной работы; Надежность можно рассматривать как качество этого времени безотказной работы, то есть гарантию того, что функциональность и удобство работы пользователей сохранятся максимально эффективно, несмотря на неблагоприятные условия.

Если услуга недоступна для использования в то время, когда она необходима, значит, доступность недостаточна. Если служба доступна, но при ее использовании отличается от ожидаемого поведения, это означает недостаток надежности. Отказоустойчивые подходы к проектированию устраняют эти недостатки, чтобы обеспечить непрерывность как для бизнеса, так и для удобства пользователей.

Доступность, надежность и состояние

В большинстве случаев первичной основой отказоустойчивого проектирования является избыточность : наличие большего количества компонентов или мощности, чем минимальное, необходимое для предоставления услуги. Ключевые вопросы касаются того, какую форму принимает эта избыточность и как ею управлять.

Ключевые вопросы касаются того, какую форму принимает эта избыточность и как ею управлять.

В физическом мире классически существует различие между

- доступность ситуаций, когда допустимо остановить услугу, а затем возобновить ее, например, остановка для замены автомобильной шины; и

- надежность ситуации, когда непрерывность обслуживания имеет важное значение, с постоянно работающими резервными элементами, такими как двигатели самолетов.

Характер требования к непрерывности влияет на способ обеспечения резервной пропускной способности.

В контексте распределенных систем в Ably мы думаем об аналогичном различии между компонентами, которые не имеют состояния , и теми, которые имеют состояние , , соответственно.

Компоненты без сохранения состояния выполняют свои функции без какой-либо зависимости от долгоживущего состояния. Каждый вызов службы может выполняться независимо от любого предыдущего вызова. Отказоустойчивая конструкция этих компонентов сравнительно проста: достаточно ресурсов доступно , чтобы можно было обработать любой отдельный вызов, даже если некоторые ресурсы вышли из строя.

Отказоустойчивая конструкция этих компонентов сравнительно проста: достаточно ресурсов доступно , чтобы можно было обработать любой отдельный вызов, даже если некоторые ресурсы вышли из строя.

Компоненты с отслеживанием состояния имеют внутреннюю зависимость от состояния для предоставления услуг. Наличие состояния неявно связывает вызов службы с прошлыми и будущими вызовами. Суть отказоустойчивости для этих компонентов, как и в случае с двигателями самолета, заключается в возможности обеспечить непрерывность работы, в частности, непрерывность состояния, от которого зависит обслуживание.Это обеспечивает надежность .

В оставшейся части этой статьи мы приведем примеры каждой из этих ситуаций и объясним инженерные проблемы, возникающие при достижении отказоустойчивости на практике.

Само собой разумеющееся отношение к отказу

В отказоустойчивых конструкциях отказы рассматриваются как обычное дело. В крупномасштабных системах предполагается, что отказы компонентов рано или поздно произойдут. Любой отдельный отказ должен рассматриваться как неизбежный, а отказы компонентов в совокупности должны происходить постоянно.

В крупномасштабных системах предполагается, что отказы компонентов рано или поздно произойдут. Любой отдельный отказ должен рассматриваться как неизбежный, а отказы компонентов в совокупности должны происходить постоянно.

В отличие от физического мира, отказы в цифровых системах обычно не двоичны. Классические меры надежности компонентов (например, среднее время наработки на отказ или MTBF) не применяются; услуги ухудшаются по мере отказа. Византийские разломы — классический пример.

Например, системный компонент может работать с перебоями или выдавать вводящие в заблуждение выходные данные. Или вы можете зависеть от внешних партнеров, которые не уведомляют вас о неудаче, пока она не станет серьезной с их стороны, что затруднит вашу работу.

Чтобы быть терпимым к небинарным сбоям, требуется много размышлений, инженерии, а иногда и вмешательства человека. Каждый потенциальный отказ должен быть идентифицирован и классифицирован, а затем должен быть в состоянии быстро устранить или избежать с помощью обширных испытаний и надежных проектных решений. Основная задача при разработке отказоустойчивых систем — это понимание природы отказов и способов их обнаружения и устранения, особенно когда они частичные или периодические, чтобы продолжать предоставлять услуги пользователям максимально эффективно.

Основная задача при разработке отказоустойчивых систем — это понимание природы отказов и способов их обнаружения и устранения, особенно когда они частичные или периодические, чтобы продолжать предоставлять услуги пользователям максимально эффективно.

Услуги без гражданства

Уровни обслуживания, которые не имеют состояния не имеют основного требования для непрерывности обслуживания для любого отдельного компонента. Доступность ресурсов напрямую влияет на доступность уровня в целом. Доступ к дополнительным ресурсам, отказы которых статистически независимы, является ключом к поддержанию работоспособности системы. Везде, где это возможно, уровни не имеют состояния, что является ключевым фактором не только доступности, но и масштабируемости.

Для объектов без состояния достаточно иметь несколько независимо доступных компонентов, чтобы продолжать предоставлять услуги. Без состояния долговечность любого отдельного компонента не является проблемой.

Однако просто иметь дополнительные ресурсы недостаточно: вы также должны эффективно их использовать. У вас должен быть способ определения доступности ресурсов и балансировки нагрузки между избыточными ресурсами.

Таким образом, вам нужно ответить на следующие вопросы:

- Как выжить в разного рода неудачах?

- Какой уровень резервирования возможен?

- Каковы затраты ресурсов и производительности на поддержание этих уровней избыточности?

- Каковы эксплуатационные расходы на управление этими уровнями резервирования?

Последующие компромиссы заключаются в следующем:

- Требования клиентов для достижения высокой доступности

- Операционные расходы бизнеса

- Реальная инженерная практичность, позволяющая сделать это возможным

Избыточные компоненты и, в свою очередь, их зависимости должны быть спроектированы, сконфигурированы и эксплуатироваться таким образом, чтобы гарантировать статистическую независимость любых отказов. Простая математика такова: статистически независимые отказы экспоненциально снижают ваши шансы на катастрофический отказ по мере увеличения уровня избыточности. Если отказы настроены так, чтобы происходить в статистических разрозненных хранилищах, то кумулятивный эффект отсутствует, и вы уменьшаете вероятность полного отказа на целый порядок с каждым дополнительным избыточным ресурсом.

Простая математика такова: статистически независимые отказы экспоненциально снижают ваши шансы на катастрофический отказ по мере увеличения уровня избыточности. Если отказы настроены так, чтобы происходить в статистических разрозненных хранилищах, то кумулятивный эффект отсутствует, и вы уменьшаете вероятность полного отказа на целый порядок с каждым дополнительным избыточным ресурсом.

В Ably, чтобы повысить статистическую независимость отказов, мы размещаем / распределяем емкость в нескольких зонах доступности и в нескольких регионах.Предлагать услуги из нескольких зон доступности в одном регионе относительно просто: AWS позволяет это с минимальными усилиями. Зоны доступности обычно имеют хорошую репутацию независимых отказов, поэтому этот шаг сам по себе обеспечивает наличие достаточной избыточности для поддержки очень высоких уровней доступности.

Однако это еще не все. Недостаточно полагаться на какой-либо конкретный регион по нескольким причинам — иногда несколько зон доступности (AZ) действительно выходят из строя одновременно; иногда могут возникать проблемы с локальным подключением, делающие регион недоступным; а иногда в регионе могут быть просто ограничения емкости, которые не позволяют поддерживать там все службы. В результате мы также способствуем доступности услуг, предоставляя услуги в нескольких регионах. Это лучший способ обеспечить статистическую независимость отказов.

В результате мы также способствуем доступности услуг, предоставляя услуги в нескольких регионах. Это лучший способ обеспечить статистическую независимость отказов.

Установить избыточность, охватывающую несколько регионов, не так просто, как поддерживать несколько зон доступности. Например, не имеет смысла просто иметь балансировщик нагрузки, распределяющий запросы между регионами; сам балансировщик нагрузки существует в каком-то регионе и может стать недоступным.

Вместо этого мы используем комбинацию мер для обеспечения того, чтобы клиентские запросы в любое время могли быть перенаправлены в регион, который считается работоспособным и имеет доступные услуги.Эта маршрутизация предпочтительно должна быть в ближайший регион, но маршрутизация в нелокальные регионы должна быть возможна, когда ближайший регион не может предоставлять услуги.

Сервисы с отслеживанием состояния

В Ably надежность означает непрерывность бизнеса сервисов с отслеживанием состояния, и решить эту проблему значительно сложнее, чем просто доступность.

Службы с отслеживанием состояния имеют внутреннюю зависимость от состояния, которая сохраняется при каждом отдельном вызове службы. Непрерывность этого состояния означает правильность обслуживания, предоставляемого слоем в целом.Это требование непрерывности означает, что отказоустойчивость этих сервисов достигается за счет классического понимания их надежности. Резервирование должно использоваться постоянно, чтобы состояние не потерялось в случае сбоя. При обнаружении и устранении неисправностей необходимо учитывать возможные византийские режимы отказа с помощью механизмов формирования консенсуса.

Самая упрощенная аналогия — с безопасностью самолета. Авиакатастрофа является катастрофой, потому что вы — и ваше государство — находитесь на конкретном самолете ; это тот самолет , который должен обеспечивать бесперебойную работу.Если этого не произойдет, состояние будет потеряно, и вам не будет предоставлена возможность продолжить переход на другой самолет.

Для всего, что зависит от состояния, при выборе альтернативного ресурса требуется возможность продолжить работу с новым ресурсом там, где предыдущий ресурс остановился. Таким образом, состояние является требованием, и в этих случаях одной доступности недостаточно.

В Ably мы предоставляем достаточно резервной мощности для ресурсов без сохранения состояния, чтобы удовлетворить все требования наших клиентов к доступности.Однако для ресурсов с отслеживанием состояния нам нужны не только избыточные ресурсы, но и явные механизмы для использования этой избыточности, чтобы поддерживать наши гарантии обслуживания функциональной непрерывности .