Поисковые роботы Яндекс и Google

Москва г. Москва, ул. Нобеля 7, п. 56 +7 (800) 700-59-30

Поисковым роботом называется специальная программа какой-либо поисковой системы, которая предназначена для занесения в базу (индексирования) найденных в Интернете сайтов и их страниц. Также используются названия: краулер, паук, бот, automaticindexer, ant, webcrawler, bot, webscutter, webrobots, webspider.

Принцип работы

Поисковый робот — это программа браузерного типа. Он постоянно сканирует сеть: посещает проиндексированные (уже известные ему) сайты, переходит по ссылкам с них и находит новые ресурсы. При обнаружении нового ресурса робот процедур добавляет его в индекс поисковика. Поисковый робот также индексирует обновления на сайтах, периодичность которых фиксируется. Например, обновляемый раз в неделю сайт будет посещаться пауком с этой частотой, а контент на новостных сайтах может попасть в индекс уже через несколько минут после публикации. Если на сайт не ведет ни одна ссылка с других ресурсов, то для привлечения поисковых роботов ресурс необходимо добавить через специальную форму (Центр вебмастеров Google, панель вебмастера Яндекс и т.д.).

Виды поисковых роботов

Пауки Яндекса:

- Yandex/1.01.001 I — основной бот, занимающийся индексацией,

- Yandex/1.01.001 (P) — индексирует картинки,

- Yandex/1.01.001 (H) — находит зеркала сайтов,

- Yandex/1.03.003 (D) — определяет, соответствует ли страница, добавленная из панели вебмастера, параметрам индексации,

- YaDirectBot/1.0 (I) — индексирует ресурсы из рекламной сети Яндекса,

- Yandex/1.02.000 (F) — индексирует фавиконы сайтов.

Пауки Google:

- Робот Googlebot — основной робот,

- Googlebot News — сканирует и индексирует новости,

- Google Mobile — индексирует сайты для мобильных устройств,

- Googlebot Images — ищет и индексирует изображения,

- Googlebot Video — индексирует видео,

- Google AdsBot — проверяет качество целевой страницы,

- Google Mobile AdSense и Google AdSense — индексирует сайты рекламной сети Google.

Другие поисковики также используют роботов нескольких видов, функционально схожих с перечисленными.

wiki.rookee.ru

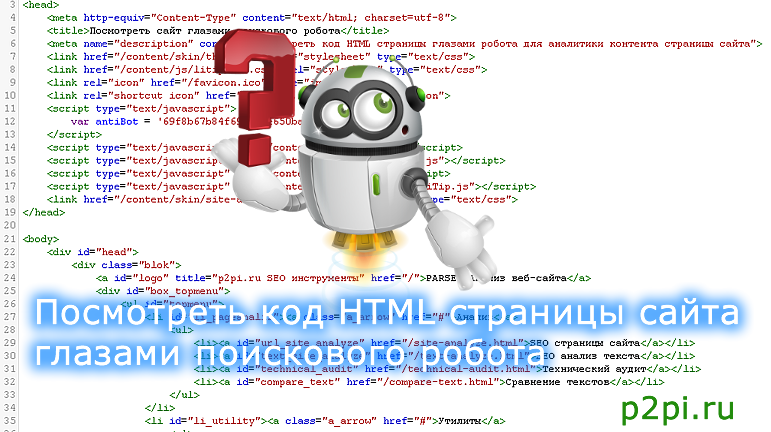

Посмотреть сайт глазами поискового робота

В некоторых случаях бывает интересно посмотреть HTML код понравившейся станицы. Например узнать какой .js библиотекой достигнут тот или иной функционал, а может заинтересовали CSS стили оформления и.т.д. Но откравая страницу правой кнопкой мыши мы можем иногда наблюдать сжатый код написанный в одну строчку, ну и разумеется без подсветки кода. Что согласитесь затрудняет поиск заинтересовавшего куска кода. Наш онлайн сервис поможет открыть HTML в удобочитаемом виде с подсветкой и форматированием кода.

Глаз робота отличается от пользователя.

Это связано с тем, что некоторые сайты могут отдавать различный контент в зависимости от пользователя или робота.

Например интернет магазин для пользователя может отдаваться различый контент в зависимости от региона проживания.

Метод черной поисковой оптимизации — называется «клоакинг» Термин произошел от английского слова to cloak – маскировать, прятать, скрывать — Сайты, отдающие разный контент пользователям и роботам поисковых систем.

Такие сайты Яндекс и Google относят к некачественным сайтам и объявили за клоакинг жесткие штрафные санкции, от пессимизации до бана.

Ярким примером клоакинга могут служить каталоги ссылок скрывающие прямые ссылки от роботов , но показывающие их простому пользователю, который никак не может понять почему же его сылка не видна в поисковых системах.

Обратите внимание, что к клоакингу не относится показ различного содержание веб-ресурса если пользователь просматривает его как авторизованный (через логин и пароль). Также не имеет отношение к клоакингу просмотр динамических страниц с разными URL переменными например URL = user и URL = bot.

Наш онлайн инструмент для веб-мастера позволяет просмотреть код HTML глазами поискового робота Googlebot и робота Яндекса.

Список HTTP USER AGENT:

Пользователь — Я Mozilla/5.0 (X11; Linux x86_64; rv:33.0) Gecko/20100101 Firefox/33.0

Основной робот Яндекса — Mozilla/5.0 (compatible; YandexBot/3.0; +http://yandex.com/bots)

Зеркальщик — робот Яндекса — Mozilla/5.0 (compatible; YandexBot/3.0; MirrorDetector; +http://yandex.com/bots)

Картинки — робот Яндекса — Mozilla/5.0 (compatible; YandexImages/3.0; +http://yandex.com/bots)

Видео — робот Яндекса Mozilla/5.0 (compatible; YandexVideo/3.0; +http://yandex.com/bots)

Вебмастер — робот Яндекса Mozilla/5.0 (compatible; YandexWebmaster/2.0; +http://yandex.com/bots)

Индексатор мультимедийных данных — робот Яндекса Mozilla/5.0 (compatible; YandexMedia/3.0; +http://yandex.com/bots)

Поиск по блогам — робот Яндекса Mozilla/5.0 (compatible; YandexBlogs/0.99; robot; +http://yandex.com/bots)

APIs-Google — робот Google PIs-Google (+https://developers.google.com/webmasters/APIs-Google.html)

AdSense — робот Google Mediapartners-Google

AdsBot Mobile Web Android — робот Google Mozilla/5.0 (Linux; Android 5.0; SM-G920A) AppleWebKit (KHTML, like Gecko) Chrome Mobile Safari (compatible; AdsBot-Google-Mobile; +http://www.google.com/mobile/adsbot.html)

AdsBot Mobile Web — робот Google Mozilla/5.0 (iPhone; CPU iPhone OS 9_1 like Mac OS X) AppleWebKit/601.1.46 (KHTML, like Gecko) Version/9.0 Mobile/13B143 Safari/601.1 (compatible; AdsBot-Google-Mobile; +http://www.google.com/mobile/adsbot.html)

AdsBot-Google (+http://www.google.com/adsbot.html) AdsBot — робот Google)

Googlebot Images — робот Google Googlebot-Image/1.0

Googlebot News — робот Google Googlebot-News

Googlebot Video — робот Google Googlebot-Video/1.0

Googlebot — робот Google Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)

Mobile AdSense — робот Google (compatible; Mediapartners-Google/2.1; +http://www.google.com/bot.html)

Mobile Apps Android — робот Google AdsBot-Google-Mobile-Apps

p2pi.ru

что это, виды, управление, проверка посещений сайта роботами

Краулер (поисковый бот, робот, паук) – это неотъемлемая для поисковой системы программа, отвечающая за поиск сайтов и сканирование их содержимого путем перехода по страницам и ссылкам для занесения собранной информации в базу данных поисковика.

Зачем нужны поисковые пауки?

Допустим, есть пользователь Иван Иванов, ежедневно посещающий какой-нибудь популярный книжный онлайн-ресурс, и этот ресурс регулярно пополняется новыми произведениями. Переходя на сайт, Иван осуществляет следующую последовательность действий:

- Заходит на главную страницу.

- Переходит в раздел «Новые книги».

- Просматривает список с недавно добавленными материалами.

- Открывает ссылки с заинтересовавшими его заголовками.

- Ознакомляется с аннотациями и скачивает интересующие его файлы.

Во избежание таких временных затрат нужно использовать программу, в автоматическом режиме занимающуюся поиском новинок.

Без роботов ни один поисковик не будет эффективным, вне зависимости от того, Google это или новая поисковая система. И чтобы не делать, как Иван, они используют роботов для «обхода» сайтов, отыскивающих для поисковых систем новую информацию, которую они смогут предложить пользователям. И чем лучше сканирует краулер, тем актуальнее материалы в выдаче.

Основные боты выполняют следующие функции:

- Собирают новый или обновленный контент с веб-ресурсов. Сканированием свежих публикаций и ранее размещенных статей занимаются пауки первого порядка.

- Идентификация зеркал. Краулер отыскивает сайты, содержащие идентичный контент, но с разными доменами. Подобные боты имеет Яндекс.

- Сканирование графических файлов. Для поиска графики может быть привлечен отдельный робот.

И много других различных краулеров, которые имеют свое предназначение, о которых мы поговорим ниже.

Виды краулеров

У каждого поисковика есть набор собственных веб-пауков, выполняющих различные функции. Поговорим о ботах двух популярнейших поисковых машин.

Роботы Яндекса

- YandexBot – основной краулер, занимающийся индексацией.

- YandexImages – вносит в индекс изображения ресурсов.

- YandexMobileBot – собирает страницы для их анализа и определения адаптации для смартфонов.

- YandexDirect – сканирует данные о материалах ресурсов-партнером РСЯ.

- YandexMetrika – поисковый паук сервиса Яндекс.Метрика.

- YandexMarket – бот Яндекс.Маркета.

- YandexCalenda – краулер Яндекс.Календаря.

- YandexNew

как правильно составить и для чего он нужен

Поисковые роботы индексируют всё, что находят. Даже админпанель с личной информацией. Robots.txt — это специальный файл для ботов с правилами, по которым они начинают работать с вашим сайтом. В этом файле вы и прописываете всё, что разрешаете или запрещаете им делать.

Важный файл robots.txt

Для чего нужен

Для того, чтобы ваш сайт быстрее индексировался, в поиск не попадали ненужные страницы или приватная информация. «Ненужные страницы» — это дубликаты товарных категорий, личная информация, формы отправки данных, страницы с результатами поиска и т.п. Robots.txt устанавливает строгие правила для поисковиков, если же эти правила не указать, то вся ваша информация окажется в сети и удалить её из архивов интернета будет практически нереально.

Где писать этот файл и где его располагать

Писать можно в любом удобном для вас редакторе — в обычном встроенном блокноте для Windows, NotePad или Word — не суть. Главное, чтобы этот файл был сохранён в текстовом формате, то есть с расширением .txt.

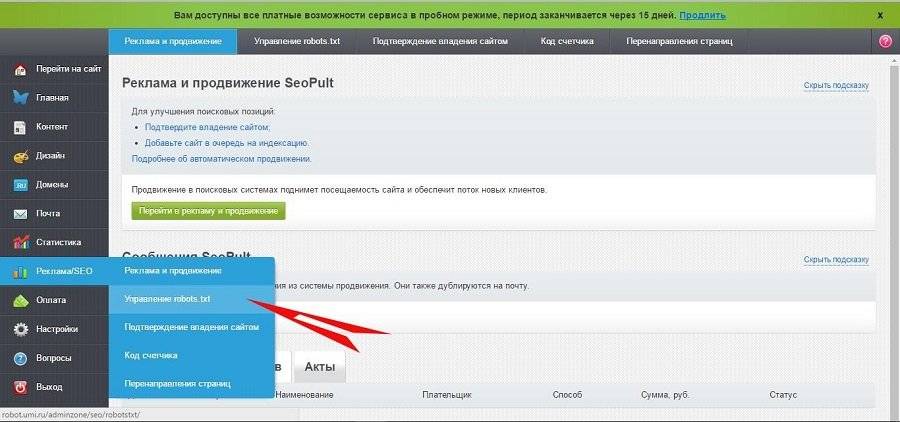

В нашей системе вставить инструкцию для поисковых ботов на сайт очень просто: выберите в левой панели управления сайтом раздел «Реклама/SEO → Управление robots.txt».

Управление robots.txt находится в разделе «Реклама/SEO»

И в открывшееся поле вы просто вставляете готовую инструкцию (с помощью функции «копировать — вставить»).

На нашем сервисе файл robots.txt автоматически генерируется системой. В большинстве случаев он полностью отвечает всем требованиям поисковых роботов и закрывает от индексации те страницы, которые не должны быть на виду. Но вы можете создать свою инструкцию или внести любые изменения в готовый файл. В случае необходимости всегда можно восстановить первоначальный вариант.

Правила синтаксиса robots.txt

Поисковый робот учитывает только определённые выражения и алгоритмы. Поэтому инструкция составляется на понятном ему «языке». Вот основные команды, которые «понимает» робот:

- User-Agent: Имя бота поисковой системы. Для Яндекса это Yandex, для Google — Google-bot, для Mail.ru — Mail.ru. Весь список названий роботов-поисковиков перечислен на этой странице.

- Allow — команда «разрешить».

- Disallow — команда «запретить».

- Host — имя вашего хостера (на 1C-UMI это robot.umi.ru).

Директива Allow не является обязательной, а вот Disallow нужно указывать. По умолчанию файл robots.txt разрешает всё, поэтому прописывать нужно только запрещающие команды.

Правильный синтаксис написания: команда → двоеточие → пробел → слеш (/) → точное наименование страницы.

Точное наименование страницы — это весь путь, который ведёт на указанную страницу, начиная с главной: мойсайт.рф — мода — женская мода — верхняя одежда — пальто — чёрное пальто в горошек.

Пример:

- Вы разрешаете поисковому боту Яндекс индексировать всё, кроме страницы «Контакты»:

- User-Agent: Yandex

- Allow:

- Disallow: /contacts

- Если вы разрешаете индексировать сайт всем поисковым системам, то после User-Agent нужно поставить знак *:

- Если вы ничего не запрещаете к индексации, то после disallow ничего не ставите:

- Если вы запрещаете какому-то определённому боту индексировать свой сайт, то ставите его имя и запрещающую команду disallow вместе со слешем:

- User-Agent: googlebot-image (робот-поисковик по картинкам в Гугл)

- Disallow: /

Disallow относится только к тому боту, который указан перед командой. Для каждого робота нужно прописывать команды индивидуально.

Как не запутаться в названиях ботов и командах

Есть удобная функция «комментарий», которую вы можете использовать при составлении robots.txt. Всё, что вы хотите прокомментировать, оставить какое-либо уточнение, отмечайте символом #. Всё, что будет написано после этого знака, роботом не учитывается.

User-Agent: Yandex

Disallow: /Price/ #Не индексировать каталог с ценами.

Как установить период захода на сайт робота-поисковика

Чтобы уменьшить нагрузку на сервер, нужно использовать директиву (команду для робота-поисковика) Crawl-delay. Она устанавливает период, за который робот-поисковик должен обойти сайт, или время, за которое робот просмотрит все страницы сайта и внесёт их в индекс. Другими словами, эта директива позволяет ускорить обход сайта роботом. Обычно устанавливается на сайт-многостраничник. Если у вас страниц ещё немного, не больше двухсот, то этот параметр можно не указывать.

Прописывается это так:

- User-Agent: Yandex

- Disallow: /contacts

- Craw-delay: 2 #Тайм-аут обхода 2 секунды

Тайм-аут обхода вы можете указать любой. Это не гарантирует, что на ваш сайт робот будет заходить каждые 2 (3, 4, 5…) секунд, вы просто даёте ему приблизительное время обхода. Если ваш сайт уже хорошо ранжируется, то роботы будут заходить на него чаще, если сайт ещё молод, то реже. В справке Яндекс об этом параметре написано подробней.

Ошибки при составлении robots.txt

Рассмотрим самые популярные ошибки, которые совершают пользователи при создании файла.

|

Ошибки |

Правильно |

|

Путаница в инструкциях User-Agent: / Disallow: Googlebot |

User-Agent: Googlebot Disallow: / |

|

Несколько каталогов в одной строке Disallow Disallow: /moda/ hat/ images |

Disallow: /moda/ Disallow: /hat/ Disallow: /images/ |

|

Пустая строка в указании имени поискового робота User-Agent: Disallow: |

User-Agent: * Disallow: |

|

Заглавные буквы USER-AGENT: YANDEX ALLOW: |

User-Agent: Yandex Allow: |

|

Перечисление каждого файла в категории User-Agent: Googlebot Disallow: / moda/ krasnoe-palto.html Disallow: /moda/ sinee-palto.html Disallow: /moda/ zelenoe-palto.html Disallow: /moda/ seroe-palto.html Disallow: /price/ women.html Disallow: /price/ men.html |

User-Agent: Googlebot Disallow: / moda/ Disallow: /price/ |

Не забывайте про знак слеш (/). Если его не будет, то робот запретит к индексации все файлы и категории с таким же названием. Например, если вы не укажете слеш в директиве: “Disallow: moda”, то из индекса выпадут все страницы, рубрики и категории, где встречается это название.

Правила написания robots.txt

- Каждую команду надо писать с новой строки.

- В одной строке — одна директива.

- В начале строки не должно быть пробела.

- Команды не берут в кавычки.

- В конце директивы не ставится точка с запятой, запятая или точка.

- Disallow: равнозначно Allow: / (всё разрешено).

- Поисковые роботы чувствительны к регистру букв — прописывайте имена файлов и категорий точно так же, как они указаны на вашем сайте.

- Если у вас нет robots.txt, это сигнал для поисковиков, что запрещений нет, индексировать можно всё.

- В robots.txt используется только английский язык. Все другие языки игнорируются.

Как проверить robots.txt на правильность написания

Есть специальные сервисы, которые проверяют, правильно ли составлен разрешающий файл. Проверьте свой robots.txt на сайте Яндекс или в Гугл.

Автоматическое создание robots.txt

Если для вас сложно самостоятельно написать инструкцию для ботов, то создайте её автоматически. На сайте pr-cy файл будет сгенерирован за 10 секунд, просто укажите нужные вам параметры, потом скопируйте текст и вставьте его в поле для robots.txt на нашем сервисе.Директивы — базовая информация

Директивы – это своеобразный свод правил поведения на страничках сайта для robots.txt. Считывая их, поисковый агент и понимает, какой контент можно использовать для индексации сайта, а какой нельзя.Если директивы не прописать вовсе, поисковик скачает с вашего сайта всю информацию и проиндексирует. Последствием этих действий станет его медленная загрузка. Очевидно, что такие сайты меньше посещают пользователи и не помещают в вершинах выдачи поисковые системы.

Ниже перечислим разные типы директив, с пояснениями.

User-agent

Если перевести на простой язык, то «User-agent» — это призыв к некоему действию. После этого директива обычно прописывается наименование robots.txt, которому сообщается информация, а далее — уже сама информация. Иными словами, User-agent — самая важная директива для robots.txt.

Вот так выглядят директивы User-agent для разных поисковых машин:

- User-agent: *; — для всех видов роботов.

- User-agent: Yandex; — для роботов поисковика Яндекс.

- User-agent: Googlebot. — для роботов поисковика Google.

- User-agent: Mail.Ru. — для роботов Mail.ru

- User-agent: Slurp – для роботов Yahoo!

- User-agent: MSNBot – для роботов MSN

- User-agent: StackRambler – для роботов Рамблера.

Disallow

Директива, запрещающая индексировать те или иные странички веб-сайта. Веб-мастера советуют прописывать ее для следующих типов страниц:

- Корзине и всем сопутствующим оформлению заказа страничкам.

- Поисковым формам.

- Административной панели сайта.

- Ajax, Json — эти скрипты выводят всплывающие формы для заполнения, рекламные баннеры и так далее.

Allow

Это директива, наоборот, открывает страничку сайта для чтения роботом.

Sitemap

Простыми словами — директива, отображающая карту вашего сайта. Сообщая роботу структуру вашего сайта, вы ускоряете его индексацию.

Host

Указывает поисковому роботу на зеркало вашего сайта, куда будут попадать пользователи.

Crawl-delay

Помогает снижать нагрузку на сервер, задавая минимальный временной интервал между обращениями к сервису.

Общие рекомендации любых директив:

- Не прописывайте в одной строчке больше одной директивы.

- Убирайте пробелы в начале строк.

- Только полная директива без лишних символов будет работать.

- Код файла robots.txt немыслим без Disallow.

Robots.txt напрямую влияет на индексацию сайта, поэтому обязательно установите свои правила для поисковых ботов. Успешного вам продвижения!

umi.ru

Файл robots.txt — способы анализа и проверки robots.txt

Поисковые роботы — краулеры начинают знакомство с сайтом с чтения файла robots.txt. В нем содержится вся важная для них информация. Владельцам сайтов следует создать и периодически проводить анализ robots.txt. От корректности его работы зависит скорость индексации страниц и место в поисковой выдачи.

Создание файла

Описание. Файл robots.txt — это документ со служебной информацией. Он предназначен для поисковых роботов. В нем записывают, какие страницы можно индексировать, какие — нет и каким именно краулерам. Например, англоязычный Facebook разрешает доступ только боту Google. Файл robots.txt любого сайта можно посмотреть в браузере по ссылке www.site.ru/robots.txt.

Он не является обязательным элементом сайта, но его наличие желательно, потому что с его помощью владельцы сайта управляют поисковыми роботами. Задавайте разные уровни доступа к сайту, запрет на индексацию всего сайта, отдельных страниц, разделов или файлов. Для ресурсов с высокой посещаемостью ограничивайте время индексации и запрещайте доступ роботов, которые не относятся к основным поисковым системам. Это уменьшит нагрузку на сервер.

Создание. Создают файл в текстовом редакторе Notepad или подобных. Следите за тем, чтобы размер файла не превышал 32 КБ. Выбирайте для файла кодировку ASCII или UTF-8. Учтите, что файл должен быть единственным. Если сайт создан на CMS, то он будет генерироваться автоматически.

Разместите созданный файл в корневой директории сайта рядом с основным файлом index.html. Для этого используют FTP доступ. Если сайт сделан на CMS, то с файлом работают через административную панель. Когда файл создан и работает корректно, он доступен в браузере.

При отсутствии robots.txt поисковые роботы собирают всю информацию, относящуюся к сайту. Не удивляйтесь, когда увидите в выдаче незаполненные страницы или служебную информацию. Определите, какие разделы сайта будут доступны пользователям, остальные — закройте от индексации.

Проверка. Периодически проверяйте, все ли работает корректно. Если краулер не получает ответ 200 ОК, то он автоматически считает, что файла нет, и сайт открыт для индексации полностью. Коды ошибок бывают такими:

-

3хх — ответы переадресации. Робота направляют на другую страницу или на главную. Создавайте до пяти переадресаций на одной странице. Если их будет больше, робот пометит такую страницу как ошибку 404. То же самое относится и к переадресации по принципу бесконечного цикла;

-

4хх — ответы ошибок сайта. Если краулер получает от файла robots.txt 400-ую ошибку, то делается вывод, что файла нет и весь контент доступен. Это также относится к ошибкам 401 и 403;

-

5хх — ответы ошибок сервера. Краулер будет «стучаться», пока не получит ответ, отличный от 500-го.

Правила создания

Начинаем с приветствия. Каждый файл должен начинаться с приветствия User-agent. С его помощью поисковики определят уровень открытости.

| Код | Значение |

| User-agent: * | Доступно всем |

| User-agent: Yandex | Доступно роботу Яндекс |

| User-agent: Googlebot | Доступно роботу Google |

| User-agent: Mail.ru | Доступно роботу Mail.ru |

Добавляем отдельные директивы под роботов. При необходимости добавляйте директивы для специализированных поисковых ботов Яндекса.

Однако в этом случае директивы * и Yandex не будут учитываться.

| YandexBot | Основной робот |

| YandexImages | Яндекс.Картинки |

| YandexNews | Яндекс.Новости |

| YandexMedia | Индексация мультимедиа |

| YandexBlogs | Индексация постов и комментариев |

| YandexMarket | Яндекс.Маркет |

| YandexMetrika | Яндекс.Метрика |

| YandexDirect | Рекламная сеть Яндекса |

| YandexDirectDyn | Индексация динамических баннеров |

| YaDirectFetcher | Яндекс.Директ |

| YandexPagechecker | Валидатор микроразметки |

| YandexCalendar | Яндекс.Календарь |

У Google собственные боты:

| Googlebot | Основной краулер |

| Google-Images | Google.Картинки |

| Mediapartners-Google | AdSense |

| AdsBot-Google | Проверка качества рекламы |

|

AdsBot-Google-Mobile |

Проверка качества рекламы на мобильных устройствах |

| Googlebot-News | Новости Google |

Сначала запрещаем, потом разрешаем. Оперируйте двумя директивами: Allow — разрешаю, Disallow — запрещаю. Обязательно укажите директиву disallow, даже если доступ разрешен ко всему сайту. Такая директива является обязательной. В случае ее отсутствия краулер может не верно прочитать остальную информацию. Если на сайте нет закрытого контента, оставьте директиву пустой.

Работайте с разными уровнями. В файле можно задать настройки на четырех уровнях: сайта, страницы, папки и типа контента. Допустим, вы хотите закрыть изображения от индексации. Это можно сделать на уровне:

- папки — disallow: /images/

- типа контента — disallow: /*.jpg

| Нет | Да |

| Disallow: Yandex |

User-agent: Yandex Disallow: / |

| Disallow: /css/ /images/ |

Disallow: /css/ Disallow: /images/ |

Пишите с учетом регистра. Имя файла укажите строчными буквами. Яндекс в пояснительной документации указывает, что для его ботов регистр не важен, но Google просит соблюдать регистр. Также вероятна ошибка в названиях файлов и папок, в которых учитывается регистр.

Укажите 301 редирект на главное зеркало сайта. Раньше для этого использовалась директива Host, но с марта 2018 г. она больше не нужна. Если она уже прописана в файле robots.txt, удалите или оставьте ее на свое усмотрение; роботы игнорируют эту директиву.

Для указания главного зеркала проставьте 301 редирект на каждую страницу сайта. Если редиректа стоят не будет, поисковик самостоятельно определит, какое зеркало считать главным. Чтобы исправить зеркало сайта, просто укажите постраничный 301 редирект и подождите несколько дней.

Пропишите директиву Sitemap (карту сайта). Файлы sitemap.xml и robots.txt дополняют друг друга. Проверьте, чтобы:

- файлы не противоречили друг другу;

- страницы были исключены из обоих файлов;

- страницы были разрешены в обоих файлах.

Указывайте комментарии через символ #. Все, что написано после него, краулер игнорирует.

Проверка файла

Проводите анализ robots.txt с помощью инструментов для разработчиков: через Яндекс.Вебмастер и Google Robots Testing Tool. Обратите внимание, что Яндекс и Google проверяют только соответствие файла собственным требованиям. Если для Яндекса файл корректный, это не значит, что он будет корректным для роботов Google, поэтому проверяйте в обеих системах.

Если вы найдете ошибки и исправите robots.txt, краулеры не считают изменения мгновенно. Обычно переобход страниц осуществляется один раз в день, но часто занимает гораздо большее время. Проверьте через неделю файл, чтобы убедиться, что поисковики используют новую версию.

Проверка в Яндекс.Вебмастере

Сначала подтвердите права на сайт. После этого он появится в панели Вебмастера. Введите название сайта в поле и нажмите проверить. Внизу станет доступен результат проверки.

Дополнительно проверяйте отдельные страницы. Для этого введите адреса страниц и нажмите «проверить».

Проверка в Google Robots Testing Tool

Позволяет проверять и редактировать файл в административной панели. Выдает сообщение о логических и синтаксических ошибках. Исправляйте текст файла прямо в редакторе Google. Но обратите внимание, что изменения не сохраняются автоматически. После исправления robots.txt скопируйте код из веб-редактора и создайте новый файл через блокнот или другой текстовый редактор. Затем загрузите его на сервер в корневой каталог.

Запомните

-

Файл robots.txt помогает поисковым роботам индексировать сайт. Закрывайте сайт во время разработки, в остальное время — весь сайт или его часть должны быть открыты. Корректно работающий файл должен отдавать ответ 200.

-

Файл создается в обычном текстовом редакторе. Во многих CMS в административной панели предусмотрено создание файла. Следите, чтобы размер не превышал 32 КБ. Размещайте его в корневой директории сайта.

-

Заполняйте файл по правилам. Начинайте с кода “User-agent:”. Правила прописывайте блоками, отделяйте их пустой строкой. Соблюдайте принятый синтаксис.

-

Разрешайте или запрещайте индексацию всем краулерам или избранным. Для этого укажите название поискового робота или поставьте значок *, который означает «для всех».

-

Работайте с разными уровнями доступа: сайтом, страницей, папкой или типом файлов.

-

Включите в файл указание на главное зеркало с помощью постраничного 301 редиректа и на карту сайта с помощью директивы sitemap.

-

Для анализа robots.txt используйте инструменты для разработчиков. Это Яндекс.Вебмастер и Google Robots Testing Tools. Сначала подтвердите права на сайт, затем сделайте проверку. В Google сразу отредактируйте файл в веб-редакторе и уберите ошибки. Отредактированные файлы не сохраняются автоматически. Загружайте их на сервер вместо первоначального robots.txt. Через неделю проверьте, используют ли поисковики новую версию.

Материал подготовила Светлана Сирвида-Льорентэ.

www.ashmanov.com

Robots.txt — Как создать правильный robots.txt

Файл robots.txt является одним из самых важных при оптимизации любого сайта. Его отсутствие может привести к высокой нагрузке на сайт со стороны поисковых роботов и медленной индексации и переиндексации, а неправильная настройка к тому, что сайт полностью пропадет из поиска или просто не будет проиндексирован. Следовательно, не будет искаться в Яндексе, Google и других поисковых системах. Давайте разберемся во всех нюансах правильной настройки robots.txt.

Для начала короткое видео, которое создаст общее представление о том, что такое файл robots.txt.

Как влияет robots.txt на индексацию сайта

Поисковые роботы будут индексировать ваш сайт независимо от наличия файла robots.txt. Если же такой файл существует, то роботы могут руководствоваться правилами, которые в этом файле прописываются. При этом некоторые роботы могут игнорировать те или иные правила, либо некоторые правила могут быть специфичными только для некоторых ботов. В частности, GoogleBot не использует директиву Host и Crawl-Delay, YandexNews с недавних пор стал игнорировать директиву Crawl-Delay, а YandexDirect и YandexVideoParser игнорируют более общие директивы в роботсе (но руководствуются теми, которые указаны специально для них).

Подробнее об исключениях:

Исключения Яндекса

Стандарт исключений для роботов (Википедия)

Максимальную нагрузку на сайт создают роботы, которые скачивают контент с вашего сайта. Следовательно, указывая, что именно индексировать, а что игнорировать, а также с какими временны́ми промежутками производить скачивание, вы можете, с одной стороны, значительно снизить нагрузку на сайт со стороны роботов, а с другой стороны, ускорить процесс скачивания, запретив обход ненужных страниц.

К таким ненужным страницам относятся скрипты ajax, json, отвечающие за всплывающие формы, баннеры, вывод каптчи и т.д., формы заказа и корзина со всеми шагами оформления покупки, функционал поиска, личный кабинет, админка.

Для большинства роботов также желательно отключить индексацию всех JS и CSS. Но для GoogleBot и Yandex такие файлы нужно оставить для индексирования, так как они используются поисковыми системами для анализа удобства сайта и его ранжирования (пруф Google, пруф Яндекс).

Директивы robots.txt

Директивы — это правила для роботов. Есть спецификация W3C от 30 января 1994 года и расширенный стандарт от 1996 года. Однако не все поисковые системы и роботы поддерживают те или иные директивы. В связи с этим для нас полезнее будет знать не стандарт, а то, как руководствуются теми или иными директивы основные роботы.

Давайте рассмотрим по порядку.

User-agent

Это самая главная директива, определяющая для каких роботов далее следуют правила.

Для всех роботов:User-agent: *

Для конкретного бота:User-agent: GoogleBot

Обратите внимание, что в robots.txt не важен регистр символов. Т.е. юзер-агент для гугла можно с таким же успехом записать соледующим образом:user-agent: googlebot

Ниже приведена таблица основных юзер-агентов различных поисковых систем.

| Бот | Функция |

|---|---|

| Googlebot | основной индексирующий робот Google |

| Googlebot-News | Google Новости |

| Googlebot-Image | Google Картинки |

| Googlebot-Video | видео |

| Mediapartners-Google | Google AdSense, Google Mobile AdSense |

| Mediapartners | Google AdSense, Google Mobile AdSense |

| AdsBot-Google | проверка качества целевой страницы |

| AdsBot-Google-Mobile-Apps | Робот Google для приложений |

| Яндекс | |

| YandexBot | основной индексирующий робот Яндекса |

| YandexImages | Яндекс.Картинки |

| YandexVideo | Яндекс.Видео |

| YandexMedia | мультимедийные данные |

| YandexBlogs | робот поиска по блогам |

| YandexAddurl | робот, обращающийся к странице при добавлении ее через форму «Добавить URL» |

| YandexFavicons | робот, индексирующий пиктограммы сайтов (favicons) |

| YandexDirect | Яндекс.Директ |

| YandexMetrika | Яндекс.Метрика |

| YandexCatalog | Яндекс.Каталог |

| YandexNews | Яндекс.Новости |

| YandexImageResizer | робот мобильных сервисов |

| Bing | |

| Bingbot | основной индексирующий робот Bing |

| Yahoo! | |

| Slurp | основной индексирующий робот Yahoo! |

| Mail.Ru | |

| Mail.Ru | основной индексирующий робот Mail.Ru |

| Rambler | |

| StackRambler | Ранее основной индексирующий робот Rambler. Однако с 23.06.11 Rambler перестает поддерживать собственную поисковую систему и теперь использует на своих сервисах технологию Яндекса. Более не актуально. |

Disallow и Allow

Disallow закрывает от индексирования страницы и разделы сайта.

Allow принудительно открывает для индексирования страницы и разделы сайта.

Но здесь не все так просто.

Во-первых, нужно знать дополнительные операторы и понимать, как они используются — это *, $ и #.

* — это любое количество символов, в том числе и их отсутствие. При этом в конце строки звездочку можно не ставить, подразумевается, что она там находится по умолчанию.

$ — показывает, что символ перед ним должен быть последним.

# — комментарий, все что после этого символа в строке роботом не учитывается.

Примеры использования:

Disallow: *?s=

Disallow: /category/$

Следующие ссылки будут закрыты от индексации:

http://site.ru/?s=

http://site.ru/?s=keyword

http://site.ru/page/?s=keyword

http://site.ru/category/

Следующие ссылки будут открыты для индексации:

http://site.ru/category/cat1/

http://site.ru/category-folder/

Во-вторых, нужно понимать, каким образом выполняются вложенные правила.

Помните, что порядок записи директив не важен. Наследование правил, что открыть или закрыть от индексации определяется по тому, какие директории указаны. Разберем на примере.

Allow: *.css

Disallow: /template/

http://site.ru/template/ — закрыто от индексирования

http://site.ru/template/style.css — закрыто от индексирования

http://site.ru/style.css — открыто для индексирования

http://site.ru/theme/style.css — открыто для индексирования

Если нужно, чтобы все файлы .css были открыты для индексирования придется это дополнительно прописать для каждой из закрытых папок. В нашем случае:

Allow: *.css

Allow: /template/*.css

Disallow: /template/

Повторюсь, порядок директив не важен.

Sitemap

Директива для указания пути к XML-файлу Sitemap. URL-адрес прописывается так же, как в адресной строке.

Например,

Sitemap: http://site.ru/sitemap.xml

Директива Sitemap указывается в любом месте файла robots.txt без привязки к конкретному user-agent. Можно указать несколько правил Sitemap.

Host

Директива для указания главного зеркала сайта (в большинстве случаев: с www или без www). Обратите внимание, что главное зеркало указывается БЕЗ http://, но С https://. Также если необходимо, то указывается порт.

Директива поддерживается только ботами Яндекса и Mail.Ru. Другими роботами, в частности GoogleBot, команда не будет учтена. Host прописывается только один раз!

Пример 1:Host: site.ru

Пример 2:Host: https://site.ru

Crawl-delay

Директива для установления интервала времени между скачиванием роботом страниц сайта. Поддерживается роботами Яндекса, Mail.Ru, Bing, Yahoo. Значение может устанавливаться в целых или дробных единицах (разделитель — точка), время в секундах.

Пример 1:Crawl-delay: 3

Пример 2:Crawl-delay: 0.5

Если сайт имеет небольшую нагрузку, то необходимости устанавливать такое правило нет. Однако если индексация страниц роботом приводит к тому, что сайт превышает лимиты или испытывает значительные нагрузки вплоть до перебоев работы сервера, то эта директива поможет снизить нагрузку.

Чем больше значение, тем меньше страниц робот загрузит за одну сессию. Оптимальное значение определяется индивидуально для каждого сайта. Лучше начинать с не очень больших значений — 0.1, 0.2, 0.5 — и постепенно их увеличивать. Для роботов поисковых систем, имеющих меньшее значение для результатов продвижения, таких как Mail.Ru, Bing и Yahoo можно изначально установить бо́льшие значения, чем для роботов Яндекса.

Clean-param

Это правило сообщает краулеру, что URL-адреса с указанными параметрами не нужно индексировать. Для правила указывается два аргумента: параметр и URL раздела. Директива поддерживается Яндексом.

Пример 1:

Clean-param: author_id http://site.ru/articles/

http://site.ru/articles/?author_id=267539 — индексироваться не будет

Пример 2:

Clean-param: author_id&sid http://site.ru/articles/

http://site.ru/articles/?author_id=267539&sid=0995823627 — индексироваться не будет

Яндекс также рекомендует использовать эту директиву для того, чтобы не учитывались UTM-метки и идентификаторы сессий. Пример:

Clean-Param: utm_source&utm_medium&utm_campaign

Другие параметры

В расширенной спецификации robots.txt можно найти еще параметры Request-rate и Visit-time. Однако они на данный момент не поддерживаются ведущими поисковыми системами.

Смысл директив:

Request-rate: 1/5 — загружать не более одной страницы за пять секунд

Visit-time: 0600-0845 — загружать страницы только в промежуток с 6 утра до 8:45 по Гринвичу.

Закрывающий robots.txt

Если вам нужно настроить, чтобы ваш сайт НЕ индексировался поисковыми роботами, то вам нужно прописать следующие директивы:

User-agent: *

Disallow: /

Проверьте, чтобы на тестовых площадках вашего сайта были прописаны эти директивы.

Правильная настройка robots.txt

Для России и стран СНГ, где доля Яндекса ощутима, следует прописывать директивы для всех роботов и отдельно для Яндекса и Google.

Для России и стран СНГ, где доля Яндекса ощутима, следует прописывать директивы для всех роботов и отдельно для Яндекса и Google.

Чтобы правильно настроить robots.txt воспользуйтесь следующим алгоритмом:

- Закройте от индексирования админку сайта

- Закройте от индексирования личный кабинет, авторизацию, регистрацию

- Закройте от индексирования корзину, формы заказа, данные по доставке и заказам

- Закройте от индексирования ajax, json-скрипты

- Закройте от индексирования папку cgi

- Закройте от индексирования плагины, темы оформления, js, css для всех роботов, кроме Яндекса и Google

- Закройте от индексирования функционал поиска

- Закройте от индексирования служебные разделы, которые не несут никакой ценности для сайта в поиске (ошибка 404, список авторов)

- Закройте от индексирования технические дубли страниц, а также страницы, на которых весь контент в том или ином виде продублирован с других страниц (календари, архивы, RSS)

- Закройте от индексирования страницы с параметрами фильтров, сортировки, сравнения

- Закройте от индексирования страницы с параметрами UTM-меток и сессий

- Проверьте, что проиндексировано Яндексом и Google с помощью параметра «site:» (в поисковой строке наберите «site:site.ru»). Если в поиске присутствуют страницы, которые также нужно закрыть от индексации, добавьте их в robots.txt

- Укажите Sitemap и Host

- По необходимости пропишите Crawl-Delay и Clean-Param

- Проверьте корректность robots.txt через инструменты Google и Яндекса (описано ниже)

- Через 2 недели перепроверьте, появились ли в поисковой выдаче новые страницы, которые не должны индексироваться. В случае необходимости повторить выше перечисленные шаги.

Пример robots.txt

# Пример файла robots.txt для настройки гипотетического сайта https://site.ru User-agent: * Disallow: /admin/ Disallow: /plugins/ Disallow: /search/ Disallow: /cart/ Disallow: */?s= Disallow: *sort= Disallow: *view= Disallow: *utm= Crawl-Delay: 5 User-agent: GoogleBot Disallow: /admin/ Disallow: /plugins/ Disallow: /search/ Disallow: /cart/ Disallow: */?s= Disallow: *sort= Disallow: *view= Disallow: *utm= Allow: /plugins/*.css Allow: /plugins/*.js Allow: /plugins/*.png Allow: /plugins/*.jpg Allow: /plugins/*.gif User-agent: Yandex Disallow: /admin/ Disallow: /plugins/ Disallow: /search/ Disallow: /cart/ Disallow: */?s= Disallow: *sort= Disallow: *view= Allow: /plugins/*.css Allow: /plugins/*.js Allow: /plugins/*.png Allow: /plugins/*.jpg Allow: /plugins/*.gif Clean-Param: utm_source&utm_medium&utm_campaign Crawl-Delay: 0.5 Sitemap: https://site.ru/sitemap.xml Host: https://site.ru

Как добавить и где находится robots.txt

После того как вы создали файл robots.txt, его необходимо разместить на вашем сайте по адресу site.ru/robots.txt — т.е. в корневом каталоге. Поисковый робот всегда обращается к файлу по URL /robots.txt

Как проверить robots.txt

Проверка robots.txt осуществляется по следующим ссылкам:

Типичные ошибки в robots.txt

В конце статьи приведу несколько типичных ошибок файла robots.txt

В конце статьи приведу несколько типичных ошибок файла robots.txt

- robots.txt отсутствует

- в robots.txt сайт закрыт от индексирования (Disallow: /)

- в файле присутствуют лишь самые основные директивы, нет детальной проработки файла

- в файле не закрыты от индексирования страницы с UTM-метками и идентификаторами сессий

- в файле указаны только директивы

Allow: *.css

Allow: *.js

Allow: *.png

Allow: *.jpg

Allow: *.gif

при этом файлы css, js, png, jpg, gif закрыты другими директивами в ряде директорий - директива Host прописана несколько раз

- в Host не указан протокол https

- путь к Sitemap указан неверно, либо указан неверный протокол или зеркало сайта

P.S.

Если у вас есть дополнения к статье или вопросы, пишите ниже в комментариях.

Если у вас сайт на CMS WordPress, вам будет полезна статья «Как настроить правильный robots.txt для WordPress».

P.S.2

Полезное видео от Яндекса (Внимание! Некоторые рекомендации подходят только для Яндекса).

seogio.ru

Несколько слов о том, как работают роботы поисковых машин

Эта статья вовсе не является попыткой объяснить, как работают поисковые машины вообще (это know-how их производителей). Однако, по моему мнению, она поможет понять как можно управлять поведением поисковых роботов (wanderers, spiders, robots — программы, с помощью которых та или иная поисковая система обшаривает сеть и индексирует встречающиеся документы) и как правильно построить структуру сервера и содержащихся на нем документов, чтобы Ваш сервер легко и хорошо индексировался.

Первой причиной того, что я решился написать эту статью, явился случай, когда я исследовал файл логов доступа к моему серверу и обнаружил там следующие две строки:

lycosidae.lycos.com - - [01/Mar/1997:21:27:32 -0500] "GET /robots.txt HTTP/1.0" 404 - lycosidae.lycos.com - - [01/Mar/1997:21:27:39 -0500] "GET / HTTP/1.0" 200 3270

то есть Lycos обратился к моему серверу, на первый запрос получил, что файла /robots.txt нет, обнюхал первую страницу, и отвалил. Естественно, мне это не понравилось, и я начал выяснять что к чему.

Оказывается, все «умные» поисковые машины сначала обращаются к этому файлу, который должен присутствовать на каждом сервере. Этот файл описывает права доступа для поисковых роботов, причем существует возможность указать для различных роботов разные права. Для него существует стандарт под названием Standart for Robot Exclusion.

По мнению Луиса Монье (Louis Monier, Altavista), только 5% всех сайтов в настоящее время имеет не пустые файлы /robots.txt если вообще они (эти файлы) там существуют. Это подтверждается информацией, собранной при недавнем исследовании логов работы робота Lycos. Шарль Коллар (Charles P.Kollar, Lycos) пишет, что только 6% от всех запросов на предмет /robots.txt имеют код результата 200. Вот несколько причин, по которым это происходит:

- люди, которые устанавливают Веб-сервера, просто не знают ни об этом стандарте, ни о необходимости существования файла /robots.txt

- не обязательно человек, инсталлировавший Веб-сервер, занимается его наполнением, а тот, кто является вебмастером, не имеет должного контакта с администратором самой «железяки»

- это число отражает число сайтов, которые действительно нуждаются в исключении лишних запросов роботов, поскольку не на всех серверах имеется такой существенный трафик, при котором посещение сервера поисковым роботом, становится заметным для простых пользователей

Файл /robots.txt предназначен для указания всем поисковым роботам (spiders) индексировать информационные сервера так, как определено в этом файле, т.е. только те директории и файлы сервера, которые НЕ описаны в /robots.txt. Это файл должен содержать 0 или более записей, которые связаны с тем или иным роботом (что определяется значением поля agent_id), и указывают для каждого робота или для всех сразу что именно им НЕ НАДО индексировать. Тот, кто пишет файл /robots.txt, должен указать подстроку Product Token поля User-Agent, которую каждый робот выдает на HTTP-запрос индексируемого сервера. Например, нынешний робот Lycos на такой запрос выдает в качестве поля User-Agent: Lycos_Spider_(Rex)/1.0 libwww/3.1.

Если робот Lycos не нашел своего описания в /robots.txt — он поступает так, как считает нужным. Как только робот Lycos «увидел» в файле /robots.txt описание для себя — он поступает так, как ему предписано.

При создании файла /robots.txt следует учитывать еще один фактор — размер файла. Поскольку описывается каждый файл, который не следует индексировать, да еще для многих типов роботов отдельно, при большом количестве не подлежащих индексированию файлов размер /robots.txt становится слишком большим. В этом случае следует применять один или несколько следующих способов сокращения размера /robots.txt:

- указывать директорию, которую не следует индексировать, и, соответственно, не подлежащие индексированию файлы располагать именно в ней

- создавать структуру сервера с учетом упрощения описания исключений в /robots.txt

- указывать один способ индексирования для всех agent_id

- указывать маски для директорий и файлов

Общее описание формата записи.

[ # comment string NL ]* User-Agent: [ [ WS ]+ agent_id ]+ [ [ WS ]* # comment string ]? NL [ # comment string NL ]* Disallow: [ [ WS ]+ path_root ]* [ [ WS ]* # comment string ]? NL [ # comment string NL | Disallow: [ [ WS ]+ path_root ]* [ [ WS ]* # comment string ]? NL ]* [ NL ]+

Описание параметров, применяемых в записях /robots.txt

[…]+ Квадратные скобки со следующим за ними знаком + означают, что в качестве параметров должны быть указаны один или несколько терминов.

Например, после «User-Agent:» через пробел могут быть указаны один или несколько agent_id.

[…]* Квадратные скобки со следующим за ними знаком * означают, что в качестве параметров могут быть указаны ноль или несколько терминов.

Например, Вы можете писать или не писать комментарии.

[…]? Квадратные скобки со следующим за ними знаком ? означают, что в качестве параметров могут быть указаны ноль или один термин.

Например, после «User-Agent: agent_id» может быть написан комментарий.

..|.. означает или то, что до черты, или то, что после.

WS один из символов — пробел (011) или табуляция (040)

NL один из символов — конец строки (015) , возврат каретки (012) или оба этих символа (Enter)

User-Agent: ключевое слово (заглавные и прописные буквы роли не играют).

Параметрами являются agent_id поисковых роботов.

Disallow: ключевое слово (заглавные и прописные буквы роли не играют).

Параметрами являются полные пути к неиндексируемым файлам или директориям

# начало строки комментариев, comment string — собственно тело комментария.

agent_id любое количество символов, не включающих WS и NL, которые определяют agent_id различных поисковых роботов. Знак * определяет всех роботов сразу.

path_root любое количество символов, не включающих WS и NL, которые определяют файлы и директории, не подлежащие индексированию.

Каждая запись начинается со строки User-Agent, в которой описывается каким или какому поисковому роботу эта запись предназначается. Следующая строка: Disallow. Здесь описываются не подлежащие индексации пути и файлы. КАЖДАЯ запись ДОЛЖНА иметь как минимум эти две строки (lines). Все остальные строки являются опциями. Запись может содержать любое количество строк комментариев. Каждая строка комментария должна начинаться с символа # . Строки комментариев могут быть помещены в конец строк User-Agent и Disallow. Символ # в конце этих строк иногда добавляется для того, чтобы указать поисковому роботу, что длинная строка agent_id или path_root закончена. Если в строке User-Agent указано несколько agent_id, то условие path_root в строке Disallow будет выполнено для всех одинаково. Ограничений на длину строк User-Agent и Disallow нет. Если поисковый робот не обнаружил в файле /robots.txt своего agent_id, то он игнорирует /robots.txt.

Если не учитывать специфику работы каждого поискового робота, можно указать исключения для всех роботов сразу. Это достигается заданием строки User-Agent: *

Если поисковый робот обнаружит в файле /robots.txt несколько записей с удовлетворяющим его значением agent_id, то робот волен выбирать любую из них.

Каждый поисковый робот будет определять абсолютный URL для чтения с сервера с использованием записей /robots.txt. Заглавные и строчные символы в path_root ИМЕЮТ значение.

Пример 1:

User-Agent: * Disallow: / User-Agent: Lycos Disallow: /cgi-bin/ /tmp/

В примере 1 файл /robots.txt содержит две записи. Первая относится ко всем поисковым роботам и запрещает индексировать все файлы. Вторая относится к поисковому роботу Lycos и при индексировании им сервера запрещает директории /cgi-bin/ и /tmp/, а остальные — разрешает. Таким образом сервер будет проиндексирован только системой Lycos.

Пример 2

User-Agent: Copernicus Fred Disallow: User-Agent: * Rex Disallow: /t

В примере 2 файл /robots.txt содержит две записи. Первая разрешает поисковым роботам Copernicus и Fred индексировать весь сервер. Вторая — запрещает всем и осебенно роботу Rex индексировать такие директории и файлы, как /tmp/, /tea-time/, /top-cat.txt, /traverse.this и т.д. Это как раз случай задания маски для директорий и файлов.

Пример 3:

# This is for every spider! User-Agent: * # stay away from this Disallow: /spiders/not/here/ #and everything in it Disallow: # a little nothing Disallow: #This could be habit forming! # Don't comments make code much more readable!!!

В примере 3 — одна запись. Здесь всем роботам запрещается индексировать директорию /spiders/not/here/, включая такие пути и файлы как /spiders/not/here/really/, /spiders/not/here/yes/even/me.html. Однако сюда не входят /spiders/not/ или /spiders/not/her (в директории ‘/spiders/not/’).

Незаконченность стандарта (Standart for Robot Exclusion)

К сожалению, поскольку поисковые системы появились не так давно, стандарт для роботов находится в стадии разработки, доработки, ну и т.д. Это означает, что в будущем совсем необязательно поисковые машины будут им руководствоваться.

Увеличение трафика

Эта проблема не слишком актуальна для российского сектора Internet, поскольку не так уж много в России серверов с таким серьезным трафиком, что посещение их поисковым роботом будет мешать обычным пользователям. Собственно, файл /robots.txt для того и предназначен, чтобы ограничивать действия роботов.

Не все поисковые роботы используют /robots.txt

На сегодняшний день этот файл обязательно запрашивается поисковыми роботами только таких систем как Altavista, Excite, Infoseek, Lycos, OpenText и WebCrawler.

Начальный проект, который был создан в результате соглашений между программистами некоторого числа коммерческих индексирующих организаций (Excite, Infoseek, Lycos, Opentext и WebCrawler) на недавнем собрании Distributing Indexing Workshop (W3C) , ниже.

На этом собрании обсуждалось использование мета-тагов HTML для управления поведением поисковых роботов, но окончательного соглашения достигнуто не было. Были определены следующие проблемы для обсуждения в будущем:

- Неопределенности в спецификации файла /robots.txt

- Точное определение использования мета-тагов HTML, или дополнительные поля в файле /robots.txt

- Информация «Please visit»

- Текущий контроль информации: интервал или максимум открытых соединений с сервером, при которых можно начинать индексировать сервер

Этот таг предназначен для пользователей, которые не могут контролировать файл /robots.txt на своих веб-сайтах. Таг позволяет задать поведение поискового робота для каждой HTML-страницы, однако при этом нельзя совсем избежать обращения робота к ней (как возможно указать в файле /robots.txt).

<META NAME="ROBOTS" CONTENT="robot_terms">

robot_terms — это разделенный запятыми список следующих ключевых слов (заглавные или строчные символы роли не играют): ALL, NONE, INDEX, NOINDEX, FOLLOW, NOFOLLOW.

NONE — говорит всем роботам игнорировать эту страницу при индексации (эквивалентно одновременному использованию ключевых слов NOINDEX, NOFOLLOW).

ALL — разрешает индексировать эту страницу и все ссылки из нее (эквивалентно одновременному использованию ключевых слов INDEX, FOLLOW).

INDEX — разрешает индексировать эту страницу

NOINDEX — неразрешает индексировать эту страницу

FOLLOW — разрешает индексировать все ссылки из этой страницы

NOFOLLOW — неразрешает индексировать ссылки из этой страницы

Если этот мета-таг пропущен или не указаны robot_terms, то по умолчанию поисковый робот поступает как если бы были указаны robot_terms= INDEX, FOLLOW (т.е. ALL). Если в CONTENT обнаружено ключевое слово ALL, то робот поступает соответственно, игнорируя возможно указанные другие ключевые слова.. Если в CONTENT имеются противоположные по смыслу ключевые слова, например, FOLLOW, NOFOLLOW, то робот поступает по своему усмотрению (в этом случае FOLLOW).

Если robot_terms содержит только NOINDEX, то ссылки с этой страницы не индексируются. Если robot_terms содержит только NOFOLLOW, то страница индексируется, а ссылки, соответственно, игнорируются.

<META NAME="KEYWORDS" CONTENT="phrases">

phrases — разделенный запятыми список слов или словосочетаний (заглавные и строчные символы роли не играют), которые помогают индексировать страницу (т.е. отражают содержание страницы). Грубо говоря, это те слова, в ответ на которые поисковая система выдаст этот документ.

<META NAME="DESCRIPTION" CONTENT="text">

text — тот текст, который будет выводиться в суммарном ответе на запрос пользователя к поисковой системе. Сей текст не должен содержать тагов разметки и логичнее всего вписать в него смысл данного документа на пару-тройку строк.

Некоторые коммерческие поисковые роботы уже используют мета-таги, позволяющие осуществлять «связь» между роботом и вебмастером. Altavista использует KEYWORDS мета-таг, а Infoseek использует KEYWORDS и DESCRIPTION мета-таги.

Вебмастер может «сказать» поисковому роботу или файлу bookmark пользователя, что содержимое того или иного файла будет изменяться. В этом случае робот не будет сохранять URL, а броузер пользователя внесет или не внесет это файл в bookmark. Пока эта информация описывается только в файле /robots.txt, пользователь не будет знать о том, что эта страница будет изменяться.

Мета-таг DOCUMENT-STATE может быть полезен для этого. По умолчанию, этот мета-таг принимается с CONTENT=STATIC.

<META NAME="DOCUMENT-STATE" CONTENT="STATIC"> <META NAME="DOCUMENT-STATE" CONTENT="DYNAMIC">

Генерируемые страницы — страницы, порождаемые действием CGI-скриптов. Их наверняка не следует индексировать, поскольку если попробовать провалиться в них из поисковой системы, будет выдана ошибка. Что касается зеркал, то негоже, когда выдаются две разные ссылки на разные сервера, но с одним и тем же содержимым. Чтобы этого избежать, следует использовать мета-таг URL с указанием абсолютного URL этого документа (в случае зеркал — на соответствующую страницу главного сервера).

<META NAME="URL" CONTENT="absolute_url">

- Charles P.Kollar, John R.R. Leavitt, Michael Mauldin, Robot Exclusion Standard Revisited, www.kollar.com/robots.html

- Martijn Koster, Standard for robot exclusion, info.webcrawler.com/mak/projects/robots/robots.html

www.internet-technologies.ru