Сложные SQL-запросы

Сложные SQL-запросы Пожалуйста, включите JavaScript в браузере!Сложные SQL-запросы

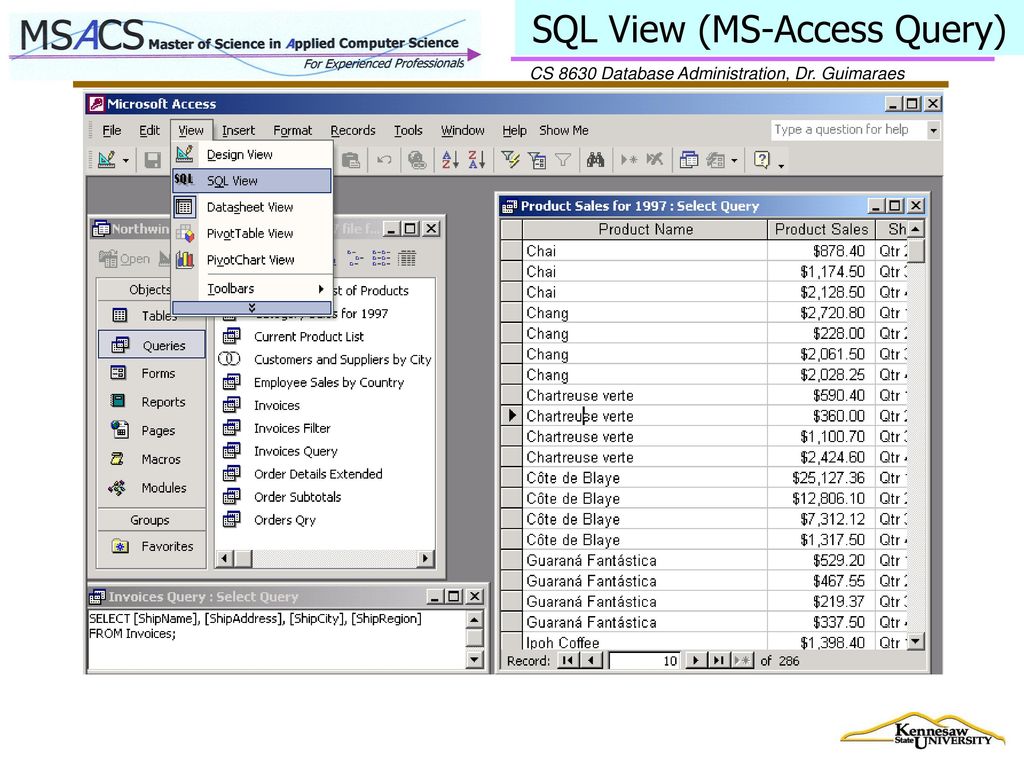

С помощью строки поиска вы можете вручную создавать SQL-запросы любой сложности для фильтрации событий.

Чтобы сформировать SQL-запрос вручную:

- Перейдите в раздел События веб-интерфейса KUMA.

Откроется форма с полем ввода.

- Введите SQL-запрос в поле ввода.

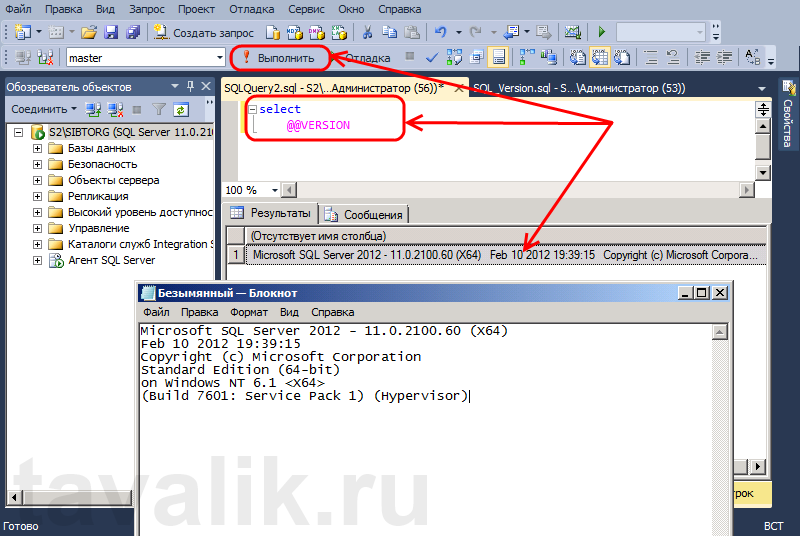

- Нажмите на кнопку .

Отобразится таблица событий, соответствующих условиям вашего запроса. При необходимости вы можете отфильтровать события по периоду.

Поддерживаемые функции и операторы

SELECT– поля событий, которые следует возвращать.Для

SELECTв программе поддержаны следующие функции и операторы:- Функции агрегации:

count, avg, max, min, sum. - Арифметические операторы:

+, -, *, /, <, >, =, !=, >=, <=.Вы можете комбинировать эти функции и операторы.

Если вы используете в запросе функции агрегации, настройка отображения таблицы событий, сортировка событий по возрастанию и убыванию, получение статистики, а также ретроспективная проверка недоступны.

- Функции агрегации:

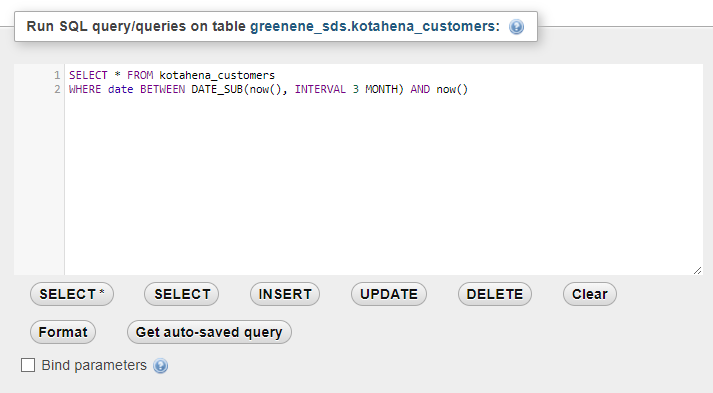

FROM– источник данных.При создании запроса в качестве источника данных вам нужно указать значение events.

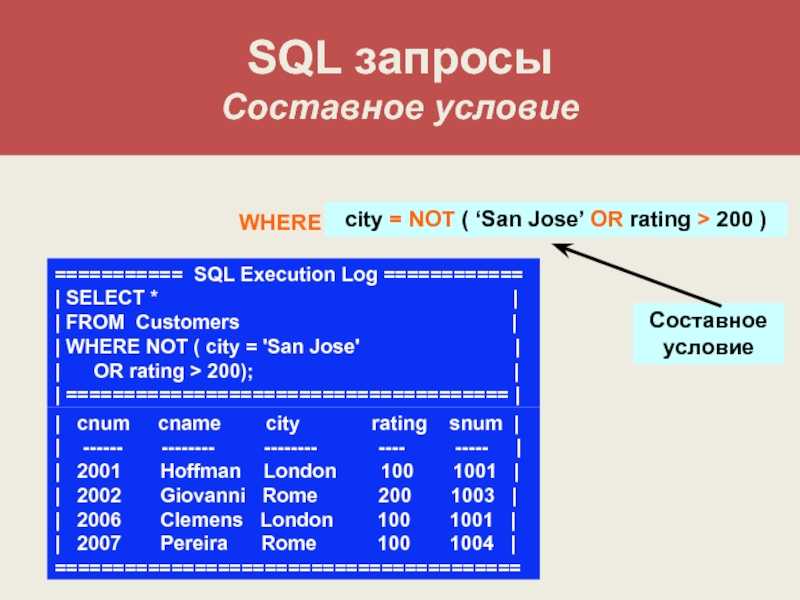

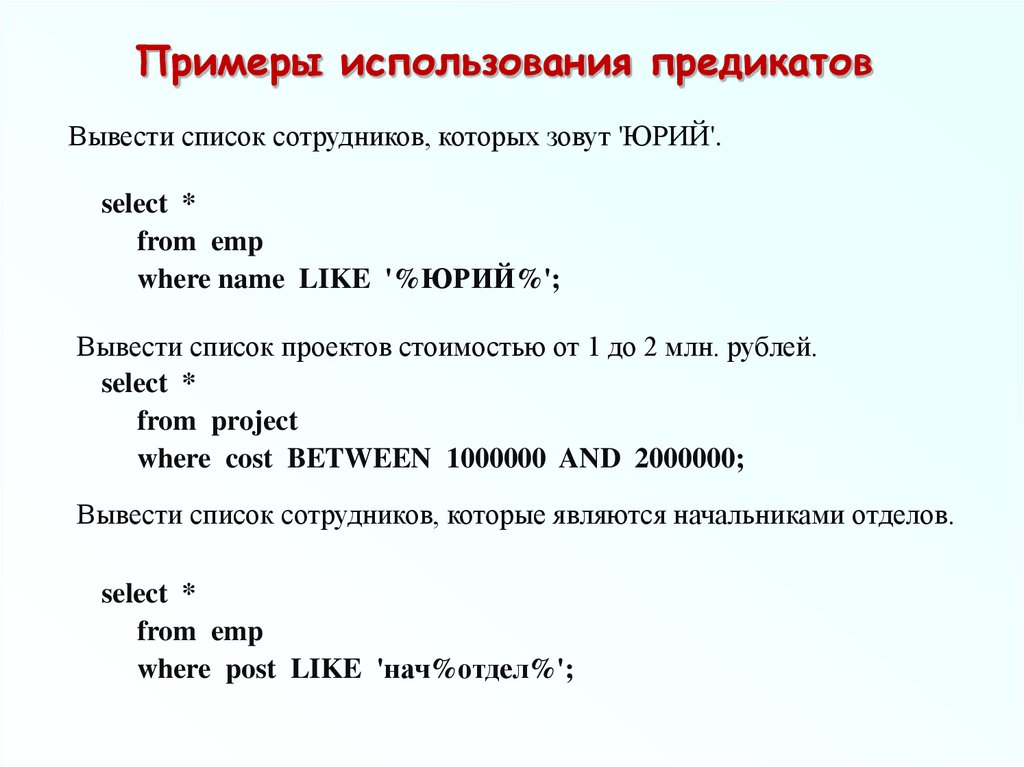

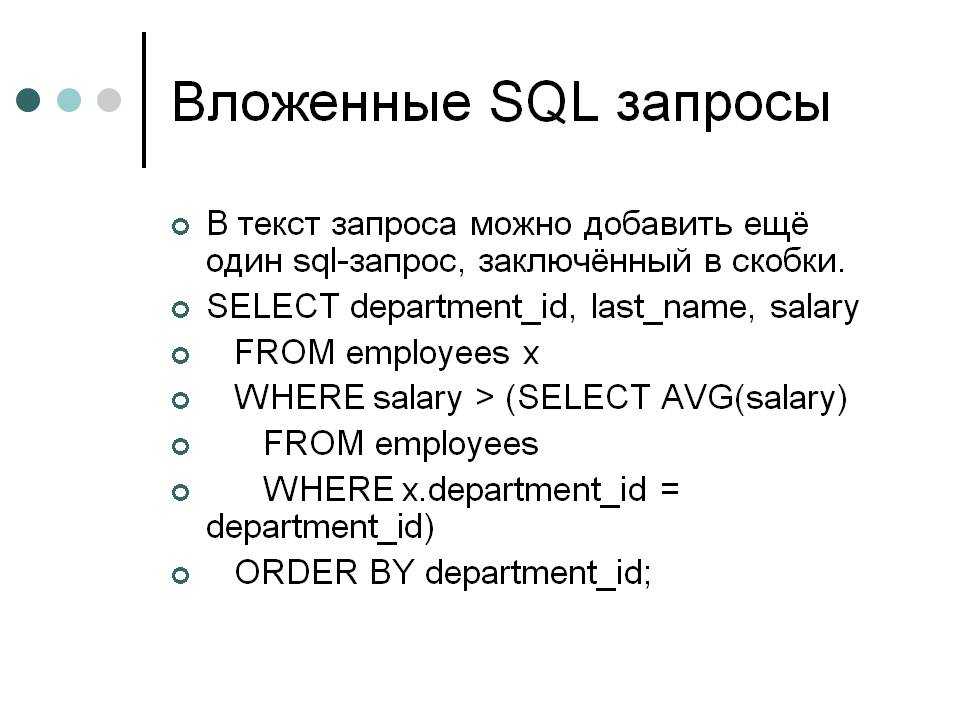

WHERE– условия фильтрации событий.AND, OR, NOT, =, !=, >, >=, <, <=INBETWEENLIKEILIKEinSubnetmatch(в запросах используется синтаксис регулярных выражений re2)

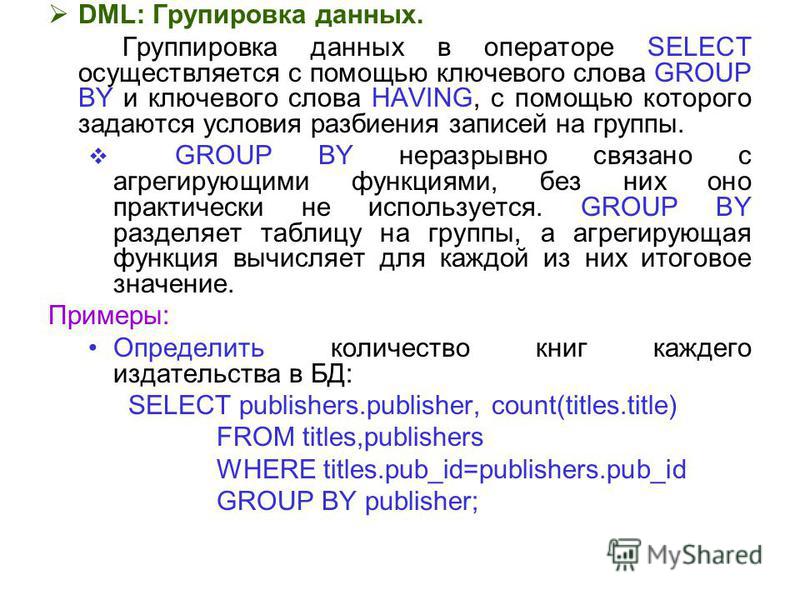

GROUP BY– поля событий или псевдонимы, по которым следует группировать возвращаемые данные.Если вы используете в запросе группировку данных, настройка отображения таблицы событий, сортировка событий по возрастанию и убыванию, получение статистики, а также ретроспективная проверка недоступны.

ORDER BY– столбцы, по которым следует сортировать возвращаемые данные.Возможные значения:

DESC– по убыванию.ASC– по возрастанию.

OFFSET– пропуск указанного количества строк перед выводом результатов запроса.LIMIT– количество отображаемых в таблице строк.Значение по умолчанию – 250.

Если при фильтрации событий по пользовательскому периоду количество строк в результатах поиска превышает заданное значение, вы можете отобразить в таблице дополнительные строки, нажав на кнопку Показать больше записей. Кнопка не отображается при фильтрации событий по стандартному периоду.

Примеры запросов:

SELECT * FROM `events` WHERE Type IN ('Base', 'Audit') ORDER BY Timestamp DESC LIMIT 250Все события таблицы events с типом Base и Audit, отсортированные по столбцу Timestamp в порядке убывания.

Количество отображаемых в таблице строк – 250.

Количество отображаемых в таблице строк – 250.SELECT * FROM `events` WHERE BytesIn BETWEEN 1000 AND 2000 ORDER BY Timestamp ASC LIMIT 250Все события таблицы events, для которых в поле BytesIn значение полученного трафика находится в диапазоне от 1000 до 2000 байт, отсортированные по столбцу Timestamp в порядке возрастания. Количество отображаемых в таблице строк – 250.

SELECT * FROM `events` WHERE Message LIKE '%ssh:%' ORDER BY Timestamp DESC LIMIT 250Все события таблицы events, которые в поле Message содержат данные, соответствующие заданному шаблону

%ssh:%в нижнем регистре, и отсортированы по столбцу Timestamp в порядке убывания. Количество отображаемых в таблице строк – 250.SELECT * FROM `events` WHERE inSubnet(DeviceAddress, '10.0.0.1/24') ORDER BY Timestamp DESC LIMIT 250Все события таблицы events для хостов, которые входят в подсеть 10.0.0.1/24, отсортированные по столбцу Timestamp в порядке убывания.

Количество отображаемых в таблице строк – 250.

Количество отображаемых в таблице строк – 250.SELECT * FROM `events` WHERE match(Message, 'ssh.*') ORDER BY Timestamp DESC LIMIT 250Все события таблицы events, которые в поле Message содержат текст, соответствующий шаблону

ssh.*, и отсортированы по столбцу Timestamp в порядке убывания. Количество отображаемых в таблице строк – 250.SELECT max(BytesOut) / 1024 FROM `events`Максимальный размер исходящего трафика (КБ) за выбранный период времени.

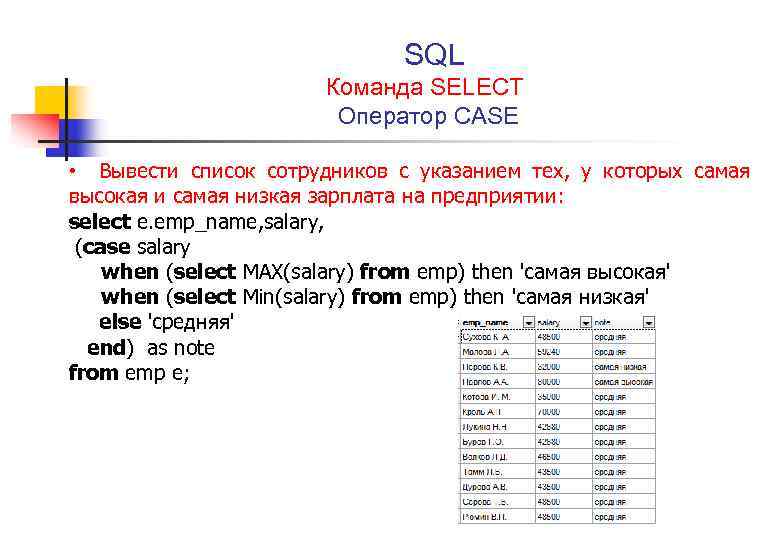

SELECT count(ID) AS "Count", SourcePort AS "Port" FROM `events` GROUP BY SourcePort ORDER BY Port ASC LIMIT 250Количество событий и номер порта. События сгруппированы по номеру порта и отсортированы по столбцу Port в порядке возрастания. Количество отображаемых в таблице строк – 250.

Столбцу ID в таблице событий присвоено имя Count, столбцу SourcePort присвоено имя Port.

Если вы хотите указать в запросе специальный символ, вам требуется экранировать его, поместив перед ним обратную косую черту (\).

Пример:

Все события таблицы events, которые в поле Message содержат текст, соответствующий шаблону |

При переключении на конструктор параметры запроса, введенного вручную в строке поиска, не переносятся в конструктор: вам требуется создать запрос заново. При этом запрос, созданный в конструкторе, не перезаписывает запрос, введенный в строке поиска, пока вы не нажмете на кнопку Применить в окне конструктора.

После обновления KUMA до версии 1.6 при фильтрации событий с помощью SQL-запроса, содержащего условие inSubnet, может возвращаться ошибка Code: 441. DB::Exception: Invalid IPv4 value.

<cast_ipv4_ipv6_default_on_conversion_error>true</cast_ipv4_ipv6_default_on_conversion_error>.Подробнее об SQL см. в справке ClickHouse.

В начало

Запуск запросов: режим «только для чтения», планировщик, SQL-журнал

Консоль запросов

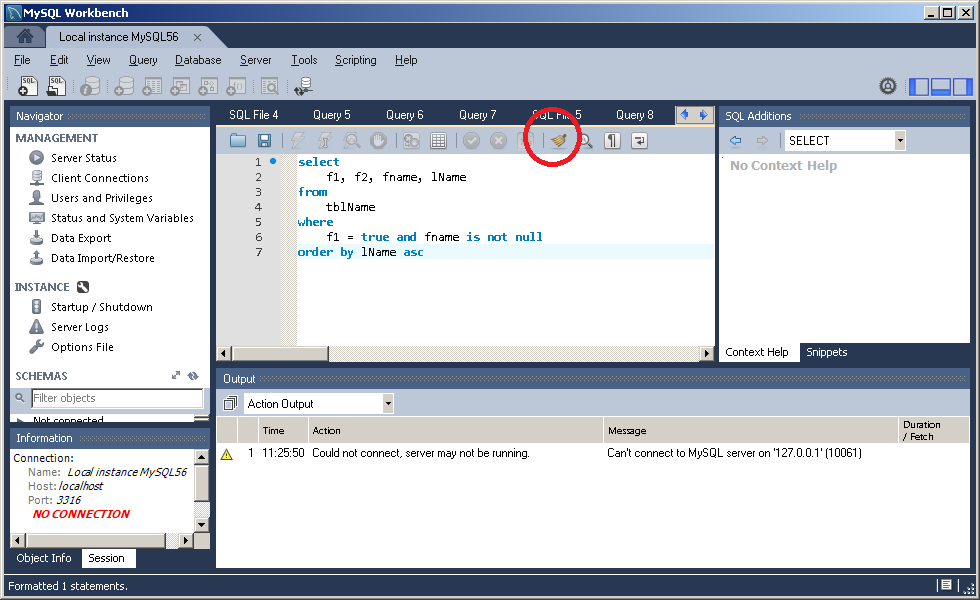

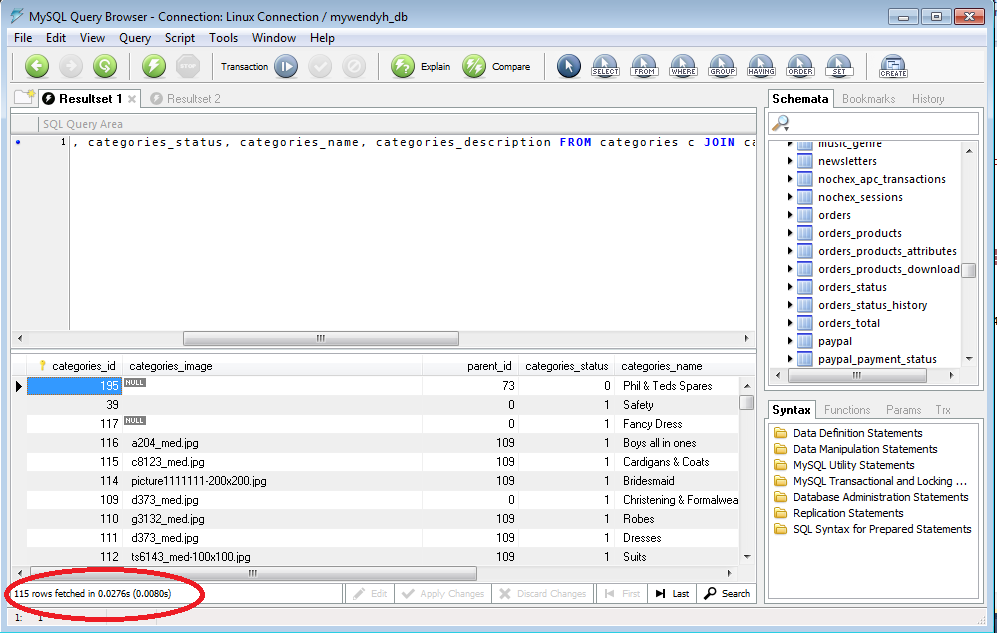

По опыту знаем, что консоль запросов — лучшее место для повседневной работы с SQL. Для каждого источника данных предусмотрена собственная консоль по умолчанию. Чтобы ее открыть, выберите Open Console в контекстном меню или нажмите F4.

Здесь вы можете написать SQL-запрос, запустить его и получить результат. Все просто.

Если вы вдруг захотите создать другую консоль для источника данных, сделайте это в меню: Context menu → New → Console.

Переключатель схем

Создавайте столько консолей запросов, сколько вам нужно, и запускайте запросы одновременно. У каждой консоли есть переключатель схем и баз данных. Если вы работаете с PostgreSQL , составьте здесь search_path.

Запуск выделенного фрагмента

Выделите фрагмент кода и запустите только его. Выбранный запрос посылается в базу «как есть», без дополнительной обработки jdbc-драйвером. Это может быть полезно, когда по той или иной причине IDE думает, что в запросе есть ошибка.

Настройки выполнения

Выполнять запрос можно несколькими способами. Поведение запуска запросов под кареткой можно настраивать. Возможные варианты того, что можно запустить: подзапрос, весь запрос, все после каретки, весь скрипт или предложить выбор.

Можно настроить три варианта поведения для запуска (Execute). По умолчанию, сочетание клавиш есть только у первого, но вы можете выбрать их и для остальных. Например, настроим два поведения: «показать выбор» и «запустить весь скрипт».

На видео пример, как сначала выполнено одно действие, затем второе.

Режим «только для чтения»

Режим «только для чтения» включайте в настройках источника данных: флажок Read-Only

На уровне jdbc-драйвера в режиме «для чтения» запросы, которые вносят изменения, нельзя запускать в базах: MySQL, PostgreSQL, AWS Redshift, h3 и Derby. В других СУБД этот режим не работает.

Поэтому мы сделали свой режим «только для чтения». Он включается одновременно с режимом на уровне драйвера. IDE понимает, какие запросы приведут к изменениям, и подчеркивает их. При запуске запроса DataGrip покажет предупреждение. Такой запрос можно запустить, нажав Execute на всплывающей панели, если вы точно уверены в том, что делаете.

DataGrip также индексирует все исходники функций и процедур и строит внутри дерево вызовов.

Контроль транзакций

Выберите контроль транзакций, который больше подходит вашей работе. Эта настройка есть в свойствах источника данных. В автоматическим режиме (флажок Auto) вам не надо каждый раз фиксировать транзакцию, а вот в ручном режиме (Manual), очевидно, надо.

Быстрый просмотр результата

Результаты запроса или выражения можно посмотреть во всплывающем окне. В других IDE на платформе IntelliJ Ctrl+Alt+F8 показывает результат вычисления выражения. В DataGrip то же самое работает для отображения результатов запуска. Если нажать эту комбинацию когда курсор на столбце, вы увидите ожидаемые значения этого столбца в результатах запроса. Та же самая операция на любом ключевом слове запроса покажет всплывающее окно с результатом. Клик мышкой при зажатом Alt работает так же.

История запущенных запросов

На панели инструментов каждой консоли есть такая кнопка: . Нажмите ее, чтобы увидеть историю всех запросов, выполненных в этом источнике данных из DataGrip. Еще здесь работает быстрый поиск!

Не забудьте и о локальной истории каждого файла.

Полный SQL-журнал

Буквально все запросы, которые запускает DataGrip, записываются в текстовый файл. Чтобы открыть его, используйте меню Help | Show SQL log.

Запуск хранимых процедур

DataGrip умеет генерировать код для запуска процедур. Укажите значения для параметров и нажмите OK.

Когда процедура открыта в редакторе, вы можете ее запустить, нажав Run на панели инструментов. Или используйте контекстное меню и выберите пункт Execute…

Небезопасные запросы

DataGrip предупредит, если вы собираетесь запустить запросы DELETE и UPDATE без предложения WHERE.

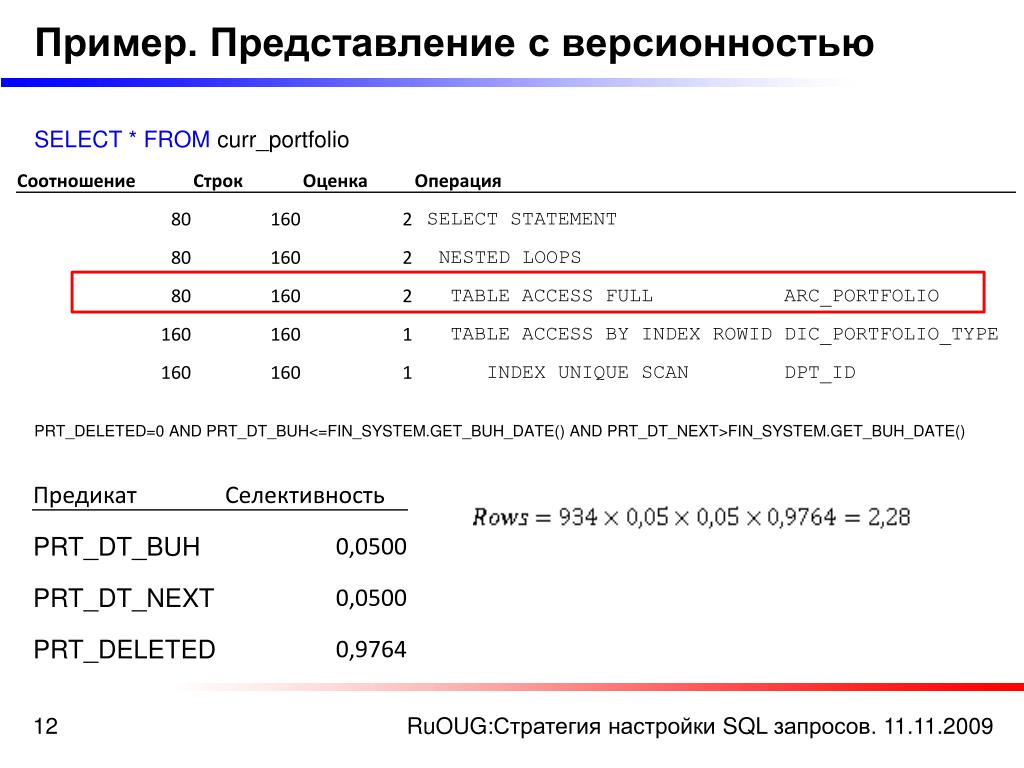

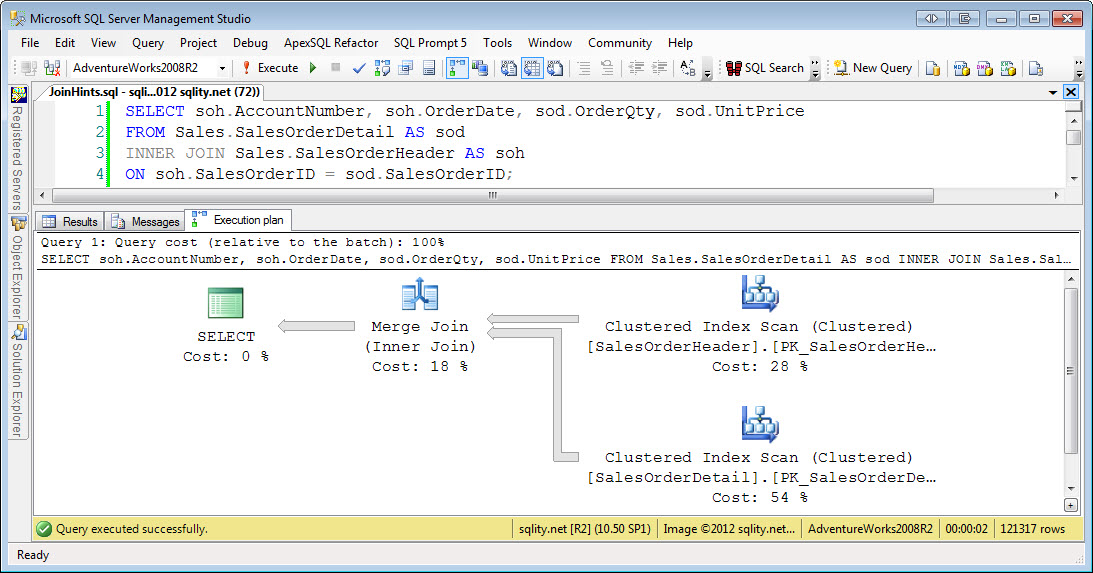

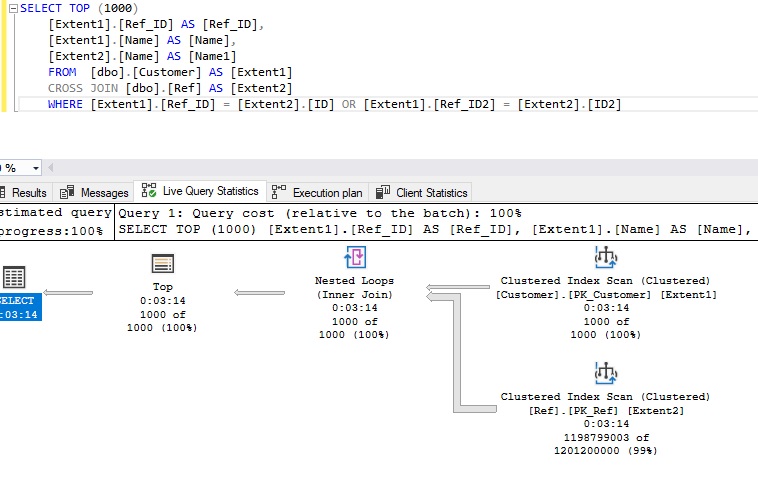

Планировщик запросов

План запросов покажет, как база данных собирается выполнить ваш запрос. Это помогает в оптимизации.

Это помогает в оптимизации.

План запросов может быть представлен в виде дерева или диаграммы.

Запросы с параметрами

В запросе могут быть параметры. DataGrip умеет запускать такие запросы.

Описать синтаксис параметров можно в Settings/Preferences → Database → User Parameters. Регулярные выражения для их описания подсвечиваются, а еще для каждого вида параметров можно указать SQL-диалект.

Структурный вид

Каждую консоль или файл можно открыть в структурном виде: в окне появится список запросов. Чтобы открыть структурный вид, используйте сочетание клавиш Ctrl+F12.

Результат запроса

Результат запроса

В DataGrip данные в результате простого запроса можно изменять. Используйте все возможности редактора данных: добавляйте, удаляйте строки, выбирайте режим контроля транзакций.

Сравнение результатов

Два результата можно сравнить, используя инструмент поиска различий. DataGrip подсветит те строчки, которые не являются общими для двух результатов. Параметр Tolerance используется для того, чтобы указать, сколько колонок могут иметь разные значения, чтобы строчки все равно считались одинаковыми. Из сравнения можно исключить любой столбец.

DataGrip подсветит те строчки, которые не являются общими для двух результатов. Параметр Tolerance используется для того, чтобы указать, сколько колонок могут иметь разные значения, чтобы строчки все равно считались одинаковыми. Из сравнения можно исключить любой столбец.

Нажмите кнопку сравнения на панели инструментов и выберите результат запроса, с которым нужно сравнить текущий результат.

Имена вкладок

Вы сами можете называть вкладки результатов: напишите имя в комментарии перед запросом.

Если вам не нравится, что любой предшествующий комментарий становится именем, укажите слово, после которого будет идти строка для заголовка. Это делается в соответствующих настройках: поле Prefix.

Быстрое изменение размера страницы

Меняйте размер страницы в редакторе данных, не заходя в настройки.

SQL-запросы к данным без серверов и СУБД с помощью Amazon S3 Select

by AWS Central EurAsia & Russia Team | on | in Amazon API Gateway, Amazon Simple Storage Service (S3), AWS CloudFormation, AWS Lambda, S3 Select, Storage | Permalink | ShareОригинал статьи: ссылка (David Green, Principal Serverless Solutions Architect и Mustafa Rahimi, Enterprise Solutions Architect)

Как AWS Solution Architect, мы ежедневно сталкиваемся с разными заказчиками и сценариями использования облачных технологий. Однако у многих из них похожие запросы: клиенты хотят уменьшить издержки на управление серверами, а также снизить сложность развертывания и поддержки инфраструктуры. И это понятно, они сфокусированы на эффективности своего бизнеса.

Однако у многих из них похожие запросы: клиенты хотят уменьшить издержки на управление серверами, а также снизить сложность развертывания и поддержки инфраструктуры. И это понятно, они сфокусированы на эффективности своего бизнеса.

У большинства заказчиков рано или поздно встает задача поиска среди большого объема данных, и это требуется сделать простым решением, без систем влекущих за собой высокие издержки. В этой статье мы рассмотрим использование SQL-запросов для работы с данными в CSV, JSON или Apache Parquet форматах, загруженными на Amazon Simple Storage Service (Amazon S3). Раньше, для того чтобы делать запросы к данным, необходимо было сначала загрузить их в какую-либо базу данных (СУБД). Мы же обойдемся без этого и, вместо развертывания баз данных и сопутствующих приложений, воспользуемся возможностью S3 под названием S3 Select. Мы продемонстрируем такой подход на примере поиска по телефонной книге, хранящийся в CSV файле. Полный код примера доступен на GitHub.

Amazon S3 используется для хранения любого объема данных без необходимости резервирования серверов и управления инфраструктурой. Amazon S3 Select и Amazon S3 Glacier Select позволяют напрямую выполнять SQL-запросы к CSV, JSON и Apache Parquet файлам, лежащим на S3 и Amazon S3 Glacier. При использовании S3 Select вы просто загружаете данные на S3, и выполняете SQL-запросы для фильтрации содержимого S3 объектов, получая на выходе нужные вам результаты. Запрашивая только необходимое подмножество хранящейся информации, вы уменьшаете объем передаваемых от Amazon S3 данных, что также уменьшает время и стоимость передачи. А уменьшение сложности, достигаемое благодаря такому решению, положительно влияет на скорость разработки.

S3 Select поддерживает сжатие CSV и JSON объектов с помощью GZIP и BZIP2, а также шифрование на стороне сервера. Вы можете выполнять SQL-запросы с помощью AWS SDK для поддерживаемых языков программирования, SELECT Object Content REST API, инструментов командной строки AWS Command Line Interface (AWS CLI), а также с помощью web консоли AWS Management Console.

Используемые AWS сервисы

Пример приложения для поиска в телефонной книге использует следующие сервисы:

- Amazon S3 – объектное хранилище, обеспечивающее высокую доступность и производительность, фактически неограниченное масштабирование и, конечно, высокий уровень безопасности.

- S3 Select – сервис, позволяющий получать подмножество данных из S3-объектов (файлов), выполняя простые SQL-запросы.

Кроме S3 и S3 Select наш пример приложения поиска в телефонной книге использует и другие сервисы:

- Amazon API Gateway – полностью управляемый (managed) сервис, позволяющий легко создавать, управлять, поддерживать и производить мониторинг защищенных API. Amazon API Gateway часто используют в serverless приложениях, и в нашем примере он используется для взаимодействия с AWS Lambda.

- AWS Lambda позволяет запускать код без развертывания и управления серверами. В нашем примере S3 Select запросы выполняются в AWS Lambda.

- AWS CloudFormation предоставляет язык для декларативного моделирования и развертывания AWS (а также сторонних) ресурсов, в облаке. CloudFormation используется в нашем примере для организации развертывания ресурсов, необходимых для примера.

Код проекта

Полный код примера приложения для поиска в телефонной книге доступен в GitHub репозитории AWS-Samples. Работа Amazon S3 Select, используемого в примере, описывается далее.

Начало работы, загрузка данных

Так как S3 Select работает напрямую с данными, хранящимися на S3, все, что вам нужно для начала работы — это AWS аккаунт и S3 бакет.

Войдите в существующий аккаунт или создайте новый. После того, как вы вошли в аккаунт, создайте S3 бакет, который будет использоваться для тестирования работы S3 Select.

Данные, которые мы будем использовать, представляют собой простой CSV файл, содержащий Имя, Номер Телефона, Город и Должность тестовых пользователей. Файл доступен в GitHub репозитории. Содержимое файла представлено далее, вы можете его дополнять и редактировать.

Файл доступен в GitHub репозитории. Содержимое файла представлено далее, вы можете его дополнять и редактировать.

Name,PhoneNumber,City,Occupation

Sam,(949) 555-6701,Irvine,Solutions Architect

Vinod,(949) 555-6702,Los Angeles,Solutions Architect

Jeff,(949) 555-6703,Seattle,AWS Evangelist

Jane,(949) 555-6704,Chicago,Developer

Sean,(949) 555-6705,Chicago,Developer

Mary,(949) 555-6706,Chicago,Developer

Kate,(949) 555-6707,Chicago,Developer

Загрузите файл sample_data.csv в ваш новый S3 бакет, созданный на предыдущем шаге.

Протестируем выполнение S3 Select запросов к файлу sample_data.csv с помощью Python скрипта. В примере используется имя бакета “s3select-demo”, вам необходимо заменить его на имя созданного вами бакета, куда был загружен файл.

Для быстрого тестирования скрипта мы развернем t3.micro EC2 инстанс с Amazon Linux 2 и установим на него boto3 – AWS SDK для Python. Проверьте, что IAM роль, назначенная EC2 инстансу, имеет доступ к созданному вами S3 бакету.

Выполняем S3 Select запросы из EC2 инстанса

После того, как вы создали и запустили EC2 инстанс, войдите на него по SSH как пользователь ec2-user, и запустите следующие команды для установки зависимостей и загрузки скриптов.

sudo yum update -y sudo yum install python3 -y python3 -m venv ~/s3select_example/env source ~/s3select_example/env/bin/activate pip install pip --upgrade pip install boto3 wget https://raw.githubusercontent.com/aws-samples/s3-select-phonebook-search/master/src/samples/jane.py wget https://raw.githubusercontent.com/aws-samples/s3-select-phonebook-search/master/src/samples/jane-gzip.py

Команды создают Python 3 environment и скачивают скрипт jane.py, содержимое которого представлено далее. Скрипт позволяет искать пользователей с именем Jane. Замените имя S3 бакета из скрипта, на имя созданного вами S3 бакета.

import boto3

s3 = boto3.client('s3')

resp = s3. select_object_content(

Bucket='s3select-demo',

Key='sample_data.csv',

ExpressionType='SQL',

Expression="SELECT * FROM s3object s where s.\"Name\" = 'Jane'",

InputSerialization = {'CSV': {"FileHeaderInfo": "Use"}, 'CompressionType': 'NONE'},

OutputSerialization = {'CSV': {}},

)

for event in resp['Payload']:

if 'Records' in event:

records = event['Records']['Payload'].decode('utf-8')

print(records)

elif 'Stats' in event:

statsDetails = event['Stats']['Details']

print("Stats details bytesScanned: ")

print(statsDetails['BytesScanned'])

print("Stats details bytesProcessed: ")

print(statsDetails['BytesProcessed'])

print("Stats details bytesReturned: ")

print(statsDetails['BytesReturned'])

select_object_content(

Bucket='s3select-demo',

Key='sample_data.csv',

ExpressionType='SQL',

Expression="SELECT * FROM s3object s where s.\"Name\" = 'Jane'",

InputSerialization = {'CSV': {"FileHeaderInfo": "Use"}, 'CompressionType': 'NONE'},

OutputSerialization = {'CSV': {}},

)

for event in resp['Payload']:

if 'Records' in event:

records = event['Records']['Payload'].decode('utf-8')

print(records)

elif 'Stats' in event:

statsDetails = event['Stats']['Details']

print("Stats details bytesScanned: ")

print(statsDetails['BytesScanned'])

print("Stats details bytesProcessed: ")

print(statsDetails['BytesProcessed'])

print("Stats details bytesReturned: ")

print(statsDetails['BytesReturned'])

Параметр OutputSerialization имеет значение CSV, поэтому результат будет возвращен в CSV формате. Также можно получать результат в формате JSON.

Также можно получать результат в формате JSON.

После изменения имени S3 бакета в файле jane.py, запустите скрипт, используя следующую команду

python jane.py

Результат выполнения скрипта показан далее:

Jane,(949) 555-6704,Chicago,Developer

Stats details bytesScanned:326Stats details bytesProcessed:326Stats details BytesReturned:38

Найдена одна запись для пользователя с именем Jane. Также скрипт выводит объем просканированных, обработанных и возвращенных S3 Select данных. В нашем случае размер фала sample_data.csv – 326 байт, S3 Select сканирует весь файл и возвращает одну строку размером 38 байт.

S3 Select и сжатые данные

Давайте запустим тот же самый тест ещё раз, но теперь со сжатыми данными. Сожмите CSV файл адресной книги с помощью gzip, назовите файл sample_data. csv.gz, и загрузите его на S3. Предварительно сжатый файл можно скачать с GitHub.

csv.gz, и загрузите его на S3. Предварительно сжатый файл можно скачать с GitHub.

Для работы с новым файлом нам потребуется модифицировать Python скрипт. В качестве значения параметра Key мы укажем имя сжатого файла, а также изменим InputSerialization CompressionType c None на GZIP. Новая версия скрипта, jane-gzip.py, доступна в репозитории, а также была скачена нами при настройке EC2 инстанса.

Мы поменяли имя S3 ключа (имя файла) на имя сжатого файла sample_data.csv.gz:

Key='sample_data.csv.gz',

Кроме того, мы поменяли строку с параметром InputSerialization чтобы указать значение GZIP для CompressionType.

InputSerialization = {'CSV': {"FileHeaderInfo": "Use"}, 'CompressionType': 'GZIP'},

Полный код файла jane-gzip.py представлен далее. Обратите внимание, что вам требуется заменить имя S3 бакета в скрипте на имя созданного вами бакета.

import boto3 s3 = boto3.client('s3') resp = s3.select_object_content( Bucket='s3select-demo', Key='sample_data.csv.gz', ExpressionType='SQL', Expression="SELECT * FROM s3object s where s.\"Name\" = 'Jane'", InputSerialization = {'CSV': {"FileHeaderInfo": "Use"}, 'CompressionType': 'GZIP'}, OutputSerialization = {'CSV': {}}, ) for event in resp['Payload']: if 'Records' in event: records = event['Records']['Payload'].decode('utf-8') print(records) elif 'Stats' in event: statsDetails = event['Stats']['Details'] print("Stats details bytesScanned: ") print(statsDetails['BytesScanned']) print("Stats details bytesProcessed: ") print(statsDetails['BytesProcessed']) print("Stats details bytesReturned: ") print(statsDetails['BytesReturned'])

Выполните скрипт следующей командой. Будет осуществлен S3 Select SQL-запрос к сжатым данным.

python jane-gzip.py

Результат выполнения скрипта представлен ниже.

Jane,(949) 555-6704,Chicago,Developer

Stats details bytesScanned:199Stats details bytesProcessed:326Stats details bytesReturned:38

Сравнение результатов запроса к сжатым и не сжатым данным

Использование сжатия позволяет сократить объем данных, хранящихся на S3. В случае нашего маленького CSV файла для теста, сжатие позволило сократить размер файла на 39%.

Таблица далее показывает разницу между запросами к не сжатому файлу sample_data.csv и сжатому sample_data.csv.gz.

| Размер файла (байт) | Просканировано байт | Обработано байт | Возвращено байт | Разница | |

| Не сжатые данные | 326 | 326 | 326 | 38 | N/A |

| Сжатые данные | 199 | 199 | 326 | 38 | ~39% меньше |

Преимущества сжатия данных становятся более существенны в случае больших файлов. Например, CSV файл размером 133,975,755 байт (~128 MB), состоящий из примерно миллиона строк, может быть уменьшен на ~ 60% до 50,308,104 байт (~50.3 MB) при использовании GZIP сжатия.

Например, CSV файл размером 133,975,755 байт (~128 MB), состоящий из примерно миллиона строк, может быть уменьшен на ~ 60% до 50,308,104 байт (~50.3 MB) при использовании GZIP сжатия.

| Размер файла (байт) | Просканировано байт | Обработано байт | Возвращено байт | Разница | |

| Не сжатые данные | 133,975,755 | 133,975,755 | 133,975,755 | 6 | N/A |

| Сжатые данные | 50,308,104 | 50,308,104 | 133,975,755 | 6 | ~60% меньше |

Запросы к архивам с S3 Glacier Select

Когда вы создаете SQL-запросы к архивным объектам, хранящимся в S3 Glacier, S3 Glacier Select выполняет запрос прямо в архиве, и возвращает результат в Amazon S3. С S3 Glacier Select вы можете запускать запросы к данным, находящимся в S3 Glacier, без необходимости восстанавливать эти данные на более “горячий” уровень, такой как S3 Standard.

С S3 Glacier Select вы можете запускать запросы к данным, находящимся в S3 Glacier, без необходимости восстанавливать эти данные на более “горячий” уровень, такой как S3 Standard.

Для выполнения SELECT запросов, S3 Glacier предлагает на выбор три уровня доступа к данным: expedited, standard, и bulk. Каждый из этих уровней имеет разное время доступа и цену, и вы можете выбрать один из них, в зависимости от того, как быстро вам нужно получить данные. Для архивов менее 250 мегабайт при использовании expedited уровня доступа, данные из S3 Glacier обычно доступны в течение 1-5 минут. В случае стандартного уровня это время увеличивается до 3-5 часов, для bulk оно составляет 5-12 часов.

Заключение

Мы показали, как S3 Select позволяет простым образом выполнять SQL-запросы напрямую к данным, хранящимся в Amazon S3 и Amazon S3 Glacier. S3 Select часто используется когда нужно обработать данные, которые были загружены на S3 програмно, или с помощью таких сервисов как AWS Transfer for SFTP (AWS SFTP). Например, вы можете загрузить данные на S3 c помощью AWS SFTP, а потом сделать выборку данных с помощью S3 Select. S3 Select запрос может быть выполнен из AWS Lambda функции, которая будет автоматически вызываться по событию загрузки нового файла на S3. Фильтрация данных с помощью S3 Select потенциально позволяет вам сэкономить вам время и деньги, по сравнению с другими способами фильтрации, когда данные сначала загружаются в базу.

Например, вы можете загрузить данные на S3 c помощью AWS SFTP, а потом сделать выборку данных с помощью S3 Select. S3 Select запрос может быть выполнен из AWS Lambda функции, которая будет автоматически вызываться по событию загрузки нового файла на S3. Фильтрация данных с помощью S3 Select потенциально позволяет вам сэкономить вам время и деньги, по сравнению с другими способами фильтрации, когда данные сначала загружаются в базу.

Для того чтобы лучше освоить работу с S3 Select и другими сервисами рекомендуем вам изучить GitHub репозиторий AWS Samples. Там вы можете найти полный пример приложения поиска в телефонной книге. Этот пример выполняет S3 Select запросы из AWS Lambda функции, выставленной наружу с помощью Amazon API Gateway.

Очистка аккаунта

В нашем примере мы создали S3 бакет и загрузили туда файлы sample_data.csv и sample_data.csv.gz. Мы осуществляли запросы из t3.micro EC2 инстанса. Для того чтобы избежать лишних трат, выключите EC2 инстанс и удалите его, выбрав terminate. А также удалите файлы из S3 бакета. Вы можете удалить и сам S3 бакет.

А также удалите файлы из S3 бакета. Вы можете удалить и сам S3 бакет.

Дополнительные ресурсы

- GitHub репозиторий, в котором находится пример приложения телефонной книги, а также CSV файл с примером данных

- AWS Samples GitHub, включающий в себя множество примеров использования самых разных AWS сервисов

- Документация по Amazon S3 Select

- Документация по поддерживаемым SQL командам в Amazon S3 Select

- AWS Transfer for SFTP

- Использование AWS Lambda с событиями Amazon S3

TAGS: Amazon API Gateway, Amazon S3 Select, Amazon Simple Storage Service (Amazon S3), AWS Cloud Storage, AWS CloudFormation, AWS Lambda

AWS Central EurAsia & Russia Team

SQL Server. Оптимизация запросов SQL. MS SQL Медленно работают запросы SELECT

Введение

В данном руководстве мы изложили некоторые рекомендации по оптимизации запросов SQL.

Оптимизация структуры таблиц SQL Server

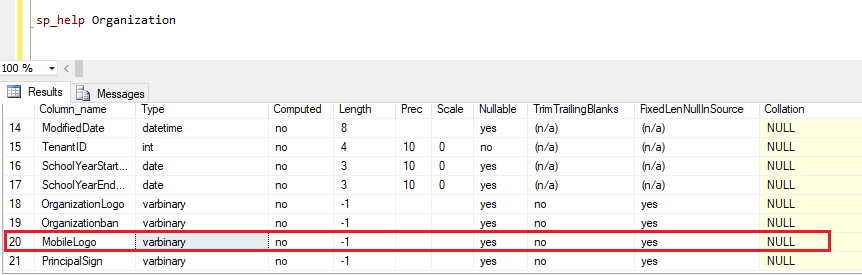

Разбивайте сложные таблицы на несколько, помните, чем больше в вашей таблице столбцов и тяжелых типов (nvarchar(max)), тем тяжелее по ней проход. Если некоторые данные не всегда используются в select с ней, выносите большие столбцы в отдельные таблицы и связывайте через FK

Выберите правильные типы данных. Всегда выбирайте самый маленький тип для данных, которые Вы должны хранить в столбце.

Если текстовые данные в столбце имеют разную длину, используйте тип данных NVARCHAR вместо NCHAR.

Не используйте NVARCHAR или NCHAR типы данных, если Вы не должны сохранить 16-разрядные символьные данные (UNICODE). Они требуют в два раза больше места, чем CHAR и VARCHAR, что повышает расходы времени на ввод-вывод (но если у вас кириллица, то без NVARCHAR не обойтись).

Если Вы должны хранить большие строки данных и их длина меньше чем 8,000 символов, используют тип данных NVARCHAR вместо TEXT. Текстовые поля требуют больше ресурсов для обработки и снижают производительность.

Текстовые поля требуют больше ресурсов для обработки и снижают производительность.

Любое поле, в котором должны быть только отличные от нуля значения, нужно объявлять как NOT NULL

Для любого поля, которое должно содержать уникальные значения, стоит указать модификатор UNIQUE

Хранение изображений в БД нежелательно. Храните в таблице путь к файлу (локальный путь или URL), а сам файл помещайте в файловую систему сервера.

Оптимизация запросов SELECT

Не читайте больше данных, чем надо. Не используйте *

Если ваше приложение позволяет пользователям выполнять запросы, но вы не можете отсечь лишние тысячи возвращаемых строк, используйте оператор TOP внутри инструкции SELECT.

Не возвращайте клиенту большее количество столбцов или строк, чем действительно необходимо (Не используй * в Select).

Как можно раньше отфильтруйте данные. Не нужно выполнять большой тяжелый подзапрос для всех строк таблицы. Сначала отфильтруйте нужные строки.

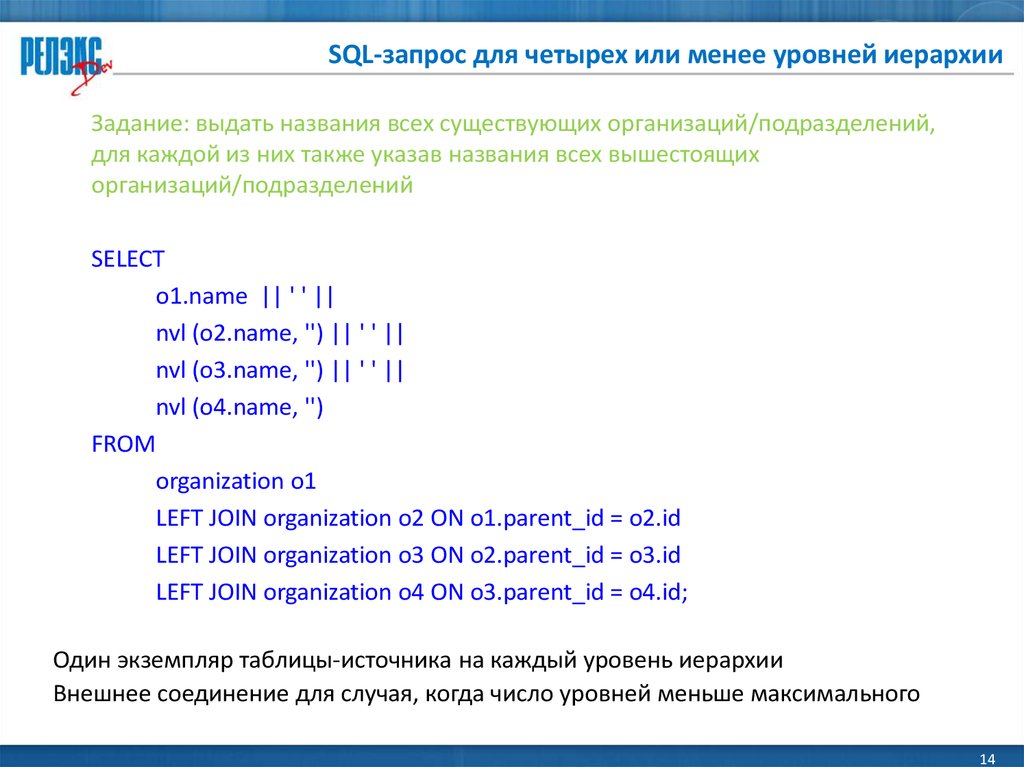

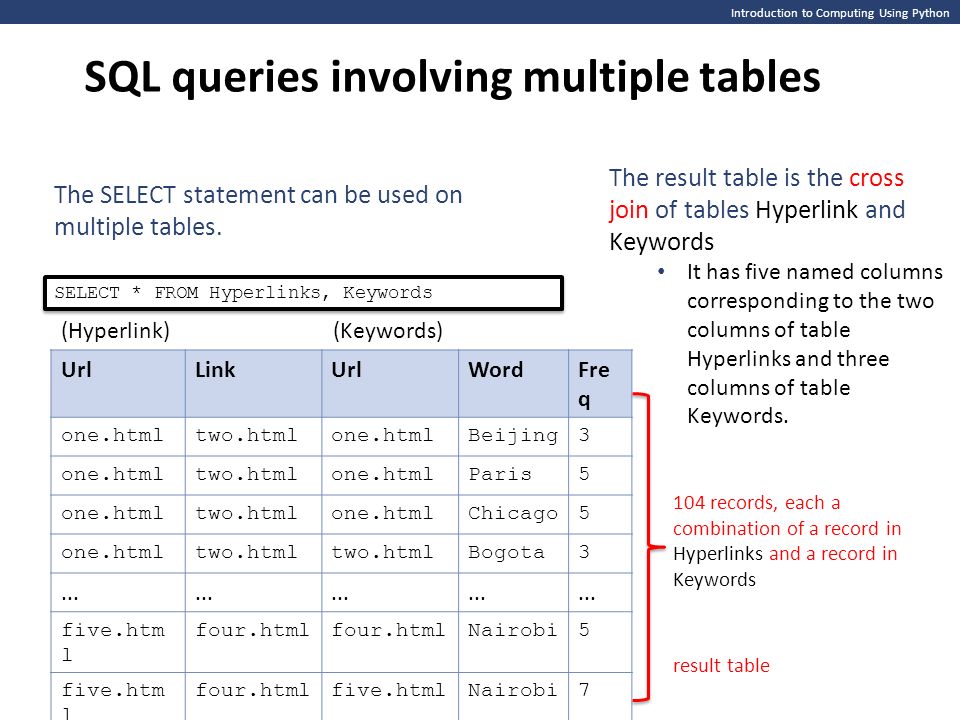

Корректно используйте JOIN

Если Вы имеете две или более таблиц, которые часто объединяются вместе, тогда столбцы, используемые для объединений должны иметь соответствующий индекс.

Для лучшей производительности, столбцы, используемые в объединениях должны иметь одинаковые типы данных. И если возможно, это должны быть числовые типы данных, вместо символьных типов.

Избегайте объединять таблицы по столбцам с малым числом уникальных значений. Если столбцы, используемые при объединениях, имеют мало уникальных значений, то SQL сервер будет просматривать всю таблицу, даже если по данному столбцу существует индекс. Для наилучшей производительности объединение таблиц должно производится по столбцам с уникальными индексами.

Если Вы должны регулярно объединять четыре или более таблиц, для получения recordset’а, попробуйте денормализовать таблицы так, чтобы число таблиц, участвующих в объединении уменьшилось. Часто, при добавлении одного или двух столбцов из одной таблицы в другую, объединения могут быть уменьшены.

Если вам нужно постоянно получать некоторые данные на лету (например, расчет бонусов клиента), попробуйте это поле хранить в отдельной колонке и обновлять по необходимости. В этом случае не нужно будет делать лишние join и подзапросы.

Тип JOIN используйте только тот, который вернет вам НЕОБХОДИМЫЕ данные без каких-либо дублей или лишней информации (или совсем отказаться от join). Т.е. не нужно получать всех пользователей таким образом:

select users.username from users inner join roles on users.roleID=roles.id

В этом случае вы получите много повторов пользователей

Сортировка в SELECT

Самой ресурсоемкой сортировкой является сортировка строк.

При объявлении полей всегда следует использовать размер, который нужен, и не выделять лишние байты про запас.

Если сортируете по дате создания, то попробуйте сортировать просто по id (первичный ключ с identity(1,1)).

Группирование в SELECT

Используйте как можно меньше колонок для группировки.

По возможности лучше использовать Where вместо Having, т.к. это уменьшает количество строк для группировки на ранней стадии.

Если требуется группирование, но без использования агрегатных функций (COUNT(), MIN(), MAX и т.д.), разумно использовать DISTINCT.

Не используйте множественные вложенные группировки через подзапросы.

Ограничить использование DISTINCT

Эта команда исключает повторяющиеся строки в результате. Команда требует повышенного времени обработки. Лучше всего комбинировать с LIMIT.

Ограничить использование SELECT для постоянно изменяющихся таблиц.

Возможно имеет смысл сохранять промежуточные агрегированные данные в какой-то другой таблице, которая обновляется менее часто чем таблица изменений (например, таблица логов).

Оптимизация WHERE в запросе SELECT

Если where состоит из условий, объединенных AND, они должны располагаться в порядке возрастания вероятности истинности данного условия. Чем быстрее мы получим false в одном из условий — тем меньше условий будет обработано и тем быстрее выполняется запрос.

Если where состоит из условий, объединенных OR, они должны располагаться в порядке уменьшения вероятности истинности данного условия. Чем быстрее мы получим true в одном из условий — тем меньше условий будет обработано и тем быстрее выполняется запрос.

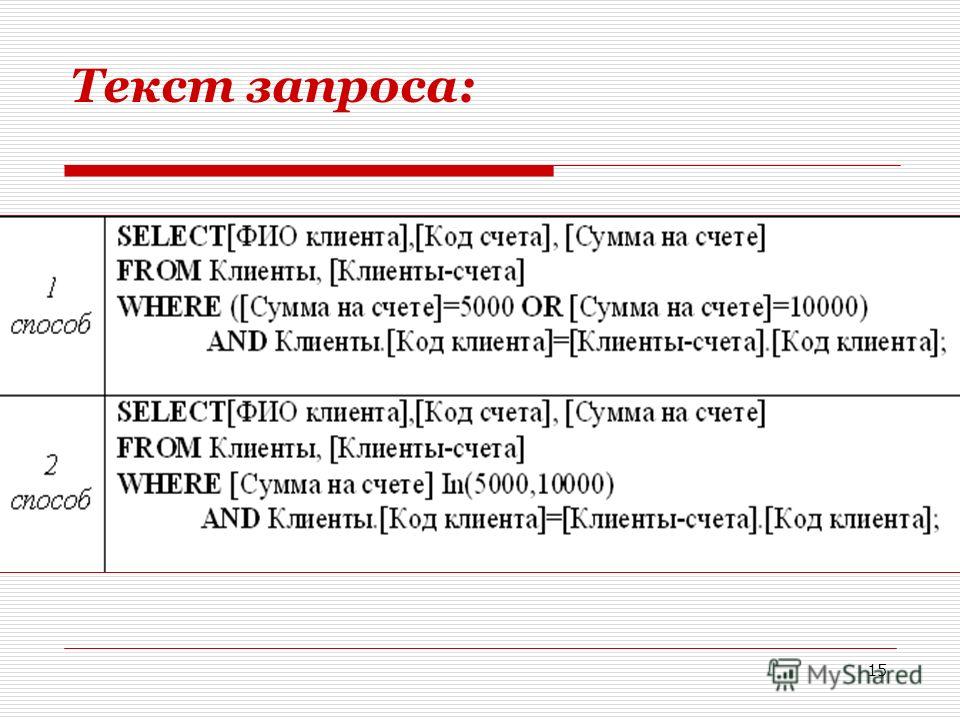

Исопльзуйте IN вместо OR. Операция IN работает гораздо быстрее, чем серия OR. Запрос «… WHERE column1 = 5 OR column1 = 6» медленнее чем «…WHERE column1 IN (5, 6)».

Используйте Exists вместо Count >0 в подзапросах. Используйте where exists (select id from t1 where id = t.id) вместо where count(select id from t1 where id=t.id) > 0

LIKE. Эту операцию следует использовать только при крайней необходимости, потому что лучше и быстрее использовать поиск, основанный на full-text индексах.

Советы по оптимизации хранимых процедур и SQL пакетов

Инкапсулируйте ваш код в хранимых процедурах

Для обработки данных используйте хранимые SQL процедуры.

Когда хранимая процедура выполняется в первый раз (и у нее не определена опция WITH RECOMPILE), она оптимизируется, для нее создается план выполнения запроса, который кешируется SQL сервером. Если та же самая хранимая процедура вызывается снова, она будет использовать кешированный план выполнения запроса, что экономит время и увеличивает производительность.

Если та же самая хранимая процедура вызывается снова, она будет использовать кешированный план выполнения запроса, что экономит время и увеличивает производительность.

Всегда включайте в ваши хранимые процедуры инструкцию «SET NOCOUNT ON». Если Вы не включите эту инструкцию, тогда каждый раз при выполнении запроса SQL сервер отправит ответ клиенту, указывающему число строк, на которые воздействует запрос.

Избегайте использования курсоров

По возможности выбирайте быстрый forward-only курсор

При использовании серверного курсора, старайтесь использовать как можно меньший рекордсет. Для этого выбирайте только те столбцы и строки, которые необходимы клиенту для решения его текущей задачи.

Когда Вы закончили использовать курсор, как можно раньше не только ЗАКРОЙТЕ (CLOSE) его, но и ОСВОБОДИТЕ (DEALLOCATE).

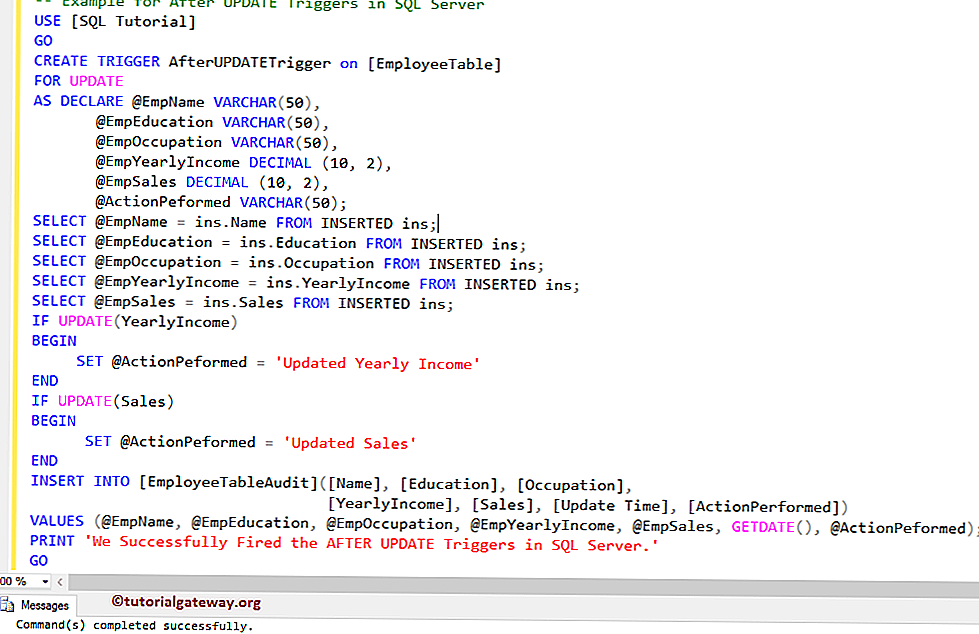

Используйте триггеры c осторожностью

Триггеры — это усложнение логики работы приложения, неявное неожиданное выполнение дополнительных действий.

Триггеры усложняют интерфейс хранимых процедур. Поместите все необходимые проверки и действия в рамки хранимых процедур.

Временные таблицы для больших таблиц, табличные переменные — для малых (меньше 1000)

Если вам требуется хранить промежуточные данные в таблицах, то используйте табличные переменные (@t1) для малых таблиц, а временные таблицы (#t1) — для больших.

Подробнее:

http://sqlcom.ru/helpful-and-interesting/compare-temp-table-vs-table-variable-vs-cte/

https://coderoad.ru/27894/%D0%92-%D1%87%D0%B5%D0%BC-%D1%80%D0%B0%D0%B7%D0%BD%D0%B8%D1%86%D0%B0-%D0%BC%D0%B5%D0%B6%D0%B4%D1%83-%D0%B2%D1%80%D0%B5%D0%BC%D0%B5%D0%BD%D0%BD%D0%BE%D0%B9-%D1%82%D0%B0%D0%B1%D0%BB%D0%B8%D1%86%D0%B5%D0%B9-%D0%B8-%D1%82%D0%B0%D0%B1%D0%BB%D0%B8%D1%87%D0%BD%D0%BE%D0%B9-%D0%BF%D0%B5%D1%80%D0%B5%D0%BC%D0%B5%D0%BD%D0%BD%D0%BE%D0%B9-%D0%B2-SQL-Server

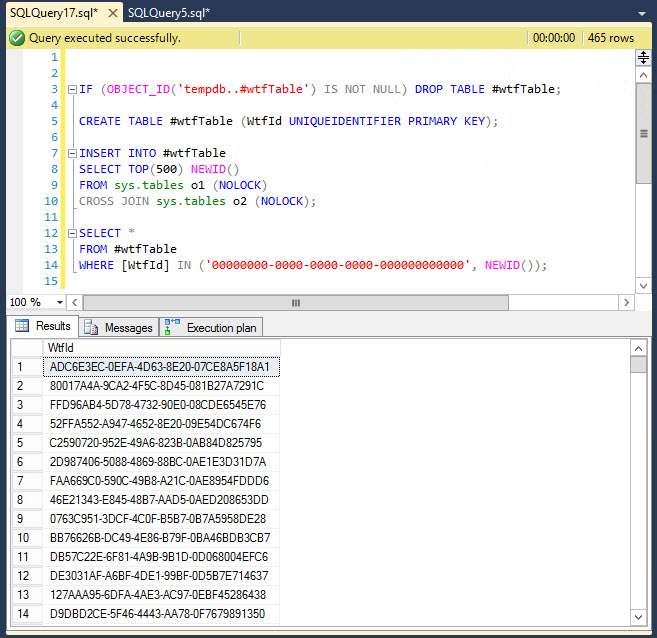

При определении временной таблицы имеет смысл проверить ее на существование:

IF OBJECT_ID('tempdb..#eventIDs') IS NOT NULL begin

DROP TABLE #eventIDs

end

CREATE TABLE #eventIDs ( id int primary key,instanceID int )

Также для улучшения быстродействия используйте для временной таблицы первичный ключ и индексы.

Как уменьшить вероятность дедлоков на базе

Дедлок — это взаимная блокировка 2 выполняющихся пакетов sql. Это самым негативным образом сказывается на быстродействии запросов.

Чтобы избежать deadlocks, пытайтесь разрабатывать ваше приложение с учетом следующих рекомендаций:

- Всегда получайте доступ к объектам в одном и том же порядке.

- Старайтесь делать транзакции короткими и заключайте их в один пакет (batch)

- Старайтесь использовать максимально низкий уровень изоляции для пользовательского соединения, которое работает с транзакцией.

Работа с индексами SQL Server

Советы по созданию кластерных индексов

- Первичный ключ не всегда должен быть кластерным индексом. Если Вы создаете первичный ключ, тогда SQL сервер автоматически делает первичный ключ кластерным индексом.

- Кластерные индексы идеальны для запросов, где есть выбор по диапазону или вы нуждаетесь в сортированных результатах. Так происходит потому, что данные в кластерном индексе физически отсортированы по какому-то столбцу.

Запросы, получающие выгоду от кластерных индексов, обычно включают в себя операторы BETWEEN, <, >, GROUP BY, ORDER BY, и агрегативные операторы типа MAX, MIN, и COUNT.

Запросы, получающие выгоду от кластерных индексов, обычно включают в себя операторы BETWEEN, <, >, GROUP BY, ORDER BY, и агрегативные операторы типа MAX, MIN, и COUNT. - Кластерные индексы хороши для запросов, которые ищут запись с уникальным значением (типа номера служащего) и когда Вы должны вернуть большую часть данных из записи или всю запись. Так происходит потому, что запрос покрывается индексом.

- Кластерные индексы хороши для запросов, которые обращаются к столбцам с ограниченным числом значений, например столбцы, содержащие данные о странах или штатах. Но если данные столбца мало отличаются, например, значения типа «да/нет», «мужчина/женщина», то такие столбцы вообще не должны индексироваться.

- Кластерные индексы хороши для запросов, которые используют операторы GROUP BY или JOIN.

- Кластерные индексы хороши для запросов, которые возвращают много записей, потому что данные находятся в индексе, и нет необходимости искать их где-то еще.

- Избегайте помещать кластерный индекс в столбцы, в которых содержатся постоянно возрастающие величины, например, даты, подверженные частым вставкам в таблицу (INSERT).

Так как данные в кластерном индексе должны быть отсортированы, кластерный индекс на инкрементирующемся столбце вынуждает новые данные быть вставленным в ту же самую страницу в таблице, что создает «горячую зону в таблице» и приводит к большому объему дискового ввода-вывода. Постарайтесь найти другой столбец, который мог бы стать кластерным индексом.

Так как данные в кластерном индексе должны быть отсортированы, кластерный индекс на инкрементирующемся столбце вынуждает новые данные быть вставленным в ту же самую страницу в таблице, что создает «горячую зону в таблице» и приводит к большому объему дискового ввода-вывода. Постарайтесь найти другой столбец, который мог бы стать кластерным индексом.

Советы по выбору некластерных индексов

- Некластерные индексы лучше подходят для запросов, которые возвращают немного записей (включая только одну запись) и где индекс имеет хорошую селективность (более чем 95 %).

- Если столбец в таблице не содержит по крайней мере 95% уникальных значений, тогда очень вероятно, что Оптимизатор Запроса SQL сервера не будет использовать некластерный индекс, основанный на этом столбце. Поэтому добавляйте некластерные индексы к столбцам, которые имеют хотя бы 95% уникальных записей. Например, столбец с «Да» или «Нет» не имеет 95% уникальных записей.

- Постарайтесь сделать ваши индексы как можно меньшего размера (особенно для многостолбцовых индексов).

Это уменьшает размер индекса и уменьшает число чтений, необходимых, чтобы прочитать индекс, что увеличивает производительность.

Это уменьшает размер индекса и уменьшает число чтений, необходимых, чтобы прочитать индекс, что увеличивает производительность. - Если возможно, создавайте индексы на столбцах, которые имеют целочисленные значения вместо символов. Целочисленные значения имеют меньше потерь производительности, чем символьные значения.

- Если ваше приложение будет выполнять один и тот же запрос много раз на той же самой таблице, рассмотрите создание покрывающего индекса на таблице. Покрывающий индекс включает все столбцы, упомянутые в запросе. Из-за этого индекс содержит все данные, которые Вы ищете, и SQL сервер не должен искать фактические данные в таблице, что сокращает логический и/или физический ввод — вывод. С другой стороны, если индекс становится слишком большим (слишком много столбцов), это может увеличить объем ввода — вывода и ухудшить производительность.

- Индекс полезен для запроса только в том случае, если оператор WHERE запроса соответствует столбцу (столбцам), которые являются крайними левыми в индексе.

Так, если Вы создаете составной индекс, типа «City, State», тогда запрос » WHERE City = ‘Хьюстон’ » будет использовать индекс, но запрос » WHERE State = ‘TX’ » не будет использовать индекс.

Так, если Вы создаете составной индекс, типа «City, State», тогда запрос » WHERE City = ‘Хьюстон’ » будет использовать индекс, но запрос » WHERE State = ‘TX’ » не будет использовать индекс. - Любая операция над полем в предикате поиска, которое лежит под индексом, сводит на нет его использование. where isnull(field,’’) = ‘’ здесь индекс не используется, where field = ‘’ and field is not null — здесь используется.

Бывает ли слишком много индексов?

Да. Проблема с лишними индексами состоит в том, что SQL сервер должен изменять их при любых изменениях таблицы (INSERT, UPDATE, DELETE).

Лучшим решением ставить сомнительный индекс или нет, будет подождать и собрать статистику по работе индексов.

Лучшие кандидаты на установку индекса

- Это поля, по которым идет Join

- Поля связи, участвующие в подзапросах

- Поля, по которым идет фильтрация в where

- Поля, по которым выполняется сортировка.

Советы по использованию временных таблиц и табличных переменных

Если вы замечаете, что обращаетесь к одной и той же таблице несколько раз, то это явный знак необходимости использовать временную таблицу.

- Временная таблица храниться физически в tempdb, табличная переменная хранится в памяти SQL

- SQL может сам решить сохранить табличную переменную физически, если там будет много данных, это потеря ресурсов

- Временная таблица подходит для большого объема данных (полноценная выборка), табличная переменная — для малого объема данных (справочники или набор ID для чего-то)

- Временная таблица доступна из любой процедуры SQL, табличная переменная только в рамках запроса. Не забывайте очищать временные таблицы после их использования

Если вы SQL-разработчик или администратор MS SQL Server, и вы хотели бы разрабатывать веб-решения на SQL, то веб-платформа Falcon Space — это то, что вам нужно.

В ней SQL — это основной язык разработки, который позволяет реализовать систему личных кабинетов с формами, таблицами, дашбордами и другими компонентами. Все настраивается на SQL. Для поддержки решения надо иметь знания только по SQL и HTML.

Вводная статья по Falcon Space для SQL специалиста

SQL-запрос — Документация Bpium

Используется для выполнения SQL-запросов к внешним базам данных.

Секция «Подключение»

Тип базы данных Выбор протокола подключения к базе данных. Подключиться можно к одной из следующих баз данных: PostgreSQL, MySQL, Oracle, SQLite, MsSQL.

Способ подключения Позволяет указать формат для подключения, передав отдельно параметры или целиком строку подключения.

Способ подключения: Параметры

Адрес сервера Адрес (домен или IP-адрес) сервера базы данных. Доступен, если способ подключения «Параметры». Допустимо указывать адрес хоста вместе с портом, разделенные через двоеточие. Формат: «значение в кавычках» или выражение.

Доступен, если способ подключения «Параметры». Допустимо указывать адрес хоста вместе с портом, разделенные через двоеточие. Формат: «значение в кавычках» или выражение.

База данных Имя базы данных. Доступен, если способ подключения «Параметры». Формат: «значение в кавычках» или выражение.

Логин Доступен, если способ подключения «Параметры». Формат: «значение в кавычках» или выражение.

Пароль Доступен, если способ подключения «Параметры». Формат: «значение в кавычках» или выражение.

Формат: «значение в кавычках» или выражение.

Способ подключения: Строка подключения

Строка подключения Строка подключения к базе данных со всеми параметрами подключения. Для разных типов баз данных используется свой синтаксис. Подробнее в документации соответствующей базы данных. Свойство доступно, если способ подключения «Строка подключения». Формат: «значение в кавычках» или выражение.

Пример для PostgreSQL:

«postgres://user:[email protected]:port/dbname»

Секция «Запрос»

SQL-запрос SQL-запрос или SQL-код в синтаксисе выбранного типа базы данных. Позволяет использовать именные параметры. Формат: «значение в кавычках» или выражение. Пример:

Позволяет использовать именные параметры. Формат: «значение в кавычках» или выражение. Пример:

«Select * from tablename where id > :paramname1»

При формировании SQL-запроса будет подставлен параметр paramname1, указанный в свойстве «Параметры запроса».

Параметры запроса Позволяет передать именные параметры для SQL-запроса. Формат: список «параметр = значение/выражение».

Помимо использования переменных из поля Параметры запроса можно так же использовать глобальные сценарные переменные, посредством синтаксиса ${value}. Например, описанный выше запрос с переменной можно описать следующим образом, при условии, что в сценарии существует переменная paramname1:

Например, описанный выше запрос с переменной можно описать следующим образом, при условии, что в сценарии существует переменная paramname1:

`Select * from tablename where id > ${paramname1}`

Секция «Ответ»

Ожидать ответа Указывает дожидаться ли компоненту возврата результата запроса.

Сохранить в Выходной параметр. Сохраняет ответ в указанную переменную. В качестве ответа компонент возвращает массив из строк. Каждая строка представлена в виде обьекта, ключами которого являются имена колонок. Формат: имя переменной. Пример:

«fieldname1»: value,

«fieldname2»: value,

В «Сохранить в» можно указать ключ объекта и массив из строк сохранится как значения этого ключа.

Пример

Если указать в поле «Сохранить в» переменнуюdata.temp, то результат будет выглядеть следующим образом:

data: {

«temp»: [

«fieldname1»: value,

«fieldname2»: value,

Компонент поддерживает 2 типа пограничных событий:

Ошибка — выход из компонента, если произошла какая-либо ошибка

Таймаут — выход из компонента, спустя заданное ограничение по времени

Если компонент завершился с ошибкой, но на нем не было пограничного события, то процесс завершается. Сообщение ошибки возвращается в результатах процесса.

вложенные запросы и временные таблицы

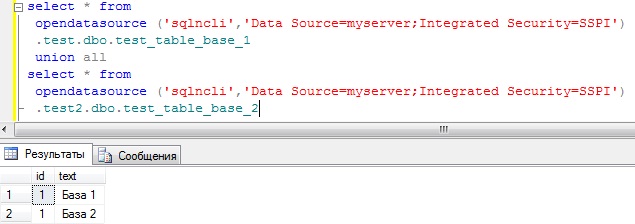

Добро пожаловать в следующую статью из цикла про SQL! В предыдущей статье мы считали Transactions и Gross для приложения на двух платформах и получили отдельный результат для каждого приложения.

Transactions и Gross для приложения «3 in a row». Скриншот из демо devtodevНо что если мы хотим обобщить его и для каждой метрики иметь только одно значение? Для этого мы будем использовать результат, получившийся с помощью операции union, как таблицу в операторе from. И затем в select вычислять сумму по полю transactions и gross из объединенной таблицы (скриншот выше).

Залогиньтесь на сайте, зайдите в демо и найдите SQL отчёт во вкладке Reports.

Результат запроса. Скриншот из демо devtodevselect ‘Metrics for all projects’ as «App»

, sum(transactions) as «Transactions»

, sum(gross) as «Gross»

from (

select count() as transactions

, sum(priceusd) as gross

from p102968.payments

where eventtime > current_date — interval ‘7 day’ and eventtime < current_dateunion all

select count() as «Transactions»

, sum(priceusd) as «Gross»

from p104704.payments

where eventtime > current_date — interval ‘7 day’ and eventtime < current_date

) as metrics_by_platform

Оператор from теперь содержит целый запрос внутри себя, который обращается сразу к двум таблицам. Тоже самое можно провернуть и с внутренним запросом, добавив в каждый из from еще запрос select, если это необходимо. Важно, чтобы такие запросы были заключены в скобки и им было дано имя – имя результирующей таблицы.

) as metrics_by_platform

Такую конструкцию можно использовать во всех операторах, обращающихся к таблицам. Например, в join.

Inner join (select … from … where …) as join_table

on join_table.param = t.param

Метрики по отдельным приложениям и суммарно по всем

Давайте в одном запросе посчитаем суммарные метрики по всем приложениям, а также выведем расшифровку (метрики по каждому из приложений) ниже.

Результат запроса. Скриншот из демо devtodevselect ‘Metrics for all projects’ as «App»

, sum(transactions) as «Transactions»

, sum(gross) as «Gross»

from (

select ‘3 in a row. iOS’ as «App»

, count() as transactions

, sum(priceusd) as gross

from p102968.payments

where eventtime > current_date — interval ‘7 day’ and eventtime < current_dateunion all

select ‘3 in a row. Android’ as «App»

, count() as transactions

, sum(priceusd) as gross

from p104704.payments

where eventtime > current_date — interval ‘7 day’ and eventtime < current_date

) metrics_by_platformunion all

select ‘3 in a row.iOS’ as «App»

, count() as transactions

, sum(priceusd) as gross

from p102968.payments

where eventtime > current_date — interval ‘7 day’ and eventtime < current_dateunion

select ‘3 in a row. Android’ as «App»

, count() as «Transactions»

, sum(priceusd) as «Gross»

from p104704.payments

where eventtime > current_date — interval ‘7 day’ and eventtime < current_date

order by 3 desc

Получается довольно громоздкий запрос, в котором мы по два раза обращаемся к каждой из таблиц payments, и к тому же мы два раза написали один и тот же код (при изменении запроса нам придётся вносить изменения в двух местах).

Чтобы избежать этого, мы можем создать представление (Common Table Expression – CTE), и затем в ходе запроса обращаться к нему несколько раз. Конструкция может содержать в себе сколь угодно сложные запросы и обращаться к другим представлениям. Она выглядит следующим образом:

Она выглядит следующим образом:

with temp_table_name as

(select … from …)

Можно сказать, что мы создаем временную таблицу, которая рассчитывается один раз в ходе выполнения запроса даже если вы обращаетесь к ней из разных мест. Использование представлений CTE также сильно упрощает чтение запроса и его последующее редактирование.

Вот как вышеуказанный запрос будет выглядеть с использованием представлений CTE:

with metrics_by_platform as (

select ‘3 in a row. iOS’ as app

, count() as transactions

, sum(priceusd) as gross

from p102968.payments

where eventtime > current_date — interval ‘9 day’ and eventtime < current_dateunion all

select ‘3 in a row. Android’ as app

, count() as transactions

, sum(priceusd) as gross

from p104704.payments

where eventtime > current_date — interval ‘9 day’ and eventtime < current_date

)

select ‘Metrics for all projects’ as «App»

, sum(transactions) as «Transactions»

, sum(gross) as «Gross»

from metrics_by_platformunion all

select app

, transactions

, gross

from metrics_by_platform

order by 3 desc

Выглядит проще, не правда ли? Если мы добавим новое приложение и захотим анализировать и его метрики, мы просто добавим его в представление metrics_by_platform, а расчет самих метрик и итоговый вывод результатов никак не зависит от количества приложений.

Доля пользователей, совершивших максимальное количество платежей (вложенные запросы)

Рассмотрим более сложный пример. Давайте узнаем, какое максимальное число платежей совершено одним пользователем за 7 дней и сколько таких пользователей.

Сложные запросы всегда лучше писать частями, и начнем мы с максимального количества платежей.

У нас есть таблица со всеми платежами пользователей from p102968.payment. Из нее мы посчитаем количество совершенных платежей для каждого из пользователей, сгруппировав их по devtodevid, а потом найдем максимальное число таких платежей с помощью max().

Результат запроса.select max(user_payments) as «max_payments»

from (

select devtodevid

, count() user_payments

from p102968.payments

where eventtime > current_date — interval ‘9 day’ and eventtime < current_date

group by devtodevid

) as payments_count

Скриншот из демо devtodev

Скриншот из демо devtodevОсталось узнать, сколько пользователей совершили 12 платежей за это же время. Для этого только что выполненный запрос мы помещаем в фильтр where user_payments = (запрос), который оставит нам только пользователей с соответствующим максимальному количеством платежей. Сам запрос будет возвращать число таких пользователей select count() as «Users» и максимальное количество платежей max(user_payments) as «Max payments count» из таблицы from (…) as payments_count.

Результат запроса. Скриншот из демо devtodevselect count(devtodevid) as «Users»

, max(user_payments) as «Max payments count»

from (

select devtodevid

, count() user_payments

from p102968.payments

where eventtime > current_date — interval ‘7 day’ and eventtime < current_date

group by devtodevid

) as payments_countwhere user_payments = (select max(user_payments)

from

(select devtodevid

, count() user_payments

from p102968.payments

where eventtime > current_date — interval ‘7 day’ and eventtime < current_date

group by devtodevid) as payments_count

)

При выполнении для каждой строчки из внешнего запроса будет производиться сравнение максимального количества платежей пользователей where user_payments = (…) . В коде мы два раза использовали один и тот же запрос, поэтому давайте оптимизируем его с помощью представления CTE.

with payments_count as (

select devtodevid

, count() user_payments

from p102968.payments

where eventtime > current_date — interval ‘7 day’ and eventtime < current_date

group by devtodevid

)select count() as «Users»

, max(user_payments) as «Payments count»

from payments_count

where user_payments = (select max(user_payments)

from payments_count

А какова доля пользователей с таким количеством платежей среди всех платящих пользователей? Может быть он всего один и платил?

Чтобы узнать это, мы должны добавить вложенный запрос прямо в select, который посчитает всех платящих пользователей. На это число мы затем и поделим количество пользователей с максимальным платежом.

На это число мы затем и поделим количество пользователей с максимальным платежом.

Результат запроса. Скриншот из демо devtodevwith payments_count as (

select devtodevid

, count() user_payments

from p102968.payments

where eventtime > current_date — interval ‘7 day’ and eventtime < current_date

group by devtodevid

)select count() as «Users with max payments count»

, max(user_payments) as «Payments count»

, round(count()*100::numeric / (select count(distinct devtodevid)

from p102968.payments

where eventtime > current_date — interval ‘7 day’ and eventtime < current_date

, 2) ||’%’ as «% of all payers»

from payments_count

where user_payments = (select max(user_payments)

from payments_count)

Вложенные запросы внутри select – довольно распространенная практика. Они часто используются для расчета доли от чего-либо, либо отображения информации из другой таблицы без использования join.

Они часто используются для расчета доли от чего-либо, либо отображения информации из другой таблицы без использования join.

P.S.

В этой статье мы рассмотрели несколько примеров использования временных таблиц и вложенных запросов. В следующий раз вы научитесь заполнять пустые даты на графиках и формировать гистограмму распределения.

Введение в интерфейс SQLite C/C++

Введение в интерфейс SQLite C/C++

► Оглавление

1. Резюме

2. Введение

3. Основные объекты и интерфейсы

4. Типичное использование основных подпрограмм и объектов

5. Удобные обертки вокруг основных подпрограмм

30 Операторы 900 2 Preparedи привязка 7. Настройка SQLite

8. Расширение SQLite

9. Другие интерфейсы

Следующие два объекта и восемь методов составляют основные элементы интерфейса SQLite:

sqlite3 → Объект подключения к базе данных.

Сделано

sqlite3_open() и уничтожается sqlite3_close().

Сделано

sqlite3_open() и уничтожается sqlite3_close().sqlite3_stmt → Подготовленный объект оператора. Сделано sqlite3_prepare() и уничтожается sqlite3_finalize().

sqlite3_open() → Откройте соединение с новой или существующей базой данных SQLite. Конструктор для sqlite3.

sqlite3_prepare() → Скомпилируйте текст SQL в байт-код, который будет выполнять работу по запросу или обновлению базы данных. Конструктор для sqlite3_stmt.

sqlite3_bind() → Храните данные приложения в параметры исходного SQL.

sqlite3_step() → Переместите sqlite3_stmt к следующей строке результата или к завершению.

sqlite3_column() → Значения столбцов в текущей строке результатов для sqlite3_stmt.

sqlite3_finalize() → Деструктор для sqlite3_stmt.

sqlite3_close() → Деструктор для sqlite3.

sqlite3_exec() → Функция-оболочка, которая выполняет функции sqlite3_prepare(), sqlite3_step(), sqlite3_column() и sqlite3_finalize() для строка из одного или нескольких операторов SQL.

SQLite имеет более 225 API. Однако большинство API являются необязательными и очень специализированными. и могут быть проигнорированы новичками. Основной API небольшой, простой и легкий в освоении. В этой статье кратко изложен основной API.

Отдельный документ, The SQLite C/C++ Interface, предоставляет подробные спецификации для всех API-интерфейсов C/C++ для SQLite. Один раз читатель понимает основные принципы работы SQLite, этот документ следует использовать в качестве справочного руководство. Эта статья предназначена только для ознакомления и не является полный и авторитетный справочник по SQLite API.

Основная задача ядра базы данных SQL состоит в том, чтобы оценивать операторы SQL. SQL. Для этого разработчику нужны два объекта:

- Объект подключения к базе данных: sqlite3

- Подготовленный объект оператора: sqlite3_stmt

Строго говоря, подготовленный объект оператора не требуется, поскольку

удобные интерфейсы-оболочки, sqlite3_exec или

sqlite3_get_table, можно использовать и эти удобные обертки

инкапсулировать и скрыть подготовленный объект оператора. Тем не менее, понимание

подготовленные операторы необходимы для полного использования SQLite.

Тем не менее, понимание

подготовленные операторы необходимы для полного использования SQLite.

Соединение с базой данных и подготовленные объекты операторов контролируются с помощью небольшого набора подпрограмм интерфейса C/C++, перечисленных ниже.

- sqlite3_open()

- sqlite3_prepare()

- sqlite3_step()

- sqlite3_column()

- sqlite3_finalize()

- sqlite3_close()

Обратите внимание, что приведенный выше список подпрограмм является концептуальным, а не фактическим.

Многие из этих подпрограмм имеют несколько версий.

Например, в приведенном выше списке показана одна подпрограмма

с именем sqlite3_open(), хотя на самом деле это три отдельные процедуры

которые выполняют одно и то же немного разными способами:

sqlite3_open(), sqlite3_open16() и sqlite3_open_v2().

В списке упоминается sqlite3_column()

когда на самом деле такой процедуры не существует.

«sqlite3_column()», показанный в списке, является заполнителем для

целое семейство подпрограмм, что дополнительный столбец

данные в различных типах данных.

Вот краткое изложение того, что делают основные интерфейсы:

sqlite3_open()

Эта рутина открывает соединение с файлом базы данных SQLite и возвращает объект подключения к базе данных. Часто это первый SQLite API. вызов, который делает приложение, и является необходимым условием для большинства других SQLite API. Для многих интерфейсов SQLite требуется указатель на объект подключения к базе данных в качестве их первого параметра и может следует рассматривать как методы объекта подключения к базе данных. Эта подпрограмма является конструктором объекта соединения с базой данных.

sqlite3_prepare()

Эта рутина преобразует текст SQL в подготовленный объект оператора и возвращает указатель к этому объекту. Для этого интерфейса требуется указатель подключения к базе данных. созданный предыдущим вызовом sqlite3_open() и текстовой строкой, содержащей оператор SQL, который необходимо подготовить.

Этот API на самом деле не оценивает

оператор SQL. Он просто подготавливает оператор SQL для оценки.

Этот API на самом деле не оценивает

оператор SQL. Он просто подготавливает оператор SQL для оценки.Думайте о каждом операторе SQL как о небольшой компьютерной программе. Цель sqlite3_prepare() состоит в том, чтобы скомпилировать эту программу в объектный код. Подготовленный оператор является объектным кодом. Интерфейс sqlite3_step() затем запускает объектный код, чтобы получить результат.

Новые приложения всегда должны вместо этого вызывать sqlite3_prepare_v2() из sqlite3_prepare(). Старый sqlite3_prepare() сохраняется для обратная совместимость. Но sqlite3_prepare_v2() предоставляет много возможностей. лучший интерфейс.

sqlite3_step()

Эта процедура используется для оценки подготовленного оператора, который был ранее созданный интерфейсом sqlite3_prepare(). Заявление оценивается до момента, когда доступна первая строка результатов. Чтобы перейти ко второй строке результатов, снова вызовите sqlite3_step().

Продолжайте вызывать sqlite3_step(), пока инструкция не будет завершена.

Операторы, не возвращающие результатов (например, INSERT, UPDATE или DELETE).

операторы) выполняются до завершения одним вызовом sqlite3_step().

Продолжайте вызывать sqlite3_step(), пока инструкция не будет завершена.

Операторы, не возвращающие результатов (например, INSERT, UPDATE или DELETE).

операторы) выполняются до завершения одним вызовом sqlite3_step().sqlite3_column()

Эта процедура возвращает один столбец из текущей строки результата. установлен для подготовленного оператора, который оценивается sqlite3_step(). Каждый раз, когда sqlite3_step() останавливается с новой строкой набора результатов, эта процедура можно вызывать несколько раз, чтобы найти значения всех столбцов в этой строке.

Как отмечалось выше, на самом деле не существует такой вещи, как sqlite3_column(). функция в SQLite API. Вместо этого то, что мы здесь называем sqlite3_column(), является заполнителем для целого семейства функций, которые возвращают значение из набора результатов в различных типах данных. Есть и рутины в этом семействе, которые возвращают размер результата (если это строка или BLOB) и количество столбцов в результирующем наборе.

- sqlite3_column_blob()

- sqlite3_column_bytes()

- sqlite3_column_bytes16()

- sqlite3_column_count()

- sqlite3_column_double()

- sqlite3_column_int()

- sqlite3_column_int64()

- sqlite3_column_text()

- sqlite3_column_text16()

- sqlite3_column_type()

- sqlite3_column_value()

sqlite3_finalize()

Эта процедура уничтожает подготовленный оператор, созданный предыдущим вызовом в sqlite3_prepare(). Каждый подготовленный оператор должен быть уничтожен с помощью вызов этой подпрограммы, чтобы избежать утечек памяти.

sqlite3_close()

Эта процедура закрывает соединение с базой данных, ранее открытое вызовом в sqlite3_open(). Все подготовленные заявления, связанные с соединение должно быть завершено до закрытия связь.

Приложение обычно использует

sqlite3_open() для создания одного соединения с базой данных

во время инициализации. Обратите внимание, что sqlite3_open() можно использовать либо для открытия существующей базы данных,

файлов или для создания и открытия новых файлов базы данных.

Хотя многие приложения используют только одно соединение с базой данных,

нет причин, по которым приложение не может вызывать sqlite3_open() несколько раз

чтобы открыть несколько подключений к базе данных — либо к одному и тому же

базу данных или к другим базам данных. Иногда многопоточное приложение

создаст отдельные подключения к базе данных для каждого потока.

Обратите внимание, что одно соединение с базой данных может иметь доступ к двум или более

базы данных с помощью SQL-команды ATTACH, поэтому нет необходимости

иметь отдельное соединение с базой данных для каждого файла базы данных.

Обратите внимание, что sqlite3_open() можно использовать либо для открытия существующей базы данных,

файлов или для создания и открытия новых файлов базы данных.

Хотя многие приложения используют только одно соединение с базой данных,

нет причин, по которым приложение не может вызывать sqlite3_open() несколько раз

чтобы открыть несколько подключений к базе данных — либо к одному и тому же

базу данных или к другим базам данных. Иногда многопоточное приложение

создаст отдельные подключения к базе данных для каждого потока.

Обратите внимание, что одно соединение с базой данных может иметь доступ к двум или более

базы данных с помощью SQL-команды ATTACH, поэтому нет необходимости

иметь отдельное соединение с базой данных для каждого файла базы данных.

Многие приложения разрушают свои соединения с базой данных, используя вызовы

sqlite3_close() при завершении работы. Или, например, приложение, которое

использует SQLite, так как его формат файла приложения может

открывать соединения с базой данных в ответ на действие меню File/Open

а затем уничтожить соответствующее соединение с базой данных в ответ

в меню Файл/Закрыть.

Чтобы запустить инструкцию SQL, приложение выполняет следующие шаги:

- Создайте подготовленный оператор, используя sqlite3_prepare().

- Оцените подготовленный оператор, вызвав sqlite3_step() один или более раз.

- Для запросов извлекайте результаты, вызывая sqlite3_column() между ними два вызова sqlite3_step().

- Уничтожить подготовленный оператор с помощью sqlite3_finalize().

Вышеизложенное — это все, что действительно нужно знать, чтобы использовать SQLite. эффективно. Все остальное оптимизация и детализация.

Интерфейс sqlite3_exec() — это удобная оболочка, которая выполняет

все четыре вышеуказанных шага с помощью одного вызова функции. Обратный звонок

функция, переданная в sqlite3_exec(), используется для обработки каждой строки

набор результатов. sqlite3_get_table() — еще одна удобная оболочка.

который выполняет все четыре вышеуказанных шага. Интерфейс sqlite3_get_table()

отличается от sqlite3_exec() тем, что сохраняет результаты запросов

в куче памяти, а не вызывать обратный вызов.

Важно понимать, что ни sqlite3_exec(), ни sqlite3_get_table() делает все, что не может быть выполнено с помощью основные процедуры. На самом деле эти обертки реализованы исключительно в с точки зрения основных процедур.

В предыдущем обсуждении предполагалось, что каждый оператор SQL подготавливается один раз, оценивается, затем уничтожается. Однако SQLite позволяет то же самое. подготовленный оператор для многократной оценки. Это выполнено используя следующие подпрограммы:

- sqlite3_reset()

- sqlite3_bind()

После того, как подготовленный оператор был оценен одним или несколькими вызовами

sqlite3_step(), его можно сбросить для повторной оценки с помощью

вызов sqlite3_reset().

Думайте о sqlite3_reset() как о перемотке подготовленной программы операторов.

вернуться к началу.

Использование sqlite3_reset() для существующего подготовленного оператора, а не

создание нового подготовленного оператора позволяет избежать ненужных вызовов

sqlite3_prepare(). Для многих операторов SQL время, необходимое

для запуска sqlite3_prepare() равно или превышает время, необходимое

sqlite3_step(). Поэтому избегание вызовов sqlite3_prepare() может дать

значительное улучшение производительности.

Для многих операторов SQL время, необходимое

для запуска sqlite3_prepare() равно или превышает время, необходимое

sqlite3_step(). Поэтому избегание вызовов sqlite3_prepare() может дать

значительное улучшение производительности.

Обычно нецелесообразно оценивать точных одинаковых SQL-запросов. утверждение более одного раза. Чаще хочется оценить похожие заявления. Например, вы можете захотеть оценить оператор INSERT. несколько раз с разными значениями. Или вы хотите оценить один и тот же запрос несколько раз, используя другой ключ в предложении WHERE. Разместить это, SQLite позволяет операторам SQL содержать параметры которые «привязаны» к значениям до их оценки. Эти значения могут позже может быть изменен, и тот же подготовленный оператор может быть оценен второй раз, используя новые значения.

SQLite позволяет параметр везде

допускается строковый литерал, числовая константа или NULL.

(Параметры нельзя использовать для имен столбцов или таблиц. )

Параметр принимает одну из следующих форм:

)

Параметр принимает одну из следующих форм:

- ?

- ? ННН

- : ААА

- $ ААА

- @ ААА

В приведенных выше примерах NNN является целым числом и AAA — это идентификатор. Изначально параметр имеет значение NULL. Перед вызовом sqlite3_step() в первый раз или сразу после sqlite3_reset() приложение может вызывать Интерфейсы sqlite3_bind() для прикрепления значений к параметрам. Каждый вызов sqlite3_bind() переопределяет предыдущие привязки того же параметра.

Приложение может заранее подготовить несколько операторов SQL.

и оценивать их по мере необходимости.

Нет произвольного ограничения на количество непогашенных

подготовленные заявления.

Некоторые приложения вызывают sqlite3_prepare() несколько раз при запуске, чтобы

создать все подготовленные операторы, которые им когда-либо понадобятся. Другой

приложения сохраняют кеш самых последних использованных подготовленных операторов

а затем повторно использовать подготовленные операторы из кеша, когда они доступны.

Другой подход заключается в повторном использовании подготовленных операторов только тогда, когда они

внутри петли.

Другой

приложения сохраняют кеш самых последних использованных подготовленных операторов

а затем повторно использовать подготовленные операторы из кеша, когда они доступны.

Другой подход заключается в повторном использовании подготовленных операторов только тогда, когда они

внутри петли.

Конфигурация по умолчанию для SQLite отлично подходит для большинства приложений. Но иногда разработчики хотят настроить установку, чтобы попытаться выжать немного больше производительности, или воспользоваться какой-то малоизвестной функцией.

Интерфейс sqlite3_config() используется для создания глобальных, общепроцессных изменения конфигурации для SQLite. Интерфейс sqlite3_config() должен вызываться до того, как будут созданы какие-либо соединения с базой данных. Интерфейс sqlite3_config() позволяет программисту делать такие вещи, как:

- Настройка способа выделения памяти SQLite, включая настройку

альтернативные распределители памяти, подходящие для критически важных с точки зрения безопасности

встроенные системы реального времени и определяемые приложениями распределители памяти.

- Настройте журнал ошибок для всего процесса.

- Укажите определяемый приложением кэш страниц.

- Отрегулируйте использование мьютексов, чтобы они подходили для различных резьбовые модели или заменить определяемая приложением система мьютексов.

После завершения настройки всего процесса и подключения к базе данных были созданы, отдельные подключения к базе данных могут быть настроены с помощью вызовы sqlite3_limit() и sqlite3_db_config().

SQLite включает в себя интерфейсы, которые можно использовать для расширения его функциональности. К таким процедурам относятся:

- sqlite3_create_collation()

- sqlite3_create_function()

- sqlite3_create_module()

- sqlite3_vfs_register()

Интерфейс sqlite3_create_collation() используется для создания новых

сопоставление последовательностей для сортировки текста.

Интерфейс sqlite3_create_module() используется для регистрации новых

реализации виртуальных таблиц. Интерфейс sqlite3_vfs_register() создает новые VFS.

Интерфейс sqlite3_vfs_register() создает новые VFS.

Интерфейс sqlite3_create_function() создает новые функции SQL — либо скалярные, либо агрегатные. Реализация новой функции обычно использует следующие дополнительные интерфейсы:

- sqlite3_aggregate_context()

- sqlite3_result()

- sqlite3_user_data()

- sqlite3_value()

Все встроенные SQL-функции SQLite созданы именно с использованием эти самые интерфейсы. Обратитесь к исходному коду SQLite и, в частности, в дата.с и Исходные файлы func.c Например.

Общие библиотеки или библиотеки DLL можно использовать в качестве загружаемых расширений для SQLite.

В этой статье упоминаются только самые важные и наиболее часто

используемые интерфейсы SQLite.

Библиотека SQLite включает множество других API, реализующих полезные

особенности, которые здесь не описаны.

Полный список функций, образующих SQLite

Интерфейс прикладного программирования находится на

Спецификация интерфейса C/C++. Обратитесь к этому документу за полной и достоверной информацией о

все интерфейсы SQLite.

Обратитесь к этому документу за полной и достоверной информацией о

все интерфейсы SQLite.

Использование SQL с онлайн-классом C++

- Все темы

- Технологии

- Разработка программного обеспечения

- Языки программирования

С Биллом Вайнманом Нравится 418 пользователям

Продолжительность: 1ч 27м Уровень мастерства: средний Дата выпуска: 12.08.2021

Начать бесплатную пробную версию на 1 месяц

Детали курса

C++ — это мощный язык для приложений баз данных, который может быть отличным инструментом для использования с SQL. В этом курсе инструктор Билл Вейнман расскажет вам, как использовать возможности C++ в SQL, начиная с основ, таких как подключение к базе данных, выполнение простых запросов и чтение строк из таблицы. Он также объясняет, как использовать подготовленные операторы и переменные связывания, а также как создать класс-оболочку для оптимизации интерфейса SQL. Наконец, он показывает вам, как построить специализированный класс приложения, чтобы вы могли создать приложение, используя то, что вы узнали. Если вы опытный разработчик C++ и хотите научиться использовать C++ с SQL, этот курс для вас.

В этом курсе инструктор Билл Вейнман расскажет вам, как использовать возможности C++ в SQL, начиная с основ, таких как подключение к базе данных, выполнение простых запросов и чтение строк из таблицы. Он также объясняет, как использовать подготовленные операторы и переменные связывания, а также как создать класс-оболочку для оптимизации интерфейса SQL. Наконец, он показывает вам, как построить специализированный класс приложения, чтобы вы могли создать приложение, используя то, что вы узнали. Если вы опытный разработчик C++ и хотите научиться использовать C++ с SQL, этот курс для вас.

Навыки, которые вы приобретете

- SQL

- С++

Получите общий сертификат

Поделитесь тем, что вы узнали, и станьте выдающимся профессионалом в желаемой отрасли с сертификатом, демонстрирующим ваши знания, полученные на курсе.

Обучение LinkedIn Обучение

Сертификат об окончанииДемонстрация в вашем профиле LinkedIn в разделе «Лицензии и сертификаты»

Загрузите или распечатайте в формате PDF, чтобы поделиться с другими

Поделитесь изображением в Интернете, чтобы продемонстрировать свое мастерство

Познакомьтесь с инструктором

Билл Вайнман

Отзывы учащихся

29рейтинги

Общий рейтинг рассчитывается на основе среднего значения представленных оценок. Оценки и обзоры могут быть отправлены только тогда, когда неанонимные учащиеся завершат не менее 40% курса. Это помогает нам избежать поддельных отзывов и спама.

Оценки и обзоры могут быть отправлены только тогда, когда неанонимные учащиеся завершат не менее 40% курса. Это помогает нам избежать поддельных отзывов и спама.

- 5 звезд Текущее значение: 19 65%

- 4 звезды Текущее значение: 9 31%

- 3 звезды Текущее значение: 1 3%

Георгий Петросян

Георгий Петросян

Старший инженер-программист

5/5

14 мая 2022 г.

Этот курс хорош для начинающих. Но я думаю, что готовые примеры бесполезны. Полезнее будет написать код с объяснением каждой функции и ее параметров.

Полезный · Отчет

Марк Финли

Марк Финли

Студент Университета Вэлли Вью

Содержание

Что включено

- Практикуйтесь, пока учитесь 1 файл с упражнениями

- Проверьте свои знания 4 викторины

- Учитесь на ходу Доступ на планшете и телефоне

Похожие курсы

Скачать курсы

Используйте приложение LinkedIn Learning для iOS или Android и смотрите курсы на своем мобильном устройстве без подключения к Интернету.

запрос.скала

query.scala // Перейти к …

- СУО

- Учебники

- запрос.скала

¶

Коммерческие и открытые системы баз данных состоят из миллионов строк оптимизированный код C. Тем не менее, их производительность по отдельным запросам падает в 10 или 100 раз. за исключением того, что может написать написанная от руки специализированная реализация того же запроса. достигать.