Как проиндексировать сайт в Google

- Главная

- База знаний

- Сайты

- Статистика и аналитика

Чтобы ваш сайт показывался пользователям в результатах поиска, вам нужно добавить информацию о сайте в SEO настройки сайта и проиндексировать сайт.

Как индексируется сайт

Индексирование в поисковых системах — это процесс считывания и добавления сведений о сайте роботом поисковой машины в базу данных, которую будут использовать для поиска текста по запросу пользователя.

Поисковый робот для индексации просматривает следующие данные:

- метаданные (заголовок, описание, ключевые слова),

- контент (актуальность и уникальность текста внутри сайта и подписи к картинкам)

- внутренние (ссылки внутри контента на странице, перелинковка между страницами сайта и добавленная навигация) и внешние ссылки (ссылка на нужную страницу с другого авторитетного сайта),

- ответ сервера при открытии страницы (существует ли страница и можно ли ее открыть) и другие данные.

Чтобы сайт быстрее проиндексировался, добавьте ссылку на ваш сайт на другом популярном сайте. Также вы можете добавить сайт в инструменты для вебмастеров, которые предоставляют владельцу рекомендации по улучшению сайта, устранению ошибок, а также данные отображению и ранжированию сайта в поисковых системах.![]()

Как добавить сайт в Google Search Console

Войдите в вашу учетную запись Google и добавьте адрес на ваш сайт в Google Search Console.

Далее нужно подтвердить, что сайт действительно принадлежит вам.

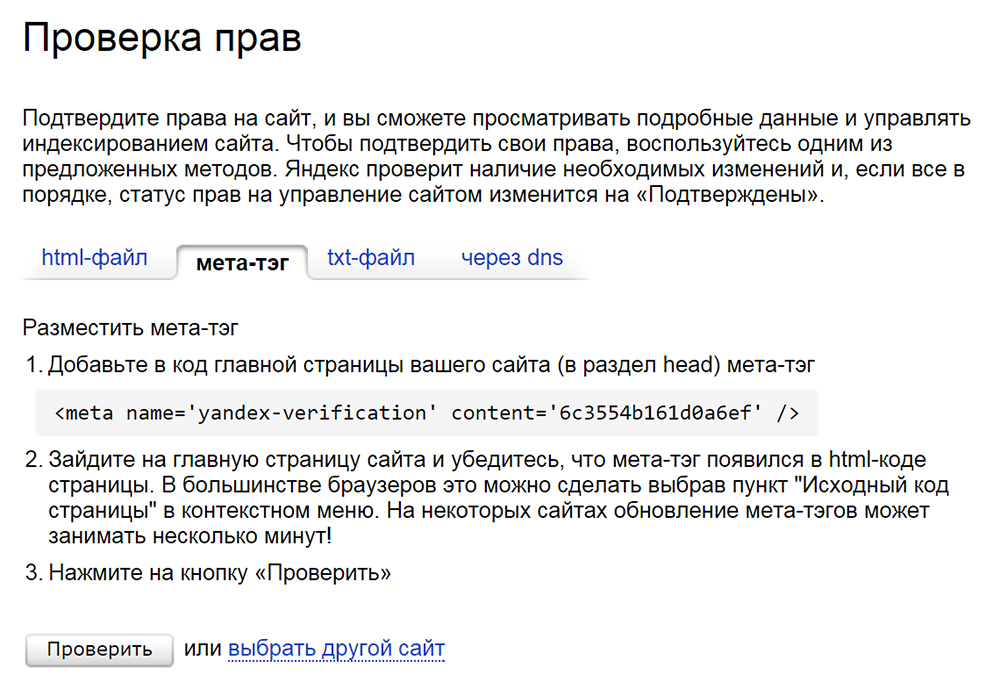

Перейдите на вкладку «Метатег», чтобы выбрать способ подтверждения домена с помощью метатега. Скопируйте предложенный HTML код.

Перейдите в настройки сайта в вашем аккаунте SendPulse на вкладку «Произвольный код» и нажмите «Добавить код на сайт».

Выберите разместить код в head. Введите название для добавленного кода и сам скопированный код и нажмите кнопку «Добавить».

Чтобы убедиться, что метатег добавлен, перейдите на сайт под этим доменом и проверьте исходный код.

Вернитесь на страницу с подтверждением прав в Google Search Console и нажмите «Подтвердить».

Если код установлен успешно, вы получите подтверждение.

После проверки подтверждения и проверки страницы на сайте нажмите «Запросить индексирование».

Как добавить сайт в другие поисковые системы

Вебмастер Bing (yahoo.com) настраивается по тому же принципу, что и Google — через добавление сайта в систему, подтверждение прав и запрос индексирования.

Обновлено: 07.03.2023

Популярное в нашем блоге

Как быстро проверить индексацию сайта в Google

Чтобы сайт отображался в результатах поиска, все его страницы, открытые для индексации, должны стать частью индекса поисковой системы. Если системе не удается добавить страницы сайта в базу данных, они остаются практически невидимыми для потенциальных клиентов.

Предлагаю рассмотреть шесть способов проверки индексации. Выясним — почему поисковые системы не индексируют сайт, найдем пути решения проблем.

- Как работает индексация сайта?

- Проверка в Google Search Console

- Как проверить индексацию конкретной страницы в Search Console?

- Анализ индексации сайта в Google поиске

- Проверка индексации онлайн с помощью сервисов

- SEO-инструменты для проверки сайтов

- Букмарклеты

- Индексатор Google Indexing API

- Почему Google не индексирует сайт?

- Как ускорить индексацию сайта?

- Как управлять краулинговым бюджетом?

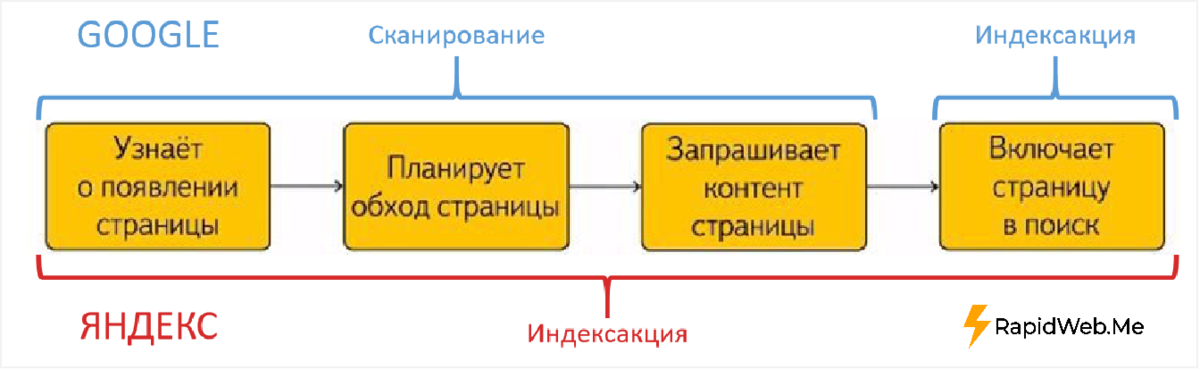

На первый взгляд может показаться, что сканирование и индексация — два очень похожих процесса. Они действительно тесно взаимосвязаны, но являются разными этапами обработки сайта поисковыми системами.

Сканирование — процесс поиска страниц для дальнейшей обработки и индексации.

Индексация — процесс добавления просканированной страницы в базу данных (индекс) поисковой системы. Таким образом, при релевантном запросе пользователя, страница появится в результатах поиска:

Важно.

Как проверить сайт на индексацию

Проиндексирован — значит виден. Очень важно, чтобы все страницы, которые нужно показать потенциальным клиентам, пользователям или читателям, проиндексировались. Иначе может получиться так: товар или услуга лучшие на рынке, статья полностью раскрывает суть вопроса, но если страницы вашего сайта отсутствуют в индексе поисковой системы — про это никто не узнает.

Именно поэтому важно уметь проверять индексацию.

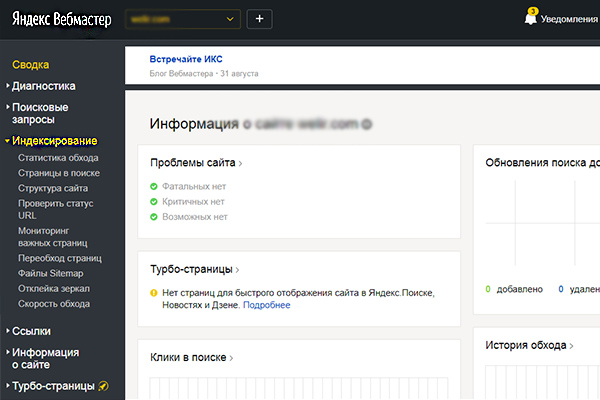

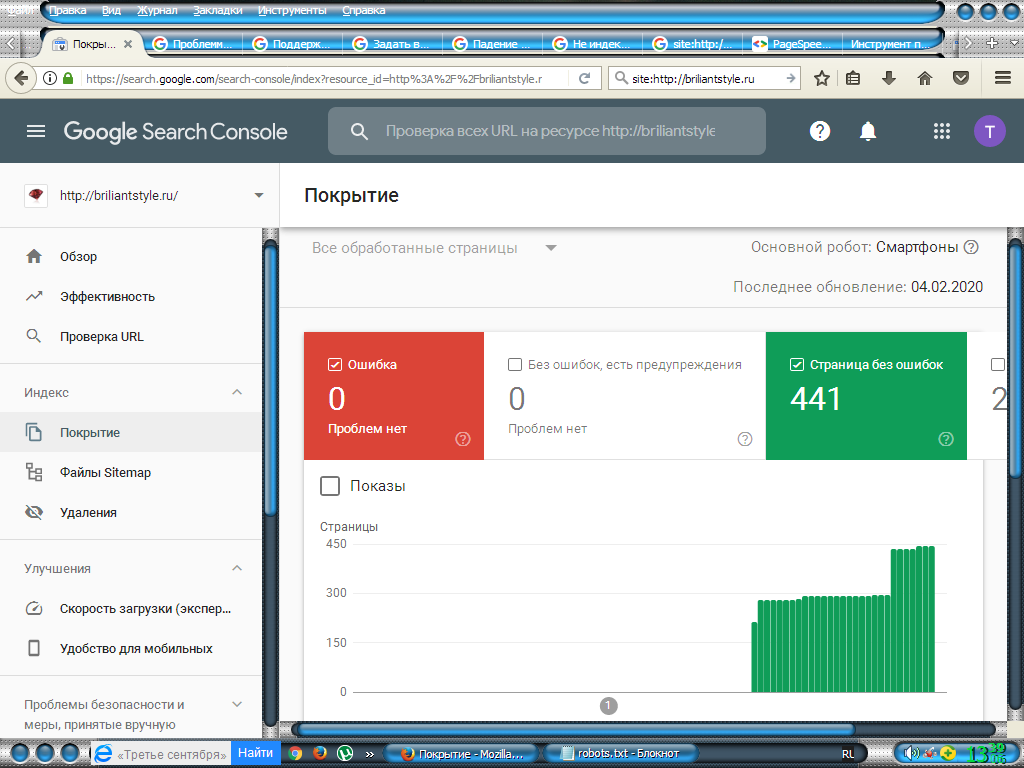

1. Проверка в Google Search Console

Это один из базовых способов проверки индексации для владельца сайта и веб-мастера.

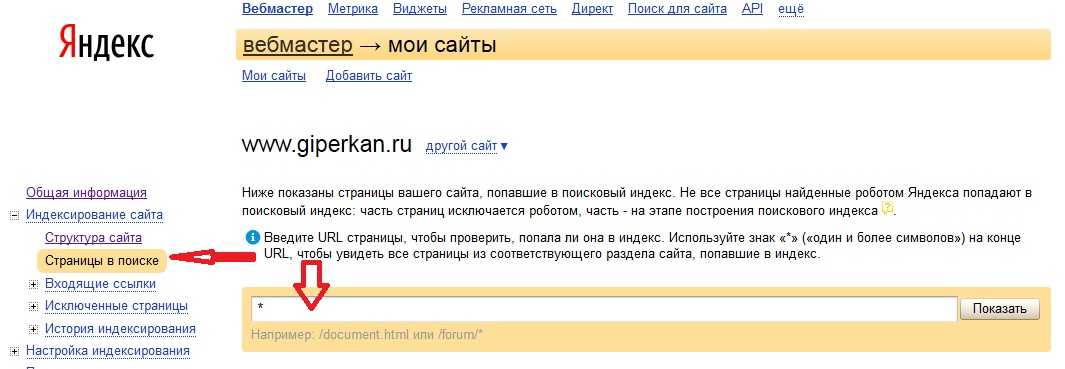

Войдите в ваш аккаунт на Search Console и перейдите по вкладке «Страницы» в разделе «Индексирование»:

В этом отчете вы найдете общую информацию о проиндексированных и непроиндексированных страницах с отображением на временной шкале:

Перейдя в полный отчет, увидите подробные данные о всех страницах, проверенных на индексацию:

Чтобы просмотреть отчет по неиндексируемым страницам и ошибкам индексации, вернитесь в раздел «Индексирование страниц»:

Кликнув на левую колонку «Причина», можно увидеть списки страниц сайта, недоступных к индексации:

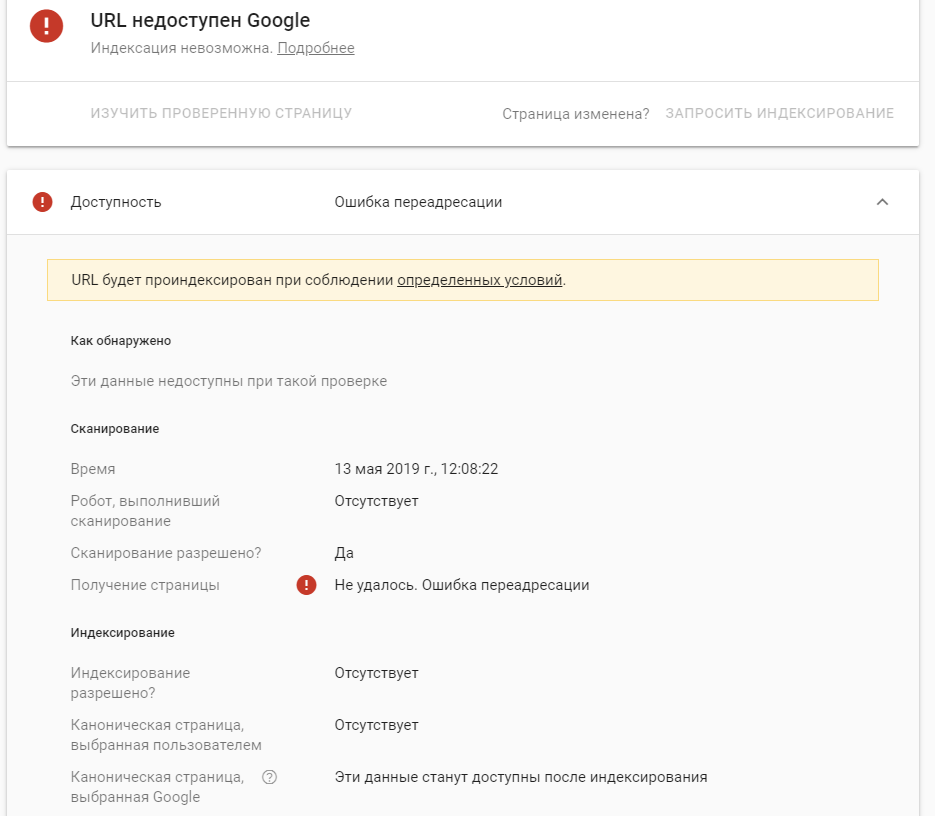

Как проверить индексацию конкретной страницы в Search Console?

Вставьте ссылку на интересующую вас страницу в строку поиска Search Console:

В результате проверки увидите одно из следующих сообщений:

- страница успешно проиндексирована;

- страница отсутствует в индексе.

Если вы внесли все необходимые изменения, но страница все еще отсутствует в индексе — отправьте запрос на пересканирование самостоятельно:

- Введите адрес страницы в инструменте проверки URL.

- Нажмите кнопку «Запросить индексирование».

Этот же способ можно использовать для ускорения индексации новых страниц сайта — но не более 10 в день.

При сканировании сразу нескольких страниц рекомендуется применять файл Sitemap.

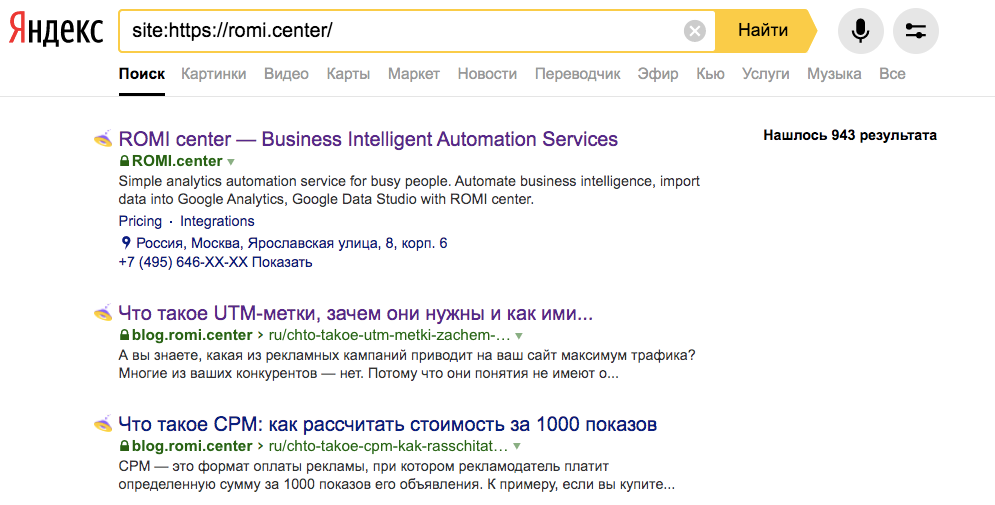

2. Анализ индексации сайта в Google поиске

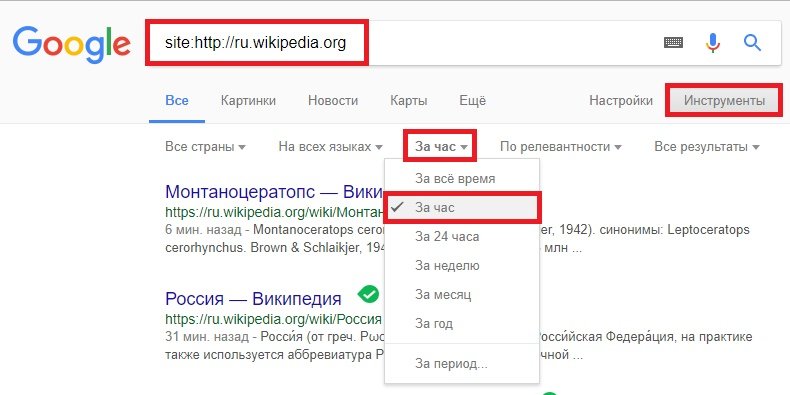

Поисковые операторы (например, «site:») помогают уточнить результаты поиска.

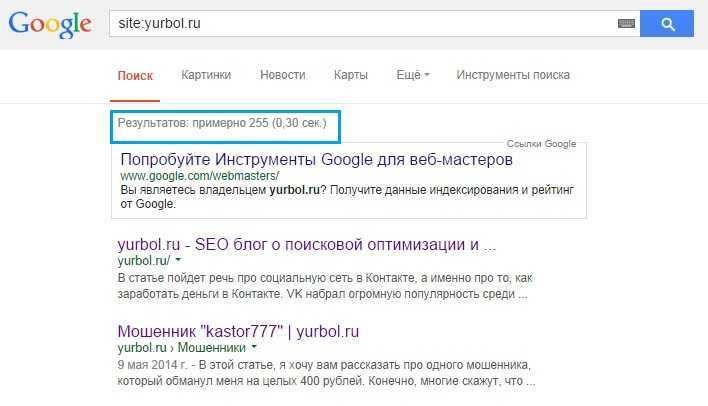

Чтобы узнать о наличии вашего сайта в индексе Google, наберите в строке поиска «site:[url вашего сайта]»:

Для проверки индексации конкретной страницы используйте оператор в формате «site:[url страницы вашего сайта]»:

Если сайт или страница успешно проиндексированы, они отобразятся в результатах поиска. Появится информация о приблизительном количестве страниц вашего сайта, которые индексировалось поисковой системой:

Кроме того, инструменты поиска могут проанализировать количество страниц, индексированных поисковой системой за определенный период времени:

3.

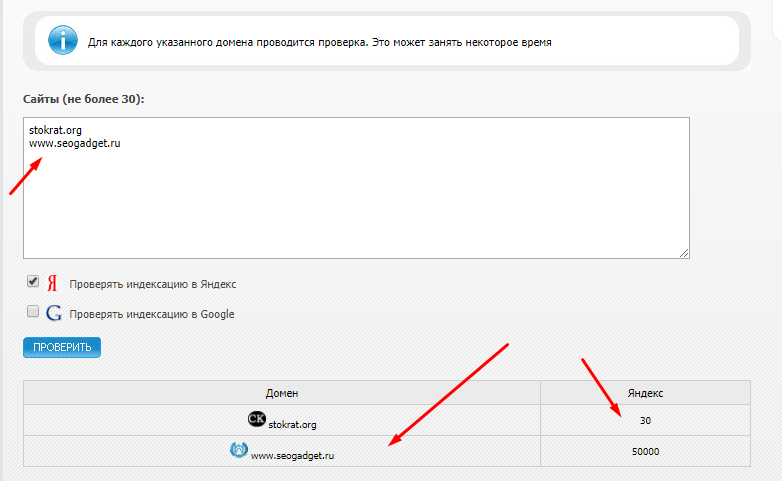

Проверка индексации онлайн с помощью сервисов

Проверка индексации онлайн с помощью сервисовСуществует большое количество бесплатных онлайн-сервисов для контроля индексации сайта, таких как linkody.com или smallseotools.com. Их недостаток — лимиты: от 5 до 50 страниц.

Однако, если ваш сайт подключен к Google Search Console, с помощью нового инструмента от Serpstat можно за один запрос проверить индексацию до 100 страниц.

- Перейдите в раздел «Инструменты» и выберите пункт «Индексация страниц»:

- Нажмите кнопку «Подключить Google Search Console» и войдите в сервис с помощью вашего аккаунта Google:

- После авторизации в верхней левой части страницы увидите список всех сайтов, к которым у вас есть доступ с помощью Google Search Console:

- Введите до 100 URL-адресов для проверки индексации сайта и нажмите кнопку «Проверить страницы». В правой части сервиса отобразятся результаты этой операции.

4.

SEO-инструменты для проверки сайтов

SEO-инструменты для проверки сайтовСпециальные программы, предназначенные для сканирования и анализа основных параметров сайта с целью выявления ошибок, могут также проверять индексацию.

При сканировании сайта в Netpeak Spider вы получите список страниц и значения параметров, влияющих на индексацию сайта: robots.txt, canonical, mета robots, X-Robots-Tag, наличие редиректов и др.:

Загрузив полученный список в Netpeak Checker, можно проверить наличие страницы или сайта в поисковой выдаче:

5. Букмарклеты

Букмарклеты (небольшие javascript-программы, сохраняемые как браузерные закладки) — автоматизированный вариант проверки.

Чтобы воспользоваться букмарклетом, откройте файл Проверка индексации и перетяните ссылку на панель закладок:

Затем найдите интересующую вас страницу либо сайт и просто нажмите на закладку. Появится новая вкладка Google с поисковым запросом, использованием уточняющего оператора «site:» и результатами индексации по запросу.

6. Индексатор Google Indexing API

Google Indexing API — бесплатный индексатор от Google, с помощью которого можно:

- узнать, когда последний раз Google получал информацию по запрошенному URL-адресу;

- отправить запрос на переиндексацию страницы;

- отправить запрос на удаление страницы из индекса.

Важным преимуществом Google Indexing API является возможность пакетных запросов индексирования, объединенных в один HTTP (до 100 штук). В день можно использовать не более 200 запросов, но если на ваших страницах внедрена разметка JobPosting или BroadcastEvent — вы можете подать заявку на увеличение квоты.

Подробнее о квотах индексатора и его подключении читайте в справке Google.

- Новый сайт. В зависимости от количества страниц, полная индексация нового сайта может занять у Googlebot от одной недели до 2-4 месяцев.

- Принудительное закрытие страниц от индексации.

Тег noindex запрещает индексирование страниц поисковому роботу. Для исключения проблем, вызванных неправильным применением тега noindex, необходимо проверить следующие директории:

Для исключения проблем, вызванных неправильным применением тега noindex, необходимо проверить следующие директории:

Метатег robots

Размещается в HTML коде и действует на уровне страницы. Пример метатега robots, запрещающего сканирование —

<meta name=»robots» content=»noindex» />

X-Robot-Tag

Является HTTP-заголовком, размещается в файле конфигурации сервера. Пример X-Robot-Tag, запрещающего сканирование —

X-Robots-Tag: noindex, nofollow

Файл robots.txt

С помощью robots.txt невозможно управлять непосредственно индексацией сайта, но неправильная конфигурация этого файла может привести к полному закрытию для сканирования поисковыми роботами.

Строка в robots.txt, полностью закрывающая сайт от сканирования —

User-agent: * Disallow: /

- Неправильное использование тега canonical. Тег canonical применяется для борьбы с дублирующимся контентом, который также может быть одной из причин плохой индексации сайта.

Он указывает поисковому роботу на предпочитаемую версию страницы. При сканировании URL-адрес, указанный в теге canonical, будет воспринят Googlebot как основная версия, среди похожих по содержанию страниц.

Он указывает поисковому роботу на предпочитаемую версию страницы. При сканировании URL-адрес, указанный в теге canonical, будет воспринят Googlebot как основная версия, среди похожих по содержанию страниц.

Помимо настроек, которые напрямую ограничивают или запрещают сканирование сайта, стоит отметить следующие факторы, негативно влияющие на скорость индексации:

- Отсутствие карты сайта sitemap.xml. Она помогает поисковым роботам понять его структуру и быстрее просканировать страницы.

- Отсутствие либо недостаточность внутренних ссылок. Правильная и равномерная перелинковка на сайте распределяет ссылочный вес страниц, а добавление ссылок на новые страницы сайта, а также страницы, которые уже находятся в индексе, помогает поисковым системам быстрее находить их.

- Скорость работы сайта. Googlebot не находится на сайте постоянно. Он лишь периодически сканирует контент его страниц. Медленная скорость загрузки сайта усложняет его индексацию и работу алгоритмов поискового робота.

- Качество контента. Последние обновления поисковой системы Google предполагают улучшение качества контента и создание авторитетных материалов — в первую очередь для людей, а не для манипуляции алгоритмами поиска. При оценке качества контента вашего сайта Google учитывает наличие орфографических ошибок, достоверность информации, оригинальность и другие факторы. Подробнее о создании полезного контента можно узнать в Google-справке.

- Отсутствие оптимизации мобильной версии. Для новых сайтов, созданных после 1 июля 2019 года, Google использует метод индексации Mobile-First index, отдающий предпочтение индексации мобильной версии сайта. Такое решение компании вызвано тем, что уже в 2016 году более половины запросов в Google выполнялись с мобильных устройств.

- Игнорирование ошибок в Google Search Console. Изучите отчет об ошибках в поисковой консоли Google. Посмотрите, какие из найденных ошибок, влияют на индексацию сайта и устраните их.

Так же проверьте, не подвергался ли ваш сайт ручным санкциям. Возможно, его доменное имя ранее было ограничено в связи с нарушением правил Google.

Так же проверьте, не подвергался ли ваш сайт ручным санкциям. Возможно, его доменное имя ранее было ограничено в связи с нарушением правил Google.

Возможности Googlebot по сканированию сайта ограничиваются краулинговым бюджетом — лимитом на проверку страниц за один визит. Узнать приблизительный краулинговый бюджет вашего сайта можно в Search Console (раздел «Индексация») — просмотрите отчет по количеству страниц, обработанных за месяц поисковой системой:

Краулинговый бюджет меняется по заложенному поисковой системой алгоритму: в зависимости от размера сайта, скорости его работы и потребностей. Если обнаружено много ошибок или мусорных страниц, бюджет может расходоваться быстрее.

Факторы, негативно влияющие на краулинговый бюджет:

- дубли страниц;

- неуникальный контент;

- битые ссылки;

- слишком большое количество редиректов;

- медленная скорость работы сайта.

Как управлять краулинговым бюджетом?

Помимо фактического управления краулинговым бюджетом с помощью индексатора Google Index API, уменьшить его расход можно с помощью технической оптимизации и улучшения качества контента.

Файл sitemap.xml.

Проверьте содержимое XML-карты сайта, убедитесь, что все указанные в ней страницы открыты к индексации и отдают код ответа сервера 200, установите автоматические добавление новых страниц (открытых к индексации) в файл sitemap.xml.

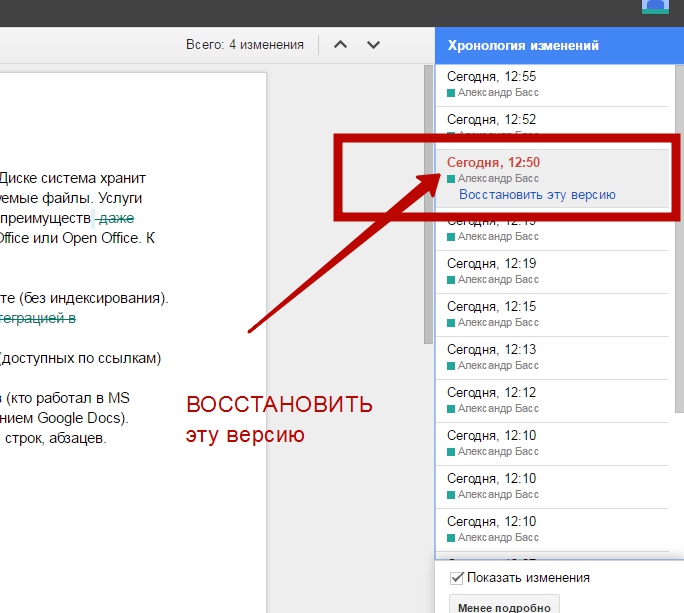

Дата изменения страницы.

Настройте HTTP заголовки Last-Modified и If-Modified-Since, чтобы указать Googlebot на страницы, контент которых не изменился с его последнего посещения (они не требуют повторного сканирования).

Оптимизация скорости загрузки сайта.

Время ответа сервера не должно превышать 200 мс, а скорость загрузки страницы — 3-5 секунд. Проверьте скорость работы сайта с помощью PageSpeed Insights, оптимизируйте страницы исходя из рекомендаций.

Редиректы и битые страницы.

Не допускайте большого количества редиректов и битых страниц на сайте. В противном случае, вместо посещения нового контента, Googlebot будет расходовать свой краулинговый бюджет на переходы по неработающим позициям.

Оптимизация перелинковки.

Добавьте ссылки на новый контент на главную страницу сайта, выведите превью анонса недавних статей, покажите новинки товаров. Организуйте перелинковку между старыми и свежими материалами, разместите ссылки на новые страницы в соцсетях — это поможет поисковому роботу быстрее их найти и просканировать.

Частота обновления сайта.

Поисковые системы отдают предпочтение актуальной и качественной информации. Регулярно обновляйте содержимое своего сайта, добавляйте новый контент не реже, чем раз в неделю, актуализируйте и дополняйте информацию на старых страницах.

Запомнить

Шесть способов самостоятельно проверить индексацию сайта или страницы:

- В Google Search Console.

- С помощью операторов поиска.

- Онлайн-сервисами.

- SEO-инструментами, например, Netpeak Spider или Netpeak Checker.

- Используя букмарклеты.

- Google Indexing API.

Для улучшения индексации сайта:

- Настройте и оптимизируйте карту сайта sitemap.

xml.

xml. - Проверьте настройки файла robots.txt и использование тега noindex.

- Следите за количеством редиректов и наличием битых страниц.

- Работайте над перелинковкой сайта.

- Улучшите скорость загрузки страниц.

- Создавайте качественный контент и регулярно работайте над его обновлением и улучшением.

- Оптимизируйте расходование краулингового бюджета.

- Не забывайте о мобильной версии сайта.

- Регулярно изучайте отчеты об ошибках в Google Search Console.

Что такое Googlebot и как он работает?

Патрик Стокс

Патрик Стокс — консультант по продуктам, специалист по технической оптимизации и представитель бренда Ahrefs. Он является организатором Raleigh SEO Meetup, Raleigh SEO Conference, Beer & SEO Meetup, Findability Conference и модератором /r/TechSEO.

Показывает, сколько разных веб-сайтов ссылаются на этот фрагмент контента. Как правило, чем больше веб-сайтов ссылаются на вас, тем выше ваш рейтинг в Google.

Показывает приблизительный месячный поисковый трафик к этой статье по данным Ahrefs. Фактический поисковый трафик (по данным Google Analytics) обычно в 3-5 раз больше.

Сколько раз этой статьей поделились в Твиттере.

Поделитесь этой статьей

Получите лучший маркетинговый контент недели

Подписка по электронной почте

Подписка

Содержание

Googlebot — это поисковый робот, используемый Google для сбора необходимой информации и создания доступного для поиска индекса в Интернете. У робота Google есть сканеры для мобильных и настольных компьютеров, а также специализированные сканеры для новостей, изображений и видео.

Есть и другие сканеры, которые Google использует для определенных задач, и каждый сканер идентифицирует себя с помощью отдельной текстовой строки, которая называется «пользовательский агент». Робот Googlebot является вечнозеленым, то есть он видит веб-сайты так же, как пользователи в последнем браузере Chrome.

Робот Googlebot работает на тысячах компьютеров. Они определяют, как быстро и что сканировать на веб-сайтах. Но они замедлят сканирование, чтобы не перегружать веб-сайты.

Давайте посмотрим на их процесс создания индекса сети.

Как робот Googlebot сканирует и индексирует веб-сайты

В прошлом компания Google поделилась несколькими версиями своего конвейера. Ниже самое последнее.

Он снова обрабатывает это и ищет любые изменения на странице или новые ссылки. Контент визуализированных страниц — это то, что хранится и доступно для поиска в индексе Google. Любые новые найденные ссылки возвращаются в корзину URL-адресов для сканирования.

Более подробная информация об этом процессе содержится в нашей статье о том, как работают поисковые системы.

Как управлять роботом Googlebot

Google предлагает несколько способов управления тем, что сканируется и индексируется.

Способы контроля сканирования

- Robots.

txt – Этот файл на вашем веб-сайте позволяет вам контролировать, что сканируется.

txt – Этот файл на вашем веб-сайте позволяет вам контролировать, что сканируется. - Nofollow – Nofollow – это атрибут ссылки или метатег робота, предполагающий, что по ссылке не следует переходить. Это всего лишь подсказка, поэтому ее можно игнорировать.

- Изменить скорость сканирования – Этот инструмент в Google Search Console позволяет замедлить сканирование Google.

Способы контроля индексации

- Удалить свой контент – Если вы удалите страницу, то индексировать будет нечего. Недостатком этого является то, что никто другой не может получить к нему доступ.

- Ограничить доступ к контенту – Google не входит на веб-сайты, поэтому любая защита паролем или аутентификация не позволит ему увидеть контент.

- Noindex – noindex в метатеге robots указывает поисковым системам не индексировать вашу страницу.

- Инструмент для удаления URL – Название этого инструмента от Google немного вводит в заблуждение, так как он работает так, что временно скрывает содержимое.

Google по-прежнему будет видеть и сканировать этот контент, но страницы не будут отображаться в результатах поиска.

Google по-прежнему будет видеть и сканировать этот контент, но страницы не будут отображаться в результатах поиска. - Robots.txt (только изображения) – Блокировка Googlebot Image от сканирования означает, что ваши изображения не будут проиндексированы.

Если вы не уверены, какой элемент управления индексацией вам следует использовать, ознакомьтесь с нашей блок-схемой в нашем посте об удалении URL-адресов из поиска Google.

Это действительно робот Google?

Многие инструменты SEO и некоторые вредоносные боты выдают себя за Googlebot. Это может позволить им получить доступ к веб-сайтам, которые пытаются их заблокировать.

Раньше для проверки робота Googlebot нужно было выполнять поиск в DNS. Но недавно Google сделал это еще проще и предоставил список общедоступных IP-адресов, которые вы можете использовать для проверки того, что запросы исходят от Google. Вы можете сравнить это с данными в журналах вашего сервера.

У вас также есть доступ к отчету «Статистика сканирования» в Google Search Console. Если вы перейдете к Настройки > Статистика сканирования , отчет будет содержать много информации о том, как Google сканирует ваш сайт. Вы можете увидеть, какой робот Googlebot сканирует какие файлы и когда он к ним обращался.

Если вы перейдете к Настройки > Статистика сканирования , отчет будет содержать много информации о том, как Google сканирует ваш сайт. Вы можете увидеть, какой робот Googlebot сканирует какие файлы и когда он к ним обращался.

Заключительные мысли

Сеть — большое и грязное место. Роботу Google необходимо пройти через все различные настройки, а также время простоя и ограничения, чтобы собрать данные, необходимые Google для работы его поисковой системы.

В завершение забавный факт заключается в том, что Googlebot обычно изображается в виде робота, и его метко называют «Googlebot». Также есть талисман паука по имени Кроули.

Остались вопросы? Дайте мне знать в Твиттере.

Подробное руководство по работе поиска Google | Центр поиска Google | Документация

Поиск Google – это полностью автоматизированная поисковая система, использующая программное обеспечение, известное как поисковые роботы.

регулярно исследуйте Интернет, чтобы найти страницы для добавления в наш индекс. На самом деле, подавляющее большинство

страницы, перечисленные в наших результатах, не отправляются вручную для включения, а обнаруживаются и добавляются

автоматически, когда наши поисковые роботы исследуют Интернет. Этот документ объясняет этапы того, как

Поиск работает в контексте вашего сайта. Наличие этих базовых знаний может помочь вам исправить

проблем со сканированием, проиндексируйте свои страницы и узнайте, как оптимизировать внешний вид вашего сайта в

Поиск Гугл.

На самом деле, подавляющее большинство

страницы, перечисленные в наших результатах, не отправляются вручную для включения, а обнаруживаются и добавляются

автоматически, когда наши поисковые роботы исследуют Интернет. Этот документ объясняет этапы того, как

Поиск работает в контексте вашего сайта. Наличие этих базовых знаний может помочь вам исправить

проблем со сканированием, проиндексируйте свои страницы и узнайте, как оптимизировать внешний вид вашего сайта в

Поиск Гугл.

Несколько замечаний, прежде чем мы начнем

Прежде чем мы углубимся в детали работы Поиска, важно отметить, что Google не

принимать оплату, чтобы чаще сканировать сайт или повышать его рейтинг. Если кто-нибудь скажет вам

в противном случае они ошибаются.

Google не гарантирует, что он будет сканировать, индексировать или обслуживать вашу страницу, даже если она следует за Google Search Essentials.

Знакомство с тремя этапами поиска Google

Поиск Google работает в три этапа, и не все страницы проходят каждый этап:

- Сканирование: Google загружает текст, изображения и видео со страниц, найденных в Интернете с помощью автоматических программ, называемых поисковыми роботами.

- Индексирование: Google анализирует текст, изображения и видеофайлы на странице и сохраняет информацию в индексе Google, который является большим база данных.

- Обслуживание результатов поиска: Когда пользователь выполняет поиск на

Google, Google возвращает информацию, относящуюся к запросу пользователя.

Ползание

Первый этап — выяснить, какие страницы существуют в Интернете. Нет центрального реестра все веб-страницы, поэтому Google должен постоянно искать новые и обновленные страницы и добавлять их в свои список известных страниц. Этот процесс называется «обнаружение URL». Некоторые страницы известны, потому что Гугл их уже посещал. Другие страницы обнаруживаются, когда Google переходит по ссылке из известной страницы на новую страницу: например, центральная страница, такая как страница категории, ссылается на новую Сообщение блога. Другие страницы обнаруживаются, когда вы отправляете список страниц ( карта сайта) для сканирования Google.

Как только Google обнаружит URL-адрес страницы, он может посетить (или «просканировать») страницу, чтобы узнать, что находится на ней.

это. Мы используем огромное количество компьютеров для сканирования миллиардов страниц в Интернете. Программа, которая

выборка называется Googlebot

(также известный как сканер, робот, бот или паук). Googlebot использует алгоритмический процесс для

определить, какие сайты сканировать, как часто и сколько страниц получать с каждого сайта.

Поисковые роботы Google

также запрограммированы таким образом, что стараются не сканировать сайт слишком быстро, чтобы не перегружать его.

Этот механизм основан на ответах сайта (например,

Ошибки HTTP 500 означают «медленнее»)

и

настройки в Search Console.

Программа, которая

выборка называется Googlebot

(также известный как сканер, робот, бот или паук). Googlebot использует алгоритмический процесс для

определить, какие сайты сканировать, как часто и сколько страниц получать с каждого сайта.

Поисковые роботы Google

также запрограммированы таким образом, что стараются не сканировать сайт слишком быстро, чтобы не перегружать его.

Этот механизм основан на ответах сайта (например,

Ошибки HTTP 500 означают «медленнее»)

и

настройки в Search Console.

Однако робот Googlebot не сканирует все обнаруженные страницы. Некоторые страницы могут быть запрещен для сканирования владельцем сайта, другие страницы могут быть недоступны без авторизации на сайте.

Во время сканирования Google отображает страницу и

запускает любой найденный JavaScript

используя последнюю версию

Chrome, подобно тому, как ваш

браузер отображает страницы, которые вы посещаете. Рендеринг важен, потому что веб-сайты часто полагаются на

JavaScript для доставки контента на страницу, и без рендеринга Google может этого не увидеть.

содержание.

Рендеринг важен, потому что веб-сайты часто полагаются на

JavaScript для доставки контента на страницу, и без рендеринга Google может этого не увидеть.

содержание.

Сканирование зависит от того, могут ли поисковые роботы Google получить доступ к сайту. Некоторые распространенные проблемы с Доступ к сайтам робота Googlebot включает:

- Проблемы с сервером, обрабатывающим сайт

- Проблемы с сетью

- Правила robots.txt, запрещающие роботу Googlebot доступ к странице

Индексация

После сканирования страницы Google пытается понять, о чем эта страница. Этот этап

называется индексированием и включает в себя обработку и анализ текстового контента и ключевого контента

теги и атрибуты, такие как <название> элементов

и атрибуты alt,

изображений,

видео и

более.

В процессе индексации Google определяет, является ли страница дубликат другой страницы в Интернете или канонической. Каноническая — это страница, которая может отображаться в результатах поиска. Для выбора канонического мы сначала сгруппируйте вместе (также известное как кластеризация) страницы, которые мы нашли в Интернете, которые имеют схожее содержание, а затем мы выбираем тот, который наиболее репрезентативен для группы. другие страницы в группе являются альтернативными версиями, которые могут обслуживаться в другом контексте, например если пользователь ищет с мобильного устройства или ищет очень конкретную страницу из тот кластер.

Google также собирает сигналы о канонической странице и ее содержании, которые могут использоваться в

следующий этап, где мы обслуживаем страницу в результатах поиска. Некоторые сигналы включают язык

страницы, страны, в которой находится контент, удобство использования страницы и т. д.

д.

Собранная информация о канонической странице и ее кластере может храниться в Google index, большая база данных, размещенная на тысячах компьютеров. Индексация не гарантируется; не каждый страница, которую обрабатывает Google, будет проиндексирована.

Индексация также зависит от содержания страницы и ее метаданных. Некоторые распространенные проблемы с индексацией может включать:

- Качество контента на странице низкое

- Роботы

мета-правилазапрещают индексирование - Дизайн сайта может затруднить индексацию

Обслуживание результатов поиска

Google не принимает плату за повышение ранжирования страниц, а ранжирование выполняется программно. Узнайте больше о рекламе в поиске Google. Когда пользователь вводит запрос, наши машины ищут в индексе соответствующие страницы и возвращают

результаты, которые мы считаем наиболее качественными и наиболее соответствующими запросу пользователя.

Он указывает поисковому роботу на предпочитаемую версию страницы. При сканировании URL-адрес, указанный в теге canonical, будет воспринят Googlebot как основная версия, среди похожих по содержанию страниц.

Он указывает поисковому роботу на предпочитаемую версию страницы. При сканировании URL-адрес, указанный в теге canonical, будет воспринят Googlebot как основная версия, среди похожих по содержанию страниц.

Так же проверьте, не подвергался ли ваш сайт ручным санкциям. Возможно, его доменное имя ранее было ограничено в связи с нарушением правил Google.

Так же проверьте, не подвергался ли ваш сайт ручным санкциям. Возможно, его доменное имя ранее было ограничено в связи с нарушением правил Google.  xml.

xml. txt – Этот файл на вашем веб-сайте позволяет вам контролировать, что сканируется.

txt – Этот файл на вашем веб-сайте позволяет вам контролировать, что сканируется. Google по-прежнему будет видеть и сканировать этот контент, но страницы не будут отображаться в результатах поиска.

Google по-прежнему будет видеть и сканировать этот контент, но страницы не будут отображаться в результатах поиска.