Robots.txt — как настроить и загрузить на сайт

Михаил Шумовский

07 октября, 2022

Кому нужен robots.txt Как настроить robots.txt Как создать robots.txt Требования к файлу robots.txt Как проверить правильность Robots.txt

Мы в Telegram

В канале «Маркетинговые щи» только самое полезное: подборки, инструкции, кейсы.

Не всегда на серьёзных щах — шуточки тоже шутим =)

Подписаться

Станьте email-рокером 🤘

Пройдите бесплатный курс и запустите свою первую рассылку

Подробнее

Robots.txt — документ, который нужен для индексирования и продвижения сайта.

Если у сайта нет robots.txt, поисковые роботы считают все страницы ресурса открытыми для индексирования. Если файл есть, владелец сайта может запретить роботам индексировать определённые страницы.

Например, контентным ресурсам или медиа можно работать без robots.txt — тут все страницы участвуют в индексации.

На других ресурсах могут быть страницы, которые не нужно показывать поисковым роботам:

- Админ-панели сайта: пути, которые начинаются с /user, /admin, /administrator и т.д.

- Пустые страницы ресурса: если на них нет контента, в индексации они не помогут.

- Формы регистрации.

- Личные страницы в интернет-магазинах: кабинеты пользователей, корзины и т.

д.

д.

Начну с основных параметров.

User-agent: Yandex

Disallow: catalog/

Allow: /catalog/cucumbers/

Sitemap: http://www.example.com/sitemap.xml

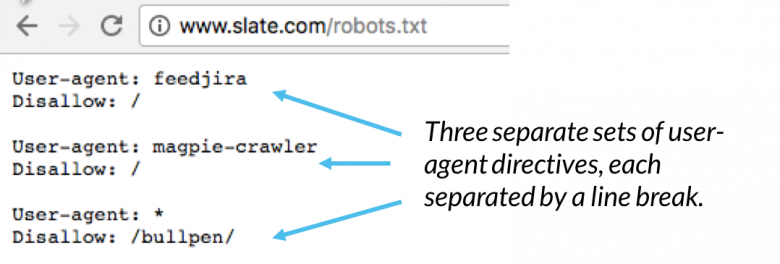

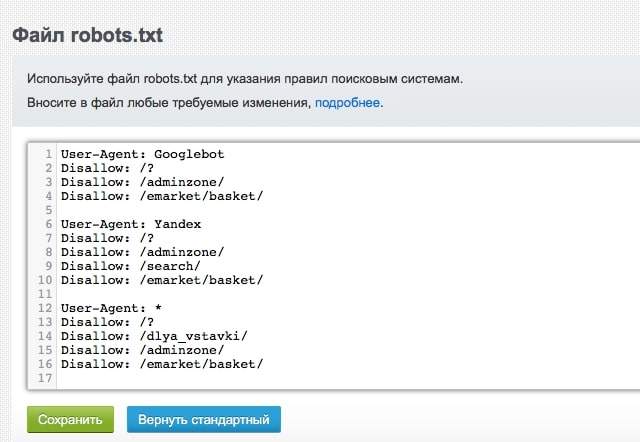

User-agent — указывает название робота, к которому применяется правило. Например, User-agent: Yandex означает, что правило применяется к роботу Яндекса.

А user-agent: * означает, что правило применяется ко всем роботам. Но о звёздочках поговорим ниже.

Основные типы роботов, которые можно указать в User-agent:

- Yandex. Все роботы Яндекса.

- YandexBot. Основной робот Яндекса

- YandexImages. Индексирует изображения.

- YandexMedia. Индексирует видео и другие мультимедийные данные.

- Google. Все роботы Google.

- Googlebot. Основной робот Google.

- Googlebot-Image.

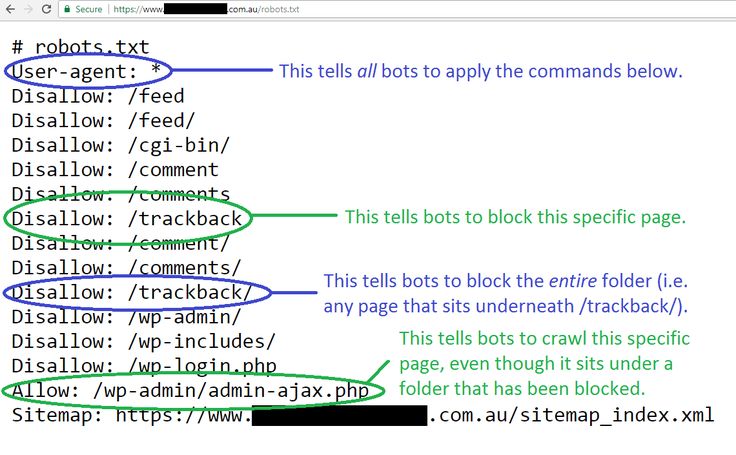

Disallow. Указывает на каталог или страницу ресурса, которые роботы индексировать не будут. Если нельзя индексировать конкретную страницу, например, определённый раздел в каталоге, нужно указывать полный путь к ней — как в поисковой строке браузера.

В начале строки должен быть символ /. Если правило касается каталога, строка должна заканчиваться символом /.

Например, disallow: /catalog/gloves. Так мы запретим индексацию раздела с перчаткам.

Если оставить disallow пустым, роботы будут индексировать все страницы сайта.

Allow. Указывает на каталог или страницу, которые можно сканировать роботу. Его используют, чтобы внести исключения в пункт

Если требуется индексировать конкретную страницу, нужно указывать к ней полный путь. Как и в disallow. Например, allow: /story/marketing. Так мы разрешили индексировать статью о маркетинге.

Так мы разрешили индексировать статью о маркетинге.

Если правило касается каталога, строка должна заканчиваться символом /.

Если allow пустой, робот не будет индексировать никакие страницы.

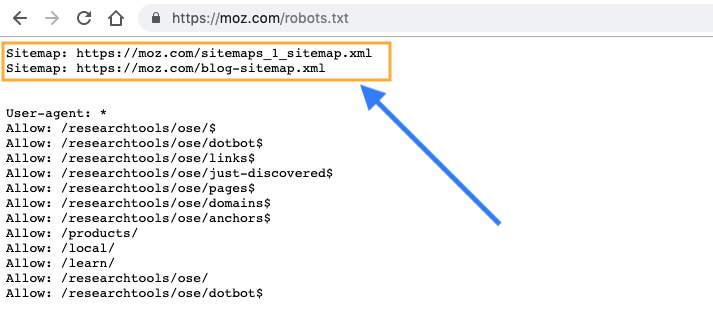

Sitemap. Необязательная директива, которая может повторяться несколько раз или не использоваться совсем. Её используют, чтобы описать структуру сайта и помочь роботам индексировать страницы.

Лендингам и небольшим сайтам sitemap не нужен. А вот таким ресурсам без sitemap не обойтись:

- Cайтам без хлебных крошек (навигационных цепочек).

- Большим ресурсам. Например, если сайт содержит большой объём мультимедиа или новостного контента.

- Сайтам с глубокой вложенностью. Например, «Главная/Каталог/Перчатки/Резиновые».

- Молодым ресурсам, на которые мало внешних ссылок, — их роботам сложно найти.

- Сайтам с большим архивом страниц, которые изолированы или не связаны друг с другом.

Файл нужно прописывать в XML-формате. Создание sitemap — тема для отдельной статьи. Подробную инструкцию читайте на Google Developers или в Яндекс.Справке.

Основные моменты robots.txt разобрали. Теперь расскажу про дополнительные параметры, которые используют в коде.

Для начала посмотрим на robots.txt Unisender. Для этого в поисковой строке браузера пишем Unisender.com/robots.txt.

По такой же формуле можно проверять файлы на всех сайтах: URL сайта + домен/robots.txt.

Robots.txt Unisender отличается от файла, который я приводил в пример. Дело в том, что здесь использованы дополнительные параметры:

Директива # (решётка) — комментарий. Решётки прописывают для себя, а поисковые роботы комментариев не видят.

User-agent: Yandex

Allow: /example/* # разрешает ‘/example/blog’

# разрешает ‘/example/blog/test’

Звёздочку роботы видят, а решётку — нет

Директива * (звёздочка) — любая последовательность символов после неё.

Например, если поставить звёздочку в поле disallow, то всё, что находится на её месте, будет запрещено.

User-agent: Yandex

Disallow: /example/* # запрещает ‘/example/blog’

# запрещает ‘/example/blog/test’

Disallow: */shop # запрещает не только ‘/shop’,

# но и ‘/example/shop’

Также и с полем allow: всё, что стоит на месте звёздочки, — разрешено для индексации.

User-agent: Yandex

Allow: /example/* # разрешает ‘/example/blog’

# разрешает ‘/example/blog/test’

Allow: */shop # разрешает не только ‘/shop’,

# но и ‘/example/shop’

Например, у Google есть особенность: компания рекомендует не закрывать от поисковых роботов файлы с css-стилями и js-скриптами. Вот как это нужно прописывать:

User-agent: Googlebot

Disallow: /site

Allow: *.css

Allow: *. js

js

Директива $ (знак доллара) — точное соответствие указанному параметру.

Например, использование доллара в disallow запретит доступ к определённому пути.

User-agent: Yandex

Disallow: /example # запрещает ‘/example’,

# запрещает ‘/example.html’

Disallow: /example$ # запрещает ‘/example’,

# не запрещает ‘/example1’

# не запрещает ‘/example-new’

Таким способом можно исключить из сканирования все файлы определённого типа, например, GIF или JPG. Для этого нужно совместить * и $. Звёздочку ставим до расширения, а $ — после.

User-agent: Yandex

Disallow: / *.gif$ # вместо * могут быть любые символы,

# $ запретит индексировать файлы gif

Директива Clean-param — новый параметр Яндекс-роботов, который не будет сканировать дублированную информацию и поможет быстрее анализировать ресурс.

Дело в том, что из-за повторяющейся информации роботы медленнее проверяют сайт, а изменения на ресурсе дольше попадают в результаты поиска. Когда роботы Яндекса увидят эту директиву, не будут несколько раз перезагружать дубли информации и быстрее проверят сайт, а нагрузка на сервер снизится.

www.example.com/dir/get_card.pl?ref=site_1&card_id=10

www.example.com/dir/get_card.pl?ref=site_2&card_id=10

Параметр ref нужен, чтобы отследить, с какого ресурса сделан запрос. Он не меняет содержимое страницы, значит два адреса покажут одну и ту же страницу с книгой card_id=10. Поэтому директиву можно указать так:

User-agent: Yandex

Disallow:

Clean-param: ref /dir/get_card.pl

Робот Яндекса сведёт страницы к одной: www.example.com/dir/get_card.pl?card_id=10

Чтобы директива применялась к параметрам на страницах по любому адресу, не указывайте адрес:

User-agent: Yandex

Disallow:

Clean-param: utm

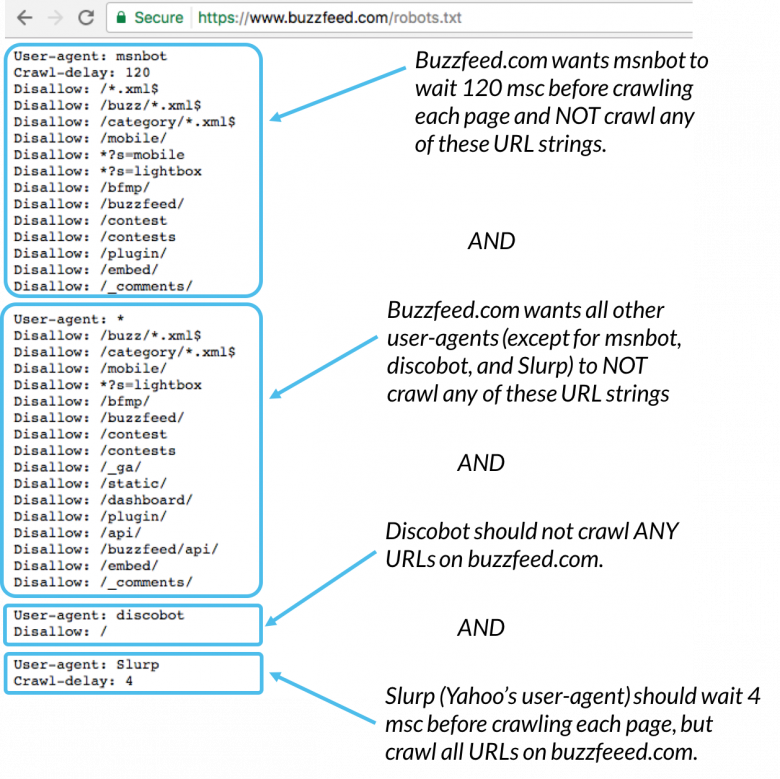

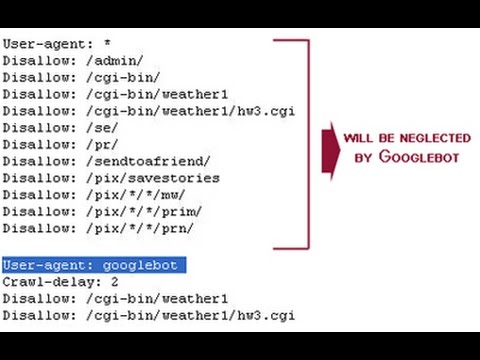

Директива Crawl-delay — устанавливает минимальный интервал в секундах между обращениями робота к сайту. Это помогает снизить нагрузку на сервер ресурса. Чем выше указанное значение, тем меньше страниц робот загрузит за сессию.

Это помогает снизить нагрузку на сервер ресурса. Чем выше указанное значение, тем меньше страниц робот загрузит за сессию.

Значения можно указывать целыми или дробными числами через точку.

User-agent: Yandex

Disallow:

Crawl-delay: 0.5

Для Яндекса максимальное значение в crawl-delay — 2. Более высокое значение можно установить инструментами Яндекс.Вебмастер.

Для Google-бота можно установить частоту обращений в панели вебмастера Search Console.

Директива Host — инструкция для робота Яндекса, которая указывает главное зеркало сайта. Нужна, если у сайта есть несколько доменов, по которым он доступен. Вот как её указывают:

User-agent: Yandex

Disallow: /example/

Host: example.ru

Если главное зеркало сайта — домен с протоколом HTTPS, его указывают так:

Host: https://site.ru

Как создать robots.txtСпособ 1. Понадобится текстовый редактор: блокнот, TextEdit, Vi, Emacs или любой другой. Не используйте приложения Microsoft Office, потому что они сохраняют файлы в неподходящем формате или добавляют в них лишние символы, которые не распознаются поисковыми роботами.

Не используйте приложения Microsoft Office, потому что они сохраняют файлы в неподходящем формате или добавляют в них лишние символы, которые не распознаются поисковыми роботами.

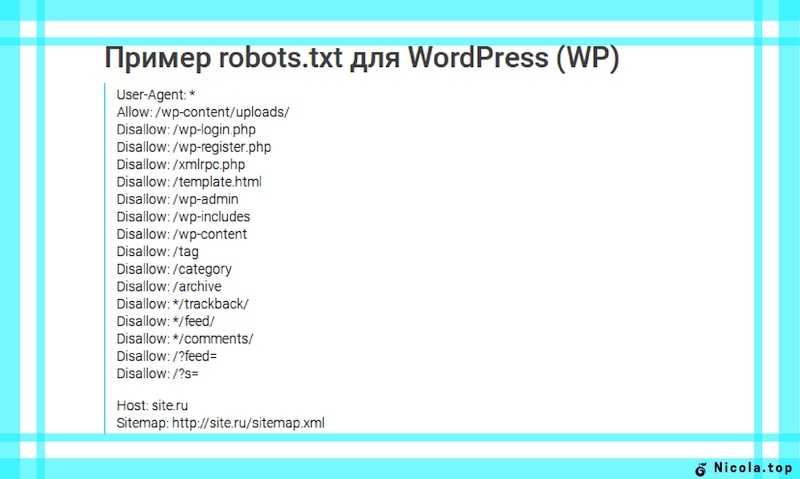

Способ 2. Создать на CMS с помощью плагинов — в этом случае robots.txt установится сам.

Если вы используете CMS хостинга, редактировать файл robots.txt не потребуется. Скорее всего, у вас даже не будет такой возможности. Вместо этого провайдер будет указывать поисковым системам, нужно ли сканировать контент, с помощью страницы настроек поиска или другого инструмента.

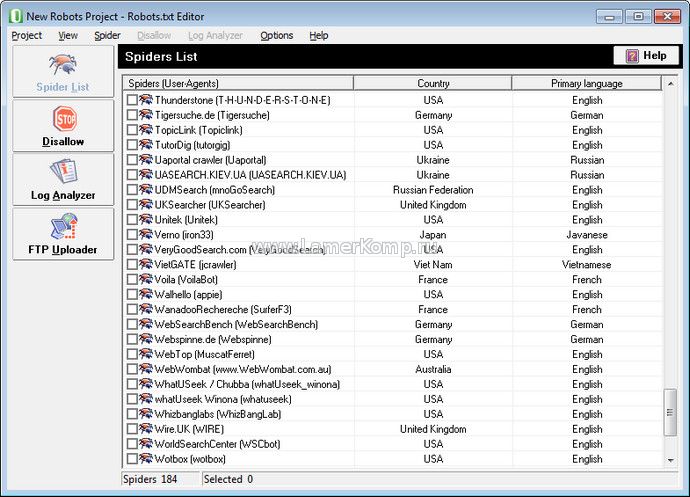

Способ 3. Воспользоваться генератором robots.txt — век технологий всё-таки.

Сгенерировать файл можно на PR-CY, IKSWEB, Smallseotools.

Требования к файлу robots.txtКогда создадите текстовый файл, сохраните его в кодировке utf-8. Иначе поисковые роботы не смогут прочитать документ. После создания загрузите файл в корневую директорию на сайте хостинг-провайдера. Корневая директория — это папка public. html.

html.

Папка, в которой нужно искать robots.txt. Источник

Если файла нет, его придётся создавать самостоятельно.

Требования, которым должен соответствовать robots.txt:

- Каждая директива начинается с новой строки.

- Одна директива в строке, сам параметр также написан в одну строку.

- В начале строки нет пробелов.

- Нет кавычек в директивах.

- Директивы не нужно закрывать точкой или точкой с запятой.

- Файл должен называться robots.txt. Нельзя называть его Robots.txt или ROBOTS.TXT.

- Размер файла не должен превышать 500 КБ.

- robots.txt должен быть написан на английском языке. Буквы других алфавитов не разрешаются.

Если файл не соответствует одному из требований, весь сайт считается открытым для индексирования.

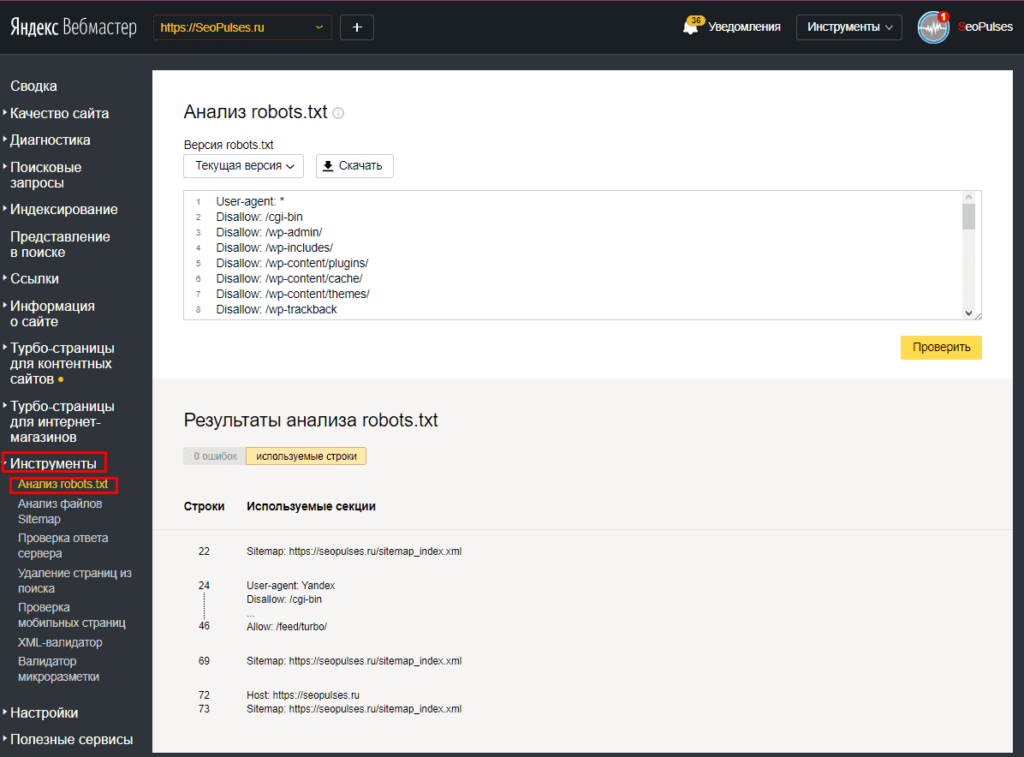

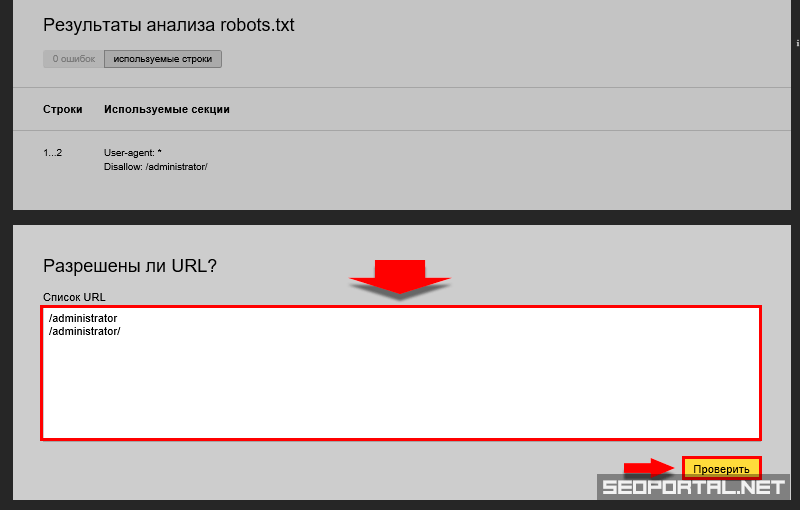

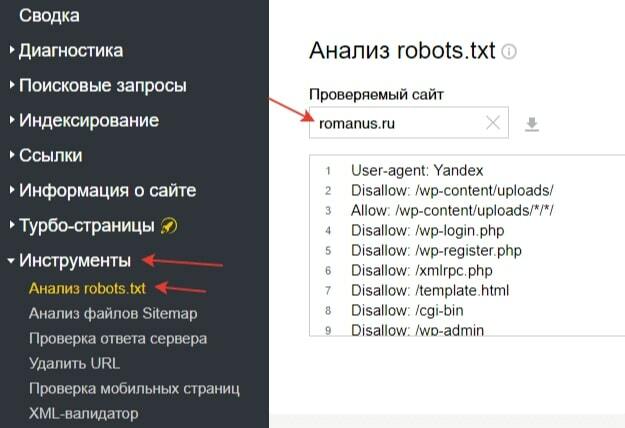

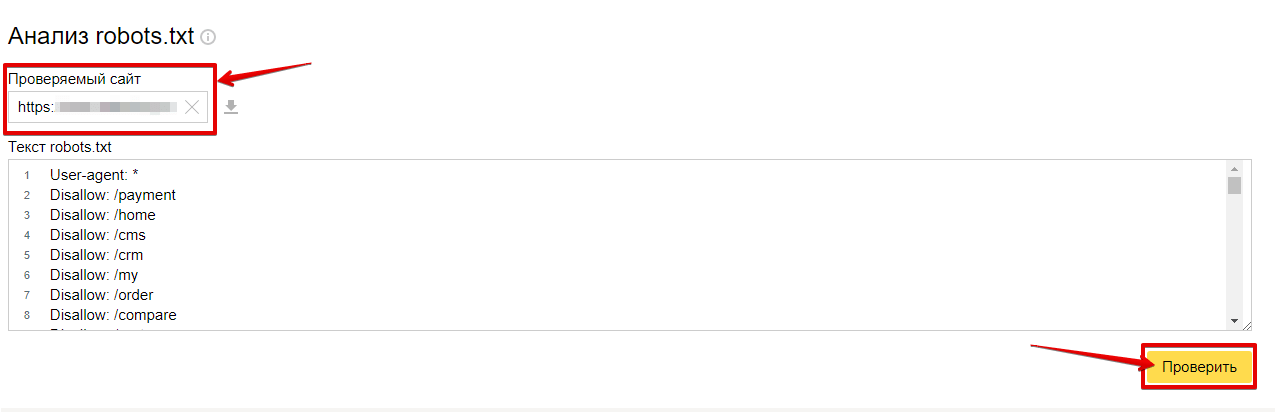

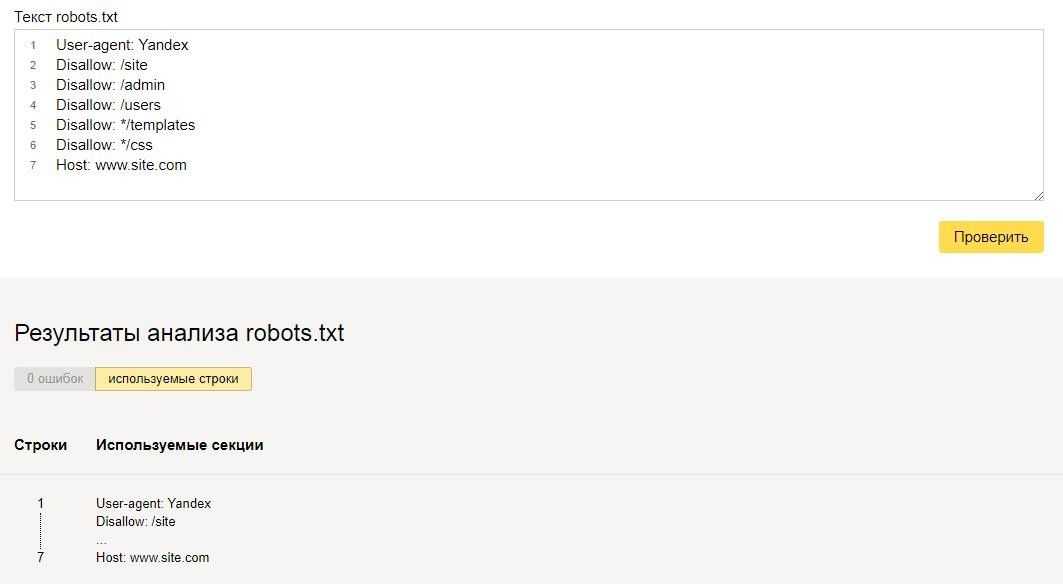

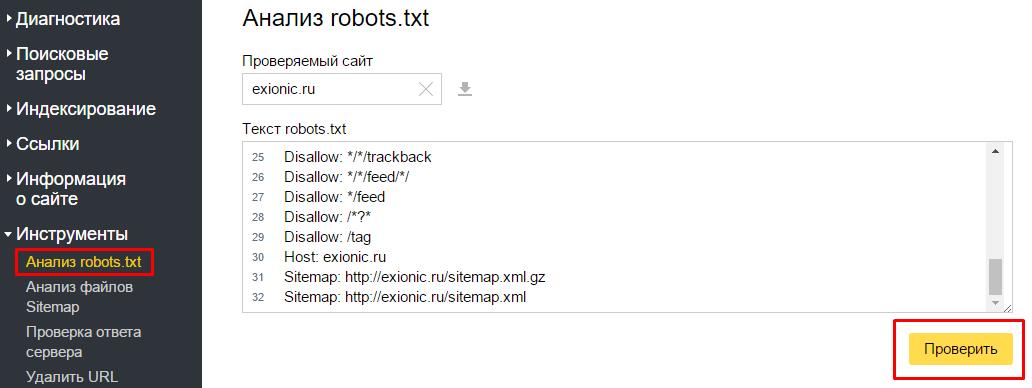

Как проверить правильность Robots.txtПроверить robots. txt помогают сервисы от Яндекс и Google. В Яндексе можно проверять файл даже без сайта — например, если вы написали robots.txt, но пока не загрузили его на сайт.

txt помогают сервисы от Яндекс и Google. В Яндексе можно проверять файл даже без сайта — например, если вы написали robots.txt, но пока не загрузили его на сайт.

Вот как это сделать:

- Перейдите на Яндекс.Вебмастер.

- В открывшееся окно вставьте текст robots.txt и нажмите проверить.

Если файл написан правильно, Яндекс.Вебмастер не увидит ошибок.

А если увидит ошибку — подсветит её и опишет возможную проблему.

На Яндекс.Вебмастер можно проверить robots.txt и по URL сайта. Для этого нужно указать запрос: URL сайта/robots.txt. Например, unisender.com/robots.txt.

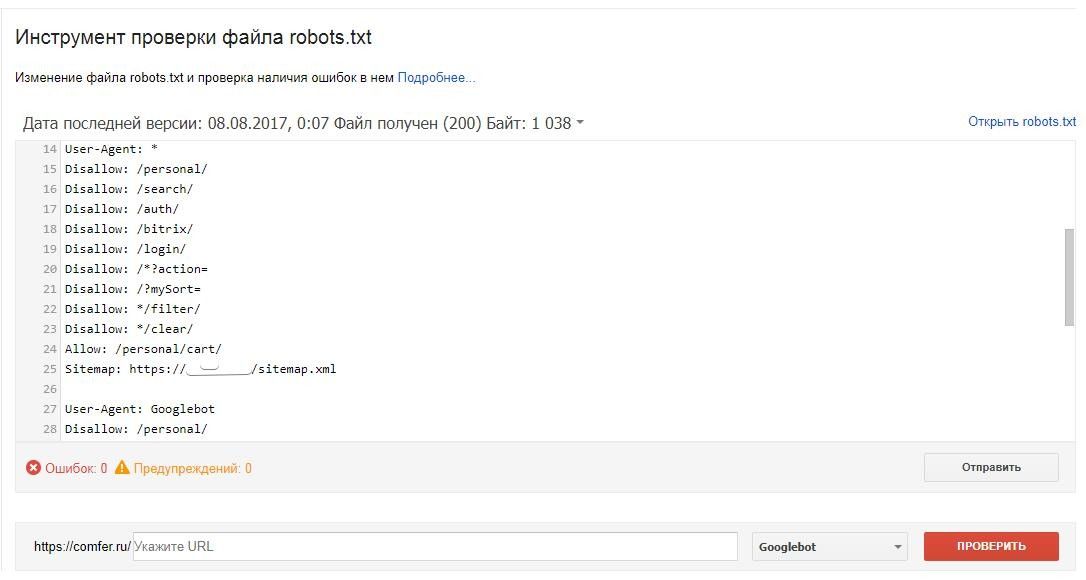

Ещё один вариант — проверить файл robots.txt через Google Search Console. Но сначала нужно подтвердить владение сайтом. Пошаговый алгоритм проверки robots.txt описан в видеоинструкции:

Поделиться

СВЕЖИЕ СТАТЬИ

Другие материалы из этой рубрики

Не пропускайте новые статьи

Подписывайтесь на соцсети

Делимся новостями и свежими статьями, рассказываем о новинках сервиса

«Честно» — авторская рассылка от редакции Unisender

Искренние письма о работе и жизни. Свежие статьи из блога. Эксклюзивные кейсы и интервью с экспертами диджитала.

Свежие статьи из блога. Эксклюзивные кейсы и интервью с экспертами диджитала.

Наш юрист будет ругаться, если вы не примете 🙁

Как запустить email-маркетинг с нуля?

В бесплатном курсе «Rock-email» мы за 15 писем расскажем, как настроить email-маркетинг в компании. В конце каждого письма даем отбитые татуировки об email ⚡️

*Вместе с курсом вы будете получать рассылку блога Unisender

Оставляя свой email, я принимаю Политику конфиденциальностиНаш юрист будет ругаться, если вы не примете 🙁

Robots.

txt — как настроить и загрузить на сайт

txt — как настроить и загрузить на сайтМихаил Шумовский

07 октября, 2022

Кому нужен robots.txt Как настроить robots.txt Как создать robots.txt Требования к файлу robots.txt Как проверить правильность Robots.txt

Мы в Telegram

В канале «Маркетинговые щи» только самое полезное: подборки, инструкции, кейсы.

Не всегда на серьёзных щах — шуточки тоже шутим =)

Подписаться

Станьте email-рокером 🤘

Пройдите бесплатный курс и запустите свою первую рассылку

Подробнее

Robots.txt — документ, который нужен для индексирования и продвижения сайта. С помощью этого файла владелец сайта подсказывает поисковым системам, какие разделы ресурса нужно учитывать, а какие — нет. Объясняю особенности его составления и настройки такого текстового файла.

С помощью этого файла владелец сайта подсказывает поисковым системам, какие разделы ресурса нужно учитывать, а какие — нет. Объясняю особенности его составления и настройки такого текстового файла.

Если у сайта нет robots.txt, поисковые роботы считают все страницы ресурса открытыми для индексирования. Если файл есть, владелец сайта может запретить роботам индексировать определённые страницы.

Например, контентным ресурсам или медиа можно работать без robots.txt — тут все страницы участвуют в индексации.

На других ресурсах могут быть страницы, которые не нужно показывать поисковым роботам:

- Админ-панели сайта: пути, которые начинаются с /user, /admin, /administrator и т.д.

- Пустые страницы ресурса: если на них нет контента, в индексации они не помогут.

- Формы регистрации.

- Личные страницы в интернет-магазинах: кабинеты пользователей, корзины и т.

д.

д.

Начну с основных параметров.

User-agent: Yandex

Disallow: catalog/

Allow: /catalog/cucumbers/

Sitemap: http://www.example.com/sitemap.xml

User-agent — указывает название робота, к которому применяется правило. Например, User-agent: Yandex означает, что правило применяется к роботу Яндекса.

А user-agent: * означает, что правило применяется ко всем роботам. Но о звёздочках поговорим ниже.

Основные типы роботов, которые можно указать в User-agent:

- Yandex. Все роботы Яндекса.

- YandexBot. Основной робот Яндекса

- YandexImages. Индексирует изображения.

- YandexMedia. Индексирует видео и другие мультимедийные данные.

- Google. Все роботы Google.

- Googlebot. Основной робот Google.

- Googlebot-Image.

Индексирует изображения.

Индексирует изображения.

Disallow. Указывает на каталог или страницу ресурса, которые роботы индексировать не будут. Если нельзя индексировать конкретную страницу, например, определённый раздел в каталоге, нужно указывать полный путь к ней — как в поисковой строке браузера.

В начале строки должен быть символ /. Если правило касается каталога, строка должна заканчиваться символом /.

Например, disallow: /catalog/gloves. Так мы запретим индексацию раздела с перчаткам.

Если оставить disallow пустым, роботы будут индексировать все страницы сайта.

Allow. Указывает на каталог или страницу, которые можно сканировать роботу. Его используют, чтобы внести исключения в пункт disallow и разрешить сканирование подкаталога или страницы в каталоге, который закрыт для обработки.

Если требуется индексировать конкретную страницу, нужно указывать к ней полный путь. Как и в disallow. Например, allow: /story/marketing. Так мы разрешили индексировать статью о маркетинге.

Так мы разрешили индексировать статью о маркетинге.

Если правило касается каталога, строка должна заканчиваться символом /.

Если allow пустой, робот не будет индексировать никакие страницы.

Sitemap. Необязательная директива, которая может повторяться несколько раз или не использоваться совсем. Её используют, чтобы описать структуру сайта и помочь роботам индексировать страницы.

Лендингам и небольшим сайтам sitemap не нужен. А вот таким ресурсам без sitemap не обойтись:

- Cайтам без хлебных крошек (навигационных цепочек).

- Большим ресурсам. Например, если сайт содержит большой объём мультимедиа или новостного контента.

- Сайтам с глубокой вложенностью. Например, «Главная/Каталог/Перчатки/Резиновые».

- Молодым ресурсам, на которые мало внешних ссылок, — их роботам сложно найти.

- Сайтам с большим архивом страниц, которые изолированы или не связаны друг с другом.

Файл нужно прописывать в XML-формате. Создание sitemap — тема для отдельной статьи. Подробную инструкцию читайте на Google Developers или в Яндекс.Справке.

Основные моменты robots.txt разобрали. Теперь расскажу про дополнительные параметры, которые используют в коде.

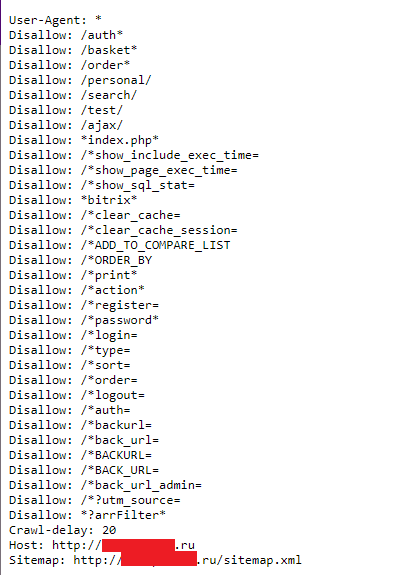

Для начала посмотрим на robots.txt Unisender. Для этого в поисковой строке браузера пишем Unisender.com/robots.txt.

По такой же формуле можно проверять файлы на всех сайтах: URL сайта + домен/robots.txt.

Robots.txt Unisender отличается от файла, который я приводил в пример. Дело в том, что здесь использованы дополнительные параметры:

Директива # (решётка) — комментарий. Решётки прописывают для себя, а поисковые роботы комментариев не видят.

User-agent: Yandex

Allow: /example/* # разрешает ‘/example/blog’

# разрешает ‘/example/blog/test’

Звёздочку роботы видят, а решётку — нет

Директива * (звёздочка) — любая последовательность символов после неё.

Например, если поставить звёздочку в поле disallow, то всё, что находится на её месте, будет запрещено.

User-agent: Yandex

Disallow: /example/* # запрещает ‘/example/blog’

# запрещает ‘/example/blog/test’

Disallow: */shop # запрещает не только ‘/shop’,

# но и ‘/example/shop’

Также и с полем allow: всё, что стоит на месте звёздочки, — разрешено для индексации.

User-agent: Yandex

Allow: /example/* # разрешает ‘/example/blog’

# разрешает ‘/example/blog/test’

Allow: */shop # разрешает не только ‘/shop’,

# но и ‘/example/shop’

Например, у Google есть особенность: компания рекомендует не закрывать от поисковых роботов файлы с css-стилями и js-скриптами. Вот как это нужно прописывать:

User-agent: Googlebot

Disallow: /site

Allow: *.css

Allow: *. js

js

Директива $ (знак доллара) — точное соответствие указанному параметру.

Например, использование доллара в disallow запретит доступ к определённому пути.

User-agent: Yandex

Disallow: /example # запрещает ‘/example’,

# запрещает ‘/example.html’

Disallow: /example$ # запрещает ‘/example’,

# не запрещает ‘/example.html’

# не запрещает ‘/example1’

# не запрещает ‘/example-new’

Таким способом можно исключить из сканирования все файлы определённого типа, например, GIF или JPG. Для этого нужно совместить * и $. Звёздочку ставим до расширения, а $ — после.

User-agent: Yandex

Disallow: / *.gif$ # вместо * могут быть любые символы,

# $ запретит индексировать файлы gif

Директива Clean-param — новый параметр Яндекс-роботов, который не будет сканировать дублированную информацию и поможет быстрее анализировать ресурс.

Дело в том, что из-за повторяющейся информации роботы медленнее проверяют сайт, а изменения на ресурсе дольше попадают в результаты поиска. Когда роботы Яндекса увидят эту директиву, не будут несколько раз перезагружать дубли информации и быстрее проверят сайт, а нагрузка на сервер снизится.

www.example.com/dir/get_card.pl?ref=site_1&card_id=10

www.example.com/dir/get_card.pl?ref=site_2&card_id=10

Параметр ref нужен, чтобы отследить, с какого ресурса сделан запрос. Он не меняет содержимое страницы, значит два адреса покажут одну и ту же страницу с книгой card_id=10. Поэтому директиву можно указать так:

User-agent: Yandex

Disallow:

Clean-param: ref /dir/get_card.pl

Робот Яндекса сведёт страницы к одной: www.example.com/dir/get_card.pl?card_id=10

Чтобы директива применялась к параметрам на страницах по любому адресу, не указывайте адрес:

User-agent: Yandex

Disallow:

Clean-param: utm

Директива Crawl-delay — устанавливает минимальный интервал в секундах между обращениями робота к сайту. Это помогает снизить нагрузку на сервер ресурса. Чем выше указанное значение, тем меньше страниц робот загрузит за сессию.

Это помогает снизить нагрузку на сервер ресурса. Чем выше указанное значение, тем меньше страниц робот загрузит за сессию.

Значения можно указывать целыми или дробными числами через точку.

User-agent: Yandex

Disallow:

Crawl-delay: 0.5

Для Яндекса максимальное значение в crawl-delay — 2. Более высокое значение можно установить инструментами Яндекс.Вебмастер.

Для Google-бота можно установить частоту обращений в панели вебмастера Search Console.

Директива Host — инструкция для робота Яндекса, которая указывает главное зеркало сайта. Нужна, если у сайта есть несколько доменов, по которым он доступен. Вот как её указывают:

User-agent: Yandex

Disallow: /example/

Host: example.ru

Если главное зеркало сайта — домен с протоколом HTTPS, его указывают так:

Host: https://site.ru

Как создать robots.txtСпособ 1. Понадобится текстовый редактор: блокнот, TextEdit, Vi, Emacs или любой другой. Не используйте приложения Microsoft Office, потому что они сохраняют файлы в неподходящем формате или добавляют в них лишние символы, которые не распознаются поисковыми роботами.

Не используйте приложения Microsoft Office, потому что они сохраняют файлы в неподходящем формате или добавляют в них лишние символы, которые не распознаются поисковыми роботами.

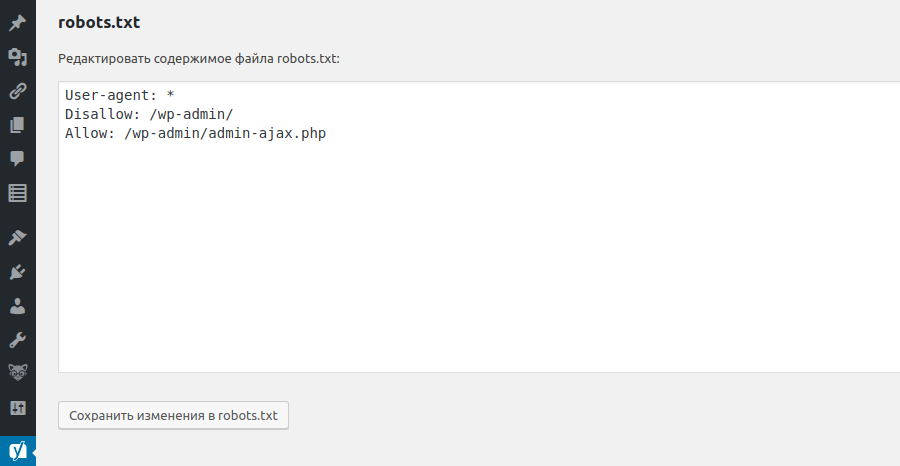

Способ 2. Создать на CMS с помощью плагинов — в этом случае robots.txt установится сам.

Если вы используете CMS хостинга, редактировать файл robots.txt не потребуется. Скорее всего, у вас даже не будет такой возможности. Вместо этого провайдер будет указывать поисковым системам, нужно ли сканировать контент, с помощью страницы настроек поиска или другого инструмента.

Способ 3. Воспользоваться генератором robots.txt — век технологий всё-таки.

Сгенерировать файл можно на PR-CY, IKSWEB, Smallseotools.

Требования к файлу robots.txtКогда создадите текстовый файл, сохраните его в кодировке utf-8. Иначе поисковые роботы не смогут прочитать документ. После создания загрузите файл в корневую директорию на сайте хостинг-провайдера. Корневая директория — это папка public. html.

html.

Папка, в которой нужно искать robots.txt. Источник

Если файла нет, его придётся создавать самостоятельно.

Требования, которым должен соответствовать robots.txt:

- Каждая директива начинается с новой строки.

- Одна директива в строке, сам параметр также написан в одну строку.

- В начале строки нет пробелов.

- Нет кавычек в директивах.

- Директивы не нужно закрывать точкой или точкой с запятой.

- Файл должен называться robots.txt. Нельзя называть его Robots.txt или ROBOTS.TXT.

- Размер файла не должен превышать 500 КБ.

- robots.txt должен быть написан на английском языке. Буквы других алфавитов не разрешаются.

Если файл не соответствует одному из требований, весь сайт считается открытым для индексирования.

Как проверить правильность Robots.txtПроверить robots. txt помогают сервисы от Яндекс и Google. В Яндексе можно проверять файл даже без сайта — например, если вы написали robots.txt, но пока не загрузили его на сайт.

txt помогают сервисы от Яндекс и Google. В Яндексе можно проверять файл даже без сайта — например, если вы написали robots.txt, но пока не загрузили его на сайт.

Вот как это сделать:

- Перейдите на Яндекс.Вебмастер.

- В открывшееся окно вставьте текст robots.txt и нажмите проверить.

Если файл написан правильно, Яндекс.Вебмастер не увидит ошибок.

А если увидит ошибку — подсветит её и опишет возможную проблему.

На Яндекс.Вебмастер можно проверить robots.txt и по URL сайта. Для этого нужно указать запрос: URL сайта/robots.txt. Например, unisender.com/robots.txt.

Ещё один вариант — проверить файл robots.txt через Google Search Console. Но сначала нужно подтвердить владение сайтом. Пошаговый алгоритм проверки robots.txt описан в видеоинструкции:

Поделиться

СВЕЖИЕ СТАТЬИ

Другие материалы из этой рубрики

Не пропускайте новые статьи

Подписывайтесь на соцсети

Делимся новостями и свежими статьями, рассказываем о новинках сервиса

«Честно» — авторская рассылка от редакции Unisender

Искренние письма о работе и жизни. Свежие статьи из блога. Эксклюзивные кейсы и интервью с экспертами диджитала.

Свежие статьи из блога. Эксклюзивные кейсы и интервью с экспертами диджитала.

Наш юрист будет ругаться, если вы не примете 🙁

Как запустить email-маркетинг с нуля?

В бесплатном курсе «Rock-email» мы за 15 писем расскажем, как настроить email-маркетинг в компании. В конце каждого письма даем отбитые татуировки об email ⚡️

*Вместе с курсом вы будете получать рассылку блога Unisender

Оставляя свой email, я принимаю Политику конфиденциальностиНаш юрист будет ругаться, если вы не примете 🙁

Как создать файл robots.

txt для вашего веб-сайта [5 шагов]

txt для вашего веб-сайта [5 шагов]Основная задача веб-робота — обход или сканирование веб-сайтов и страниц в поисках информации; они неустанно работают над сбором данных для поисковых систем и других приложений. Для некоторых есть веская причина держать страницы подальше от поисковых систем. Независимо от того, хотите ли вы настроить доступ к своему сайту или хотите работать над сайтом разработки, не отображаясь в результатах Google, после внедрения файл robots.txt позволяет веб-сканерам и ботам знать, какую информацию они могут собирать.

Что такое файл robots.txt?

robots.txt — это простой текстовый файл веб-сайта в корне вашего сайта, который соответствует стандарту исключения роботов. Например, www.yourdomain.com будет иметь файл robots.txt по адресу www.yourdomain.com/robots.txt. Файл состоит из одного или нескольких правил, которые разрешают или блокируют доступ сканерам, ограничивая их доступ к указанному пути к файлу на веб-сайте. По умолчанию все файлы полностью разрешены для сканирования, если не указано иное.

Файл robots.txt является одним из первых аспектов, проанализированных поисковыми роботами. Важно отметить, что на вашем сайте может быть только один файл robots.txt. Файл размещается на одной или нескольких страницах или на всем сайте, чтобы поисковые системы не отображали информацию о вашем сайте.

В этой статье описаны пять шагов для создания файла robots.txt и синтаксис, необходимый для защиты от ботов.

Как настроить файл Robots.txt

1. Создайте файл Robots.txt

У вас должен быть доступ к корню вашего домена. Ваш провайдер веб-хостинга может помочь вам определить, есть ли у вас соответствующий доступ.

Наиболее важной частью файла является его создание и расположение. С помощью любого текстового редактора создайте файл robots.txt. Его можно найти по адресу: 9.0003

- Корень вашего домена: www.yourdomain.com/robots.txt.

- Ваши поддомены: page.yourdomain.com/robots.txt.

- Нестандартные порты: www.

yourdomain.com:881/robots.txt.

yourdomain.com:881/robots.txt.

Примечание:

Файлы robots.txt не помещаются в подкаталог вашего домена (www.yourdomain.com/page/robots.txt).

Наконец, вам нужно убедиться, что ваш файл robots.txt является текстовым файлом в кодировке UTF-8. Google и другие популярные поисковые системы и сканеры могут игнорировать символы вне диапазона UTF-8, что может сделать ваши правила robots.txt недействительными.

2. Установите свой агент пользователя robots.txt

Следующим шагом в создании файлов robots.txt является установка агента пользователя . Пользовательский агент относится к поисковым роботам или поисковым системам, которые вы хотите разрешить или заблокировать. Несколько объектов могут быть пользовательским агентом . Ниже мы перечислили несколько поисковых роботов, а также их ассоциации.

Существует три разных способа установить пользовательский агент в файле robots.txt.

Создание одного агента пользователя

Синтаксис, который вы используете для установки агента пользователя: Агент пользователя: NameOfBot . Ниже DuckDuckBot является единственным установленным пользовательским агентом .

Ниже DuckDuckBot является единственным установленным пользовательским агентом .

# Пример установки user-agent Пользовательский агент: DuckDuckBot

Создание более одного пользовательского агента

Если нам нужно добавить более одного, выполните тот же процесс, что и для пользовательского агента DuckDuckBot , в следующей строке, введя имя дополнительные пользовательский агент . В этом примере мы использовали Facebot.

#Пример установки более одного пользовательского агента Агент пользователя: DuckDuckBot Агент пользователя: Facebot

Установка всех сканеров в качестве агента пользователя

Чтобы заблокировать всех ботов или сканеров, замените имя бота звездочкой (*).

#Пример того, как установить все поисковые роботы в качестве агента пользователя User-agent: *

Примечание:

Знак решетки (#) обозначает начало комментария.

3. Установите правила для файла robots.

txt

txtФайл robots.txt читается группами. Группа будет указывать, кем является пользовательский агент , и иметь одно правило или директиву, чтобы указать, к каким файлам или каталогам пользовательский агент может или не может получить доступ.

Вот используемые директивы:

- Запретить : Директива, относящаяся к странице или каталогу, относящемуся к вашему корневому домену, который вы не хотите сканировать названным агентом пользователя . Он начинается с косой черты (/), за которой следует полный URL-адрес страницы. Вы завершите его косой чертой, только если он относится к каталогу, а не к целой странице. Вы можете использовать один или несколько запретить настройки для каждого правила.

- Разрешить : Директива относится к странице или каталогу, относящемуся к вашему корневому домену, который вы хотите, чтобы названный пользовательский агент сканировал. Например, вы можете использовать директиву allow для переопределения правила disallow .

Он также будет начинаться с косой черты (/), за которой следует полный URL-адрес страницы. Вы завершите его косой чертой, только если он относится к каталогу, а не к целой странице. Вы можете использовать один или несколько разрешить настройки для каждого правила.

Он также будет начинаться с косой черты (/), за которой следует полный URL-адрес страницы. Вы завершите его косой чертой, только если он относится к каталогу, а не к целой странице. Вы можете использовать один или несколько разрешить настройки для каждого правила. - Карта сайта : Директива карты сайта является необязательной и указывает местоположение карты сайта для веб-сайта. Единственным условием является то, что это должен быть полный URL-адрес. Вы можете использовать ноль или больше, в зависимости от того, что необходимо.

Поисковые роботы обрабатывают группы сверху вниз. Как упоминалось ранее, они получают доступ к любой странице или каталогу, для которых явно не установлено значение , запрещающее . Поэтому добавьте Disallow: / под user-agent информация в каждой группе, чтобы запретить этим конкретным пользовательским агентам сканировать ваш сайт.

# Пример как заблокировать DuckDuckBot Агент пользователя: DuckDuckBot Запретить: / #Пример того, как заблокировать более одного пользовательского агента Агент пользователя: DuckDuckBot Агент пользователя: Facebot Запретить: / #Пример того, как заблокировать все поисковые роботы Пользовательский агент: * Disallow: /

Чтобы заблокировать определенный поддомен от всех поисковых роботов, добавьте косую черту и полный URL-адрес поддомена в правило запрета.

# Пример Пользовательский агент: * Disallow: /https://page.yourdomain.com/robots.txt

Если вы хотите заблокировать каталог, выполните тот же процесс, добавив косую черту и имя вашего каталога, но затем закончите еще одной косой чертой.

# Пример Пользовательский агент: * Disallow: /images/

Наконец, если вы хотите, чтобы все поисковые системы собирали информацию на всех страницах вашего сайта, вы можете создать правило allow или disallow , но не забудьте добавить косую черту при использовании разрешить правило . Примеры обоих правил показаны ниже.

# Разрешить пример, чтобы разрешить все поисковые роботы Пользовательский агент: * Позволять: / # Пример запрета, чтобы разрешить все поисковые роботы Пользовательский агент: * Disallow:

4. Загрузите файл robots.txt

Веб-сайты не содержат файл robots.txt автоматически, поскольку он не требуется. Как только вы решите создать его, загрузите файл в корневой каталог вашего сайта. Загрузка зависит от файловой структуры вашего сайта и среды веб-хостинга. Обратитесь к своему хостинг-провайдеру, чтобы узнать, как загрузить файл robots.txt.

Загрузка зависит от файловой структуры вашего сайта и среды веб-хостинга. Обратитесь к своему хостинг-провайдеру, чтобы узнать, как загрузить файл robots.txt.

5. Проверьте правильность работы файла robots.txt

Существует несколько способов проверить правильность работы файла robots.txt. С любым из них вы можете увидеть любые ошибки в вашем синтаксисе или логике. Вот некоторые из них:

- Тестер Google robots.txt в их Search Console.

- Средство проверки и тестирования robots.txt от Merkle, Inc.

- Средство тестирования robots.txt компании Ryte.

Бонус: использование robots.txt в WordPress

Если вы используете WordPress плагин Yoast SEO, вы увидите раздел в окне администратора для создания файла robots.txt.

Войдите в серверную часть своего веб-сайта WordPress и откройте Инструменты в разделе SEO , а затем щелкните Редактор файлов .

Yoast Следуйте той же последовательности, что и раньше, чтобы установить пользовательские агенты и правила. Ниже мы заблокировали поисковые роботы из каталогов WordPress wp-admin и wp-includes, но по-прежнему разрешаем пользователям и ботам видеть другие страницы сайта. Когда закончите, нажмите Сохраните изменения в robots.txt , чтобы активировать файл robots.txt.

Ниже мы заблокировали поисковые роботы из каталогов WordPress wp-admin и wp-includes, но по-прежнему разрешаем пользователям и ботам видеть другие страницы сайта. Когда закончите, нажмите Сохраните изменения в robots.txt , чтобы активировать файл robots.txt.

Отключить сканирование корзины

Поисковые системы, сканирующие ссылки добавления в корзину и нежелательные страницы, могут повредить вашему поисковому рейтингу. Ссылки «Добавить в корзину» могут вызывать более специфические проблемы, поскольку эти страницы не кэшируются, что увеличивает нагрузку на ЦП и память вашего сервера, поскольку страницы повторяются.

К счастью, адаптировать файл robot.txt вашего сайта несложно, чтобы поисковые системы сканировали только те страницы, которые вам нужны. Используйте эти строки кода в файле robots.txt сайта, чтобы адресовать ссылки для добавления в корзину и указать поисковым системам не индексировать их.

Агент пользователя: * Disallow: /*add-to-cart=*

Также рекомендуется изменить файл robots. txt, чтобы запретить индексирование страниц корзины, оформления заказа и моей учетной записи, что можно сделать, добавив строки ниже.

txt, чтобы запретить индексирование страниц корзины, оформления заказа и моей учетной записи, что можно сделать, добавив строки ниже.

Запретить: /корзина/ Запретить: /checkout/ Disallow: /my-account/

Заключение

Мы рассмотрели, как создать файл robots.txt. Эти шаги просты в выполнении и могут сэкономить ваше время и нервы, связанные с сканированием содержимого вашего сайта без вашего разрешения. Создайте файл robots.txt, чтобы заблокировать ненужное сканирование поисковыми системами и ботами.

Если вы размещаете с помощью Liquid Web и у вас есть вопросы по созданию файла robots.txt для вашего веб-сайта, обратитесь за помощью в нашу службу поддержки.

Как добавить файл robots.txt

Текстовый файл robots или файл robots.txt (часто ошибочно называемый файлом robot.txt) является обязательным для каждого веб-сайта. Добавление файла robots.txt в корневую папку вашего сайта — очень простой процесс, и наличие этого файла на самом деле является «знаком качества» для поисковых систем. Давайте посмотрим на параметры robots.txt, доступные для вашего сайта.

Давайте посмотрим на параметры robots.txt, доступные для вашего сайта.

Что такое текстовый файл robots?

Файл robots.txt — это простой текстовый файл в формате ASCII, который сообщает поисковым системам, на какие сайты им нельзя заходить. Он также известен как стандарт исключения роботов. Любые файлы или папки, перечисленные в этом документе, не будут просканированы и проиндексированы поисковыми роботами. Наличие robots.txt, даже пустого, показывает, что вы признаете, что поисковые системы разрешены на вашем сайте и что они могут иметь к нему свободный доступ. Мы рекомендуем добавить текстовый файл robots в ваш основной домен и все поддомены на вашем сайте.

Параметры форматирования robots.txt

Создание файла robots.txt — простой процесс. Выполните следующие простые шаги:

- Откройте Блокнот, Microsoft Word или любой текстовый редактор и сохраните файл как «роботы», все в нижнем регистре, обязательно выбрав .txt в качестве расширения типа файла (в Word выберите «Обычный текст»).

.

. - Затем добавьте в файл следующие две строки текста:

User-agent: *

Disallow:

«User-agent» — это другое слово для роботов или пауков поисковых систем. Звездочка (*) означает, что эта строка относится ко всем паукам. Здесь нет файлов или папок, перечисленных в строке «Запретить», что означает, что каждый каталог на вашем сайте может быть доступен. Это основной текстовый файл robots.

- Блокировка поисковых роботов на всем вашем сайте также является одной из опций robots.txt. Для этого добавьте в файл эти две строки:

User-agent: *

Disallow: /

- Если вы хотите заблокировать пауков из определенных областей вашего сайта, ваш robots.txt может выглядеть примерно так:

User-agent: *

Disallow: /database/

Disallow: /scripts/

Приведенные выше три строки сообщают всем роботам, что им не разрешен доступ к чему-либо в каталогах или подкаталогах базы данных и скриптов.

д.

д.

д.

д. Индексирует изображения.

Индексирует изображения.

yourdomain.com:881/robots.txt.

yourdomain.com:881/robots.txt. Он также будет начинаться с косой черты (/), за которой следует полный URL-адрес страницы. Вы завершите его косой чертой, только если он относится к каталогу, а не к целой странице. Вы можете использовать один или несколько разрешить настройки для каждого правила.

Он также будет начинаться с косой черты (/), за которой следует полный URL-адрес страницы. Вы завершите его косой чертой, только если он относится к каталогу, а не к целой странице. Вы можете использовать один или несколько разрешить настройки для каждого правила. .

.