Screaming Frog SEO Spider — подробная инструкция по работе и возможности программы

Screaming Frog SEO Spider – один из наиболее важных инструментов в арсенале оптимизатора. Этот сервис просто незаменим при анализе интернет-ресурса, так как позволяет автоматизировать сбор и структурирование самых важных данных о сайте, тем самым сильно ускоряя работу.

Если вы занимаетесь развитием собственного веб-проекта, или продвижением сайтов клиентов, то Screaming Frog наверняка вам знаком. Но используете ли вы доступные возможности на 100%? В этой статье мы подготовили максимально подробное руководство по использованию данного инструмента. Надеемся, вы сможете найти здесь много нового и полезного.

Базовое сканирование сайта

Как сканировать весь сайт

Как сканировать один подкаталог

Как сканировать определенный набор поддоменов или подкаталогов

Exclusion (Исключение)

Include (Включение)

Как получить список всех страниц на моем сайте

Как получить список всех страниц в определенном подкаталоге

Как найти все субдомены на сайте и проверить внутренние ссылки

Способ 1

Способ 2

Способ 3

Как сканировать интернет-магазин или другой большой сайт

Как сканировать сайт, размещенный на старом сервере, или как сканировать сайт без сбоев

Как сканировать сайт, который требует куки

Как сканировать, используя другой пользовательский агент (User-Agent)

Как сканировать страницы, требующие аутентификации

Внутренние ссылки

Как получить информацию обо всех внутренних и внешних ссылках на моем сайте (якорный текст, директивы, ссылки на страницу и т. д.)

Как найти неработающие внутренние ссылки на странице или сайте

Как найти неработающие исходящие ссылки на странице или сайте (или все исходящие ссылки в целом)

Как найти ссылки, которые перенаправляются

Для чего нужны данные о ссылках

Контент сайта

Как определить страницы с неинформативным контентом

Как получить список ссылок на изображения на определенной странице

Как найти изображения, в которых отсутствует текст alt или изображения с длинным текстом alt

Как найти каждый файл CSS на моем сайте

Как найти каждый файл JavaScript на сайте

Как определить все плагины jQuery, используемые на сайте, и на каких страницах они используются

Как определить места со встроенным flash

Как найти любые внутренние PDF-файлы

Как понять сегментацию контента внутри сайта или группы страниц

Как найти страницы с кнопками социальных сетей

Как найти страницы, которые используют iframes

Как найти страницы, которые содержат встроенный видео или аудио контент

Метаданные и директивы

Как идентифицировать страницы с длинными заголовками страниц, метаописаниями или URL-адресами

Как найти повторяющиеся заголовки страниц, метаописания или URL

Как найти дублированный контент или URL-адреса, которые необходимо переписать / перенаправить / канонизировать

Как определить все страницы, содержащие мета-директивы, например: nofollow / noindex / noodp / canonical и т. д.

д.

Как проверить корректность работы файла robots.txt

Как найти или проверить разметку схемы или другие микроданные на моем сайте

Карта сайта

Как создать XML Sitemap

Создание XML-файла Sitemap путем загрузки URL-адресов

Как проверить мой существующий XML Sitemap

Определение отсутствующих страниц в XML Sitemap

Общие проблемы

Как определить, почему определенные разделы сайта не индексируются или не ранжируются

Как найти медленные страницы на моем сайте

Как найти вредоносное ПО или спам на моем сайте

PPC и аналитика

Как проверить список URL-адресов PPC навалом

Зачистка

Как очистить метаданные для списка страниц

Как очистить сайт для всех страниц, которые содержат определенный размер?

Перезапись URL

Как найти и удалить идентификатор сеанса или другие параметры из моих просканированных URL

Как переписать просканированные URL-адреса (например, заменить .com на .co.uk или написать все URL-адреса строчными буквами)

Исследование ключевых слов

Как узнать, какие страницы мои конкуренты ценят больше всего

Как узнать, какой якорный текст используют мои конкуренты для внутренних ссылок

Как узнать, какие метатеги keywords (если они есть) конкуренты добавили на свои страницы

Создание ссылок

Как проанализировать список предполагаемых ссылок

Как найти неработающие ссылки для расширения возможностей

Как проверить мои обратные ссылки и просмотреть текст привязки

Как убедиться, что ссылки удаляются по запросу в процессе очистки

Дополнительная информация

Как редактировать метаданные

Как сканировать JavaScript-сайта

Просмотр оригинального HTML и визуализированного HTML

В заключение

Базовое сканирование сайта

Как сканировать весь сайт

Приступая к сканированию сайта, важно наперед определить, какую информацию вы хотите получить, насколько велик сайт, и какую часть сайта вам нужно сканировать, чтобы получить доступ к нужным данным.

Примечание: Иногда для масштабных ресурсов лучше ограничить сканер подразделом URL-адресов, чтобы получить хороший репрезентативный образец данных. Это делает размеры файлов и экспорт данных более управляемыми. Мы рассмотрим это более подробно ниже.

Для сканирования всего сайта, включая все дочерние домены, вам нужно внести небольшие изменения в конфигурацию spider, чтобы начать.

По умолчанию Screaming Frog сканирует только субдомен, который вы ввели. Любые дополнительные субдомены, с которыми сталкивается spider, будут рассматриваться, как внешние ссылки. Для обхода дополнительных поддоменов, необходимо изменить настройки в меню Spider Configuration. Отметив Crawl All Subdomains, вы убедитесь, что SEO Spider сканирует любые ссылки, которые он встречает, на другие поддомены на вашем сайте.

Шаг 1:

Шаг 2:

Если вы запускаете сканирование из определенной подпапки или подкаталога и по-прежнему хотите, чтобы Screaming Frog сканировал весь сайт, установите флажок Crawl Outside of Start Folder.

По умолчанию SEO Spider настроен только на сканирование подпапки или подкаталога, который вы сканируете. Если вы хотите сканировать весь сайт и запускать из определенного подкаталога, убедитесь, что для конфигурации задан обход за пределами начальной папки.

Совет: Чтобы сэкономить время и место на диске, помните о ресурсах, которые могут вам не понадобиться при сканировании. Снимите флажки с изображения, CSS, JavaScript и SWF-ресурсов, чтобы уменьшить размер обхода.

Как сканировать один подкаталог

Если вы хотите ограничить сканирование одной папкой, просто введите URL-адрес и нажмите Start, не изменяя никаких настроек по умолчанию. Если вы перезаписали исходные настройки по умолчанию, сбросьте настройки по умолчанию в меню File.

Если вы хотите начать сканирование в определенной папке, но нужно продолжить сканирование в остальных частях субдомена, обязательно выберите Crawl Outside Of Start Folder в настройках Spider Configuration, прежде, чем вводить ваш конкретный стартовый URL.

Как сканировать определенный набор поддоменов или подкаталогов

Чтобы ограничить просмотр определенным набором поддоменов или подкаталогов, вы можете использовать RegEx, чтобы установить эти правила в параметрах Include или Exclude в меню Configuration.

Exclusion (Исключение)

Шаг 1:

Перейдите в Configuration > Exclude, используйте подстановочные регулярные выражения для определения URL или параметров, которые вы хотите исключить.

Шаг 2:

Проверьте свое регулярное выражение, чтобы убедиться, что оно исключает ожидаемые страницы до начала сканирования:

Include (Включение)

В приведенном ниже примере мы хотели просмотреть только подпапку команды на elit-web.ru. Опять же, используйте закладку Test, чтобы протестировать несколько URL и убедиться, что RegEx правильно настроен для вашего правила inclusion.

Это отличный способ сканирования больших сайтов. На самом деле, Screaming Frog рекомендует этот метод, если вам нужно разделить и сканировать сайт с большим числом обратных ссылок.

Как получить список всех страниц на моем сайте

По умолчанию, Screaming Frog настроен на сканирование всех изображений, JavaScript, CSS и флэш-файлов, с которыми сталкивается SEO Spider. Чтобы сканировать (crawl) только HTML, вам придется снять выделение с пунктов Check Images, Check CSS, Check JavaScript и Check SWF в меню Spider Configuration.

Запуск SEO Spider с этими настройками без галочки, по сути, предоставит вам список всех страниц вашего сайта, на которые есть внутренние ссылки, указывающие на них.

После завершения сканирования перейдите на вкладку Internal и отфильтруйте результаты по HTML. Нажмите кнопку Export, и у вас будет полный список в формате CSV.

Совет: Если вы склонны использовать одни и те же настройки для каждого сканирования, Screaming Frog теперь позволяет вам сохранить настройки конфигурации:

Как получить список всех страниц в определенном подкаталоге

В дополнение к снятию флажка Check Images, Check CSS, Check JavaScript и Check SWF, вы также захотите снять флажок Check Links Outside Folder в настройках Spider Configuration. Запуск SEO Spider с этими настройками без флажка, даст вам список всех страниц в вашей стартовой папке (если они не являются страницами, на которые нет внутренних или внешних ссылок).

Запуск SEO Spider с этими настройками без флажка, даст вам список всех страниц в вашей стартовой папке (если они не являются страницами, на которые нет внутренних или внешних ссылок).

Как найти все субдомены на сайте и проверить внутренние ссылки

Есть несколько разных способов найти все поддомены на сайте.

Способ 1

Используя Screaming Frog для идентификации всех поддоменов на данном сайте, перейдите в Configuration > Spider и убедитесь, что выбрана опция Crawl all Subdomains. Как и при сканировании всего сайта, это поможет сканировать любой поддомен, связанный с обходом сайта. Тем не менее, это не найдет поддоменов, которые не связаны ссылками.

Способ 2

Используйте Google, (расширение для браузера Scraper Chrome) для идентификации всех проиндексированных поддоменов, мы можем найти все индексируемые субдомены для данного домена.

Шаг 1:

Начните вводить в поисковике: site: оператор поиска в Google, чтобы ограничить результаты для вашего конкретного домена. Затем используйте оператор поиска -inurl, чтобы сузить результаты поиска, удалив основной домен. Появится список поддоменов, которые были проиндексированы в Google, в котором не будет основного домена.

Шаг 2:

Используйте расширение Scraper, чтобы извлечь все результаты в Google Sheet. Просто щелкните правой кнопкой мыши URL-адрес в поисковой выдаче, нажмите Scrape Similar и экспортируйте в Google Doc.

Шаг 3:

В вашем Документе Google Doc используйте следующую функцию, чтобы обрезать URL-адрес до субдомена:

=LEFT(A2,SEARCH («/»,A2,9))

По сути, приведенная выше формула должна помочь удалить любые подкаталоги, страницы или имена файлов в конце сайта. Эта формула, позволяет не экспортировать в Excel то, что находится слева от конечной косой черты. Стартовое число 9 является важным, потому что мы просим его начать искать косую черту «/» после 9-го символа. Это составляет протокол: https://, длиной в 8 символов.

Это составляет протокол: https://, длиной в 8 символов.

Дублируйте список и загрузите его в Screaming Frog в режиме списка (List Mode) – вы можете вручную вставить список доменов, использовать функцию вставки (paste) или загрузить (upload) CSV.

Способ 3

Введите URL-адрес корневого домена в инструменты (tools), чтобы найти сайты, которые могут существовать на том же IP-адресе. Также вы можете воспользоваться поисковыми системами, специально предназначенными для поиска поддоменов, например FindSubdomains. Создайте бесплатную учетную запись для входа и экспорта списка поддоменов. Затем загрузите список в Screaming Frog, используя режим списка (List Mode).

Как только SEO Spider закончит работу, вы сможете увидеть код состояния, а также любые ссылки на домашних страницах поддоменов, текст привязки и дубликаты заголовков страниц, среди прочего.

Как сканировать интернет-магазин или другой большой сайт

Изначально Screaming Frog не был создан для сканирования сотен тысяч страниц, но благодаря некоторым обновлениям он становится многофункциональнее с каждым днем.

Последняя версия Screaming Frog была обновлена, чтобы полагаться на хранилище базы данных для обходов. В версии 11.0 Screaming Frog позволял пользователям сохранять все данные на диске в базе данных, а не просто хранить их в оперативной памяти. Это открыло возможность сканирования очень больших сайтов в один клик.

В версии 12.0 сканирование автоматически сохраняет обходы в базе данных. Это позволяет получить к ним доступ и открыть с помощью File > Crawls в меню верхнего уровня (на случай, если вы удивляетесь, куда пошла команда open?)

Хотя использование обхода базы данных помогает Screaming Frog лучше управлять большими объемами информации, это, конечно, не единственный способ сканирования большого сайта.

Во-первых, вы можете увеличить выделение памяти в SEO Screaming Frog.

Во-вторых, вы можете разбить сканирование по подкаталогу или сканировать только определенные части сайта, используя настройки Include / Exclude.

В-третьих, вы можете не сканировать изображения, JavaScript, CSS и flash. Отменив выбор этих параметров в меню Configuration, сэкономив тем самым память, сканируя только HTML.

Совет: До недавнего времени Screaming Frog SEO Spider мог приостанавливаться или зависать при сканировании большого сайта. Теперь, когда хранилище базы данных является настройкой по умолчанию, вы можете восстановить обходы, чтобы выбрать, где вы остановились. Кроме того, вы также можете получить доступ к URL-адресам в очереди. Это может дать вам представление о любых дополнительных параметрах или правилах, которые вы можете исключить для сканирования большого сайта.

Как сканировать сайт, размещенный на старом сервере, или как сканировать сайт без сбоев

В некоторых случаях старые серверы могут не обрабатывать количество URL-запросов по умолчанию в секунду. Мы рекомендуем включить ограничение на количество сканируемых URL-адресов в секунду, чтобы на всякий случай не усложнять работу сервера сайта. Лучше всего, чтобы клиент знал, когда вы планируете сканировать сайт, на случай, если у него может быть защита от неизвестных пользовательских агентов. С одной стороны, им может понадобиться внести в белый список ваш IP или пользовательский агент (User-Agent), прежде, чем вы будете сканировать сайт. В худшем случае вы можете отправить слишком много запросов на сервер и непреднамеренно завершить работу сайта.

Чтобы изменить скорость сканирования, выберите Speed в меню Configuration и во всплывающем окне выберите максимальное количество потоков, которые должны работать одновременно. В этом меню вы также можете выбрать максимальное количество URL-адресов, запрашиваемых в секунду.

Совет: Если вы обнаружите, что при сканировании возникает много ошибок сервера, перейдите на вкладку Advanced в меню Spider Configuration и увеличьте значение Response Timeout и 5xx Response Retries, чтобы получить лучшие результаты.

Как сканировать сайт, который требует куки

Хотя поисковые роботы не принимают файлы cookie, если вы сканируете сайт и хотите разрешить использование файлов cookie, просто выберите Allow Cookies на вкладке Advanced в меню Spider Configuration.

Как сканировать, используя другой пользовательский агент (User-Agent)

Чтобы сканировать с использованием другого пользовательского агента, выберите User Agent в меню Configuration, затем выберите поискового бота из выпадающего списка или введите нужные строки пользовательского агента.

Поскольку Google теперь ориентирован на мобильные устройства, попробуйте просканировать сайт как смартфон Googlebot или измените User-Agent, чтобы он был как смартфон Googlebot. Это важно по двум причинам:

- Сканирование сайта, имитирующее пользовательского агента (user-agent) смартфон Googlebot, может помочь определить любые проблемы, возникающие у Google при сканировании и отображении контента вашего сайта.

- Использование модифицированной версии пользовательского агента смартфона Googlebot поможет вам различать ваши обходы и обходы Google при анализе журналов сервера.

Как сканировать страницы, требующие аутентификации

Когда Screaming Frog встречает страницу, защищенную паролем, появляется всплывающее окно, в котором вы можете ввести требуемое имя пользователя и пароль.

Аутентификация на основе форм является очень мощной функцией и может потребовать рендеринга JavaScript для эффективной работы.

Примечание: проверку подлинности на основе форм следует использовать экономно и только опытным пользователям. Сканер запрограммирован так, что он кликает каждую ссылку на странице, это может привести к появлению ссылок для выхода из системы, создания сообщений или даже удаления данных.

Чтобы управлять аутентификацией, перейдите к Configuration > Authentication.

Чтобы отключить запросы на аутентификацию, отмените выбор Authentication на основе стандартов в окне Authentication в меню Configuration.

Внутренние ссылки

Как получить информацию обо всех внутренних и внешних ссылках на моем сайте (якорный текст, директивы, ссылки на страницу и т. д.)

Если вам не нужно проверять изображения, JavaScript, Flash или CSS на сайте, отмените выбор этих параметров в меню Spider Configuration, чтобы сэкономить время и память.

Как только SEO Spider завершит сканирование, используйте меню Bulk Export, чтобы экспортировать CSV All Links. Это предоставит вам все ссылки, а также соответствующий якорный текст, директивы и т. д.

Все ссылки могут быть в большом отчете. Помните об этом при экспорте. Для большого сайта этот экспорт может занять несколько минут.

Для быстрого подсчета количества ссылок на каждой странице перейдите на вкладку Internal и отсортируйте по Outlinks. Страницы, где более 100 ссылок, возможно, потребуется пересмотреть.

Как найти неработающие внутренние ссылки на странице или сайте

Как и в предыдущем пункте, отмените выбор JavaScript, Flash или CSS сайта в меню Spider Configuration, если вам не нужно проверять изображения.

После того, как SEO Spider завершит сканирование, отсортируйте результаты вкладки Internal по Status Code. Любой 404, 301 или другой код состояния будут легко доступны для просмотра.

Нажав на любой отдельный URL в результатах сканирования, вы увидите изменение информации в нижнем окне программы. Нажав на вкладку In Links в нижнем окне, вы увидите список страниц, которые ссылаются на выбранный URL, а также якорный текст и директивы, используемые в этих ссылках. Вы можете использовать эту функцию для определения страниц, на которых необходимо обновить внутренние ссылки.

Чтобы экспортировать полный список страниц, которые содержат неработающие или перенаправленные ссылки, выберите Redirection (3xx) In Links или Client Error (4xx) In Links или Server Error (5xx) In Links в меню Advanced Export, и вы получите CSV-экспорт данных.

Чтобы экспортировать полный список страниц, которые содержат неработающие или перенаправленные ссылки, посетите меню Bulk Export. Прокрутите вниз до кода ответов и посмотрите следующие отчеты:

Прокрутите вниз до кода ответов и посмотрите следующие отчеты:

- No Response Inlinks;

- Redirection (3xx) Inlinks;

- Redirection (JavaScript) Inlinks;

- Redirection (Meta Refresh) Inlinks;

- Client Error (4xx) Inlinks;

- Server Error (5xx) Inlinks.

Просмотр всех этих отчетов должен дать вам адекватное представление о том, какие внутренние ссылки следует обновить, чтобы они указывали на каноническую версию URL и эффективно распределяли качественные ссылки.

Как найти неработающие исходящие ссылки на странице или сайте (или все исходящие ссылки в целом)

После отмены выбора Check Images, Check CSS, Check JavaScript и Check SWF в настройках Spider Configuration убедитесь, что Check External Links остается выбранной.

После того, как SEO Spider завершит сканирование, нажмите на вкладку External в верхнем окне, отсортируйте по Status Code Вы легко сможете найти URL с кодом состояния, отличными от 200. После нажатия на любой отдельный URL, просканируйте результаты, а затем, нажав на вкладку In Links в нижнем окне, вы увидите список страниц, которые указывают на выбранный URL-адрес. Вы можете использовать эту функцию для определения страниц, на которых необходимо обновить исходящие ссылки.

Чтобы экспортировать полный список исходящих ссылок, нажмите External Links на вкладке Bulk Export.

Для получения полного списка всех местоположений и текста привязки исходящих ссылок выберите All Outlinks в меню Bulk Export. Отчет All Outlinks также будет включать исходящие ссылки на ваши субдомены. Если вы хотите исключить свой домен, воспользуйтесь отчетом External Links, упомянутым выше.

Как найти ссылки, которые перенаправляются

После завершения сканирования выберите вкладку Response Codes в основном пользовательском интерфейсе и выполните фильтрацию по коду состояния. Поскольку Screaming Frog использует регулярные выражения для поиска, отправьте в качестве фильтра следующие критерии: 301 | 302 | 307. Это должно дать вам довольно солидный список всех ссылок, которые возвращались с каким-либо перенаправлением, независимо от того, был ли контент постоянно перемещен, найден и перенаправлен, или временно перенаправлен из-за настроек HSTS (это вероятная причина 307 перенаправлений в Screaming Frog ).

Это должно дать вам довольно солидный список всех ссылок, которые возвращались с каким-либо перенаправлением, независимо от того, был ли контент постоянно перемещен, найден и перенаправлен, или временно перенаправлен из-за настроек HSTS (это вероятная причина 307 перенаправлений в Screaming Frog ).

Сортируйте по Status Code, и вы сможете разбить результаты по типу. Нажмите на вкладку In Links в нижнем окне, чтобы просмотреть все страницы, на которых используется ссылка для перенаправления.

Если вы экспортируете напрямую из этой вкладки, то увидите только те данные, которые отображаются в верхнем окне (оригинальный URL, код состояния и куда он перенаправляется).

Чтобы экспортировать полный список страниц, содержащих перенаправленные ссылки, вам нужно будет выбрать Redirection (3xx) In Links в меню Advanced Export. Это вернет CSV, который включает в себя местоположение всех ваших перенаправленных ссылок. Чтобы показать только внутренние перенаправления, отфильтруйте столбец Destination в CSV, чтобы включить только ваш домен.

Совет: Используйте функцию VLOOKUP (ВПР) между двумя вышеупомянутыми файлами экспорта, чтобы сопоставить столбцы Source и Destination с окончательным расположением URL-адреса.

Пример формулы:

= ВПР ([@ Destination], ‘response_codes_redirection_ (3xx) .csv’ $ A $ 3: $ F $ 50,6, FALSE)

Где response_codes_redirection_ (3xx) .csv – это файл CSV, содержащий URL-адреса перенаправления, а 50 – количество строк в этом файле.

Для чего нужны данные о ссылках

Грамотное распределение внутренних ссылок может повысить эффективность поискового продвижения, особенно когда вы занимаетесь стратегическим подходом к распределению PageRank и качественных ссылок, ранжирование ключевых слов и привязки к ключевым словам.

Контент сайта

Как определить страницы с неинформативным контентом

После завершения сканирования SEO Spider перейдите на вкладку Internal, отфильтруйте их по HTML, затем прокрутите вправо до столбца Word Count. Сортируйте столбец Word Count по убыванию, чтобы найти страницы с низким содержанием текста. Вы можете перетащить столбец Word Count влево, чтобы лучше сопоставить значения низкого количества слов с соответствующими URL-адресами. Нажмите Export на вкладке Internal, если вы предпочитаете вместо этого управлять данными в CSV.

Сортируйте столбец Word Count по убыванию, чтобы найти страницы с низким содержанием текста. Вы можете перетащить столбец Word Count влево, чтобы лучше сопоставить значения низкого количества слов с соответствующими URL-адресами. Нажмите Export на вкладке Internal, если вы предпочитаете вместо этого управлять данными в CSV.

Как получить список ссылок на изображения на определенной странице

Если вы уже просмотрели весь сайт или подпапку, просто выберите страницу в верхнем окне, а затем нажмите вкладку Image Info в нижнем окне, чтобы просмотреть все изображения, найденные на этой странице. Изображения будут перечислены в столбце To.

Совет: Щелкните правой кнопкой мыши любую запись в нижнем окне, чтобы скопировать или открыть URL-адрес.

Кроме того, вы также можете просматривать изображения на одной странице, сканируя только этот URL. Убедитесь, что в настройках конфигурации SEO Spider задана глубина сканирования 1, затем после сканирования страницы перейдите на вкладку Images, и вы увидите все изображения, найденные screaming frog.

Как найти изображения, в которых отсутствует текст alt или изображения с длинным текстом alt

Во-первых, вы должны убедиться, что в меню Spider Configuration выбран Check Images. После того, как SEO Spider закончил анализировать, перейдите на вкладку Images и отфильтруйте по Missing Alt Text или Alt Text Over 100 Characters. Вы можете найти страницы, где находится любое изображение, нажав на вкладку Image Info в нижнем окне. Страницы будут перечислены в столбце From.

Наконец, если вы предпочитаете CSV, используйте меню Bulk Export, чтобы экспортировать All Images или Images Missing Alt Text Inlinks, чтобы увидеть полный список изображений, где они находятся, и любой связанный с ним текст alt или проблемы с alt Text.

Кроме того, используйте правую боковую панель, чтобы перейти к разделу изображений для обхода. Здесь вы можете легко экспортировать список всех изображений, пропущенным текстом alt.

Как найти каждый файл CSS на моем сайте

В меню Spider Configuration выберите Crawl и Store CSS перед сканированием, затем, когда сканирование завершится, отфильтруйте результаты на вкладке Internal с помощью CSS.

Как найти каждый файл JavaScript на сайте

В меню Spider Configuration выберите Check JavaScript перед сканированием, затем, когда сканирование завершится, отфильтруйте результаты на вкладке Internal по JavaScript.

Как определить все плагины jQuery, используемые на сайте, и на каких страницах они используются

Во-первых, убедитесь, что в меню Spider Configuration выбран Check JavaScript. После того, как SEO Spider завершил сканирование, отфильтруйте вкладку Internal по JavaScript, затем найдите jquery. Это предоставит вам список файлов плагинов. Сортируйте список по Address для более удобного просмотра при необходимости, затем просмотрите InLinks в нижнем окне или экспортируйте данные в CSV, чтобы найти страницы, где используется файл. Они будут в столбце From.

Кроме того, вы можете использовать меню Advanced Export, чтобы экспортировать CSV All Links и отфильтровать столбец Destination, чтобы отображались только URL-адреса с jquery.

Совет: Не все плагины jQuery вредны для SEO. Если вы видите, что сайт использует jQuery, лучше всего убедиться, что контент, который вы хотите проиндексировать, включен в источник страницы и обслуживается при загрузке страницы, а не после. Если вы все еще не уверены, установите плагин Google для получения дополнительной информации о том, как он работает.

Как определить места со встроенным flash

В меню Spider Configuration выберите Check SWF перед сканированием, затем, когда сканирование завершится, отфильтруйте результаты на вкладке Internal по Flash.

Это становится все более важным, чтобы находить и идентифицировать контент, который поставляется Flash, и предлагать альтернативный код для него. Flash постепенно устаревает для Chrome.![]() Потому этот функционал действительно нужно использовать, чтобы определить, если есть проблемы с критическим контентом и Flash на сайте.

Потому этот функционал действительно нужно использовать, чтобы определить, если есть проблемы с критическим контентом и Flash на сайте.

Примечание: этот метод находит только файлы .SWF, которые связаны на странице. Если флэш-память загружается через JavaScript, вам нужно использовать пользовательский фильтр.

Как найти любые внутренние PDF-файлы

После завершения сканирования в Screaming Frog отфильтруйте результаты на вкладке Internal по PDF.

Как понять сегментацию контента внутри сайта или группы страниц

Если вы хотите найти на своем сайте страницы с определенным типом контента, установите специальный фильтр для HTML-кода, уникального для этой страницы. Это следует сделать перед запуском screaming frog.

Как найти страницы с кнопками социальных сетей

Чтобы найти страницы, содержащие кнопки социальных сетей, вам нужно установить собственный фильтр перед запуском. Чтобы установить пользовательский фильтр, перейдите в меню Configuration и нажмите Custom. Оттуда введите любой фрагмент кода из исходного кода страницы.

В приведенном выше примере фильтр для facebook.com/plugins/like.php.

Как найти страницы, которые используют iframes

Чтобы найти страницы, которые используют iframe, установите пользовательский фильтр для < iframe перед запуском.

Как найти страницы, которые содержат встроенный видео или аудио контент

Чтобы найти страницы, содержащие встроенное видео или аудиоконтент, установите специальный фильтр для фрагмента кода встраивания для Youtube или любого другого медиаплеера, используемого на сайте.

Как идентифицировать страницы с длинными заголовками страниц, метаописаниями или URL-адресами

После завершения сканирования, перейдите на вкладку Page Titles и отфильтруйте по Over 65 Characters, чтобы увидеть слишком длинные заголовки страниц. Вы можете сделать то же самое на вкладке Meta Description или на вкладке URI.

Как найти повторяющиеся заголовки страниц, метаописания или URL

После того, как SEO Spider закончил сканировать, перейдите на вкладку Page Titles, затем выберите Duplicate. Вы можете сделать то же самое на вкладках Meta Description или URI.

Как найти дублированный контент или URL-адреса, которые необходимо переписать / перенаправить / канонизировать

После того, как SEO Spider завершил сканирование, перейдите на вкладку URI, затем отфильтруйте по Underscores, Uppercase или Non ASCII Characters, чтобы просмотреть URL, которые потенциально могут быть переписаны в более стандартную структуру. Выберите Duplicate, и вы увидите все страницы с несколькими версиями URL. Отфильтруйте по Parameters, и вы увидите URL-адреса, содержащие параметры.

Кроме того, если вы перейдете на вкладку Internal, отфильтруете по HTML и прокрутите столбец Hash в крайнем правом углу, вы увидите уникальные серии букв и цифр для каждой страницы. Если вы нажмете Export, вы можете использовать условное форматирование в Excel, чтобы выделить дублирующиеся значения в этом столбце, в конечном счёте, будут вам показаны страницы, которые идентичны и требуют решения.

Как определить все страницы, содержащие мета-директивы, например: nofollow / noindex / noodp / canonical и т. д.

После того, как SEO Spider закончил проверку, нажмите на вкладку Directives. Чтобы увидеть тип директивы, просто прокрутите вправо, чтобы увидеть, какие столбцы заполнены, или используйте фильтр, чтобы найти любой из следующих тегов:

- index;

- noindex;

- follow;

- nofollow;

- noarchive;

- nosnippet;

- noodp;

- noydir;

- noimageindex;

- notranslate;

- unavailable_after;

- refresh.

Как проверить корректность работы файла robots.txt

По умолчанию Screaming Frog будет выполнять требования robots. txt. В качестве приоритета он будет следовать директивам, сделанным специально для пользовательского агента (user agent) Screaming Frog. Если для пользовательского агента (user-agent) Screaming Frog нет никаких директив, то SEO Spider будет следовать любым директивам для робота Googlebot, а если нет специальных директив для робота Googlebot, он будет следовать глобальным директивам для всех пользовательских агентов.

txt. В качестве приоритета он будет следовать директивам, сделанным специально для пользовательского агента (user agent) Screaming Frog. Если для пользовательского агента (user-agent) Screaming Frog нет никаких директив, то SEO Spider будет следовать любым директивам для робота Googlebot, а если нет специальных директив для робота Googlebot, он будет следовать глобальным директивам для всех пользовательских агентов.

SEO Spider будет следовать только одному набору директив, поэтому, если существуют правила, установленные специально для Screaming Frog, он будет следовать только этим правилам, а не правилам для робота Google или каких-либо глобальных правил. Если вы хотите заблокировать определенные части сайта от SEO Spider, используйте обычный синтаксис robots.txt с пользовательским агентом Screaming Frog SEO Spider. Если вы хотите игнорировать robots.txt, просто выберите эту опцию в настройках Spider Configuration.

Configuration > Robots.txt > Settings

Как найти или проверить разметку схемы или другие микроданные на моем сайте

Чтобы найти каждую страницу, содержащую разметку схемы или любые другие микроданные, вам нужно использовать пользовательские фильтры. Просто нажмите Custom → Search в меню конфигурации и введите нужный элемент footprint.

Чтобы найти каждую страницу, содержащую разметку схемы, просто добавьте следующий фрагмент кода в пользовательский фильтр: itemtype = http://schema.org

Чтобы найти конкретный тип разметки, вам нужно быть более конкретным. Например, с помощью пользовательского фильтра для ‹span itemprop = ratingValue› вы получите все страницы, содержащие разметку схемы для оценок.

Начиная с Screaming Frog 11.0, Spider SEO также предлагает нам возможность сканировать, извлекать и проверять структурированные данные непосредственно из сканирования. Проверяйте любые структурированные данные JSON-LD, Microdata или RDFa в соответствии с рекомендациями Schema.org и спецификациями Google в режиме реального времени во время сканирования. Чтобы получить доступ к инструментам проверки структурированных данных, выберите параметры в Config > Spider > Advanced.

Чтобы получить доступ к инструментам проверки структурированных данных, выберите параметры в Config > Spider > Advanced.

Теперь в главном интерфейсе есть вкладка Structured Data, которая позволит вам переключаться между страницами, которые содержат структурированные данные, и которые могут иметь ошибки или предупреждения проверки:

Вы также можете выполнить массовый экспорт проблем со структурированными данными, посетив Reports> Structured Data > Validation Errors & Warnings.

Карта сайта

Как создать XML Sitemap

После того, как SEO Spider завершит сканирование вашего сайта, нажмите меню Siteamps и выберите XML Sitemap.

Открыв настройки конфигурации XML-карты сайта, вы можете включать или исключать страницы по коду ответов, последним изменениям, приоритетам, частоте изменений, изображениям и т. Д. По умолчанию Screaming Frog включает только 2xx URL-адресов, но это правило можно исправить.

В идеале, ваша карта сайта XML должна содержать только 200 статусных, единичных, предпочтительных (канонических) версий каждого URL-адреса, без параметров или других дублирующих факторов. После внесения любых изменений нажмите ОК. Файл XML-файла сайта будет загружен на ваше устройство и позволит вам редактировать соглашение об именах по вашему усмотрению.

Создание XML-файла Sitemap путем загрузки URL-адресов

Вы также можете создать карту сайта XML, загрузив URL-адреса из существующего файла или вставив вручную в Screaming Frog.

Измените Mode с Spider на List и нажмите на выпадающий список Upload, чтобы выбрать любой из вариантов.

Нажмите кнопку Start и Screaming Frog будет сканировать загруженные URL-адреса. После сканирования URL вы будете следовать тому же процессу, который указан выше.

Как проверить мой существующий XML Sitemap

Вы можете легко загрузить существующую XML-карту сайта или индекс карты сайта, чтобы проверить наличие ошибок или несоответствий при сканировании.

Перейдите в меню Mode в Screaming Frog и выберите List. Затем нажмите Upload в верхней части экрана, выберите Download Sitemap или Download Sitemap Index, введите URL-адрес карты сайта и начните сканирование. Как только SEO Spider закончит сканирование, вы сможете найти любые перенаправления, 404 ошибки, дублированные URL-адреса и многое другое. Вы можете легко экспортировать и выявленные ошибки.

Определение отсутствующих страниц в XML Sitemap

Вы можете настроить параметры сканирования, чтобы обнаруживать и сравнивать URL-адреса в ваших XML-файлах сайта с URL-адресами в пределах вашего сайта.

Перейдите в Configuration -> Spider в главной навигации, и внизу есть несколько опций для XML-карт сайтов – Auto discover XML sitemaps через ваш файл robots.txt или вручную введите ссылку XML-карты сайта в поле. *Important note – если ваш файл robots.txt не содержит правильных целевых ссылок на все XML-карты сайта, которые вы хотите сканировать, вы должны ввести их вручную.

После обновления настроек сканирования XML-файла Sitemap перейдите к пункту Crawl Analysis в навигации, затем нажмите Configure и убедитесь, что кнопка Sitemaps отмечена. Сначала запустите полное сканирование сайта, затем вернитесь к Crawl Analysis и нажмите Start.

После завершения анализа сканирования вы сможете увидеть любые расхождения при сканировании, такие как URL-адреса, обнаруженные в рамках полного сканирования сайта, которые отсутствуют в карте сайта XML.

Общие проблемы

Как определить, почему определенные разделы сайта не индексируются или не ранжируются

Хотите знать, почему некоторые страницы не индексируются? Во-первых, убедитесь, что они не были случайно помещены в файл robots.txt или помечены как noindex. Затем вы должны убедиться, что SEO Spider может добраться до страниц, проверив ваши внутренние ссылки. Страницу, которая не имеет внутренних ссылок на вашем сайте, часто называют «сиротами» (Orphaned Page).

Чтобы выявить потерянные страницы, выполните следующие действия:

Перейдите в Configuration -> Spider в главной навигации, и внизу есть несколько опций для XML-карт сайтов – Auto discover XML sitemaps через ваш файл robots.txt или вручную введите ссылку XML-карты сайта в поле. *Important note – если ваш файл robots.txt не содержит правильных целевых ссылок на все XML-карты сайта, которые вы хотите сканировать, вы должны ввести их вручную.

Перейдите в Configuration → API Access → Google Analytics – используя API, вы можете получить аналитические данные для конкретной учетной записи и просмотра. Чтобы найти бесхозные страницы из органического поиска, убедитесь, что они разделены на органический трафик.

Вы также можете перейти к разделу General → Crawl New URLs Discovered In Google Analytics, если вы хотите, чтобы URL-адреса, обнаруженные в GA, были включены в ваш полный обход сайта. Если это не включено, вы сможете просматривать только новые URL-адреса, извлеченные из GA, в отчете Orphaned Pages.

Перейдите в Configuration → API Access → Google Search Console – используя API, вы можете получить данные GSC для конкретной учетной записи и просмотра. Чтобы найти бесхозные страницы, вы можете искать URL-адреса, на которых получены клики и показы, которые не включены в ваш просмотр. Вы также можете перейти к разделу General → Crawl New URLs Discovered In Google Search Console, если вы хотите, чтобы URL-адреса, обнаруженные в GSC, были включены в ваш полный обход сайта. Если этот параметр не включен, вы сможете просматривать только новые URL-адреса, извлеченные из GSC, в отчете Orphaned Pages.

Просканируйте весь сайт. После завершения сканирования перейдите в Crawl Analysis -> Start и дождитесь его завершения.

Просмотрите потерянные URL-адреса на каждой из вкладок или выполните Bulk Expor всех потерянных URL-адресов, перейдя в Reports → Orphan Pages.

Если у вас нет доступа к Google Analytics или GSC, вы можете экспортировать список внутренних URL-адресов в виде файла . CSV, используя фильтр HTML на вкладке Internal.

CSV, используя фильтр HTML на вкладке Internal.

Откройте файл CSV и на втором листе вставьте список URL-адресов, которые не индексируются или плохо ранжируются. Используйте VLOOKUP, чтобы увидеть, были ли URL-адреса в вашем списке на втором листе найдены при сканировании.

Как найти медленные страницы на моем сайте

После того, как SEO Spider завершил сканирование, перейдите на вкладку Response Codes и отсортируйте по столбцу Response Time по возрастанию, чтобы найти страницы, которые могут страдать от медленной скорости загрузки.

Как найти вредоносное ПО или спам на моем сайте

Во-первых, вам необходимо идентифицировать след вредоносного ПО или спама. Далее в меню Configuration нажмите Custom → Search и введите искомый элемент, который вы ищете.

Вы можете ввести до 10 различных фильтров для сканирования. Наконец, нажмите OK и продолжайте сканирование сайта или списка страниц.

Когда SEO Spider завершит сканирование, выберите вкладку Custom в верхнем окне, чтобы просмотреть все страницы, содержащие ваш отпечаток. Если вы ввели более одного пользовательского фильтра, вы можете просмотреть каждый, изменив фильтр по результатам.

PPC и аналитика

Как проверить список URL-адресов PPC навалом

Сохраните список в формате .txt или .csv, затем измените настройки Mode на List.

Затем выберите файл для загрузки и нажмите Start или вставьте свой список вручную в Screaming Frog. Посмотрите код состояния каждой страницы, перейдя на вкладку Internal.

Зачистка

Как очистить метаданные для списка страниц

Итак, вы собрали множество URL, но вам нужна дополнительная информация о них? Установите режим List, затем загрузите список URL-адресов в формате .txt или .csv. После того, как SEO Spider будет готов, вы сможете увидеть код состояния, исходящие ссылки, количество слов и, конечно же, метаданные для каждой страницы в вашем списке.

Как очистить сайт для всех страниц, которые содержат определенный размер?

Во-первых, вам нужно определить след. Затем в меню Configuration нажмите Custom → Search или Extraction и введите искомый элемент, который вы ищете.

Затем в меню Configuration нажмите Custom → Search или Extraction и введите искомый элемент, который вы ищете.

Вы можете ввести до 10 различных следов на сканирование. Наконец, нажмите OK и продолжайте сканирование сайта или списка страниц. В приведенном ниже примере я хотел найти все страницы с надписью УСЛУГИ в разделе цен, поэтому я нашел и скопировал HTML-код из исходного кода страницы.

Когда SEO Spider завершит проверку, выберите вкладку Custom в верхнем окне, чтобы просмотреть все страницы, содержащие ваш отпечаток. Если вы ввели более одного пользовательского фильтра, вы можете просмотреть каждый, изменив фильтр по результатам.

Ниже приведены некоторые дополнительные общие следы, которые вы можете почерпнуть с веб-сайтов, которые могут быть полезны для ваших аудитов SEO:

- http: // schema \ .org – найти страницы, содержащие schema.org;

- youtube.com/embed/|youtu.be|<video|player.vimeo.com/video/|wistia.(com|net)/embed|sproutvideo.com/embed/|view.vzaar.com|dailymotion.com/ embed / | Players.brightcove.net/ | play.vidyard.com/ | kaltura.com/ (p | kwidget) / – найти страницы, содержащие видеоконтент.

Совет: Если вы извлекаете данные о продукте с клиентского сайта, вы можете сэкономить некоторое время, попросив клиента извлечь их непосредственно из его базы данных. Описанный выше метод предназначен для сайтов, к которым у вас нет прямого доступа.

Перезапись URL

Как найти и удалить идентификатор сеанса или другие параметры из моих просканированных URL

Чтобы идентифицировать URL с идентификаторами сеансов или другими параметрами, просто просмотрите ваш сайт с настройками по умолчанию. Когда SEO Spider закончил анализировать, нажмите на вкладку URI и выберите Parameters, чтобы просмотреть все URL-адреса, содержащие параметры.

Чтобы удалить параметры, отображаемые для просматриваемых URL-адресов, выберите URL Rewriting в меню конфигурации, затем на вкладке Remove Parameters нажмите Add, чтобы добавить все параметры, которые вы хотите удалить из URL-адресов, и нажмите OK.![]() Вам придется снова запустить Screaming Frog с этими настройками, чтобы произошла перезапись.

Вам придется снова запустить Screaming Frog с этими настройками, чтобы произошла перезапись.

Как переписать просканированные URL-адреса (например, заменить .com на .co.uk или написать все URL-адреса строчными буквами)

Чтобы переписать любой URL, который вы сканируете, выберите URL Rewriting в меню Configuration, затем на вкладке Regex Replace нажмите Add, чтобы добавить RegEx для того, что вы хотите заменить.

После того, как вы добавили все нужные правила, вы можете проверить их на вкладке Test, введя тестовый URL в поле URL before rewriting. URL after rewriting будет автоматически обновляться в соответствии с вашими правилами.

Если вы хотите установить правило, согласно которому все URL-адреса возвращаются в нижнем регистре, просто выберите Lowercase discovered URLs на вкладке Options. Это удалит любое дублирование URL-адресами с заглавными буквами при сканировании.

Помните, что вам придется запустить SEO Spider с этими настройками, чтобы перезапись URL произошла.

Исследование ключевых слов

Как узнать, какие страницы мои конкуренты ценят больше всего

Конкуренты будут пытаться распространить популярность ссылок и привлечь трафик на свои наиболее ценные страницы, ссылаясь на них внутри. Любой SEO-ориентированный конкурент, вероятно, также будет ссылаться на важные страницы из блога своей компании. Найдите ценные страницы вашего конкурента, просканировав их сайт, а за тем отсортировав вкладку Internal по столбцу Inlinks по возрастанию, чтобы увидеть, какие страницы имеют больше внутренних ссылок.

Чтобы просмотреть страницы, ссылки на которые есть в блоге вашего конкурента, отмените выбор Check links outside folder в меню Spider Configuration и просмотрите папку / поддомен блога. Затем на вкладке External отфильтруйте результаты с помощью поиска по URL основного домена. Прокрутите до крайнего правого края и отсортируйте список по столбцу Inlinks, чтобы увидеть, какие страницы связаны чаще всего.

Совет: Перетащите столбцы влево или вправо, чтобы улучшить просмотр данных.

Как узнать, какой якорный текст используют мои конкуренты для внутренних ссылок

В меню Bulk Export выберите All Anchor Text, чтобы экспортировать CSV-файл, содержащий весь текст привязки на сайте, где он используется и с чем он связан.

Как узнать, какие метатеги keywords (если они есть) конкуренты добавили на свои страницы

После того, как SEO Spider закончил сканировать, посмотрите на вкладку Meta Keywords, чтобы увидеть их, найденные для каждой страницы. Сортируйте по столбцу Meta Keyword 1, чтобы расположить алфавитный список и визуально отделить пустые записи или просто экспортировать весь список.

Создание ссылок

Как проанализировать список предполагаемых ссылок

Если вы создали список URL-адресов, которые необходимо проверить, вы можете загрузить и отсканировать их в режиме List, чтобы собрать больше информации о страницах. После завершения сканирования, проверьте коды состояния на вкладке Response Codes и просмотрите исходящие ссылки, типы ссылок, текст привязки и директивы nofollow на вкладке Outlinks в нижнем окне. Это даст вам представление о том, на какие сайты ссылаются эти страницы и как. Чтобы просмотреть вкладку Outlinks, убедитесь, что в верхнем окне выбран интересующий вас URL.

Конечно, вы захотите использовать пользовательский фильтр, чтобы определить, ссылаются ли эти страницы уже на вас.

Вы также можете экспортировать полный список выходных ссылок, нажав All Outlinks в Bulk Export Menu. Это не только предоставит вам ссылки на внешние сайты, но также покажет все внутренние ссылки на отдельных страницах вашего списка.

Как найти неработающие ссылки для расширения возможностей

Итак, вы нашли сайт, с которого хотите получить ссылку? Используйте Screaming Frog, чтобы найти неработающие ссылки на нужной странице или на сайте в целом, затем обратитесь к владельцу сайта, предложив свой сайт в качестве замены неработающей ссылки, где это применимо, или просто укажите на неработающую ссылку в качестве знака доброй воли.

Как проверить мои обратные ссылки и просмотреть текст привязки

Загрузите свой список обратных ссылок и запустите SEO Spider в режиме List. Затем экспортируйте полный список исходящих ссылок, нажав All Out Links в Advanced Export Menu. Это предоставит вам URL-адреса и анкорный текст / текст alt для всех ссылок на этих страницах. Затем вы можете использовать фильтр в столбце Destination CSV, чтобы определить, связан ли ваш сайт и какой текст привязки / текст alt включен.

Как убедиться, что ссылки удаляются по запросу в процессе очистки

Установите пользовательский фильтр, содержащий URL-адрес вашего корневого домена, затем загрузите список обратных ссылок и запустите SEO Spider в режиме List. Когда SEO Spider завершит сканирование, выберите вкладку Custom, чтобы просмотреть все страницы, которые все еще ссылаются на вас.

Дополнительная информация

Знаете ли вы, что, щелкнув правой кнопкой мыши по любому URL в верхнем окне ваших результатов, вы можете выполнить любое из следующих действий?

- Скопировать или открыть URL;

- Повторно сканировать URL или удалить его из своего сканирования;

- Экспортировать информацию об URL, в ссылках, выходных ссылках или информации об изображении для этой страницы

- Проверить индексацию страницы в Google;

- Проверить обратные ссылки на страницу в Majestic, OSE, Ahrefs и Blekko.

- Посмотреть на кэшированную версию / дату кеша страницы;

- Смотреть старые версии страницы;

- Проверить HTML-код страницы

- Открыть robots.txt для домена, на котором находится страница;

- Поиск других доменов на том же IP.

Аналогично, в нижнем окне, щелкнув правой кнопкой мыши, вы можете скопировать или открыть URL-адрес в столбце To для From выбранной строки.

Как редактировать метаданные

Режим SERP позволяет вам просматривать фрагменты SERP на устройстве, чтобы визуально показать, как ваши метаданные будут отображаться в результатах поиска.

-

Загрузите URL, заголовки и метаописания в Screaming Frog, используя документ .CSV или Excel.

Если вы уже провели сканирование своего сайта, то можете экспортировать URL-адреса, перейдя в Reports → SERP Summary. Это легко отформатирует URL и мета, которые вы хотите загрузить и отредактировать.

- Mode → SERP → Upload File.

- Редактируйте метаданные в Screaming Frog.

Массовый экспорт обновленных метаданных для отправки напрямую разработчикам для обновления.

Как сканировать JavaScript-сайта

Все чаще веб-сайты создаются с использованием таких JavaScript-фреймворков, как Angular, React и т. д. Google настоятельно рекомендует использовать решение для рендеринга, поскольку робот Googlebot все еще пытается сканировать содержимое JavaScript. Если вы определили сайт, созданный с использованием JavaScript, следуйте приведенным ниже инструкциям, чтобы сканировать сайт.

Configuration → Spider → Rendering → JavaScript

Измените настройки рендеринга в зависимости от того, что вы ищете. Вы можете настроить время ожидания, размер окна (мобильный, планшет, рабочий стол и т. д.)

Нажмите OK и сканируйте веб-сайт.

В нижней части навигации щелкните вкладку Rendered Page, чтобы увидеть, как страница отображается. Если ваша страница не отображается должным образом, проверьте наличие заблокированных ресурсов или увеличьте лимит времени ожидания в настройках конфигурации. Если ни один из вариантов не поможет решить, как ваша страница отображается, возможно, возникнет более серьезная проблема.

Вы можете просмотреть и массово экспортировать любые заблокированные ресурсы, которые могут повлиять на сканирование и визуализацию вашего сайта, перейдя в Bulk Export → Response Codes.

Просмотр оригинального HTML и визуализированного HTML

Если вы хотите сравнить необработанный HTML и визуализированный HTML, чтобы выявить какие-либо несоответствия или убедиться, что важный контент находится в DOM, перейдите в Configuration → Spider -> Advanced и нажмите hit store HTML и store rendered HTML.

В нижнем окне вы сможете увидеть необработанный и визуализированный HTML. Это может помочь выявить проблемы с тем, как ваш контент отображается и просматривается сканерами.

В заключение

Мы надеемся, что это руководство даст вам лучшее представление о том, какие возможности вам доступны в Screaming Frog, а также поможет сэкономить часы работы.

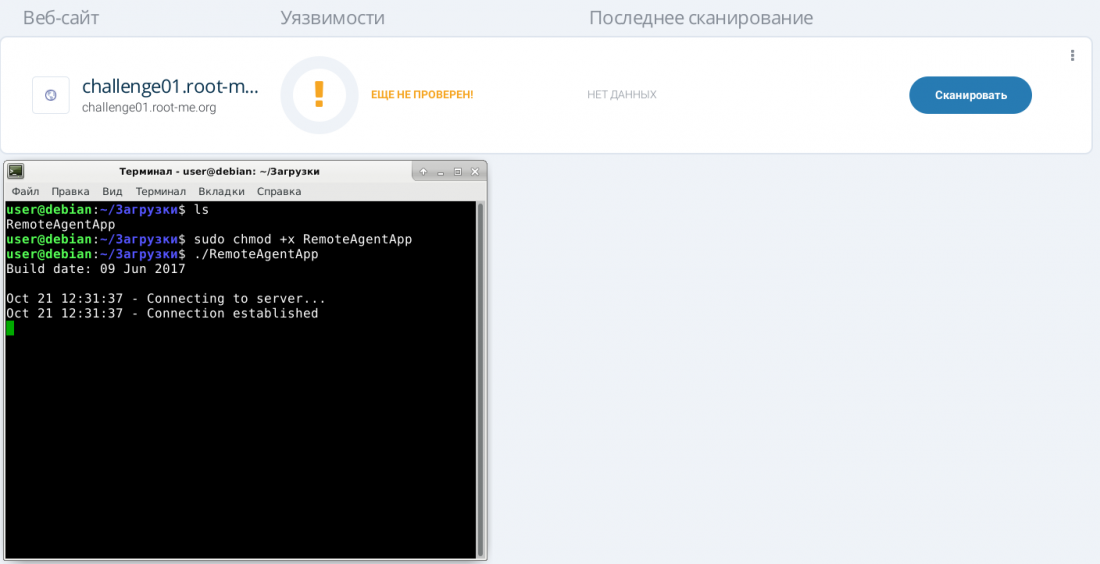

поиск уязвимостей, сетевые сканеры, дебаггеры, уязвимости в скриптах

В данном обзоре рассматриваются бесплатные сканеры защищенности веб-сайтов — дается их определение, описывается принцип работы, приводятся краткие обзоры продуктов.

1. Введение

2. Что такое сканеры защищенности веб-сайтов

3. Принцип работы сканеров защищенности веб-сайтов

4. Категории сканеров защищенности веб-сайтов

5. Краткий обзор бесплатных сканеров защищенности веб-сайтов

5.1. Сетевые сканеры

5.1.1. Nmap

5.1.2. IP Tools

5.2. Сканеры поиска уязвимостей в веб-скриптах

5.2.1. Nikto

5.2.2. Skipfish

5.2.3. Wapiti

5.3. Средства поиска эксплойтов

5.3.1. Metasploit Framework

5.3.2. Nessus

5.4. Средства автоматизации инъекций

5.4.1. SQLMap

5.4.2. bsqlbf-v2

5.5. Дебаггеры

5.5.1. Burp Suite

5.5.2. Fiddler

5.6. Универсальные сканеры

5.6.1. Web Application Attack and Audit Framework (w3af)

5.6.2. N-Stalker Web Application Security Scanner X Free Edition

6. Выводы

Введение

В современном бизнесе веб-технологии приобрели огромную популярность. Большинство сайтов крупных компаний представляют собой набор приложений, обладающих интерактивностью, средствами персонализации, средствами взаимодействия с клиентами (интернет-магазины, дистанционное банковское обслуживание), а нередко — и средствами интеграции с внутренними корпоративными приложениями компании.

Однако как только веб-сайт становится доступным в интернете, он превращается в мишень для кибератак. Наиболее простым способом атак на веб-сайт сегодня является использование уязвимостей его компонентов. И основная проблема заключается в том, что уязвимости стали вполне обычным явлением для современных сайтов.

Наиболее простым способом атак на веб-сайт сегодня является использование уязвимостей его компонентов. И основная проблема заключается в том, что уязвимости стали вполне обычным явлением для современных сайтов.

Уязвимости представляют собой неизбежную и растущую угрозу. Они, по большей части, являются результатами дефектов безопасности в коде веб-приложения и неправильной конфигурации компонентов веб-сайта.

Приведем немного статистики. По данным из отчета о киберугрозах за первое полугодие 2016 года High-Tech Bridge releases web security trends of the first half of 2016, подготовленного компанией High-Tech Bridge:

- свыше 60% веб-сервисов или API для мобильных приложений содержат по крайней мере одну опасную уязвимость, позволяющую скомпрометировать базу данных;

- 35% уязвимых к XSS-атакам сайтов также уязвимы к SQL-инъекциям и XXE-атакам;

- 23% сайтов содержат уязвимость POODLE, и только 0,43% — Heartbleed;

- в 5 раз участились случаи эксплуатации опасных уязвимостей (например, позволяющих осуществить SQL-инъекцию) в ходе атак RansomWeb;

- 79,9% веб-серверов имеют неправильно сконфигурированные или небезопасные заголовки http;

- актуальные на сегодняшний день необходимые обновления и исправления установлены только на 27,8% веб-серверов.

Для защиты веб-ресурсов специалисты по информационной безопасности используют различный набор средств. Например, для шифрования трафика применяют SSL-сертификаты, а на периметре веб-серверов устанавливают Web Application Firewall (WAF), которые требуют серьезной настройки и долгого самообучения. Не менее эффективным средством обеспечения безопасности веб-сайтов является и периодическая проверка состояния защищенности (поиск уязвимостей), а инструментами для проведения таких проверок служат сканеры защищенности веб-сайтов, о которых и пойдет речь в этом обзоре.

На нашем сайте уже был обзор, посвященный сканерам защищенности веб-приложений — «Сканеры защищенности веб-приложений (WASS) – обзор рынка в России и в мире», в котором рассматривались продукты лидеров рынка. В настоящем обзоре мы уже не будем затрагивать эти темы, а сфокусируем внимание на обзоре бесплатных сканеров защищенности веб-сайтов.

В настоящем обзоре мы уже не будем затрагивать эти темы, а сфокусируем внимание на обзоре бесплатных сканеров защищенности веб-сайтов.

Тема бесплатного программного обеспечения сегодня особенно актуальна. Из-за нестабильной экономической ситуации в России сейчас во многих организациях (как и в коммерческих, так и в госсекторе) идет оптимизация ИТ-бюджета, и средств на покупку дорогих коммерческих продуктов для анализа защищенности систем зачастую не хватает. При этом существует множество бесплатных (free, open source) утилит для поиска уязвимостей, о которых люди просто не знают. Причем некоторые из них не уступают по функциональным возможностям своим платным конкурентам. Поэтому в этой статьей расскажем о наиболее интересных бесплатных сканерах защищенности веб-сайтов.

Что такое сканеры защищенности веб-сайтов

Сканеры защищенности веб-сайтов — это программные (программно-аппаратные) средства, осуществляющие поиск дефектов веб-приложений (уязвимостей), которые приводят к нарушению целостности системных или пользовательских данных, их краже или получению контроля над системой в целом.

С помощью сканеров защищенности веб-сайтов можно обнаружить уязвимости следующих категорий:

- уязвимости этапа кодирования;

- уязвимости этапа внедрения и конфигурирования веб-приложения;

- уязвимости этапа эксплуатации веб-сайта.

К уязвимостям этапа кодирования относятся уязвимости, связанные с некорректной обработкой входных и выходных данных (SQL-инъекции, XSS).

К уязвимостям этапа внедрения веб-сайта относятся уязвимости, связанные с некорректными настройками окружения веб-приложения (веб-сервера, сервера приложений, SSL/TLS, фреймворк, сторонние компоненты, наличие DEBUG-режима и т. п.).

К уязвимостям этапа эксплуатации веб-сайта относятся уязвимости, связанные с использованием устаревшего ПО, простых паролей, хранением архивных копий на веб-сервере в общем доступе, наличием в общем доступе служебных модулей (phpinfo) и т. п.

п.

Принцип работы сканеров защищенности веб-сайтов

В общем случае принцип работы сканера защищенности веб-сайтов заключается в следующем:

- Сбор информации об исследуемом объекте.

- Аудит программного обеспечения веб-сайта на предмет уязвимостей по базам уязвимостей.

- Выявление слабых мест системы.

- Формирование рекомендаций по их устранению.

Категории сканеров защищенности веб-сайтов

Сканеры защищенности веб-сайтов, в зависимости от их предназначения, можно разделить на следующие категории (типы):

- Сетевые сканеры — данный тип сканеров раскрывает доступные сетевые сервисы, устанавливает их версии, определяет ОС и т. д.

- Сканеры поиска уязвимостей в веб-скриптах — данный тип сканеров осуществляет поиск уязвимостей, таких как SQL inj, XSS, LFI/RFI и т. д., или ошибок (не удаленные временные файлы, индексация директорий и т. п.).

- Средства поиска эксплойтов — данный тип сканеров предназначен для автоматизированного поиска эксплойтов в программном обеспечении и скриптах.

- Средства автоматизации инъекций — утилиты, которые конкретно занимаются поиском и эксплуатацией инъекций.

- Дебаггеры — средства для исправления ошибок и оптимизации кода в веб-приложении.

Существуют также и универсальные утилиты, которые включают в себя возможности сразу нескольких категорий сканеров.

Далее будет приведен краткий обзор бесплатных сканеров защищенности веб-сайтов. Поскольку бесплатных утилит очень много, в обзор включены только самые популярные бесплатные инструменты для анализа защищенности веб-технологий. При включении в обзор той или иной утилиты анализировались специализированные ресурсы по тематике безопасности веб-технологий:

Краткий обзор бесплатных сканеров защищенности веб-сайтов

Сетевые сканеры

Nmap

Тип сканера: сетевой сканер.

Nmap (Network Mapper) — это бесплатная утилита с открытым исходным кодом. Она предназначена для сканирования сетей с любым количеством объектов, определения состояния объектов сканируемой сети, а также портов и соответствующих им служб. Для этого Nmap использует много различных методов сканирования, таких как UDP, TCP connect, TCP SYN (полуоткрытое), FTP proxy (прорыв через ftp), Reverse-ident, ICMP (ping), FIN, ACK, Xmas tree, SYN и NULL-сканирование.

Nmap также поддерживает большой набор дополнительных возможностей, а именно: определение операционной системы удаленного хоста с использованием отпечатков стека TCP/IP, «невидимое» сканирование, динамическое вычисление времени задержки и повтор передачи пакетов, параллельное сканирование, определение неактивных хостов методом параллельного ping-опроса, сканирование с использованием ложных хостов, определение наличия пакетных фильтров, прямое (без использования portmapper) RPC-сканирование, сканирование с использованием IP-фрагментации, а также произвольное указание IP-адресов и номеров портов сканируемых сетей.

Nmap получил статус Security Product of the Year от таких журналов и сообществ, как Linux Journal, Info World, LinuxQuestions.Org и Codetalker Digest.

Платформа: утилита кросс-платформенна.

Подробнее со сканером Nmap можно ознакомиться здесь.

IP Tools

Тип сканера: сетевой сканер.

IP Tools — это анализатор протоколов, поддерживающий правила фильтрации, адаптер отбора, декодирование пакетов, описание протокола и многое другое. Подробная информацию о каждом пакете содержится в дереве стиля, меню по щелчку правой кнопкой мыши позволяет сканировать выбранный IP-адрес.

В дополнение к пакетному снифферу, IP Tools предлагает полный набор сетевых инструментов, включая адаптер статистики, мониторинг IP-трафика и многое другое.

Подробнее со сканером IP-Tools можно ознакомиться здесь.

Платформа: Windows.

Top 100 Network Security Tools — топ-100 утилит для сетевой безопасности.

Сканеры поиска уязвимостей в веб-скриптах

Nikto

Тип сканера: сканер поиска уязвимостей в веб-скриптах.

Nikto — бесплатный сканер, который осуществляет всеобъемлющее тестирование веб-серверов на уязвимости, в том числе проверяет наличие более 6500 потенциально опасных файлов и CGI, определяет устаревшие версии более 1250 различных веб-серверов, а также отображает специфические проблемы для более чем 270 версий серверов. Сканер также определяет типичные ошибки в конфигурации веб-сервера, в том числе наличие нескольких индексных файлов, опции HTTP-сервера, после чего пытается составить максимально полный список версий программ и модулей на сервере. Список сканируемых объектов в Nikto реализован в виде подключаемых плагинов и часто обновляется (эти плагины не являются open source).

Сканер Nikto спроектирован для работы в скрытном режиме: он осуществляет сканирование максимально быстро, записывая результаты в лог. Версия 2.1.5 содержит исправления нескольких багов, а также новые функции и новые виды проверок. Среди самого важного — распознавание IP в HTTP-заголовках, автоматическая проверка доступных файлов после парсинга robots.txt, проверка иконок в <link>, проверка уязвимостей с crossdomain.xml и clientaccesspolicy.xml. Среди новых опций программы — установка максимального времени сканирования хоста (в секундах) для маскировки сканирования, повтор сохраненных JSON-запросов с помощью replay.pl, поддержка SSL-сертификатов на стороне клиента, более продвинутое тестирование за счет автоматического добавления переменных в db_variables после парсинга robots.txt или других страниц.

Стоит также отметить, что свободный движок Nikto используется в коммерческих сканерах уязвимостей Edgeos и HackerTarget.com.

Платформа: MacOS, Linux, Windows.

Подробнее со сканером Nikto можно ознакомиться здесь.

Skipfish

Тип сканера: сканер поиска уязвимостей в веб-скриптах.

Кросс-платформенный сканер веб-уязвимостей Skipfish от программиста Michal Zalewski выполняет рекурсивный анализ веб-приложения и его проверку на базе словаря, после чего составляет карту сайта, снабженную комментариями об обнаруженных уязвимостях.

Разработка инструмента ведется внутри компании Google.

Сканер осуществляет детальный анализ web-приложения. Также существует возможность создания словаря для последующего тестирования этого же приложения. Подробный отчет Skipfish содержит информацию об обнаруженных уязвимостях, URL ресурса, содержащего уязвимость, а также переданный запрос. В отчете полученные данные отсортированы по уровню опасности и по типу уязвимости. Отчет формируется в html-формате.

Стоит отметить, что сканер веб-уязвимостей Skipfish генерирует очень большой объем трафика, а сканирование происходит очень долго.

Платформы: MacOS, Linux, Windows.

Подробнее со сканером Skipfish можно ознакомиться здесь.

Wapiti

Тип сканера: сканер поиска уязвимостей в веб-скриптах.

Wapiti — это консольная утилита для аудита веб-приложений. Работает по принципу «черного ящика» (blackbox).

Wapiti функционирует следующим образом: сначала WASS-сканер анализирует структуру сайта, ищет доступные сценарии, анализирует параметры. После Wapiti включает фаззер и продолжает сканирование до тех пор, пока все уязвимые скрипты не будут найдены.

WASS-сканер Wapiti работает со следующими типами уязвимостей:

- File disclosure (Local and remote include/require, fopen, readfile).

- Database Injection (PHP/JSP/ASP SQL Injections and XPath Injections).

- XSS (Cross Site Scripting) injection (reflected and permanent).

- Command Execution detection (eval(), system(), passtru()…).

- CRLF Injection (HTTP Response Splitting, session fixation…).

- XXE (XmleXternal Entity) injection.

- Use of know potentially dangerous files.

- Weak .htaccess configurations that can be bypassed.

- Presence of backup files giving sensitive information (source code disclosure).

Wapiti входит в состав утилит дистрибутива Kali Linux. Можно скачать исходники с SourceForge и использовать на любом дистрибутиве, основанном на ядре Linux. Wapiti поддерживает GET и POST HTTP методы запросов.

Платформы: Windows, Unix, MacOS.

Подробнее со сканером Wapiti можно ознакомиться здесь.

Web Application Security Scanner List by WebAppSec — список сканеров защищенности веб-сайтов от организации WebAppSec.

Средства поиска эксплойтов

Metasploit Framework

Тип сканера: средства поиска эксплойтов.

Простая в использовании платформа проникновения, содержащая описание новейших угроз, дополненная функциями автоматического обновления и расширяемая с помощью известного языка Perl. Metasploit Framework очень пригодится специалистам по сетевой безопасности для эмуляции угроз.

Metasploit — механизм на базе сценариев Perl, с помощью которого можно применять множество методов проникновения для различных платформ и приложений. Помимо набора методов проникновения через известные лазейки, Metasploit позволяет переслать в обнаруженную брешь конкретную программу.

Metasploit Framework расширяется с использованием модулей Perl, поэтому можно подготовить собственные средства проникновения, включить их в инфраструктуру и воспользоваться готовой подходящей программой использования.

Подробнее со сканером Metasploit Framework можно ознакомиться здесь.

Nessus

Категория сканера: сетевой сканер и средство поиска эксплойтов.

Сканер Nessus является мощным и надежным средством, которое относится к семейству сетевых сканеров, позволяющих осуществлять поиск уязвимостей в сетевых сервисах, предлагаемых операционными системами, межсетевыми экранами, фильтрующими маршрутизаторами и другими сетевыми компонентами. Для поиска уязвимостей используются как стандартные средства тестирования и сбора информации о конфигурации и функционировании сети, так и специальные средства, эмулирующие действия злоумышленника по проникновению в системы, подключенные к сети.

Платформы: кросс-платформенное программное обеспечение.

Подробнее со сканером Nessus можно ознакомиться здесь.

Top 10 Web Vulnerability Scanners — топ-10 сканеров уязвимостей веб-сайтов.

Средства автоматизации инъекций

SQLMap

Тип сканера: средство автоматизации инъекций.

Бесплатный сканер с открытым исходным кодом, главная задача которого — автоматизированный поиск SQL-уязвимостей. SQLMap позволяет не только обнаруживать уязвимости, но и при возможности эксплуатировать их. SQLMap поддерживает большое количество СУБД.

К функциональным возможностям SQLMap относятся:

- Поиск инъекций: boolean-based blind, time-based blind, error-based, UNION query и stacked queries.

- Возможность работы с конкретным URL либо со списком.

- Проверка параметров, передаваемых методами GET и POST.

- Работа в многопотоковом режиме.

- Интеграция с другими инструментами для анализа веб-приложений — Metasploit и w3af.

- Возможность получения полезной информации о приложении и сервере (fingerprint).

Платформы: MySQL, Oracle, PostgreSQL, Microsoft SQL Server, Microsoft Access, IBM DB2, SQLite, Firebird, Sybase, SAP MaxDB и HSQLDB.

Подробнее со сканером SQLMap можно ознакомиться здесь.

bsqlbf-v2

Тип сканера: средство автоматизации инъекций.

bsqlbf-v2 — скрипт, написанный на языке Perl. Брутфорсер «слепых» SQL-инъекций. Сканер работает как с integer-значениями в url, так и со строковыми (string).

Платформы: MS-SQL, MySQL, PostgreSQL, Oracle.

Подробнее со сканером bsqlbf-v2 можно ознакомиться здесь.

Дебаггеры

Burp Suite

Тип сканера: дебаггер.

Burp Suite — это набор относительно независимых кросс-платформенных приложений, написанных на Java.

Ядром комплекса является модуль Burp Proxy, выполняющий функции локального прокси-сервера; остальные компоненты набора — это Spider, Intruder, Repeater, Sequencer, Decoder и Comparer. Все составляющие связаны между собой в единое целое таким образом, что данные могут быть отправлены в любую часть приложения, например, из Proxy в Intruder для проведения различных проверок над веб-приложением, из Intruder в Repeater — для более тщательного ручного анализа HTTP-заголовков.

Платформы: кросс-платформенное программное обеспечение.

Подробнее со сканером Burp Suite можно ознакомиться здесь.

Fiddler

Тип сканера: дебаггер.

Fiddler — это отладочный прокси, логирующий весь HTTP(S)-трафик. Инструмент позволяет исследовать этот трафик, устанавливать breakpoint и «играться» с входящими или исходящими данными.

Функциональные особенности Fiddler:

- Возможность контроля всех запросов, файлов cookie, передаваемых параметров интернет-браузерами.

- Функция изменения ответов сервера «на лету».

- Возможность манипулировать заголовками и запросами.

- Функция изменения ширины канала.

Платформы: кросс-платформенное программное обеспечение.

Подробнее со сканером Fiddler можно ознакомиться здесь.

Top 10 Vulnerability Scanners— топ-10 сканеров уязвимостей.

Универсальные сканеры

Web Application Attack and Audit Framework (w3af)

Тип сканера: сканер поиска уязвимостей в веб-скриптах, средство поиска эксплойтов.

Web Application Attack and Audit Framework (w3af) — это WASS-сканер (фреймворк) с открытым исходным кодом. WASS-сканер написан на Python, поэтому с успехом запускается и под Windows, и под *NIX, и под MacOS. Для инсталляции необходим установленный интерпретатор Python. В распоряжении пользователя как графический (с использованием GTK), так и консольный интерфейсы.

Подавляющую часть функциональности платформы составляют плагины (на данный момент уже более 100). Они делятся на группы:

- audit — плагины, которые непосредственно ищут уязвимости на веб-сервере;

- bruteforce — плагины для перебора логинов и паролей веб-форм и BasicAuth;

- discovery — плагины для сбора информации: версия веб-сервера, версия ОС, ссылки, пользователи, почтовые ящики;

- evasion — плагины, которые изменяют запросы к веб-серверу для преодоления фильтрации, типа кавычек и прочего;

- grep — плагины для анализа запросов и ответов веб-сервера;

- mangle — плагины для изменения запросов к веб-серверу «на лету».

Плагины, имеющиеся в w3af, делятся на 3 типа: для исследований, для аудита и для проведения атак.

Платформы: Windows, Unix, MacOS.

Подробнее со сканером Web Application Attack and Audit Framework (w3af) можно ознакомиться здесь.

N-Stalker Web Application Security Scanner X Free Edition

Тип сканера: сканер поиска уязвимостей в веб-скриптах, средство поиска эксплойтов.

Эффективный инструмент для веб-служб — N-Stealth Security Scanner компании N-Stalker. Компания продает более полнофункциональную версию N-Stealth, но бесплатная пробная версия вполне пригодна для простой оценки. Платный продукт располагает более чем 30 тыс. тестов системы безопасности веб-серверов, но и бесплатная версия обнаруживает более 16 тыс. конкретных пробелов, в том числе уязвимые места в таких широко распространенных веб-серверах, как Microsoft IIS и Apache. Например, N-Stealth отыскивает уязвимые сценарии Common Gateway Interface (CGI) и Hypertext Preprocessor (PHP), использует атаки с проникновением в SQL Server, типовые кросс-сайтовые сценарии и другие пробелы в популярных веб-серверах.

тестов системы безопасности веб-серверов, но и бесплатная версия обнаруживает более 16 тыс. конкретных пробелов, в том числе уязвимые места в таких широко распространенных веб-серверах, как Microsoft IIS и Apache. Например, N-Stealth отыскивает уязвимые сценарии Common Gateway Interface (CGI) и Hypertext Preprocessor (PHP), использует атаки с проникновением в SQL Server, типовые кросс-сайтовые сценарии и другие пробелы в популярных веб-серверах.

N-Stealth поддерживает как HTTP, так и HTTP Secure (HTTPS — с использованием SSL), сопоставляет уязвимые места со словарем Common Vulnerabilities and Exposures (CVE) и базой данных Bugtraq, а также генерирует неплохие отчеты. N-Stealth используется для поиска наиболее распространенных уязвимых мест в веб-серверах и помогает определять самые вероятные направления атак.

Конечно, для более достоверной оценки безопасности веб-узла или приложений рекомендуется приобрести платную версию.

Подробнее со сканером N-Stealth можно ознакомиться здесь.

Выводы

Тестирование веб-сайтов на предмет выявления уязвимых мест — это хорошая превентивная мера. В настоящее время существует множество как коммерческих, так и свободно распространяемых сканеров защищенности веб-сайтов. При этом сканеры могут быть как универсальные (комплексные решения), так и специализированные, предназначенные только для выявления определенных типов уязвимостей.

Некоторые бесплатные сканеры являются довольно мощными инструментами и показывают большую глубину и хорошее качество проверки веб-сайтов. Но перед тем как использовать бесплатные утилиты для анализа защищенности веб-сайтов, необходимо удостовериться в их качестве. Сегодня для этого уже есть множество методик (например, Web Application Security Scanner Evaluation Criteria, OWASP Web Application Scanner Specification Project).

Наиболее полную картину о защищенности той или иной инфраструктуры позволяют получить только комплексные решения. В некоторых случаях лучше применять несколько сканеров защищенности.

Принципы работы Google Поиска | Сканирование и индексирование

Чтобы пользователи могли быстро найти нужные сведения, наши роботы собирают информацию на сотнях миллиардов страниц и упорядочивают ее в поисковом индексе.

При очередном сканировании наряду со списком веб-адресов, полученных во время предыдущего сканирования, используются файлы Sitemap, которые предоставляются владельцами сайтов. По мере посещения сайтов робот переходит по указанным на них ссылкам на другие страницы. Особое внимание он уделяет новым и измененным сайтам, а также неработающим ссылкам. Он самостоятельно определяет, какие сайты сканировать, как часто это нужно делать и какое количество страниц следует выбрать на каждом из них.

При помощи Search Console владельцы сайтов могут указывать, как именно следует сканировать их ресурсы, в частности предоставлять подробные инструкции по обработке страниц, запрашивать их повторное сканирование, а также запрещать сканирование, используя файл robots.txt. Google не увеличивает частоту сканирования отдельных ресурсов за плату. Чтобы результаты поиска были максимально полезными для пользователей, все владельцы сайтов получают одни и те же инструменты.

Поиск информации с помощью сканирования

Интернет похож на библиотеку, которая содержит миллиарды изданий и постоянно пополняется, но не располагает централизованной системой учета книг. Чтобы находить общедоступные страницы, мы используем специальное программное обеспечение, называемое поисковыми роботами. Роботы анализируют страницы и переходят по ссылкам на них – как обычные пользователи. После этого они отправляют сведения о ресурсах на серверы Google.

Систематизация информации с помощью индексирования

Во время сканирования наши системы обрабатывают материалы страниц так же, как это делают браузеры, и регистрируют данные по ключевым словам и новизне контента, а затем создают на их основе поисковый индекс.![]()

Индекс Google Поиска содержит сотни миллиардов страниц. Его объем значительно превышает 100 миллионов гигабайт. Он похож на указатель в конце книги, в котором есть отдельная запись для каждого слова на всех проиндексированных страницах. Во время индексирования данные о странице добавляются в записи по всем словам, которые на ней есть.

Как сканировать веб-сайт или извлекать данные в базу данных с помощью python? Ru Python

Я хотел бы создать webapp, чтобы помочь другим студентам моего университета создать свои графики. Для этого мне нужно просканировать основные расписания (одну огромную страницу html), а также ссылку на подробное описание каждого курса в базу данных, предпочтительно на python. Кроме того, мне нужно войти в систему, чтобы получить доступ к данным.